线性模型

线性模型试图学得一个属性的线性组合形式来预测的函数

用向量形式表示也就是\(f(\boldsymbol{x}) = \boldsymbol{w}^{\mathrm{T}} \boldsymbol{x} + b\)

线性回归

将属性表示为向量,对于连续属性,这是易得的

对于离散属性,如果属性值之间存在“序”关系,则可以通过连续化转化为连续值,例如“高”“矮”可以转化为{1.0,0.0},否则一般要通过独热编码的方式进行转化,也就是k个属性值转化为k维向量,例如“男生”“女生”转化为(1,0),(0,1)

可以想到线性回归的核心就在于确定参数w和b,使得\(f(x_i)\simeq y_i\),该目标可以转为为让均方误差最小化

均方误差对应于欧几里得距离,基于均方误差最小化来进行模型求解的方法称为“最小二乘法”,从几何意义上看,就是试图找到一条直线,使所有样本到直线上的欧氏距离最小

对于最小二乘法而言,这样就得到了目标函数,因为这个函数比较简单,可以通过求导并令导数为0来得到参数的闭式解

扩展

线性模型不仅简单,还可以有很多的变化,例如若我们认为示例所对应的输出标记是在指数尺度上变化,那么我们同样可以用线性模型进行学习,只需要将输出标记的对数作为线性模型逼近的目标,即\(ln y = \boldsymbol{w}^T \boldsymbol{x}+b\)

这就是对数线性回归

更一般地,对于单调可微函数g(\(\cdot\)),令\(y=g^{-1}(\boldsymbol{w}^T \boldsymbol{x}+b)\)

这称为是广义线性模型,其中函数g(\(\cdot\))称为联系函数。显然对数线性回归是其中的一个特例

对数几率回归

对于分类任务,一般的线性模型并不能对这个目标进行学习,但是参考扩展中的思想,只需要找到一个单调可微函数将分类任务的真实标记y和线性回归模型的预测值联系起来就能进行学习

显然,对于分类任务,最合适的是阶跃函数,例如对于二分类函数,单位阶跃函数是最理想的

但是这种函数并不连续,不能很好地学习,于是考虑一个单调可微的近似函数:sigmoid函数

对数几率函数是其中最常用的一个:\(y=\frac{1}{1+e^{-z}}\)

(y视为样本\(\boldsymbol{x}\)作为正例的可能性,1-y是其反例可能性,则两者的比值\(\frac{y}{1-y}\)称为几率)

将z用线性模型预测的结果代入,那么y就可以表示为对于分类结果的预测,这种模型称为“对数几率回归”,虽然是回归,但实际上是一种分类学习方法

具体的学习过程可以用极大似然法来实现,如果将上式中的y看作是一种后验概率估计,则\(ln \frac{p(y=1 \mid \boldsymbol{x})}{p(y=0|\boldsymbol{x})}=\boldsymbol{w}^T \boldsymbol{x}+b\),进一步就可以得到\(p(y=1 \mid \boldsymbol{x})=\frac{e^{\boldsymbol{w}^T \boldsymbol{x}+b}}{1+e^{\boldsymbol{w}^T \boldsymbol{x}+b}}\),目标就是最大化对数似然函数

线性判别分析(LDA)

给定训练样例集,设法将样例投影到一条直线上,使得同类样例的投影点尽可能接近,异类样例的投影点尽可能远离,在对新样本进行分类时,将其投影到同样的这条直线上,再根据投影点的位置来确定新样本的类别

即,让同类样例投影点的协方差尽可能小,类中心之间的距离尽可能大

多分类LDA将样本投影到N-1维空间,N-1通常远小于数据原有的属性数,因此可以通过这个投影来减小样本点的维数,且投影过程中使用了类别信息,因此LDA被视为一种经典的监督降维技术

最大熵模型

和对数几率回归一样,都属于对数线性模型

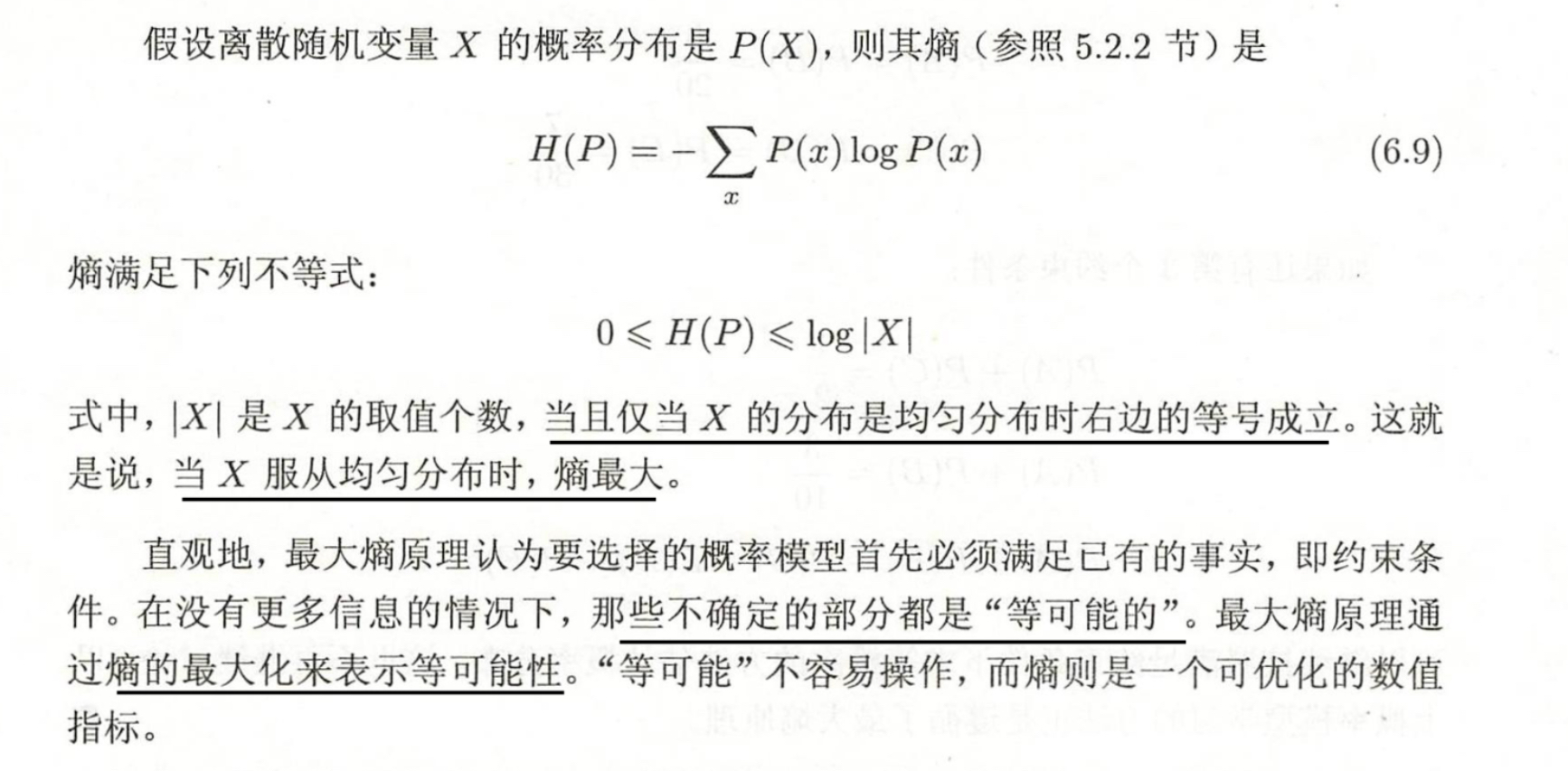

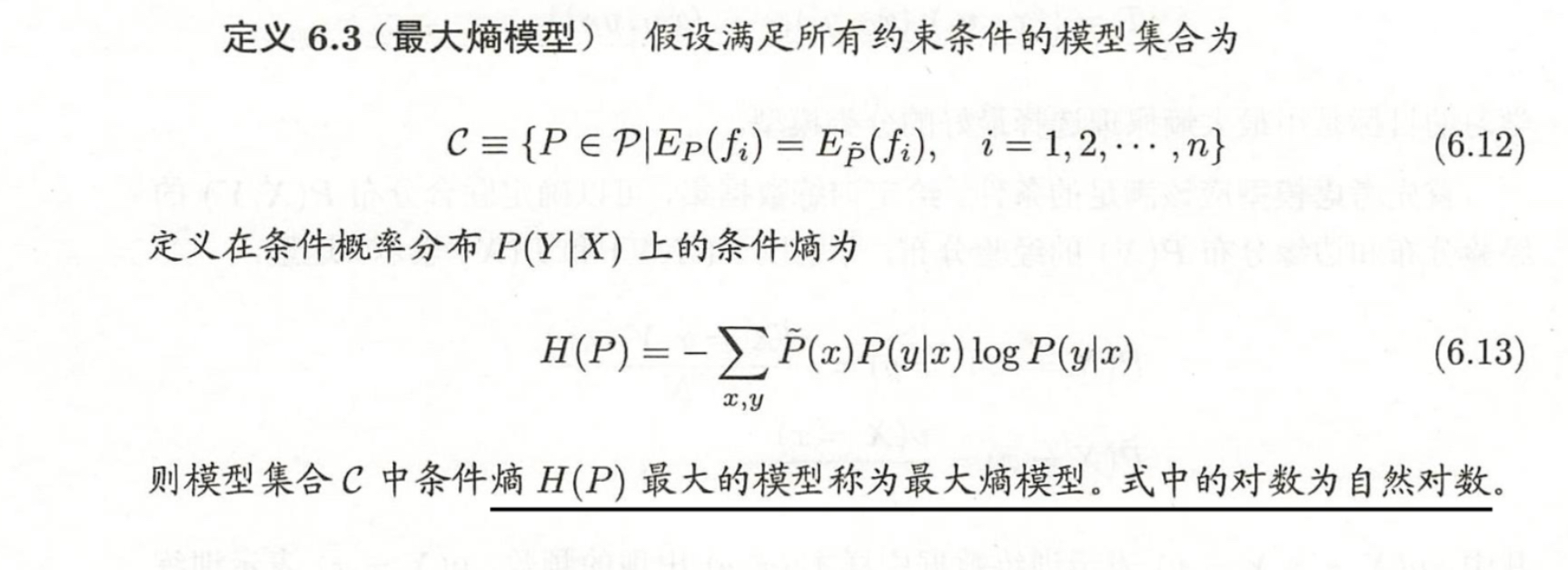

最大熵原理是概率模型学习的一个准则,最大熵原理认为,学习概率模型时,在所有可能的概率模型(分布)中,熵最大的模型是最好的模型

最大熵原理的目标是在已知条件下保持最大不确定性,即概率分布尽可能均匀;而决策树中的信息增益虽然也使用了熵相关的信息,但其目标是通过特征划分减少不确定性,即选择能够最大化降低熵的特征;于是最大熵原理通常用于构建概率模型,而信息增益一般用于决策树的特征选择,构建高效的分类树

浙公网安备 33010602011771号

浙公网安备 33010602011771号