数学基础

向量

一个向量时一列数,这些数是有序排列的

用符号 - 表示集合的补集中的索引,例如\(\boldsymbol{x}_{-1}\)表示\(\boldsymbol{x}\)中除\(x_1\)外的所有元素

张量

坐标超过两维的数组

矩阵

特殊矩阵

满秩矩阵:rank(A)=min(m,n)

正定矩阵:是一个对称矩阵,满足所有特征值都为正,同时所有的主子式也都是正数

正定矩阵满足$x^\top A x = 0 \Rightarrow x = 0$

秩

矩阵乘积的秩小于任意一个乘子的秩

迹

主对角线上的元素之和,即 \(tr(A)=\sum_{i=1}^{n}A_{ii}\),由定义可以得到

- \(tr(A^T)=tr(A)\)

- \(tr(A+B)=tr(A)+tr(B)\)

- \(tr(AB)=tr(BA)\)

可逆矩阵

要求矩阵必须是一个方阵,同时所有列都是线性无关的

一个列向量线性相关的方阵被称为奇异的

范数

范数是一种函数,将向量或者矩阵映射到非负性,同时非负性、齐次性以及三角不等式

常见的范数:

- L1范数是向量中各元素绝对值之和,倾向于令某些特征权重为0,从而实现稀疏性

- L2范数是各元素平方和的平方根,对于异常值敏感,且具有良好的数学性质

- L0范数是向量中非零元素的个数,直接衡量向量的稀疏性

- Frobenius范数是将矩阵张成向量后的L2范数,可用于权重正则化

范数可以视作用来衡量向量大小,直观上来说,向量\(\boldsymbol{x}\)的范数衡量从原点到点\(\boldsymbol{x}\)的距离

导数

矩阵A对于标量x的导数以及x对于A的导数都是矩阵

- \((\frac{\partial A}{\partial x})_{ij}=\frac{\partial A_{ij}}{\partial x}\)

- \((\frac{\partial x}{\partial A})_{ij}=\frac{\partial}{\partial A_{ij}}\)

对于函数f(x),若其对向量的元素可导,那么f(x)关于x的一阶导数是一个向量,第i各分量是

- \((\nabla f(\mathbf{x}))_i=\frac{\partial f(\mathbf{x})}{\partial x_i}\)

f(x)关于x的二阶导数是称为海森矩阵(Hessian matrix)的一个方阵,第i行j列上的元素是

- \((\nabla^2 f(\mathbf{x}))_{ij}=\frac{\partial ^2 f(\mathbf{x})}{\partial x_i \partial x_j}\)

有时需要计算输入和输出都为向量的函数的所有偏导数。包含所有这样的偏导数的矩阵被称为 Jacobian 矩阵

具体来说,如果我们有一个函数:\(f: \mathbb{R}^m \rightarrow \mathbb{R}^n\),f的 Jacobian 矩阵\(J \in \mathbb{R}^{n \times m}\)定义为\(J_{i,j} = \frac{\partial}{\partial x_j} f(\mathbf{x})_i\)。

二阶导数是对曲率的衡量,它能表示只基于梯度信息的梯度下降步骤是否会产生如我们预期的那样大的改善

Hessian 等价于梯度的 Jacobian 矩阵

由于微分算子在任何二阶偏导连续的点处可交换,也就是它们的顺序可以互换,因此Hessian矩阵是实对称的,我们可以将其分解为一组实特征值和一组特征向量的正交基

于是在特定方向 d 上的二阶导数可以写成\(d^THd\)。当 d 是 H 的一个特征向量时,这个方向的二阶导数就是对应的特征值。对于其他的方向d,方向二阶导数是所有特征值的加权平均, 权重在 0 和 1 之间, 且与 d 夹角越小的特征向量的权重越大。最大特征值确定最大二阶导数,最小特征值确定最小二阶导数

二阶导数还能用来确定一个临界点是否是局部极大点、局部极小点或者鞍点,这称为二阶导数测试

在多维情况下,可以利用 Hessian 的特征值分解,将二阶导数测试扩展到多维情况

在临界点处(梯度为0),通过检测Hessian的特征值来判断该临界点是一个局部极大点、局部极小点还是鞍点。 当 Hessian 是正定的(所有特征值都是正的), 则该临界点是局部极小点。因为方 向二阶导数在任意方向都是正的,参考单变量的二阶导数测试就能得出此结论。

如果 Hessian 的特征值中至少一个是正的且至少一个是负的,那么 x 是 f 某个横截面的局部极大点,却是另一个横截面的局部极小点。

特征值分解

正如通过分解质因数来发现整数的一些性质,也可以通过分解矩阵来得到一些性质

特征分解是其中的一种形式,将矩阵分解为一组特征向量和特征值

方阵\(\mathbf{A}\)的特征向量是指和\(\mathbf{A}\)相乘后相当于对该向量进行缩放的非零向量\(\boldsymbol{x}\):

假设矩阵\(\mathbf{A}\)有n个线性无关的特征向量\(\{v^{(1)}, \ldots, v^{(n)}\}\),对应着特征值\(\{\lambda_1, \ldots, \lambda_n\}\)。我们将特征向量连接成一个矩阵,使得每一列是一个特征向量:\(V = [v^{(1)}, \ldots, v^{(n)}]\)

类似地,我们也可以将特征值连接成一个向量\(\lambda = [\lambda_1, \ldots, \lambda_n]^\top\)。因此\(\mathbf{A}\)的特征分解可以记作

每个实对称矩阵都可以分解成实特征向量和实特征值:

其中Q是A的特征向量组成的正交矩阵,\(\Lambda\)是对角矩阵。特征值\(\Lambda_{i,i}\)对应的特征向量是矩阵Q的第 i列,记作\(Q_{.,i}\)。因为Q是正交矩阵,我们可以将A看作沿方向\(v^{(i)}\)延展$\lambda_i$倍的空间

虽然任意一个实对称矩阵A都有特征分解,但是特征分解可能并不唯一。如果两个或多个特征向量拥有相同的特征值,那么在由这些特征向量产生的生成子空间中,任意一组正交向量都是该特征值对应的特征向量。因此,我们可以等价地从这些特征向量中构成Q作为替代。按照惯例,我们通常按降序排列A的元素。在该约定下,特征分解唯一当且仅当所有的特征值都是唯一的。

矩阵的特征分解给了我们很多关于矩阵的有用信息。

矩阵是奇异的当且仅当含有零特征值。实对称矩阵的特征分解也可用于优化二次方程\(f(x) = x^\top A x\),其中限制\(\|x\|_2 = 1\)。当x等于A的某个特征向量时,f将返回对应的特征值。在限制条件下,函数f的最大值是最大特征值,最小值是最小特征值。

奇异值分解(SVD)

任意实矩阵\(A\in\mathbb{R}^{m\times n}\)都可以分解为:

- \(A = U \Sigma V^{\mathrm{T}}\)

当A为对称正定矩阵时,奇异值分解与特征值分解结果相同

\(U\)的列向量称为A的左奇异向量,\(V\)的列向量称为A的右奇异向量,\(\sum\)是一个对角矩阵,其中的元素称为奇异值(一般将奇异值降序排列以保证\(\sum\)的唯一性)

矩阵A的秩等于非零奇异值的个数

运算

两个矩阵的元素对应乘积或者Hadamard乘积记作\(\mathbf{A} \odot \mathbf{B}\)

维数相同的向量\(\boldsymbol{x}\)和\(\boldsymbol{y}\)的点积可以看作是矩阵乘积\(\boldsymbol{x}^T\boldsymbol{y}\)

矩阵乘积服从分配律、结合律但不满足交换律,两个向量的点积满足交换律

优化

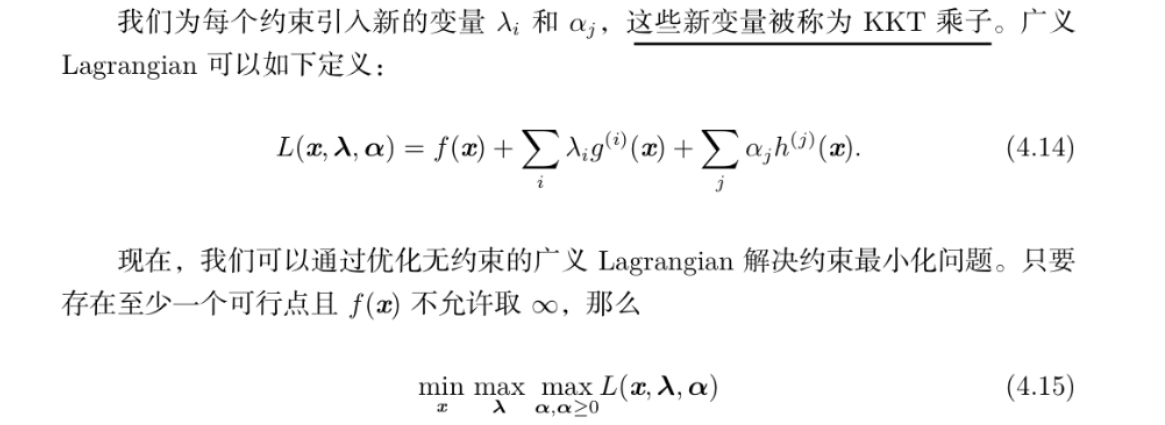

拉格朗日乘子法

通过引入拉格朗日乘子,可以将有d个变量和k个约束条件的最优化问题转化为具有d+k个变量的无约束优化问题

也就是设计一个不同的、无约束的优化问题,其解可以转化成原始约束优化问题的解

对于等式约束的问题,从几何角度看,是在g(x)=0确定的d-1维曲面上寻找能使目标函数f(x)最小化的点,于是有:

- 在最优点\(\mathbf{x}^{\mathbf{*}}\),目标函数在该点的梯度\(\nabla f(\mathbf{x}^{\mathbf{*}})\)正交于约束曲面

(若不正交,则梯度可以分解维曲面法向量和曲面上向量,也就是可以沿着曲面继续移动,于是该点不是最优点)

活跃约束定义了可行域的边界,并且在最优点上起作用,最优解也必须位于这些边界上。目标函数的梯度在最优点处必须与这些活跃约束的梯度方向一致,这意味着目标函数在最优解处不能沿任何方向增加,从而确保最优解是最小值。

非活跃约束在最优点并未形成边界限制,因此其对应的拉格朗日乘子 λ i=0,对目标函数的优化方向没有影响

可以使用一组简单的性质来描述约束优化问题的最优点。这些性质称为KKT条件

这些是确定一个点是最优点的必要条件,但不一定是充分条件。这些条件是:

- 广义 Lagrangian 的梯度为零。

- 所有关于 x 和 KKT 乘子的约束都满足。

- 不等式约束显示的 ‘‘互补松弛性’’:α ⊙ h(x) = 0。

梯度下降法

梯度下降法是一种一阶优化方法,也就是仅使用目标函数的一阶导数,不利用高阶导数

本质是利用泰勒展式的一阶形式来判断自变量增量对原函数的影响,\(f(x+\Delta x) \approx f(x)+\Delta x^T \nabla f(x)\),于是如果\(f(x+\Delta x) < f(x)\),则可选\(\Delta(x) = - \gamma \nabla f(x)\)

如果f(x)二阶可微,那么可以替换成二阶展式,也就是牛顿法的形式

坐标下降(上升)法

每次迭代中选择一个坐标方向进行搜索,通过循环使用不同的坐标方向来达到目标函数的局部最小值

即,\(\mathbf{x}^{t+1}\)的第i个分量\(x^{t+1}_{i}\)构造为\(x^{t+1}_{i}=\underset{y \in \mathbb{R}}{argmin} f(x_1^{t+1},\ldots,x_{i-1}^{t+1},y,x_{i+1}^{t+1},\ldots,x_d^t)\),y是本轮要更新的参数,y之前是本轮已经更新完毕的参数,而y之后是还未更新的参数

目标函数不光滑的情况下,梯度下降法可能陷入非驻点

正规方程

通过求偏导的得到的使MSE最小化的系统方程称为正规方程,如:\(\mathbf{w} = \left( \mathbf{X}^{(\text{train})^\top} \mathbf{X}^{(\text{train})} \right)^{-1} \mathbf{X}^{(\text{train})^\top} \mathbf{y}^{(\text{train})}\)

上面这个形式是针对于线性回归模型的,但实际上对于x的二次函数模型,正规方程仍然是成立的

即,若模型\(\hat{y}=b+w_1x+w_2x^2\),尽管模型是输入的二次函数,但输出仍然是参数的线性函数(指对参数\(w1,\lodts,w_n\)是线性的,但是对输入特征不是线性的),因此仍然可以用正规方程得到模型的闭解

概率

直接与时间发生的频率相联系,称为频率派概率;涉及到确定性水平,称为贝叶斯概率

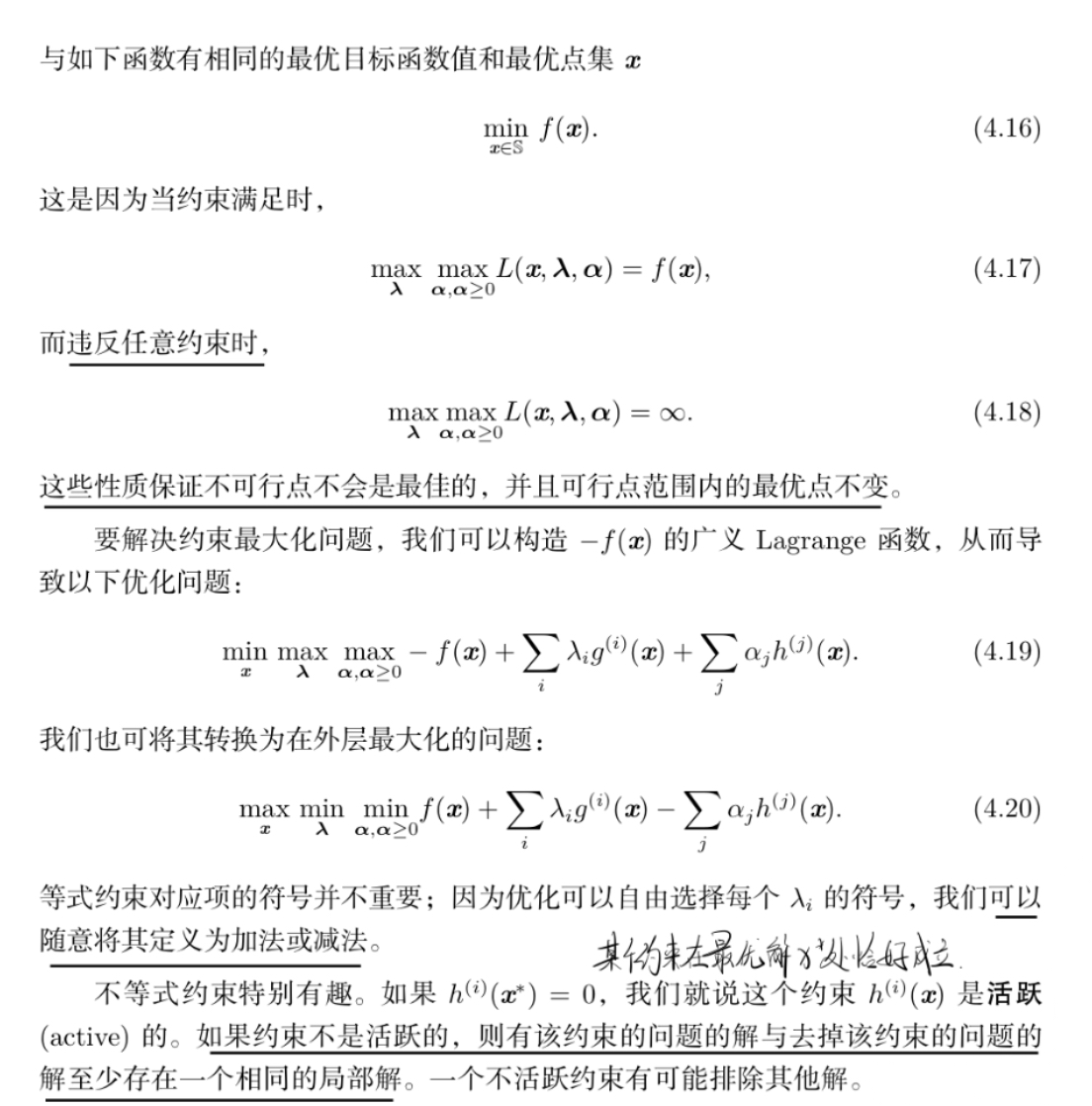

条件概率的链式法则

共轭分布

假设变量 x 服从分布$ P(x \mid \Theta)$,其中 \(\Theta\) 为参数, $X = {x_1, x_2, \ldots, x_m} $ 为变量 x 的观测样本,假设参数 \(\Theta\) 服从先验分布 \(\Pi(\Theta)\)。若由先验分布 \(\Pi(\Theta)\)和抽样分布\(P(X \mid \Theta)\)决定的后验分布\(F(\Theta \mid X)\)与\(\Pi(\Theta)\)是同种类型的分布,则称先验分布\(\Pi(\Theta)\) 为分布 \(P(x \mid \Theta)\)或$P(X \mid \Theta) $的共轭分布

当先验信息和样本提供的信息共轭时,后验分布与先验分布属于同种类型,这意味着先验信息与样本提供的信息具有某种同一性,于是使用后验分布作为进一步抽样的先验分布,那么新的后验分布仍然属于同种类型

KL散度

度量两个概率之间的差异

\(KL(p \parallel q) = \int p(x) \log\frac{p(x)}{q(x)} dx\)

也可以表示成:\(D_{\text{KL}}(P \parallel Q) = \mathbb{E}_{x \sim P} \left[ \log \frac{P(x)}{Q(x)} \right] = \mathbb{E}_{x \sim P}[\log P(x) - \log Q(x)].\)

KL散度仅满足非负性但不满足对称性,从而KL散度并非一个度量;因为 KL 散度是非负的并且衡量的是两个分布之间的差异,它经常被用作分布之间的某种距离

KL散度又称相对熵,量化了当一个概率分布用于近似另一个概率分布时所丢失的信息

交叉熵

与KL散度密切联系,\(H(P,Q)=H(P)+D_{KL}(P || Q)\),它和KL散度很像但是缺少左边一项:\(H(P,Q)=-\mathbb{E}_{x \sim P} log Q(x)\)

针对 Q 最小化交叉熵等价于最小化 KL 散度,因为 Q 并不参与被省略的那一项

KL散度衡量了使用 Q 近似 P 时所丢失的信息量,即 P 和 Q 之间的“额外信息量”

交叉熵衡量了使用 Q 来编码 P 所需的平均信息量,即 P 的熵与 P 和 Q 之间的KL散度之和

一致性

一般我们希望当当数据集中数据点的数量m增加时,点估计会收敛到对应参数的真实值

渐进无偏性:期望值趋近于真实值。

一致性:估计量依概率收敛于真实值。

渐进无偏性不保证一致性,因为即使期望值趋近于真实值,若方差不趋近于零,估计量仍可能不一致。

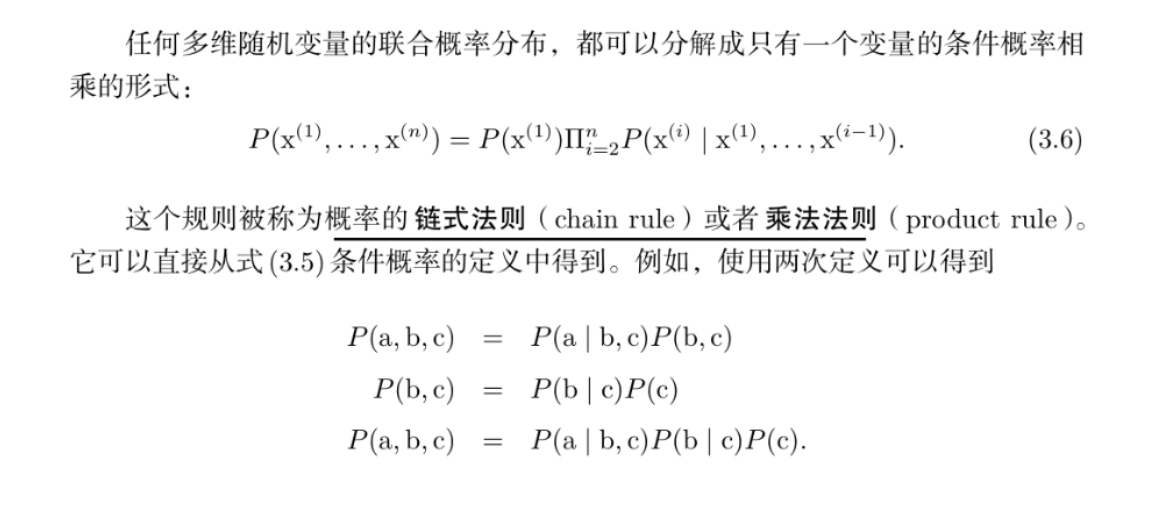

连续型变量的处理

常用函数

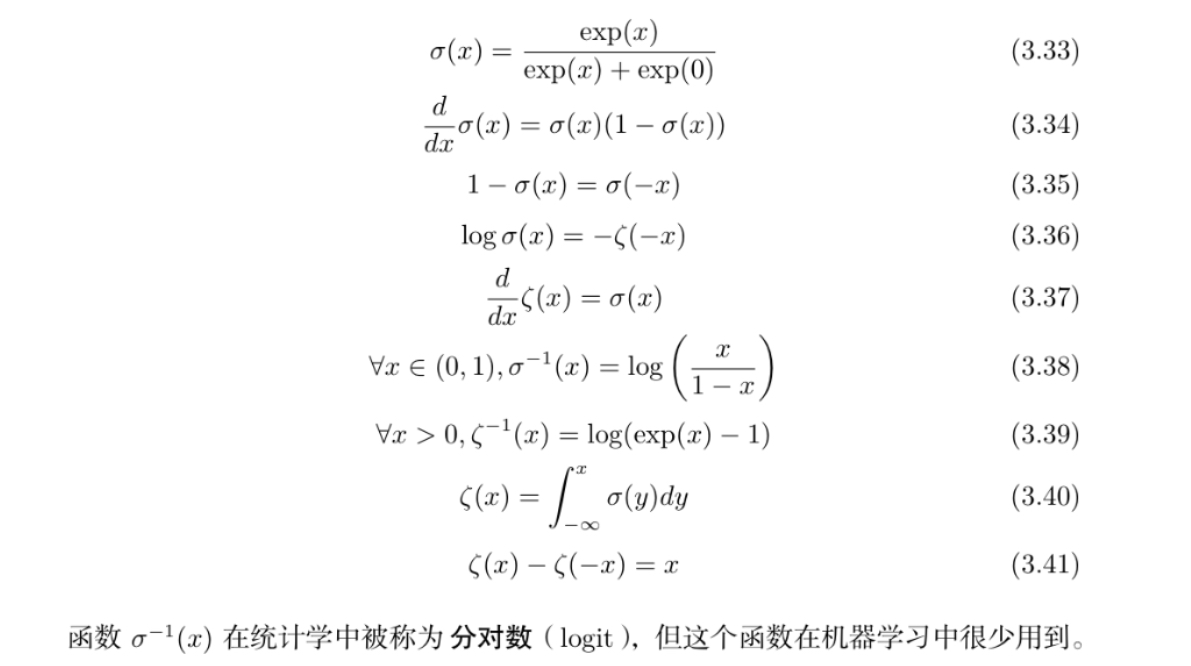

logistic sigmoid 函数

通常用来产生Bernoulli分布中的参数\(\phi\),因为它的范围是(0,1),处在\(\phi\)的有效取值范围内

sigmoid 函数在变量取绝对值非常大的正值或负值时会出现饱和现象,意味着函数会变得很平,并且对输入的微小改变会变得不敏感。

softplus函数

softplus 函数可以用来产生正态分布的 β 和 σ 参数,因为它的范围是 (0, ∞)。 当处理包含 sigmoid 函数的表达式时它也经常出现

softpilus函数的性质:

浙公网安备 33010602011771号

浙公网安备 33010602011771号