本地部署 DeepSeek-R1 模型

霸屏的AI

最近在刷视频的时候,总是突然突然出现一个名叫 DeepSeek 的玩意,像这样:

这样:

这不经激起我的一顿好奇心,这 DeepSeek 到底是个什么玩意

DeepSeek是什么?

这突然冒出来的AI,更加让我好奇了,随着ChatGPT席卷全球,已经是一两年前的事情了,这次出现的 DeepSeek 究竟有什么魅力。在好奇心的驱使下,我打开了他的官网。

嗯?国产的?这好像也没啥新奇的,毕竟国内早就有文心一言、星火等同类的产品了。

桥豆麻袋,github 上怎么也会有同名项目。

难道是开源的?这怎么不可能呢?从来没见过那个大模型是开源的。

阿这?真的是开源的。开源就开源吧。难不成我本地还能运行的起来?就我这8G的显存,还是有点自信的

这。。不能够吧,我的电脑可以运行AI了???那这高低得试试看了

安装DeepSeek

在网上逛了一圈,只是体验的话,就不去整源码了。直接用 ollama 似乎比较方便点。官网的界面也很直接,没有什么乱七八糟的东西

直接根据自己的系统下载就可以了,安装也简单,无脑下一步下一步就行了

我这里已经安装过了,就不重复安装了。各位安装好之后,打开命令窗口,输入 ollama -v 验证是否安装成功,出现样子的信息,就是安装成功了

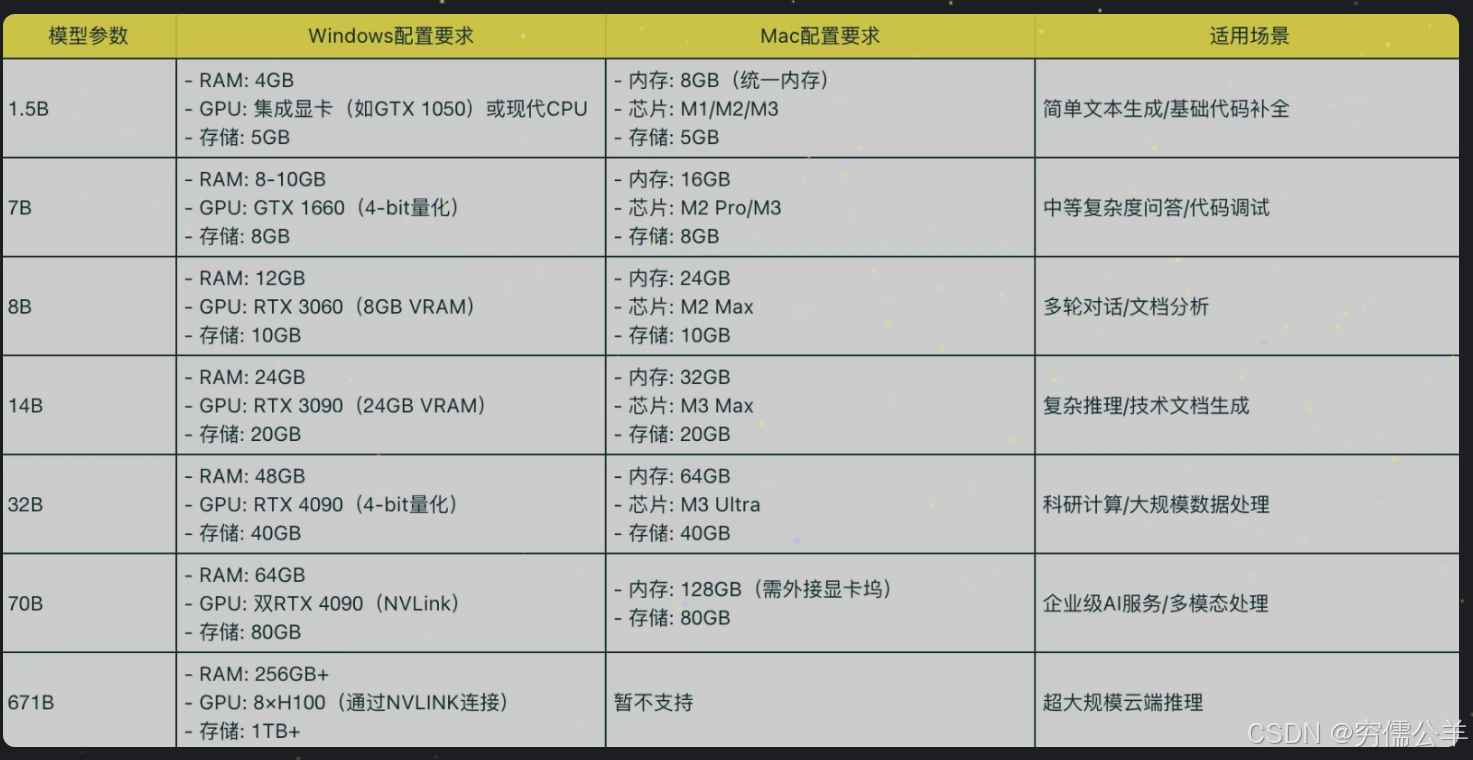

ollama 安装完成之后,接着就需要下载模型了,ollama 已经整合了 DeepSeek 相关模型了,大家可以根据自己的电脑配置进行选择

如果大家的电脑是近几年出的,应该都能够到中配置的门槛,不过这里为了演示方便,我就直接用1.5b最小模型,大家可以根据自己的配置进行选择。在命令行中,直接输入ollama run deepseek-r1:1.5b

下载完成后,就会出现这样子的界面,已经可以直接进行对话了

安装图形化界面

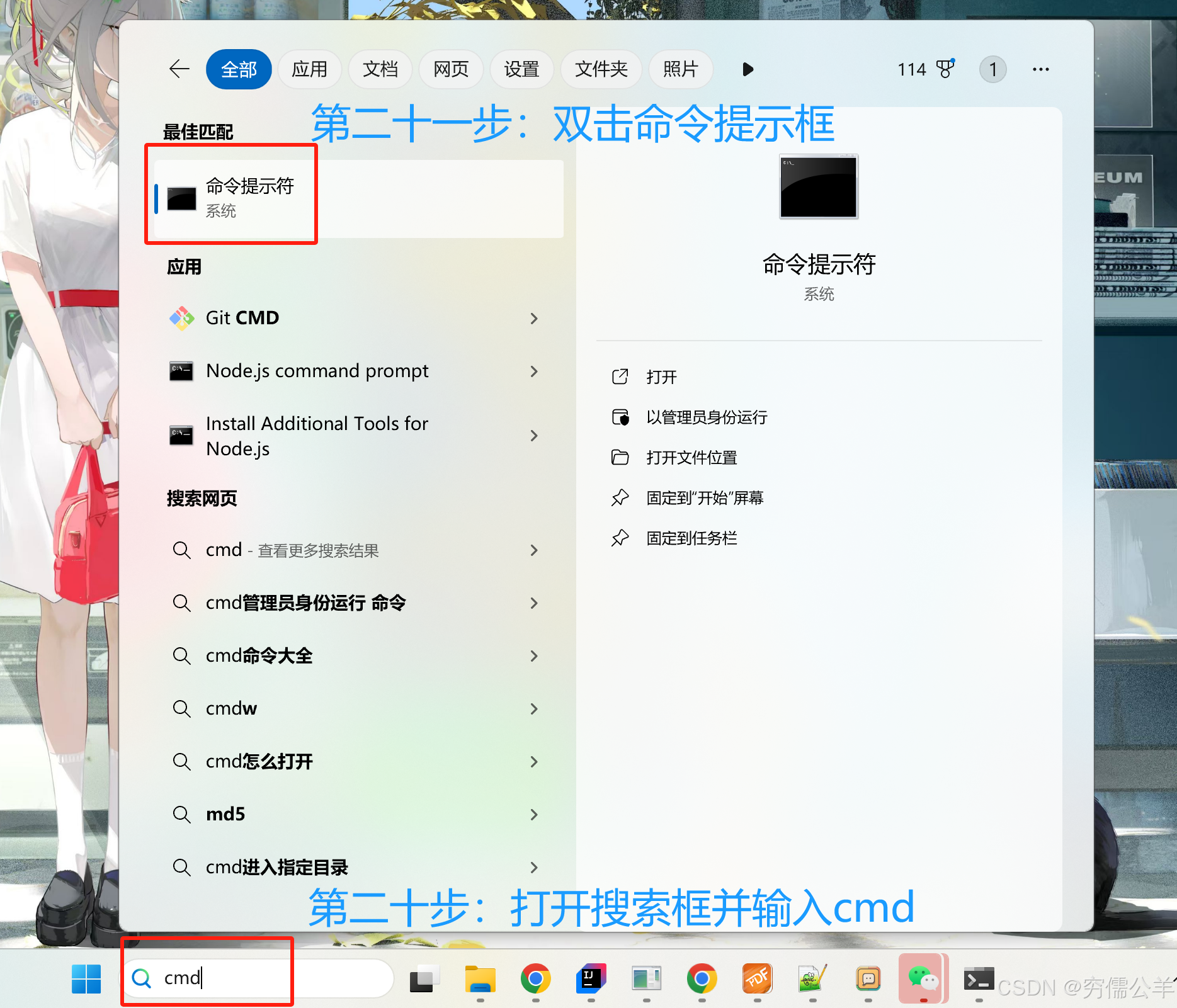

虽然已经可以进行对话了,但是这个黑乎乎的窗口,看着像几十年前的产物,实在令人不爽。网上翻了半天的资料,发现主要的图形化界面有两个:Open WebUI 和 Chatbox。这里我选择用,老样子,去他的官网直接下载即可

安装完成,需要先配置下模型

配置好之后,就可以开始聊天了

额,这都哪跟哪啊,这个模型看起来有点捞啊,如果是官方自己的就不会这么离谱了

远程访问 Ollama 服务

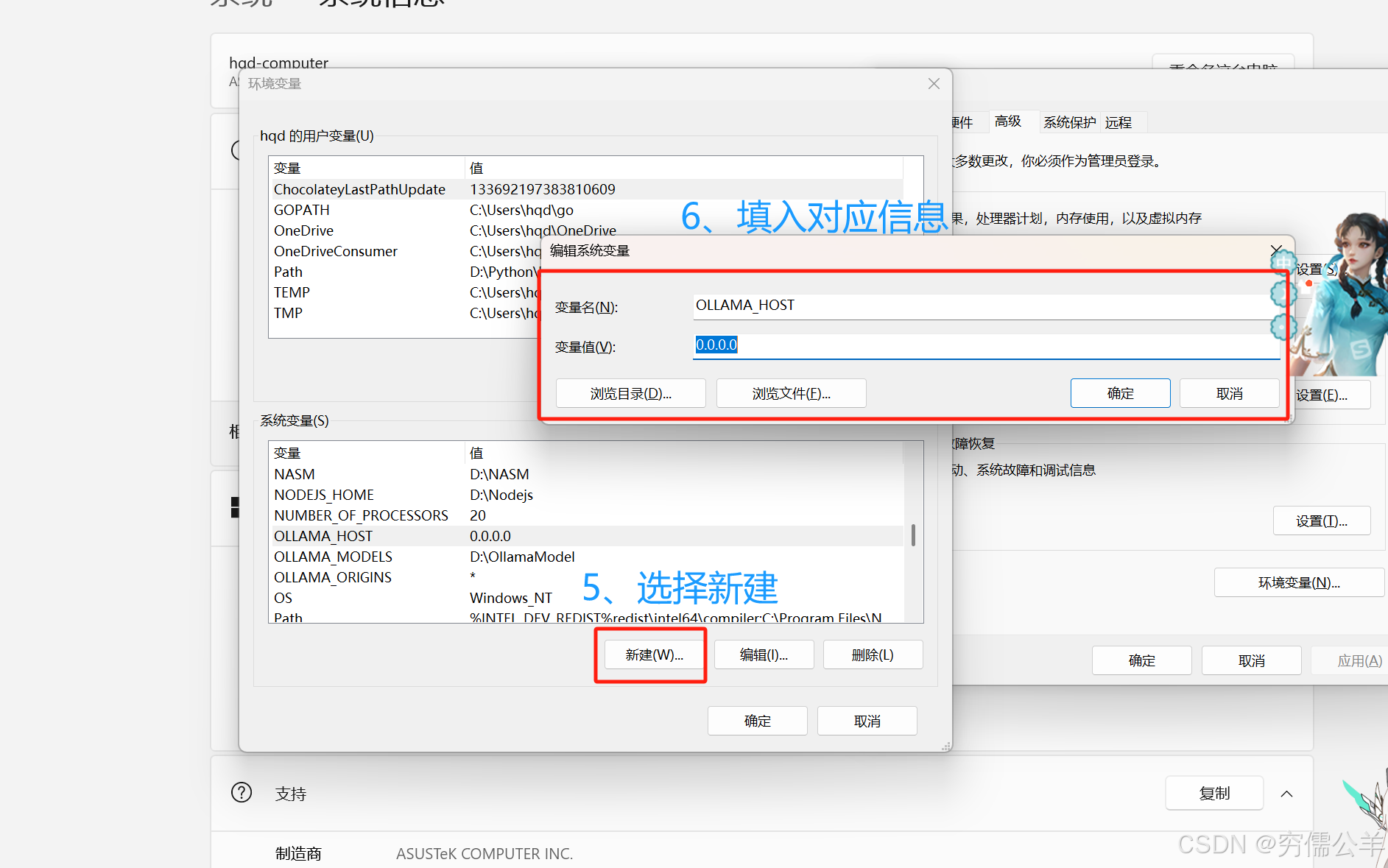

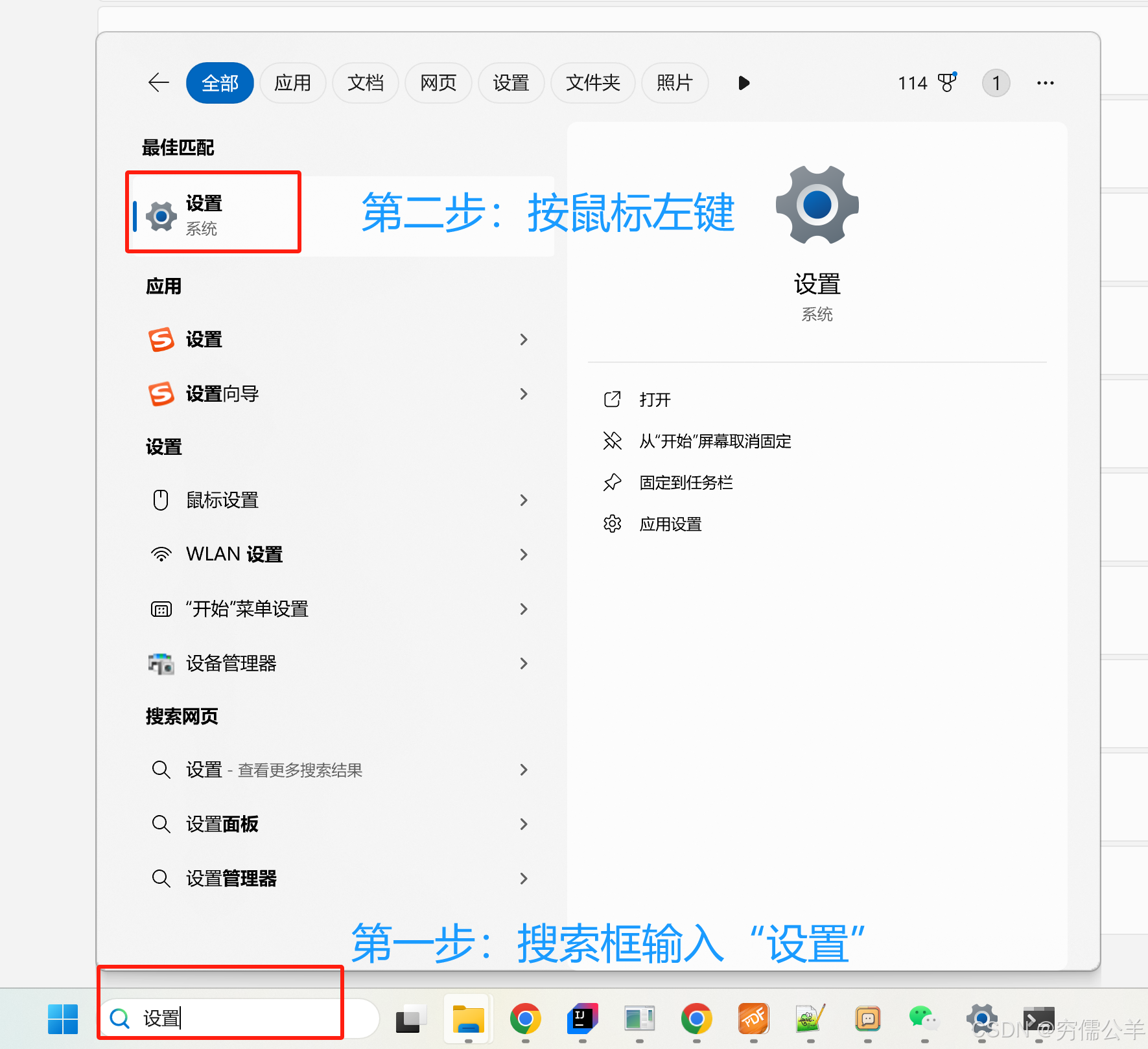

本地模型是部署好了,还有一个小小滴需求,现在每个人几乎都有好几台设备。诸如:手机、平板、办公本云云,自然而然希望每台设备都能用到大模型,总不能每个设备都部署一个吧。一来浪费资源,二来也麻烦。最好是部署在一台算力最强的电脑上,让各个设备都可以访问,起码局域网内如此,当然了,公网也可以,不过要涉及到内网穿透和安全等问题,这里暂时不涉及,先来看下局域网内怎么做到吧

变量名:OLLAMA_HOST

变量值:0.0.0.0

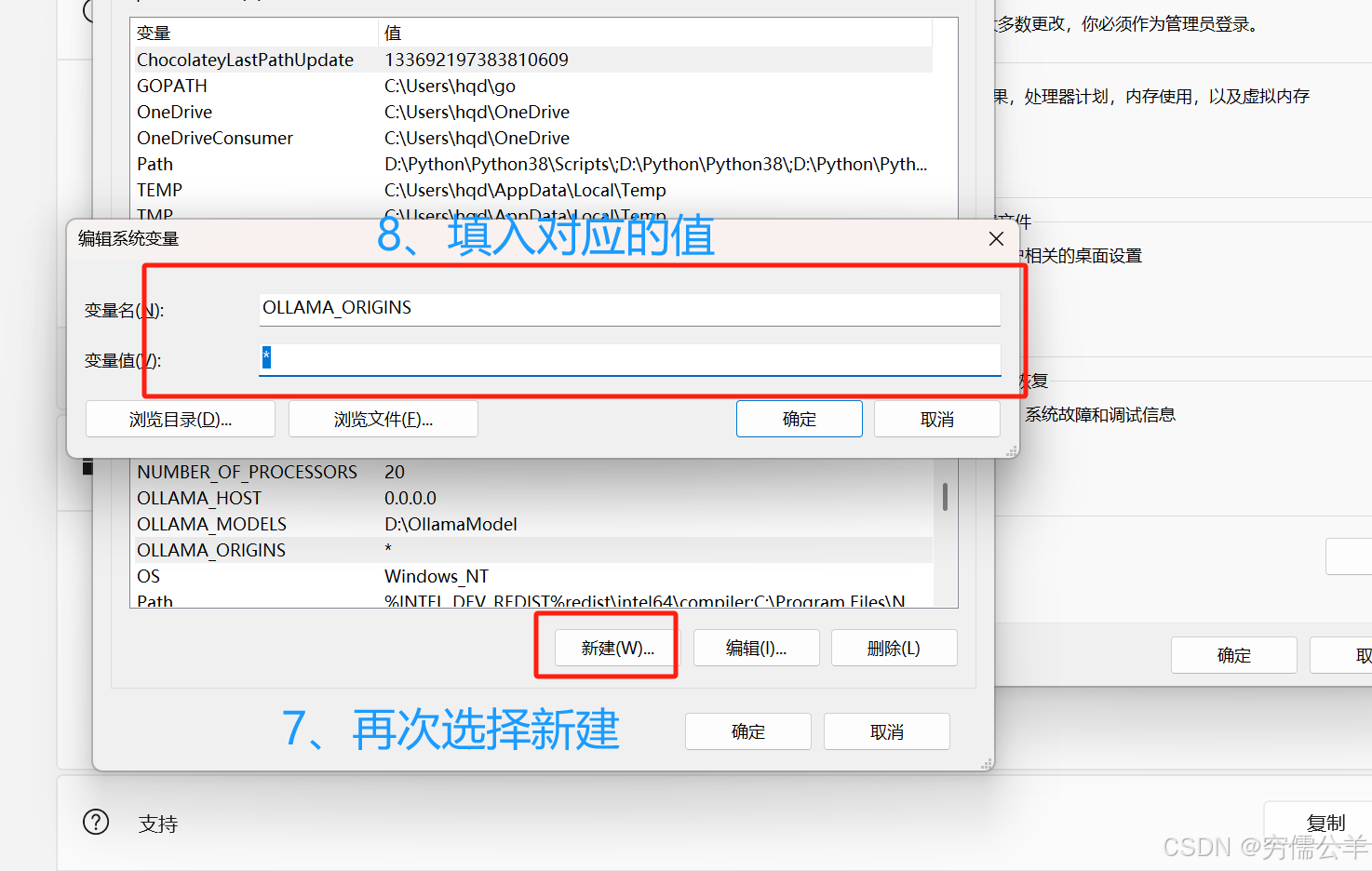

变量名:OLLAMA_ORIGINS

变量值:*

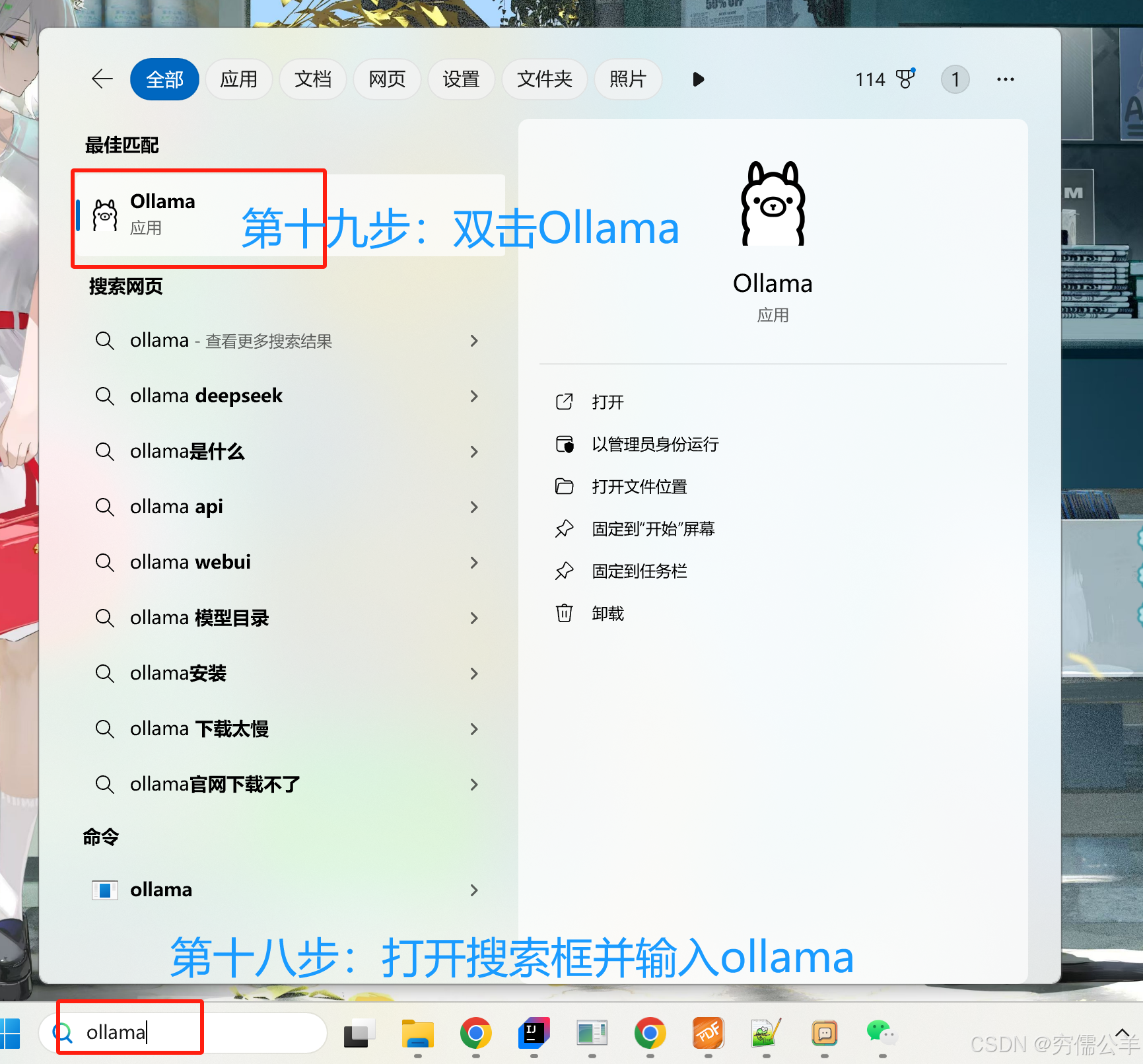

做完这些后,重启下 Ollama 即可。既然说是局域网,首先得保证设备连的是同一个网络,才能继续往下。连上同一个网络后,在配置下 Chatbox

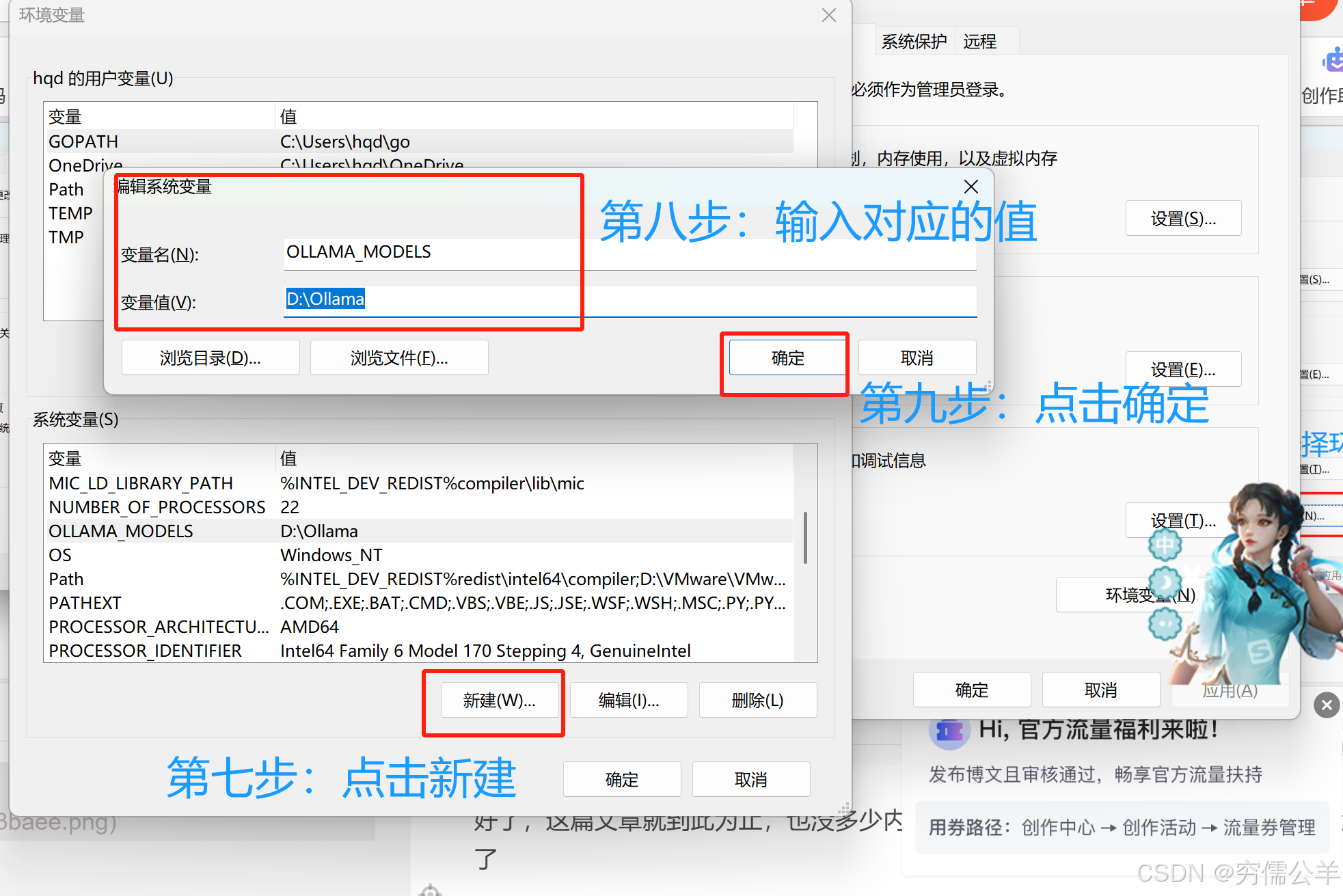

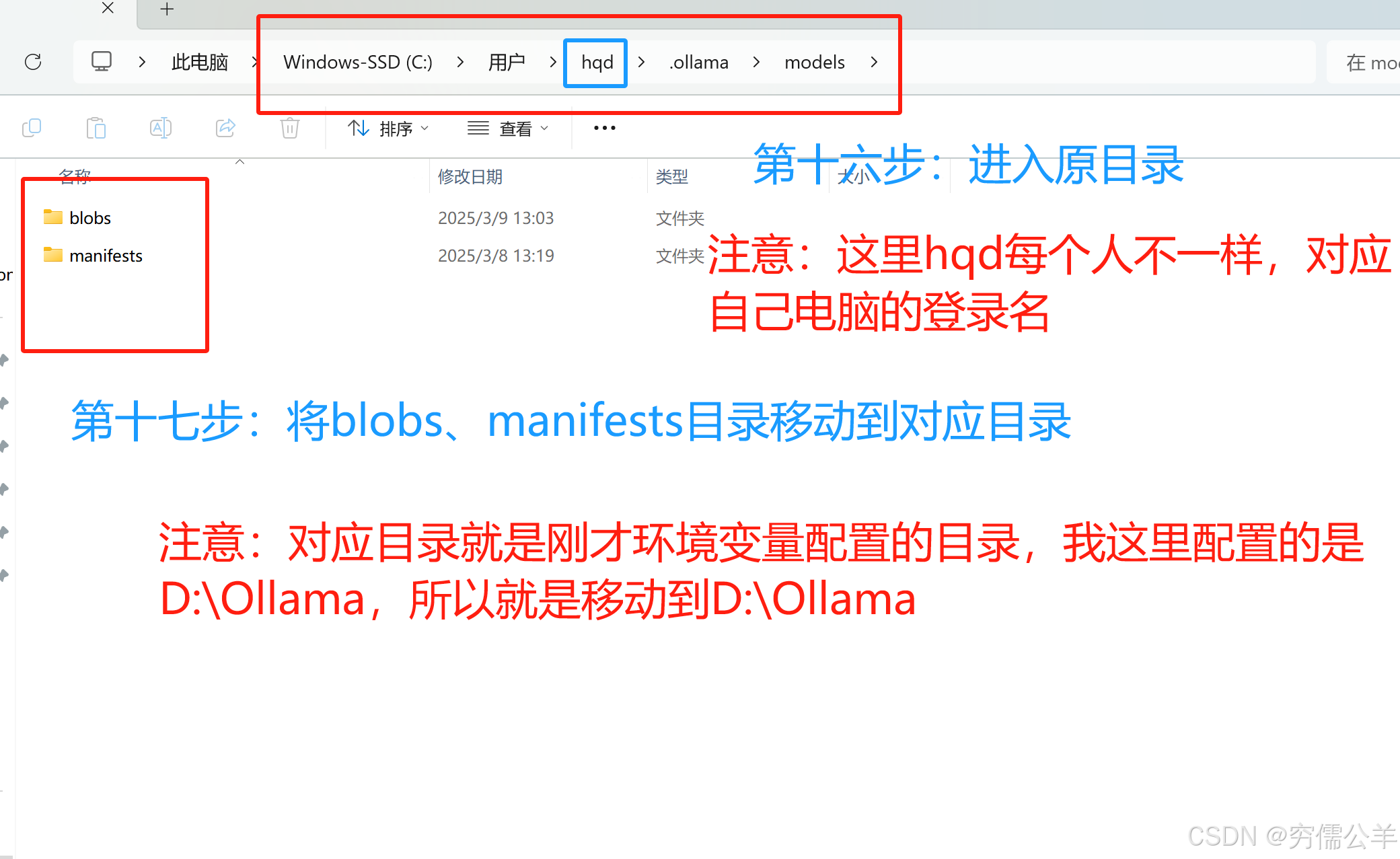

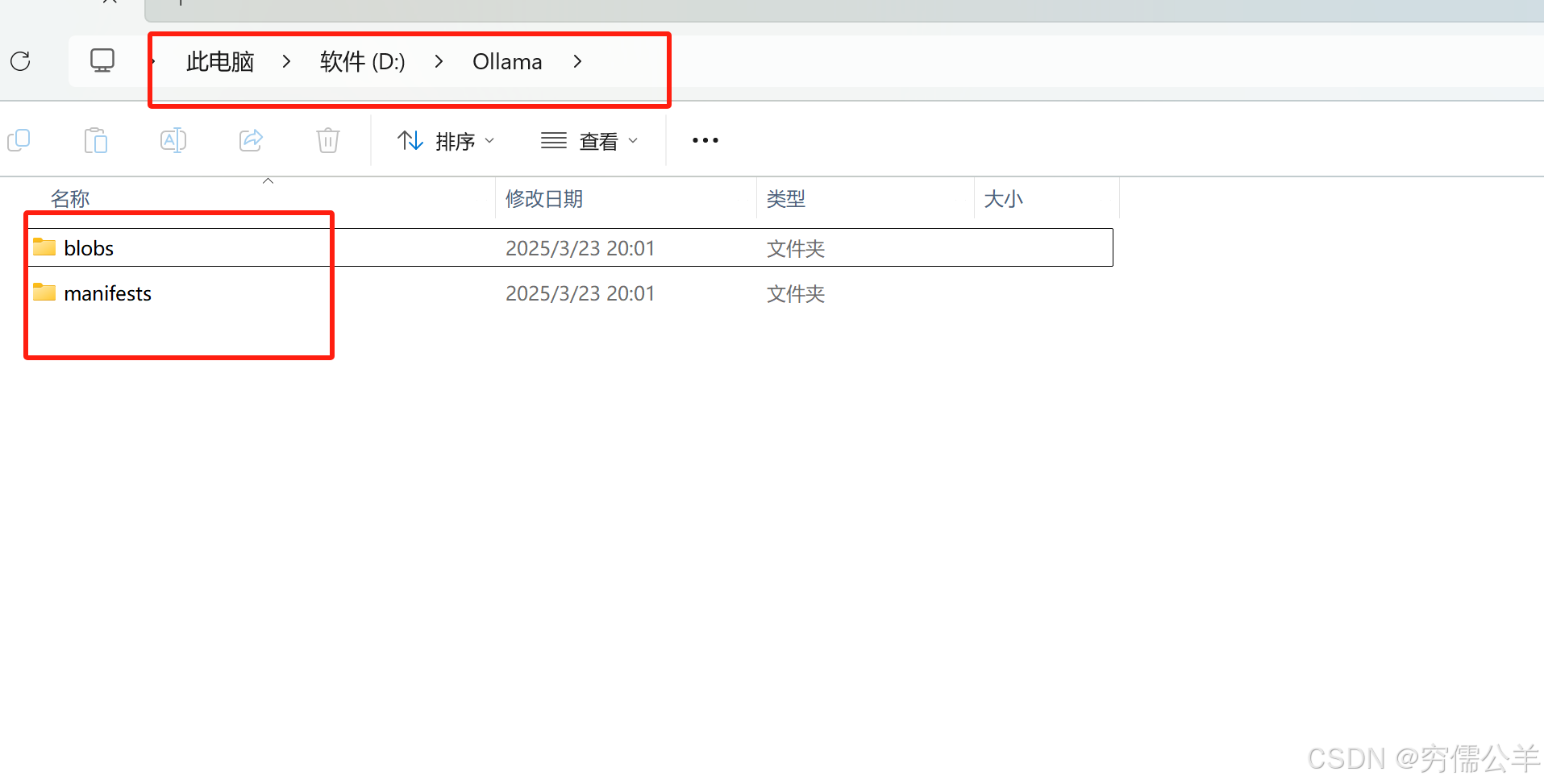

修改模型路径

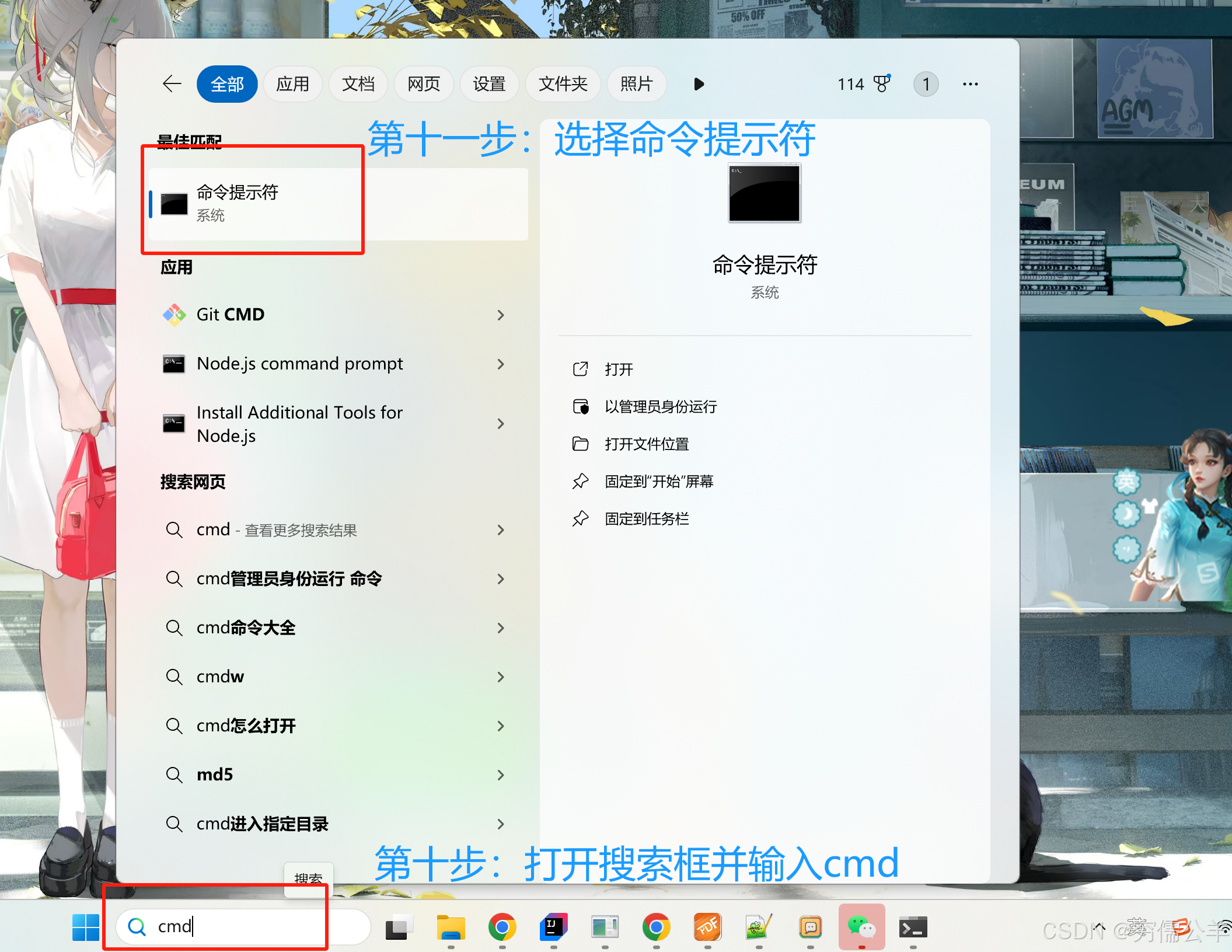

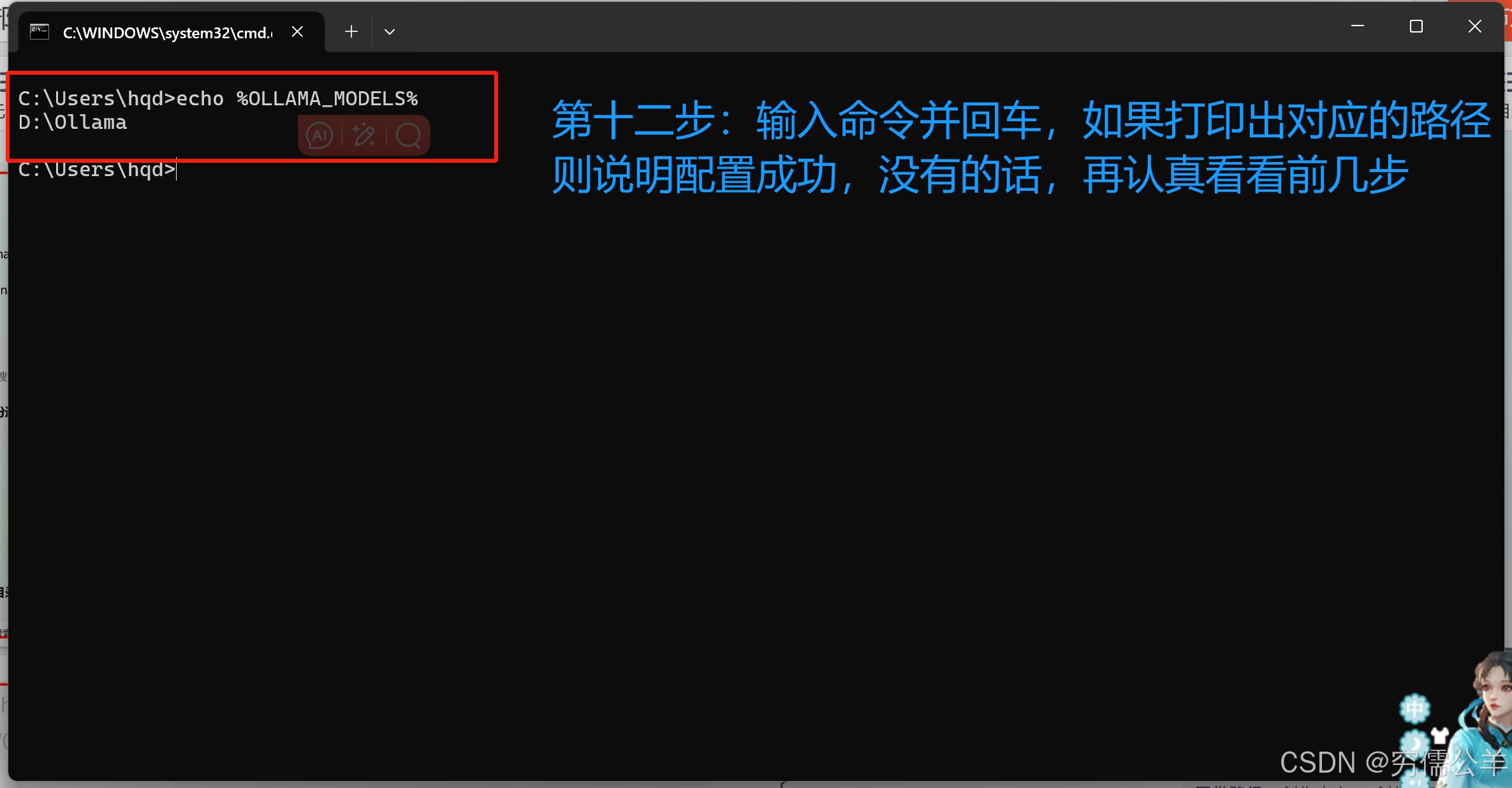

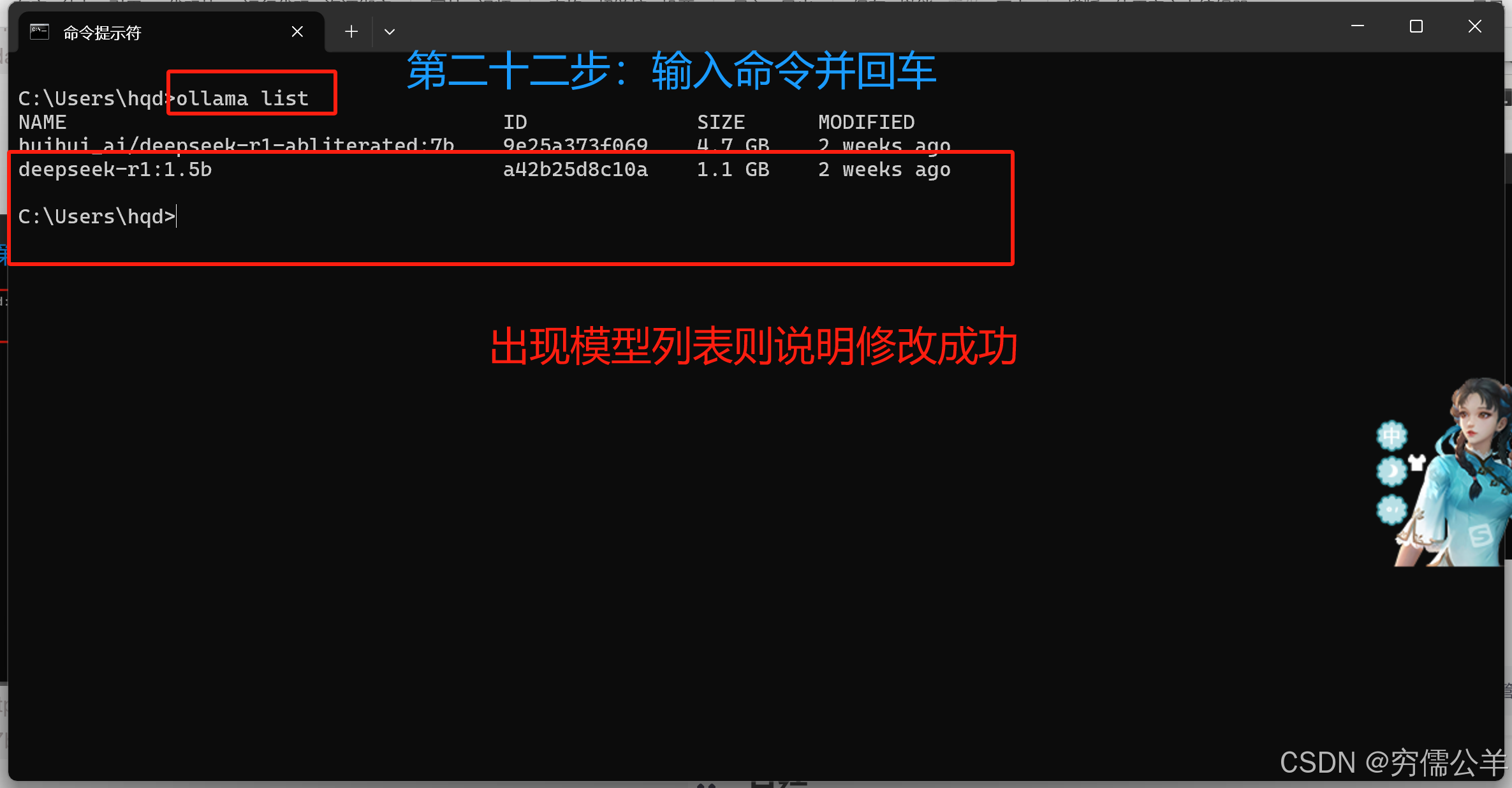

折腾完之后,发现 ollama 模型默认都是在C盘,这怎么能行?必须得把这个路径改过来,在一顿百度之后,发现其实也简单:

变量名:OLLAMA_MODELS

变量值:D:\Ollama

echo %OLLAMA_MODELS%

未经审查(无限制)模型

在 Deepseek 官方发布的模型中,或多或少存在着一些限制,既然是本地部署,自然希望自由一点。为此,需要一些没有限制的模型。多的也不说了。根据自己的电脑配置下载吧

ollama run huihui_ai/deepseek-r1-abliterated:7b

ollama run huihui_ai/deepseek-r1-abliterated:8b

ollama run huihui_ai/deepseek-r1-abliterated:14b

ollama run huihui_ai/deepseek-r1-abliterated:32b

ollama run huihui_ai/deepseek-r1-abliterated:70b

好了,这篇文章就到此为止,也没多少内容,就当抛砖引玉了,更细致的内容就看大家发挥了

总结

这里主要尝试下最近比较火的 DeepSeek,他可以本地部署着实吸引人,这样可以在没有网络的环境下部署AI,意味着一些云内环境可以使用了。故而对此进行了一些调研,稍作记录

浙公网安备 33010602011771号

浙公网安备 33010602011771号