【笔记】深度学习第一课2.2逻辑回归(Logistic Regression)

Hypothesis Function

对于二元分类来说,给定一个输入特征向量$X$,它可能对应一张图片,你想识别这张图片识别看它是否是一只猫或者不是一只猫的图片,这时我们需要一个算法来输出$\hat{y}$,借此来预测,换言之,$\hat{y}$是该图片为猫的概率。下面我们给出该函数:

$$\hat{y} = w^Tx + b$$

其中,$X$为一个$n_x$维向量,$w$为逻辑回归的参数,也是一个$n_x$维向量(本质上是一个特征权重),$b$是一个实数,表示偏置值。

对于二元分类来讲,这个函数是有缺陷的:$\hat{y}$的大小应当在0到1之间,而实际上并不是这样。因此我们需要另一个函数将线性函数转化为非线性函数,这就是sigmoid函数。

sigmoid函数

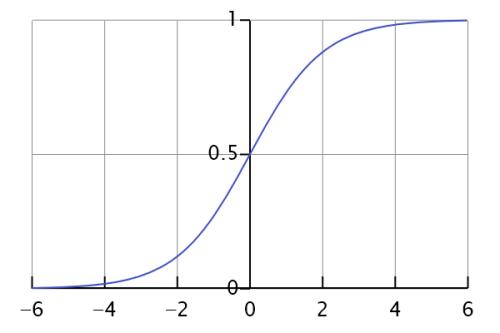

如图为该函数的函数图像,我们把水平轴成为$z$轴,在这里,$z$就是$w^Tx + b$的值。

该函数的表达式为:

$$\sigma (z) = \frac{1}{1 + e^{-z}}$$

顺带一提,该函数的导数为

$$\sigma^` (z) = \frac{e^{-z}}{{(1 + e^{-z})}^2} = \sigma (z) (1 - \sigma (z) )$$

接下我们的工作就是让机器学习参数$w$和$b$。

符号说明

在本课程里,我们将$b$和$w$分开,而不是用$theta$表示。

作者:Roki_

-------------------------------------------

キミが笑うだけで 全回復だもん!

只要能看到你的笑容 就能完全恢复!

努力做一个灵魂有趣的人!

如果觉得这篇文章对你有小小的帮助的话,记得在右下角点个“推荐”哦,博主在此感谢!( ̄▽ ̄)~*

要是打赏一点就更好了(〜 ̄△ ̄)〜(前微信后支付宝)

浙公网安备 33010602011771号

浙公网安备 33010602011771号