ElasticSearch基础+文档CRUD操作

本篇博客是上一篇的延续,主要用来将年前学习ES的知识点做一个回顾,方便日后进行复习和汇总!因为近期项目中使用ES出现了点小问题,因此在这里做一个详细的汇总!

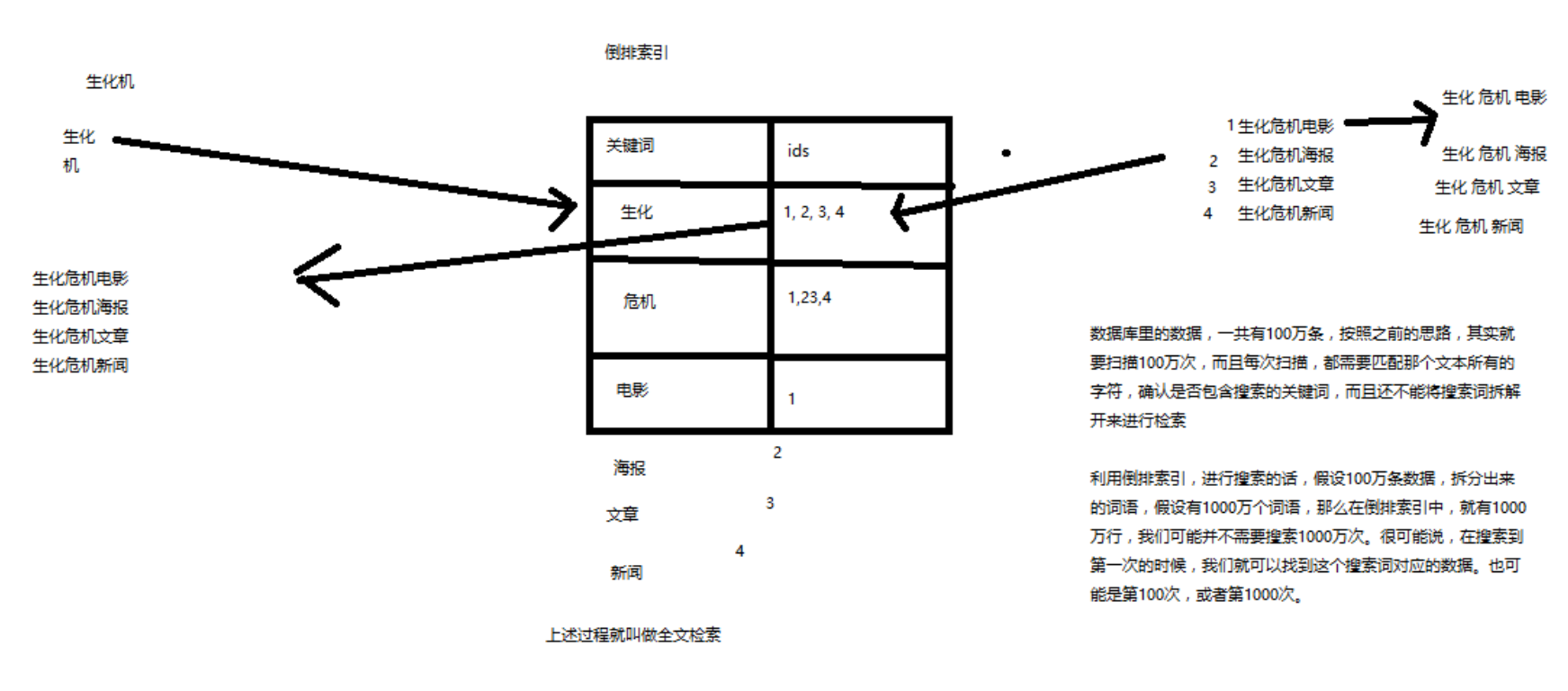

【01】全文检索和Lucene

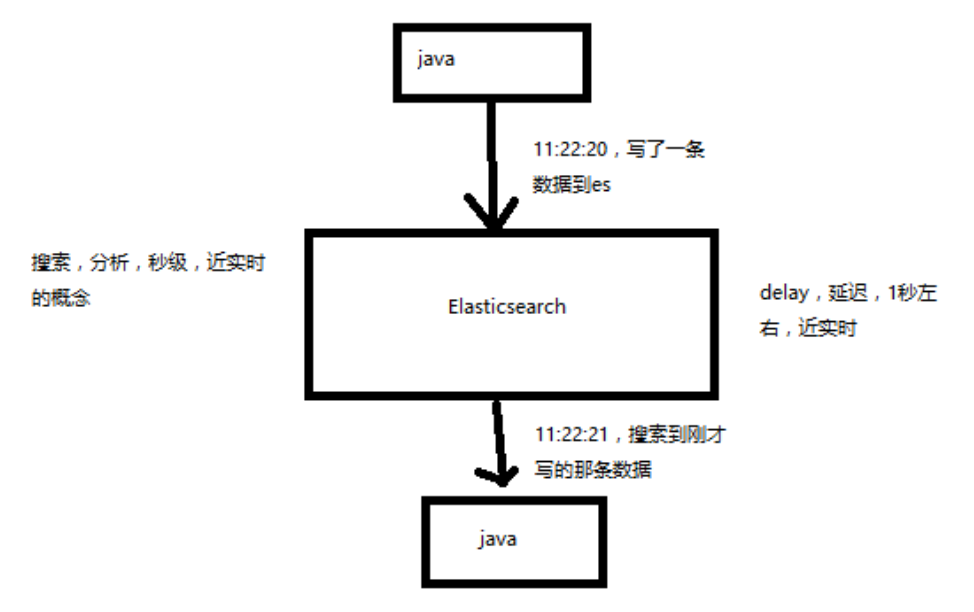

【02】Elasticsearch的功能

【03】Elasticsearch的特点

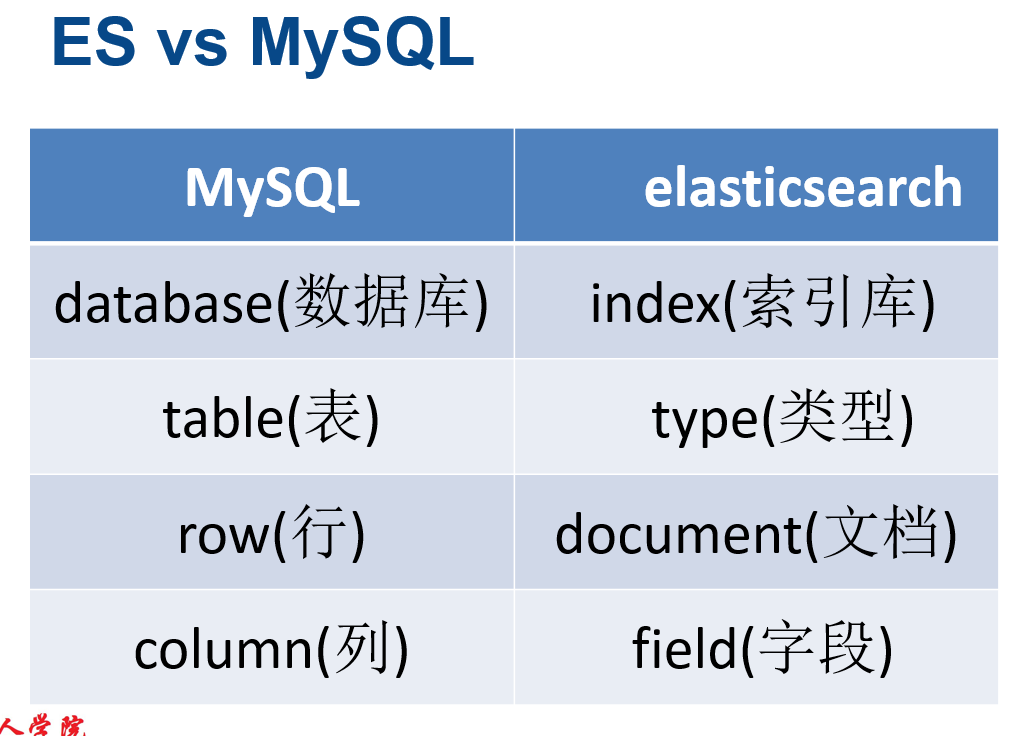

【04】elasticsearch的核心概念

举个稍微形象点的例子:

举个例子:

商品index,里面存放了所有的商品数据,即商品document

但是商品分很多种类,每个种类的document的field可能不太一样,比如说电器商品,可能还包含一些诸如

售后时间范围这样的特殊field;生鲜商品,还包含一些诸如生鲜保质期之类的特殊field

type,日化商品type,电器商品type,生鲜商品type

日化商品type:product_id,product_name,product_desc,category_id,category_name

电器商品type:product_id,product_name,product_desc,category_id,category_name,service_period

生鲜商品type:product_id,product_name,product_desc,category_id,category_name,eat_period

每一个type里面,都会包含一堆document

{

"product_id": "2",

"product_name": "长虹电视机",

"product_desc": "4k高清",

"category_id": "3",

"category_name": "电器",

"service_period": "1年"

}

{

"product_id": "3",

"product_name": "基围虾",

"product_desc": "纯天然,冰岛产",

"category_id": "4",

"category_name": "生鲜",

"eat_period": "7天"

}

因此归根结底就是index里面有很多个Type,而每个type又有很多document。即一个数据库(index)中有很多表(type),每张表中又有很多行数据(document)

下面再来看ES中的两个核心概念:

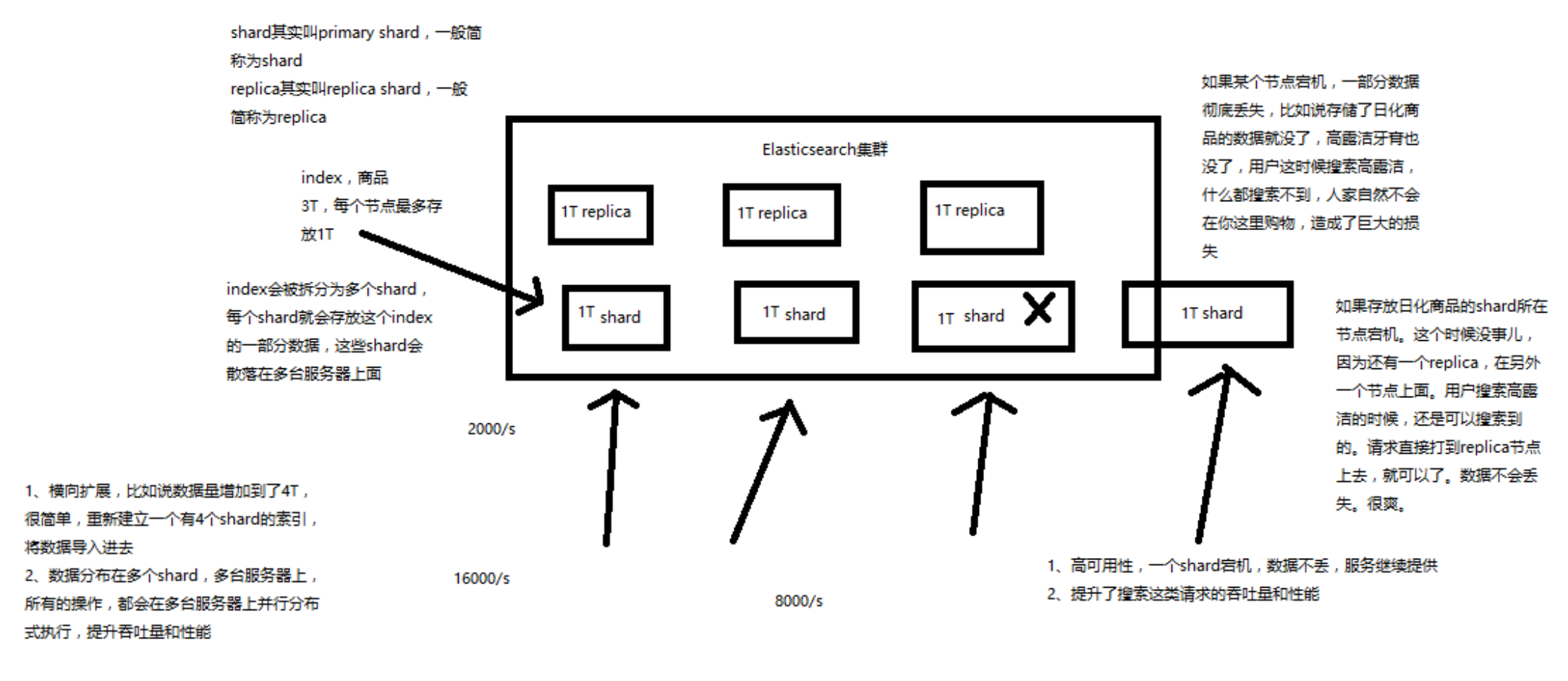

(7)shard:单台机器无法存储大量数据,es可以将一个索引中的数据切分为多个shard,分布在多台服务器上存储。有了shard就可以横向扩展,存储更多数据,让搜索和分析等操作分布到多台服务器上去执行,提升吞吐量和性能。每个shard都是一个lucene index。

(8)replica:任何一个服务器随时可能故障或宕机,此时shard可能就会丢失,因此可以为每个shard创建多个

replica副本。replica可以在shard故障时提供备用服务,保证数据不丢失,多个replica还可以提升搜索操作的吞

吐量和性能。primary shard(建立索引时一次设置,不能修改,默认5个),replica shard(随时修改数量,默认1个

),默认每个索引10个shard,5个primary shard,5个replica shard,最小的高可用配置,是2台服务器。

ES规定primary shard和replica shard不能在同一个节点上。因此我们一般将ES搭建在两台服务器上。

通过如下的一张图就可以很清晰的明白上面的概念了:

【05】ES的基本操作

关于ES的安装网络上有很多博客,笔者在此不再赘述。

epoch timestamp cluster status node.total node.data shards pri relo init unassign pending_tasks max_task_wait_time active_shards_percent

1488006741 15:12:21 elasticsearch yellow 1 1 1 1 0 0 1 0 - 50.0%

epoch timestamp cluster status node.total node.data shards pri relo init unassign pending_tasks max_task_wait_time active_shards_percent

1488007113 15:18:33 elasticsearch green 2 2 2 1 0 0 0 0 - 100.0%

epoch timestamp cluster status node.total node.data shards pri relo init unassign pending_tasks max_task_wait_time active_shards_percent

1488007216 15:20:16 elasticsearch yellow 1 1 1 1 0 0 1 0 - 50.0%

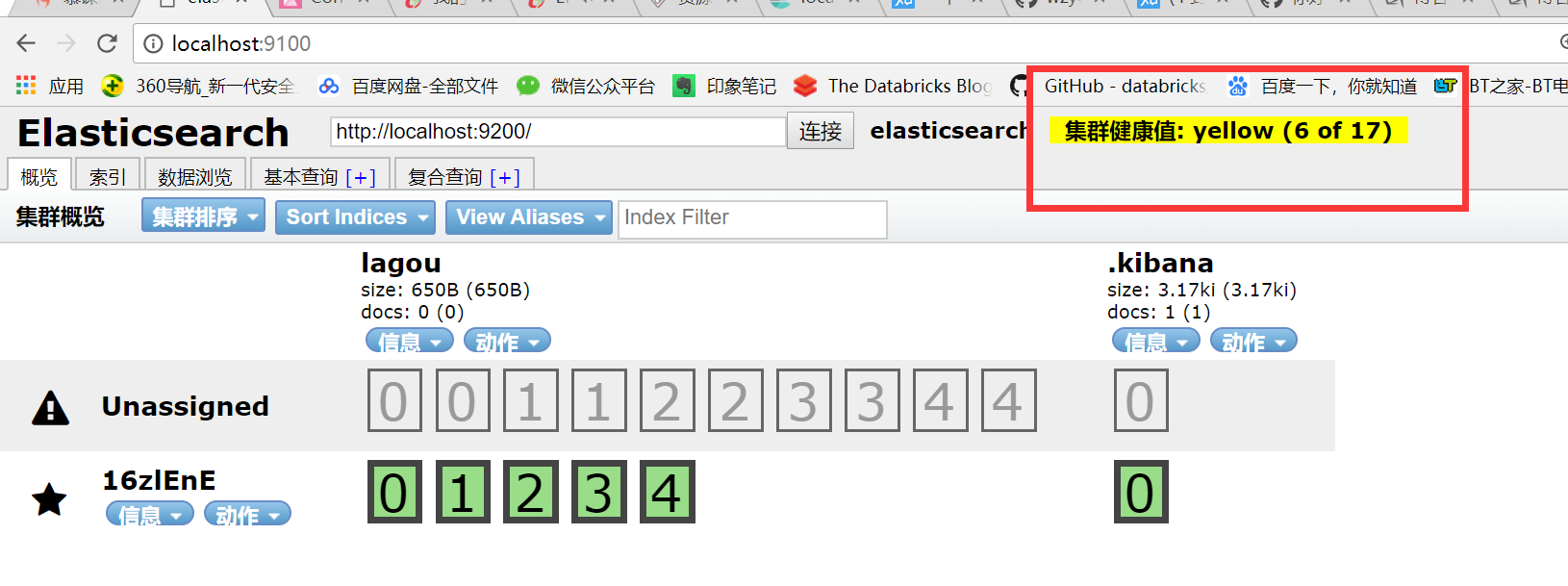

如何快速了解集群的健康状况?green、yellow、red?

原因:

我们现在就一个笔记本电脑,就启动了一个es进程,相当于就只有一个node。现在es中有一个index,就是kibana自己内置建立的index。由于默认的配置是给每个index分配5个

primary shard和5个replica shard,而且primary shard和replica shard不能在同一台机器上(为了容错)。现在kibana自己建立的index是1个primary shard和1个

replica shard。当前就一个node,所以只有1个primary shard被分配了和启动了,但是一个replica shard没有第二台机器去启动。

索引操作:

(2)快速查看集群中有哪些索引

GET /_cat/indices?v

health status index uuid pri rep docs.count docs.deleted store.size pri.store.size

yellow open .kibana rUm9n9wMRQCCrRDEhqneBg 1 1 1 0 3.1kb 3.1kb

(3)简单的索引操作

创建索引:PUT /test_index?pretty

health status index uuid pri rep docs.count docs.deleted store.size pri.store.size

yellow open test_index XmS9DTAtSkSZSwWhhGEKkQ 5 1 0 0 650b 650b

yellow open .kibana rUm9n9wMRQCCrRDEhqneBg 1 1 1 0 3.1kb 3.1kb

删除索引:DELETE /test_index?pretty

health status index uuid pri rep docs.count docs.deleted store.size pri.store.size

yellow open .kibana rUm9n9wMRQCCrRDEhqneBg 1 1 1 0 3.1kb 3.1kb

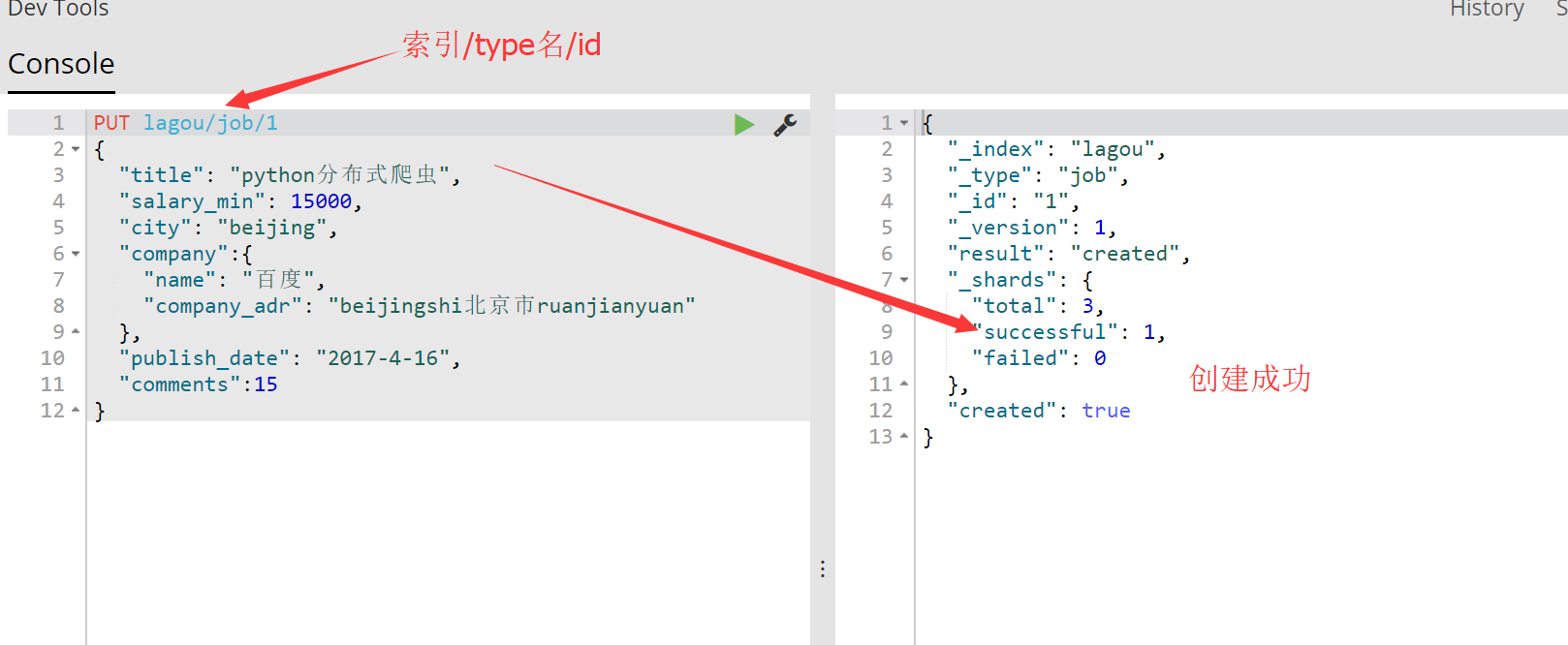

基本的CRUD操作:

如下才是正确的:

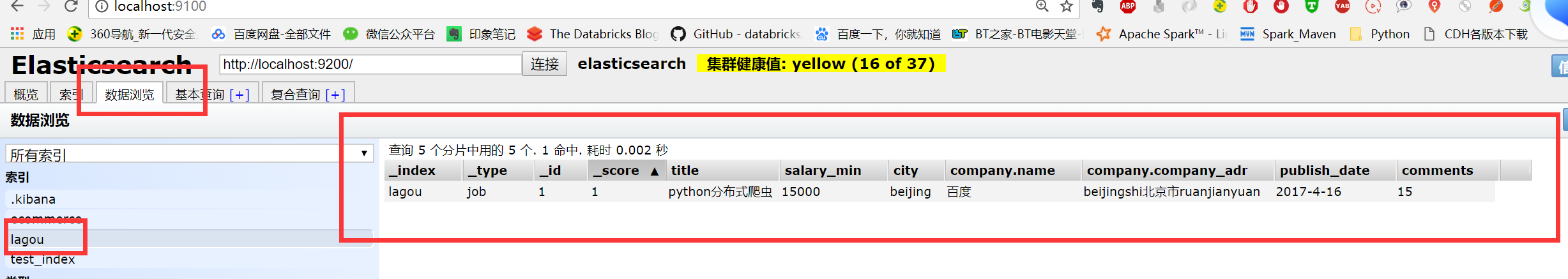

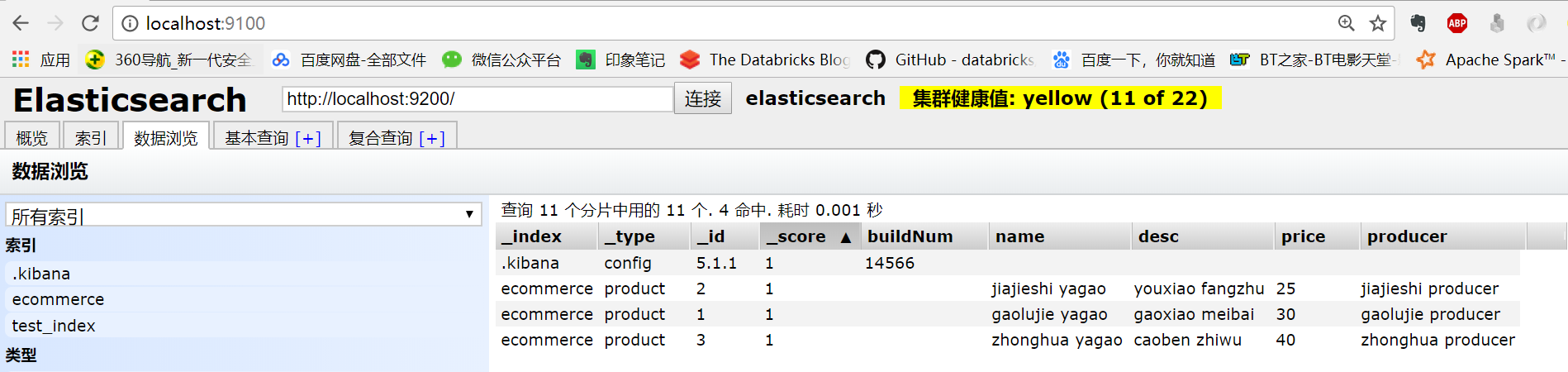

然后去head插件中查看:

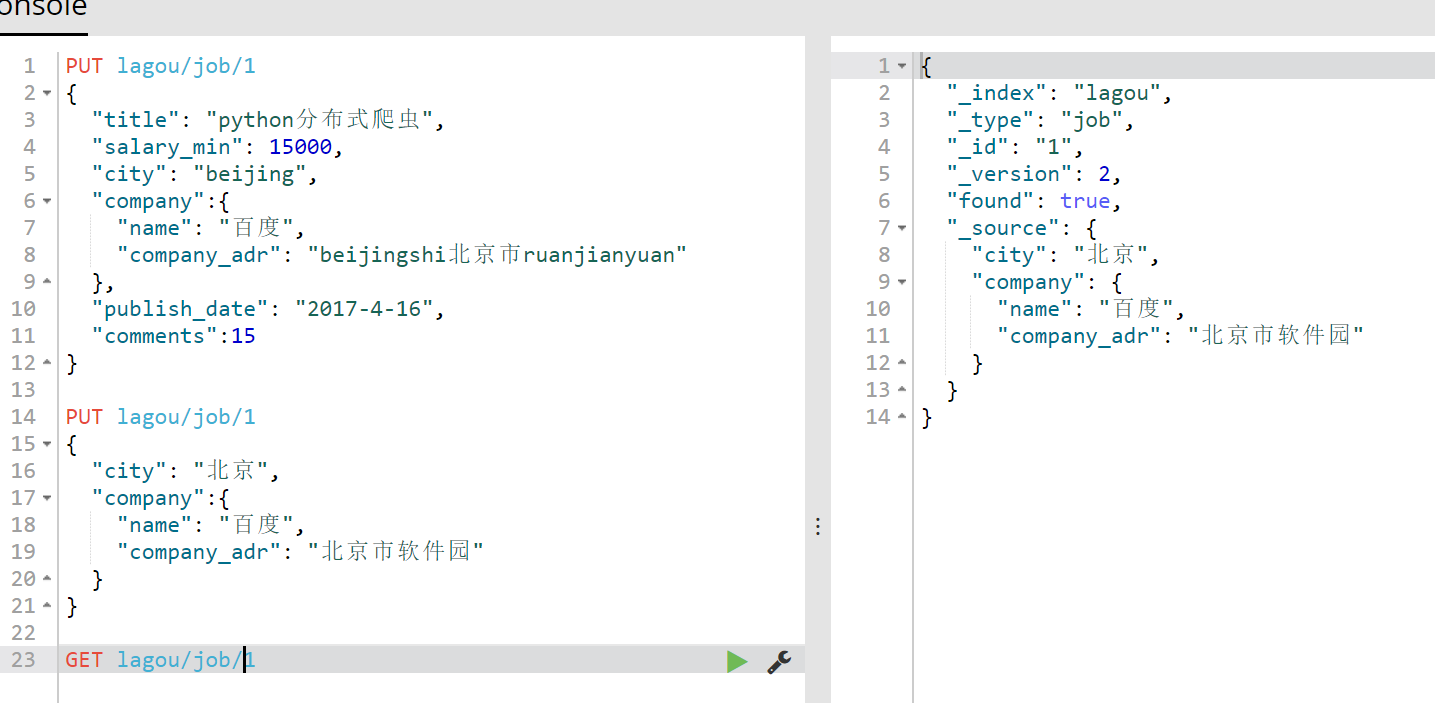

我们来修改下地址和城市,结果如下:

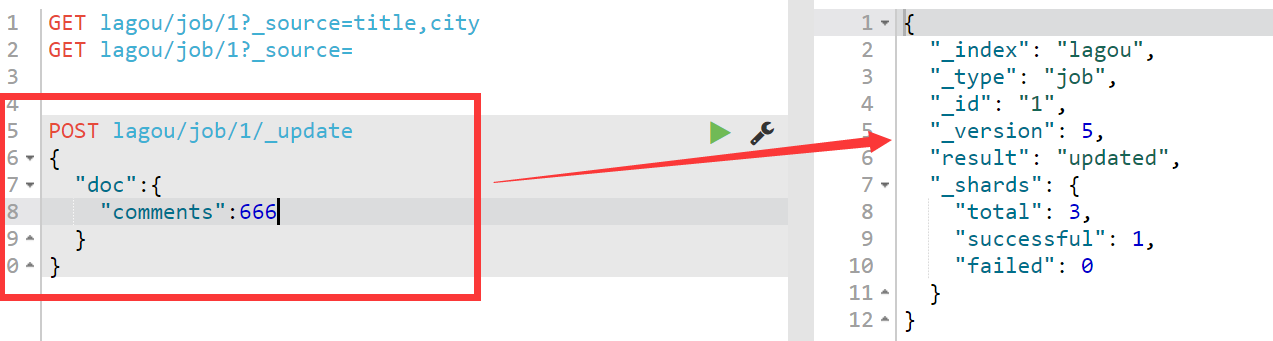

看到没有这里有个小坑,直接像上面那样修改会直接将原始数据的其他字段值全量覆盖,因此要想修改指定字段的值,我们需要在地址栏中指定_update关键字,同时在里面使用doc指定,需要修改哪个字段,相当于就是说需要修改文档中的哪个字段,如下所示:另外还要注意指定ID,表示我修改的是哪个document 。另外要注意修改字段的值使用的是post请求

再来查看修改后的结果:

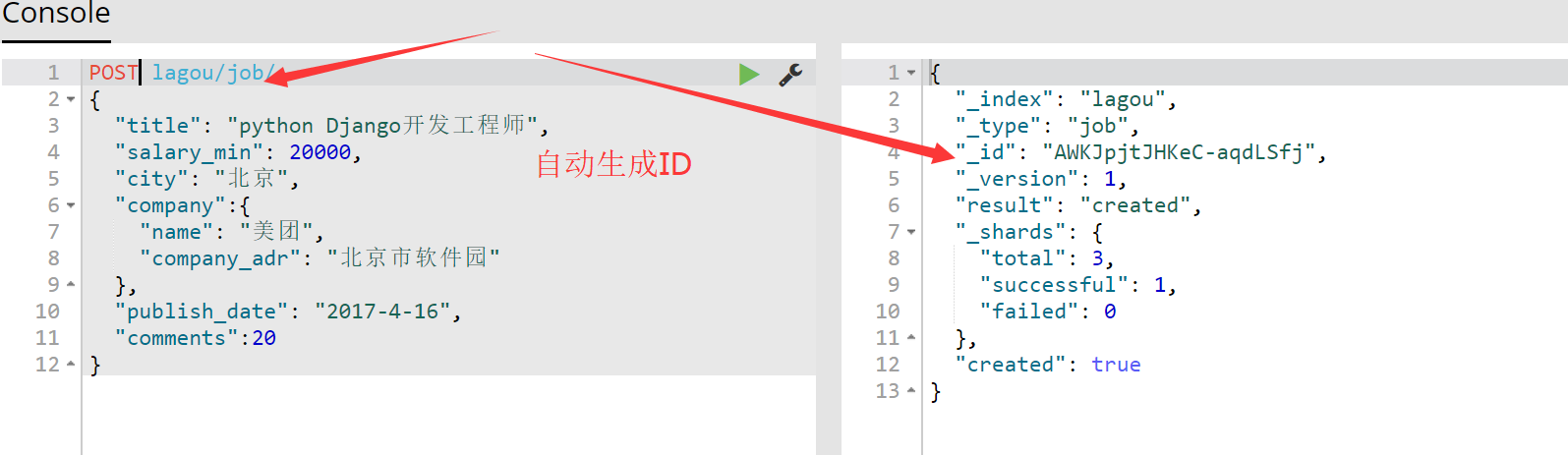

【06】在上面我们创建索引时,指定了doc的ID,但有时候我们需要ES来为我们生成ID,而不是我们自己指定ID,例如我们新增另外一条数据,记住这里使用的是post新增一条数据,而不是put:

可以看到我们在上面使用了POST新增了一条数据到type中,而且没有指定ID,ES为我们自动生成了ID。再来查看head插件:

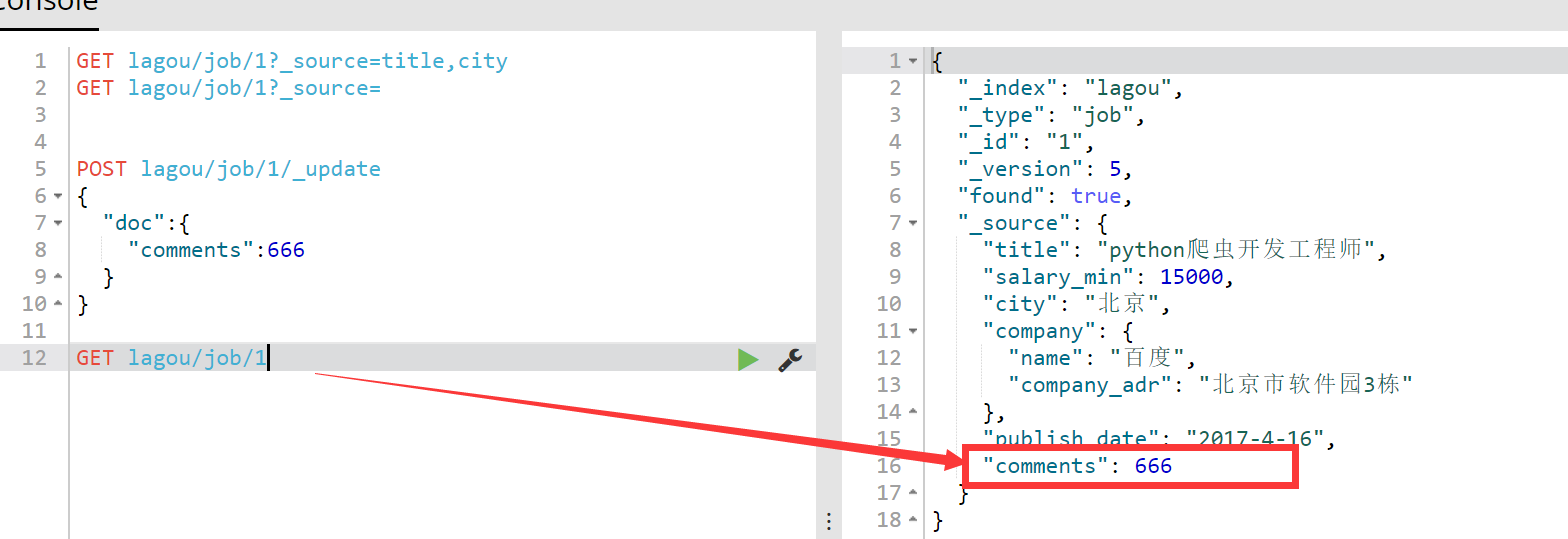

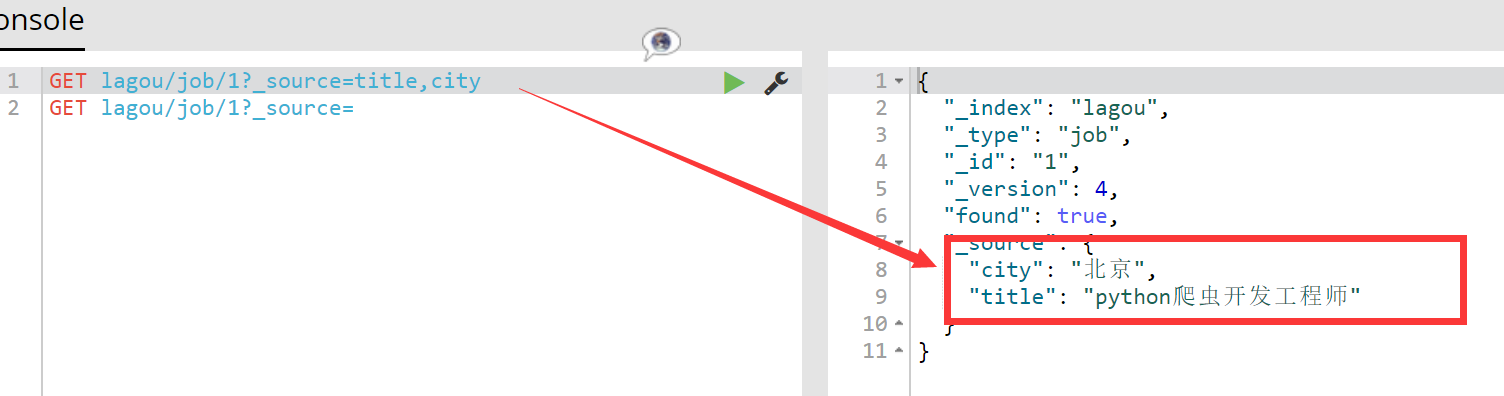

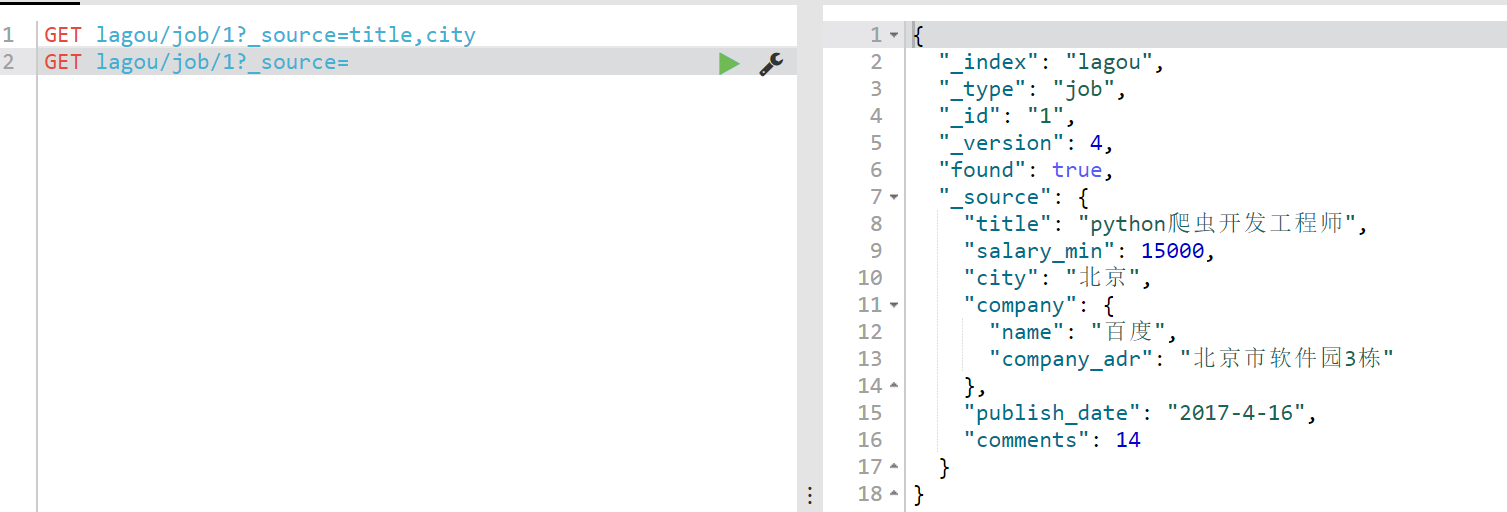

【07】获取指定的字段

现在我想获取指定的字段,例如title和city:

GET lagou/job/1?_source=title,city

结果如下所示:

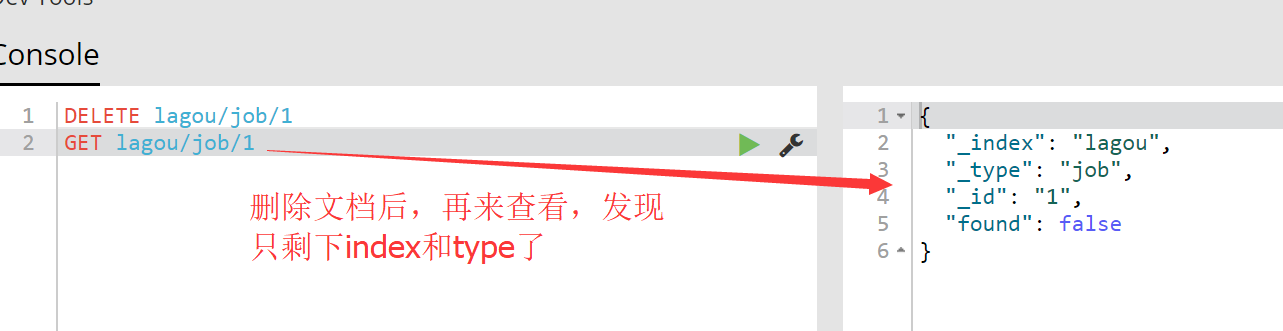

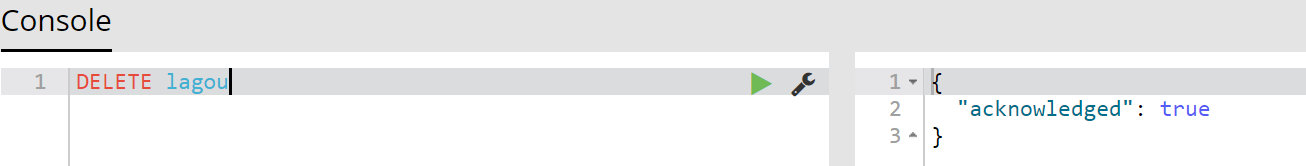

【08】删除操作

1.删除doc 使用DELETE lagou/job/1表示删除id为1的doc,此时索引index和type,相当于就是删除表中的一条数据

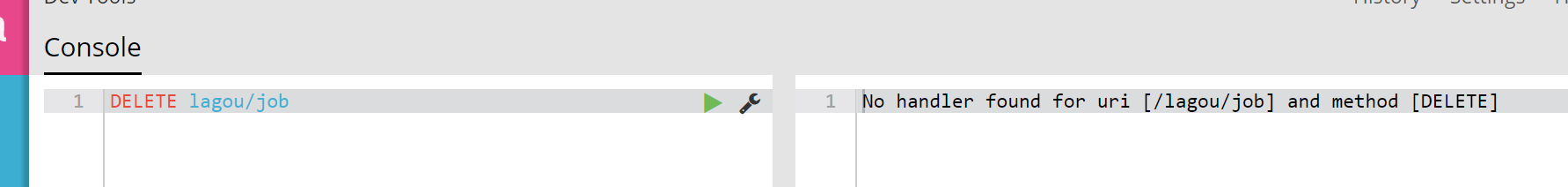

2.删除type ES5报错,说明它不能删除Type:

3.删除索引,可以删除索引:

再去head中查看,发现没有了拉钩这个索引:

以上就是关于ES的基本增删改查操作。相关的命令汇总如下:

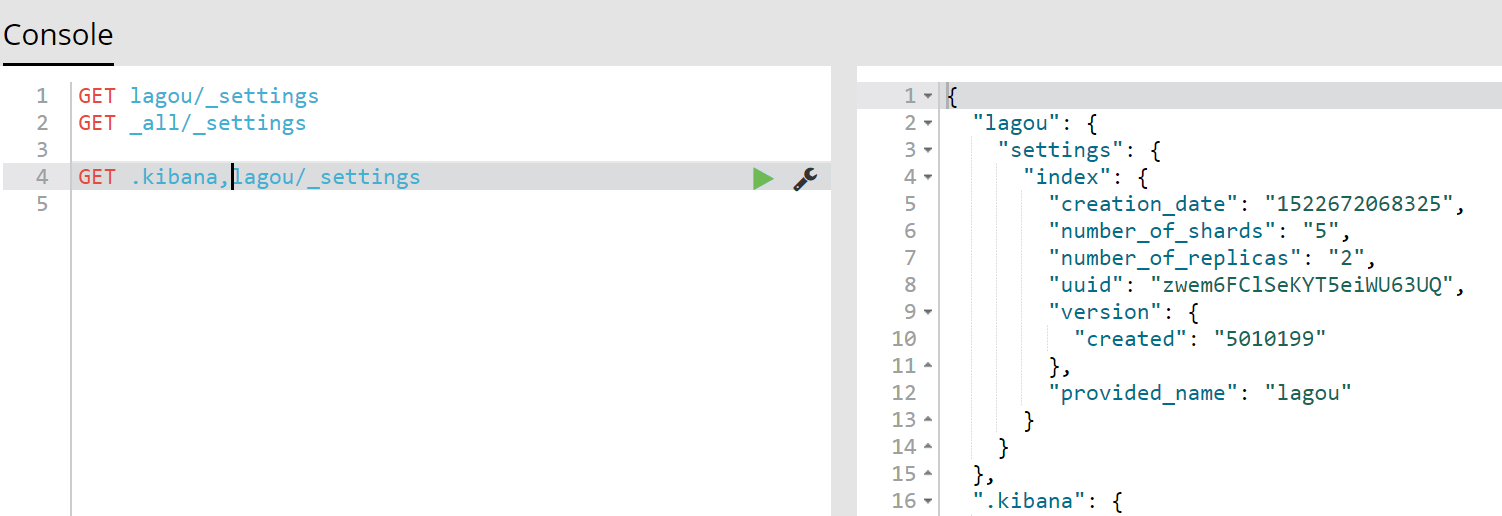

GET lagou/_settings

GET _all/_settings

GET .kibana,lagou/_settings

#

PUT lagou/_settings

{

"number_of_replicas": 2

}

GET _all

GET lagou

POST lagou/job/1

{

"title": "python爬虫开发工程师",

"salary_min": 15000,

"city": "北京",

"company":{

"name": "百度",

"company_adr": "北京市软件园3栋"

},

"publish_date": "2017-4-16",

"comments":14

}

POST lagou/job/

{

"title": "python Django开发工程师",

"salary_min": 20000,

"city": "北京",

"company":{

"name": "美团",

"company_adr": "北京市软件园"

},

"publish_date": "2017-4-16",

"comments":20

}

POST lagou/job/1

{

"title": "python爬虫开发工程师",

"salary_min": 15000,

"city": "北京",

"company":{

"name": "百度",

"company_adr": "北京市软件园3栋"

},

"publish_date": "2017-4-16",

"comments":14

}

DELETE lagou/job/1

GET lagou/job/1

浙公网安备 33010602011771号

浙公网安备 33010602011771号