线性回归

线性回归

一、综述

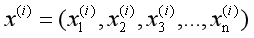

线性回归遇到的问题一般是这样的。我们有m个样本,每个样本对应n维特征和一个结果输出,并且输出结果y是连续性变量,如下:

表示第i个样本输入

表示第i个样本输入

表示第i个样本输入的真实输出

表示第i个样本输入的真实输出

表示第i个样本的第j个分量

表示第i个样本的第j个分量

线性回归问题,就是找到一个合适的函数用于拟合训练数据,使得该函数具备很好的泛化能力,使得对于新的输入,能够得到尽量正确的输出。

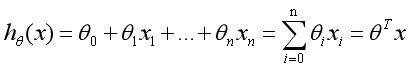

二、假设函数

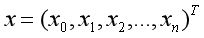

输入,n+1维的列向量,其中

输入,n+1维的列向量,其中

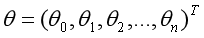

参数,n+1维的列向量,

参数,n+1维的列向量, 是bias

是bias

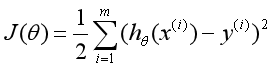

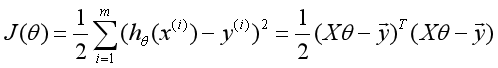

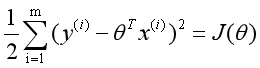

三、代价函数LMS

代价函数,也叫成本函数。对m个样本,不同的参数,每个样本都有一个误差,总的误差如下:

四、梯度下降算法求LMS的最小值

对不同的 ,成本函数有不同的值,现在我们来求其最小值。我们采用搜索算法求的最小值。

,成本函数有不同的值,现在我们来求其最小值。我们采用搜索算法求的最小值。

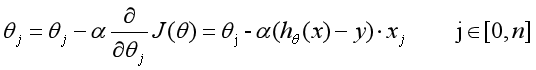

随机给 定一个初始值,我们重复的按照如下规则修改

定一个初始值,我们重复的按照如下规则修改 ,

,

既我们按照梯度的方向修改,其中 是超参数。假设,我们只有一个样本:

是超参数。假设,我们只有一个样本:

因此,对于单个样本来说:

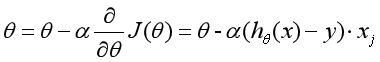

向量表示:

因此,对于m个样本来说:

五、通过矩阵求导,求LMS的最小值

5.1用矩阵表示代价函数

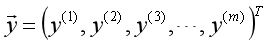

输入:

输出:

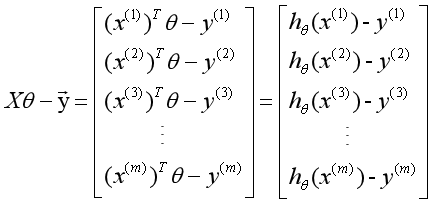

则:

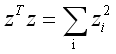

对向量 有:

有:

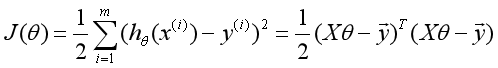

所以有:

5.2矩阵求导公式

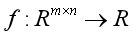

函数:

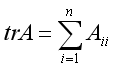

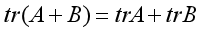

迹:

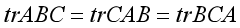

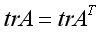

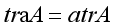

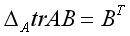

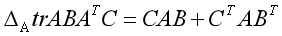

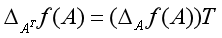

则有:

5.3对代价函数求导

因为:

则:

令导数为0,得到:

六、LMS的概率解释

当我们面对一个回归问题,我们为什么会选择线性回归,为什么选择LMS作为成本函数。这里,我们做一系列的假设用于说明LMS是一个合理的成本函数。

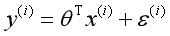

假设,输入与输出之间满足如下关系:

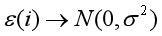

表示,随机噪音,假设满足期望为0的高斯分布,并且独立同分布。

表示,随机噪音,假设满足期望为0的高斯分布,并且独立同分布。

既:

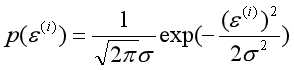

所以:

所以:

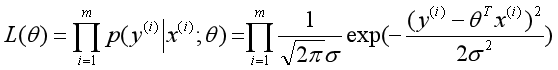

现在用最大似然估计求 。

。

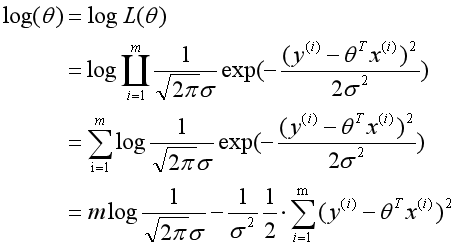

最小化似然函数,就是最大化

所以,LMS是一个合理的成本函数。

浙公网安备 33010602011771号

浙公网安备 33010602011771号