6.RDD综合练习:更丰富的操作

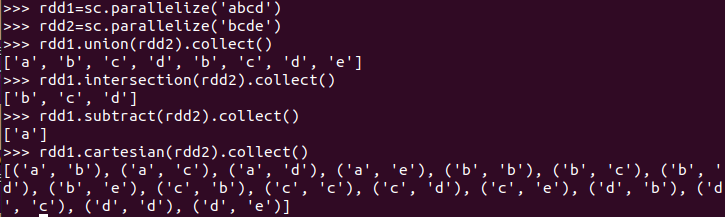

集合运算练习

union(), intersection(),subtract(), cartesian()

rdd1=sc.parallelize('abcd') rdd2=sc.parallelize('bcde') rdd1.union(rdd2).collect() rdd1.intersection(rdd2).collect() rdd1.subtract(rdd2).collect() rdd1.cartesian(rdd2).collect()

内连接与外连接

join(), leftOuterJoin(), rightOuterJoin(), fullOuterJoin()

多个考勤文件,签到日期汇总,出勤次数统计

三、综合练习:学生课程分数

通过RDD操作实现以下数据分析:

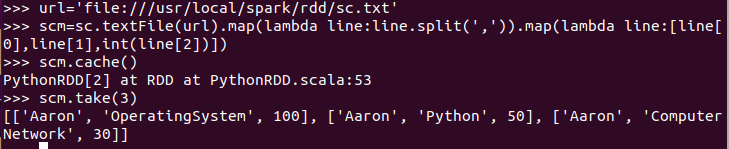

- 持久化 scm.cache()

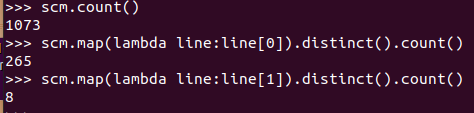

- 总共有多少学生?map(), distinct(), count()

- 开设了多少门课程?

url='file:///usr/local/spark/rdd/sc.txt' scm=sc.textFile(url).map(lambda line:line.split(',')).map(lambda line:[line[0],line[1],int(line[2])]) scm.cache()

scm.take(3)

scm.count() scm.map(lambda line:line[0]).distinct().count() scm.map(lambda line:line[1]).distinct().count()

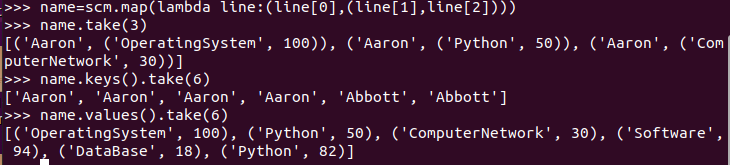

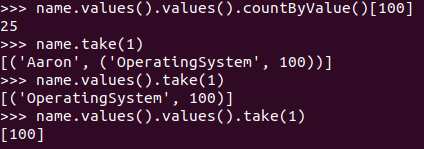

- 生成(姓名,课程分数)键值对RDD,观察keys(),values()

name=scm.map(lambda line:(line[0],(line[1],line[2]))) name.take(3) name.keys().take(6) name.values().take(6)

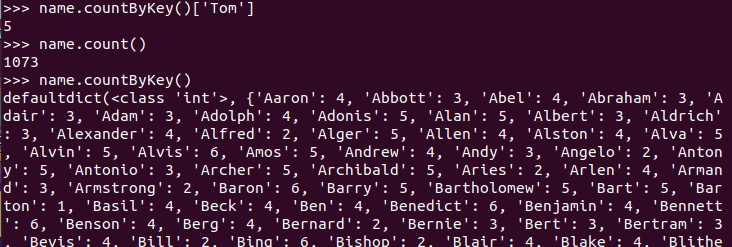

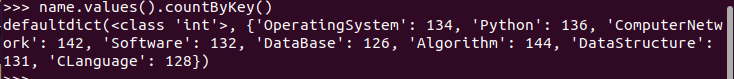

- 每个学生选修了多少门课?map(), countByKey()

- 每门课程有多少个学生选?map(), countByValue()

- 有多少个100分?

name.countByKey()['Tom'] name.count() name.countByKey() name.values().countByKey() name.values().values().countByValue()[100] name.take(1) name.values().take(1) name.values().values().take(1)

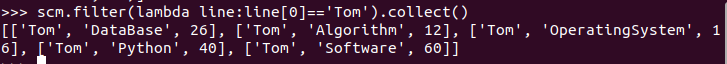

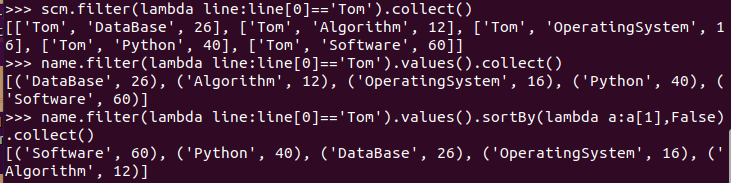

- Tom选修了几门课?每门课多少分?filter(), map() RDD

scm.filter(lambda line:line[0]=='Tom').collect()

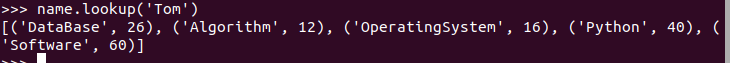

- Tom选修了几门课?每门课多少分?map(),lookup() list

name.lookup('Tom')

- Tom的成绩按分数大小排序。filter(), map(), sortBy()

- Tom的平均分。map(),lookup(),mean()

scm.filter(lambda line:line[0]=='Tom').collect() name.filter(lambda line:line[0]=='Tom').values().collect() name.filter(lambda line:line[0]=='Tom').values().sortBy(lambda a:a[1],False).collect()

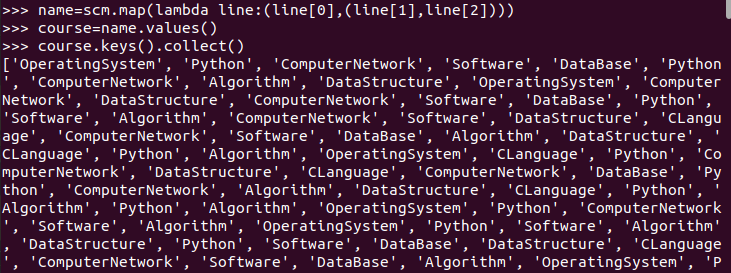

- 生成(课程,分数)RDD,观察keys(),values()

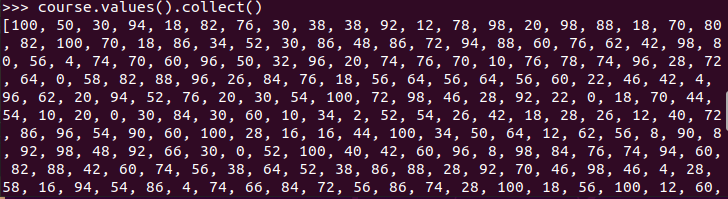

- 每个分数+5分。mapValues(func)

- 求每门课的选修人数及所有人的总分。combineByKey()

- 求每门课的选修人数及平均分,精确到2位小数。map(),round()

- 求每门课的选修人数及平均分。用reduceByKey()实现,并比较与combineByKey()的异同。

- 结果可视化。 pyecharts.charts,Bar()

#生成(课程,分数)RDD

course=name.values() course.keys().collect() course.values().collect()

浙公网安备 33010602011771号

浙公网安备 33010602011771号