1.1卷积神经网络基础

目录:

1、卷积神经网络(历史)

2、全连接层

3、卷积层

4、池化层

1、卷积神经网络CNN(Convolutional Neural Network)

包含卷积层的网络。

1986 Rumelhart和Hinton提出反向传播(Back Propagation,即BP算法)

1998 LeCun利用BP算法训练LeNet5网络,标志着CNN的真正问世

2006 Hinton 在Science Paper中首次提出Deep Learning

2012 Hinton 学生 Alex Krizhevsky获得视觉领域竞赛ILSVRC2012冠军,效果大幅度超过传统方法,从传统的70%多提升到80%多

tips:尽可能使用GPU,GPU比CPU提升效率约在20倍以上

2、全连接层

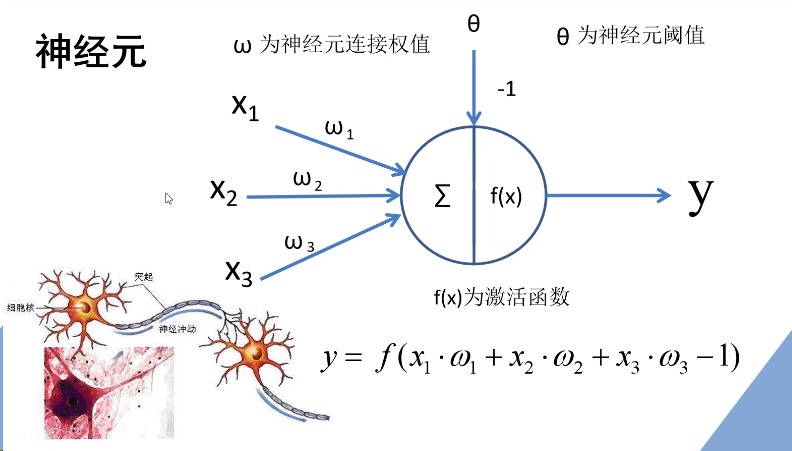

神经元

全连接层:将神经元按列排列,列与列之间一一进行连接,就形成了全连接层。

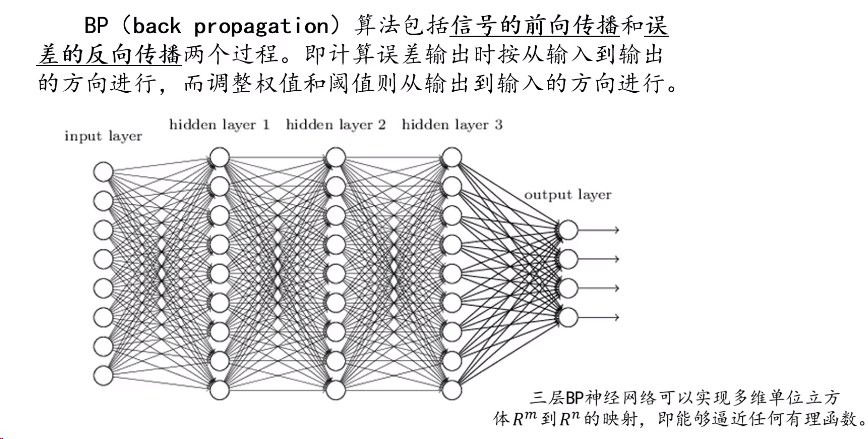

BP算法:包括信号的向前传播和误差反向传播。

即计算误差输出时按从输入到输出的方向进行,而调整权值和阈值则从输出到输入的方向进行。

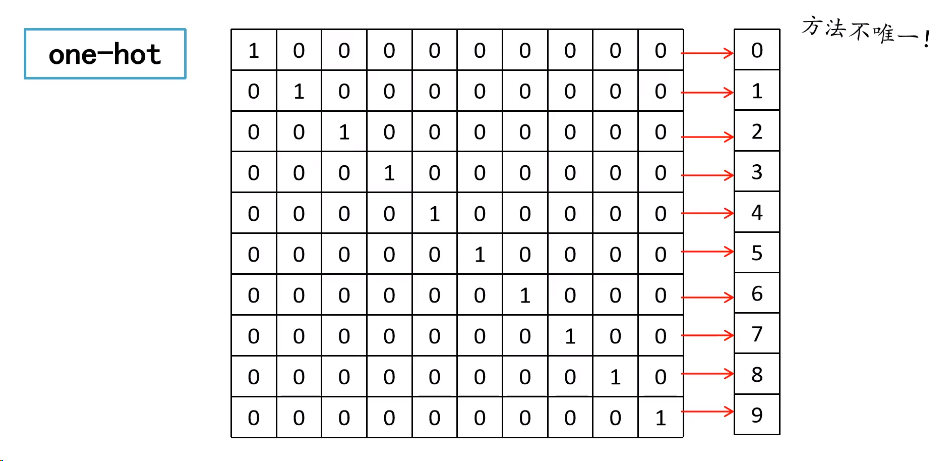

one-hot编码:标签编码方式

3、卷积层

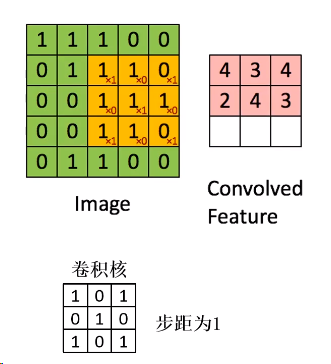

卷积:滑动窗口在特征图像滑动并计算。

卷积特性:拥有局部感知和权值共享。

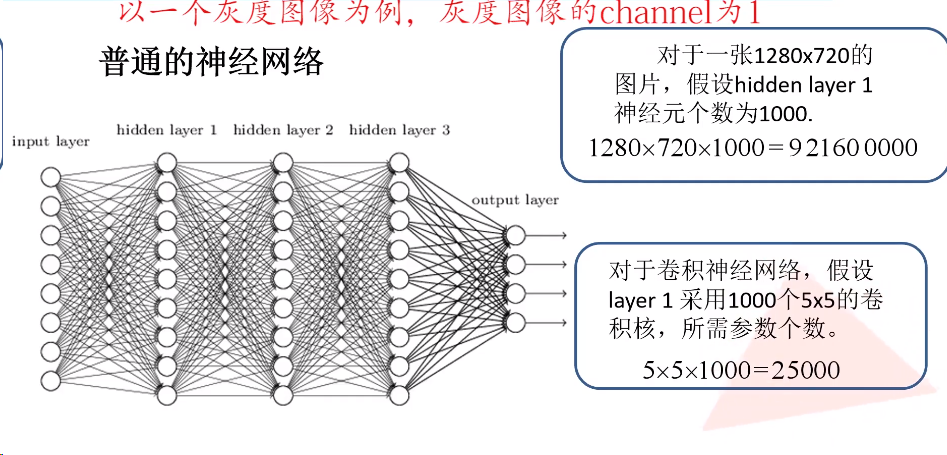

权值共享:大大减少参数的数量

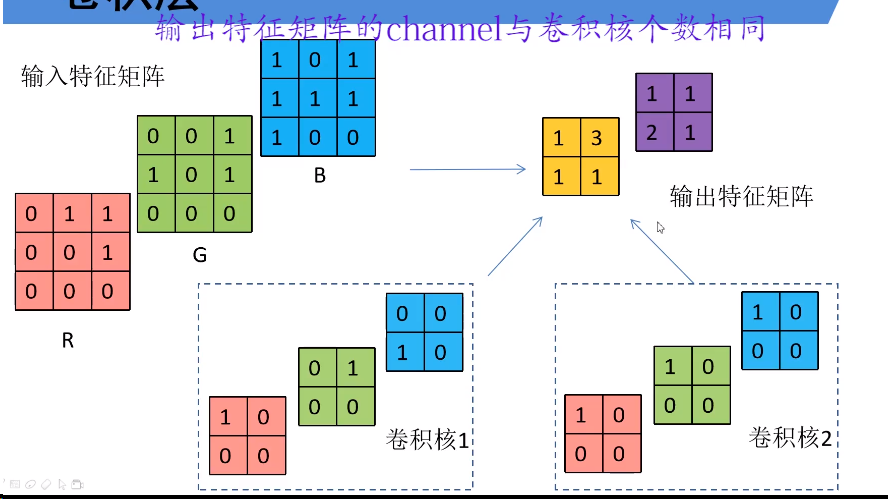

卷积核的深度(channel)要与输入特征层的深度(channel)一致,如输入彩色RGB图像,则卷积核为3层n*n的窗口

输出特征矩阵的channel与卷积核的个数相同

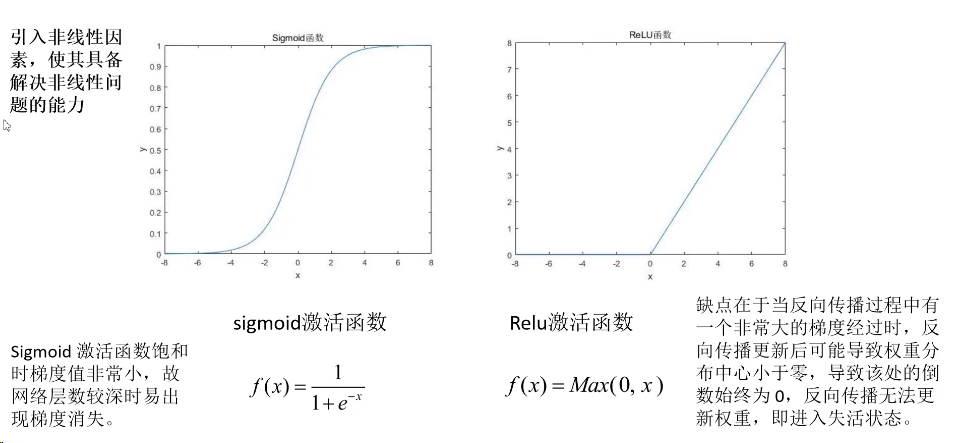

为什么使用激活函数?引入非线性因素,使其具备解决非线性问题的能力

在卷积操作过程中,矩阵经卷积操作后的尺寸由以下几个因数决定:

N = ( W - F + 2P) / S + 1

- 输入图片大小W * W

- Filter大小 F * F

- 步长 S

- padding的像素数 P

4、池化层

目的:对特征图进行稀疏处理,减少数据运算量。

- 没有训练参数

- 只改变特征矩阵的w和h,不改变channel

- 一般poolsize和stride相同

- 常见:MaxPooling、AveragePooling

posted on 2021-05-22 10:36 NeverDelay 阅读(124) 评论(0) 收藏 举报

浙公网安备 33010602011771号

浙公网安备 33010602011771号