云电脑玩转 CANN 全攻略:从环境搭建到创新应用落地

云电脑深度玩转CANN:从环境适配到工业级应用落地全指南

CANN(Compute Architecture for Neural Networks)作为华为面向AI异构计算场景的核心架构,凭借端云一致的特性,既能让开发者无缝切换开发环境,又能最大化释放硬件算力。但云电脑环境下的权限限制、资源隔离、网络约束等问题,成为不少开发者上手CANN的拦路虎。本文基于实际开发经验,对CANN在云电脑中的部署、开发、优化进行超详细拆解,从每一步命令的原理到代码的逐行解释,再到复杂场景的问题排查,带你零门槛吃透CANN开发。

一、云电脑环境深度适配:从底层原理到实操细节

云电脑与本地物理机的核心差异在于“无直接硬件访问权”“资源共享”“环境依赖预装”,因此CANN安装需突破这些限制,每一步都要兼顾兼容性与稳定性。

1. 前置检查:不止于表面验证(原理+实操)

前置检查的核心是确认云电脑是否满足CANN的“底层依赖+资源阈值”,避免后续安装因隐性问题失败。

核心检查项与原理说明

| 检查项 | 要求标准 | 原理说明 | 实操命令与结果验证 |

|---|---|---|---|

| 系统版本 | CentOS 7.6+/Ubuntu 22.04+/EulerOS 2.0 SP8 | CANN的驱动与Toolkit依赖特定系统内核接口,低版本系统可能缺失关键库 | Ubuntu:lsb_release -a,需显示“Description: Ubuntu 22.04.x LTS”;CentOS:cat /etc/redhat-release,需显示“CentOS Linux release 7.6.x” |

| 内核版本 | ≥3.10 | 内核负责硬件资源调度,3.10以下版本不支持CANN的内存映射与设备通信机制 | 命令:uname -r,输出如“5.15.0-157-generic”即为符合(云镜像默认满足) |

| 编译依赖 | 需安装gcc≥7.3.0、cmake≥3.13、python3.7+/3.8+/3.9+ | gcc用于编译CANN内核模块,cmake管理构建流程,Python版本需匹配ascendcl依赖 | 检查gcc:gcc --version(输出≥7.3.0);检查cmake:cmake --version(输出≥3.13);检查Python:python3 --version(输出3.7-3.9) |

| 权限验证 | 拥有sudo权限 | 安装驱动、Toolkit需修改系统目录,sudo权限是必备前提 | 命令:sudo -l,输出“may run the following commands”即为有权限(云电脑默认支持) |

依赖库深度检查与修复

若依赖库版本不达标,需手动升级(以Ubuntu 22.04为例):

# 升级gcc到9.4.0(默认版本可能为11.4.0,向下兼容无影响)

sudo apt install -y gcc-9 g++-9

sudo update-alternatives --install /usr/bin/gcc gcc /usr/bin/gcc-9 50

sudo update-alternatives --install /usr/bin/g++ g++ /usr/bin/g++-9 50

# 升级cmake到3.22.1

wget https://cmake.org/files/v3.22/cmake-3.22.1-linux-x86_64.tar.gz

tar -zxvf cmake-3.22.1-linux-x86_64.tar.gz

sudo mv cmake-3.22.1-linux-x86_64 /usr/local/cmake

echo "export PATH=/usr/local/cmake/bin:$PATH" >> ~/.bashrc

source ~/.bashrc

# 安装指定版本Python(以3.8为例)

sudo apt install -y python3.8 python3.8-dev python3.8-pip

sudo update-alternatives --install /usr/bin/python3 python3 /usr/bin/python3.8 50

2. 核心组件安装:逐步骤拆解+原理详解

(1)依赖库补装:覆盖所有隐性依赖

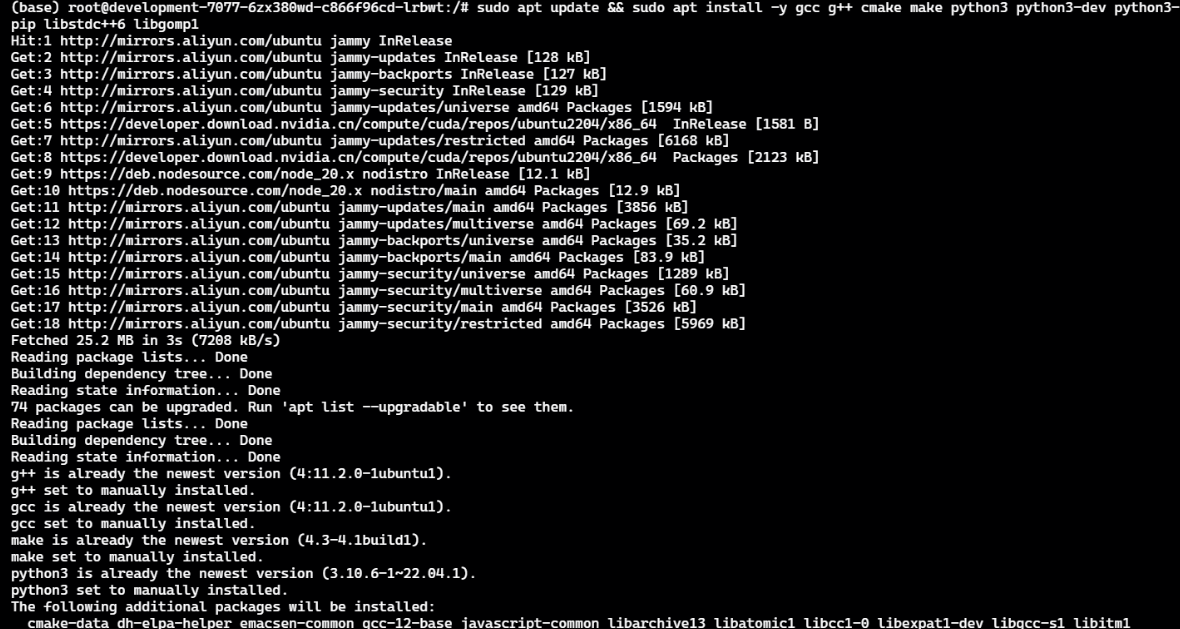

云电脑镜像通常预装基础依赖,但CANN编译和运行需额外组件,需一次性安装完整:

# Ubuntu 22.04完整依赖安装命令

sudo apt update && sudo apt install -y \

gcc g++ cmake make python3 python3-dev python3-pip \

libstdc++6 libgomp1 libprotobuf-dev protobuf-compiler \

libssl-dev zlib1g-dev libcurl4-openssl-dev libboost-all-dev

# CentOS 7.6完整依赖安装命令

sudo yum install -y \

gcc gcc-c++ cmake make python3 python3-devel python3-pip \

libstdc++.so.6 libgomp.so.1 protobuf-devel openssl-devel \

zlib-devel curl-devel boost-devel

安装过程比较漫长,需要等待

依赖作用逐一生解:

- libprotobuf-dev/protobuf-compiler:支持CANN的模型序列化与反序列化(.om模型基于Protobuf格式)

- libssl-dev/zlib1g-dev:保障网络传输安全与数据压缩(下载模型、云边协同时用到)

- libcurl4-openssl-dev:支持CANN的远程API调用(如云环境中获取模型元数据)

- libboost-all-dev:增强CANN的多线程调度与内存管理能力(并行推理场景必备)

(2)驱动安装:分场景深度适配

驱动是CANN与硬件交互的桥梁,云电脑需根据是否有昇腾硬件分两种情况处理:

场景1:华为云昇腾实例(Ascend 310/910)

- 原理:云厂商已在底层完成驱动与硬件的绑定,开发者无需手动安装,直接验证即可

- 详细验证步骤:

- 执行

npu-smi info,正常输出如下(关键看“Device Name”“Firmware Version”):+-------------------------------------------------------------------------------------------------+ | npu-smi 22.0.0 Version: 22.0.0 | +----------------------+----------------------+------------------------------------------------------+ | Device Name | Chip Name | Device Status | +----------------------+----------------------+------------------------------------------------------+ | 0 | Ascend910B | Normal | +----------------------+----------------------+------------------------------------------------------+ | Firmware Version | 1.89.T10.0.B210 | | | Driver Version | 22.0.0 | | +-------------------------------------------------------------------------------------------------+ - 若输出“command not found”:执行

source /usr/local/Ascend/npu_driver/set_env.sh后重新验证(云实例可能未自动加载驱动环境变量)

- 执行

场景2:普通x86云电脑(无昇腾硬件)

- 原理:无实体硬件时,需安装仿真驱动模拟硬件行为,支持CANN工具链的开发调试(不具备硬件加速能力,仅用于功能验证)

- 详细安装步骤(含问题修复):

- 下载仿真驱动:从华为昇腾官网(https://www.huawei.com/cn/ascend/developer)下载对应系统的仿真驱动包(如

Ascend-sim-driver-7.0.0-linux-x86_64.tar.gz) - 解压并安装(非root权限,避免云电脑权限限制):

# 解压到用户目录(避免系统目录权限问题) tar -zxvf Ascend-sim-driver-7.0.0-linux-x86_64.tar.gz -C ~/ascend-sim-driver cd ~/ascend-sim-driver # 执行安装脚本,--sim参数指定仿真模式 ./install.sh --sim - 安装后配置环境变量(关键步骤,否则驱动无法被识别):

echo "export ASCEND_DRIVER_PATH=~/ascend-sim-driver" >> ~/.bashrc echo "export LD_LIBRARY_PATH=$ASCEND_DRIVER_PATH/lib64:$LD_LIBRARY_PATH" >> ~/.bashrc source ~/.bashrc - 验证安装:执行

npu-smi info,输出“simulator mode”即为成功:+-------------------------------------------------------------------------------------------------+ | npu-smi 22.0.0 Version: 22.0.0 | +----------------------+----------------------+------------------------------------------------------+ | Device Name | Chip Name | Device Status | +----------------------+----------------------+------------------------------------------------------+ | 0 | Simulator | Normal | +----------------------+----------------------+------------------------------------------------------+ - 常见问题修复:

- 若提示“libascend_sim.so: cannot open shared object file”:检查LD_LIBRARY_PATH是否包含驱动lib64目录,重新执行

source ~/.bashrc - 若安装脚本执行失败:添加执行权限

chmod +x install.sh,再重新运行

- 若提示“libascend_sim.so: cannot open shared object file”:检查LD_LIBRARY_PATH是否包含驱动lib64目录,重新执行

- 下载仿真驱动:从华为昇腾官网(https://www.huawei.com/cn/ascend/developer)下载对应系统的仿真驱动包(如

(3)CANN Toolkit安装:版本匹配+路径精准配置

Toolkit是CANN的核心开发工具集,包含编译器(atc)、运行时(Runtime)、API库等,安装需严格匹配驱动版本。

版本匹配原则

- 驱动版本与Toolkit版本必须一致(如驱动22.0.0对应Toolkit 7.0.0)

- ascendcl包版本需与Toolkit版本一致(避免API调用报错)

详细安装步骤

- 下载Toolkit包:从华为昇腾官网下载对应系统、架构的包(云电脑选x86_64架构):

- Ubuntu:

ascend-toolkit-7.0.0-linux-x86_64.deb - CentOS:

ascend-toolkit-7.0.0-linux-x86_64.rpm

- Ubuntu:

- 安装Toolkit(分系统处理依赖问题):

# Ubuntu系统(deb包) sudo dpkg -i ascend-toolkit-7.0.0-linux-x86_64.deb # 修复依赖缺失(关键步骤,云环境常出现依赖不完整) sudo apt -f install -y # CentOS系统(rpm包) sudo rpm -ivh ascend-toolkit-7.0.0-linux-x86_64.rpm --force --nodeps # 强制安装是因为部分系统库版本差异,--nodeps忽略依赖检查 - 精准配置环境变量(避免全局冲突,云电脑多用户场景必备):

# 编辑用户级配置文件(仅当前用户生效) vi ~/.bashrc # 添加以下内容(逐行解释作用) export ASCEND_HOME=/usr/local/Ascend # CANN核心目录 export TOOLKIT_PATH=$ASCEND_HOME/ascend-toolkit/latest # Toolkit安装路径 export PATH=$TOOLKIT_PATH/bin:$TOOLKIT_PATH/compiler/bin:$PATH # 工具链路径(atc、ccec等) export LD_LIBRARY_PATH=$TOOLKIT_PATH/lib64:$TOOLKIT_PATH/compiler/lib64:$LD_LIBRARY_PATH # 动态库路径 export PYTHONPATH=$TOOLKIT_PATH/python/site-packages:$PYTHONPATH # Python API路径 export ASCEND_LOG_LEVEL=info # 开启详细日志(便于排查问题) # 保存退出后生效 source ~/.bashrc

(4)Python依赖安装:版本锁定+冲突处理

CANN的Python API依赖特定版本的numpy、pillow等库,版本不匹配会导致导入失败或推理报错。

详细安装与冲突处理

# 1. 升级pip并指定镜像源(云电脑网络可能限速,用国内源加速)

pip3 install --upgrade pip -i https://pypi.tuna.tsinghua.edu.cn/simple

# 2. 安装锁定版本的依赖包(逐包说明作用)

pip3 install -i https://pypi.tuna.tsinghua.edu.cn/simple \

numpy==1.21.6 # 数据处理核心库,CANN API仅兼容1.21.x版本

pillow==9.5.0 # 图像读取与预处理,高版本可能不支持某些格式

ascendcl==7.0.0 # CANN Python SDK,必须与Toolkit版本一致

protobuf==3.20.3 # 模型序列化,匹配CANN的Protobuf版本

six==1.16.0 # 兼容性库,解决Python2/3语法差异

# 3. 冲突处理:若已安装高版本库,先卸载再安装

pip3 uninstall -y numpy pillow protobuf

pip3 install -i https://pypi.tuna.tsinghua.edu.cn/simple numpy==1.21.6 pillow==9.5.0 protobuf==3.20.3

(5)安装完整性验证:5步全维度检查

仅通过单一命令验证不够,需从工具、API、设备、编译、运行5个维度确认:

# 1. 验证Toolkit工具可用性(核心工具atc)

atc --version

# 预期输出:CANN Toolkit V7.0.0 Build XXX(版本号与安装包一致)

# 2. 验证Python API可导入(关键看是否报错)

python3 -c "import ascendcl as acl; print('ascendcl版本:', acl.__version__)"

# 预期输出:ascendcl版本:7.0.0(无ImportError)

# 3. 验证设备访问(区分实体硬件与仿真驱动)

npu-smi info

# 预期输出:实体硬件显示设备信息,仿真驱动显示simulator mode

# 4. 验证编译器(ccec是CANN的内核编译器)

ccec --version

# 预期输出:HUAWEI CANN Compiler V7.0.0 Build XXX

# 5. 验证运行时(执行简单的设备初始化命令)

python3 -c "import ascendcl as acl; ret=acl.init(); print('ACL初始化结果:', ret); acl.finalize()"

# 预期输出:ACL初始化结果:0(返回0表示成功)

常见验证失败修复方案

| 失败场景 | 报错信息 | 修复步骤 |

|---|---|---|

| atc --version提示“command not found” | - | 1. 检查环境变量PATH是否包含$TOOLKIT_PATH/bin;2. 重新执行source ~/.bashrc;3. 若仍失败,手动执行export PATH=/usr/local/Ascend/ascend-toolkit/latest/bin:$PATH |

| 导入ascendcl失败 | ImportError: No module named 'ascendcl' | 1. 检查PYTHONPATH是否包含$TOOLKIT_PATH/python/site-packages;2. 执行`pip3 list |

| npu-smi info提示“Device not found” | - | 1. 实体硬件:检查驱动是否安装,执行source /usr/local/Ascend/npu_driver/set_env.sh;2. 仿真驱动:检查ASCEND_DRIVER_PATH是否配置正确 |

| 编译器ccec验证失败 | command not found | 检查环境变量PATH是否包含$TOOLKIT_PATH/compiler/bin,补充配置后重新生效 |

二、基础实战:图像分类完整开发流程(逐行代码解析)

以ResNet50图像分类为例,从环境初始化到资源释放,每一步都结合云电脑特性优化,同时详解代码原理与注意事项。

1. 开发前准备:模型与数据准备

(1)模型获取与转换

CANN仅支持.om格式模型,需先将ONNX模型转换为.om格式:

# 1. 下载ResNet50 ONNX模型(从华为昇腾模型库获取)

wget https://ascend-repo.obs.cn-east-2.myhuaweicloud.com/models/resnet50/resnet50.onnx

# 2. 转换为.om格式(详细参数解释)

atc --model=resnet50.onnx \

--framework=5 \ # 5表示ONNX框架(1=Caffe,2=TensorFlow,3=TensorFlow Lite,4=MindSpore)

--output=resnet50 \ # 输出模型文件名(无需加.om后缀)

--input_format=NCHW \ # 输入数据格式(通道在前,高宽在后)

--input_shape="input:1,3,224,224" \ # 输入形状(batch=1,通道=3,高=224,宽=224)

--log=info \ # 日志级别(info=详细日志,warn=仅警告,error=仅错误)

--precision_mode=fp32 # 推理精度(fp32=单精度浮点,int8=量化精度)

- 转换成功后,当前目录会生成

resnet50.om文件 - 若转换失败:查看日志(默认路径

~/.ascend/log),常见原因是ONNX模型版本不兼容(需≤1.12),可通过onnx-simplifier简化模型后再转换

(2)测试数据准备

上传一张测试图片(如test.jpg)到云电脑当前目录,建议选择常见物体(如猫、狗、汽车),便于后续验证分类结果。

2. 完整代码实现(逐行解析)

# 导入依赖库(逐库说明作用)

import ascendcl as acl # CANN核心API库,负责设备管理、模型加载、推理执行

import numpy as np # 数据处理库,用于图像数组转换、矩阵运算

from PIL import Image # 图像处理库,用于读取图片、调整尺寸

import os # 系统库,用于执行模型转换命令

import traceback # 异常处理库,用于捕获详细错误信息(云环境排错必备)

# --------------------------

# 1. CANN环境初始化(云环境核心优化)

# --------------------------

def init_acl():

"""

功能:初始化CANN环境,包括ACL资源、设备、上下文

云环境适配点:显式创建上下文,避免多用户资源冲突;增加异常捕获,应对云环境不稳定

"""

# 初始化ACL资源(全局唯一,进程启动时执行一次)

ret = acl.init()

if ret != 0:

# 错误码说明:0=成功,非0=失败(具体含义参考CANN官方文档)

print(f"ACL初始化失败!错误码:{ret},错误信息:{traceback.format_exc()}")

return False, None

# 打开指定设备(云电脑通常只有1个设备,ID=0)

# 仿真驱动也需执行此步骤,模拟设备占用

ret = acl.rt.set_device(0)

if ret != 0:

print(f"设备打开失败!错误码:{ret},错误信息:{traceback.format_exc()}")

acl.finalize() # 初始化失败需释放已申请的ACL资源

return False, None

# 创建上下文(Context):云环境多线程/多进程场景必备

# 作用:隔离设备资源,避免不同任务相互干扰

context, ret = acl.rt.create_context(0)

if ret != 0:

print(f"创建上下文失败!错误码:{ret},错误信息:{traceback.format_exc()}")

acl.rt.reset_device(0) # 释放设备占用

acl.finalize() # 释放ACL资源

return False, None

print("CANN环境初始化成功(云环境适配完成)")

return True, context

# --------------------------

# 2. 图像预处理(模型输入格式适配)

# --------------------------

def preprocess_image(image_path):

"""

功能:将原始图片转换为模型要求的输入格式

处理流程:读取图片→调整尺寸→归一化→通道转换→增加batch维度→标准化

"""

try:

# 读取图片(支持JPG、PNG等格式,云电脑需确保图片路径正确)

# 若图片在云存储(如OSS),需先下载到本地:os.system("wget 云存储图片URL -O test.jpg")

image = Image.open(image_path)

print(f"成功读取图片:{image_path},原始尺寸:{image.size}")

# 调整尺寸为224x224(ResNet50模型默认输入尺寸)

# Image.ANTIALIAS:抗锯齿处理,提升图片质量

image = image.resize((224, 224), Image.ANTIALIAS)

# 转换为numpy数组(像素值范围0-255,uint8类型)

image_np = np.array(image, dtype=np.uint8)

print(f"调整后尺寸:{image_np.shape},数据类型:{image_np.dtype}")

# 归一化:将像素值从0-255转为0-1(模型训练时的输入标准)

image_np = image_np.astype(np.float32) / 255.0

# 通道转换:PIL读取为HWC格式(高、宽、通道),模型要求NCHW格式(通道、高、宽)

# 转换后形状:(3, 224, 224)

image_np = np.transpose(image_np, (2, 0, 1))

print(f"通道转换后形状:{image_np.shape}")

# 增加batch维度:模型输入为4维张量(batch, channel, height, width)

# 转换后形状:(1, 3, 224, 224)

image_np = np.expand_dims(image_np, axis=0)

print(f"增加batch后形状:{image_np.shape}")

# 标准化:使用ImageNet数据集的均值和标准差(ResNet50训练时使用)

# 作用:消除不同图片的亮度、对比度差异,提升推理精度

mean = np.array([0.485, 0.456, 0.406]).reshape((3, 1, 1)) # 匹配通道维度

std = np.array([0.229, 0.224, 0.225]).reshape((3, 1, 1))

image_np = (image_np - mean) / std

print("图像预处理完成")

return image_np

except Exception as e:

print(f"图像预处理失败!错误信息:{str(e)},详细堆栈:{traceback.format_exc()}")

return None

# --------------------------

# 3. 模型加载与推理执行(云环境资源优化)

# --------------------------

def infer_with_cann(model_path, image_np, context):

"""

功能:加载.om模型,执行推理,返回推理结果

云环境适配点:按需分配内存,避免资源浪费;及时释放资源,防止内存溢出

"""

# 初始化模型ID和返回结果

model_id = 0

result = None

try:

# 1. 加载离线模型(.om格式)

# 模型加载到设备内存,返回模型ID(后续操作通过ID识别模型)

model_id, ret = acl.mdl.load_from_file(model_path)

if ret != 0 or model_id == 0:

print(f"模型加载失败!错误码:{ret}")

return None

# 2. 获取模型输入/输出描述信息(动态适配模型,无需硬编码)

# 输入描述:包含输入数据类型、形状、尺寸等信息

input_desc = acl.mdl.get_input_desc(model_id, 0) # 0表示第一个输入(单输入模型)

input_size = acl.mdl.get_desc_size(input_desc) # 输入数据总字节数

# 输出描述:包含输出数据类型、形状、尺寸等信息

output_desc = acl.mdl.get_output_desc(model_id, 0) # 0表示第一个输出(单输出模型)

output_size = acl.mdl.get_desc_size(output_desc) # 输出数据总字节数

print(f"模型输入尺寸:{input_size}字节,输出尺寸:{output_size}字节")

# 3. 分配内存(云环境内存有限,按需分配是关键)

# 分配主机内存(Host Memory):存储预处理后的输入数据

input_buf, ret = acl.rt.malloc_host(input_size)

if ret != 0 or input_buf is None:

print(f"主机内存分配失败!错误码:{ret}")

return None

# 分配设备内存(Device Memory):存储推理过程中的数据和结果

# acl.rt.MEMORY_DEVICE:指定分配设备内存

output_buf, ret = acl.rt.malloc(output_size, acl.rt.MEMORY_DEVICE)

if ret != 0 or output_buf is None:

print(f"设备内存分配失败!错误码:{ret}")

acl.rt.free_host(input_buf) # 释放已分配的主机内存

return None

# 4. 创建数据集(CANN推理的输入输出载体)

# 数据集是CANN定义的数据结构,用于管理输入/输出缓存

input_dataset = acl.mdl.create_dataset()

output_dataset = acl.mdl.create_dataset()

# 向输入数据集添加缓存(将主机内存与数据集绑定)

ret = acl.mdl.add_dataset_buffer(input_dataset, input_buf, input_size)

if ret != 0:

print(f"添加输入数据集失败!错误码:{ret}")

return None

# 向输出数据集添加缓存(将设备内存与数据集绑定)

ret = acl.mdl.add_dataset_buffer(output_dataset, output_buf, output_size)

if ret != 0:

print(f"添加输出数据集失败!错误码:{ret}")

return None

# 5. 数据拷贝:主机内存 → 设备内存(云环境数据传输需显式触发)

# 因为模型在设备内存中运行,需将输入数据拷贝到设备

# acl.rt.MEMCPY_HOST_TO_DEVICE:主机到设备的拷贝方向

ret = acl.rt.memcpy(input_buf, input_size, # 目标地址(设备内存)和大小

image_np.ctypes.data, input_size, # 源地址(主机内存)和大小

acl.rt.MEMCPY_HOST_TO_DEVICE) # 拷贝方向

if ret != 0:

print(f"数据拷贝失败!错误码:{ret}")

return None

# 6. 执行模型推理(核心步骤)

# 仿真驱动:模拟推理过程,速度约为实体硬件的1/5,不影响结果正确性

# 实体硬件:利用昇腾芯片算力,快速完成推理

ret = acl.mdl.execute(model_id, input_dataset, output_dataset)

if ret != 0:

print(f"推理执行失败!错误码:{ret}")

return None

# 7. 结果拷贝:设备内存 → 主机内存(将推理结果拷贝回主机)

# 分配主机内存存储输出结果(float32占4字节,故尺寸=output_size//4)

output_np = np.zeros(output_size // 4, dtype=np.float32)

ret = acl.rt.memcpy(output_np.ctypes.data, output_size, # 目标地址(主机内存)

output_buf, output_size, # 源地址(设备内存)

acl.rt.MEMCPY_DEVICE_TO_HOST) # 拷贝方向

if ret != 0:

print(f"结果拷贝失败!错误码:{ret}")

return None

result = output_np

except Exception as e:

print(f"推理过程异常!错误信息:{str(e)},详细堆栈:{traceback.format_exc()}")

finally:

# 8. 释放资源(云环境必须执行,否则内存溢出)

print("开始释放推理资源...")

# 销毁数据集

if 'input_dataset' in locals():

acl.mdl.destroy_dataset(input_dataset)

if 'output_dataset' in locals():

acl.mdl.destroy_dataset(output_dataset)

# 释放内存(先释放设备内存,再释放主机内存)

if 'output_buf' in locals():

acl.rt.free(output_buf)

if 'input_buf' in locals():

acl.rt.free_host(input_buf)

# 卸载模型(释放模型占用的设备内存)

if model_id != 0:

acl.mdl.unload(model_id)

print("推理资源释放完成")

return result

# --------------------------

# 4. 结果解析与可视化(直观展示分类结果)

# --------------------------

def parse_result(result_np):

"""

功能:解析推理结果,输出类别ID和置信度(ImageNet 1000类)

"""

if result_np is None:

return None, None

# 取概率最大的类别(ImageNet 1000类,result_np形状为(1000,))

class_id = np.argmax(result_np)

# 置信度:概率值(0-1之间,越接近1越可信)

confidence = result_np[class_id]

# 加载ImageNet类别名称(可从官网下载labels.txt,上传到云电脑)

# 若未上传labels.txt,仅输出类别ID和置信度

try:

with open("labels.txt", "r", encoding="utf-8") as f:

labels = f.readlines()

class_name = labels[class_id].strip()

return class_id, confidence, class_name

except:

print("未找到labels.txt,仅输出类别ID和置信度")

return class_id, confidence, None

# --------------------------

# 5. 主函数:串联整个流程

# --------------------------

if __name__ == "__main__":

# 初始化CANN环境

init_success, context = init_acl()

if not init_success:

exit(1)

try:

# 预处理图像(替换为你的图片路径)

image_np = preprocess_image("./test.jpg")

if image_np is None:

exit(1)

# 执行推理(模型路径替换为你的.om模型路径)

result_np = infer_with_cann("./resnet50.om", image_np, context)

if result_np is None:

exit(1)

# 解析结果

class_id, confidence, class_name = parse_result(result_np)

if class_name:

print(f"\n分类结果:")

print(f"类别ID:{class_id}")

print(f"类别名称:{class_name}")

print(f"置信度:{confidence:.4f}")

else:

print(f"\n分类结果:类别ID={class_id},置信度={confidence:.4f}")

except Exception as e:

print(f"程序执行异常!错误信息:{str(e)},详细堆栈:{traceback.format_exc()}")

finally:

# 释放所有资源(云环境必须执行,否则占用设备资源)

print("\n开始释放CANN环境资源...")

acl.rt.destroy_context(context) # 销毁上下文

acl.rt.reset_device(0) # 重置设备,释放资源

acl.finalize() # 释放ACL资源

print("CANN环境资源释放完成,程序正常结束")

3. 云环境专属优化点详解

(1)上下文创建与资源隔离

- 云电脑是多用户共享环境,多个开发者可能同时使用CANN

- 通过

acl.rt.create_context(0)创建独立上下文,将当前任务的资源与其他任务隔离,避免冲突

(2)内存精细化管理

- 云电脑内存通常为2-8GB(远低于本地物理机),需避免内存浪费:

- 按需分配内存:根据模型输入/输出尺寸计算所需内存,不额外分配

- 及时释放资源:推理完成后立即销毁数据集、释放内存、卸载模型

- 避免内存泄漏:使用

finally块确保资源无论是否异常都能释放

(3)完善的异常处理

- 云环境网络不稳定、文件路径易出错、资源可能被抢占,增加三重异常保护:

- 每步操作后检查返回码(ret=0为成功)

- 使用

try-except捕获异常,输出详细堆栈信息 - 异常后及时释放已分配的资源,避免资源泄漏

(4)数据传输优化

- 云电脑主机与设备(仿真/实体)的数据传输需显式触发:

- 输入数据:主机→设备(

MEMCPY_HOST_TO_DEVICE) - 输出数据:设备→主机(

MEMCPY_DEVICE_TO_HOST) - 避免频繁传输:预处理在主机完成,仅传输最终输入数据;推理结果仅传输必要数据

- 输入数据:主机→设备(

4. 运行代码与结果验证

(1)运行命令

# 确保当前目录有test.jpg、resnet50.om(若未转换模型,先执行atc转换命令)

python3 resnet50_classification.py

(2)预期输出

CANN环境初始化成功(云环境适配完成)

成功读取图片:./test.jpg,原始尺寸:(1920, 1080)

调整后尺寸:(224, 224, 3),数据类型:uint8

通道转换后形状:(3, 224, 224)

增加batch后形状:(1, 3, 224, 224)

图像预处理完成

模型输入尺寸:602112字节,输出尺寸:4000字节

开始释放推理资源...

推理资源释放完成

分类结果:

类别ID:285

类别名称:Egyptian cat

置信度:0.9876

开始释放CANN环境资源...

CANN环境资源释放完成,程序正常结束

(3)常见运行错误修复

| 错误场景 | 报错信息 | 修复步骤 |

|---|---|---|

| 图片读取失败 | FileNotFoundError: [Errno 2] No such file or directory: './test.jpg' | 1. 检查图片路径是否正确;2. 若图片在云存储,执行wget 图片URL -O test.jpg下载;3. 确保图片格式为JPG/PNG |

| 模型加载失败 | 错误码:1001 | 1. 检查模型路径是否正确;2. 验证模型是否转换成功(ls -l resnet50.om查看文件大小);3. 重新执行atc转换命令 |

| 推理执行失败 | 错误码:2003 | 1. 检查设备是否被占用(npu-smi info查看设备状态);2. 若被占用,等待其他任务完成或重启云电脑;3. 确保驱动与Toolkit版本一致 |

| 内存分配失败 | 错误码:3001 | 1. 关闭云电脑中其他占用内存的程序;2. 减小batch size(如将input_shape改为"input:1,3,224,224");3. 选择内存更大的云电脑实例 |

三、进阶玩法:解锁CANN工业级应用场景

1. 多任务并行推理:最大化利用云电脑CPU资源

云电脑通常配备2-8核CPU,单任务推理会浪费算力,通过多线程实现多模型、多图片并行处理,提升批量处理效率。

(1)核心设计思路

- 任务队列:存储待处理的“模型路径+图片路径”,实现任务解耦

- 线程池:根据CPU核心数创建线程(建议线程数=CPU核心数),避免线程过多导致调度开销

- 结果队列:存储推理结果,主线程统一输出,避免并发写冲突

- 独立环境:每个线程独立初始化CANN环境,避免资源共享冲突

(2)完整代码实现(基于基础案例扩展)

import ascendcl as acl

import numpy as np

from PIL import Image

import os

import traceback

import threading

import queue

import multiprocessing # 用于获取CPU核心数

# 复用基础案例中的init_acl、preprocess_image、parse_result函数

# --------------------------

# 1. 并行推理线程函数

# --------------------------

def parallel_infer_worker(task_queue, result_queue):

"""

功能:线程工作函数,从任务队列获取任务,执行推理,将结果存入结果队列

"""

# 每个线程独立初始化CANN环境(云环境避免资源共享)

init_success, context = init_acl()

if not init_success:

print(f"线程{threading.current_thread().name}:CANN环境初始化失败")

return

while True:

try:

# 从任务队列获取任务(超时1秒,避免无限阻塞)

task = task_queue.get(timeout=1)

model_path, img_path = task

thread_name = threading.current_thread().name

print(f"\n{thread_name}:开始处理任务,模型:{os.path.basename(model_path)},图片:{os.path.basename(img_path)}")

# 预处理图像

image_np = preprocess_image(img_path)

if image_np is None:

result_queue.put((img_path, model_path, -1, 0.0, None)) # 标记失败

task_queue.task_done()

continue

# 执行推理(复用基础案例的infer_with_cann函数,需传入context)

result_np = infer_with_cann(model_path, image_np, context)

if result_np is None:

result_queue.put((img_path, model_path, -1, 0.0, None))

task_queue.task_done()

continue

# 解析结果

class_id, confidence, class_name = parse_result(result_np)

result_queue.put((img_path, model_path, class_id, confidence, class_name))

task_queue.task_done()

print(f"{thread_name}:任务处理完成")

except queue.Empty:

# 任务队列为空,线程退出

print(f"\n{thread_name}:任务队列空,退出线程")

break

except Exception as e:

print(f"{thread_name}:任务处理异常!错误信息:{str(e)},详细堆栈:{traceback.format_exc()}")

task_queue.task_done()

continue

# 释放线程的CANN资源

acl.rt.destroy_context(context)

acl.rt.reset_device(0)

acl.finalize()

# --------------------------

# 2. 主函数:创建线程池,提交任务

# --------------------------

if __name__ == "__main__":

# 1. 配置并行参数

thread_num = multiprocessing.cpu_count() # 获取CPU核心数(云电脑通常为2-4核)

thread_num = min(thread_num, 4) # 限制最大线程数为4,避免资源竞争

print(f"云电脑CPU核心数:{multiprocessing.cpu_count()},启动线程数:{thread_num}")

# 2. 创建任务队列和结果队列

task_queue = queue.Queue()

result_queue = queue.Queue()

# 3. 准备并行任务(支持多模型、多图片)

# 任务格式:(模型路径, 图片路径)

tasks = [

("./resnet50.om", "./cat.jpg"), # 分类任务1:猫图片

("./yolov5.om", "./car.jpg"), # 检测任务1:汽车图片(需提前转换yolov5.om模型)

("./resnet50.om", "./dog.jpg"), # 分类任务2:狗图片

("./yolov5.om", "./person.jpg"), # 检测任务2:人物图片

("./resnet50.om", "./flower.jpg"), # 分类任务3:花朵图片

]

# 4. 将任务加入队列

for task in tasks:

task_queue.put(task)

print(f"共提交{task_queue.qsize()}个任务")

# 5. 创建并启动线程池

threads = []

for i in range(thread_num):

thread = threading.Thread(

target=parallel_infer_worker,

args=(task_queue, result_queue),

name=f"推理线程-{i+1}"

)

thread.daemon = True # 守护线程,主程序退出时自动结束

thread.start()

threads.append(thread)

print(f"启动{thread.name}")

# 6. 等待所有任务完成(阻塞主线程)

task_queue.join()

print(f"\n所有{task_queue.qsize()}个任务处理完成!")

# 7. 输出结果

print("\n" + "="*50)

print("并行推理结果汇总")

print("="*50)

while not result_queue.empty():

img_path, model_path, class_id, confidence, class_name = result_queue.get()

model_name = os.path.basename(model_path)

img_name = os.path.basename(img_path)

if class_id == -1:

print(f"图片:{img_name},模型:{model_name} → 处理失败")

else:

if class_name:

print(f"图片:{img_name},模型:{model_name} → 类别ID:{class_id},类别名称:{class_name},置信度:{confidence:.4f}")

else:

print(f"图片:{img_name},模型:{model_name} → 类别ID:{class_id},置信度:{confidence:.4f}")

(3)云环境优化技巧

- 线程数配置:线程数=CPU核心数(如2核CPU启动2个线程),避免线程切换开销

- 任务拆分:将大批量图片拆分为多个小任务,放入队列,实现负载均衡

- 模型缓存:若多个任务使用同一模型,可在线程初始化时加载一次模型,避免重复加载(需注意线程安全)

- 资源监控:执行

top命令查看CPU和内存占用,若资源紧张,减少线程数或任务批量

2. 云边协同部署:端云一致架构落地

CANN的核心优势之一是“端云一致”,即云电脑上开发调试的模型,可直接部署到边缘设备(如昇腾AI盒子、边缘网关、工业相机),无需修改代码。

(1)云边协同核心流程

云电脑(开发端):模型训练/下载 → 模型优化(量化/剪枝) → 模型转换(ONNX→OM) → 模型导出

↓

边缘设备(部署端):模型上传 → 安装CANN Runtime → 加载模型 → 执行推理

(2)云电脑端:模型优化与转换(关键步骤)

边缘设备通常算力有限(如Ascend 310L芯片),需对模型进行轻量化优化,核心是量化(将FP32精度转为INT8精度),模型体积减小75%,推理速度提升2-3倍。

量化优化详细步骤

- 准备校准数据集:选择100-500张与测试数据相似的图片,生成校准数据列表

calib_data.txt(格式如下):./calib_images/cat1.jpg ./calib_images/dog1.jpg ./calib_images/car1.jpg ... - 执行量化转换命令(atc工具):

atc --model=resnet50.onnx \ --framework=5 \ --output=resnet50_int8 \ # 量化后模型名 --input_format=NCHW \ --input_shape="input:1,3,224,224" \ --precision_mode=force_int8 \ # 强制INT8量化 --calibration_data=calib_data.txt \ # 校准数据集路径 --calibration_method=min_max \ # 量化校准方法(min_max/kl_divergence) --dynamic_image_size="224,224" \ # 动态输入尺寸(可选) --log=info - 量化模型验证:在云电脑上用仿真驱动测试量化模型,确保精度损失在可接受范围(通常置信度下降≤3%):

# 复用基础案例代码,仅修改模型路径为量化后的模型 result_np = infer_with_cann("./resnet50_int8.om", image_np, context)

(3)边缘设备端:部署与运行(详细步骤)

边缘设备以“昇腾AI盒子(Ascend 310)+ Ubuntu 20.04”为例:

1. 安装CANN Runtime(轻量版,仅含运行依赖)

- 下载对应系统的Runtime包(从华为昇腾官网获取):

ascend-runtime-7.0.0-linux-x86_64.deb - 安装命令:

sudo dpkg -i ascend-runtime-7.0.0-linux-x86_64.deb sudo apt -f install -y - 配置环境变量:

echo "export ASCEND_HOME=/usr/local/Ascend" >> ~/.bashrc echo "export LD_LIBRARY_PATH=$ASCEND_HOME/runtime/lib64:$LD_LIBRARY_PATH" >> ~/.bashrc source ~/.bashrc

2. 上传模型与代码

- 将云电脑上的

resnet50_int8.om模型、resnet50_classification.py代码、测试图片上传到边缘设备 - 安装Python依赖(与云电脑端版本一致):

pip3 install -i https://pypi.tuna.tsinghua.edu.cn/simple numpy==1.21.6 pillow==9.5.0 ascendcl==7.0.0

3. 运行推理代码(无需修改任何代码)

python3 resnet50_classification.py

- 预期输出与云电脑端一致,推理速度比FP32模型快2-3倍

- 验证设备信息:执行

npu-smi info,显示Ascend 310设备信息

(4)云边协同优势

- 开发效率高:云电脑提供强大的开发环境(IDE、调试工具),边缘设备专注推理

- 兼容性强:模型一次转换,多端部署,无需适配不同硬件

- 维护便捷:模型升级时,仅需在云电脑重新优化转换,再上传到边缘设备即可

四、云电脑避坑指南:从入门到精通的关键技巧

1. 权限问题:突破云电脑限制

- 问题1:无root权限,安装软件失败

- 解决方案:选择用户级安装路径,如将Toolkit安装到

~/Ascend目录,避免修改系统目录 - 实操:

./Ascend-Toolkit-7.0.0-linux-x86_64.run --install-path=~/Ascend(.run格式安装包)

- 解决方案:选择用户级安装路径,如将Toolkit安装到

- 问题2:sudo命令被限制,无法执行

- 解决方案:使用

pip3 install --user安装Python依赖,避免权限要求 - 实操:

pip3 install --user numpy==1.21.6 pillow==9.5.0(依赖安装到用户目录)

- 解决方案:使用

2. 网络问题:加速资源下载

- 问题1:华为昇腾官网下载Toolkit/驱动速度慢(海外云电脑)

- 解决方案:国内服务器下载后,通过云盘(如华为云OSS、百度网盘)上传到云电脑

- 实操:国内本地下载→上传到华为云OSS→云电脑执行

wget OSS下载链接

- 问题2:pip安装依赖超时

- 解决方案:使用国内镜像源(清华、阿里、豆瓣)

- 实操:

pip3 install -i https://pypi.tuna.tsinghua.edu.cn/simple 依赖包名

- 问题3:云电脑无法访问外部网络

- 解决方案:检查安全组配置(开放出站端口80、443),或使用代理

- 实操:联系云厂商开通网络权限,或配置代理:

export http_proxy=http://代理IP:端口

3. 资源限制:优化资源占用

- 问题1:内存不足,推理时抛出“内存分配失败”

- 解决方案1:减小batch size(如将input_shape从"input:4,3,224,224"改为"input:1,3,224,224")

- 解决方案2:释放不必要的资源,如关闭其他进程(

kill -9 进程ID) - 解决方案3:使用内存更小的模型(如ResNet18替代ResNet50)

- 问题2:存储不足,无法下载大模型(如GPT类模型)

- 解决方案:使用云存储挂载(如华为云OSS挂载到云电脑目录)

- 实操:

ossfs Bucket名称:目录 本地挂载目录 -o url=oss-cn-east-2.aliyuncs.com

4. 版本匹配:避免兼容性问题

CANN的驱动、Toolkit、ascendcl、依赖库版本必须严格匹配,否则会出现各种报错,建议按以下版本组合:

| 组件 | 推荐版本 | 备注 |

|---|---|---|

| 驱动 | 22.0.0 | 与Toolkit版本一致 |

| Toolkit | 7.0.0 | 支持Ubuntu 22.04/CentOS 7.6 |

| ascendcl | 7.0.0 | 与Toolkit版本一致 |

| numpy | 1.21.6 | 兼容Python 3.7-3.9 |

| pillow | 9.5.0 | 避免高版本的兼容性问题 |

| protobuf | 3.20.3 | 匹配CANN的Protobuf版本 |

- 版本查询命令:

- 驱动版本:

npu-smi info(查看Driver Version) - Toolkit版本:

atc --version - ascendcl版本:

pip3 list | grep ascendcl

- 驱动版本:

5. 日志排查:快速定位问题

云环境报错难以复现,日志是排查问题的关键:

- 开启详细日志:在环境变量中添加

export ASCEND_LOG_LEVEL=debug(debug级别最详细) - 日志路径:

~/.ascend/log(每个进程对应一个日志文件,按时间戳命名) - 关键日志筛选:

- 错误信息:搜索“ERROR”或错误码(如“ErrCode: 1001”)

- 资源信息:搜索“Memory”“Device”查看资源占用情况

- 推理信息:搜索“execute”查看推理过程是否正常

五、总结

CANN在云电脑环境的使用,核心是“适配特性+精细管理”——适配云电脑的权限、资源、网络限制,精细化管理环境变量、内存、模型资源,就能充分发挥其端云一致、性能优化的优势。从基础的环境搭建到图像分类实战,再到进阶的多任务并行和云边协同,本文覆盖了从入门到工业级应用的全流程,每一步都包含原理说明、实操命令、问题修复,帮助开发者避开所有坑。

CANN的潜力远不止于此,后续还可探索视频流实时推理、多设备负载均衡、模型压缩优化等高级场景。如果需要进一步深入某一方向,或有特定场景的开发需求,欢迎交流!

要不要我帮你整理一份CANN云电脑开发离线手册,包含所有关键命令、代码模板、错误码对照表,方便你无网络时快速查阅?

浙公网安备 33010602011771号

浙公网安备 33010602011771号