mit6.824课程笔记

欢迎来到我的MIT6.824(分布式系统)学习笔记

资源分享

关于课堂笔记请看: Lecture 12 - Distributed Transaction | MIT6.824

分布式系统简介

6 lab简介

-

Lab 1: 分布式大数据框架 (如 MapReduce)

-

实验 2: 使用复制的容错库 (Raft)

-

实验 3: 一个简单的容错数据库

-

实验 4: 通过分片实现可伸缩的数据库性能

7 三种基础架构:

- 存储

- 通信

- 计算

通信是实现分布式系统的工具, 保证可靠性

大目标: 我们想要把分布式的存储和计算的逻辑抽象封装成简单易用的接口, 就像在单个主机下操作文件系统一样简单

8 考虑的主题(目标)

在对基础架构抽象的过程中需要考虑的一些主题:

-

例如RPC: 就是将我们底层通过不可靠⽹络进⾏通信这个事实进⾏隐藏,

-

通信还需要考虑多线程并发, 锁等

-

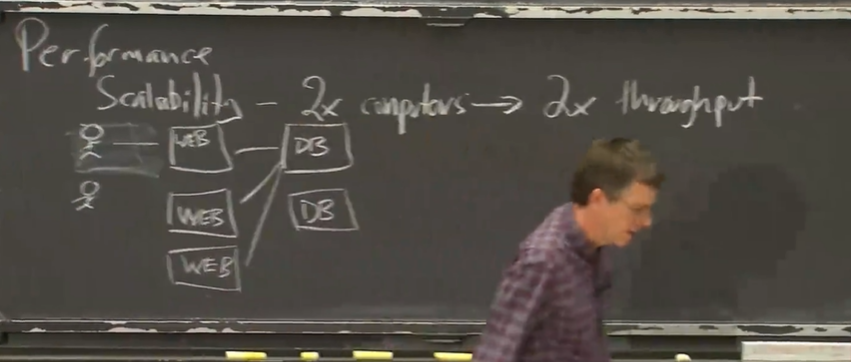

通过可拓展性获得高性能 : 如果你按照某种系数增加⽤于解决问题的计算机数量,那么你就可以得到该系数倍

的吞吐量和系统性能

以http服务器⽹站为例: 起初你可能只需要两台主机(一台充当Web服务器,一台充当数据库); 但随着用户访问量的增加,

要加快处理的速度的⽅法⾸先要做的就是买更多的web服务器,并分流⽤户;

但不幸的是,这种可扩展性并⾮⽆限的,当你有了10台,20台或者100台web服务器访问同⼀个数据库,此时对于这些系统⽽⾔, 此时,数据库就成为了瓶颈,此时你应该去做些系统设计上的⼯作,比如使用分布式数据库系统

你需要进⾏⼀些设计上的⼯作,以此来将这个想法⽆⽌境的推进:

- 容错性: ⼤规模会让你本来不⽤担⼼的⼩概率事件变成了⼀个常⻅问题

- 可用性: 当遇到一些局部故障后, 仍能提供可用的服务

- 可恢复性: 系统感知到太多故障后选择停止服务, 维修减少故障数量后, 能恢复正常(可能需要把最新的数据从硬盘(故障时数据保存)中读取)

- 使用非易失性存储(但是非易失性存储如磁盘,磁臂的移动太慢了相比于CPU)

- 保存系统状态的检查点或Log(就是复制副本, 对副本的管理是一个难题, lab2就是管理副本实现容错)

如果每台电脑预期⼀年会出一次故障(硬件? 软件? 网络? 断电?…)的话,⼀千台电脑也就意味着,你每天可能遇上⼤约有三台电脑出现故障

因为故障总是出现,无法避免 —> 这意味着必须很少发⽣故障,或者只需要在设计中内置⽆故障进⾏能⼒,即掩饰故障的能⼒

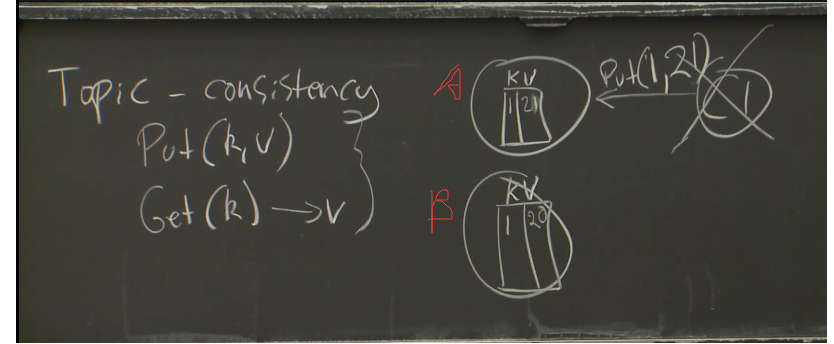

- 最终主题: 一致性

我们想要容错,想要高性能, 通常需要数据副本, 假如你只对一个K-V存储系统做Put和Get, 很难保证一致性:

由于容错的原因,A,B两个副本可能存储在不同的城市, 你用PUT保持数据一致,先修改A(A可能是主服务器),再修改B,但是在修改完A后,和B之间网络故障,或者B主机down了, 总有一天, 主服务器down了.需要切换到B,你可能就读到了旧的数据

即: 在分布式系统中,由于复制或者缓存之类的东⻄,就会造成有多个数据副本的存在, 该键值对可能有很多不同版本 —> 你不一定总能看到最新的数据

强一致性 or 弱一致性?

要保持良好的⼀致性就必须进⾏通信,这可能代价会极其⾼;

或者同时检查所有副本找出最新的那个,但是需要很⾼的代价

MapReduce(分布式计算)

请按照以下顺序食用:

[MapReduce论文翻译](MapReduce:在大型集群上简化数据处理 - 知乎)

重要的是: [6.824Schedule](6.824 Schedule: Spring 2022)中的这节课的Introduction, 说是介绍,其实更像总结(一节课的比较详细的大纲),并且总结的很好

RPC和多线程

1 使用Go的原因:

- ⽐如,对线程的良好⽀持,线程之间的锁和同步;

- 用简单易用的RPC包;类型安全和内存安全(不用担心段错误等);

- 垃圾回收(这就意味着,你永远不需要担⼼会对同⼀段内存释放两次或者释放那些依然在使⽤的内存之类的问题, 当这些东⻄停⽌使⽤的时候,垃圾回收器就会将它们释放, 尤其是在并发场景,这很有用, 因为你只能在所有的线程都不需要某个共享对象时才能释放, 实现很麻烦,如果你使⽤垃圾回收,那这种问题就再也不会困扰我们);

- 最后,那就是这⻔语⾔很简单

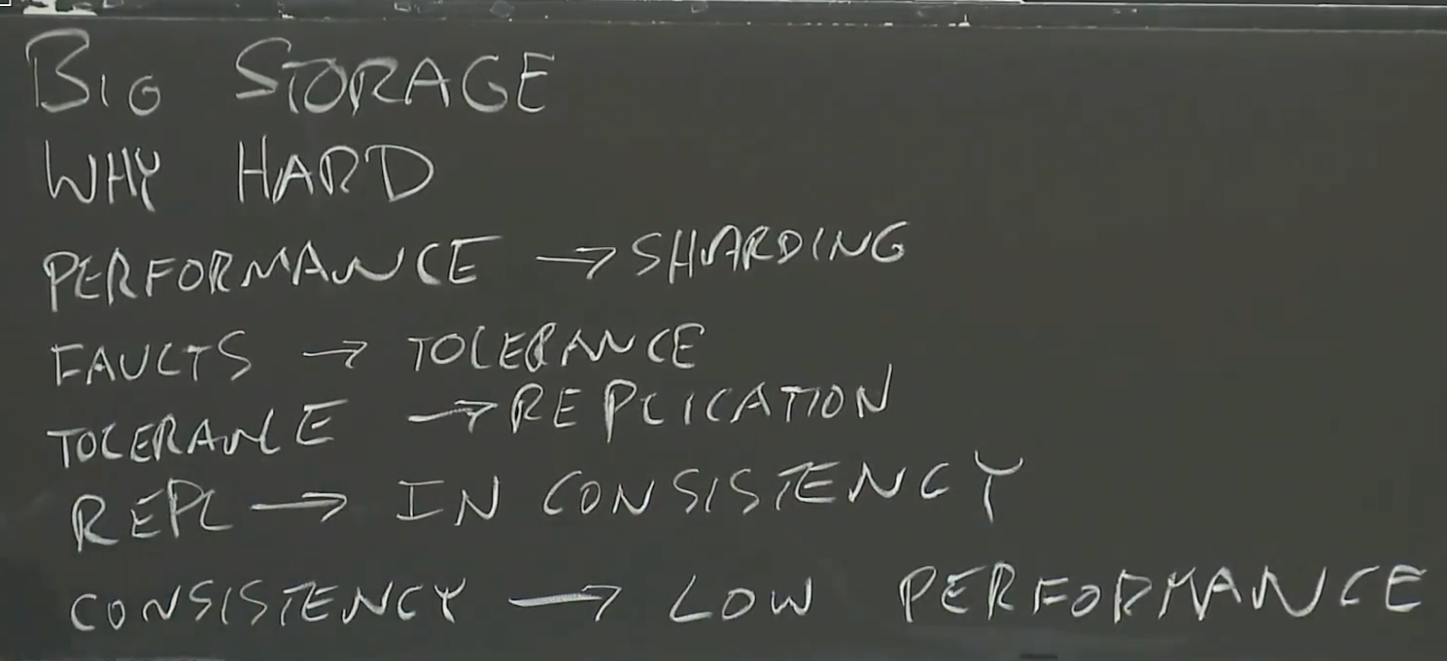

GFS(分布式存储)

论文提出了一种观点: 让分布式系统拥有弱一致性也是可以的

- 文件系统的演变: 单机文件系统 → 分布式文件系统 → GFS

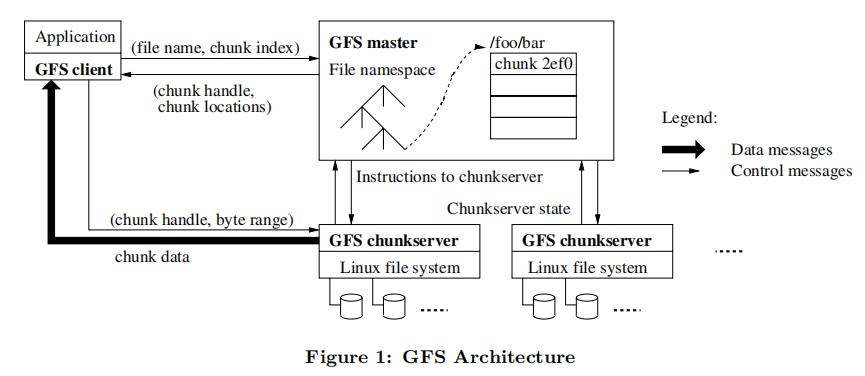

图中的关键点:

-

把文件切分为多个chunk, 每个chunk由一个chunkhandle唯一标志

-

单个master

-

master中保存元数据, chunkserver中存具体的数据

-

master中元数据有:

-

filename —> [chunkhandle1, chunkhandle2 …] (需要保存到Disk)

-

chunkhandle —> [chunkserver1, chunkserver2, chunkserver3] // 每个chunk保存三个副本,在不同的chunkserver上 (不需要保存到Disk, master重启或运行时通过心跳通信获取)

-

version 号 (需要保存到Disk) ,每往这个chunk写入一次,chunk的version #就更新一次,version #越大说明数据越新, 在没有设置primary chunk时,在读/追加写场景下,我们都需要获取最新的chunk(由master询问chunk server,他们保存chunk的 version #,来获取最新的chunk保存在哪个chunkserver上, 因为数据有可能不一致)

使用版本号的原因就是master可以通过chunk的version号来确定,最新的chunk存在哪个chunkserver上,进而确定Primary chunk

-

primary

-

租约

- 不使用租约有脑裂的风险: 当master发送心跳包给primary chunk, 或者当primary chunk给master回复的时候,出现局部网络故障(primary chunk 与 master无法通信, 但是primary chunk与其他chunk副本仍正常通信) 这时候master会再次指定其他的chunk副本作为新的primary chunk—>出现了两个primary chunk

- 租约的作用: 当租约到期primary chunk会自动拒接client的请求, 转为普通chunk; 而master发现与primary chunk失联,要等当前租约到期,才能重新选primary chunk并提供租约

-

-

通过LOG,checkpoint(COW: cope on write) —> Disk

-

-

client会缓存master发来的: chunkhandle —> [chunkserver1, chunkserver2, chunkserver3]

-

写入: 写入分两种: 改写和追加

-

没有Primary chunk时: master去找要获取的chunk的最新version(有记录,并持久化), 找到保存该chunk的chunk server, 将其设置为Primary chunk(写操作是由Primary chunk来控制的)

- 流水线写入, 从离client最近的chunkserver开始, 这里只是缓存在chunkserver上,并没有实际写入chunk

- 具体的写入控制是由chunk primary来做的, chunk primary完成写操作后才通知其他副本进行写入, 这里只有所有副本都写入成功chunk primary才向client汇报写入成功

- 如果应用程序很注重写入的顺序—> 不要把并发写入任务交给多个client,(即使交给同一个client, 如果每次写入任务都涉及多个不同的chunk,那么写入顺序将由各个primary chunk指定, 还是有很大可能顺序不一致(不同chunk之间))

-

可改进的点: 两阶段提交, 当client发送一个请求给primary chunk, primary chunk会先询问各个chunk副本,这个活你们能不能干, 只有所有的chunk副本都回复能干, 等待primary chunk一声令下,再去执行

问题思考:

- A1. 文件怎样分散存储在多台服务器上?怎样实现自动扩缩容?

——****分割存储;自动扩缩容在master单点上增减、

调整chunk的元数据即可

- A2. 怎样知道一个文件存储在哪台机器上?

**——****根据master中文件到chunk再到chunk位置的映射来定位具体的chunkserver

- A3. 怎样保证服务器在故障时文件不损坏不丢失?

——****master的WAL和主备、chunk的多副本

- A4. 使用多副本的话,怎样保证副本之间的一致?

——GFS对改写和追加不同写入模式的区分,在串行和并行情况下设计了不同的一致性

- B1. 怎样支持大文件(几个GB)存储?

——****采用了更大的chunk,以及配套的一致性策略

- B2. 超多机器的情况下,怎样实现自动监控、容错与恢复?

——****master的主备切换由chubby负责,chunk的租约、副本位置与数量由master负责**

- B3. 怎样支持快速的顺序读和追加写?

——****整体上是三写一读的模式,采用了流水线技术和数据流与控制流分离技术保证性能**

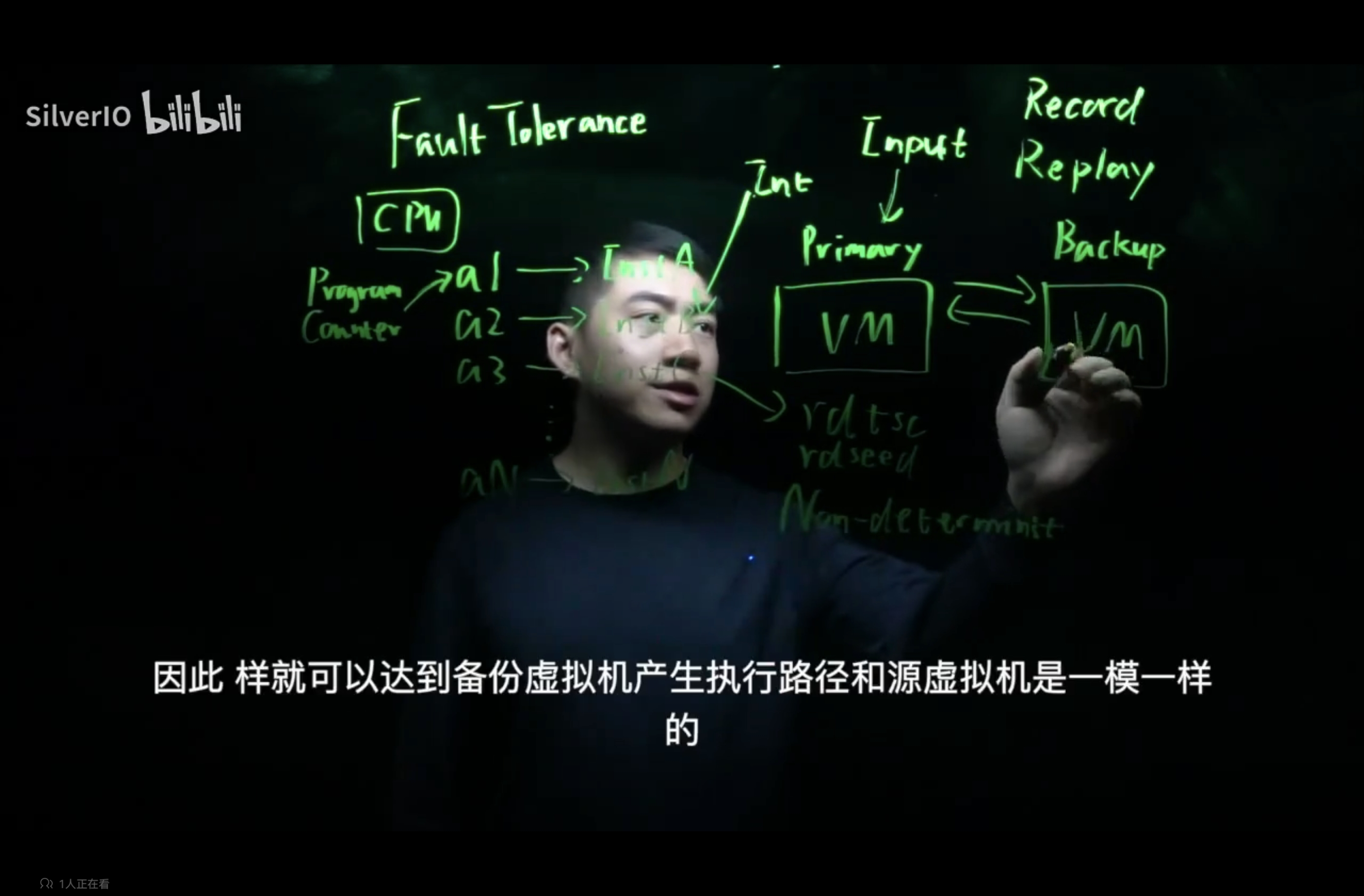

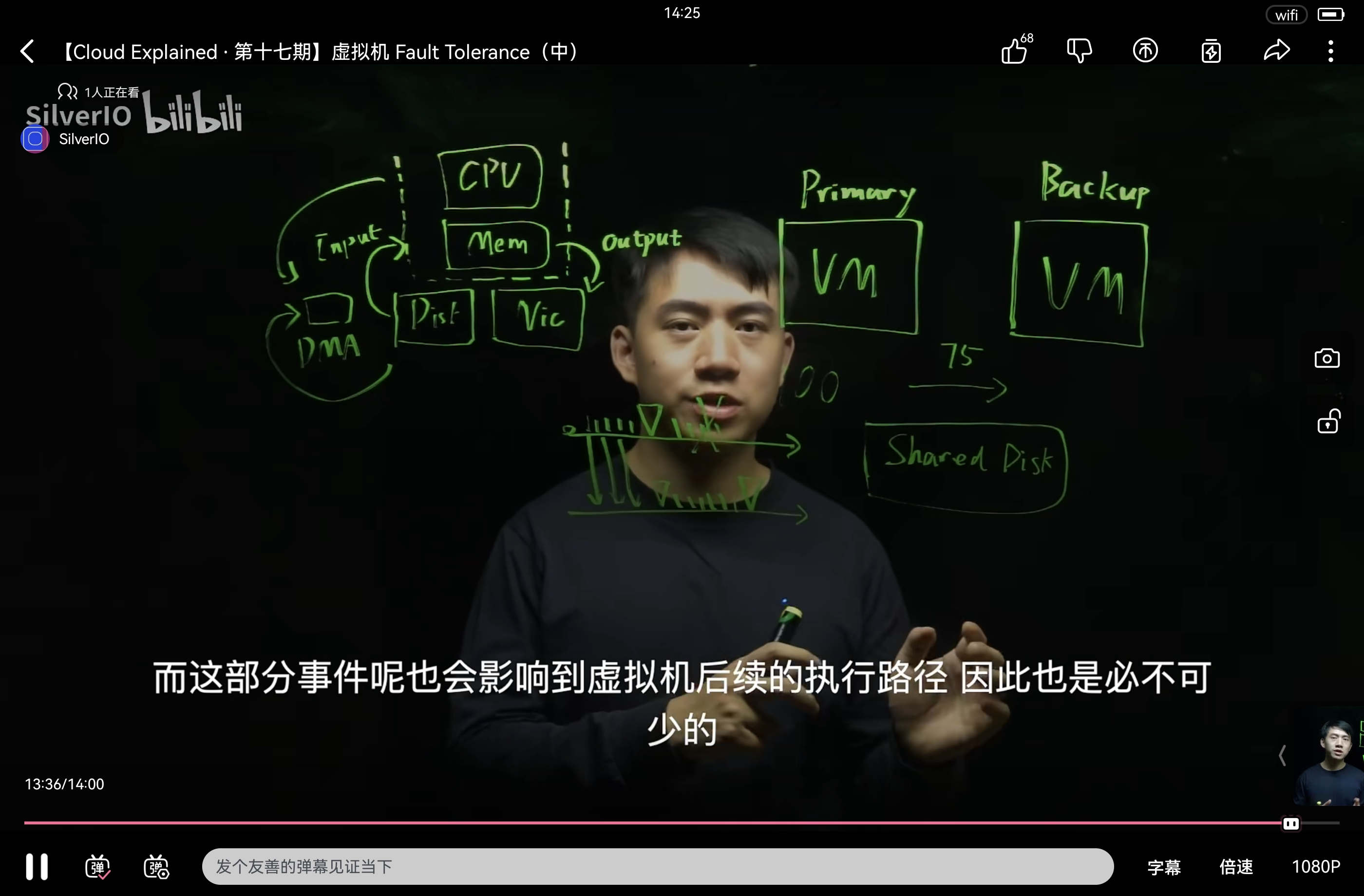

Primary-Backup Replication

推荐一个视频:

【【Cloud Explained ∙ 第十六期】虚拟机 Fault Tolerance(上)】https://www.bilibili.com/video/BV1Ta2UYuEtQ?vd_source=c5fdcb7e8bfbd07851554854d73aa1fa

摘要:

- 实时复制内存不可取, 数据量太大

- 复制指令: 同步 or 异步

- 不可靠指令: 如时间戳, 随机数, IO中断, cpu相关信息等

- 由Hypervisor捕捉指令, 在backup上重放, backup输出被丢弃

- Primary和backup共用一个disk

- 复制指令: 同步 or 异步 —> 实时一致性 or 效率

- 不以不确定性指令作为同步点, 以cpu和内存向外的写操作(外部可见)作为同步点, 即到达该指令,让master阻塞等待把之前的指令都同步到backup

- FT-vm的缺陷: 在多CPU处理机上无法使用, 因为又引入了新的不确定性事件- 在不同cpu上指令的执行顺序

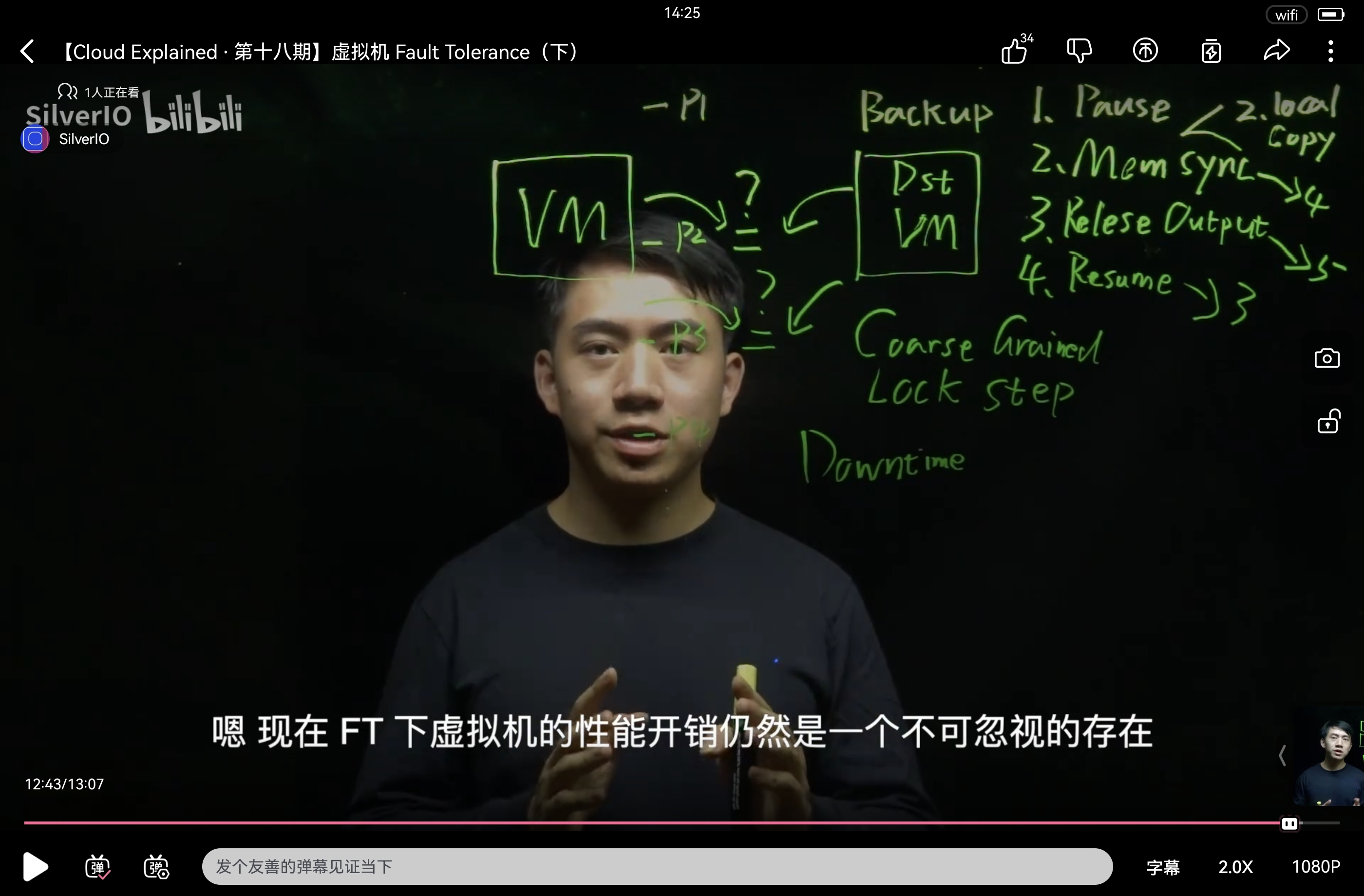

- 新的方法:

- 复制内存页, 仍以输出操作为同步点

- 每到一个同步点, 不着急去同步数据, 先判断该输出结果是否相同, 再确定要不要同步

6.5840 2025 讲座3:主/备复制(Primary/Backup Replication)

今日主题

主/备复制实现容错,以VMware FT(2010)为案例研究——该理念的极致实践

为何研读此文?

-

清晰的主/备设计,揭示本学期反复出现的核心问题:

- 状态机复制(state-machine replication)

- 输出规则(output rule)

- 故障切换/主节点选举(fail-over/primary election)

-

突破性:在

机器指令级

实现复制

- 可透明复制任意应用

- 后续设计需应用层配合,而VM-FT无需

目标:高可用性

- 单机故障时服务不中断

- 实现方式:复制

复制能应对的故障类型

-

适用:单副本"故障-停止"(fail-stop)

- 风扇停转、CPU过热关机

-

电源/网线被拔

- 磁盘空间不足自停

-

不适用(软/硬件BUG):

- 程序错误/操作失误(非故障停止,可能级联崩溃)

-

地震/全市停电(需物理分散的副本)

主流复制方案:复制状态机

- 客户端向主节点发送操作

- 主节点排序后转发备节点

- 所有副本执行相同操作序列

- 起始状态相同 + 操作相同 + 顺序相同 + 确定性 → 最终状态相同

(替代方案:状态转移)

- 起始状态相同 + 操作相同 + 顺序相同 + 确定性 → 最终状态相同

VM-FT采用复制状态机

- 同本课程实验

- 同其他指定论文

副本数量权衡

- 成本限制:通常3-5副本

- 本文仅用2副本(容忍单点故障)

核心问题

- 状态与操作是什么?

- 主节点需等待备节点?

- 备节点如何决策接管?

- 切换时是否可见异常?

- 如何同步新备节点?

复制层级选择

-

应用状态级

(如数据库表)

- 高效(主节点仅发送高层操作)

- 需应用理解容错(如GFS)

-

机器状态级

(寄存器+内存)

- 透明性:可复制任意未修改应用!

- 需转发机器事件(中断、网络包等)

- 需修改机器以收发事件流...

VMware FT:机器级状态复制

- 透明性:运行任意现有OS/服务器软件

- 客户端视角:单台服务器

架构概览

graph LR

A[客户端] --> B[网络]

B --> C[主节点 hypervisor]

B --> D[备节点 hypervisor]

C & D --> E[共享磁盘服务器]

subgraph 物理机1

C --> F[主虚拟机 OS+App]

end

subgraph 物理机2

D --> G[备虚拟机 OS+App]

end

核心机制

- 初始状态同步:主备内存/寄存器完全一致

- 常规指令:多数指令无需同步(如ADD)

- 同步触发点:任何可能导致执行分叉的事件

分叉根源与消除

- 非确定性指令(如读当前时间)

- 外部输入(网络包/磁盘读 → DMA+中断)

- 中断时机

- 不处理多核竞争(仅单处理器)

分叉灾难案例

- 场景:6.5840作业提交服务器

- 主节点:作业包在计时器触发前到达 → 判有效

- 备节点:同一包在计时器后到达 → 判超时

- 后果:主节点故障后,备节点状态不一致暴露

日志通道(Logging Channel)

- 主节点向备节点发送所有事件:

- 中断、网络包、磁盘读取数据

- 备节点输入源:日志条目

- 备节点输出抑制

- 网络中断处理:

- 主/备无法通信时"上线"(go live)提供独立服务

- 主节点上线后停止发送日志

事件处理详解

| 事件类型 | 主节点处理 | 备节点处理 |

|---|---|---|

| 计时器中断 | 1. 截获中断 2. 读指令编号X 3. 发日志"计时器中断@X" 4. 传递中断给虚拟机 | 1. 忽略本地时钟 2. 在指令X处跳转至FT 3. 模拟中断 |

| 网络包到达 | 1. NIC(网卡)写包到弹跳缓冲区 2. 截获中断 3. 复制数据到虚拟机内存 4. 模拟中断 | 1. 从日志读数据/指令号X 2. 在指令X处跳转至FT 3. 复制数据+模拟中断 |

| 非确定性指令 | 1. 截获指令 2. 执行并记录结果 3. 发日志(结果+指令号) | 1. 在指令X处跳转至FT 2. 注入主节点结果(不执行指令) |

跳跃缓冲区作用

- 控制Primary和backup看到网络数据的时机

- 确保主备在相同指令位置看到相同数据

- 避免预读数据导致状态分叉

磁盘I/O处理

- 虚拟本地磁盘 → 实际共享网络磁盘

- 仅主节点读写磁盘:

- 主节点转发读取的数据块

- 备节点忽略应用写操作,读操作用主节点数据

备节点延迟执行

- 要求:至少缓存1个日志条目

- 原因:若主节点在指令X处中断,备节点执行超过X则无法同步

输出处理(关键!)

- 主备同时执行输出指令

- 实际输出者:主节点FT

- 备节点:丢弃输出

输出规则漏洞案例

sequenceDiagram

participant C as 客户端

participant P as 主节点

participant B as 备节点

C->>P: 增值请求(值=10→11)

P->>B: 发送日志条目

P->>C: 回复"11"(随后崩溃)

B->>日志: 条目丢失

B--xC: 未收到请求

C->>B: 新请求:11→12?

B->>C: 回复"11"(状态仍为10!)

解决方案:输出规则

主节点发送输出(网络回复/磁盘写)前,必须等待备节点确认所有先前日志条目

输出规则执行流程

sequenceDiagram

participant C as 客户端

participant P as 主节点

participant B as 备节点

C->>P: 增值请求

P->>B: 发送日志条目

P->>B: 等待ACK

B->>P: 确认ACK

P->>C: 发送"11"回复

输出规则重要性

-

强一致性系统的核心机制(常称"同步复制")

-

性能瓶颈:主节点在某个时间点必须等待, 保证数据以全部同步到backup

-

优化方向:

- 只读操作可能无需等待

-

FT无应用层知识,需保守处理

边界问题解答

| 问题 | 答案 |

|---|---|

| 主节点收ACK后发输出前崩溃 | 备节点接管后: - 若在发送指令前 → 补发输出 - 若在发送后 → TCP机制自动重传(因ACK未达) |

| 主节点发输出后崩溃 | 备节点可能重复输出 - TCP:序列号去重 - 磁盘写:相同数据写相同块 结论:需客户端处理重复或设计幂等操作 |

| 网络分区(脑裂) 当Primary和backup之间存在网络分区,即没办法通信时, 都会认为自己是Primary去和client交互, 不再向对方send log, 导致states不一致 |

共享磁盘仲裁: 1. 节点(Primary/backup)尝试原子性测试并设置(test-and-set) 2. 仅成功者上线 要求:共享磁盘需高可用(单点故障风险); 只要其中一个宕机了, 其他的节点并不知道是什么情况(有可能是网络问题), 这时候就要test-and-set |

| 备节点恢复时崩溃 | 系统完全宕机 → 需集群服务启动新虚拟机 |

| 为何不支持多核? | 未明确说明(推测因多核竞争引入非确定性) |

性能数据

- FT/非FT:延迟增加甚微(表1)

- 日志带宽:18 Mbit/s(反映磁盘读+网络输入速率)

- 局限:高吞吐场景不适用(如高速磁盘读取)

适用场景

- 关键但低强度服务(如域名服务器)

- 不便修改软件的服务

高性能复制替代方案

应用级状态机

(如数据库):

- 状态=数据库(非全内存/磁盘)

- 事件=DB命令(非原始网络包)

- 优势:日志量少,输出规则暂停少

- 案例:GFS、实验2

总结

- 主备复制:VM-FT是经典实现

- 无单点故障的分区应对:下节课内容

- 性能提升:应用级状态机复制

附:多核支持说明

- VMware KB#1013428提及多CPU支持

- VM-FT或从状态机复制转向状态转移(未证实)

- 参考链接:

vSphere容错机制

学术论文1

学术论文2

test-and-set

Test-and-Set:并发编程中的关键原子操作

Test-and-Set(测试并设置)是计算机科学中一种关键的原子操作,用于在多线程或分布式系统中实现互斥锁(mutex)和同步机制。它是构建更高级同步原语(如信号量、屏障等)的基础。

核心概念

-

什么是原子操作?

原子操作是指不可分割的操作——要么完全执行成功,要么完全不执行,中间状态不会被其他线程或进程观察到。在并发环境中,原子操作是构建线程安全数据结构的基础。

2. Test-and-Set 定义

Test-and-Set 是一个硬件支持的原子指令,其功能可以用以下伪代码表示:

function TestAndSet(boolean *lock) {

boolean old = *lock; // 读取当前值

*lock = true; // 无论原值是什么,都设置为true

return old; // 返回原始值

}

这个操作在单个不可中断的步骤中完成:

- 读取内存位置的值

- 将该内存位置设置为true

- 返回读取到的原始值

实现自旋锁(Spinlock)

Test-and-Set 最常见的应用是实现自旋锁:

typedef struct {

int flag;

} spinlock_t;

void spinlock_init(spinlock_t *lock) {

lock->flag = 0; // 0=未锁定, 1=已锁定

}

void spinlock_lock(spinlock_t *lock) {

while (TestAndSet(&lock->flag) == 1) {

// 自旋等待,直到锁可用

}

}

void spinlock_unlock(spinlock_t *lock) {

lock->flag = 0;

}

工作流程:

- 加锁尝试:

- 线程调用

TestAndSet(&lock->flag) - 如果返回0(锁空闲),线程获得锁

- 如果返回1(锁已被占用),线程循环重试

- 线程调用

- 解锁操作:

- 将锁标志设置为0(空闲)

- 注意:解锁不需要原子操作,因为只有锁持有者才能解锁, 其他线程都被阻塞陷入忙等待了

关键特性

- 原子性保证

- 整个操作在单个CPU指令周期完成

- 不会被线程切换或中断打断

- 确保并发环境下状态一致性

- 忙等待(Busy Waiting)

- 等待锁的线程会持续循环检查

- 优点:响应速度快(锁释放后立即获取)

- 缺点:浪费CPU资源(尤其在长时间等待时)

- 内存可见性

- 强制内存屏障(memory barrier)

- 确保锁状态变更对所有处理器核心可见

- 防止指令重排序导致的状态不一致

优缺点分析

优点:

- 简单高效:实现简单,在低竞争环境下性能好

- 无上下文切换:避免操作系统调度开销

- 响应及时:锁释放后可立即获取

缺点:

- 忙等待问题:

- 高竞争时浪费CPU周期

- 可能导致优先级反转(priority inversion)

- 公平性问题:

- 不保证先请求的线程先获得锁

- 可能导致线程饥饿

- 缓存一致性压力:

- 频繁的原子操作增加缓存同步开销

- 在多核系统中可能成为瓶颈

实际应用场景

- 操作系统内核

- Linux内核中的

ticket spinlock - Windows内核的

KSPIN_LOCK

- 并发数据结构

- 无锁队列(lock-free queues)

- 并发哈希表

- 内存分配器

- 分布式系统

- 分布式锁的基础实现

- 领导者选举算法

高级变种

- Compare-and-Swap (CAS)

bool CAS(int *ptr, int expected, int new) {

if (*ptr == expected) {

*ptr = new;

return true;

}

return false;

}

更灵活的原子操作,现代无锁编程的基础

- Fetch-and-Add

int FetchAndAdd(int *ptr, int value) {

int old = *ptr;

*ptr = old + value;

return old;

}

用于实现高效的计数器

- Load-Linked/Store-Conditional (LL/SC)

int LoadLinked(int *ptr) {

return *ptr; // 标记内存地址

}

bool StoreConditional(int *ptr, int value) {

// 仅当标记地址未被修改时存储

}

更灵活的原子操作原语

总结

Test-and-Set作为并发编程的基石:

- 提供硬件级别的原子性保证

- 是构建高效同步机制的基础

- 在操作系统内核和低延迟系统中至关重要

- 理解其原理对优化高性能系统至关重要

在现代系统中,虽然开发者通常使用更高级的同步原语(如互斥锁、信号量),但这些高级原语底层往往依赖于类似Test-and-Set的原子操作。掌握这些基础原理,有助于设计更高效、更可靠的并发系统。

compare-and-swap(CAS)

Compare-and-Swap (CAS):并发编程的基石

Compare-and-Swap (CAS) 是现代并发编程中最重要的原子操作之一,它提供了实现无锁数据结构和同步原语的基础能力。CAS 操作是构建高性能、可扩展并发系统的关键工具。

1. 什么是 CAS?

CAS 是一个原子操作,它执行以下三个步骤:

- 读取内存位置的值

- 比较该值与预期值

- 如果值匹配,则写入新值

整个过程在单个不可中断的操作中完成,伪代码如下:

bool CAS(T* ptr, T expected, T new_value) {

if (*ptr == expected) {

*ptr = new_value;

return true;

}

return false;

}

其中:

- ptr`:指向内存位置的指针

- expected`:预期值(比较值)

new_value:要写入的新值

2. 原子性保证

CAS 操作的关键特性是原子性:

- 整个操作(比较+交换)在单个CPU指令周期完成

- 不会被线程切换或中断打断

- 确保并发环境下状态一致性

3. 实现自旋锁(Spinlock)

CAS 最常见的应用是实现自旋锁:

typedef struct {

int flag; // 0=未锁定, 1=已锁定

} spinlock_t;

void spinlock_lock(spinlock_t *lock) {

while (true) {

if (CAS(&lock->flag, 0, 1)) {

break; // 成功获取锁

}

// 等待并重试

}

}

void spinlock_unlock(spinlock_t *lock) {

lock->flag = 0; // 不需要原子操作

}

zookeeper论文

摘要

在本文中,我们描述了 ZooKeeper,一个用于协调分布式应用程序进程的服务。由于 ZooKeeper 是关键基础设施的一部分,其目标是提供一个简单且高性能的内核,以便客户端在其之上构建更复杂的协调原语。它在一个复制的、集中式的服务中,融合了组消息传递、共享寄存器和分布式锁服务的元素。ZooKeeper 暴露的接口兼具共享寄存器的无等待特性,以及一个类似于分布式文件系统缓存失效机制的事件驱动机制,从而提供了一个简单而强大的协调服务。

ZooKeeper 的接口使其能够实现高性能的服务。除了无等待特性,ZooKeeper 还保证了每个客户端的请求按 FIFO(先进先出)顺序执行,并且对所有改变 ZooKeeper 状态的请求提供线性一致性。这些设计决策使得实现一个高性能的处理管道成为可能,其中读请求可以由本地服务器直接满足。我们通过目标工作负载(读写比从 2:1 到 100:1)表明,ZooKeeper 可以每秒处理数万至数十万次事务。这种性能使得 ZooKeeper 能够被客户端应用程序广泛使用。

详细解释与关键术语解析

这段摘要精炼地概括了 ZooKeeper 的设计目标、核心特性和性能优势。

1. 核心定位:分布式协调服务

- 是什么:ZooKeeper 是一个专门为分布式系统提供协调功能的中心化服务。所谓“协调”,包括但不限于:选举主节点、管理配置信息、发现服务、分布式锁、同步操作等。

- 设计哲学:它不直接提供所有复杂的协调功能,而是提供一个简单、可靠、高性能的核心(Kernel)。应用程序可以基于这个核心,像搭积木一样,构建出自己需要的、更复杂的协调功能(原语)。这是一种“提供机制而非策略”的设计思想。

2. 关键术语解析

a. 组消息传递

- 基本概念:指一种一对多的通信模式,一个节点发送的消息可以被组内的所有其他节点接收。在分布式系统中,这常用于实现状态同步、事件通知或成员管理(如某个节点加入或离开集群)。

- 在 ZooKeeper 中的体现:ZooKeeper 本身是一个复制(Replicated)服务,由多个服务器节点组成一个集群(一个组)。服务器之间使用类似组消息传递的共识协议(如Zab协议)来复制数据、达成状态一致。对于客户端,它通过 “Watch”机制 实现了一种事件通知,客户端可以监听一个数据节点(Znode),当该节点发生变化时,所有监听了它的客户端都会收到通知,这类似于一种反向的组消息传递。

b. 共享寄存器

- 基本概念:在分布式系统中,可以将其想象成一个小小的、可被网络间多个进程共同访问和修改的数据存储单元。它类似于编程中的共享变量,但要解决分布式环境下的并发控制和数据一致性问题。

- 在 ZooKeeper 中的体现:ZooKeeper 的数据模型是一棵树(Znode Tree),每个节点(Znode)就像一个共享寄存器,可以存储少量数据(通常用于存储配置、状态等)。多个客户端可以并发地读取和写入这些 Znode。

c. 分布式锁

- 基本概念:用于控制分布式系统中多个进程/线程对共享资源的互斥访问,确保在同一时间只有一个参与者可以执行临界区代码。实现分布式锁比实现单机锁复杂得多,需要处理网络延迟、节点故障等问题。

- 在 ZooKeeper 中的体现:ZooKeeper 是实现分布式锁的理想基石。利用其有序临时节点(Sequential Ephemeral Nodes)和 Watch 机制,可以非常可靠地实现公平的分布式锁,而无需应用程序自己处理复杂的分布式共识问题。论文说 ZooKeeper 融合了其元素,意味着它提供了构建锁所需的基本工具。

3. 核心特性与设计决策

a. 无等待

- 含义:指客户端的操作(特别是读请求)不需要等待其他客户端的操作完成即可执行。这极大地提升了读操作的性能和可扩展性。

- 实现:ZooKeeper 允许读请求由任何服务器本地处理,无需与其他服务器进行复杂的协调,因此速度极快,是“无等待”的。

b. 事件驱动机制

- 含义:客户端不需要通过轮询(不断重复查询)来获取数据变化,而是事先注册一个监听(Watch)。当数据发生变化时,服务端会主动通知客户端。

- 类比:类似于分布式文件系统的“缓存无效化”(Cache Invalidation)。当客户端缓存的数据在服务器端失效(被修改)时,服务器会通知客户端“你的缓存过期了”,客户端从而知道需要重新获取数据。

c. FIFO 客户端顺序 & 线性一致性

- FIFO 客户端顺序:来自同一个客户端的所有请求(无论是读还是写), ZooKeeper 保证会严格按照它们被发送的顺序执行。这是实现 Watch 机制正确性的基础(你不可能在更新操作完成前先收到更新通知)。

- 线性一致性:所有修改系统状态的写请求(跨所有客户端),当它们完成后,其效果看起来就像是瞬间完成的,并且所有客户端后续的读请求都能看到这个最新的结果。这是非常强的一致性保证,简化了上层应用的开发。

- 注意:ZooKeeper 的全局一致性是写线性化,而读是可能读到稍旧数据的(因为它可以由本地服务器处理)。但这种设计在协调场景中通常是可接受的,并且换来了极高的读性能。

4. 高性能实现

- 读写分离:利用上述特性,ZooKeeper 构建了一个高性能管道。大量的读请求(占工作负载的绝大部分)由本地服务器直接返回数据,延迟极低。只有写请求需要由 Leader 协调进行集群间的共识复制。

- 目标场景:非常适合读多写少的场景(读写比 2:1 到 100:1)。在这种场景下,它的扩展性非常好,可以达到极高的吞吐量(每秒数万至数十万事务)。

总结

ZooKeeper 的成功在于其精妙的设计取舍:

- 提供基础原语而非完整解决方案,使其灵活且通用。

- 通过写线性化 + 读本地化的策略,在保证强一致性的同时,为读多写少的场景提供了极致性能。

- 通过 FIFO 和 Watch 机制,构建了一个简单而强大的事件通知系统。

- 它将组消息(集群复制)、共享寄存器(Znode)和分布式锁(构建能力)等概念融合在一个集中、复制的服务中,为构建可靠的分布式系统提供了至关重要的协调“内核”。

Introduction

大规模分布式应用需要不同形式的协调。配置是最基本的协调形式之一。在其最简单的形式中,配置只是系统进程的操作参数列表,而更复杂的系统则拥有动态配置参数。组成员管理和领导者选举在分布式系统中也很常见:进程通常需要知道哪些其他进程存活以及这些进程负责什么。锁构成了一种强大的协调原语,用于实现对关键资源的互斥访问。

协调的一种方法是为每种不同的协调需求开发专门的服务。例如,Amazon Simple Queue Service [3] 专门专注于队列服务。其他服务则专门为领导者选举 [25] 和配置 [27] 而开发。实现更强大原语的服务可以用来实现功能较弱的原则。例如,Chubby [6] 是一个提供强同步保证的锁服务。锁随后可被用来实现领导者选举、组成员管理等。

在设计我们的协调服务时,我们摒弃了在服务器端实现特定原语的方法,而是选择暴露一个 API,让应用程序开发者能够实现他们自己的原语。这一选择导致我们实现了一个协调内核,它能够在无需更改服务核心的情况下启用新的原语。这种方法实现了多种适应应用需求的协调形式,而不是将开发者限制在一组固定的原语中。

在设计 ZooKeeper 的 API 时,我们避开了阻塞性原语,例如锁。协调服务的阻塞性原语可能导致诸多问题,例如缓慢或故障的客户端会对更快客户端的性能产生负面影响。如果处理请求依赖于其他客户端的响应和故障检测,那么服务本身的实现会变得更加复杂。因此,我们的系统 ZooKeeper 实现了一个 API,用于操作以分层结构组织(如文件系统)的简单无等待数据对象。事实上,ZooKeeper 的 API 类似于任何其他文件系统,仅从 API 签名来看,ZooKeeper 似乎就是去掉了锁方法、open 和 close 的 Chubby。然而,实现无等待数据对象使 ZooKeeper 与基于阻塞原语(如锁)的系统显著不同。

尽管无等待特性对性能和容错很重要,但它对于协调来说并不足够。我们还必须为操作提供顺序保证。特别是,我们发现保证所有操作的 FIFO 客户端顺序和线性化写入,既能够实现服务的高效运行,也足以实现我们应用程序感兴趣的协调原语。事实上,我们可以用我们的 API 为任意数量的进程实现共识,根据 Herlihy 的层次结构,ZooKeeper 实现了一个通用对象[14]。

ZooKeeper 服务包含一个服务器集合(ensemble),它们使用复制来实现高可用性和高性能。其高性能使得包含大量进程的应用程序能够使用这样的协调内核来管理协调的各个方面。我们能够使用一种简单的流水线架构来实现 ZooKeeper,这种架构允许我们有成百上千个未完成的请求,同时仍能实现低延迟。这样的流水线自然支持以 FIFO 顺序执行来自单个客户端的操作。保证 FIFO 客户端顺序使得客户端能够异步提交操作。通过异步操作,一个客户端能够同时拥有多个未完成的操作。这个特性是非常可取的,例如,当一个新客户端成为领导者时,它必须操作元数据并相应地更新它。如果没有多个未完成操作的可能性,初始化时间可能会是秒级而不是亚秒级。

为了保证更新操作满足线性一致性,我们实现了一个基于领导者的原子广播协议[23],称为 Zab[24]。然而,ZooKeeper 应用的典型工作负载以读操作为主,因此扩展读取吞吐量变得非常必要。在 ZooKeeper 中,服务器在本地处理读操作,我们不使用 Zab 来完全排序它们。

在客户端缓存数据是提高读取性能的一项重要技术。例如,一个进程缓存当前领导者的标识符,而不是每次需要知道领导者时都去探测 ZooKeeper,这是有用的。ZooKeeper 使用一种 Watch 机制使客户端能够缓存数据,而无需直接管理客户端缓存。通过这种机制,客户端可以监视给定数据对象的更新,并在更新时收到通知。Chubby 直接管理客户端缓存。它通过阻塞更新来使所有缓存了正在更改数据的客户端缓存失效。在这种设计下,如果这些客户端中有任何一个缓慢或发生故障,更新就会被延迟。Chubby 使用租约(leases)来防止故障客户端无限期地阻塞系统。然而,租约只是限制了缓慢或故障客户端的影响,而 ZooKeeper 的 Watch 则完全避免了这个问题。

在本文中,我们讨论了 ZooKeeper 的设计和实现。使用 ZooKeeper,我们能够实现我们应用程序所需的所有协调原语,尽管只有写操作是线性化的。为了验证我们的方法,我们展示了如何使用 ZooKeeper 实现一些协调原语。

总结来说,我们在本文中的主要贡献是:

- 协调内核:我们提出了一种具有宽松一致性保证的无等待协调服务,用于分布式系统。特别是,我们描述了我们协调内核的设计和实现,我们已在许多关键应用中用它来实现各种协调技术。

- 协调方案(Recipes):我们展示了如何使用 ZooKeeper 来构建更高级的协调原语,甚至是分布式应用中常用的阻塞性和强一致性原语。

- 协调经验:我们分享了我们使用 ZooKeeper 的一些方式,并评估了其性能。

详细解释与关键术语解析

这段文字深入阐述了 ZooKeeper 的设计动机、核心决策及其优势。

1. 设计哲学:提供机制,而非策略(Coordination Kernel)

- 核心思想:ZooKeeper 没有直接提供像“锁”、“选举”这样的具体协调功能(策略)。相反,它提供了一个非常核心的、基础的数据模型(类似文件系统的层次结构节点树)和一套操作这些数据的 API(机制)。

- 好处: 灵活性:开发者可以基于这些简单的基础构件,组合出任何他们需要的、更适合其特定应用的复杂协调原语(即所谓的 "Coordination Recipes")。 稳定性:服务核心(Kernel)非常简单稳定,因为不需要为各种复杂多变的协调场景添加逻辑。所有复杂性都被推到了客户端库中。 通用性:一个 ZooKeeper 集群可以被公司内所有不同类型的分布式应用使用,每个应用按自己的方式使用它。

2. 关键设计决策:无等待 (Wait-free) 与异步 API

- 无等待:客户端的操作(请求)不会因为服务端要等待其他客户端的动作(如释放锁)而被阻塞。客户端发出请求后,总会(很快)得到响应,无论成功或失败。

- 避免阻塞原语:像锁这样的原语本质上是阻塞的(拿不到锁就要等待)。ZooKeeper 的 API 本身不提供这种会阻塞客户端请求的原语。

- 好处: 性能与容错:一个“慢”或“宕机”的客户端不会直接影响其他客户端的性能和可用性。在基于锁的服务中,一个客户端宕机不释放锁,会导致所有其他客户端被阻塞。ZooKeeper 从根本上避免了这个问题。 简化服务端:服务端无需跟踪和管理每个客户端的状态(如谁持有什么锁),只需处理简单的数据读写请求,实现更简单、更健壮。

3. 顺序保证 (Order Guarantees):强大功能的基石

虽然数据模型和 API 很简单,但 ZooKeeper 提供了两个至关重要的顺序保证,使得在其上构建强一致性的原语成为可能:

- FIFO 客户端顺序:来自同一个客户端的所有请求(A, B, C...),会严格按照它们被发送的顺序被 ZooKeeper 服务执行。这是实现异步操作和 Watch 可靠性的基础。

- 线性化写入 (Linearizable Writes):所有客户端的的所有写操作,在完成后,其效果看起来就像是瞬间完成的,并且所有客户端后续的读请求都能看到这个最新的结果。这是一个非常强的一致性保证。

两者的结合:FIFO Client Order + Linearizable Writes 这个组合被证明是构建分布式协调原语的充分条件。论文甚至提到,根据 Herlihy 的理论,ZooKeeper 的数据模型是一个通用对象 (Universal Object),意味着可以用它来实现任何并发对象(包括锁、队列等),即可以实现共识。

4. 高性能架构

- 读写分离: 写操作:使用 Zab 协议(一种原子广播协议)在所有服务器间进行复制,保证线性一致性。这相对较慢,但写操作通常占比较少。 读操作:可以由任何服务器本地处理,无需与其他服务器通信。这使得读吞吐量可以随服务器数量线性扩展,且延迟极低。这是 ZooKeeper 高性能的关键。

- 流水线架构 (Pipelined Architecture):服务器可以异步处理请求,允许单个客户端同时发出大量请求(

have multiple outstanding operations),而服务器会按 FIFO 顺序处理它们。这极大提升了效率,例如一个新主节点可以快速完成初始化。

5. Watch 机制 vs. Chubby 的客户端缓存管理

这是一个非常关键的对比,凸显了 ZooKeeper 的设计优势。

- Chubby (由服务端直接管理客户端缓存):

- 模式:采用“无效化 (Invalidation)”模式。当数据要更新时,服务端会阻塞本次更新,并主动联系所有缓存了该数据的客户端,要求它们失效缓存(这需要客户端的确认应答),然后才完成更新。

- 缺点:如果其中一个客户端响应慢或宕机,本次更新操作就会被阻塞。虽然通过租约 (Leases)(一个有时间限制的授权)来防止故障客户端无限期阻塞(租约到期后服务端会单方面失效缓存),但问题依然存在,只是影响被限制了。慢客户端会直接影响系统更新速度。

- ZooKeeper (Watch 机制):

- 模式:采用“主动通知 (Publish-Subscribe)”模式。客户端在数据上设置一个 Watch(监听器)。当数据变化时,ZooKeeper 服务会异步地、尽力地推送一个事件通知给客户端,告知“数据变了”。客户端随后自己决定何时去获取新数据。服务端不关心客户端是否处理了这个通知,也不等待客户端响应。

- 优点:服务端完全不管理客户端缓存。写操作的成功与否不依赖于任何客户端的行为。一个客户端的慢或故障完全不影响服务端的更新操作和其他客户端。从根本上避免了由客户端引起的阻塞问题。

6. 关键术语:Chubby

- 是什么:Chubby 是 Google 开发的一个粗粒度分布式锁服务。它被设计用于 Google 内部系统(如 Bigtable)来进行领导者选举和元数据存储。

- 核心特性: 提供类似文件系统的接口,但核心抽象是锁。 提供强一致性(线性化)保证。 采用主从复制。 如论文所述,其直接管理客户端缓存的设计是其与 ZooKeeper 的一个重要区别。

- 与 ZooKeeper 的关系:Chubby 是 ZooKeeper 的一个重要的思想先驱和比较对象。ZooKeeper 的设计在很多方面借鉴了 Chubby(如类似文件系统的接口),但又在关键决策上(无等待、Watch 机制)做出了不同的、被认为更优的选择。论文中说 ZooKeeper 的 API 看起来像“没有锁操作的 Chubby”,恰恰说明了两者的渊源和差异。

总结

这段文字清晰地展示了 ZooKeeper 的成功之道:它通过一个简单、无等待的数据内核,辅以强大的顺序保证(FIFO + 线性化写) 和高效的读写分离架构,成功地提供了一个灵活、高性能、高可用的分布式协调基础组件。其“提供机制而非策略”的设计哲学,使其成为了构建分布式系统的“瑞士军刀”,能够适应各种复杂的协调需求。与 Chubby 的对比尤其突出了其在避免客户端引起的阻塞问题上的卓越设计。

The ZooKeeper service

好的,我们将分部分翻译和解释这篇关于 ZooKeeper 的论文内容。

1. 服务概述与术语

翻译:

ZooKeeper 服务

客户端通过客户端 API(使用 ZooKeeper 客户端库)向 ZooKeeper 提交请求。除了通过客户端 API 暴露 ZooKeeper 服务接口外,客户端库还管理着客户端与 ZooKeeper 服务器之间的网络连接。

在本节中,我们首先提供 ZooKeeper 服务的高层概览。然后我们讨论客户端用于与 ZooKeeper 交互的 API。

术语:在本文中,我们使用 客户端 来指代 ZooKeeper 服务的用户,服务器 来指代提供 ZooKeeper 服务的进程,znode 来指代 ZooKeeper 数据中一个内存中的数据节点,这些数据被组织在一个称为数据树的分层命名空间中。我们也使用更新和写入来指代任何修改数据树状态的操作。客户端在连接到 ZooKeeper 时建立一个会话,并获得一个会话句柄,通过它来发出请求。

解释:

这部分介绍了 ZooKeeper 的基本交互模型和核心术语。客户端不直接与服务器集群打交道,而是通过一个客户端库。这个库扮演着关键角色:1)提供编程接口(API);2)管理所有网络通信(如寻找可用的服务器、保持连接等),对应用开发者隐藏了分布式系统的复杂性。

- 客户端:使用 ZooKeeper 服务的应用程序进程。

- 服务器:组成 ZooKeeper 集群的进程,共同提供协调服务。

- znode:这是 ZooKeeper 的核心抽象。它是数据树中的一个节点,可以存储数据(通常是元数据或配置信息)。它不是为存储大文件设计的。

- 数据树:所有 znode 组成的层次结构命名空间,类似于文件系统的目录树。这是 ZooKeeper 组织数据的方式。

- 会话:客户端与 ZooKeeper 服务之间的一个长期连接。会话有超时时间,如果 ZooKeeper 在超时时间内未收到客户端的心跳,则会认为该客户端故障并终止会话。会话是许多功能(如临时节点)的基础。

2.1 服务概述

翻译:

ZooKeeper 向其客户端提供了一组数据节点(znodes)的抽象,这些节点按照分层命名空间组织。客户端通过 ZooKeeper API 操作此层次结构中的 znode 数据对象。分层命名空间通常在文件系统中使用。这是一种组织数据对象的理想方式,因为用户熟悉这种抽象,并且它能更好地组织应用程序元数据。为了引用特定的 znode,我们使用标准的 UNIX 文件系统路径表示法。例如,我们使用 /A/B/C 来表示 znode C 的路径,其中 C 的父节点是 B,B 的父节点是 A。所有 znode 都存储数据,并且除临时节点外,所有 znode 都可以拥有子节点。

客户端可以创建两种类型的 znode:

- 常规节点:客户端通过显式创建和删除来操作常规节点;

- 临时节点:客户端创建此类节点,并可以显式删除它们,或者让系统在创建它们的会话终止时(主动终止或因故障终止)自动删除它们。

此外,在创建新 znode 时,客户端可以设置一个顺序标志。设置了顺序标志创建的节点,其名称后会附加一个单调递增计数器的值。如果 n 是新 znode,p 是父 znode,那么 n 的序列值永远不会小于曾经在 p 下创建的任何其他顺序 znode 名称中的值。

ZooKeeper 实现了 Watch 机制,允许客户端及时接收变更通知,而无需轮询。当客户端发出设置了 watch 标志的读操作时,操作正常完成,但服务器承诺在返回的信息发生变化时通知客户端。Watch 是与会话关联的一次性触发器;一旦被触发或会话关闭,它们就会被注销。Watch 指示发生了变化,但不提供变更内容。例如,如果客户端在 “/foo” 被更改两次之前发出了 getData("/foo", true),客户端将收到一个 watch 事件,告知 “/foo” 的数据已更改。会话事件,例如连接丢失事件,也会发送到 watch 回调函数,以便客户端知道 watch 事件可能会延迟。

解释:

这部分详细说明了 ZooKeeper 的数据模型和核心概念。

- 分层命名空间:这是 ZooKeeper 组织数据的核心方式,类似于文件路径。这种结构非常直观,便于对不同应用的元数据进行分类和管理(例如,

/app1/config,/app2/locks)。 - znode 类型: 常规节点:持久存在的节点,除非显式删除。 临时节点:节点的生命周期与创建它的客户端会话绑定。会话结束(客户端断开或崩溃),节点自动消失。这是实现组 membership(成员管理)和发现机制的基础。例如,每个进程创建一个临时节点代表自己,进程存活则节点在,进程退出则节点自动删除,其他进程通过查看这些节点就知道哪些成员在线。 顺序节点:创建节点时,ZooKeeper 会自动在节点名后附加一个单调递增的、全局唯一的序列号。这是实现公平锁、队列等高级原语的关键。它保证了创建的全局顺序性。

- Watch 机制:这是 ZooKeeper 实现事件驱动编程模型的核心。 一次性:Watch 被触发一次后就需要重新设置。这简化了服务端的实现,避免了维护复杂的状态。 异步通知:客户端不必轮询(不断查询)数据是否变化,而是设置一个 Watch 后就可以继续处理其他任务。当数据变更时,服务端会发送一个事件通知。 不传递数据:Watch 只通知“某事发生了”,客户端需要在收到通知后主动去获取最新数据。这避免了在通知中传输可能很大的数据内容。

翻译:

数据模型。ZooKeeper 的数据模型本质上是一个具有简化 API 且仅支持完整数据读取和写入的文件系统,或者一个具有分层键的键/值表。分层命名空间对于为不同应用程序的命名空间分配子树以及为这些子树设置访问权限非常有用。我们还在客户端利用目录的概念来构建更高级的原语,正如我们将在第 2.4 节中看到的那样。

与文件系统中的文件不同,znode 并非为通用数据存储而设计。相反,znode 映射到客户端应用程序的抽象,通常对应于用于协调目的的元数据。如图 1 所示,我们有两个子树,一个用于应用程序 1 (/app1),另一个用于应用程序 2 (/app2)。应用程序 1 的子树实现了一个简单的组成员协议:每个客户端进程 p_i 在 /app1 下创建一个 znode p_i,只要进程正在运行,该 znode 就会持续存在。

尽管 znode 并非为通用数据存储而设计,但 ZooKeeper 确实允许客户端存储一些信息,这些信息可用于分布式计算中的元数据或配置。例如,在基于领导者的应用程序中,刚刚启动的应用服务器了解当前哪个服务器是领导者是非常有用的。为了实现这个目标,我们可以让当前领导者将这一信息写入 znode 空间中的一个已知位置。Znode 还具有带时间戳和版本计数器的关联元数据,这允许客户端跟踪 znode 的更改并根据 znode 的版本执行条件更新。

会话。客户端连接到 ZooKeeper 并启动一个会话。会话有一个关联的超时时间。如果 ZooKeeper 在超过该超时时间后未从其会话收到任何信息,则认为客户端故障。当客户端显式关闭会话句柄或 ZooKeeper 检测到客户端故障时,会话结束。在一个会话内,客户端观察到一系列状态变化,这些状态变化反映了其操作的执行。会话使客户端能够在 ZooKeeper 集群内透明地从一个服务器移动到另一个服务器,从而在 ZooKeeper 服务器之间持久存在。

解释:

- 数据模型用途:再次强调,ZooKeeper 存储的是元数据(关于数据的数据)和配置信息,而不是大量的应用数据。例如,它存储的是“谁是主节点”、“某个任务是否完成”等信息,而不是任务本身的具体数据。

- 图 1 示例:图中

/app1下的p_1,p_2,p_3就是临时节点的典型应用。每个进程启动时创建一个代表自己的临时节点,进程退出时节点消失。其他进程通过列出/app1的子节点就能知道当前所有存活的进程成员。 - 会话:会话是有状态的连接。客户端的所有操作都在一个会话上下文中进行。会话的超时机制是容错的关键:它允许 ZooKeeper 自动清理故障客户端留下的临时节点和锁。透明故障转移是指如果客户端当前连接的服务器宕机,客户端库会自动将会话重新连接到集群中的另一台服务器,而客户端应用程序可能对此毫无感知(除了短暂的连接延迟)。

2.2 客户端 API

翻译:

我们在下面展示了 ZooKeeper API 的一个相关子集,并讨论了每个请求的语义。

create(path, data, flags):创建一个路径名为path的 znode,将data[]存储在其中,并返回新 znode 的名称。flags使客户端能够选择 znode 的类型:常规、临时,并设置顺序标志;delete(path, version):如果 znodepath处于预期的版本,则删除它;exists(path, watch):如果路径名为path的 znode 存在则返回 true,否则返回 false。watch标志使客户端能够在 znode 上设置一个监视点(watch);getData(path, watch):返回与 znode 关联的数据和元数据,例如版本信息。watch标志的工作方式与exists()相同, except that ZooKeeper does not set the watch if the znode does not exist(除了当 znode 不存在时 ZooKeeper 不会设置监视点);setData(path, data, version):如果版本号是 znode 的当前版本,则将data[]写入 znodepath;getChildren(path, watch):返回 znode 的子节点名称集合;sync(path):等待操作开始时所有未完成的更新传播到客户端所连接的服务器。目前path被忽略。

所有方法在 API 中都同时有同步和异步版本可用。当应用程序需要执行单个 ZooKeeper 操作并且没有并发任务要执行时,它使用同步 API,因此它进行必要的 ZooKeeper 调用并阻塞。然而,异步 API 使应用程序能够同时拥有多个未完成的 ZooKeeper 操作和其他并行执行的任务。ZooKeeper 客户端保证每个操作的相应回调按顺序被调用。

请注意,ZooKeeper 不使用句柄来访问 znode。每个请求都包含被操作 znode 的完整路径。这一选择不仅简化了 API(没有 open() 或 close() 方法),而且消除了服务器需要维护的额外状态。

每个更新方法都接受一个预期的版本号,这实现了条件更新。如果 znode 的实际版本号与预期版本号不匹配,则更新失败并返回意外版本错误。如果版本号为 -1,则不执行版本检查。

解释:

这部分列出了 ZooKeeper 的核心 API。

- API 设计:API 非常精简,主要围绕 znode 的 CRUD(创建、读取、更新、删除)操作。

- 同步 vs 异步: 同步 API:调用会阻塞,直到收到服务器的响应。简单,但吞吐量低。 异步 API:调用立即返回,应用程序提供一个回调函数。当操作完成时,库会在后台线程中调用该回调函数。这是实现高性能的关键,允许客户端并行发送大量请求。

- 无句柄设计:每次操作都使用完整路径。这使 API 变得无状态(服务器不需要为每个客户端维护“打开文件”的表),极大地简化了服务端的实现并提高了可扩展性。

- 条件更新(版本号):这是实现乐观锁的关键机制。 客户端读取数据时,会获取到该数据的版本号(例如

version=5)。 当客户端要更新数据时,它必须提供之前读到的版本号 (setData(path, newData, 5))。 如果在此期间没有其他客户端修改过数据(版本号还是5),则更新成功,版本号变为6。 如果在此期间数据已被其他客户端修改(版本号变为6),则本次更新失败,客户端必须重新读取数据并重试。 这避免了使用沉重的悲观锁,非常适合读多写少的场景。

2.3 ZooKeeper 保证

翻译:

ZooKeeper 有两个基本的顺序保证:

- 线性化写入:所有更新 ZooKeeper 状态的请求都是可串行化的并尊重先后顺序;

- FIFO 客户端顺序:来自给定客户端的的所有请求都按照客户端发送的顺序执行。

请注意,我们对线性化的定义与 Herlihy [15] 最初提出的定义不同,我们称之为 A-线性化(异步线性化)。在 Herlihy 的线性化原始定义中,一个客户端一次只能有一个未完成的操作(一个客户端是一个线程)。在我们的定义中,我们允许一个客户端有多个未完成的操作,因此我们可以选择保证同一客户端未完成操作没有特定顺序,或者保证 FIFO 顺序。我们为我们的特性选择后者。

观察到所有对线性化对象成立的结果对 A-线性化对象也成立是非常重要的,因为满足 A-线性化的系统也满足线性化。因为只有更新请求是 A-线性化的,ZooKeeper 在每个副本本地处理读请求。这使得服务能够随着服务器添加到系统中而线性扩展。

为了了解这两个保证如何相互作用,请考虑以下场景。一个包含多个进程的系统选举一个领导者来指挥工作进程。当一个新的领导者接管系统时,它必须更改大量配置参数并在完成后通知其他进程。我们有两个重要的要求:

- 当新领导者开始进行更改时,我们不希望其他进程开始使用正在更改的配置;

- 如果新领导者在配置完全更新之前死亡,我们不希望进程使用这部分配置。

观察到分布式锁,例如 Chubby 提供的锁,有助于第一个要求,但不足以满足第二个要求。使用 ZooKeeper,新领导者可以将一个路径指定为就绪 znode(ready znode);其他进程仅在该 znode 存在时才会使用配置。新领导者通过删除 ready、更新各种配置 znode 和创建 ready 来进行配置更改。所有这些更改都可以通过流水线操作和异步发出,以快速更新配置状态。尽管更改操作的延迟大约为 2 毫秒,但如果一个接一个地发出请求,一个必须更新 5000 个不同 znode 的新领导者将需要 10 秒;通过异步发出请求,请求将花费不到一秒。由于顺序保证,如果一个进程看到就绪 znode,它必须也看到新领导者所做的所有配置更改。如果新领导者在就绪 znode 创建之前死亡,其他进程知道配置尚未最终确定,并且不会使用它。

上述方案仍然有一个问题:如果一个进程在新领导者开始更改之前看到 ready 存在,然后在更改进行时开始读取配置,会发生什么。这个问题通过通知的顺序保证得到解决:如果客户端正在监视更改,客户端将在看到更改后系统的新状态之前看到通知事件。因此,如果读取就绪 znode 的进程请求被通知该 znode 的更改,它将在可以读取任何新配置之前看到一个通知客户端更改的事件。

当客户端除了 ZooKeeper 之外还有自己的通信通道时,可能会出现另一个问题。例如,考虑两个客户端 A 和 B,它们在 ZooKeeper 中有一个共享配置,并通过共享通信通道进行通信。如果 A 更改了 ZooKeeper 中的共享配置,并通过共享通信通道将更改告知 B,B 会期望在重新读取配置时看到更改。如果 B 的 ZooKeeper 副本稍微落后于 A 的副本,它可能看不到新配置。使用上述保证,B 可以通过在重新读取配置之前发出写入来确保它看到最新的信息。为了更有效地处理这种情况,ZooKeeper 提供了 sync 请求:后跟一个读操作时,构成一个慢速读取。sync 导致服务器在处理读取之前应用所有未完成的写入请求,而没有完整写入的开销。此原语在思想上类似于 ISIS [5] 的 flush 原语。

ZooKeeper 还具有以下两个活性和持久性保证:如果大多数 ZooKeeper 服务器处于活动状态并相互通信,服务将可用;并且如果 ZooKeeper 服务成功响应更改请求,那么只要法定数量的服务器最终能够恢复,该更改就会在任意数量的故障中持续存在。

解释:

这部分阐述了 ZooKeeper 最核心的理论基础和行为保证。

- 两个核心保证: 线性化写入:所有写操作是强一致性的。一旦一个写操作成功,所有后续的读操作(无论从哪个服务器读)都必须能看到这个写操作的结果,或者之后更新的结果。这保证了全局顺序。 FIFO 客户端顺序:来自同一个客户端的所有操作(读和写)都会按照它们发出的顺序被应用。这保证了单个客户端的操作顺序。

- A-线性化:这是对经典线性化定义的扩展,以适应 ZooKeeper 的异步 API。经典定义要求客户端是同步的(一个操作完成后再发下一个)。ZooKeeper 允许客户端异步地发出大量操作,但保证这些操作在服务器端最终会按照客户端发出的顺序(FIFO)被处理。这既提供了强一致性,又提供了高性能。

- 读写分离的性能优势:写操作需要集群共识(通过 Zab 协议),所以慢。读操作可以由任何服务器本地处理(因为数据是复制的),所以非常快。这使得 ZooKeeper 的读吞吐量可以近乎线性地随着服务器数量增长。

- 示例:新领导者配置更新:这个例子完美展示了两个保证如何协同工作。 领导者异步地发出大量写请求(

delete(ready),setData(config1),setData(config2), ...,create(ready))。 由于 FIFO 顺序,这些请求在服务器端会按照这个顺序被处理。 由于线性化写入,所有客户端看到的状态变化顺序是一致的。 因此,任何看到ready节点被创建出来的客户端,必定已经看到了之前所有对configX的修改。这是一个非常强大且有用的属性。 - Watch 顺序保证:Watch 通知先于数据变化对客户端可见。这确保了客户端在读到新数据之前就知道数据已经变了,避免了竞态条件。

sync操作:用于解决“跨信道”问题。如果客户端通过 ZooKeeper 之外的方式(如另一个网络消息)得知数据已变更,它不能直接去读,因为可能读到旧数据(如果它连接的服务器刚好滞后)。sync操作会强制客户端等待,直到它连接的服务器追上了最新的写操作,然后接下来的读操作就能读到最新值。它是一种轻量级的“写操作”,只用于同步状态,不传输数据。

2.4 原语示例

翻译:

在本节中,我们展示如何使用 ZooKeeper API 来实现更强大的原语。ZooKeeper 服务对这些更强大的原语一无所知,因为它们完全是在客户端使用 ZooKeeper 客户端 API 实现的。一些常见的原语,如组成员关系和配置管理,也是无等待的。对于其他原语,例如 rendezvous ,客户端需要等待事件。尽管 ZooKeeper 是无等待的,但我们可以使用 ZooKeeper 实现高效的阻塞原语。ZooKeeper 的顺序保证允许有效地推理系统状态,而监视允许高效地等待。

配置管理 ZooKeeper 可用于在分布式应用程序中实现动态配置。在其最简单的形式中,配置存储在一个 znode zc 中。进程启动时带有 zc 的完整路径名。启动的进程通过读取 zc 并设置 watch 标志为 true 来获取其配置。如果 zc 中的配置被更新,进程会收到通知并读取新配置,再次将 watch 标志设置为 true。

请注意,在此方案中,与大多数其他使用监视的方案一样,监视用于确保进程拥有最新的信息。例如,如果一个正在监视 zc 的进程收到 zc 更改的通知,并且在它能够发出对 zc 的读取之前 zc 又发生了三次更改,该进程不会收到另外三个通知事件。这不会影响进程的行为,因为这三个事件只会通知进程它已经知道的事情:它拥有的 zc 信息已经过时。

Rendezvous 有时在分布式系统中,最终系统配置会是什么样子并不总是先验清楚的。例如,客户端可能想要启动一个主进程和几个工作进程,但启动进程是由调度程序完成的,因此客户端无法提前知道诸如地址和端口等信息,以便提供给工作进程来连接到主进程。我们使用 ZooKeeper 处理这种情况,使用一个 rendezvous znode zr,这是一个由客户端创建的节点。客户端将 zr 的完整路径名作为主进程和工作进程的启动参数传递。当主进程启动时,它用它正在使用的地址和端口信息填充 zr。当工作进程启动时,它们读取 zr 并将 watch 设置为 true。如果 zr 尚未被填充,工作进程等待被通知 zr 被更新。如果 zr 是一个临时节点,主进程和工作进程可以监视 zr 被删除,并在客户端结束时自行清理。

组成员关系 我们利用临时节点来实现组成员关系。具体来说,我们利用临时节点允许我们看到创建节点的会话状态这一事实。我们首先指定一个 znode zg 来表示组。当组中的一个进程成员启动时,它在 zg 下创建一个临时子 znode。如果每个进程有唯一的名称或标识符,则该名称用作子 znode 的名称;否则,进程使用 SEQUENTIAL 标志创建 znode 以获得唯一的名称分配。进程可以将进程信息放在子 znode 的数据中,例如进程使用的地址和端口。

在 zg 下创建子 znode 后,进程正常启动。它不需要做任何其他事情。如果进程失败或结束,代表它的 zg 下的 znode 会自动被移除。

进程可以通过简单列出 zg 的子节点来获取组信息。如果一个进程想要监视组成员关系的变化,该进程可以将 watch 标志设置为 true,并在收到更改通知时刷新组信息(始终将 watch 标志设置为 true)。

解释:

这部分展示了如何用 ZooKeeper 的基础 API 构建高级功能,体现了其“提供机制而非策略”的设计哲学。

- 配置管理:这是一个典型的“发布-订阅”模式。客户端订阅(watch)一个配置节点,当配置变更时收到通知,然后拉取新配置。一次性 Watch 的语义在这里是合适的,因为客户端只需要知道“配置变了”这一事件,而不需要知道变了多少次,最终它都会去拉取最新的完整配置。

- Rendezvous(汇合点):用于解决动态发现问题。主进程的地址信息在启动前是未知的。通过一个预先约定好的 znode (

zr),主进程启动后将自己的地址信息写入这里,工作进程启动后来自动从这里读取。Watch 机制让工作进程在主进程还没启动时能耐心等待。 - 组成员关系:这是临时节点的经典用例。每个进程在组 znode (

zg) 下创建一个临时子节点代表自己。进程存活,节点就在;进程崩溃或断开,节点自动消失。其他进程通过getChildren就能获取到当前在线的、健康的成员列表。配合 Watch,可以实时监控组成员的变化。

翻译:

简单锁 尽管 ZooKeeper 不是一个锁服务,但它可用于实现锁。使用 ZooKeeper 的应用程序通常使用根据其需求定制的同步原语,例如上面显示的那些。这里我们展示如何使用 ZooKeeper 实现锁,以表明它可以实现各种通用的同步原语。

最简单的锁实现使用“锁文件”。锁由一个 znode 表示。为了获取锁,客户端尝试使用 EPHEMERAL 标志创建指定的 znode。如果创建成功,客户端持有锁。否则,客户端可以读取该 znode 并将 watch 标志设置为 true,以便在当前领导者死亡时收到通知。客户端在其死亡或显式删除 znode 时释放锁。一旦观察到 znode 被删除,正在等待锁的其他客户端会再次尝试获取锁。

虽然这个简单的锁协议有效,但它确实有一些问题。首先,它受到羊群效应的影响。如果有许多客户端等待获取锁,当锁被释放时它们都会争夺锁,尽管只有一个客户端可以获取锁。其次,它只实现排他锁。以下两个原语展示了如何克服这两个问题。

无羊群效应的简单锁 我们定义一个锁 znode l 来实现此类锁。直观上,我们将所有请求锁的客户端排队,每个客户端按请求到达的顺序获取锁。因此,希望获取锁的客户端执行以下操作:

加锁

n = create(l + "/lock-", EPHEMERAL|SEQUENTIAL)C = getChildren(l, false)- 如果

n是C中序号最小的 znode,退出(获得锁) p=C中按顺序排在n之前的那个 znode- 如果

exists(p, true)等待 watch 事件 - 回到第 2 步

解锁

delete(n)

在加锁的第 1 行中使用 SEQUENTIAL 标志相对于所有其他尝试对客户端的加锁尝试进行排序。如果客户端的 znode 在第 3 行具有最小的序列号,则客户端持有锁。否则,客户端等待要么持有锁要么将在此客户端的 znode 之前获得锁的那个 znode 被删除。通过仅监视在客户端的 znode 之前的 znode,当锁被释放或锁请求被放弃时,我们通过仅唤醒一个进程来避免羊群效应。一旦客户端正在监视的 znode 消失,客户端必须检查它现在是否持有锁。(先前的锁请求可能已被放弃,并且可能仍然有一个序列号更低的 znode 在等待或持有锁。)释放锁就像删除代表锁请求的 znode n 一样简单。通过在创建时使用 EPHEMERAL 标志,崩溃的进程将自动清理任何锁请求或释放它们可能持有的任何锁。

总之,这种锁方案具有以下优点:

- 一个 znode 的移除只会引起一个客户端被唤醒,因为每个 znode 正好被另一个客户端监视,所以我们没有羊群效应;

- 没有轮询或超时;

- 由于我们实现锁的方式,我们可以通过浏览 ZooKeeper 数据来查看锁争用的程度、打破锁以及调试锁问题。

读写锁 为了实现读写锁,我们稍微修改锁过程,并拥有单独的读锁和写锁过程。解锁过程与全局锁情况相同。

写锁

n = create(l + "/write-", EPHEMERAL|SEQUENTIAL)C = getChildren(l, false)- 如果

n是C中序号最小的 znode,退出 p=C中按顺序排在n之前的那个 znode- 如果

exists(p, true)等待事件 - 回到第 2 步

读锁

n = create(l + "/read-", EPHEMERAL|SEQUENTIAL)C = getChildren(l, false)- 如果

C中没有比n序号更小的写 znode,退出 p=C中按顺序排在n之前的那个写 znode- 如果

exists(p, true)等待事件 - 回到第 3 步

这个锁过程与之前的锁略有不同。写锁仅在命名上不同。由于读锁可以共享,第 3 和第 4 行略有不同,因为只有更早的写锁 znode 会阻止客户端获取读锁。当有几个客户端等待读锁并在序号较低的 “write-” znode 被删除时收到通知,看起来我们可能有了“羊群效应”;事实上,这是一个期望的行为,所有这些读客户端都应该被释放,因为它们现在可能获得了锁。

解释:

这部分展示了如何实现分布式锁,这是最经典的协调原语之一。

- 简单锁(有问题):尝试创建同一个临时节点作为锁。谁创建成功谁就获得锁。问题在于羊群效应:锁释放时,所有等待的客户端都会被通知,然后一起蜂拥而至地竞争,给网络和 ZooKeeper 集群带来巨大压力。

- 无羊群效应的锁(队列锁):这是 ZooKeeper 实现锁的标准且推荐的方式。它利用了顺序临时节点。 排队:每个想获取锁的客户端在锁目录下创建一个顺序临时节点。ZooKeeper 保证了这些节点名称的全局唯一和递增顺序。这相当于所有客户端都拿到了一个排队号。 检查:客户端获取锁目录下的所有子节点(即所有排队号)。 判断:如果自己的节点是序号最小的,则获得锁。 等待:如果不是,它只监视排在自己前面的那个节点的存在与否(

exists(p, true))。 链式唤醒:当前一个节点被删除(代表前一个客户端释放了锁)时,只有监视它的这一个客户端会被通知。然后这个客户端醒来,检查自己是否变成了最小的节点(是则获锁,否则继续监视新的前一个节点)。

这样,锁的释放只会唤醒一个客户端,完全避免了羊群效应。这是一个非常巧妙的设计。 - 读写锁:在队列锁的基础上进行扩展。核心思想是: 写锁:是排他的,所以逻辑和普通队列锁一样。它必须等待所有前面的节点(无论是读是写)释放。 读锁:是共享的。它只需要等待前面的写锁释放即可。一旦前面没有写锁了,所有的读锁可以同时共享资源。当最后一个写锁释放时,它会通知下一个节点(可能是一个读锁,也可能是一个写锁)。如果下一个是读锁,那么这个读锁获锁,并且由于读锁可以共享,它之后连续的所有读锁都可以同时获锁,这就造成了“羊群效应”,但这是读写锁语义所期望的。

翻译:

双屏障 双屏障使客户端能够同步计算的开始和结束。当足够多的进程(由屏障阈值定义)加入屏障后,进程开始其计算,并在完成后离开屏障。我们在 ZooKeeper 中用一个称为 b 的 znode 来表示一个屏障。每个进程 p 在进入时通过创建一个作为 b 的子节点的 znode 来向 b 注册,并在准备离开时注销——删除该子节点。当 b 的子 znode 数量超过屏障阈值时,进程可以进入屏障。当所有进程都移除了它们的子节点时,进程可以离开屏障。我们使用监视来高效地等待进入和退出条件得到满足。为了进入,进程监视 b 的一个就绪子节点的存在,该子节点将由导致子节点数量超过屏障阈值的进程创建。为了离开,进程监视一个特定的子节点消失,并且仅在该 znode 被移除后检查退出条件。

解释:

- 双屏障:用于同步一个分布式计算的开始和结束。例如,所有进程必须等到 N 个进程都准备好才开始计算,并且必须等到所有进程都计算完才一起结束。

- 实现: 注册:每个进程在屏障 znode

b下创建一个子节点(通常是临时节点)来注册自己。 进入(开始):进程通过getChildren检查b的子节点数量。如果数量达到阈值,就可以开始计算。如果没达到,可以 watchb的子节点变化,等待条件满足。论文中提到一个优化:由一个进程在条件满足时创建一个ready节点,其他进程 watch 这个ready节点是否存在,这样可以避免所有进程都去 watchb的子节点列表变化(羊群效应)。 离开(结束):进程计算完成后,删除自己注册的节点。然后,它需要等待所有其他进程也删除它们的节点(即子节点数量降为0)。同样,可以通过 watch 最后一个被删除的节点来实现高效等待。

总结

这篇论文详细阐述了 ZooKeeper 作为一个分布式协调“内核”的设计理念、实现机制和广泛应用。其核心在于提供一个简单、高效、可靠的基础数据模型(分层命名空间、znode、Watch)和 API,并通过强大的一致性保证(线性化写、FIFO 客户端顺序)使得客户端能够在此基础上构建出各种复杂的分布式协调原语,如配置管理、服务发现、分布式锁、队列、屏障等。这种“机制而非策略”的设计使得 ZooKeeper 极其灵活和强大,成为众多分布式系统的基础组件。

Consistency and Linearizability

6.5840 2025 讲座4:一致性模型,线性一致性

今日主题:一致性模型,特别是线性一致性

存储作为独立服务非常普遍

因此计算和存储分离,通过RPC通信

[简单图示]

例如:网站应用逻辑 vs 数据库

例如:MapReduce vs GFS

我们需要能够推理分布式存储的正确行为

例如:应用开发者对GFS或实验2的期望

部分涉及单个请求的行为

今日重点:并发客户端如何交互

--> 一致性模型

什么是一致性模型?

规范不同客户端对服务视图的关系

聚焦带网络客户端的键值存储:

put(k, v) -> <完成>

get(k) -> v

给定put/get调用,哪些结果是有效的?

在普通顺序编程中无需讨论:

我们期望读操作返回最后写入的值

何时需要讨论正确性?

[简单客户端/服务器图示]

读与写并发

副本

缓存

故障恢复

消息丢失

重传

为何存储系统需要显式一致性模型?

对应用:没有存储保证则难以确保正确性

例如生产者计算后执行:

put("result", 27)

put("done", true)

消费者执行:

while get("done") == false:

pause

v = get("result")

v是否保证为27?

对服务:没有规范则难以设计/实现/优化

例如:客户端从GFS副本(而非主节点)读取是否可行?

存在多种一致性模型

有时为简化应用开发者工作

有时为追求存储性能

有时描述实现者便利的行为

不同领域定义重叠(如文件系统、数据库、CPU内存)

今日重点:线性一致性

但也会涉及:

最终一致性

因果一致性

分叉一致性

可串行化

驱动力:性能/便利性/容错的权衡

线性一致性

这是一种规范——服务必须如何行为的要求

从客户端视角:从服务外部观察

通常被称为"强一致性"

线性一致性较符合程序员直觉

但排除许多优化

你将在实验2实现线性化键值存储

并在实验4中实现容错版本

起点

假设存在串行规范定义单个操作行为

串行 = 单服务器顺序执行操作

db[]

put(k, v):

db[k] = v

return true

get(k):

return db[k]

此处无意外

并发客户端操作如何处理?

客户端发送请求:

网络传输耗时;

服务器计算,与副本通信等;

回复通过网络返回;

客户端接收回复

在此期间其他客户端可能发送/接收/等待!

因此串行规范不能直接应用

我们需要描述并发场景的方法,

以讨论哪些结果有效/无效

定义:历史记录

描述可能并发操作的时间线

每个操作有客户端开始和结束时间

(客户端发送RPC请求和接收回复的时间)

以及参数和返回值

示例:

C1: |-Wx1-| |-Wx2-|

C2: |---Rx2---|

X轴为真实时间

|- 表示客户端发送请求时间

-| 表示客户端接收回复时间

"Wx1"表示put(x, 1)

"Rx2"表示get(x) -> 2

C1发送put(x,1),收到回复,发送put(x,2),收到回复

写操作有响应,表示完成

C2发送get(x),收到回复=2

历史记录是实际执行中客户端观察的追踪

用于检查执行是否线性化

设计者用于"这样是否可行"的思想实验

定义:历史记录线性化当且仅当

- 能为每个操作在开始(客户端发出请求)和结束(客户端收到回复)之间找到一个时间点(客户端操作在服务器端已完成)

- 历史记录的结果值与按时间点顺序串行执行相同

示例历史1:

|--Wx1--| |--Wx2--|

|----Rx2----|

|--Rx1--|

此历史是否线性化?

能否为每个操作找到线性化点?

可能需要尝试不同时间点分配方案

以下顺序满足规则:

Wx1 Rx1 Wx2 Rx2

- 每个点位于开始和结束之间

- 序列满足串行put/get规范

注意:任一读操作可能返回1或2

因此线性化常允许多种不同结果

我们常无法提前预测,但可事后检查

注意:服务可能未在这些点执行操作!

我们不关心服务内部如何运作

只关注客户端可见结果可能

源于某种时间点顺序的执行

线性化定义的用途?

设计者:此优化是否导致非线性化结果?

程序员:作为客户端能假设/期望什么?

测试:生成请求,检查观察到的历史

为何称"线性化"?

线性化点将并发操作转为串行执行——"线性"

因此"可线性化"指结果等同于

操作的某种线性执行

示例2:

|-Wx1-| |----Wx2----|

|---Rx2---|

|-Rx1-|

可尝试几种线性化点分配

如Wx1 Wx2 Rx2 Rx1?

无效,因"Wx2 Rx1"不符合串行规范

如何证明非线性化?

证明无时间点分配方案可行

即违反时间规则或值规则

常可简化排除大量分配方案

例如时间规则要求Wx1或Rx2必须在前

此示例无可行方案!

Wx2的点必须在Rx2之前

因此Wx2点也在Rx1之前

第二次读获得不可能的值

若系统产生此历史,则说明:

系统非线性化:存在缺陷,或从未承诺线性化

若无Rx2,Rx1本可合法

读(及写)操作会影响未来的合法性

因此若需线性化:

一旦读操作观察到写,所有严格后续读必须也观察到

排除脑裂

不能遗忘已揭示的写操作

排除如崩溃后遗忘数据

GFS非线性化:可能产生示例2历史

因Rx1可能来自未更新的副本

若需GFS线性化,

一种方法是让客户端读也通过主节点

但会更慢!

示例3:

|--Wx0--| |--Wx1--|

|--Wx2--|

|-Rx2-| |-Rx1-|

看似非线性化:因Rx2应强制第二次读也看到2

但此顺序显示可线性化:Wx0 Wx2 Rx2 Wx1 Rx1

因此:

服务可为并发写选择任意顺序

线性顺序可与开始/结束时间不同!

示例4:

|--Wx0--| |--Wx1--|

|--Wx2--|

C1: |-Rx2-| |-Rx1-|

C2: |-Rx1-| |-Rx2-|

是否存在串行顺序?

C1需 Wx2 Rx2 Wx1 Rx1

C2需 Wx1 Rx1 Wx2 Rx2

无法同时满足Wx2在Wx1前和后

故非线性化

因此:

服务可为并发写选择任意顺序

但所有客户端必须看到相同写顺序

存在副本或缓存时至关重要

所有副本必须以相同顺序执行操作

示例5:

|-Wx1-|

|-Wx2-|

|-Rx1-|

无可行顺序——非线性化

因此:

读必须返回最新数据:线性化排除陈旧读

即使读者不知晓写操作

时间规则要求读返回最新数据

再次影响缓存和副本的使用

线性化禁止的诱人设计/错误:

脑裂(双主节点)

崩溃重启后遗忘已完成写操作

从滞后副本或过期缓存读取

示例6:

[客户端/网络/服务器图示]

C1发送put(x,1)

C2发送put(x,2)

服务接收C1请求;

网络丢弃响应;

C1的RPC库重传请求

服务执行C1的两个请求是否合法?

若C3读取三次可能看到:

C1: |--------Wx1---------| (due to retransmission(重传))

C2: |-Wx2-|

C3: |-Rx1-| |-Rx2-| |-Rx1-|

假设x初始为0

此历史非线性化!

因此若需线性化:

必须抑制重传的重复请求!

实验2...

线性化系统不限于读写操作

递增

追加

测试并设置(实现锁)

服务器状态的任何操作

应用开发者青睐线性化——相对易用:

- 读看到新数据——非陈旧

- 无写时所有客户端看到相同数据

- 所有客户端以相同顺序看到数据变更

因此put(v,27); put(done,true)示例成立

对比弱一致性时这些优势更明显

如何实现线性化?

取决于所需的副本数、缓存和容错能力

单机串行无故障服务器

[图示:客户端、服务器、操作队列、状态]

服务器为并发到达的请求选择顺序

按序逐个执行,

回复后再处理下一个

加上重复请求抑制

注意:服务器无需推理历史、

线性化点或并发

能否有比线性化更强的一致性?

例如get看到最近完成的put?

此场景保证Rx2,永不Rx1:

C1: |---Wx1---|

C2: |---Wx2---|

C3: |--Rx2--|

此场景保证Rx1,永不Rx2:

C1: |---Wx1---|

C2: |---Wx2---|

C3: |--Rx1--|

如此一个保证可能是困难的:

服务器不易知晓操作何时在客户端完成

线性化对服务器友好,因其允许

自由排序并发操作

若需高可用性?

主备复制

[图示:主节点、两个备节点]

所有请求到主节点

选择串行顺序

转发给备节点

备节点按相同顺序执行

主节点仅在备节点执行后回复客户端

因此若客户端收到响应,所有备节点保证已执行

主节点故障时至关重要

避免遗忘已完成请求

客户端不能像GFS中直读备节点

C1可能看到新值,后续又看到旧值

需外部仲裁决定备节点接管

避免脑裂

例如VMware FT共享磁盘的原子测试并设置,或GFS协调者

线性化系统性能?

坏消息:串行特性难以并行加速

坏消息:副本化需大量通信和等待

坏消息:副本化要求副本可达,限制容错

好消息:可按键分片

其他一致性模型?

能否提供更好性能?

是否有直观语义?

示例:最终一致性——弱模型

数据多副本(如不同数据中心)

读操作咨询任意副本(如最近)

写操作更新任意副本(如最近)

副本a在单次更新完成后即响应

副本后台同步更新

最终其他副本将看到更新

最终一致性较流行

比线性化更快

尤其副本在不同城市时

可用性更高——任意副本即可响应

无需等待主备通信

Amazon Dynamo;Cassandra;GFS

但最终一致性向应用开发者暴露异常:

- 读可能看不到最新写——读可能看到陈旧数据

密码更改、ACL变更时成问题 - 写可能乱序

破坏result/done示例 - 不同客户端可能看到不同数据

- 并发写同一项需解决冲突!

C1: put(x,1)

C2: put(x,2)

可能先应用于不同副本

之后才同步到其他副本

如何合并并发新值?

如何确保所有副本选择相同终值?

最终达成一致 - 最终一致性不支持测试并设置等操作

通用模式:通常只能二选一

强一致性

最大可用性

不可兼得

强一致性需等待副本更新,

过多副本不可达时无法进行

故可用性差

最终一致性在无其他副本可达时仍可进行

但一致性弱

FAQ(frequently asked questions 常见问题解答)

好的,这是您提供的关于线性一致性的问答内容的中文翻译:

问:什么是线性一致性?

答: 线性一致性是定义服务在面对并发客户端请求时行为正确性的一种方式。粗略地说,它规定服务应该表现得好像它按照客户端操作到达的顺序一个接一个地执行这些操作。

线性一致性是针对“历史”(history)定义的:即客户端操作的追踪记录,标注了客户端开始每个操作的时间以及客户端看到该操作完成的时间。线性一致性告诉你单个历史是否合法;如果服务可能生成的每个历史都是线性一致的,我们就可以说该服务是线性一致的。

历史中有一个事件对应客户端开始一个操作,另一个事件对应客户端判定操作已完成。因此,历史显式地体现了客户端之间的并发性和网络延迟。通常,开始和完成事件对应于与服务器交换的请求和响应消息。

一个历史是线性一致的,如果你能为每个操作分配一个“线性化点”(一个时间点),其中每个操作的点位于其开始和完成事件的时间之间,并且历史的响应值与如果你按点顺序一个接一个地执行操作所得到的值相同。如果没有线性化点的分配能满足这两个要求,则该历史不是线性一致的。

线性一致性的一个重要结果是服务在执行并发(时间上重叠的)操作顺序方面具有自由度。特别是,如果客户端 C1 和 C2 的操作是并发的,服务器可以执行 C2 的操作在先,即使 C1 在 C2 之前开始。另一方面,如果 C1 在 C2 开始之前完成,线性一致性要求服务表现得好像它在 C2 的操作之前执行了 C1 的操作(即,如果有的话,C2 的操作必须观察到 C1 操作的效果)。

问:线性一致性检查器如何工作?

答: 一个简单的线性一致性检查器会尝试所有可能的顺序(或线性化点的选择),以查看是否有一种顺序根据线性一致性的定义规则是有效的。因为这在大型历史上会太慢,聪明的检查器会避免查看明显不可能的排序(例如,如果提议的线性化点在操作开始时间之前),将历史分解成可以单独检查的子历史(当可能时),并使用启发式方法优先尝试更可能的顺序。

这些论文描述了相关技术;我认为 Knossos 基于第一篇论文,而 Porcupine 添加了第二篇论文的思想:

http://www.cs.ox.ac.uk/people/gavin.lowe/LinearizabiltyTesting/paper.pdf

https://arxiv.org/pdf/1504.00204.pdf

问:服务是否使用线性一致性检查器来实现线性一致性?

答: 不;检查器仅作为测试的一部分使用。

问:那么服务如何实现线性一致性?

答: 如果服务实现为单个服务器,没有复制、缓存或内部并行性,那么服务按照请求到达的顺序一个接一个地执行客户端请求几乎就足够了。主要的复杂性来自于客户端因为认为网络丢失消息而重发请求:对于有副作用的请求,服务必须注意只执行任何给定的客户端请求一次。如果服务涉及复制或缓存,则需要更复杂的设计。

问:有没有使用 Porcupine 或类似测试框架测试过的现实世界系统的例子?

答: 这种测试很常见——例如,看看 ;Jepsen 是一个组织,它测试了许多存储系统的正确性(以及在适用情况下的线性一致性)。

具体到 Porcupine,这里有一个例子:

问:其他一致性模型有哪些?

答: 可以查找

最终一致性 (eventual consistency)

因果一致性 (causal consistency)

分叉一致性 (fork consistency)

可串行化 (serializability)

顺序一致性 (sequential consistency)

时间线一致性 (timeline consistency)

在数据库、CPU 内存/缓存系统和文件系统领域还有其他的模型。

一般来说,不同的模型在它们对应用程序员有多直观,以及你能用它们获得多少性能方面有所不同。例如,最终一致性允许许多异常结果(例如,即使一个写操作已完成,后续的读取也可能看不到它),但在分布式/复制环境中,它可以比线性一致性以更高的性能实现。

问:为什么线性一致性被称为强一致性模型?

答: 它在禁止许多可能让应用程序员惊讶的情况的意义上是“强”的。

例如,如果我调用 put(x, 22),并且我的 put 完成了,并且没有其他人写 x,随后你调用 get(x),线性一致性保证你看到的除了 22 之外没有其他值。也就是说,读取看到的是新数据。

再举一个例子,如果没有人写 x,我调用 get(x),你也调用 get(x),我们不会看到不同的值。

这些属性在我们稍后将看到的其他一些一致性模型中并不成立,例如最终一致性和因果一致性。后面这些模型通常被称为“弱”一致性。

问:在实践中,人们如何确保他们的分布式系统是正确的?

答: 彻底的测试是一个常见的计划。

形式化方法的使用也很常见;这里有一些例子:

~stavros/papers/2022-cpp-published.pdf

问:为什么使用线性一致性作为一致性模型,而不是其他模型,比如最终一致性?

答: 人们确实经常构建提供比线性一致性更弱一致性的存储系统,例如最终一致性和因果一致性。

线性一致性对应用程序编写者有一些很好的特性:

- 读取总是观察到新数据。

- 如果没有并发写入,所有读取者看到相同的数据。

- 在大多数线性一致的系统上,你可以添加像测试并设置(test-and-set)这样的小型事务(因为大多数线性一致的设计最终会对每个数据项上的操作进行一个接一个的执行)。

像最终一致性和因果一致性这样的较弱方案可以实现更高的性能,因为它们不需要立即更新所有数据副本。这种更高的性能通常是决定性因素。对于一些应用程序,弱一致性不会引起问题,例如,如果存储的是从不更新的数据项,如图像或视频。

然而,弱一致性给应用程序编写者带来了一些复杂性:

- 读取可能观察到过时(陈旧)的数据。

- 读取可能观察到乱序的写入。

- 如果你写入,然后读取,你可能看不到你的写入,而是看到陈旧的数据。

- 对相同项目的并发更新不是一次一个执行的,因此很难实现像测试并设置或原子递增这样的小型事务。

问:你如何决定那条橙色小线(操作的线性化点)放在哪里?在图中,它看起来像是随机画在请求主体内的某个地方。

答: 其思想是,为了证明一个执行是线性一致的,你(作为人)需要找到放置这些橙色小线(线性化点)的位置。也就是说,为了证明一个历史是线性一致的,你需要找到一个线性化点的分配(从而一个操作顺序),该分配符合这些要求:

- 所有函数调用在其调用和响应之间的某个瞬间有一个线性化点。

- 所有函数在其线性化点瞬间发生,行为符合顺序定义。

因此,一些线性化点的放置是无效的,因为它们位于请求的时间跨度之外;另一些是无效的,因为它们违反了顺序定义(对于键值存储,违反意味着读取没有观察到最近写入的值,这里的“最近”指的是线性化点)。

对于一个复杂的历史,你可能需要尝试许多线性化点的分配,以找到一个能证明该历史是线性一致的分配。如果你尝试了所有可能都无法找到,那么这个历史就不是线性一致的。

问:是否存在这样的情况:当两个命令同时执行时,我们能够强制执行特定的行为,使得一个命令总是先执行(即它总是有一个更早的线性化点)?

答: 在一个线性一致的存储服务中(例如 GFS 或你的 Lab 4),如果来自多个客户端的请求是并发的,服务可以自由选择执行它们的顺序。在实践中,大多数服务按照请求碰巧到达网络的顺序执行请求。实际的实现通常不涉及显式的线性化点概念。

问:我们可以执行哪些其他类型的更强的一致性检查?不知何故,线性一致性在直觉上感觉不太有帮助,因为即使你在同一时间执行两个命令,你也可能读取到不同的数据。

答: 确实,线性一致性让人想起在程序中使用线程而不使用锁。这种方式可以正确编程,但需要小心。

更强一致性概念的一个例子是事务(transactions),如许多数据库中发现的,它有效地锁定了所使用的任何数据。对于读写多个数据项的程序,事务比线性一致性更容易编程。“可串行化”(Serializability)是提供事务的一种一致性模型的名称。

然而,事务系统比线性一致系统要复杂得多、慢得多,并且更难实现容错。

问:是什么使得验证现实系统涉及“巨大的努力”?

答: 验证意味着证明一个程序是正确的,保证它符合某些规范。事实证明,证明关于复杂程序的重要定理是困难的——比普通编程困难得多。

你可以尝试本课程的实验来感受一下:

问:根据指定的阅读材料,大多数分布式系统并没有被正式证明是正确的。那么一个团队如何决定他们已经对产品进行了足够彻底的测试,可以交付给客户?

答: 在产品上市并获得收入之前就开始发货是一个好主意,否则公司可能会耗尽资金而破产。人们会在此之前尽可能多地进行测试,并且通常会说服一些早期客户使用该产品(并帮助发现错误),同时理解它可能无法正常工作。也许当产品功能足以满足许多客户并且没有已知的重大错误时,你就准备好发货了。

除此之外,明智的客户也会测试他们所依赖的软件。任何严肃的组织都不会期望任何软件没有错误。

问:为什么不使用客户端发送命令的时间作为线性化点?也就是说,让系统按照客户端发送操作的顺序执行操作?

答: 构建一个保证这种行为的系统很困难——开始时间是客户端代码发出请求的时间,但由于网络延迟,服务可能直到很久以后才收到请求。也就是说,请求到达服务的顺序可能与开始时间的顺序大不相同。原则上,服务可以延迟执行每个到达的请求,以防有更早发出时间的请求稍后到达,但很难知道要等多久,因为网络延迟可能是无界的。而且这会增加每个请求的延迟,可能增加很多。话虽如此,我们稍后将看到的 Spanner 使用了相关的技术。

像线性一致性这样的正确性规范需要在足够宽松以便高效实现,但又足够严格以向应用程序提供有用保证之间走一条细线。“看起来按调用顺序执行操作”对于高效实现来说太严格了,而线性一致性的“看起来在调用和响应之间的某个时间点执行”是可实现的,尽管对应用程序员来说不那么直观。

问:如果同时存在一个并发的 put(),并发的 get() 可能看到不同的值,这是一个问题吗?

答: 在存储系统的背景下,这通常不是问题。例如,如果我们讨论的值是我的个人资料照片,并且两个不同的人在我更新照片的同时请求查看它,那么他们看到不同的照片(旧的或新的)是合理的。

问:在哪些应用场景下,线性一致性比弱一致性模型更容易编程?

答: 假设应用程序的一部分计算一个值,将其写入存储系统,然后在存储系统中设置一个标志,指示计算的值已就绪:

v = compute...

put("value", v)

put("done", true)

在另一台计算机上,一个程序检查 "done" 以查看值是否可用,如果可用就使用它:

if get("done") == true:

v = get("value")

print v

如果实现 put() 和 get() 的存储系统是线性一致的,上述程序将按预期工作。

对于许多弱一致性模型,上述程序可能不会如人们所希望的那样工作。例如,提供“最终一致性”的存储系统可能会对两个 put 进行重排序(导致 "done" 为 true 而 "value" 不可用),或者可能为任何一个 get() 返回一个陈旧(旧)的值。

问:现实世界中有哪些线性一致存储系统的例子?以及哪些存储系统提供较弱的一致性保证?

答: Google 的 Spanner 和 Amazon 的 S3 是提供线性一致性的存储系统。

Google 的 GFS、Amazon 的 Dynamo 和 Cassandra 提供较弱的一致性;它们可能最好被归类为最终一致的。

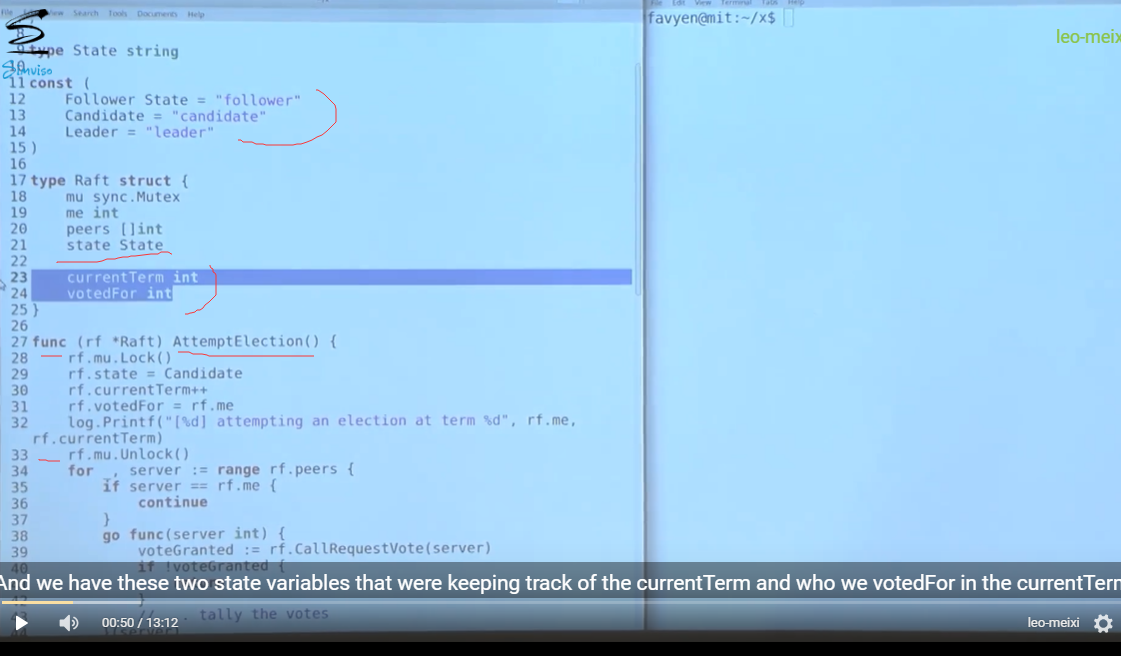

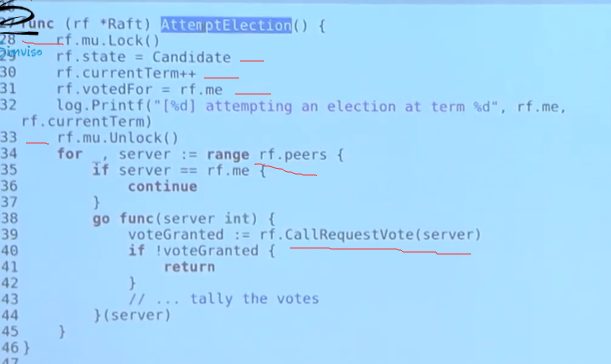

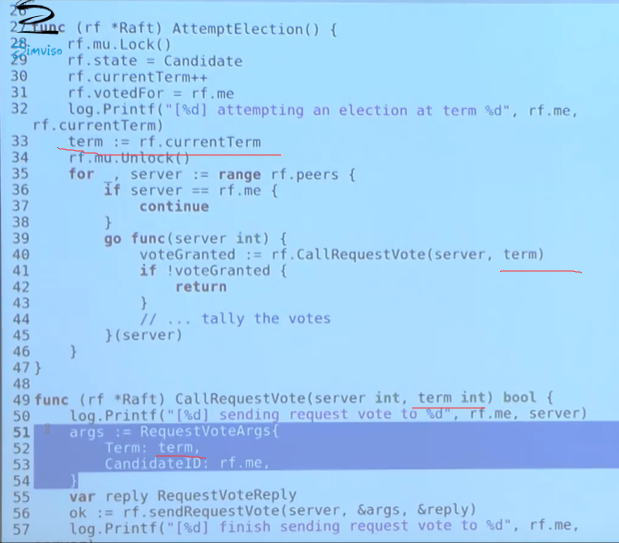

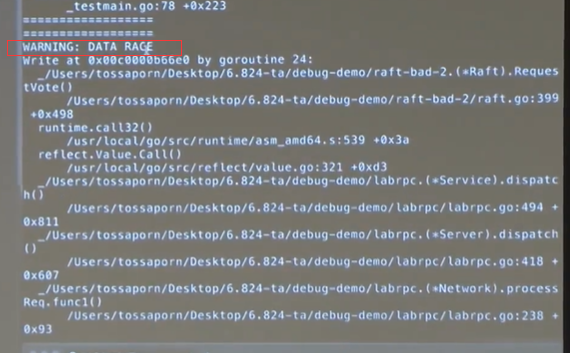

一些BUG

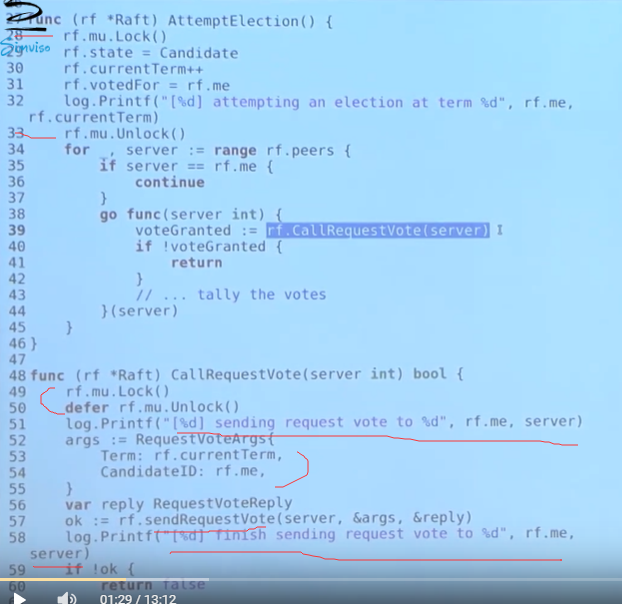

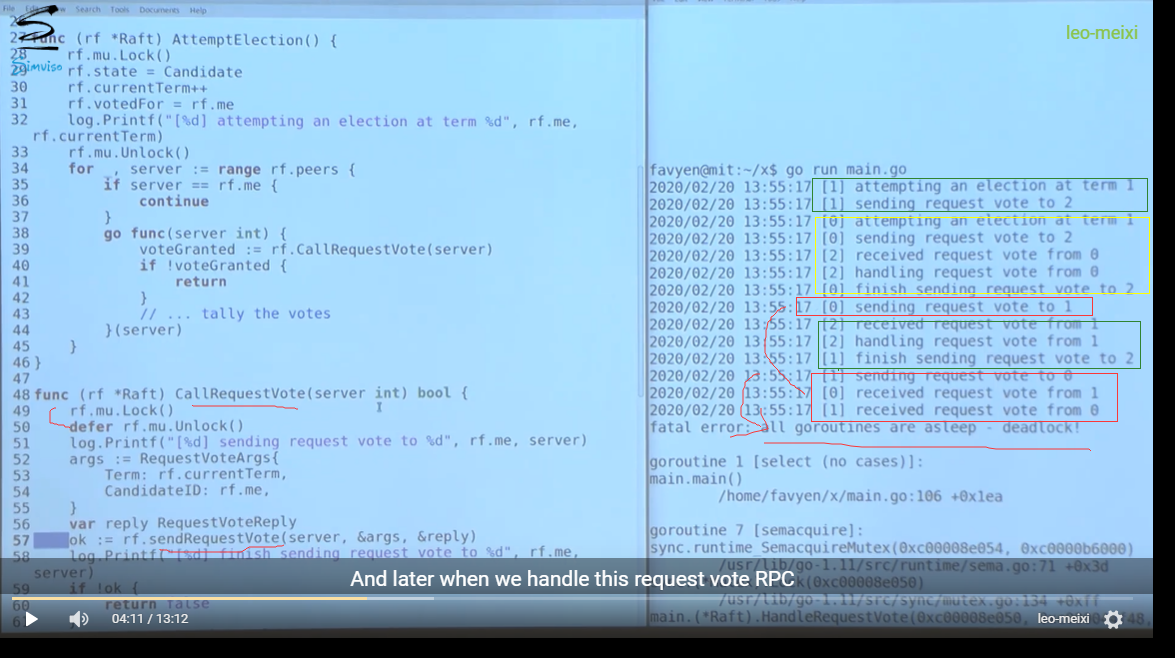

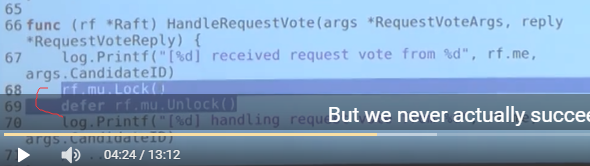

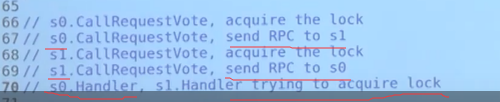

调用RPC时不要加锁

attemptElection()

callRequestVote()

结果死锁了, 原因如下:

- call rpc 和 receive rpc 过程都加锁了

- 尝试重复加锁导致死锁

解决死锁:

- 首先加锁是为了保护共享变量 currrentTerm

- 两个思路,

- 在callRequestVote中并没有改变currrentTerm, 因此可以把currrentTerm当做局部变量(函数的参数传进来);

- 在callRequestVote中保护currrentTerm后及时释放锁

此外如果网络不可靠, 你在rpc的时候使用了锁, 那么就会导致其他go routinue 阻塞, 降低效率

因此,在调用rpc时不要加锁

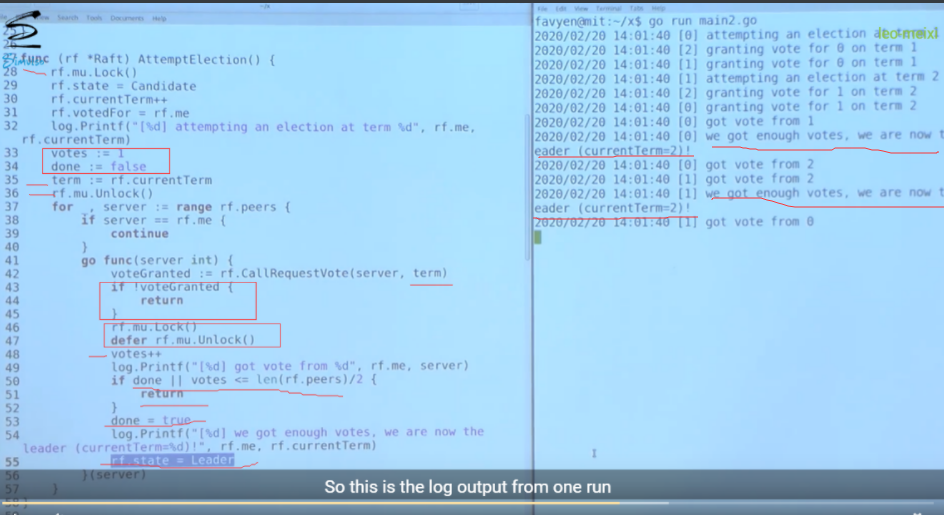

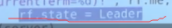

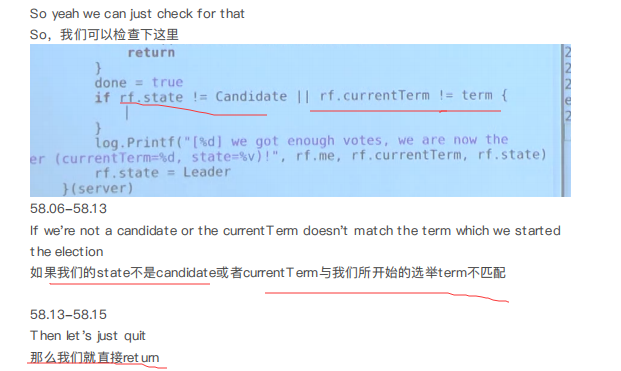

增加了选举计数机制, 一个Term内出现了两个leader

问题就是, 0在处理投票结果之前(成为leader之前)收到了1的RequestVote, 由于1的termId : 2 > 1(0的Termid), 所以0会把状态从candidate变为follower, 并且Termid设为2, 但是我们在选举计数处理中,在投票超过半数后, 直接把状态改成了leader, 即没有对当前的Termid和states进行检查

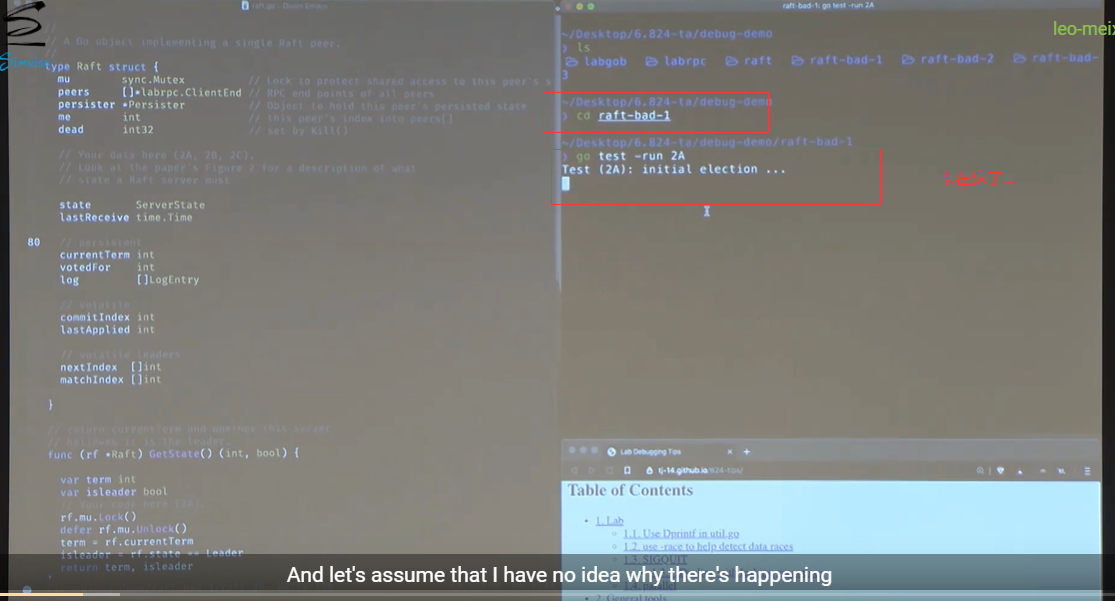

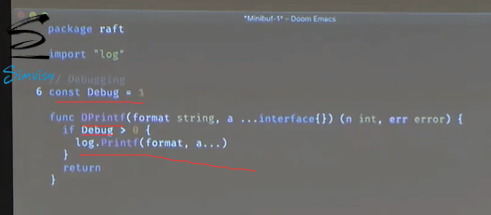

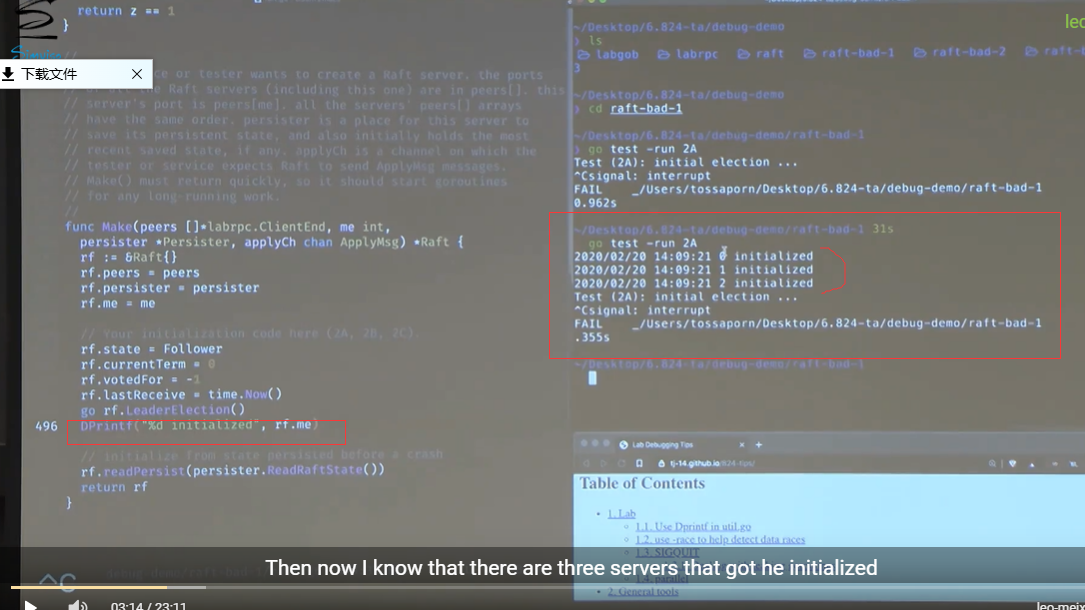

怎么去DEBUG

加printf—> 缩小排查范围

最好在printf中加上位置信息, eg: 哪个文件, 哪个函数, 哪一行, 能帮助你快速定位BUG位置

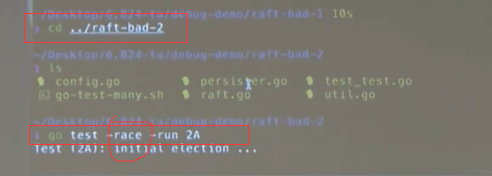

测试加 -race

在测试的时候加 -race 可以检测出data race的情况

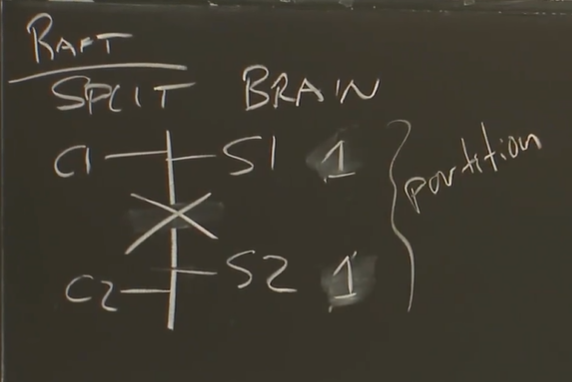

raft

回顾

vm依赖test-and-set在脑裂的时候判断哪个是Primary

网络是不可靠的, 一旦网络分区就容易发生脑裂, 要想办法解决

-

节点总数最好是奇数

-

节点数和最大卡发生故障次数关系:

-

一个candidate想成为新的leader, 支持新leader和旧leader中的followers中肯定有重合的(至少有一个), 也就是说新leader想上位必须要争取至少一个支持过旧leader的follower的投票(或者它本身就是) —> 这个candidate的log要足够新;

6.5840 2025 讲座5:Raft (第一部分)

本次讲座内容

- 今日主题: 状态机复制、多数决原则与 Raft 选举(实验 3A)

- 下期预告: Raft 持久化、客户端行为与快照机制(实验 3B, 3C, 3D)

*主题:状态机复制 (State-Machine Replication)

- 构建容错应用程序的一种流行方法

- 客户端将操作发送给主节点 (Primary)

- 主节点对操作进行排序并发送给备份节点 (Backups)

- 所有副本 (Replicas) 执行所有操作

- 如果起始状态相同、

- 执行的操作相同、

- 执行顺序相同、

- 且操作是确定性的 (Deterministic),

- 那么最终状态必然相同。

- 示例:VM FT (虚拟机容错) 中的主备模式

- 操作单元:机器指令 (Instructions)

- 主节点故障怎么办?

- • 在 GFS (Google 文件系统) 中,协调器 (Coordinator) 会挑选新的主节点。

- • 如果协调器自身故障了怎么办?

- 能否让副本节点自主选举新主节点?

- 考虑两个服务器 S1 和 S2 的场景:

- 如果两者都正常运行,S1 负责,将决策转发给 S2。

- 如果 S2 发现 S1 宕机,S2 接管成为协调器。

- 可能出现什么问题?

- 网络分区 (Network Partition)!脑裂 (Split Brain)!

- 考虑两个服务器 S1 和 S2 的场景:

- 核心难题: 计算机无法区分“服务器崩溃”和“网络中断”

- 两者的症状相同:通过网络发送的查询没有响应。

- 这个难题在很长一段时间内似乎无法克服。

- 似乎需要外部代理(例如人类)来决定何时切换服务器。

- 我们更倾向于一种自动化方案!

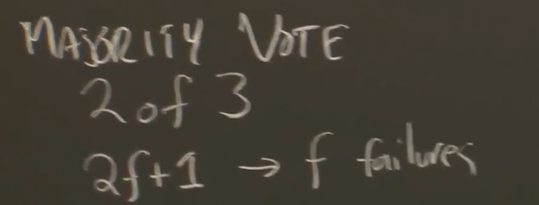

*主题:多数决原则 (Majority Rule)

- 应对网络分区的关键洞见:多数表决机制 (Majority Vote)

- 配置奇数台服务器(例如 3 台)。

- 任何决策都需要获得多数派 (Majority) 的同意 —— 例如 3 台中的 2 台。

- 如果无法形成多数派,则等待。

- 为什么多数派能帮助避免脑裂?

- 最多只有一个分区 (Partition) 能够拥有多数派。

- 这打破了我们在仅有两台服务器时看到的对称性困局。

- 注意: 多数派是基于所有服务器总数计算的,而不仅仅是当前存活的服务器。

- 注意: 获得多数派同意后立即推进操作。

- 不要等待更多响应,因为它们可能已经宕机。

- 更通用的公式:

2f + 1台服务器可以容忍f台服务器故障。- 因为剩余的

f + 1台服务器构成了2f + 1的多数派。 - 如果超过

f台服务器故障(或无法联系),则系统无法取得进展。

- 因为剩余的

- 这种机制通常被称为“法定人数 (Quorum)”系统。

- 多数派的一个关键特性: 任意两个多数派必有交集 (Intersect)。

- 交集内的服务器可以传递关于先前决策的信息。

- 例如:当前任期 (Term) 已经选举了另一个 Raft 领导者。

- 大约在 1990 年,发明了两种分区容忍的复制方案:

- Paxos 和 视图戳复制 (View-Stamped Replication, VSR)。

- 它们被称为“共识 (Consensus)”或“一致性协议 (Agreement Protocols)”。

- 在过去的 15 年里,这项技术得到了大量的实际应用。

- Raft 论文是了解现代技术的一个很好的入门指南。

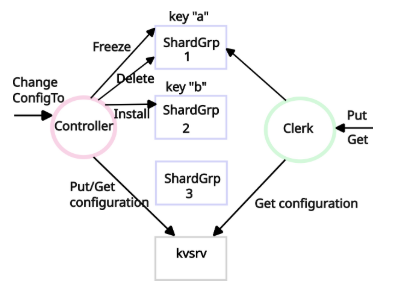

*主题:基于 Raft 的状态机复制 (State-Machine Replication with Raft)

- 使用 Raft 实现状态机复制 —— 以实验 2 + 4 为例:

- [架构图:客户端 (Clients), 3 个副本 (Replicas), 键值层 (k/v layer) + 状态机 (state), Raft 层 (raft layer) + 日志 (logs)]

- Raft 是一个库 (Library),包含在每个副本中。

- 一个客户端命令的时序图:

- [C (客户端), L (领导者), F1, F2 (跟随者)]

- 客户端向领导者 (Leader) 的键值层发送 Put/Get “命令”。

- 键值层调用

Start()来调用 Raft。- 领导者的 Raft 层将命令添加到其日志中。

- 领导者向跟随者 (Followers) 发送 AppendEntries RPCs。

- 跟随者将命令添加到它们各自的日志中。

- 领导者等待来自简单多数派 (Bare Majority)(包括它自己)的回复。

- 如果一个多数派将命令放入了它们的日志中,则该日志条目 (Entry) 被视为“已提交 (Committed)”。

- “已提交”意味着即使发生故障也不会被遗忘。

- 多数派 -> 该条目将在下一任领导者的投票请求中被看到。

- 领导者通过下一次 AppendEntries RPC “捎带 (Piggybacks)” 提交信息。

- 一旦条目被提交,领导者和跟随者将命令交给键值层执行。

- 对应实验中的

ApplyMsg和applyCh。

- 对应实验中的

- 领导者向客户端发送响应。

- 为什么需要日志 (Logs)?

- 服务 (Service) 维护状态机的状态,例如键/值数据库 (Key/Value DB)。

- 日志是相同信息的另一种表示形式!

- 为什么两者都需要?

- 日志对命令进行排序 (Orders)。

- 帮助副本就单一的执行顺序达成一致。

- 帮助领导者确保跟随者拥有相同的日志。

- 日志存储临时 (Tentative) 命令直到它们被提交。

- 日志存储命令,以防领导者需要重新发送给跟随者。

- 日志持久化 (Persistently) 存储命令,以便在重启后重放 (Replay)。

- 服务 (Service) 维护状态机的状态,例如键/值数据库 (Key/Value DB)。

- 各服务器的日志是彼此完全相同的副本吗?

- 否: 一些副本可能滞后 (Lag)。

- 否: 我们会看到它们可能暂时拥有不同的条目。

- 好消息:

- 它们最终会收敛 (Converge) 为完全相同。

- 提交机制确保服务器只执行稳定的 (Stable) 条目。

- 实现挑战:

- 故障 (Failures)

- 网络分区、消息丢失、服务器崩溃。

- 并发 (Concurrency)

- 服务器内部以及服务器之间的并发。

- 结果: 存在许多可能的执行路径和许多边界情况 (Corner Cases)。

- 需要处理大量细节 —— 见图 2 (Figure 2)。

- 今日重点: 选举新领导者必须应对这些挑战。

- 故障 (Failures)

*主题:领导者选举 (Leader Election) (实验 3A)

- 为什么需要领导者?

- 确保所有副本以相同的顺序执行相同的命令。

- (一些设计,例如 Paxos,没有领导者)。

- Raft 为领导者序列编号:

- 新领导者 -> 新任期 (New Term)。

- 一个任期最多有一个领导者;也可能没有领导者。

- 编号有助于服务器跟随最新的领导者,而不是被取代的 (Superseded) 领导者。

- Raft 节点何时开始领导者选举?

- 当它在“选举超时 (Election Timeout)”期间内没有收到当前领导者的消息时。

- 递增本地的

currentTerm,尝试收集选票 (Votes)。 - 注意: 这可能导致不必要的选举;虽然安全但效率较低。

- 注意: 旧的领导者可能仍然存活并认为自己是领导者。

- 如何确保一个任期内最多只有一个领导者?

- (见图 2 RequestVote RPC 和服务器规则)

- 领导者必须获得来自服务器多数派的“是 (Yes)”投票。

- 每个服务器在每个任期内只能投一票。

- 如果自己是候选者 (Candidate),则投票给自己。

- 如果不是候选者,则投票给第一个请求投票且符合图 2 规则的候选者。

- 在给定的任期内,最多只有一个服务器能获得多数票。

- -> 即使发生网络分区,也最多只有一个领导者。

- -> 即使一些服务器发生故障,选举也能成功。

- 注意: 再次强调,多数派是基于所有服务器总数计算的(不仅仅是存活的服务器)。

- 服务器如何得知新选举出的领导者?

- 领导者发出带有新的更高任期号的 AppendEntries 心跳包 (Heart-beats)。

- 只有领导者才能发送 AppendEntries。

- 每个任期只有一个领导者。

- 因此,如果你看到带有任期 T 的 AppendEntries,你就知道谁是任期 T 的领导者。

- 心跳包抑制 (Suppress) 任何新的选举。

- 领导者发送心跳包的频率必须高于选举超时时间。

- 选举可能因两个原因而不成功:

- • 可连通 (Reachable) 的服务器少于多数派。

- • 同时出现的候选者 (Simultaneous Candidates) 分散了选票 (Split the Vote),没有人获得多数票。

- 如果选举不成功会发生什么?

- 没有心跳包 -> 另一个超时 -> 为新任期发起新的选举。

- 更高的任期具有优先权 (Precedence),旧任期的候选者退出。

- 如果没有特殊处理,选举经常会因票数分散而失败:

- 所有选举计时器 (Election Timers) 很可能在大致相同的时间到期。

- 每个候选者都投票给自己。

- 所以没有人会投票给别人!

- 所以每个人都将恰好获得一票,没有人拥有多数票。

- Raft 如何避免票数分散?

- 每个服务器为其选举超时期限添加一些随机性 (Randomness)。

- [服务器超时到期时间示意图]

- 随机性打破了服务器之间的对称性 (Symmetry)。

- 一个服务器会选择最低的随机延迟。

- 希望在下一个超时到期之前有足够的时间完成选举。

- 其他服务器将看到新领导者的 AppendEntries 心跳包,从而不会成为候选者。

- 随机延迟是网络协议中的一种常见模式。

- 如何选择选举超时时间?

- • 至少包含几个心跳间隔 (Heartbeat Intervals)(以防网络丢失心跳包)。

- 以避免不必要的选举,这会浪费时间。

- • 随机部分要足够长,以便让一个候选者在下一个候选者开始之前成功。

- • 足够短以快速响应故障,避免长时间停顿。

- • 足够短以允许在测试程序 (Tester) 报错之前进行几次重试。

- 测试程序要求选举在 5 秒或更短时间内完成。

- • 至少包含几个心跳间隔 (Heartbeat Intervals)(以防网络丢失心跳包)。

- 如果旧领导者不知道新领导者已被选出怎么办?

- 可能旧领导者没有看到选举消息。

- 可能旧领导者处于少数派网络分区中。

- 新领导者的出现意味着多数派服务器已经递增了

currentTerm。 - 要么旧领导者会在 AppendEntries 回复中看到新的任期号并退位 (Step Down)。

- 要么旧领导者将无法获得多数派的回复。

- 因此旧领导者将无法提交或执行任何新的日志条目。

- 因此避免了脑裂。

- 但是,少数派可能接受旧服务器的 AppendEntries。

- 因此,在旧任期的末尾,日志可能会出现分歧 (Diverge)。

6.5840 2025 第7讲:Raft(2)

Raft

- 用于构建复制状态机(Replicated State Machine)的库

- 容忍网络分区(network partition)

- 自动故障转移至新主节点(leader/primary)

- 核心思想:法定多数(quorum)

- 大规模分布式系统的构建模块,例如:

- Etcd(配置服务)使用 Raft 库

- Etcd 用于构建更高级服务(如 Kubernetes)

- CockroachDB(分片分布式数据库)使用 Raft

- Etcd(配置服务)使用 Raft 库

上节课内容:选举安全性(Election Safety)

- 每个任期(term)仅有一个主节点

- 只要主节点存活:

- 客户端仅与主节点交互

- 客户端不会看到从节点(follower)的状态或日志

今日主题:日志的复制、持久化与压缩

主题:Raft 日志(实验 2B)

挑战:日志分歧(Log Divergence)

-

主节点崩溃前未向所有从节点发送

AppendEntries-

示例:

- S1:

[3] - S2:

[3, 3] - S3:

[3, 3] - (

3是日志条目的任期号)

- S1:

-

更严重的情况:同一日志位置可能出现不同命令!

-

例如:

日志条目编号:10 11 12 13 S1: [3] S2: [3, 3, 4] S3: [3, 3, 5] -

如何发生的?

- S2 是任期 3 的主节点:

- 向 S1、S2、S3 追加条目 10

- 向 S2、S3 追加条目 11(S1 崩溃)

- S2 崩溃并快速重启,成为任期 4 的主节点:

- 向自己的日志追加条目 12,然后崩溃

- S3 在任期 5 成为主节点(借助 S1):

- 向自己的日志追加不同的条目 12

- S2 是任期 3 的主节点:

-

-

Raft 如何确保一致性?

-

目标:

-

如果任一服务器执行了某日志条目的命令,则其他服务器不能对该条目执行不同操作(图 3 的“状态机安全性”)

-

原因:如果服务器对操作有分歧,主节点切换可能导致客户端可见状态变化,违反“模拟单机”的目标

-

示例:

S1: put(k1,1) | put(k1,2) S2: put(k1,1) | put(k2,3)- 不允许两者都执行它们的第二个日志条目!

-

Raft 的解决方案:强制从节点采纳新主节点的日志

- 示例:

- S3 被选为任期 6 的新主节点,希望追加条目 13

- S3 向所有从节点发送

AppendEntriesRPC:prevLogIndex=12prevLogTerm=5

- S2 返回

false(AppendEntries步骤 2) - S3 将

nextIndex[S2]递减至 12,重新发送包含条目 12 和 13 的 RPC - S2 删除自己的条目 12(

AppendEntries步骤 3),追加新条目 - S1 同理,但需回退更多

回滚(Rollback)的结果:

- 存活的从节点删除与主节点日志不一致的尾部

- 接受主节点的新条目

- 最终所有从节点日志与主节点一致

Q:为何可以忽略 S2 的 index=12, term=4条目?

Q:新主节点能否回滚已提交(committed)的条目?

- 灾难性后果:旧主节点可能已向客户端返回“成功”

- Raft 的保障:新主节点必须包含所有已提交的日志条目

为何不选举日志最长的服务器为主节点?

-

示例:

S1: [5, 6, 7] S2: [5, 8] S3: [5, 8]- S1 在任期 6 和 7 作为主节点,仅追加日志到自身后崩溃

- S2/S3 在任期 8 成为主节点(因已知任期 7)

- 问题:S1 的日志最长,但条目 8 可能已提交!

- 解决方案:选举限制(Election Restriction)

RequestVote仅投票给“至少与自己日志一样新”的候选者:- 候选者最后一条日志的任期更高,或

- 相同任期但日志更长

- 结果:S2/S3 不会投票给 S1,仅 S2/S3 可能成为主节点

关键点:

- “至少一样新”的规则确保新主节点日志包含所有可能已提交的条目

- 因此新主节点不会回滚任何已提交的操作

持久化(实验 2C)

服务器崩溃后需保留哪些状态?

- 持久化状态(图 2):

log[]、currentTerm、votedFor- 必须写入非易失性存储(磁盘、SSD 等)

- 每次状态变更后保存,或发送 RPC 前保存

- 为何需要这些?

log[]:确保已提交条目不被遗忘(即使重启)votedFor:防止同一任期内投票给不同候选者(导致脑裂)currentTerm:避免跟随过期的主节点或参与过期的选举

易失性状态:commitIndex、lastApplied、nextIndex[]/matchIndex[]

- 为何无需持久化?因其可安全重建

持久化是性能瓶颈:

- 磁盘写入耗时(HDD 10ms,SSD 0.1ms)

- 优化技巧:

- 批量写入日志条目

- 使用电池供电的 RAM

- 容忍最后几条更新的丢失风险

服务(如键值存储)如何恢复?

- 简单方法:从空状态重放完整日志(图 2 的做法)

- 高效方法:使用快照(Snapshot)仅重放日志尾部

日志压缩与快照(实验 2D)

问题:日志可能远大于状态机状态,重启或新节点同步耗时

解决方案:服务定期创建持久化快照

- 快照包含截至某日志索引的服务状态(如键值表)

- Raft 丢弃快照索引之前的日志

- 所有服务器均需快照(非仅主节点)

崩溃恢复流程:

- 服务从磁盘读取快照

- Raft 读取持久化日志

- Raft 设置

lastApplied为快照的最后索引,避免重复应用已执行的日志

问题:从节点日志落后于主节点日志的起始点?

- 解决方案:

InstallSnapshotRPC

哲学思考:

- 状态(State)与操作历史(Operation History)可相互转换

- 存储或通信时选择更高效的形式

实际注意事项:

- 快照适用于小状态(如配置),不适用于大型数据库

- 替代方案:服务数据直接存储在磁盘(如 B-Tree)

- 需处理落后副本的同步问题

只读操作(第 8 节末尾)

Q:Raft 主节点是否需将只读操作(如 Get(key))提交到日志后才能响应?

A:

- 图 2 和实验要求:必须提交

Get()到日志- 避免返回过时数据(如主节点未察觉自己已失去领导权)

- 若无法获取多数

AppendEntries确认,则不响应客户端

- 优化思路:租约(Leases)

- 主节点在租约期内(如 5 秒)可直接响应只读请求

- 新主节点需等待旧租约过期才能执行写操作

- 注意:实验中仍需提交

Get()到日志

现实权衡:

- 许多应用为读多写少,提交

Get()影响性能 - 实践中常容忍过时数据以换取更高吞吐量

raft论文figure2

这张图是 Raft 一致性算法的核心机制流程图,清晰展示了算法运行所需的状态、RPC 交互和服务器行为规则。以下是图中四个核心模块的中文详解:

1. State (状态)

- 持久化状态 (所有服务器必须写入稳定存储):

currentTerm:服务器已知的最新任期号(首次启动为0,单调递增)。votedFor:在当前任期内收到其投票的候选者ID(若无投票则为空)。log[]:日志条目数组。每个条目包含:状态机命令 + 领导者接收该条目时的任期号(索引从1开始)。

- 易失性状态 (所有服务器):

commitIndex:已知已提交的最高日志条目索引(初始为0,单调递增)。lastApplied:已应用到状态机的最高日志条目索引(初始为0,单调递增)。

- 易失性状态 (领导者专用,选举后重置):

nextIndex[]:nextIndex[]是一个数组,领导者为集群中的每个跟随者维护一个条目。对于跟随者i,nextIndex[i]表示领导者将要发送给该跟随者的下一条日志条目的索引。matchIndex[]:matchIndex[]也是一个数组,领导者为集群中的每个跟随者维护一个条目。对于跟随者i,matchIndex[i]表示领导者已知的、已经成功复制到该跟随者上的最高日志条目的索引。

2. AppendEntries RPC (日志复制/心跳 RPC)

- 用途:领导者复制日志条目(§5.3)或发送心跳包(§5.2)。

- 参数:

term:领导者的任期号。leaderId:领导者ID(用于跟随者重定向客户端)。prevLogIndex:新条目前一条日志的索引。prevLogTerm:prevLogIndex条目的任期号。entries[]:需存储的日志条目(心跳包为空,可批量发送)。leaderCommit:领导者的commitIndex。

- 结果:

term:跟随者的当前任期(供领导者更新自身)。success:若跟随者日志包含与prevLogIndex和prevLogTerm匹配的条目,则为true。

- 接收者处理逻辑:

- 若

term < currentTerm,返回false(§5.1)。 - 若日志在

prevLogIndex处无条目或任期不匹配,返回false(§5.3)。 - 冲突处理:若新条目与现存条目冲突(同索引不同任期),删除冲突条目及其后所有条目(§5.3)。

- 追加日志:添加所有不存在的新条目。

- 更新提交索引:若

leaderCommit > commitIndex,则设置commitIndex = min(leaderCommit, 最后新条目索引)。

- 若

3. RequestVote RPC (选举投票 RPC)

- 用途:候选者收集选票(§5.2)。

- 参数:

term:候选者的任期号。candidateId:请求投票的候选者ID。lastLogIndex:候选者最后一条日志的索引(§5.4)。lastLogTerm:候选者最后一条日志的任期号(§5.4)。

- 结果:

term:接收者的当前任期(供候选者更新自身)。voteGranted:若投票给该候选者,则为true。

- 接收者处理逻辑:

- 若

term < currentTerm,返回false(§5.1)。 - 投票条件:若

votedFor为空或已是candidateId,且候选者日志至少与接收者日志一样新(§5.2, §5.4),则授予投票。

- 若

4. Rules for Servers (服务器行为规则)

- 所有服务器:

- 若

commitIndex > lastApplied:递增lastApplied,将log[lastApplied]应用到状态机(§5.3)。 - 若 RPC 请求/响应中的

term T > currentTerm:设置currentTerm = T,转换为跟随者(§5.1)。

- 若

- 跟随者 (Followers):

- 响应来自候选者和领导者的 RPC。

- 触发选举条件:若在选举超时内未收到当前领导者的

AppendEntries或未给候选者投票,则转换为候选者。

- 候选者 (Candidates):

- 开始选举:转换时立即执行:

- 递增

currentTerm。 - 投票给自己。

- 重置选举计时器。

- 向所有其他服务器发送

RequestVoteRPC。

- 递增

- 成为领导者:若获得多数派投票。

- 收到心跳:若收到新领导者的

AppendEntries,转换为跟随者。 - 选举超时:若超时未胜选,发起新一轮选举。

- 开始选举:转换时立即执行:

- 领导者 (Leaders):

- 当选后:立即向每个服务器发送初始空

AppendEntries(心跳),并在空闲时重复发送(防止选举超时)(§5.2)。 - 接收客户端命令:追加条目到本地日志,在条目应用到状态机后响应客户端(§5.3)。

- 日志同步:若某跟随者的

nextIndex≤ 领导者最后日志索引:- 发送从

nextIndex开始的AppendEntries。 - 若成功:更新该跟随者的

nextIndex和matchIndex(§5.3)。 - 若因日志不一致失败:递减

nextIndex并重试(§5.3)。

- 发送从

- 提交新条目:若存在满足以下条件的

N:N > commitIndex- 多数派的

matchIndex[i] ≥ N log[N].term == currentTerm- 则设置

commitIndex = N(§5.3, §5.4)。

- 当选后:立即向每个服务器发送初始空

核心要点总结

- 任期机制:

currentTerm标识逻辑时间,确保同一任期最多一个有效领导者。 - 心跳保活:领导者通过

AppendEntries心跳维持权威,抑制选举。 - 日志一致性:

- 领导者强制覆盖跟随者的冲突日志(步骤3)。

- 提交需满足 多数派复制 + 当前任期 条件(规则4)。

- 选举安全:

- 投票需满足 日志至少一样新(

lastLogTerm和lastLogIndex比较)。 - 同一任期每台服务器只能投一票。

- 投票需满足 日志至少一样新(

- 状态机安全:仅提交的日志条目(

commitIndex)才会被应用到状态机。

这张图是 Raft 算法的“操作手册”,Lab 3 的实现需严格遵循这些规则。理解图中交互逻辑(如日志冲突处理、心跳抑制选举、提交条件)是完成实验的关键。

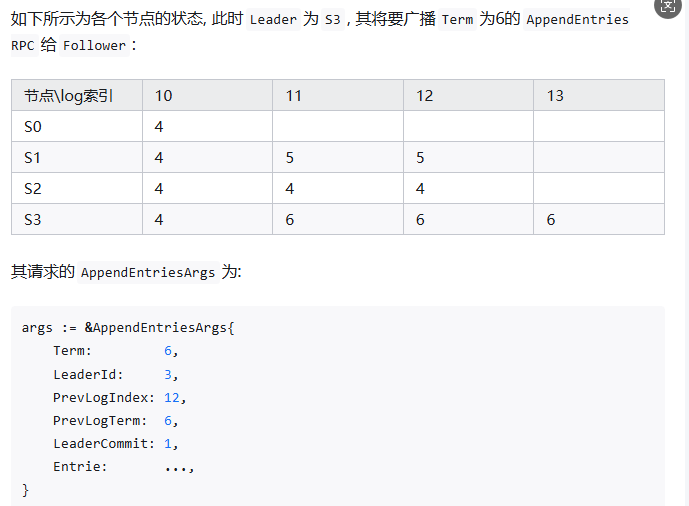

追加日志

快速恢复不一致follower的Log

持久化

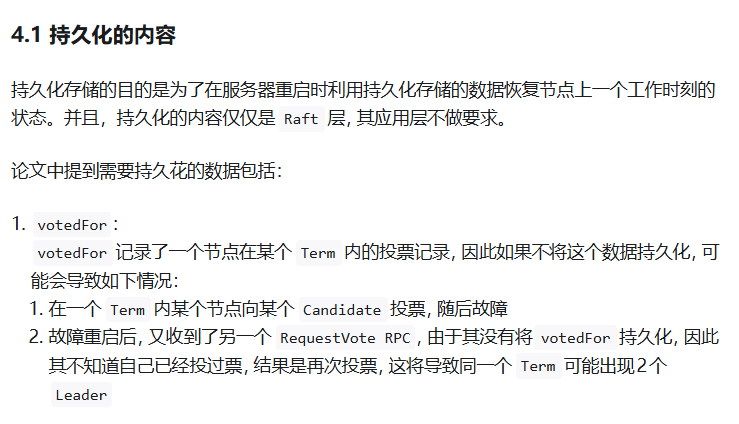

持久化的内容

总结对比表

| 状态 | 是否持久化 | 原因 |

|---|---|---|

currentTerm |

必须 | 防止同一个任期内出现多个领导者(保证安全性)。 |

votedFor |

必须 | 防止在一个任期内投出多张票(保证安全性)。 |

log[] |

必须 | 这是状态机的操作历史,是最终状态的来源(保证安全性)。 |

state |

不持久化 | 角色是瞬时的,由当前集群状态决定。重启后必须从Follower开始。 |

commitIndex |

不持久化 | 可由领导者通过心跳广播;重新应用日志是幂等的。 |

lastApplied |

不持久化 | 可从持久化的日志中重新应用至 commitIndex。 |

nextIndex[] |

不持久化 | 领导者的工作状态,新领导者会重置并重新探测。 |

matchIndex[] |

不持久化 | 领导者的工作状态,新领导者会重置并重新累积。 |

持久化内容的核心思想

Raft 持久化的设计遵循一个核心原则:只持久化用于保证安全性的最小状态子集。这些状态是确保系统在崩溃恢复后仍能维持一致性的绝对必要条件。其他状态都是用于优化性能或记录临时进度的“工作状态”,可以在运行中通过 RPC 交互重新构建。

问题 1: 为什么 commitIndex, lastApplied, nextIndex, matchIndex不用持久化?它们是如何重建的?

这些索引被称为 “易失性状态”(Volatile State)。它们不需要持久化的原因在于,其功能是优化和记录进度,而非保证安全性的核心。它们可以在节点重启后,通过正常的 Raft 协议交互(主要是心跳和日志追加)安全地重新构建出来。

1. commitIndex(提交索引)

-

•

为什么不需要持久化?:

commitIndex表示已知已提交的最高日志索引。领导者通过心跳 (AppendEntriesRPC) 中的leaderCommit字段将其广播给所有追随者。因此,一个重启后的节点,无论是领导者还是追随者,都会在收到下一个有效的心跳或日志追加 RPC 时,从领导者那里获取到最新的commitIndex。 -

•

如何重建?:

-

•

追随者:直接从领导者发来的

AppendEntriesRPC 参数中的leaderCommit字段获取。 -

•

领导者:领导者需要重新计算

commitIndex。它通过向所有追随者发送心跳,收集他们的matchIndex,然后按照 Raft 规则(取所有matchIndex的中位数)来更新自己的commitIndex。

-

2. lastApplied(最后应用索引)

-

•

为什么不需要持久化?:

lastApplied是状态机应用的进度,它总是小于等于commitIndex。应用日志条目是幂等的(多次应用同一条日志命令不会改变最终状态)。重启后,节点只需从lastApplied = 0开始,重新应用所有已提交的日志(从持久化的日志中读取),直到追上当前的commitIndex即可。虽然效率不高,但能保证正确性。 -

•

如何重建?:节点重启后,将

lastApplied初始化为 0,然后从日志中依次重新应用所有已提交的条目(即索引从 1 到commitIndex的条目)。

3. nextIndex和 matchIndex(下一个索引和匹配索引)

-

•

为什么不需要持久化?:这两个是领导者独有的工作状态,用于追踪每个追随者的日志复制进度。它们是领导者的“最佳猜测”,本身就是临时性的。如果领导者崩溃,新选举产生的领导者会重置这些值,并从头开始与追随者同步日志,这是最安全的方式。

-

•

如何重建?:

-

•

新领导者当选后:它会立即将所有追随者的

nextIndex[]初始化为自己最后一条日志的索引 + 1(即len(log)),这是一个乐观的假设(认为所有追随者的日志都和它一样新)。同时,将matchIndex[]初始化为 0。 -

•

通过后续 RPC 调整:领导者通过发送

AppendEntriesRPC 来探测每个追随者的实际日志状态。如果追随者拒绝(因为日志不匹配),领导者会根据回复信息(如您之前提到的XTerm,XIndex)递减nextIndex,直到找到一致点。一旦某个AppendEntries成功,领导者就能相应地更新matchIndex和nextIndex。

-

总结:不持久化这些索引,相当于用网络通信和重试来换取实现的简单性和一致性。虽然重启后可能需要一些时间来重新同步,但协议保证了最终所有状态都能正确恢复,而不会破坏安全性。

问题 2: State (节点状态) 为什么不持久化?一个 Leader 宕机恢复后它的状态是什么?

为什么不持久化 State?

节点状态(Follower/Candidate/Leader)是一个瞬时的角色,完全由当前任期号和日志内容派生而来。持久化它是没有意义且危险的:

-

无意义:角色取决于集群的整体状态。一个节点崩溃后,集群的任期可能已经前进(

currentTerm增加),其他节点可能已经当选为新的领导者。重启后的节点绝不能假设自己仍然是领导者,否则会导致“脑裂”(Split Brain),即出现多个领导者。 -

危险:如果持久化了

state = Leader,但重启后集群的currentTerm已经变大,这个过期的领导者会以为自己是合法的,会继续发送心跳和日志,扰乱集群的正常运行。

一个 Leader 宕机恢复后它的状态是什么?

一个领导者节点宕机重启后,它的状态永远是 Follower。

其恢复过程如下:

-

从磁盘加载持久化状态:读取

currentTerm、votedFor和log。 -

初始化易失性状态:将

state初始化为Follower。将commitIndex和lastApplied初始化为 0(或从快照中恢复的位置)。nextIndex和matchIndex只有在成为领导者时才会被创建和初始化,此时为空或不使用。 -

等待心跳或超时:

-

•

如果它能很快收到来自当前任期领导者的有效心跳,它就会安心做一个追随者。

-

•

如果一段时间内没有收到心跳(选举超时),它就会自荐为候选人(

state = Candidate),增加自己的currentTerm,并开始新一轮的选举。

-

这个设计非常关键:它确保了任何节点重启后都必须以“谦虚”的追随者身份重新加入集群,通过通信来确认自己的角色,从而避免了过期的领导者扰乱集群。这是 Raft 安全性的又一重保障。

持久化的时机

Log compaction

好的,我们来详细解析这段关于 Raft 快照(Snapshotting) 机制的论述。这段文字解释了为什么需要快照、如何工作以及其设计上的权衡。

核心问题:日志无限增长的挑战

在正常操作中,Raft 的日志会不断增长以容纳更多的客户端请求。但这会带来实际问题:

- 空间占用:日志越长,占用的存储空间越多。

- 时间开销:服务器重启后,需要重放(replay) 所有日志来重建状态,日志越长,耗时越久。

- 可用性问题:最终,上述两点会导致系统可用性下降。

因此,需要一种机制来丢弃日志中积累的、已经过时的(obsolete) 信息。这个过程称为 日志压缩(Compaction)。

解决方案:快照(Snapshotting)

1. 基本概念

快照是最简单的压缩方法。其核心思想是:

- 将整个当前系统状态序列化后写入稳定存储(如硬盘)的一个快照文件中。

- 然后,丢弃该快照点之前的所有日志条目。

举个例子:假设状态机是一个键值存储,当前状态是 {A=1, B=2, C=3}。打快照就是将 {A=1, B=2, C=3}这个完整状态直接保存到文件中,然后就可以丢弃所有导致这个状态的 PUT A=1, PUT B=2, PUT C=3等日志条目。

2. 快照中包含的内容

- 状态机状态:这是快照的主体,由应用程序负责生成。

- 关键元数据(Raft 添加):

- 最后包含的索引(last included index):该快照所覆盖的最后一条日志的索引。

- 最后包含的任期(last included term):上述索引对应的日志条目的任期号。

- 最新的配置信息:用于支持集群成员变更。

元数据的作用:为了支持快照之后的第一个日志条目的 AppendEntries一致性检查。因为领导者发送 PrevLogIndex和 PrevLogTerm时,如果追随者的日志已经被快照截断,它就需要用这些元数据来证明自己的日志与领导者在快照点是一致的。

3. 创建快照的时机

- 各服务器独立进行:每个服务器根据自己的情况决定何时创建快照,通常与领导者无关。

- 常见策略:当日志大小达到一个固定的字节数时触发。这个阈值应显著大于快照的预期大小,以减少磁盘带宽开销。

4. 性能优化:写入时不阻塞

写入快照可能很耗时,不能因此阻塞正常操作。解决方案是:

- 写时复制(Copy-on-Write):允许在写入快照的同时接受新的更新。

- 使用函数式数据结构的状态机天然支持此特性。

- 利用操作系统的支持,如 Linux 的

fork系统调用,创建整个状态机的内存快照。

关键 RPC:InstallSnapshot

当某个追随者远远落后(例如刚重启或新加入集群),而领导者已经丢弃了它需要发送给该追随者的下一批日志条目时,领导者就需要通过网络发送快照。这是通过 InstallSnapshotRPC 实现的。

接收方(Follower)处理逻辑:

- 基本检查:如果 RPC 中的

term小于自己的当前任期,立即拒绝。 - 分块处理:快照可能分多次发送。根据

offset将data[]写入快照文件的指定位置。如果done为false,说明还有后续分块,等待即可。 - 安装决策(这是核心):

- 情况A:快照包含新信息(最常见)。追随者会丢弃其整个日志,因为快照包含了所有最新信息,且其本地日志可能包含与快照冲突的未提交条目。

- 情况B:快照是其日志的前缀(通常因重传或错误导致)。追随者仅删除快照所覆盖的那部分日志,而保留快照之后的日志条目(这些条目仍然有效,必须保留)。

- 重置状态机:最后,追随者使用快照内容重置其状态机。

设计权衡与选择

1. 为什么采用“各自快照”而非“领导者统一快照”?

文章探讨了另一种方案:只由领导者创建快照,然后分发给所有追随者。但认为当前方案(各自快照)更优,原因如下:

- 网络带宽和速度:将快照从领导者发送给所有追随者会浪费大量网络带宽且过程缓慢。而让追随者自己利用本地状态生成快照,成本要低得多。

- 领导者复杂度:领导者需要并行处理——既要给落后的追随者发送快照,又要给跟得上的追随者复制新的日志条目,设计非常复杂。当前的方案简化了领导者的逻辑。

2. 这是否违背了 Raft 的“强领导者原则”?

强领导者原则要求所有数据都从领导者流向追随者。在快照机制中,追随者可以独立创建快照,看似违背了这一原则。

文章的解释是合理的:虽然创建快照的行为是独立的,但快照本身所包含的数据(状态机状态)最初完全来自于领导者通过 RPC 复制的日志。共识已经在快照所覆盖的日志条目上达成,因此不会引发新的决策冲突。数据流的源头依然是领导者,追随者只是在重组自己本地的数据。

总结

| 方面 | Raft 快照机制 |

|---|---|

| 目的 | 解决日志无限增长带来的存储和恢复效率问题 |

| 核心操作 | 将整个系统状态写入快照文件,并丢弃之前的所有日志 |

| 关键元数据 | lastIncludedIndex, lastIncludedTerm, 配置信息 |

| 创建方式 | 各服务器独立进行,通常由日志大小触发 |

| 落后追赶 | 领导者通过 InstallSnapshotRPC 向落后追随者发送快照 |

| 设计选择 | 选择“各自快照”而非“领导者统一快照”,以节省带宽和简化领导者逻辑 |

快照机制是 Raft 实践中的重要组成部分,它在保证一致性的前提下,巧妙地解决了日志压缩这一实际问题,并通过 InstallSnapshotRPC 确保了集群成员最终能恢复一致。

好的,我们来详细解释 Raft 中的快照(Snapshot)机制,它如何解决日志无限增长的问题,以及如何处理由此引发的 Follower 日志缺失问题。

1. 核心问题:为什么需要快照?

以你提到的 K/V 数据库为例:

- 日志(Log):记录了所有更改状态的操作序列,例如

[Put A=1, Put B=2, Put A=3, Put C=4]。 - 状态(State):是这些操作应用后的最终结果,例如

{A=3, B=2, C=4}。

运行很长时间后,日志会变得非常长,但其中大部分是历史中间状态(如 Put A=1 已被 Put A=3 覆盖)。存储所有日志既浪费空间,又在节点重启后需要重放所有日志,极其低效。

快照的核心思想就是定期将整个当前状态({A=3, B=2, C=4})保存下来,并丢弃产生此状态之前的所有日志。这样就只用存储最终状态和之后的日志,极大地节省了空间并加快了恢复速度。

2. 快照机制如何工作?

a) 触发时机(由应用程序决定)

Raft 本身不知道何时做快照。它向上层应用提供一个接口(例如 Snapshot(index int, snapshotData []byte))。应用需要自己决定触发策略,常见的有:

- 日志大小阈值:当日志体积超过一定值(如 1MB)时触发。

- 条目数量阈值:当日志条数超过一定数量时触发。

- 定时触发:定期创建快照。

b) 创建过程

- 选择分界点:应用选择一个已提交(committed)且已应用(applied)的日志索引,假设为

X。这意味着索引X及之前的所有操作的效果都已经体现在当前状态中。 - 生成快照:应用将自己的完整当前状态序列化(对于 K/V 数据库,就是序列化整个键值对映射表),生成

snapshot_data。 - 通知 Raft:应用调用

rf.Snapshot(X, snapshot_data)。 - Raft 持久化:Raft 层会同时持久化: 快照数据 (

snapshot_data) 快照的元数据:最后包含的索引 (lastIncludedIndex) = X 和 最后包含的任期 (lastIncludedTerm)(即日志中索引X对应的任期号)。 - 截断日志:Raft 层安全地丢弃索引

X及之前的所有日志条目。

c) 节点启动恢复

节点重启后,Raft 的启动流程变为:

- 从稳定存储中读取最新的快照和其元数据 (

lastIncludedIndex,lastIncludedTerm)。 - 将快照数据交给上层应用,应用加载此快照来直接恢复其状态,而无需重放任何历史日志。

- 然后读取并重放快照点之后(索引

X+1开始)的日志(如果有的话)。

3. 关键挑战与 Raft 的解决方案

快照引入了一个新问题:如果 Leader 已经丢弃了 Follower 所需要的旧日志,如何同步?

问题场景

- Leader:日志索引为 1-1000。它在索引 800 处做了快照,因此丢弃了索引 1-800 的日志,只保留 801-1000。

- Follower:因宕机离线,日志只到索引 500。

- Follower 恢复:它需要从索引 501 开始同步,但 Leader 已经没有 501-800 的日志了!

解决方案 1:Leader 不丢弃落后 Follower 所需的日志

- 做法:Leader 为每个 Follower 维护一个“最低所需索引”,只有当所有 Follower 的

matchIndex都超过快照点X时,Leader 才真正丢弃X之前的日志。 - 缺陷:不可行。如果有一个 Follower 严重落后(如关机一周),Leader 将永远无法丢弃任何日志,使得快照机制完全失效,违背了初衷。

解决方案 2:Raft 的标准方案 —— InstallSnapshot RPC

这是 Raft 论文中采用的方案,其流程完美地解决了该问题,如下图所示:

flowchart TD

A[Leader尝试通过<br>AppendEntries同步日志] --> B{Follower日志是否<br>落后到已被Leader丢弃?}

B -- 否 --> C[正常日志复制流程]

B -- 是 --> D[Leader通过InstallSnapshot RPC<br>将快照发送给Follower]

D --> E{Follower处理快照}

E --> F[丢弃所有现有日志]

F --> G[用快照数据加载状态机]

G --> H[后续通过AppendEntries<br>接收快照点后的新日志]

H --> I[最终状态一致]

其工作原理如下:

- 探测到落后:Leader 通过正常的

AppendEntriesRPC 发现某个 Follower 所需要的下一个日志索引(nextIndex)已经被自己丢弃(即nextIndex <= lastIncludedIndex)。 - 切换至发送快照:Leader 停止尝试发送日志条目,转而发起

InstallSnapshotRPC。 - 发送快照:Leader 将它的快照数据(包括

lastIncludedIndex、lastIncludedTerm和应用程序的完整状态数据)发送给 Follower。快照可能被分成多个块(chunk)传输。 - Follower 处理快照: 如果快照是最新的(其

lastIncludedIndex大于 Follower 的最后日志索引),Follower 会丢弃其整个日志,因为快照包含了所有最新信息。 它将快照数据交给上层应用,应用完全重置其状态为快照所保存的状态。 它将自己的lastApplied和commitIndex至少更新到lastIncludedIndex。 - 恢复日志同步:此后,Follower 的日志“起点”变成了

lastIncludedIndex。Leader 接下来就可以通过正常的AppendEntriesRPC,从lastIncludedIndex + 1开始,将其后的新日志(801-1000)发送给 Follower,最终使其完全同步。

总结

| 方面 | Raft 快照机制 |

|---|---|

| 目的 | 解决日志无限增长问题,节省空间,加速恢复 |

| 触发者 | 上层应用程序(根据自身策略决定) |

| 内容 | 应用程序状态 + Raft 元数据(lastIncludedIndex, lastIncludedTerm) |

| 核心挑战 | Leader 丢弃的日志如何同步给严重落后的 Follower |

| 解决方案 | InstallSnapshot RPC,直接发送状态快照而非历史日志 |

| 优势 | 允许 Leader 积极丢弃日志,而不受个别落后 Follower 的制约,真正实现了日志压缩的目标 |

通过这种设计,Raft 在保证一致性的前提下,优雅地解决了实际工程中的存储和效率问题。一个离线很久的 Follower 可以通过接收一个快照和一小段新日志迅速追上集群进度,而不需要重传整个历史操作记录。

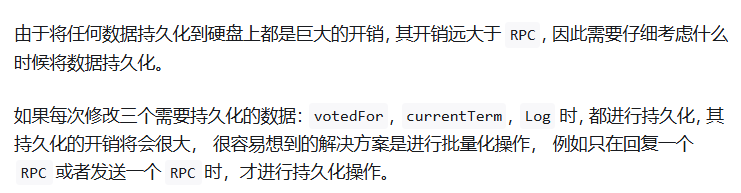

lab简介

lab相关

lab1

第一讲(引言)及 MapReduce

好的,这是麻省理工学院 6.5840 分布式系统工程 2025 年第一讲(引言)及 MapReduce 案例研究部分的中文翻译:

6.5840 2025 第一讲:引言

6.5840:分布式系统工程

我对“分布式系统”的定义:

一组协同工作以提供服务的计算机

示例

- 我们都使用分布式系统:

- 流行应用的后端(例如消息应用)

- 大型网站

- 电话系统

- 本课程重点关注分布式基础设施:

- 存储系统

- 事务处理系统

- “大数据”处理框架

- 认证服务

以这种方式构建系统并非易事:

- 并发性(Concurrency)

- 复杂的交互(Complex interactions)

- 性能瓶颈(Performance bottlenecks)

- 部分故障(Partial failure)

那么,人们为什么要构建分布式系统?

- 通过并行处理(Parallel processing)提高容量(Capacity)

- 通过复制(Replication)实现容错(Fault tolerance)

- 匹配物理设备的分布(如传感器)

- 通过隔离(Isolation)增强安全性(Security)

为什么学习这个主题?

- 有趣:充满挑战性的问题和强大的解决方案

- 广泛应用:由大型网站的兴起所驱动

- 活跃的研究领域:存在重要的未解决问题

- 构建具有挑战性:你将在实验中亲身体验

课程结构 (COURSE STRUCTURE)

课程网站:http://pdos.csail.mit.edu/6.5840

课程团队成员:

- 主讲教师: Frans Kaashoek 和 Robert Morris

- 助教: Kenneth Choi, Yun-Sheng Chang, Ivy Wu, Aryan Kumar

课程组成:

- 讲座(Lectures)

- 论文(Papers)

- 两次考试(Two exams)

- 实验(Labs)

- 期末项目(Final project - 可选)

讲座:

- 讲解核心思想、论文讨论、实验指导

论文:

- 每次讲座对应一篇论文

- 研究论文,包括经典文献和新近成果

- 内容涵盖:问题、思路、实现细节、评估方法

- 请在课前阅读论文!

- 网站会为每篇论文提供一个简短问题让你回答

- 同时要求你提交一个关于该论文的问题

- 在讲座开始前提交答案和问题

考试:

- 期中考试在课堂上进行

- 期末考试在期末考试周进行

- 考试内容主要围绕论文和实验

- 必须参加考试!

实验 (Labs):

- 目标: 运用并实现一些关键技术

- 目标: 获取分布式编程的实际经验

- 第一个实验截止日期是下周五

- 之后的实验基本上每周一个

- Lab 1: 分布式大数据处理框架(类似于 MapReduce)

- Lab 2: 客户端/服务器 vs 不可靠网络

- Lab 3: 使用复制实现容错(Raft 共识算法)

- Lab 4: 容错数据库实现

- Lab 5: 通过分片(Sharding)实现可扩展的数据库性能

- 我们使用一套测试用例来评分实验

- 我们提供所有测试用例,没有隐藏测试。

可选期末项目 (Optional final project) 在课程最后进行,可以 2 或 3 人一组:

- 期末项目可以替代 Lab 5。

- 需要构思项目想法并获得课程组批准。

- 要求提交代码、简短报告,并在最后一天进行演示。

重要提示:调试实验可能非常耗时!

- 尽早开始!

- 在 Piazza(课程问答平台)上提问!

- 利用助教的 Office Hours(答疑时间)!

核心主题 (MAIN TOPICS)

这是一门关于为应用提供基础设施支持的课程。

- 存储 (Storage)。

- 通信 (Communication)。

- 计算 (Computation)。

核心目标: 向应用程序隐藏分布式系统的复杂性。

-

主题:容错性 (Fault tolerance)

-

数千台服务器,庞大的网络 -> 总会出现故障。我们希望能向应用隐藏这些故障。

-

“高可用性”:服务在故障发生时能够持续运行。

核心思路:服务器复制 (Replicated servers)。

- 如果一台服务器崩溃,可以使用其他服务器继续运行。

-

-

主题:一致性 (Consistency)

- 通用基础设施需要明确定义的行为。例如,“read(x) 返回最近一次 write(x) 的值”。

- 实现良好行为非常困难!例如,保持“副本”服务器完全相同非常困难。

-

主题:性能 (Performance)

目标:可扩展的吞吐量 (Scalable throughput)

-

N 倍服务器 -> 通过并行利用 CPU、内存、磁盘、网络实现 N 倍总吞吐量。

-

随着 N 的增长,扩展变得更难:

- 负载不均衡 (Load imbalance)。

- N 节点中最慢节点的延迟 (Slowest-of-N latency)。

-

-

主题:权衡 (Tradeoffs)

- 容错性、一致性和性能是相互制约的。

- 容错性和一致性需要通信:

- 例如,发送数据到备份服务器。

- 例如,检查缓存数据是否是最新的。

- 通信通常速度慢且难以扩展。

- 许多设计牺牲一致性来换取速度。

- 例如,read(x) 可能不返回最近一次 write(x) 的值!

- 这对应用程序员(或用户)来说是痛苦的。

- 我们将看到在一致性/性能频谱上的多种设计权衡点。

-

主题:实现 (Implementation)

- RPC (远程过程调用), 线程 (Threads), 并发控制 (Concurrency control), 配置管理 (Configuration)。

- ...就是实验中要做的事情。

该领域知识在现实世界中应用广泛:

- 所有大型网站和云服务提供商都是分布式系统领域的专家。

- 许多开源项目都围绕着这些思想构建。

- 在学术界和工业界都是一个热门话题。

案例研究:MapReduce (CASE STUDY: MapReduce)

我们来探讨一下 MapReduce (MR):

- 它是阐明 6.5840 核心主题的一个极佳范例

- 具有巨大的影响力

- 是 Lab 1 的重点

MapReduce 概述

背景 (context):

对

太字节 (terabyte) 级别

的数据集进行

耗时数小时

的计算

-

例如:构建搜索索引,或排序,或分析网络结构。

-

只有使用上千台计算机才具有实际可行性。

核心目标:让非专业程序员更容易上手

- 程序员只需定义

Map和Reduce函数。 - 通常这些是相当简单的串行代码。

- MR 负责管理并隐藏分布式处理的所有细节!

MapReduce 作业的抽象视图 —— 单词计数 (word count)

Input1 -> Map -> a,1 b,1

Input2 -> Map -> b,1

Input3 -> Map -> a,1 c,1

| | |

| | -> Reduce -> c,1

| -----> Reduce -> b,2

---------> Reduce -> a,2

- 输入 (Input) 被(预先)分割成

M个小文件 (pieces)。 - MR 为每个输入分片调用

Map()函数,生成<键, 值>(k, v) 对列表 —— 即 “中间数据” (intermediate data)。每个Map()调用被称为一个 “任务” (task)。 - 当所有

Map任务完成后,MR 为每个键k收集其所有中间值v,并将每个k及其对应的values传递给一个Reduce调用。 - 最终输出 (Final output) 是来自所有

Reduce()调用的<k, v>对的集合。

单词计数代码示例

Map(d)

将文档 d 分割成单词

对于每个单词 w:

输出(w, "1")

Reduce(k, v[])

输出( len(v[]) ) // 输出该单词的总数 (即values列表v的长度)

MapReduce 扩展性良好:

-

拥有

N个“工作节点” (worker computers)(可能)带来

N倍的吞吐量。

Map()任务可以并行运行,因为它们之间不交互。Reduce()任务同样如此。

-

因此,更多的计算机 -> 更高的吞吐量 —— 非常棒!

MapReduce 隐藏了大量复杂性:

- 向服务器发送 map 和 reduce 代码

- 跟踪哪些任务已完成

- 将中间数据从 Map 节点“混洗” (Shuffling) 到 Reduce 节点

- 在服务器之间平衡负载

- 从崩溃的服务器中恢复

为了获得这些好处,MapReduce 对应用程序施加了限制:

- 除通过中间输出外,没有交互或状态(No interaction or state)。

- 数据处理流仅限于 Map/Reduce 这一种模式(Just the one Map/Reduce pattern)。

- 不支持实时或流处理(No real-time or streaming processing)。

一些细节(论文中的图 1)

-

输入和输出存储在 GFS 集群文件系统上

- MapReduce 需要巨大的并行输入和输出吞吐量。

- GFS 将文件分割存储在许多服务器、许多磁盘上,每个块大小为 64 MB。

- Map 任务并行读取输入。

- Reduce 任务并行写入输出。

- GFS 将所有数据复制在 2 或 3 台服务器上,以实现容错。

- GFS 对 MapReduce 来说是一个巨大的优势。

-

“协调器”(Coordinator)管理作业中的所有步骤:

协调器将 Map 任务分配给工作进程,直到所有 Map 任务完成:

- Map 任务将输出(中间数据)写入本地磁盘。

- Map 任务将其输出根据

hash(key) mod R进行分片,为每个 Reduce 任务生成一个文件(R 是 Reduce 任务的数量)。

在所有 Map 任务完成后,协调器分发 Reduce 任务:

- 每个 Reduce 任务对应一个中间输出文件的哈希桶。

- 每个 Reduce 任务从每一个 Map 工作进程那里获取属于它的桶(的文件)。

- (Reduce 端)按键(key)进行排序,并为每个键调用

Reduce()函数。 - 每个 Reduce 任务在 GFS 上写入一个单独的输出文件。

-

哪些因素可能限制性能?

-

我们关心这个问题,因为性能瓶颈是需要优化的重点。

-

CPU?内存?磁盘?网络?

-

在 2004 年(论文发表时),作者们主要受限于

网络速度

。

- MapReduce 在网络上传输什么?

- Map 任务从 GFS 读取输入。

- Reduce 任务获取 Map 任务的中间输出 —— 这称为 Shuffle(混洗)。这通常和输入一样大(例如排序作业)。

- Reduce 任务将输出文件写入 GFS。

- [图:服务器,网络交换机的树状拓扑]

- 在 MapReduce 的全对全(all-to-all)Shuffle 阶段,一半的流量会经过根交换机。

- 论文使用的根交换机:总计 100 到 200 Gb/s。

- 共有 1800 台机器,平均每台机器只有约 55 Mb/s (55 兆比特每秒)。

- 55 Mb/s 很小:远低于磁盘或内存的速度。

- MapReduce 在网络上传输什么?

-

-

MapReduce 如何最小化网络使用?

-

协调器尽量在

存储输入数据

的 GFS 服务器上运行每个 Map 任务。

- 所有计算机都同时运行 GFS 和 MapReduce 工作进程。

- 因此,Map 的输入通常直接从本地磁盘上的 GFS 数据读取,无需经过网络。

中间数据只在网络上传输一次:

-

Map 工作进程将(中间数据)写入其本地磁盘。

-

Reduce 工作进程通过网络从 Map 工作进程的磁盘上读取(中间数据)。

-

(如果将它们存储在 GFS 中则至少需要在网络上传输两次。)

-

中间数据被

哈希分区

成包含多个键的文件:

- Reduce 任务处理的基本单元是一个哈希桶(而不是单个键)。

- 大型的网络传输效率更高。

-

-

MapReduce 如何实现良好的负载均衡?

-

为什么我们需要关心负载均衡?

- 如果一台服务器的任务量比其他服务器多,或者速度更慢。

- 那么在工作结束时,其他服务器将会空闲等待(资源被浪费)。

-

但是任务大小可能不同,计算机速度也可能不同。

-

解决方案:使用

远多于工作机器数量

的任务。

- 协调器将新任务分配给已完成前一个任务的工作进程。

- 因此,更快的服务器会处理更多的任务,而较慢的服务器则处理较少的任务。

- 较慢的服务器被分配较少的任务,从而减少了它们对总执行时间的影响。

-

-

容错是如何处理的?

- 如果一个工作进程计算机崩溃了怎么办?

- 我们希望对应用程序开发人员隐藏这些失败!

- MapReduce 是否必须从头重新运行整个作业?

- 为什么不呢?

- MapReduce只需重新运行失败的 Map 任务和 Reduce 任务。

-

假设 MapReduce 将同一个 Map 任务运行了两次,假设一个 Reduce 任务看到了第一次运行的输出,而另一个 Reduce 任务看到了第二次运行的输出,会发生什么?

-

两次 Map 执行必须产生完全相同的中间输出!

-

Map 函数和 Reduce 函数

必须是纯确定性函数

:

- 它们只能查看其参数/输入。

- 不能有状态、不能进行文件 I/O、不能交互、不能进行外部通信、不能使用随机数。

-

程序员有责任确保这种确定性。

-

-

工作进程崩溃恢复的细节:

一个工作进程在运行 Map 任务时崩溃:

-

协调器注意到该工作进程无响应。

-

协调器知道在那个工作进程上运行了哪些 Map 任务。

-

这些任务的中间输出现已丢失,必须重新生成。

-

协调器通知其他工作进程运行这些(丢失的)任务。

-

如果所有 Reduce 任务都已经获取了该(崩溃的 Map 节点)的中间数据,则可以省略重新运行这些 Map 任务。

一个工作进程在运行 Reduce 任务时崩溃:

- 已经完成的任务是没问题的——它们存储在具有副本的 GFS 中。

- 协调器将该工作进程未完成的任务重新分配给其他工作进程。

-

-

其他失败/问题:

如果协调器把同一个 Map() 任务分配给两个工作进程会怎样?

-

可能是协调器错误地认为其中一个工作进程死掉了。

-

它只会告诉 Reduce 工作进程关于其中一个(Map 任务实例)的信息。

如果协调器把同一个 Reduce() 任务分配给两个工作进程会怎样?

-

它们都会尝试在 GFS 上写入相同的输出文件!

-

GFS 的原子重命名操作防止了混合输出;最终只会有一个完成的文件是可见的。

如果一个工作进程非常慢 —— 一个“掉队者节点”(straggler)?

-

可能是由于不稳定的硬件造成的。

-

协调器为最后几个任务启动第二个备份副本运行(称为备份执行 / Speculative Execution)。

如果一个工作进程由于损坏的硬件或软件而计算出错误的输出怎么办?

-

那就太糟糕了!MapReduce 假设 CPU 和软件是“故障-停止”的(只发生崩溃故障,不会产生错误结果)。

-

如果协调器自己崩溃了怎么办? (论文未详细说明此问题,这是系统的单点故障)。

-

-

性能如何?

- 图 2

- X 轴:时间

- Y 轴:类似 'grep' 作业读取其输入的总速率

- 输入大小为 1 TB (1000 GB)

- 1764 个工作进程

- 30,000 MB/s (30 GB/s) 是巨大的吞吐量!

- 为什么是 30,000 MB/s?

- 每台工作机器约 17 MB/s —— 140 兆比特每秒 (Mb/s)

- 这超过了我们之前对每台机器网络带宽(55 Mb/s)的猜测。

- 输入文件可能直接从本地 GFS 磁盘读取。

- 所以磁盘的读取速度可能大约就是 17 MB/s。

- 为什么主要活动期大约是 30 秒?

- 为什么需要 50 秒才能使吞吐量达到最大值?(启动、任务分发、GFS读取预热等因素导致前期吞吐量较低)。

-

现状如何?

-

极具影响力 (Hadoop, Spark 等均由其启发)。

在谷歌内部可能不再使用

。