信息熵

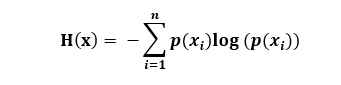

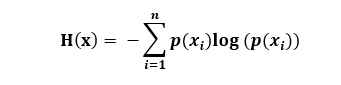

信息熵的公式:

其中𝑝(𝑥𝑖) 代表随机事件𝑥𝑖 的概率。

先了解下什么是信息量,信息量是对信息的度量。当我们考虑一个离散的随机变量x 的时候,当我们观察到的这个变量的一个具体值的时候,我们接收到了多少信息呢?

多少信息用信息量来衡量,我们接收到的信息量跟具体发生的事件有关。

信息的大小跟随机事件的概率有关,越小概率的事件发生产生的信息量越大,如太阳从东边升起(再平常不过的事)产生的信息量越小,反之如果太阳从西边升起(肯定有什么大事发生,可能太阳系发生了重大变化),信息量很大。

因此一个具体事件的信息量应该是随着其发生概率的升高而递减,并且不能为负。但是这个表示信息量的函数该怎么表示呢?毕竟随概率增大而减小的函数形式太多。

如果我们有两个不想关的事件x 和y,那么我们观察到这两个事假同时发生时获得的信息量应该等于观察到的事件各自发生时获得的信息之和,即:

h(x,y) = h(x) + h(y)

由于x, y是两个不相关的事件,那么它们同时发生的概率满足

P(x, y) = P(x) * P(y)

根据上面的推导,我们很容易看出 h(x) 和 p(x) 存在对数关系,还不清楚的话请复习一下对数公式:

因此我们得出信息量公式如下:

𝐡(𝐱) = −𝒍𝒐𝒈𝟐𝒑(𝒙)

1) 为什么会有个负号?这里负号是为了确保信息量的值>= 0,总不能<1 吧。

2)为什么底数为2?这是因为我们只需要信息量满足低概率事件x 对应于高的信息,那么对数的选择可以是任意的,我们只是遵循信息论的普遍传统,使用2 作为对数的底。

下面正式引出信息熵:信息量度量的是一个具体事件发生所带来的信息,而熵则是在结果出来之前对可能产生的信息量的期望,考虑随机变量的所有可能取值,即所有可能发生事件所带来的信息量的期望,即:

信息熵还可以作为一个系统复杂程度的度量,如果系统越复杂,出现不同情况的种类越多,那么它的信息熵越大。如果一个系统越简单,出现情况种类很少(极端情况为1种情况,那么对应概率为1,对应的信息熵为0),此时的信息熵较小。

浙公网安备 33010602011771号

浙公网安备 33010602011771号