Spark makeRDD方法本地Task的默认分区数

注意setMaster("local")和setMaster("local[*])的分区数是不一样的。*会匹配所有的cpu核数。

import org.apache.spark.rdd.RDD import org.apache.spark.{SparkConf, SparkContext} object Seq_Partition_04 { def main(args: Array[String]): Unit = { val sparkConf: SparkConf = new SparkConf().setMaster("local").setAppName("Operator") val sc: SparkContext = new SparkContext(sparkConf) val rdd: RDD[Int] = sc.makeRDD(List(1, 2, 3, 4)) rdd.saveAsTextFile("seq_output_04") sc.stop() } }

import org.apache.spark.rdd.RDD import org.apache.spark.{SparkConf, SparkContext} object Seq_Partition_05 { def main(args: Array[String]): Unit = { val sparkConf: SparkConf = new SparkConf().setMaster("local[*]").setAppName("Operator") val sc: SparkContext = new SparkContext(sparkConf) val rdd: RDD[Int] = sc.makeRDD(List(1, 2, 3, 4)) rdd.saveAsTextFile("seq_partition_05") sc.stop() } }

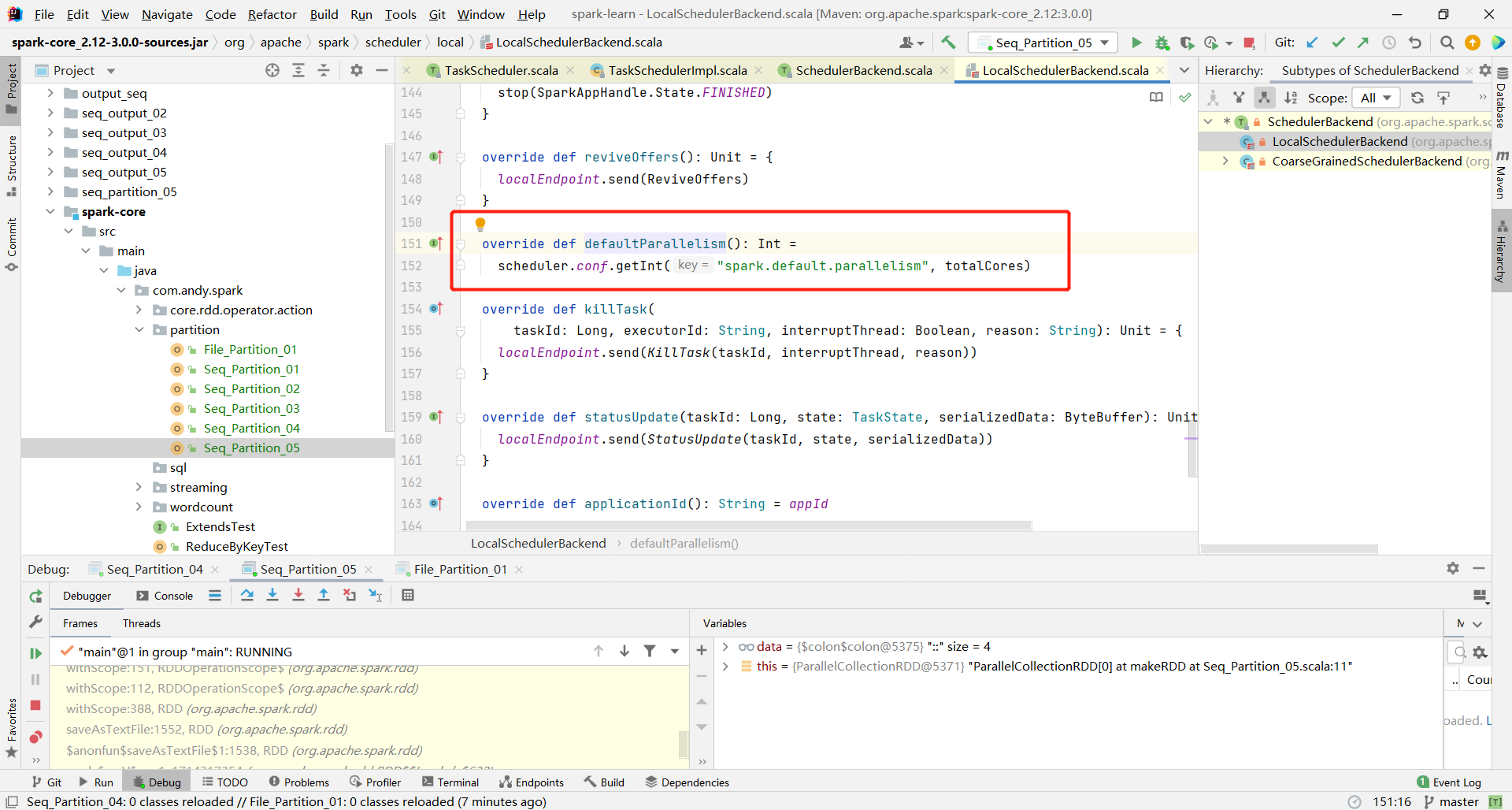

如果spark.default.parallelism没有设置,就会使用cpu的核数。

浙公网安备 33010602011771号

浙公网安备 33010602011771号