Spark on Intellij IDEA

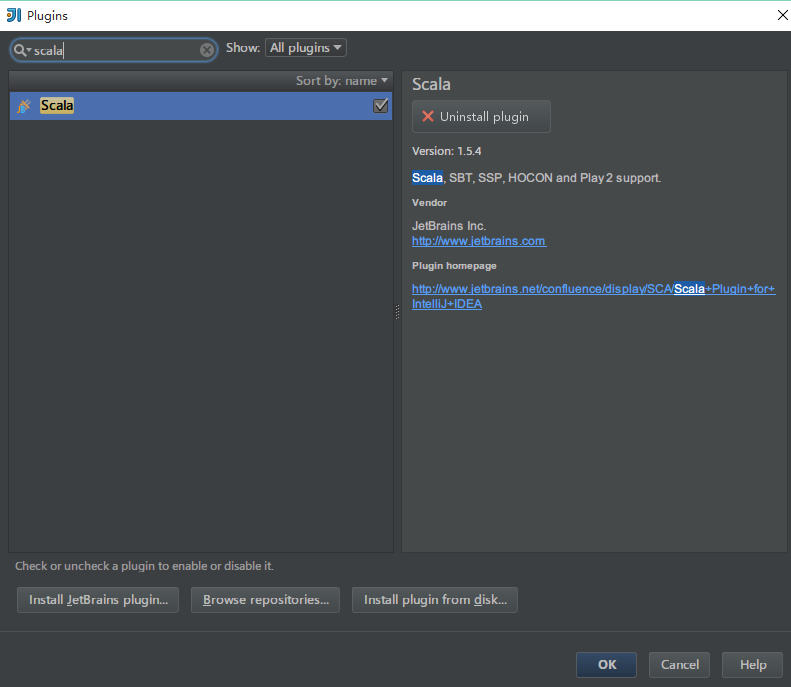

添加scala插件

如果网络有问题,可以手动下载插件安装包(http://plugins.jetbrains.com/plugin/?id=1347),在上面选择“Install plugin from disk”,在弹出的标签里选择你存放插件的路径,点OK即可。

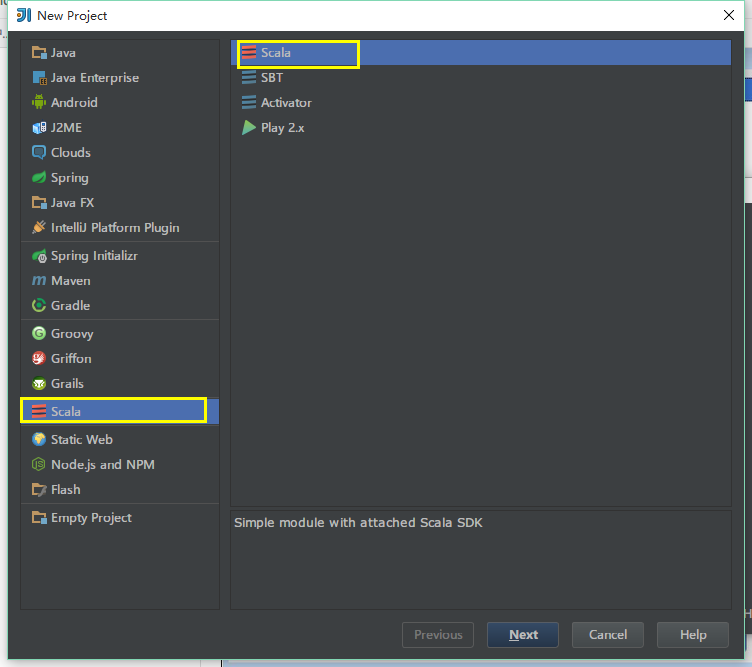

下面新建scala工程

据说scala2.11问题多,最好用2.10

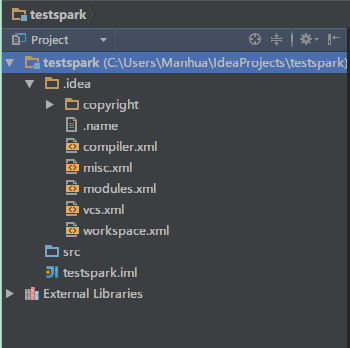

点击finish之后,啥都没有

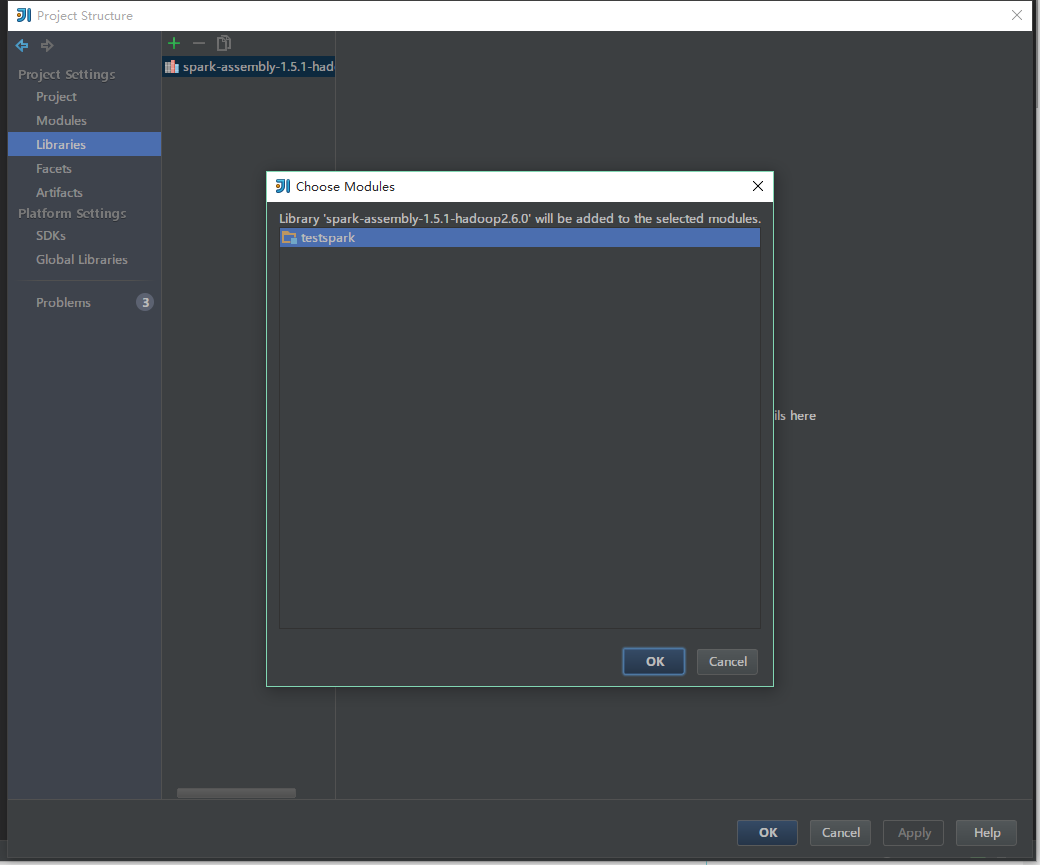

到官网http://spark.apache.org/下载spark,解压,从File->Project Structre中导入[spark root path]/lib/spark-assembly-1.5.1-hadoop2.6.0.jar

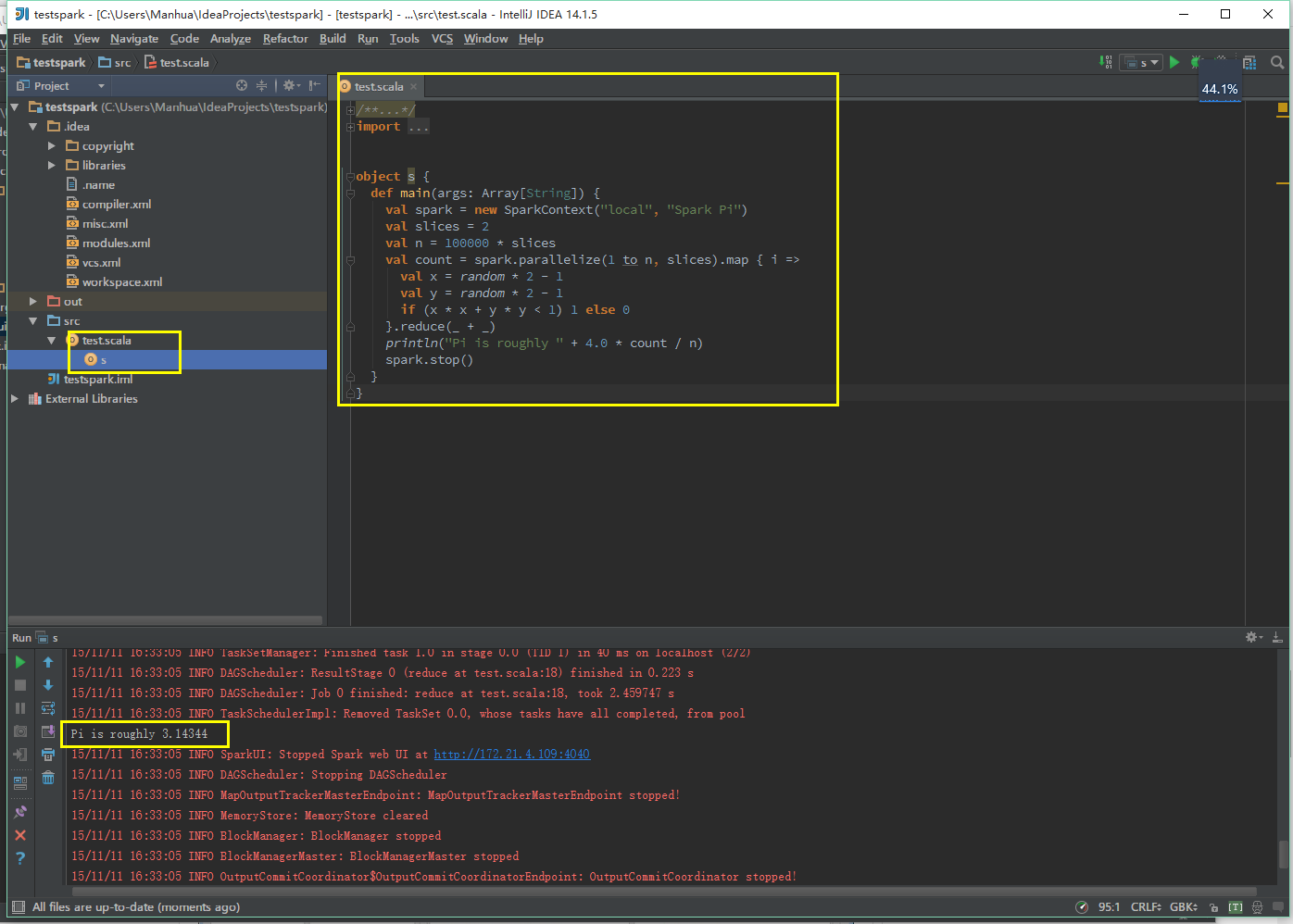

在scr下新建scala object

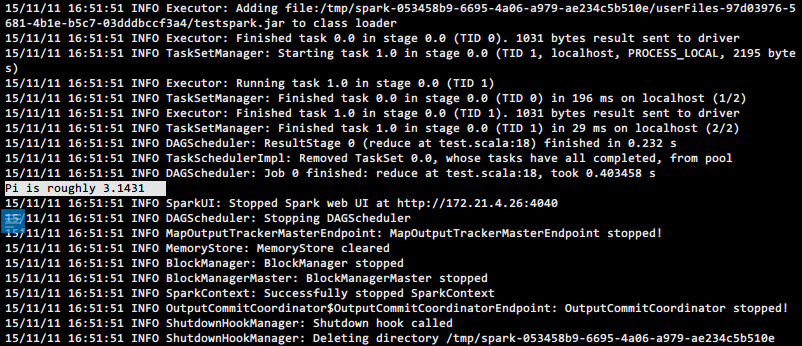

/** * Created by Manhua on 2015/11/11. */ import org.apache.spark._ import scala.math.random object s { def main(args: Array[String]) { val spark = new SparkContext("local", "Spark Pi") val slices = 2 val n = 100000 * slices val count = spark.parallelize(1 to n, slices).map { i => val x = random * 2 - 1 val y = random * 2 - 1 if (x * x + y * y < 1) 1 else 0 }.reduce(_ + _) println("Pi is roughly " + 4.0 * count / n) spark.stop() } }

右击test.scala,编译,运行

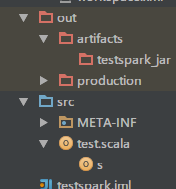

打包jar运行

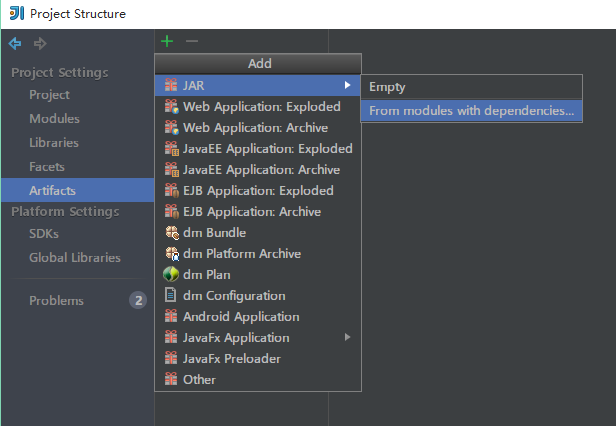

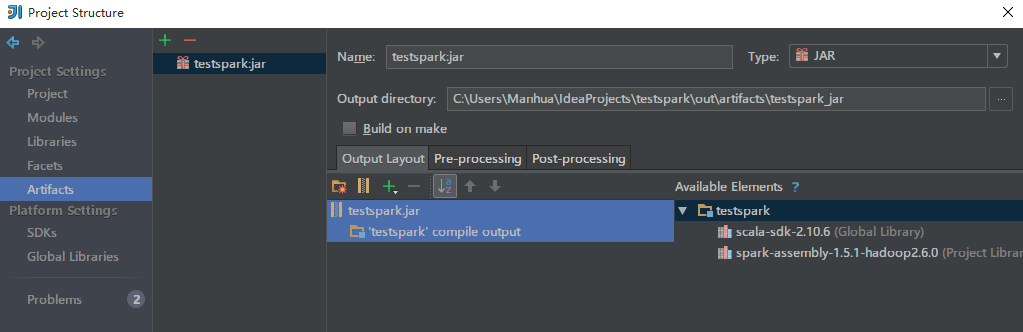

生成程序包之前要先建立一个artifacts,File -> Project Structure -> Artifacts -> + -> Jars -> From moudles with dependencies,然后随便选一个class作为主class。

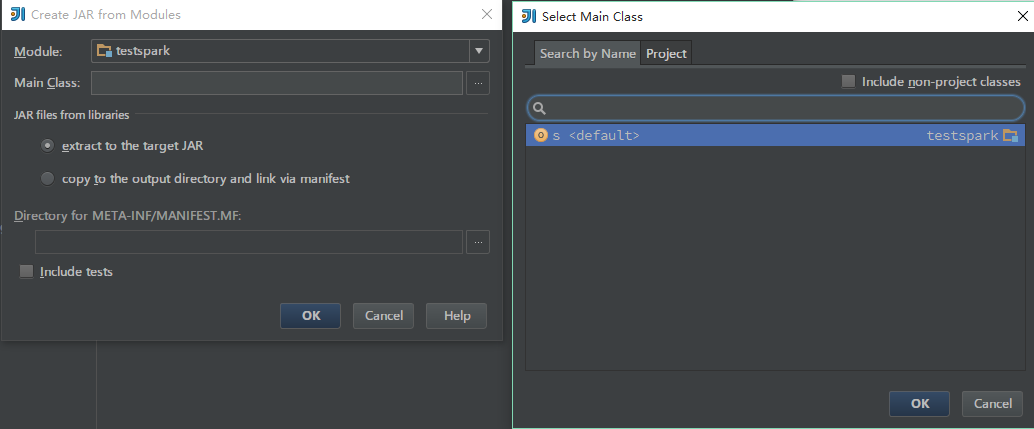

选择jar包入口main class

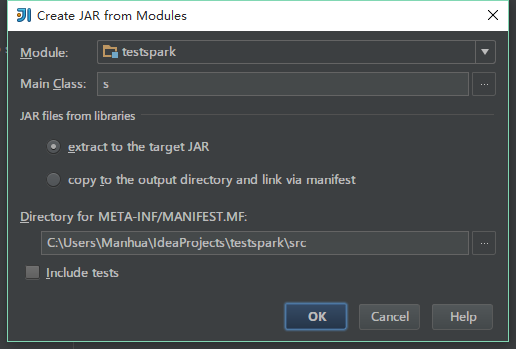

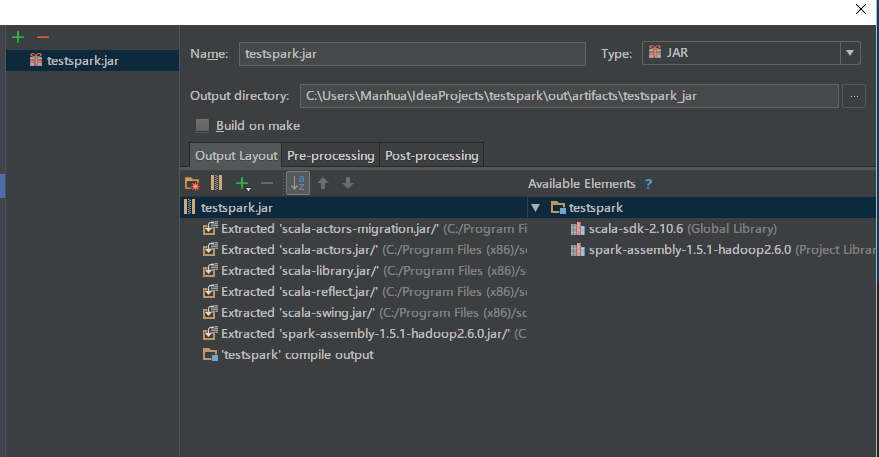

ok之后显示如下

把complie output之外的依赖包remove掉。Name可以按需修改

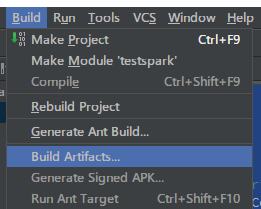

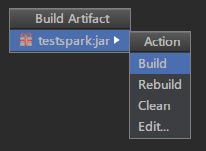

然后就可以build了

输出目录

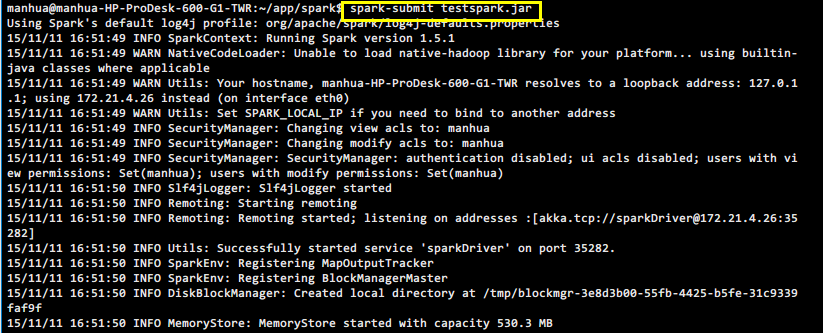

上传运行

浙公网安备 33010602011771号

浙公网安备 33010602011771号