RAGFlow(了解即可,效果不如Dify)

环境准备

1.下载ollama平台

ollama是一个用于本地运行和管理大语言模型(LLM)的工具。通过olama将DeepSeek模型下载到本地运行;

参照Dify

环境变量配置

由于RAGFlow是通过Docker部署的(在虚拟机里),而Ollama 是运行在本地电脑的,得让RAGFlow能访问Ollama 的服务。所以需要进行如下环境变量配置:

- OLLAMA_HOST - 0.0.0.0:11434(0.0.0.0相当于在所有 IPv4 和 IPv6 地址上监听)

作用:让虚拟机里的RAGFlow能够访问到本机上的 Ollama; - 如果配置后虚拟机无法访问,可能是你的本机防火墙拦截了端口11434;

- 不想直接暴露 11434 端口:SSH 端口转发来实现;

OLLAMA_MODELS-自定义位置

- 作用:ollama 默认会把模型下载到C盘,如果希望下载到其他盘需要进行配置;如:D:\data\ollamamodel

更新完两个环境变量记得重启电脑;

3.通过ollama下载模型deepseek-r1:1.5b

ollama run deepseek-r1:1.5b;

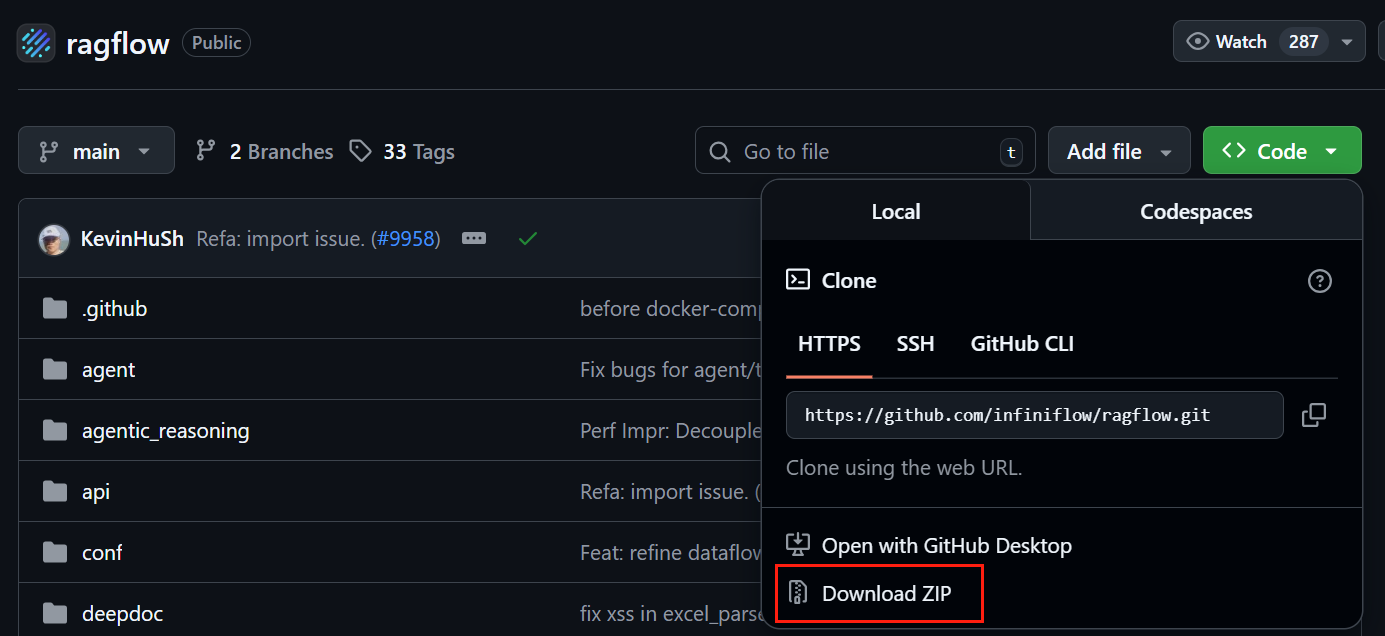

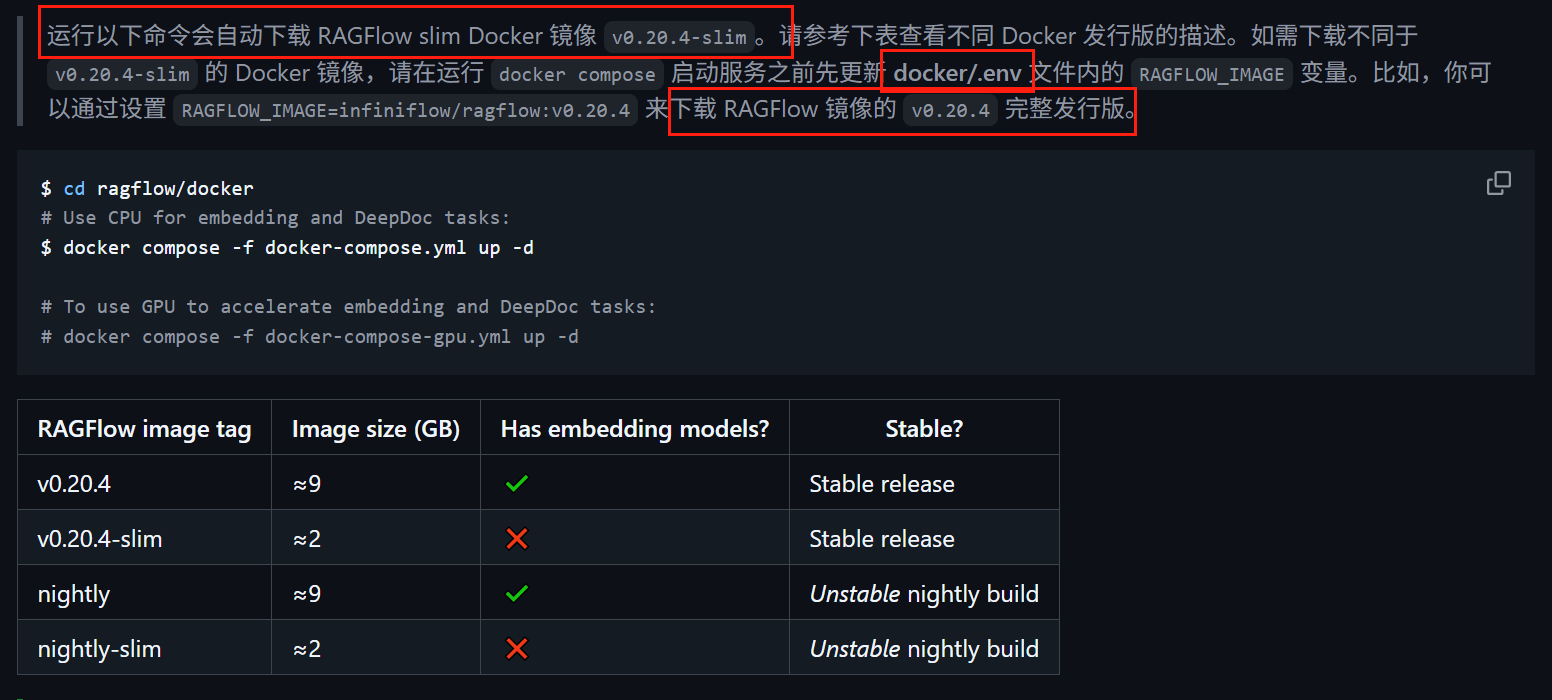

下载RAGflow源代码和Docker(参照Dify),通过Docker来本地部署RAGflow;

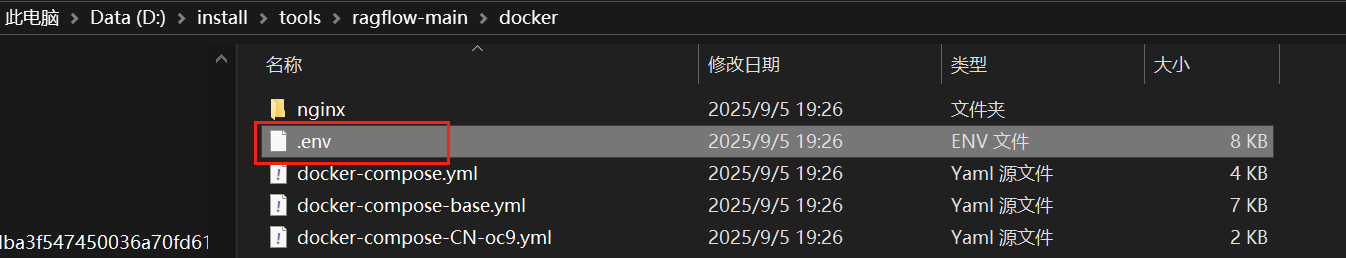

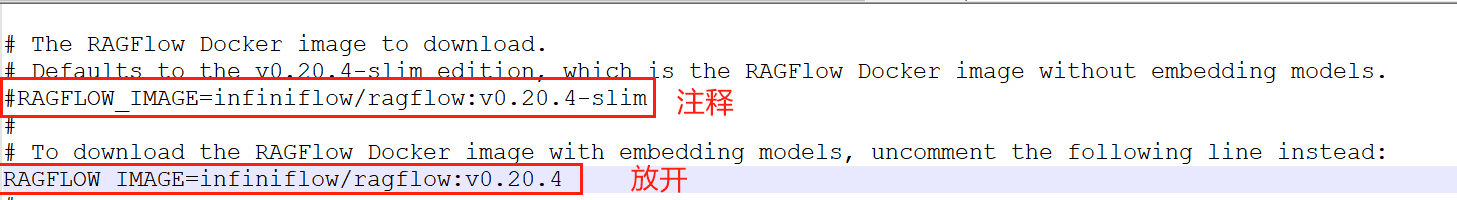

下载解压之后,修改配置文件,因为根据官方文档:https://github.com/infiniflow/ragflow/blob/main/README_zh.md说明,docker默认下载的是轻量版,不包含embedding模型,后续我们还要单独再去下载,很是麻烦,所以需要去配置文件按照官方文档修改配置,来现在完整版

配置完成后就可以在RagFlow的源码解压目录,执行doker命令安装RAGFlow了:

docker compose -f docker-compose.yml up -d通过doker启动RAGFlow:

docker compose -f docker-compose.yml up -d停止所有容器运行:

docker compose -f docker/docker-compose.yml down -v启动报错:

解决方案:

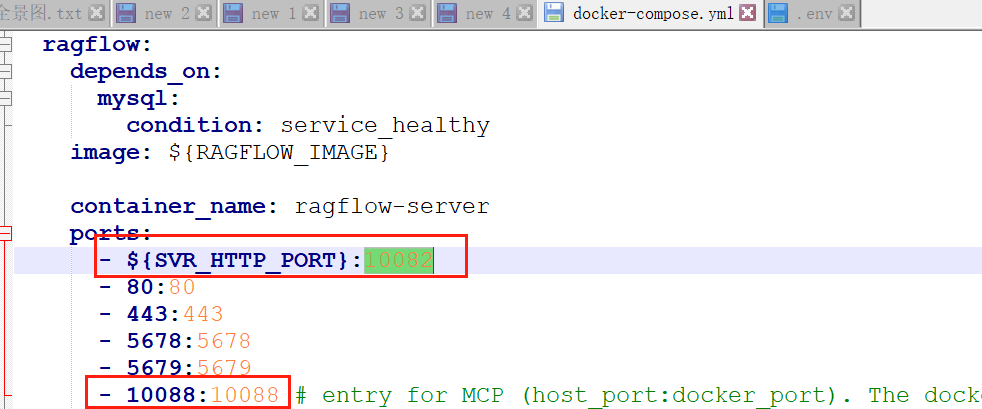

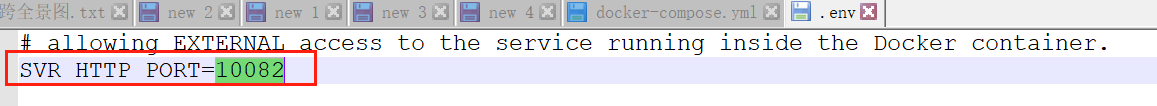

去这两个配置文件把端口改掉:

启动成功后,在浏览器输入localhost,即可访问:

http://localhost/login

登录即可:

1967610524@qq.com

qwe123!@#

RAGflow的配置

中文简体

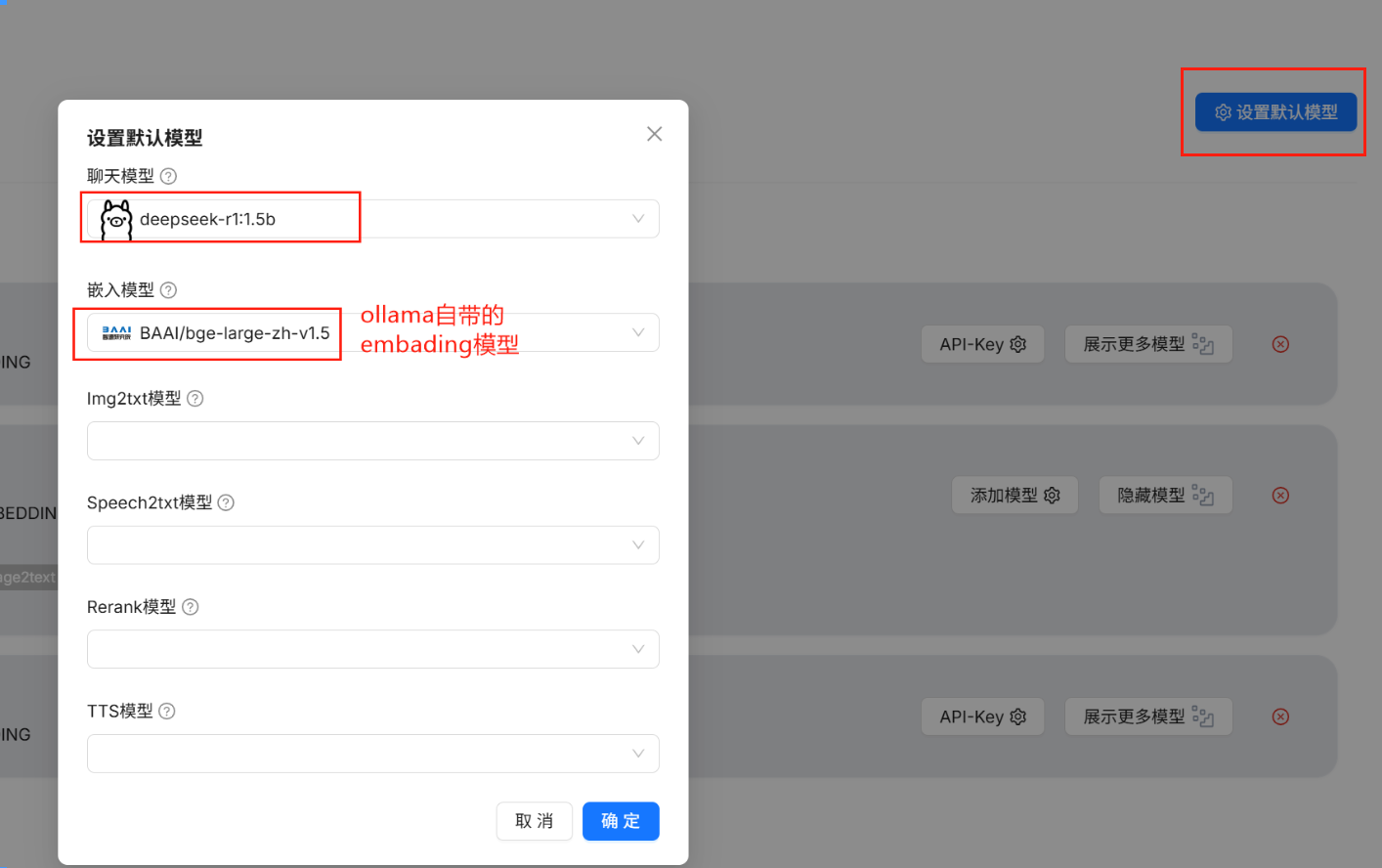

模型配置

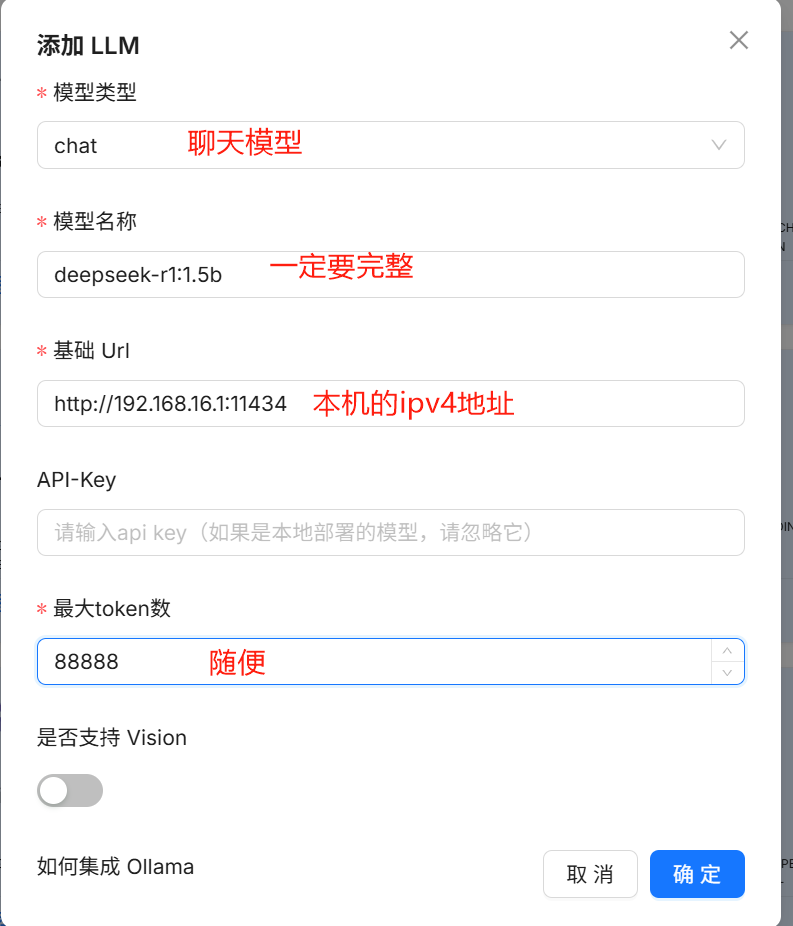

将上面通过ollama安装的deepseek添加进来:

首先在命令窗口使用ollama list查看所有的已安装的模型:

复制模型完整名称:deepseek-r1:1.5b

添加模型:

添加模型如果报错,请参考:https://blog.csdn.net/yuanjinshenglife/article/details/146166276,不过我完全按照此博客操作也照样报错:

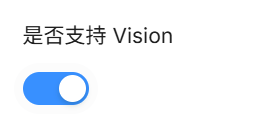

最后,我是点击了最下面的“Vision”之后,自己就好了:

RAGflow的应用

在RAGflow中构建个人知识库并实现基于个人知识库的对话问答;

创建知识库

相关配置:

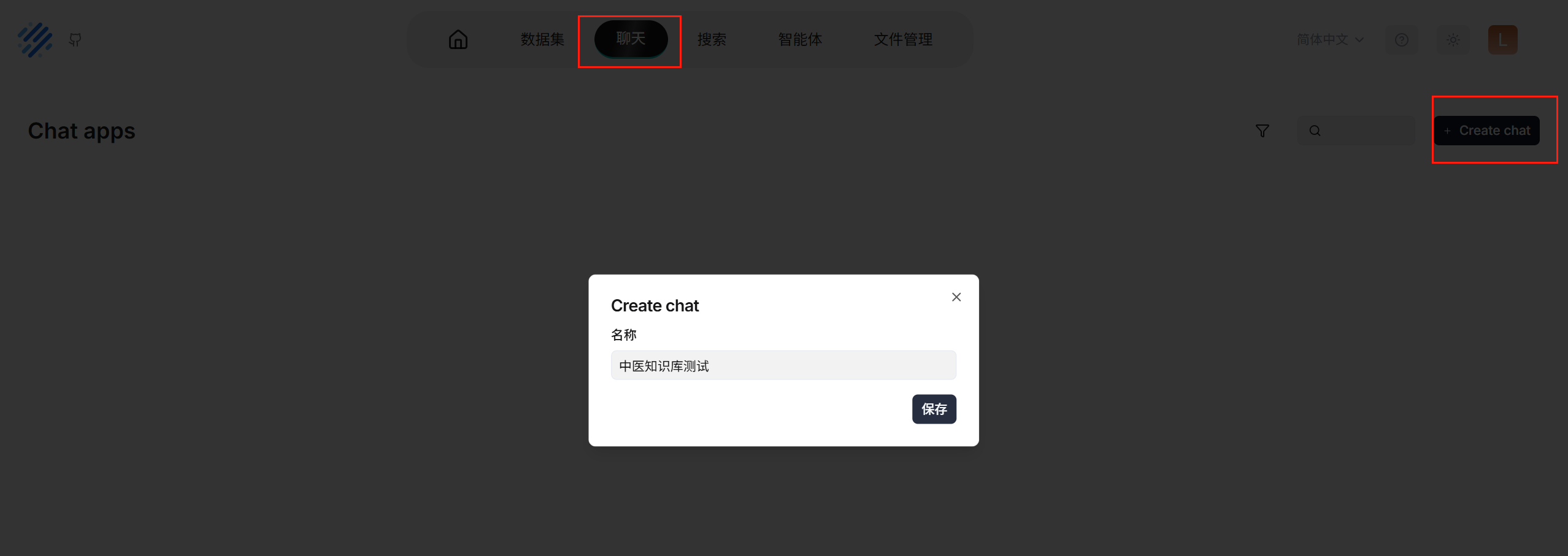

创建聊天

配置知识库

测试

不耐疲劳,口燥、咽干可能是哪些证候?

结论:

效果很一般,了解即可

只想迅速搭建个人知识库,可以不本地部署大模型吗?

当然可以!这样实现起来更简单,而且效果一般来说会更好;

具体步骤:

- 下载RAGFlow源代码和docker,通过docker本地部署RAGFoW(RAGFlow目前没有官方的网页版);

- 在RAGFlow中配置任意的Chat模型和Embedding模型(你需要到这些模型对应的官网去付费申请apiKey);

优点:

- 不用本地部署大模型,简单易操作;企业大模型性能一般更优越;

缺点:

- 隐私安全问题;

- 调用企业大模型API的成本:

浙公网安备 33010602011771号

浙公网安备 33010602011771号