本地部署与微调概述

技术必要性分析

-

本地部署的必要性:

- 场景适配:当需要处理敏感数据/定制化需求时(如医疗、金融场景),本地部署是刚需。若目标是开发行业应用(如医疗咨询、法律文书分析),本地部署是落地的关键环节。例如,通过本地微调 DeepSeek-R1-Distill-Qwen-1.5B 模型,可将通用大模型转化为领域专家。

- 成本控制:云端 API 调用费用高昂(如 GPT-4 约 0.06 美元 / 千 token),本地部署可降低长期使用成本。某金融机构通过本地部署节省了 73% 的推理费用。推理API成本超过本地硬件投入时(根据HuggingFace的测算,当API调用量>50万次/月时,自建T4服务器更经济)

- 数据安全:政府、医疗等敏感领域需数据不出域,本地部署是合规刚需。某三甲医院通过私有化部署实现患者信息 100% 本地化处理。

- 最新趋势显示,2024年企业级LLM应用中,混合部署(本地+云端)方案占比已达67%(来源:MLOps Community Survey)

-

Fine-tuning现状:

-

参数高效微调(PEFT)已成为主流,LoRA/QLoRA可降低90%显存需求

-

新兴的Delta-tuning技术可在仅调整0.1%参数下达到全参数微调效果

-

当前是否值得学习?

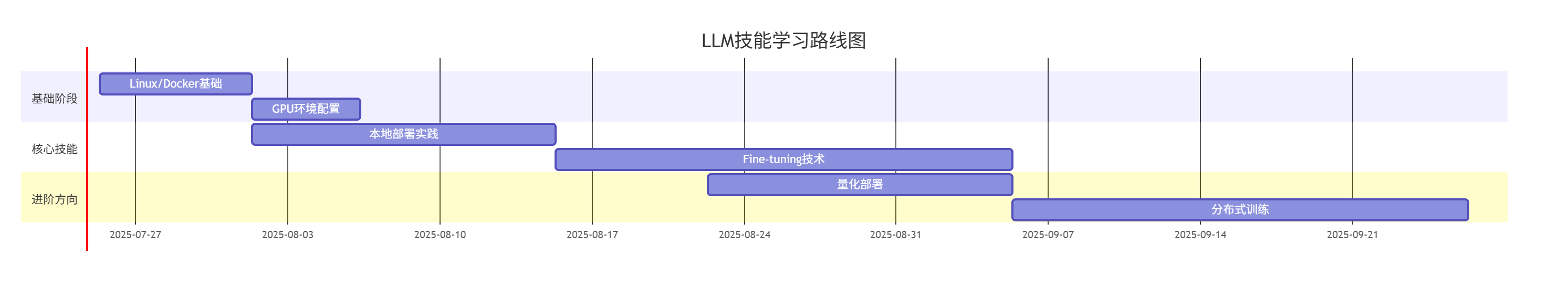

学习路径建议(含时间规划)

模型选型矩阵

|

模型 |

参数量 |

显存需求(QLoRA) |

中文支持 |

生态完善度 |

|---|---|---|---|---|

|

DeepSeek-MoE |

16B |

24GB(RTX3090) |

★★★★★ |

★★★☆☆ |

|

Qwen1.5-7B |

7B |

16GB(RTX2080Ti) |

★★★★☆ |

★★★★☆ |

|

Llama3-8B |

8B |

18GB |

★★☆☆☆ |

★★★★★ |

|

Phi-3-mini |

3.8B |

10GB |

★★★☆☆ |

★★★☆☆ |

推荐选择:Qwen1.5-7B(平衡中文能力与硬件需求)或Phi-3-mini(最低硬件门槛)

DeepSeek 仍具独特价值

DeepSeek 的现状与学习建议

现代技术栈组合

-

部署工具链:

-

vLLM(推理加速)+ Triton(服务化)+ Prometheus(监控)

-

典型部署耗时:从模型下载到API暴露约2小时(含Docker打包)

-

-

微调方案:

-

硬件性价比分析(2025年Q2数据):

-

二手RTX3090(24GB):约¥3500,可运行7B模型QLoRA

-

全新RTX4090(24GB):约¥12000,支持8B模型全参数微调

-

云服务对比:AWS g5.2xlarge(¥12.8/小时)vs 本地设备回本周期≈300小时

-

前沿方向建议

-

关注MoE架构的微调策略(如DeepSeek-MoE的专家选择机制)

-

学习模型合并技术(如模型嫁接、权重插值)

-

掌握FP8量化技术(NVIDIA H100的新特性)

建议从Qwen1.5-7B开始实践,使用vLLM部署基础服务后,通过LLaMA-Factory工具进行可视化微调(支持30+种数据集模板)。每周保持10小时实操,预计6周可达到生产级应用水平。

浙公网安备 33010602011771号

浙公网安备 33010602011771号