00机器学习(Machine Learning)概述

1 什么是机器学习

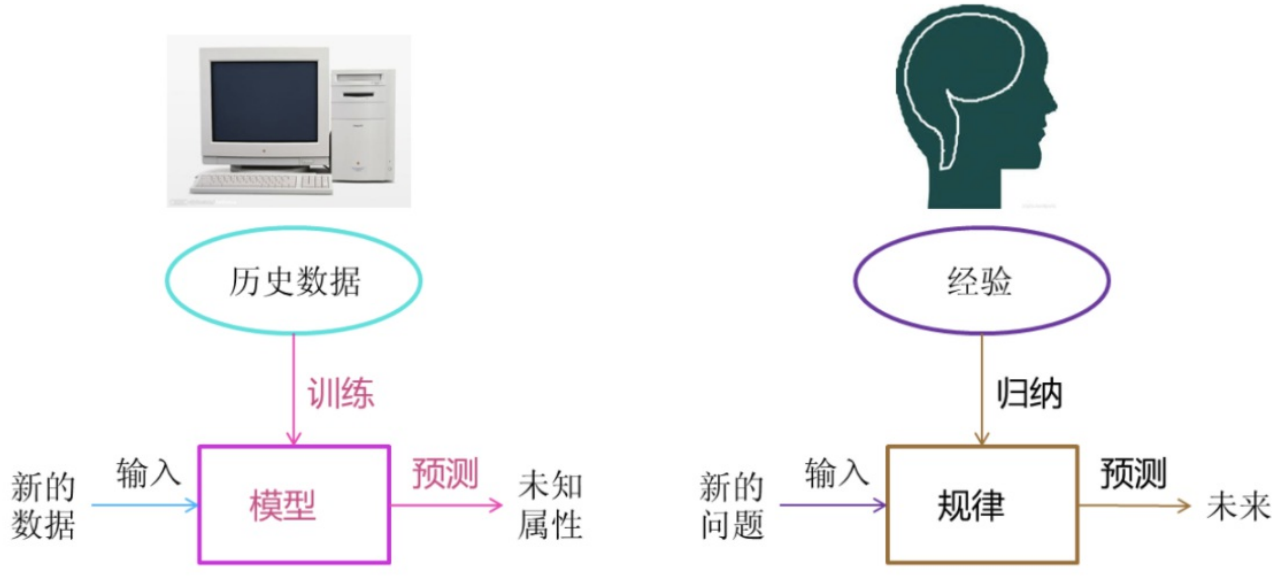

机器学习就是让机器从过去已知的大量数据中进行学习,进而得到一个无限接近现实的规律,最后通过这个规律对未知数据进行预测。

2 机器学习工作流程

- 机器学习工作流程总结

1.获取数据

2.数据基本处理

即对数据进行缺失值、去除异常值等处理

3.特征工程

4.机器学习(模型训练)

5.模型评估

-

- 结果达到要求,上线服务

- 没有达到要求,重新上面步骤

完整机器学习项目的流程

1 抽象成数学问题

明确问题是进行机器学习的第一步。机器学习的训练过程通常都是一件非常耗时的事情,胡乱尝试时间成本是非常高的。这里的抽象成数学问题,指的明确我们可以获得什么样的数据,抽象出的问题,是一个分类还是回归或者是聚类的问题。

2 获取数据

数据决定了机器学习结果的上限,而算法只是尽可能逼近这个上限。

数据要有代表性,否则必然会过拟合。

而且对于分类问题,数据偏斜不能过于严重,不同类别的数据数量不要有数量级的差距。

而且还要对数据的量级有一个评估,多少个样本,多少个特征,可以估算出其对内存的消耗程度,判断训练过程中内存是否能够放得下。如果放不下就得考虑改进算法或者使用一些降维的技巧了。如果数据量实在太大,那就要考虑分布式了。

3 特征预处理与特征选择

良好的数据要能够提取出良好的特征才能真正发挥作用。

特征预处理、数据清洗是很关键的步骤,往往能够使得算法的效果和性能得到显著提高。归一化、离散化、因子化、缺失值处理、去除共线性等,数据挖掘过程中很多时间就花在它们上面。这些工作简单可复制,收益稳定可预期,是机器学习的基础必备步骤。

筛选出显著特征、摒弃非显著特征,需要机器学习工程师反复理解业务。这对很多结果有决定性的影响。特征选择好了,非常简单的算法也能得出良好、稳定的结果。这需要运用特征有效性分析的相关技术,如相关系数、卡方检验、平均互信息、条件熵、后验概率、逻辑回归权重等方法。

4 训练模型与调优

直到这一步才用到我们上面说的算法进行训练。现在很多算法都能够封装成黑盒供人使用。但是真正考验水平的是调整这些算法的(超)参数,使得结果变得更加优良。这需要我们对算法的原理有深入的理解。理解越深入,就越能发现问题的症结,提出良好的调优方案。

5 模型诊断

如何确定模型调优的方向与思路呢?这就需要对模型进行诊断的技术。

过拟合、欠拟合 判断是模型诊断中至关重要的一步。常见的方法如交叉验证,绘制学习曲线等。过拟合的基本调优思路是增加数据量,降低模型复杂度。欠拟合的基本调优思路是提高特征数量和质量,增加模型复杂度。

误差分析 也是机器学习至关重要的步骤。通过观察误差样本全面分析产生误差的原因:是参数的问题还是算法选择的问题,是特征的问题还是数本身的问题……

诊断后的模型需要进行调优,调优后的新模型需要重新进行诊断,这是一个反复迭代不断逼近的过程,需要不断地尝试, 进而达到最优状态。

6 模型融合

一般来说,模型融合后都能使得效果有一定提升。而且效果很好。

工程上,主要提升算法准确度的方法是分别在模型的前端(特征清洗和预处理,不同的采样模式)与后端(模型融合)上下功夫。因为他们比较标准可复制,效果比较稳定。而直接调参的工作不会很多,毕竟大量数据训练起来太慢了,而且效果难以保证。

7 上线运行

这一部分内容主要跟工程实现的相关性比较大。工程上是结果导向,模型在线上运行的效果直接决定模型的成败。 不单纯包括其准确程度、误差等情况,还包括其运行的速度(时间复杂度)、资源消耗程度(空间复杂度)、稳定性是否可接受。

这些工作流程主要是工程实践上总结出的一些经验。并不是每个项目都包含完整的一个流程。这里的部分只是一个指导性的说明,只有大家自己多实践,多积累项目经验,才会有自己更深刻的认识。

机器学习算法分类

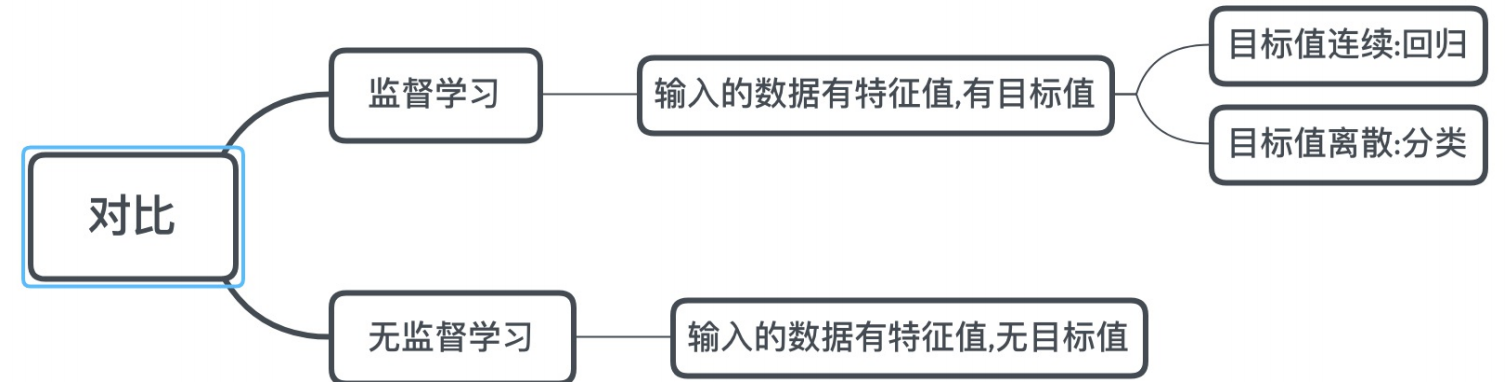

根据数据集组成不同,可以把机器学习算法分为:

- 监督学习

- 无监督学习

- 半监督学习

- 强化学习

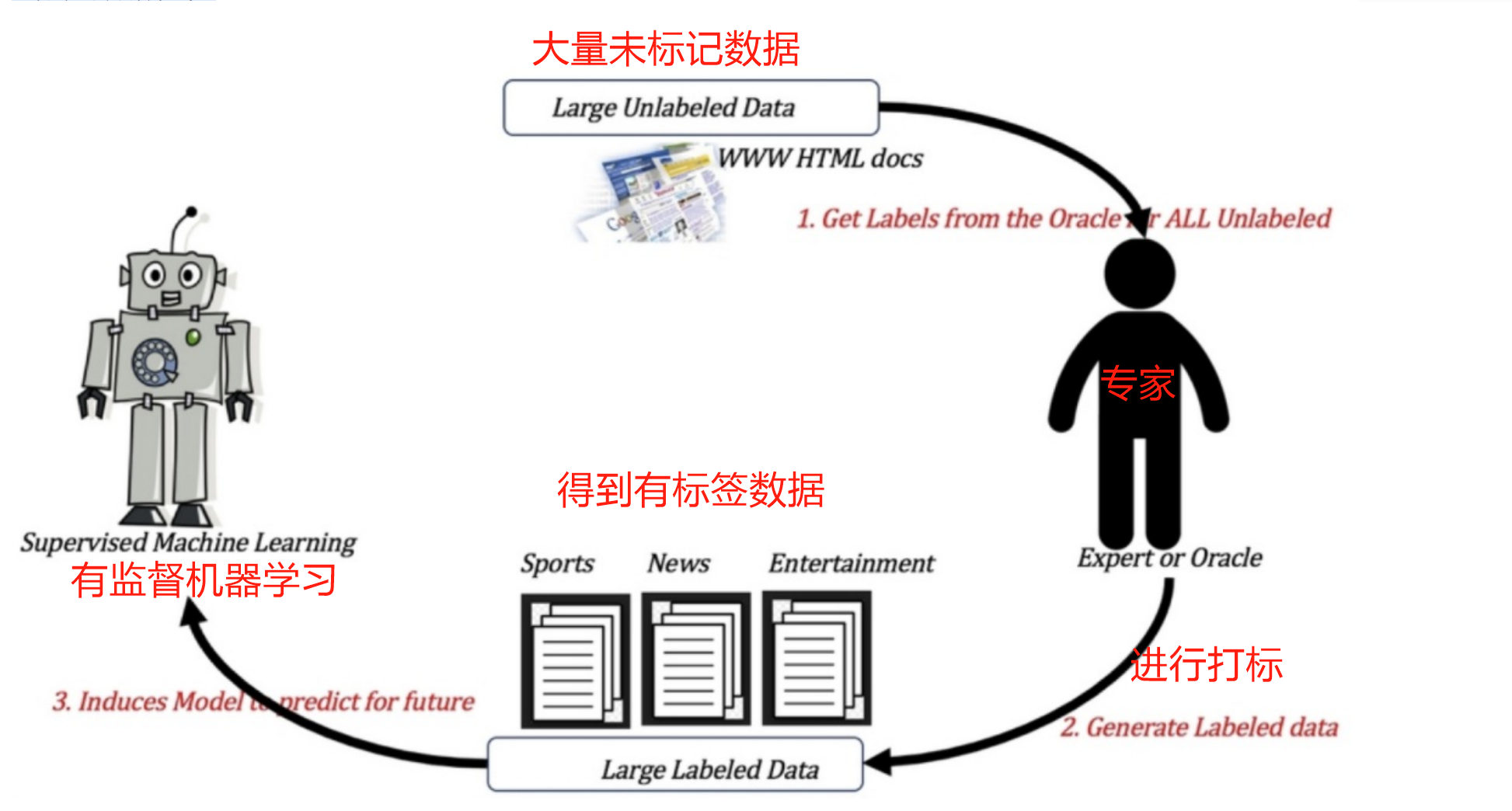

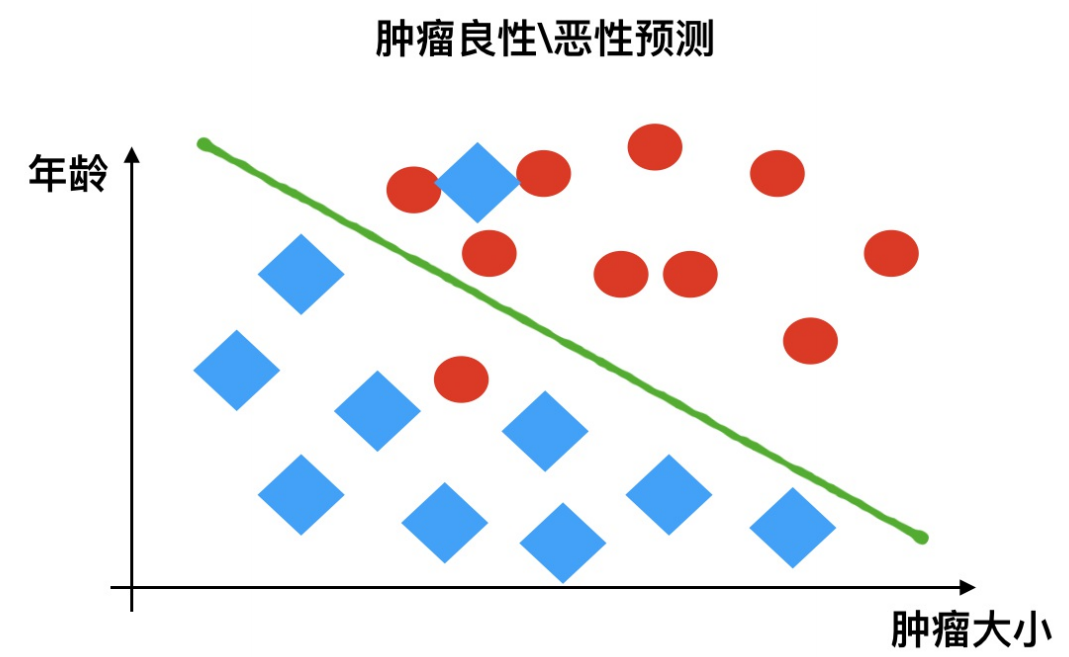

1 监督学习

- 定义:

输入数据是由特征值和目标值所组成。

函数的输出可以是一个连续的值(称为回归),或是输出是有限个离散值(称作分类)。

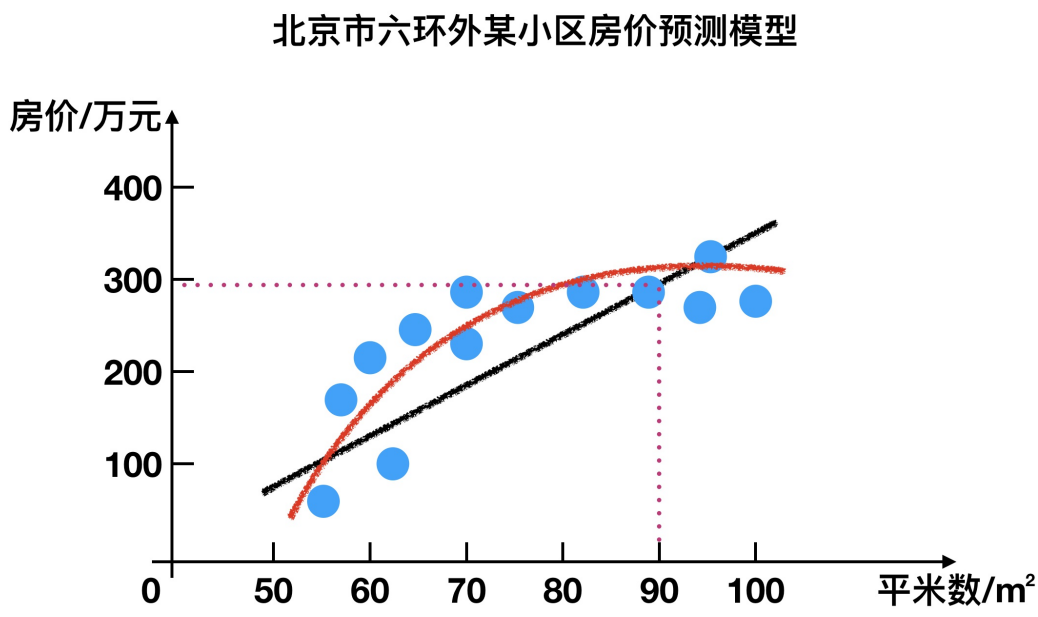

1.1 回归问题

例如:预测房价,根据样本集拟合出一条连续曲线。

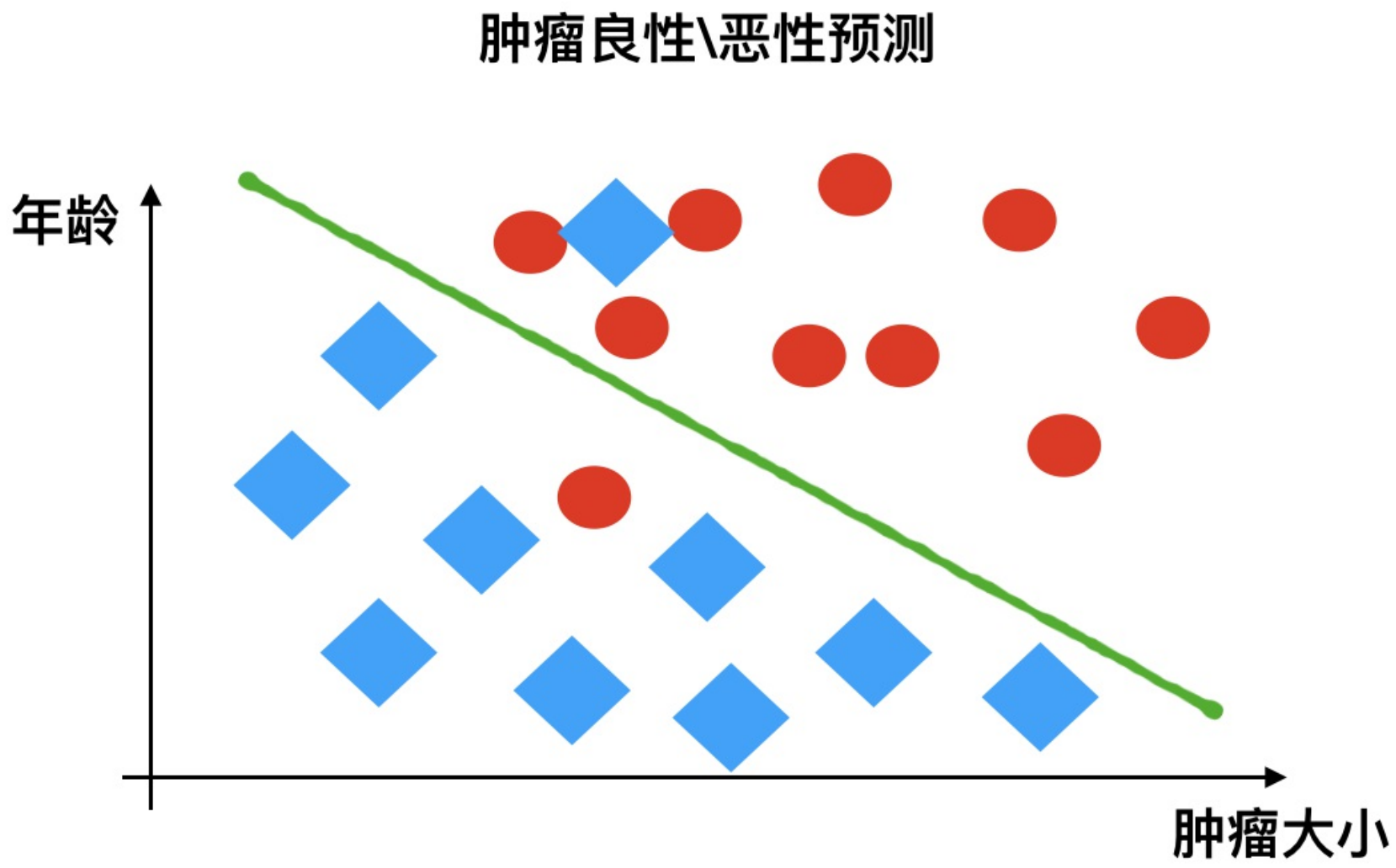

1.2 分类问题

例如:根据肿瘤特征判断良性还是恶性,得到的是结果是“良性”或者“恶性”,是离散的。

2 无监督学习

- 定义:

输入数据是只有特征值组成,没有目标值

输入数据没有被标记,也没有确定的结果。样本数据类别未知;

需要根据样本间的相似性对样本集进行类别划分。

- 举例:

例如下图,算法可以将戴帽子和不戴帽子作为特征进行分类,也可能是手里拿东西和不拿东西作为特征进行分类

有监督,无监督算法对比:

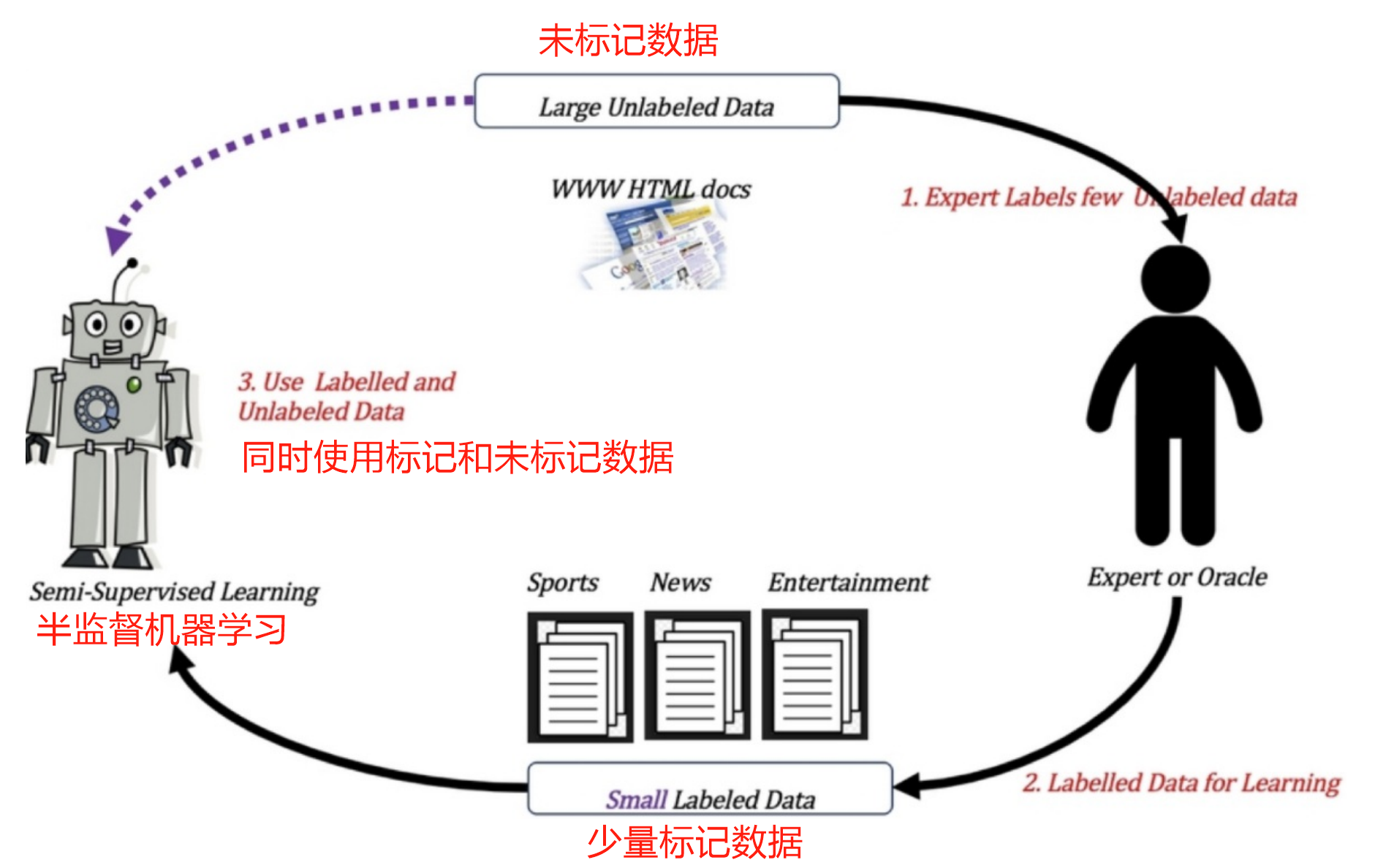

3 半监督学习

- 定义:

训练集同时包含有标记样本数据和未标记样本数据。

- 举例:

监督学习训练方式:

半监督学习训练方式:

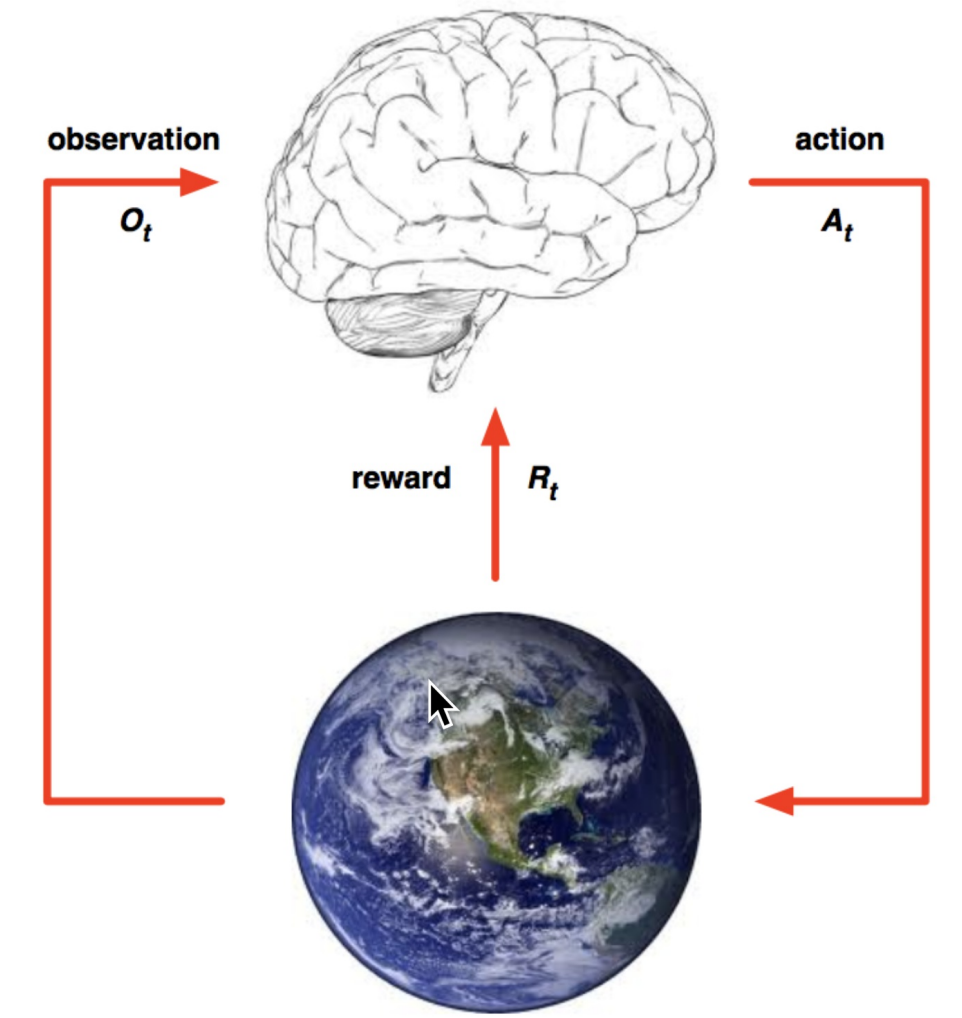

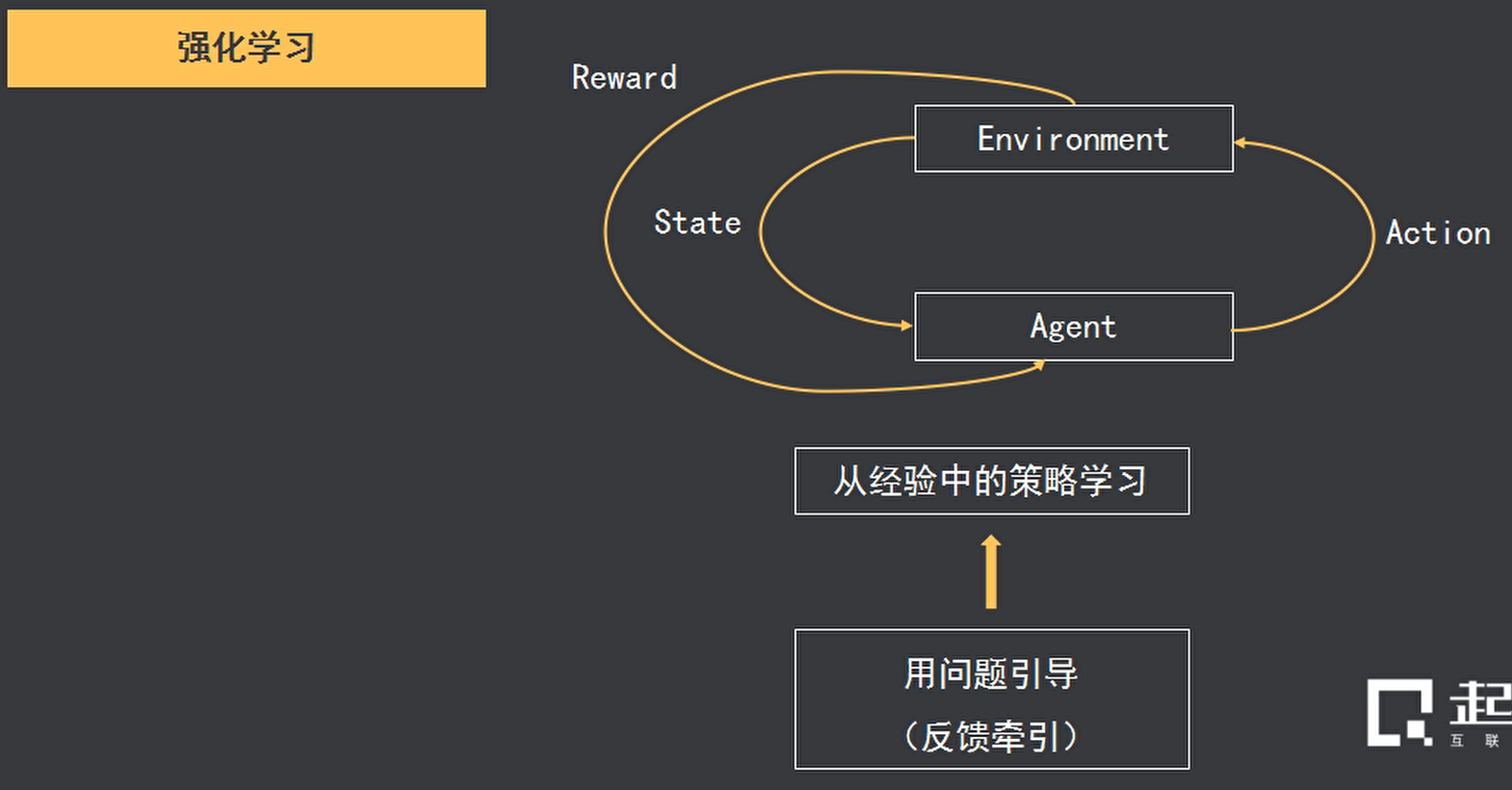

4 强化学习

- 定义:

实质是make decisions 问题,即自动进行决策,并且可以做连续决策。

- 举例:

小孩想要走路,但在这之前,他需要先站起来,站起来之后还要保持平衡,接下来还要先迈出一条腿,是左腿还是右腿,迈出一步后还要迈出下一步。

小孩就是 agent,他试图通过采取行动(即行走)来操纵环境(行走的表面),并且从一个状态转变到另一个状态(即他走的每一步),当他完成任务的子任务(即走了几步)时,孩子得到奖励(给巧克力吃),并且当他不能走路时,就不会给巧克力。

主要包含五个元素:agent, action, reward, environment, observation;

强化学习的目标就是获得最多的累计奖励。

监督学习和强化学习核心区别总结

| 维度 | 监督学习 | 强化学习 |

|---|---|---|

| 反馈类型 | 直接标签(正确答案) | 延迟奖励(行为评价) |

| 数据生成 | 静态数据集 | 动态交互环境 |

| 目标函数 | 最小化预测误差 | 最大化长期累积奖励 |

| 数据分布 | 独立同分布(i.i.d) | 时间相关、状态转移依赖 |

| 应用重点 | 精确匹配已知模式 | 在不确定环境中优化决策序列 |

示例说明

- 监督学习:训练一个垃圾邮件分类器时,每个邮件(输入)都有明确的“垃圾/正常”标签,模型直接学习两者映射。

- 强化学习:训练一个走迷宫的机器人,机器人通过尝试不同路径(动作)获得奖励(如到达终点+1,撞墙-1),最终学会最优路径策略。

通过理解两者的差异,可以更精准地选择适合任务的学习方法。监督学习适合有明确标注数据的场景,而强化学习更适合需要通过试错探索的动态决策问题。

独立同分布IID(independent and identically distributed)

1.独立同分布(i.i.d.)

在概率统计理论中,如果变量序列或者其他随机变量有相同的概率分布,并且互相独立,那么这些随机变量是独立同分布。

在西瓜书中解释是:输入空间中的所有样本服从一个隐含未知的分布,训练数据所有样本都是独立地从这个分布上采样而得。

2.简单解释 — 独立、同分布、独立同分布

(1)独立:每次抽样之间没有关系,不会相互影响

举例:给一个骰子,每次抛骰子抛到几就是几,这是独立;如果我要抛骰子两次之和大于8,那么第一次和第二次抛就不独立,因为第二次抛的结果和第一次相关。

(2)同分布:每次抽样,样本服从同一个分布

举例:给一个骰子,每次抛骰子得到任意点数的概率都是六分之一,这个就是同分布

(3)独立同分布:i.i.d.,每次抽样之间独立而且同分布

3.机器学习领域的重要假设

IID独立同分布即假设训练数据和测试数据是满足相同分布的,它是通过训练数据获得的模型能够在测试集获得好的效果的一个基本保障。

4.目前发展

机器学习并不总要求独立同分布,在不少问题中要求样本数据采样自同一个分布是因为希望用训练数据集得到的模型可以合理的用于测试数据集,使用独立同分布假设能够解释得通。

目前一些机器学习内容已经不再囿于独立同分布假设下,一些问题会假设样本没有同分布。

5 小结

|

In

|

Out

|

目的

|

案例 | |

|

监督学习

(supervised learning)

|

有标签

|

有反馈

|

预测结果

|

猫狗分类 房价预测 |

|

无监督学习

(unsupervised learning)

|

无标签

|

无反馈

|

发现潜在结构

|

“物以类聚,人以群分” |

|

半监督学习

(Semi-Supervised Learning)

|

部分有标签,部分无标签

有反馈

|

降低数据标记的难度 | ||

|

强化学习

(reinforcement learning)

|

决策流程及激励系统

|

一系列行动

|

长期利益最大化

|

学下棋

|

1.6 模型评估

模型评估是模型开发过程不可或缺的一部分。它有助于发现表达数据的最佳模型和所选模型将来工作的性能如何。

按照数据集的目标值不同,可以把模型评估分为分类模型评估和回归模型评估。

1 分类模型评估

- 准确率

-

- 预测正确的数占样本总数的比例。

其他评价指标:精确率、召回率、F1-score、AUC指标等

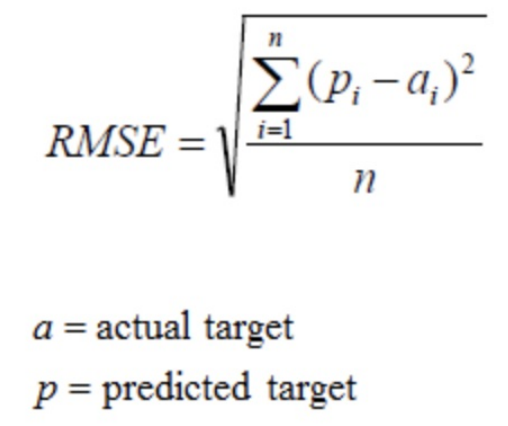

2 回归模型评估

均方根误差(Root Mean Squared Error,RMSE)

RMSE是一个衡量回归模型误差率的常用公式。 不过,它仅能比较误差是相同单位的模型。

- 举例:

假设上面的房价预测,只有五个样本,对应的 真实值为:100,120,125,230,400 预测值为:105,119,120,230,410

那么使用均方根误差求解得:

其他评价指标:相对平方误差(Relative Squared Error,RSE)、平均绝对误差(Mean Absolute Error,MAE)、相对绝对误差(Relative Absolute Error,RAE)

3 拟合

模型评估用于评价训练好的的模型的表现效果,其表现效果大致可以分为两类:过拟合、欠拟合。

在训练过程中,你可能会遇到如下问题:

训练数据训练的很好啊,误差也不大,为什么在测试集上面有问题呢?

当算法在某个数据集当中出现这种情况,可能就出现了拟合问题。

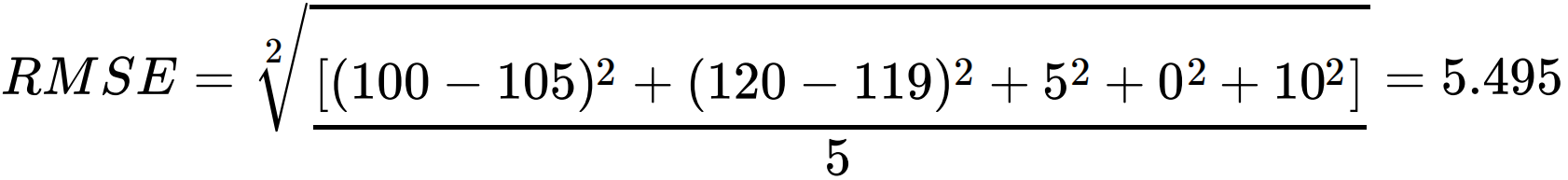

3.1 欠拟合

欠拟合(under-fitting):模型学习的太过粗糙,连训练集中的样本数据特征关系都没有学出来。

因为机器学习到的天鹅特征太少了,导致区分标准太粗糙,不能准确识别出天鹅。

3.2 过拟合

过拟合(over-fitting):所建的机器学习模型或者是深度学习模型在训练样本中表现得过于优越,导致在测试数据集中表现不佳。

训练数据训练的很好啊,误差也不大,为什么在测试集上面有问题呢?

上问题解答:

机器已经基本能区别天鹅和其他动物了。然后,很不巧已有的天鹅图片全是白天鹅的,于是机器经过学习后,会认为天鹅的羽毛都是白的,以后看到羽毛是黑的天鹅就会认为那不是天鹅。

4 小结

- 分类模型评估【了解】

-

- 准确率

- 回归模型评估【了解】

-

- RMSE -- 均方根误差

- 拟合【知道】

-

- 举例 -- 判断是否是人

-

- 欠拟合

-

-

- 学习到的东西太少

- 模型学习的太过粗糙

-

-

- 过拟合

-

-

- 学习到的东西太多

- 学习到的特征多,不好泛化

-

总结

假设,我们要通过机器学习预测未来几天内是否下雨,那我们需要筛选出过去一段时间内比较重要的天气特征数据,比如过去的平均气温、湿度、降水量等等,然后通过机器学习算法从这些历史数据中发现规律。这个所谓的规律就是算法工程师常说的模型,而发现这个规律的过程就是训练模型的过程。最终通过这个模型加上相应的气温、湿度等特征数据,我们就可以计算出未来几天内下雨的一个概率。

其中,我们使用的过去的数据就是我们说的样本,而气温、湿度这些属性就是特征,过去某一天是否下雨就是我们建模时用到的标签(结果数据)。

如果在建模过程中,我们能够获得这些标签并使用它们训练模型,就叫做有监督学习(Supervised Learning)。如果没有标签,就叫做无监督学习(UnsupervisedLearning)。像上面这种预测是否下雨,预测结果是“是 / 否”这样的问题,就是分类问题,如果是预测具体温度是多少,预测的结果是一个连续值的,就是回归问题。

如果你倾向于去做机器学习平台的产品经理,就去重点学习模型建模的过程,甚至要自己尝试去使用一些公共的机器学习平台,去创建一个算法模型。比如阿里云的 PAI、百度的EasyDL,它们都是很优秀的建模平台。

浙公网安备 33010602011771号

浙公网安备 33010602011771号