命名实体识别(NER)

前言

在自然语言处理(Natural Language Processing, NLP)的广阔领域中,命名实体识别(Named Entity Recognition, NER)是一项关键技术。它致力于从非结构化文本中识别和分类实体,例如人物、组织、地名、时间等。无论是在信息检索、语音助手还是机器翻译中,NER 都扮演着不可或缺的角色。

NER 的重要性不仅在于其能够提升 NLP 系统的精度,还在于它为其他下游任务提供了坚实的基础。本文将全面介绍命名实体识别的基本概念、应用场景、技术方法以及未来发展趋势,旨在为读者提供系统而清晰的理解。

1. 什么是命名实体识别?

1.1 概念解析

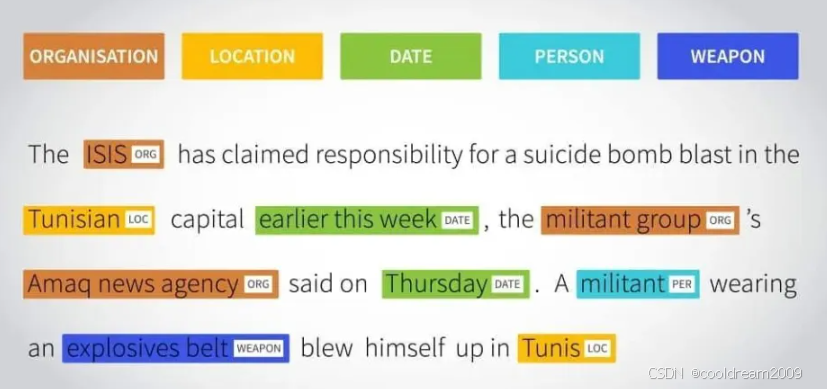

命名实体识别是自然语言处理中的一项基础任务。具体来说,它的目标是从文本中找到特定的实体(如"北京"或"2025年1月1日"),并将这些实体分类到预定义的类别中(如地名或时间)。

NER 的定义可以分为两个关键步骤:

实体边界检测:识别文本中哪些部分属于实体,例如句子中的"苹果公司"。

实体类别分类:将识别到的实体归类到特定类别,如组织、地点或时间。

NER 的概念看似简单,但其实现涉及到复杂的语义分析、上下文理解以及多层次的特征提取,这为其研究和应用带来了挑战。

1.2 NER 的重要性

NER 是许多 NLP 应用的基础模块,其结果通常被用于更高级的任务。例如:

在搜索引擎中,NER 可用于理解用户的搜索意图,确保搜索结果更加精准。

在语音助手中,NER 可解析用户提问中的核心信息,例如时间、地点和任务对象。

在知识图谱构建中,NER 是从海量文本中提取结构化知识的关键步骤。

此外,NER 在信息安全、推荐系统、舆情分析等领域也有着广泛的应用价值。

2. NER 的应用场景

2.1 信息抽取

信息抽取旨在从非结构化文本中提取有用的信息,而 NER 是其核心组件。例如,在新闻、金融分析和学术研究中,NER 可以帮助快速识别事件中的重要信息,例如时间、地点、人物和事件类型。

例如: “2025年1月1日,苹果公司在旧金山发布了新产品。”

时间:2025年1月1日

组织:苹果公司

地点:旧金山

通过这种方式,信息抽取能够将分散在文本中的关键信息汇总并结构化,从而为决策提供支持。

2.2 对话系统

现代对话系统需要深刻理解用户输入以生成准确的响应,而命名实体识别是实现这一目标的核心。例如,当用户询问语音助手"明天北京的天气如何"时,系统需要识别出"明天"作为时间实体和"北京"作为地名实体,然后调用相关的天气 API 返回结果。

此外,在客户服务和医疗问答等场景中,NER 可以帮助系统快速定位用户问题的核心。

2.3 搜索引擎优化

在搜索引擎中,命名实体识别技术被广泛用于提高搜索结果的相关性。当用户搜索"2023年热门电影"时,搜索引擎可以利用 NER 提取关键词"2023年"和"电影",然后筛选符合条件的内容。

这种技术也可以支持垂直搜索,例如法律文档、学术论文的检索,通过实体识别快速定位目标内容。

3. NER 的技术方法

3.1 基于规则的方法

早期的 NER 系统主要依赖规则和词典。规则方法通过预定义的正则表达式或模式来识别特定类型的实体。例如:

正则表达式可以用来捕捉日期格式(如"YYYY-MM-DD")。

利用地名库或人名库进行匹配。

这种方法实现简单,特别适用于特定领域(如医学或法律)且词汇固定的场景。然而,其缺点在于泛化能力较差,无法适应开放领域中多样化的实体表达。

3.2 基于机器学习的方法

随着统计学习的兴起,NER 开始采用机器学习技术。常见的算法包括:

隐马尔可夫模型(HMM):基于状态转移概率和观察概率对序列进行标注。

条件随机场(CRF):通过建模上下文关系,能够有效处理实体边界的识别。

机器学习方法的优势在于可以通过学习数据中的模式提高性能。然而,其效果依赖于特征工程,即手动设计和选择文本的特征(如词性、词向量等)。

3.3 基于深度学习的方法

近年来,深度学习方法成为 NER 的主流技术。通过自动化特征提取和上下文建模,深度学习模型能够取得显著的性能提升。

主要模型包括:

循环神经网络(RNN)及其变体 LSTM 和 GRU:擅长捕捉序列数据的上下文依赖关系。

BERT 等预训练语言模型:通过大规模语料库训练,能够捕获深层语义和上下文信息。

例如,基于 BERT 的 NER 模型已经在多个数据集上实现了超越传统方法的性能,其在处理复杂句法结构和歧义时表现尤为出色。

4. NER 的挑战与解决方案

4.1 多语言和跨语言问题

不同语言的语法、词汇和书写系统差异巨大,使得单一模型难以适用于多种语言。为解决这一问题,研究者提出了以下方法:

构建多语言语料库,提供多语言支持。

使用跨语言预训练模型(如 XLM-R),在多语言任务中取得良好表现。

4.2 实体类别多样性

开放领域中的实体类别繁多,例如社交媒体上的新兴词汇和网络流行语。这对传统 NER 系统提出了挑战。解决方案包括:

动态扩展实体类别,以适应新领域需求。

结合少样本学习技术,通过少量数据学习新类别。

4.3 数据标注成本

高质量的标注数据获取成本高昂,尤其是涉及多领域或多语言任务时。为此,可以采取以下策略:

半监督学习或无监督学习:利用未标注数据提升模型性能。

数据增强技术:通过数据合成或生成方法扩展标注语料。

5. NER 的未来发展方向

5.1 更强大的预训练模型

随着语言模型的快速发展,未来的 NER 系统将更加依赖高效的预训练模型。这些模型不仅能够捕捉深层语义,还可以结合多模态信息(如图像和文本),进一步提升性能。

5.2 实时与大规模应用

在大规模实时系统中,NER 面临计算资源和响应速度的挑战。未来的研究方向包括:

更轻量化的模型设计,例如知识蒸馏技术。

分布式计算和云服务的进一步优化,实现高效处理。

5.3 更高的鲁棒性

未来的 NER 系统需要具备更强的鲁棒性,能够应对领域变化、语言差异和数据分布的不均衡。例如,通过元学习技术提升模型在不同任务间的迁移能力。

鲁棒性(Robustness)是指系统在面临内部结构或外部环境变化时,保持其性能和功能稳定的能力。具体来说,鲁棒性强的系统能够在各种干扰、噪声、故障等不利因素的影响下,仍然能够正常运行,并且保持较好的性能表现。

结语

命名实体识别作为自然语言处理的重要组成部分,在技术和应用上都展现了巨大的潜力。从规则方法到深度学习的演进,NER 已经成为驱动诸多智能应用的核心技术之一。尽管挑战依然存在,但随着技术的不断突破,我们有理由相信,NER 将在未来发挥更大的价值,推动 NLP 的进一步发展。

浙公网安备 33010602011771号

浙公网安备 33010602011771号