机器学习第二次作业

第一章

1.2模式识别数学表达

输入空间&输出空间

模型的概念

用于回归

用于分类

判别函数

判别公式&决策边界:用于分类

特征&特征空间

1.3特征向量的相关性

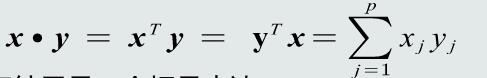

特征向量点积:代数定义

特征向量点积:几何定义

特征向量投影

点积与投影

残差向量

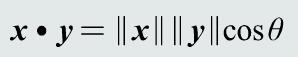

特征向量的欧氏距离

1.4机器学习基本概念

训练样本

模型的参数和结构

线性模型

非线性模型

样本量与模型参数量比较

目标函数

优化算法

机器学习的方式

输出真值

监督式学习

无监督式学习

半监督式学习

强化学习

1.5模型的泛化能力

训练集&测试集

训练误差&测试误差

模型的泛华能力

过拟合

提高泛化能力

选择复杂度适合的模型

调节超参数

正则化

多项式拟合&超参数

1.6评估方法与性能指标

评估方法

留出法

K折交叉验证

留一验证

性能指标度量

F-Score

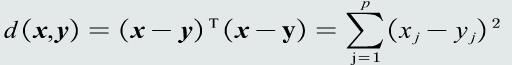

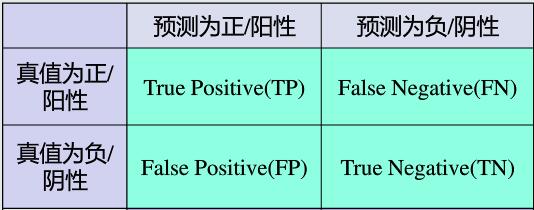

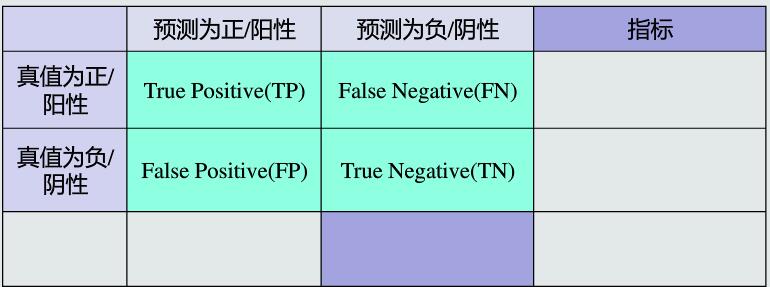

混淆矩阵

曲线度量

PR曲线

ROC曲线

AUC

第二章

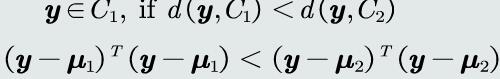

2.1MED分类器

基于距离分类的基本概念

判别公式

决策边界

2.2特征白化

特征正交白化

特征解耦任务

特征向量与特征值

特征解耦

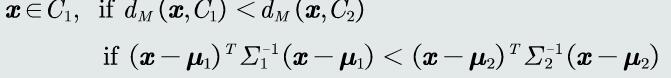

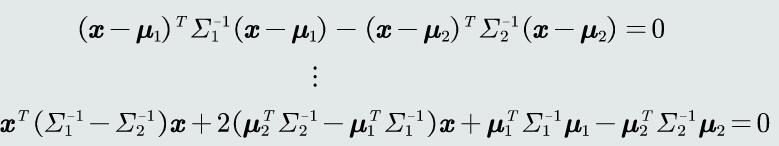

2.3MICD分类器

判别公式

马氏距离的属性

决策边界

第三章

3.1 贝叶斯决策与MAP分类器

后验概率:用于分类决策

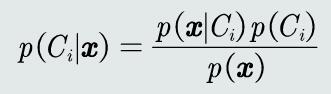

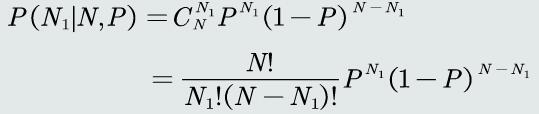

贝叶斯规则

观测概率&后验概率

MAP分类器

判别公式

决策边界

3.2MAP分类器:高斯观测概率

先验和观测概率的表达方式

观测概率:单维高斯分布

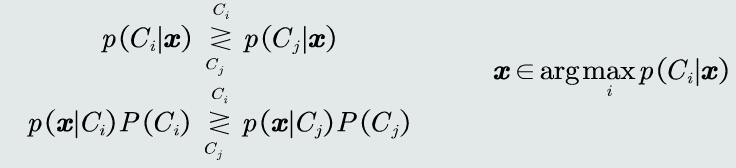

高斯观测概率:决策边界

观测概率:高维高斯分布

判别函数

3.3 决策风险与贝叶斯分类器

决策风险概念

损失概念

损失的评估

决策风险的评估

贝叶斯分类器

决策损失

决策目标

朴素贝叶斯分类器

3.4 最大似然估计

监督式学习方法

参数估计方法

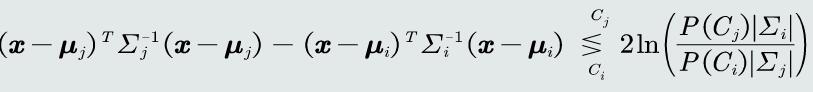

最大似然估计

先验概率估计

观测概率估计:高斯分布

高斯分布参数估计

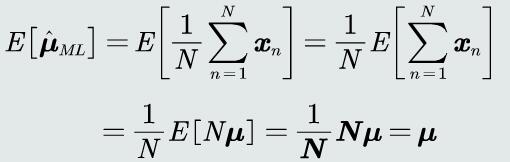

均值估计

协方差估计

3.5 最大似然的估计偏差

无偏估计

高斯均值

高斯协方差

高斯协方差估计偏值

协方差估计的修正

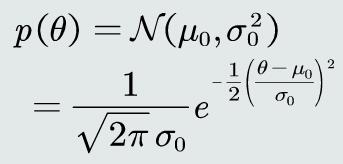

3.6 贝叶斯估计(1)

贝叶斯估计概念

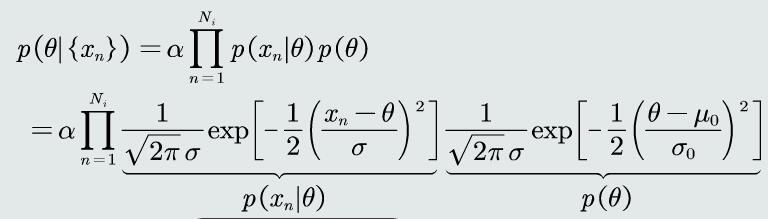

贝叶斯估计:高斯观测似然

参数先验概率

参数后验概率

3.7 贝叶斯估计(2)

贝叶斯估计也最大似然估计对比

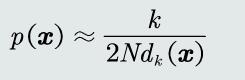

3.8 KNN估计

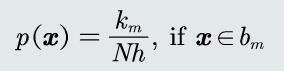

概率估计密度基本理论

KNN估计

KNN的优缺点

3.9 直方图与核密度估计

直方图估计:原理

直方图估计:优缺点

直方图双线性插值

直方图估计:带宽选择

核密度估计

原理

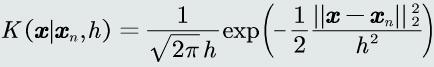

核密度估计:核函数

核密度估计:优缺点

核密度估计:带宽选择

直方图与核密度估计

第四章

4.1 线性判据基本概念

生成模型

优缺点

判别模型

线性判据定义

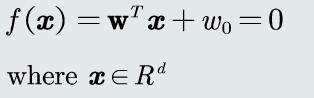

线性判据数学表达

线性判据:决策边界

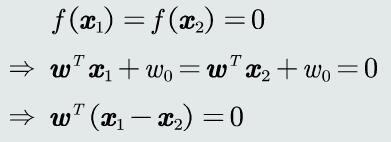

线性判据:w的方向

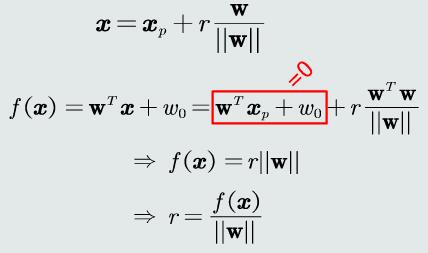

任意样本到决策边界的距离

决策边界到坐标原点的距离

4.2 线性判据学习概述

参数空间&解域

解域:

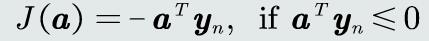

目标函数

加入约束条件

4.3 并行感知机算法

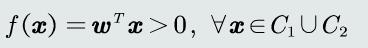

感知机算法:预处理

感知机:解域

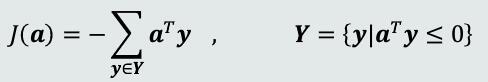

并行感知机:目标函数

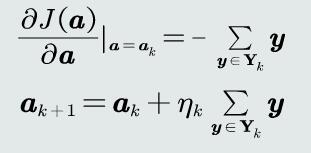

梯度下降法

并行感知机:参数更新

并行感知机:算法流程

4.4 串行感知机算法

串行感知机

目标函数

算法流程

参数更新过程

感知机:收敛性

全局最优与局部最优

感知机:步长与收敛性

提升感知机泛化能力

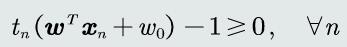

加入margin约束

4.5 fisher线性判据

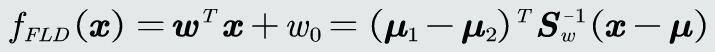

fisher线性判据

目标函数

最优参数解

决策边界

4.6 支持向量机基本概念

支持向量机:设计动机

支持向量机:设计思想

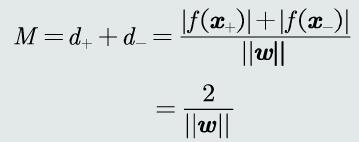

间隔的数学定义

支持向量的概念

分类器重新表达

分类器表达:支持向量

间隔计算

支持向量机:目标函数

目标函数:分析

4.7 拉格朗日乘数法

拉格朗日乘数法:等式约束

等式约束:拉格朗日函数

等式约束:等价优化问题

拉格朗日乘数法:不等式约束

不等式约束:对偶可行性

不等式约束:KKT条件

拉格朗日乘数法:多个约束

4.8 拉格朗日对偶问题

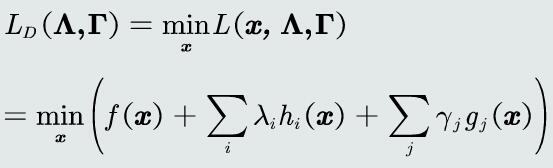

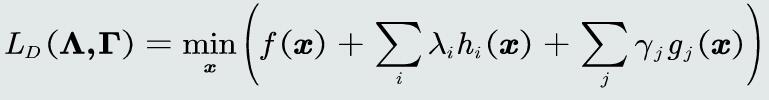

拉格朗日对偶函数

对偶问题

对偶函数的凹凸性

浙公网安备 33010602011771号

浙公网安备 33010602011771号