kafka

https://kafka.apache.org/intro

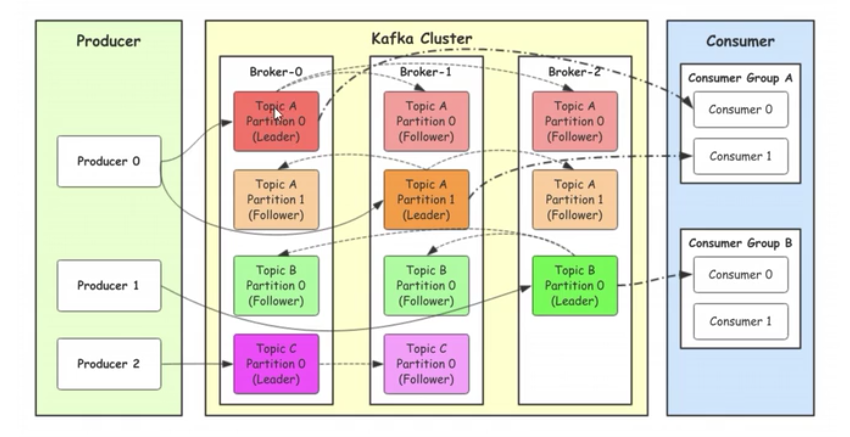

broker 节点

topic

partition

leader

follower

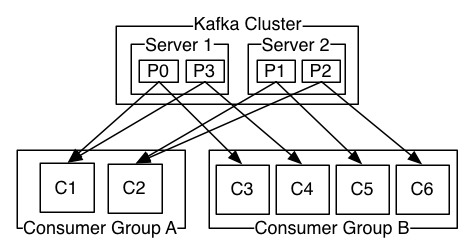

consumer group

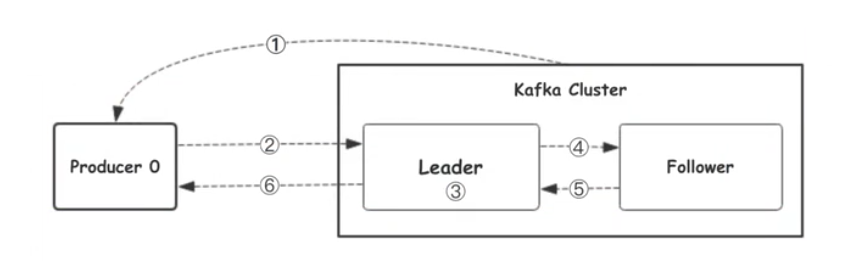

1、生产者从kafka集群获取分区leader信息 2、生产者将消息发送给leader 3、leader将消息写入本地磁盘 4、follower从leader拉取消息数据 5、follower将消息写入本地磁盘后向leader发送ACK 6、leader收到所有follower的ACK之后向生产者发送ACK

生产者往kafka发送数据的模式

0 把数据发送给leader就不管了,效率最高,安全性最低

1 把数据发送给leader,等待leader回ACK

all 把数据发送给leader,确保follower从leader拉取数据回复ACK给leader,leader再回复ACK,安全性最高

Kafka选择分区的模式(3种)

1、指定往哪个分区写

2、指定key,kfaka根据key做hash然后决定写哪个分区

3、轮询方式

Partition结构

Partition在服务器上的表现形式就是一个一个的文件夹,每个partition的文件夹下面有多组segment文件,每组segment文件又包含

.index文件、.log文件、.timeindex文件三个文件,

其中.log文件就是实际存储message的地方,而.index和.timeindex文件为索引文件,用于检索消息.

Kafka 使用Zookeeper 来保存相关配置信息,Kafka及Zookeeper 依赖Java 运行环境,从oracle网站下载JDK 安装包,也可以直接yum

yum install java-sdk wget http://mirror.bit.edu.cn/apache/kafka/2.4.0/kafka_2.12-2.4.0.tgz tar zxvf kafka_2.12-2.4.0.tgz mv kafka_2.12-2.4.0 kafka cd kafka

# 启动zookeeper

bin/zookeeper-server-start.sh ./config/zookeeper.properties

# 启动kafka

bin/kafka-server-start.sh ./config/server.properties

# kafka终端

bin/kafka-console-consumer.sh --bootstrap-server=127.0.0.1:9092 --topic=x --from-begining

zookeeper是一个分布式的,开放源码的分布式应用程序协调服务,是Google的

Chubby一个开源的实现,它是集群的管理者,监视者集群中各个节点的状态根据节点提交的反馈进行下一步合理操作。

最终,将简单易用的接口和性能高效、性能稳定的系统提供给用户

被etcd替换

功能验证

1.启动Zookeeper

使用安装包中的脚本启动单节点Zookeeper 实例:

bin/zookeeper-server-start.sh -daemon config/zookeeper.properties

[2015-10-26 04:26:59,585] INFO Reading configuration from: config/zookeeper.properties (org.apache.zookeeper.server.quorum.QuorumPeerConfig)....

2.启动Kafka 服务

使用kafka-server-start.sh 启动kafka 服务:

bin/kafka-server-start.sh config/server.properties

[2015-10-26 04:28:56,115] INFO Verifying properties (kafka.utils.VerifiableProperties)

[2015-10-26 04:28:56,141] INFO Property broker.id is overridden to 0 (kafka.utils.VerifiableProperties)

3.创建topic

使用kafka-topics.sh 创建单分区单副本的topic test:

bin/kafka-topics.sh --create --zookeeper localhost:2181 --replication-factor 1 --partitions 1 --topic test

查看topic:

bin/kafka-topics.sh --list --zookeeper localhost:2181

test

4.产生消息

使用kafka-console-producer.sh 发送消息:

bin/kafka-console-producer.sh --broker-list localhost:9092 --topic test

Hello world!

Hello Kafka!

5.消费消息

使用kafka-console-consumer.sh 接收消息并在终端打印:

bin/kafka-console-consumer.sh --zookeeper localhost:2181 --topic test --from-beginning

Hello world!

Hello Kafka!

集群配置

单机多broker 集群配置

利用单节点部署多个broker。 不同的broker 设置不同的 id,监听端口及日志目录。 例如:

cp config/server.properties config/server-1.properties

编辑配置:

config/server-1.properties:

broker.id=1

port=9093

log.dir=/tmp/kafka-logs-1

启动Kafka服务:

bin/kafka-server-start.sh config/server-1.properties &

启动多个服务,按上文类似方式产生和消费消息。

多机多broker 集群配置

分别在多个节点按上述方式安装Kafka,配置启动多个Zookeeper 实例。 例如: 在10.4.253.22,10.4.253.23,10.4.253.24三台机器部署,Zookeeper配置如下:

initLimit=5

syncLimit=2

server.1=10.4.253.22:2888:3888

server.2=10.4.253.23:2888:3888

server.3=10.4.253.24:2888:3888

分别配置多个机器上的Kafka服务 设置不同的broke id,zookeeper.connect设置如下:

zookeeper.connect=10.4.253.22:2181,10.4.253.23:2181,10.4.253.24:2181

启动Zookeeper与Kafka服务,按上文方式产生和消费消息,验证集群功能。

问题:Kafka单机,broker内网地址192.168.1.100:9092,映射到外网XXXXXX:4006,springBoot install和运行失败,

总是报连接broker超时 1)放开advertised.listeners注释,配置为hostname:外网端口,注意:这里映射到外网的端口必须和内网保持一致,

否则kafka启动时会报错,如这里kafka broker内网端口是9092,则映射到外网的端口也是9092

2)服务器的/etc/hosts 配置

127.0.0.1 hostname

3)你自己本地电脑调试时,C:\Windows\System32\drivers\etc\hosts文件配置

XXXXXX(broker外网地址) hostname

2)服务器的/etc/hosts 配置 127.0.0.1 hostname 3)你自己本地电脑调试时,C:\Windows\System32\drivers\etc\hosts文件配置 XXXXXX(broker外网地址) hostname

浙公网安备 33010602011771号

浙公网安备 33010602011771号