预热篇2:从RNN到Transformmer

下面是整理的一个思维导图

2010年Mikolov提出了RNN网络,RNN网络存在长距离依赖(梯度消失),计算效率(RNN 难以并行)两个问题

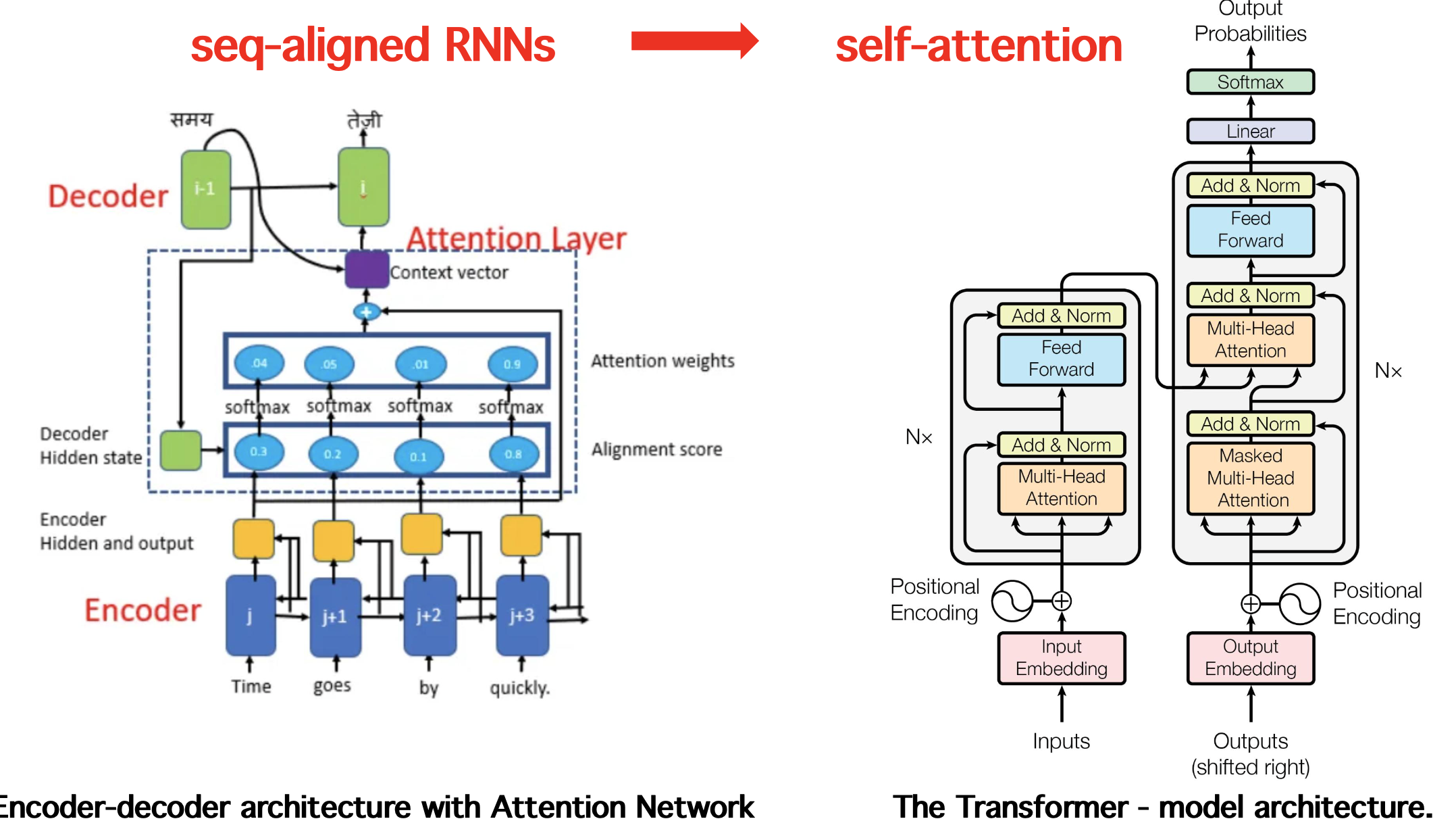

2017年Transformmer网络结构问世,Transformer 网络架构架构由 Ashish Vaswani 等人在 Attention Is All You Need一文中提出,并用于机器翻译任务,和以往网络架构有所区别的是,该网络架构中,编码器和解码器没有采用 RNN 或 CNN 等网络架构,而是采用完全依赖于注意力机制的架构。网络架构如下所示:

Transformmer网络结构解决了传统编码器-解码器模型的挑战,避免信息损失和无法建模输入输出对齐的问题,自动学习注意力权重,捕捉编码器和解码器之间的相关性。在自然语言处理(NLP)、计算机视觉(Computer Vision)、跨模态任务和推荐系统等多个领域中,注意力机制已成为多项任务中的最 先进模型,取得了显著的性能提升。需要关注思维导图中多头注意力机制部分

浙公网安备 33010602011771号

浙公网安备 33010602011771号