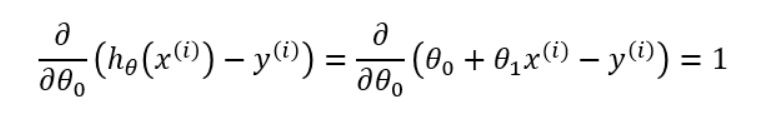

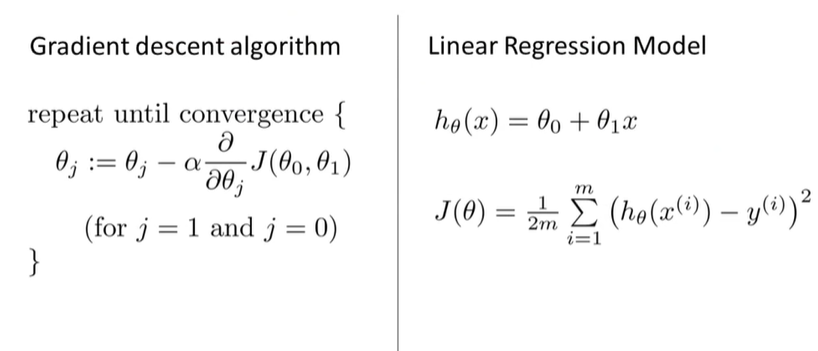

Gradient Descent Derivation

线性回归 梯度下降公式推导步骤:

J(θ)是损失函数。下降的过程需要,同时更新θi 和θj 的值,也就是减去各自方向的偏导数。

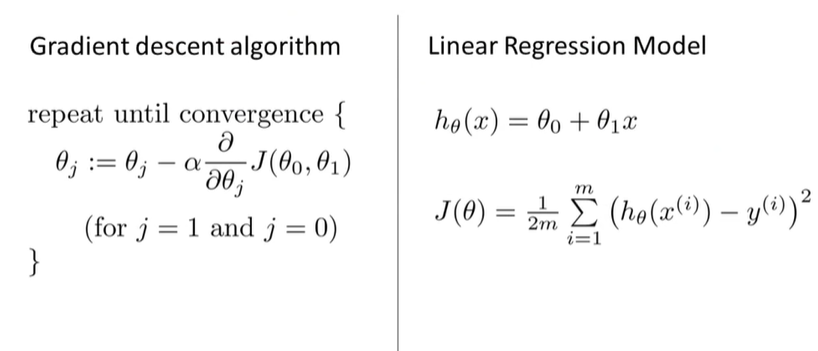

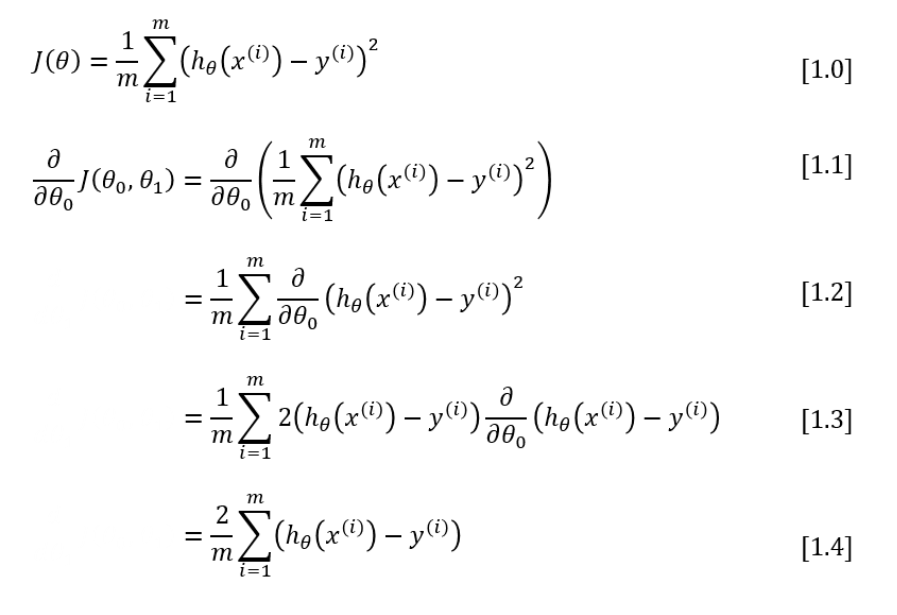

损失函数求偏导数推导过程:

[1.1]->[1.2]

[1.2]->[1.3]

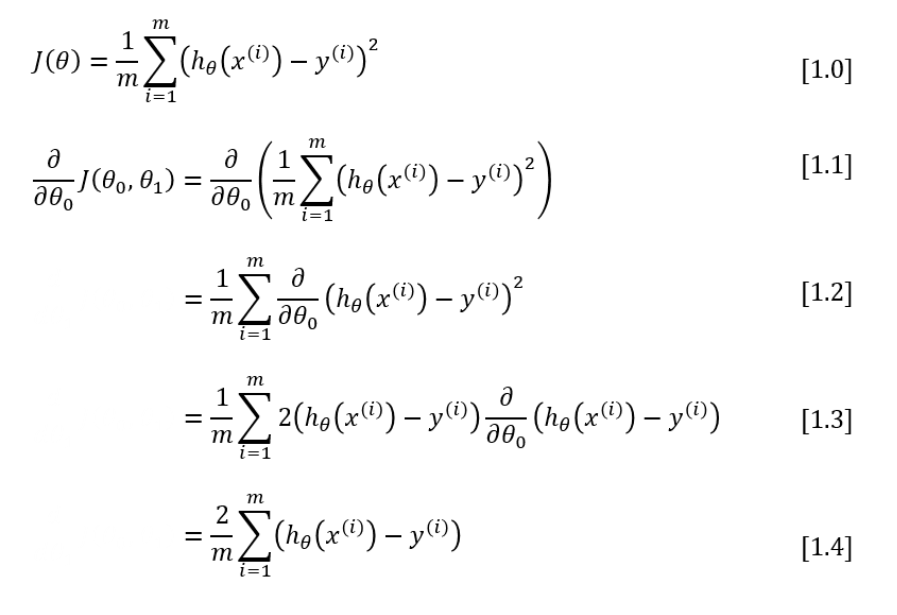

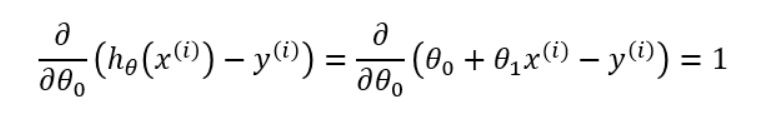

[1.3]->[1.4]

引文θ1方向 中间偏导求的结果X没带上角标

https://mccormickml.com/2014/03/04/gradient-descent-derivation/

线性回归 梯度下降公式推导步骤:

J(θ)是损失函数。下降的过程需要,同时更新θi 和θj 的值,也就是减去各自方向的偏导数。

损失函数求偏导数推导过程:

[1.1]->[1.2]

[1.2]->[1.3]

[1.3]->[1.4]