Databricks 第10篇:Job

大家知道,用户可以在Notebook UI中以交互方式运行Notebook中的SQL、Python等代码,交互方式便于数据的调查和分析。用户还可以通过Job来自动维护数据,Job是立即运行或按计划运行notebook(或JAR)的一种方法,通过Job可以定时执行数据的清理和整合,用户只需要设置好计划(schedule),就可以自动实现数据的维护。

用户也可以通过Databricks UI来监控Job的运行结果,或者发送email alert,一旦Job运行失败或成功,用户会收到包含Job运行结果的邮件。

Databricks限制一个工作区:

- 最多只能同时运行1000个Job,并发度是1000;

- 在一个小时内,最多可以创建5000个Job(包括“立即运行”和“运行提交”)

一,使用UI来创建Job

点击“Jobs”图标 ,进入到Jobs页面,点击下面的“Create Job”按钮来创建Job:

,进入到Jobs页面,点击下面的“Create Job”按钮来创建Job:

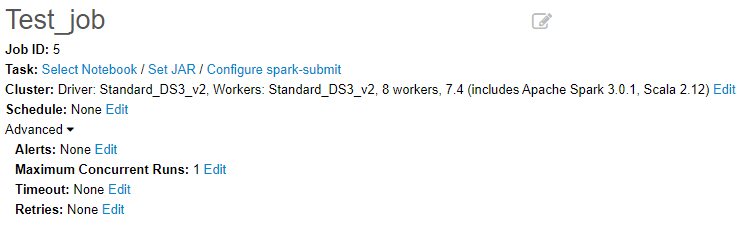

输入Job的Title,并选择Job执行的Task。

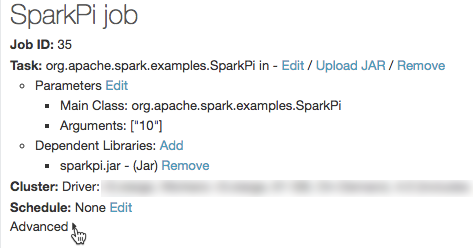

设置Job的属性:

- 设置Task,可以选择 Notebook、 Set JAR、Configure spark-submit,通常选择Notebook。

- 设置Cluster:设置Job运行时使用的Cluster

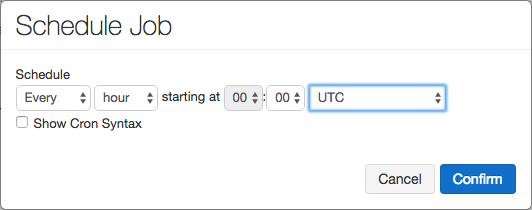

- 设置Schedule:设置计划定时执行Job

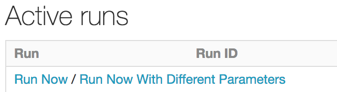

二,立即运行Job

若要立即运行作业,请在“Active runs”列表中单击“Run Now”:

三,查看Job运行结果

可以通过导出作业运行的结果来持久保存作业运行。 对于笔记本作业运行,可以先导出呈现的笔记本,稍后再将其导入到 Databricks 工作区中。

1,在作业详细信息页中,单击“运行”列中的作业运行名称。

2,单击“导出到 HTML”。

四,控制对Job的访问

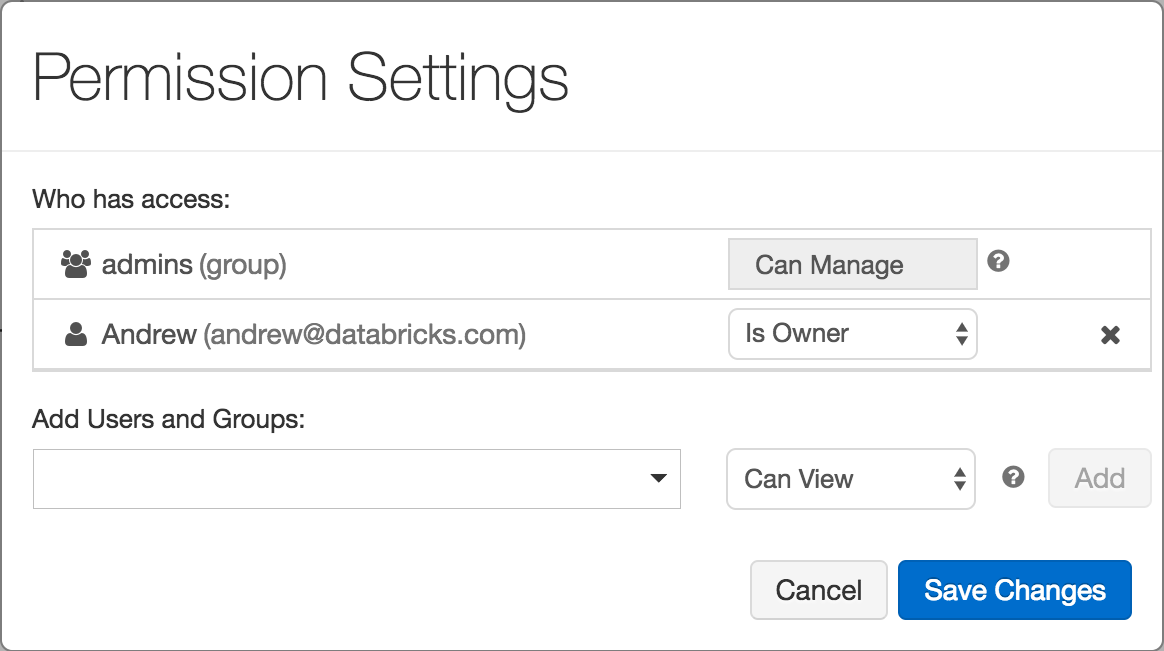

Job的所有者和管理员可以通过"Job Access Control"控制权限。使用作业访问控制,作业所有者可以选择允许哪些其他用户或组查看作业的结果。 所有者还可以选择允许谁管理其作业的运行(即,调用“立即运行”,然后单击“取消”)。

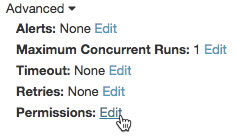

Step1,跳转到Job的详细信息页面,点击“Advanced”链接

Step2,点击Permissions后面的“Edit”链接

Step3,在弹出对话框中,通过用户名旁边的下拉菜单分配作业权限。

参考文档:

作者:悦光阴

本文版权归作者和博客园所有,欢迎转载,但未经作者同意,必须保留此段声明,且在文章页面醒目位置显示原文连接,否则保留追究法律责任的权利。

浙公网安备 33010602011771号

浙公网安备 33010602011771号