第八周总结

在开始学习hadoop之前,配置相关的vm环境。承接上周的linux的学习内容,下载三个虚拟机配置了hdfs集群,对主机名,ip,ssh免密登录,jdk部署,防火墙,selinux,时间同步配置。在配置hdfs集群的时候,麻烦较多,配置文件有差错,查找错误较费时间。

完成前序配置后,开始连接大数据的历史和概念,hadoop的三大组成,数据存储,计算,传送,并且先学习了HDFS的部分内容。

HDFS集群启停命令(9870)

start-dfs.sh

stop-dfs.sh

hadoop-daemon.sh (start/stop/status) (namenode/datanode/secondarynamenode)

hdfs --daemon (start/stop/status) (namenode/datanode/secondarynamenode)

HDFS基础操作

老版本hadoop fs [generic options]

旧版本hdfs dfs [generic options]

上传文件

-put -f(覆盖文件) -p(保留文件基本信息) linux文件位置 hdfs文件位置

下载文件

-get -f(覆盖文件) -p(保留文件基本信息) hdfs文件位置 linux文件位置

拷贝文件

-cp -f(覆盖) 文件路径 文件路径

追加数据

-appendToFile 文件路径 文件路径

删除文件

-rm -r -skipTrash(跳过回收站直接删除)删除路径

修改副本数和fsck命令

配置文件hdfs-set.xml

上传文件时设定Hadoop fs -D dfs.replication=2 -put txt.txt /

hdfs dfs -setrep -R 2 path

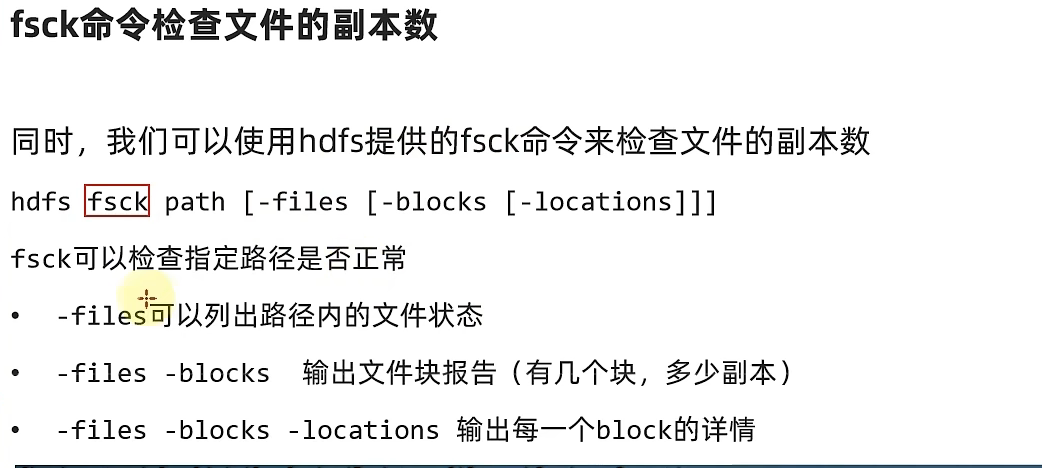

fsck命令查看副本数

yarn集群命令(8088)

start-yarn.sh

stop-yarn.sh

单操作:

yarn --daemon start/stop resourcemanager/nodemanager/proxyserver

mapred --daemon start/stop historyserver

yarn算法:

Hadoop jar 命令路径($HADOOP_HOME/share/hadoop/mapreduce/hadoop-mapreduce-examples-3.3.1.jar ) 算法名

浙公网安备 33010602011771号

浙公网安备 33010602011771号