Spark 2.x管理与开发-Spark Streaming-Spark Streaming基础(一)Spark Streaming简介+特点+内部结构

Posted on 2020-08-06 15:44 MissRong 阅读(138) 评论(0) 收藏 举报Spark 2.x管理与开发-Spark Streaming-Spark Streaming基础(一)

1、Spark Streaming简介

官网:http://spark.apache.org/streaming/

Spark Streaming makes it easy to build scalable fault-tolerant streaming applications.

易于构建灵活的、高容错的流式系统。

Spark Streaming是核心Spark API的扩展,可实现可扩展、高吞吐量、可容错的实时数据流处理。

数据可以从诸如Kafka,Flume,Kinesis或TCP套接字等众多来源获取,并且可以使用由高级函数(如map,reduce,join和window)开发的复杂算法进行流数据处理。最后,处理后的数据可以被推送到文件系统,数据库和实时仪表板。

而且,您还可以在数据流上应用Spark提供的机器学习和图处理算法。

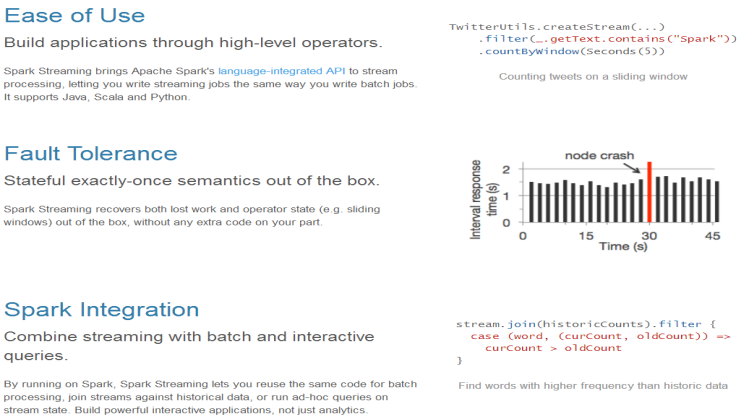

2、Spark Streaming的特点

- 易用:集成在Spark中

- 容错性:底层也是RDD,RDD本身就具备容错机制

- 支持多种语言:java、Scala、Python

3、Spark Streaming的内部结构

在内部,它的工作原理如下。

Spark Streaming接收实时输入数据流,并将数据切分成批,然后由Spark引擎对其进行处理,最后生成“批”形式的结果流。

Spark Streaming将连续的数据流抽象为discretizedstream或DStream。

在内部,DStream 由一个RDD序列表示。

浙公网安备 33010602011771号

浙公网安备 33010602011771号