Spark 2.x管理与开发-Spark SQL-使用数据源(三)JSON Datasets

Posted on 2020-07-26 09:40 MissRong 阅读(120) 评论(0) 收藏 举报Spark 2.x管理与开发-Spark SQL-使用数据源(三)JSON Datasets

Spark SQL能自动解析JSON数据集的Schema,读取JSON数据集为DataFrame格式。

读取JSON数据集方法为SQLContext.read().json()。该方法将String格式的RDD或JSON文件转换为DataFrame。

需要注意的是,这里的JSON文件不是常规的JSON格式。

JSON文件每一行必须包含一个独立的、自满足有效的JSON对象。

如果用多行描述一个JSON对象,会导致读取出错。

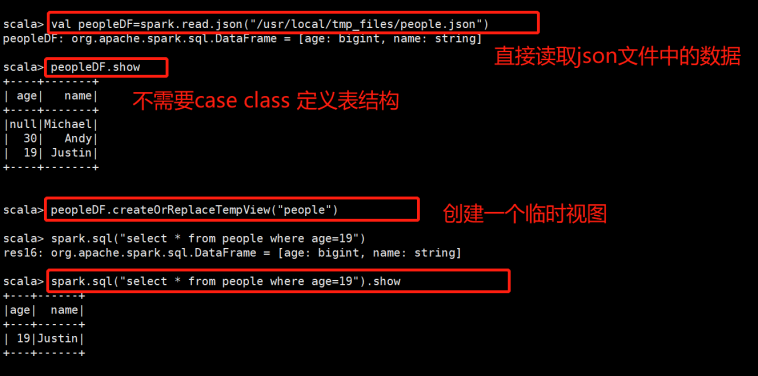

读取JSON数据集示例如下:

Demo1:使用Spark自带的示例文件 --> people.json 文件

定义路径:

val path ="/root/resources/people.json"

读取Json文件,生成DataFrame:

val peopleDF = spark.read.json(path)

打印Schema结构信息:

peopleDF.printSchema()

创建临时视图:

peopleDF.createOrReplaceTempView("people")

执行查询

spark.sql("SELECT name FROM people WHERE age=19").show

**********自己定义*********

Spark SQL支持统一的访问接口:对于不同的数据源,进入到Spark使其转换成DataFrame类型的数据进行操作即可。

浙公网安备 33010602011771号

浙公网安备 33010602011771号