Spark 2.x管理与开发-Spark的体系结构

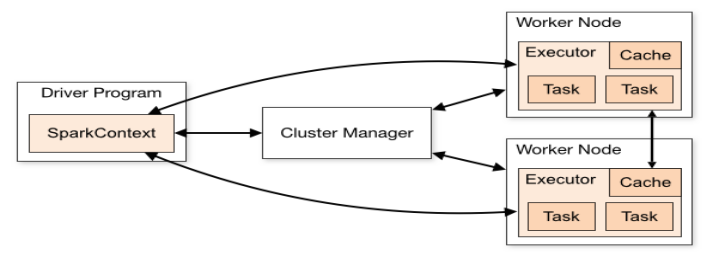

官方的一张图:

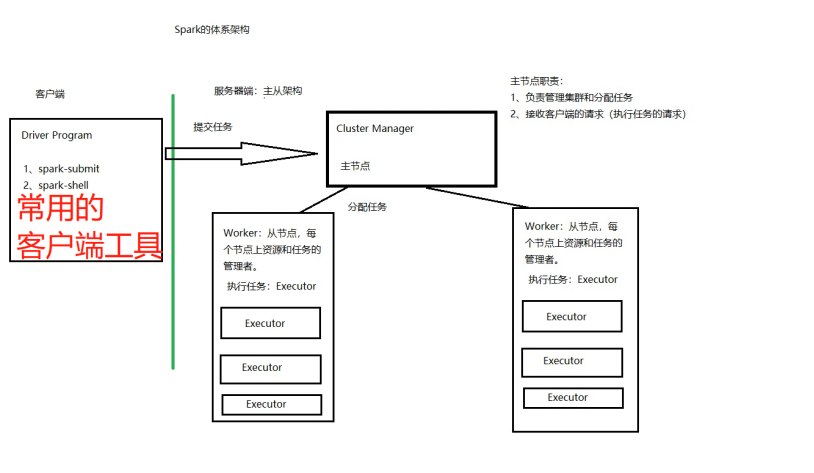

我自己的一张图:

Spark可以运行在Yarn上,如果使用yarn,我们的资源管理、任务调度等工作都交给Yarn。

Spark也可以有自己的调度。

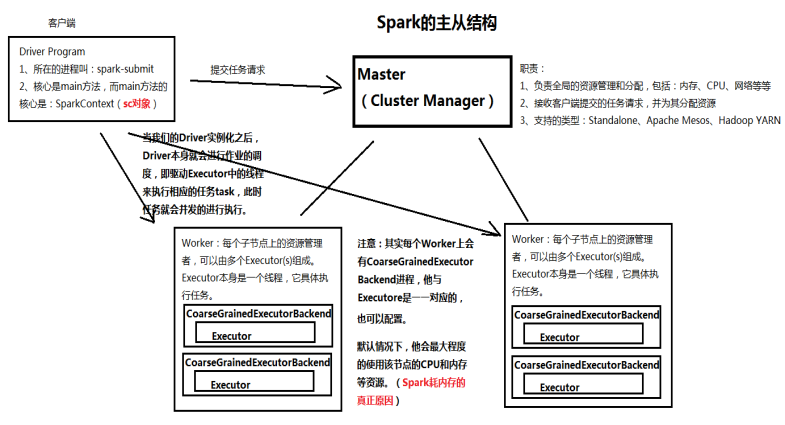

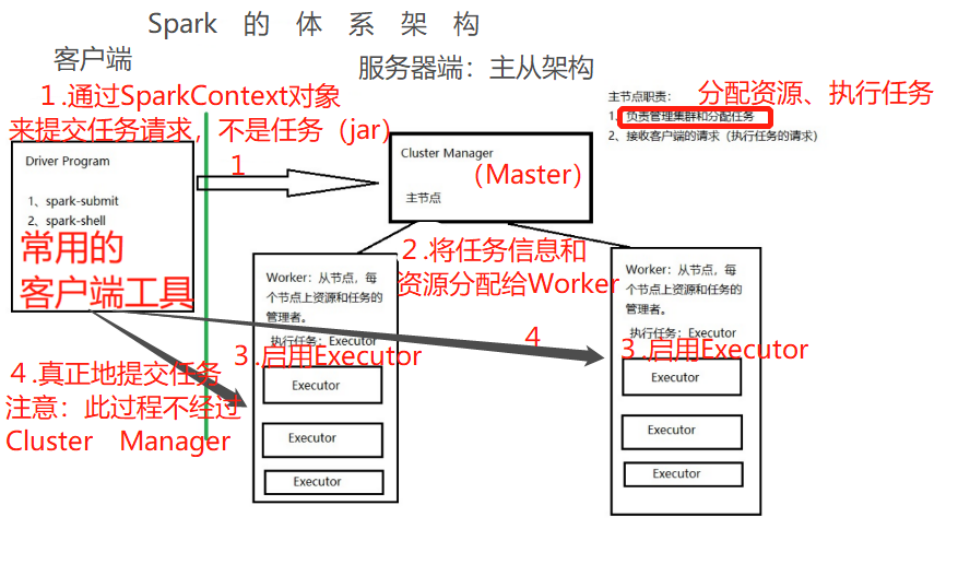

Worker:从节点-每个计算节点上资源和任务管理者。他只负责管理一个节点,不负责管理其他节点。

Executor-执行任务者:一个Worker有多个Executor。

Worker的默认行为:占用该节点上所有的资源(CPU、内存)

Spark对内存没有很好的管理,容易出现OOM(溢出),Spark把内存管理交给应用程序(程序员写的代码)。

Driver Program-客户端:

1)spark-submit:用于提交spark任务(spark代码)

2)Spark-shell:REPL命令行

Cluster Program-主节点(Master):

1)负责管理集群的分配任务

2)接受客户端的请求

浙公网安备 33010602011771号

浙公网安备 33010602011771号