Hadoop综合大作业

作业来源:https://edu.cnblogs.com/campus/gzcc/GZCC-16SE1/homework/3363

本次作业是在《爬虫大作业》的基础上进行的,在《爬虫大作业》中。本次作业的任务主要有以下三点:

1.对CSV文件进行预处理生成无标题文本文件,将爬虫大作业产生的csv文件上传到HDFS

2.把hdfs中的文本文件最终导入到数据仓库Hive中,在Hive中查看并分析数据

3.用Hive对爬虫大作业产生的进行数据分析(10条以上的查询分析)

大数据分析

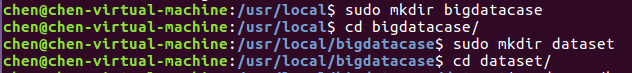

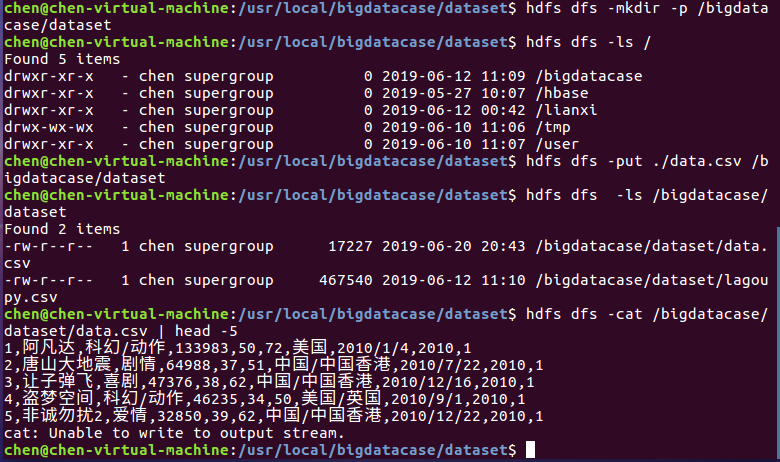

1.对CSV文件进行预处理生成无标题文本文件,将爬虫大作业产生的csv文件上传到HDFS

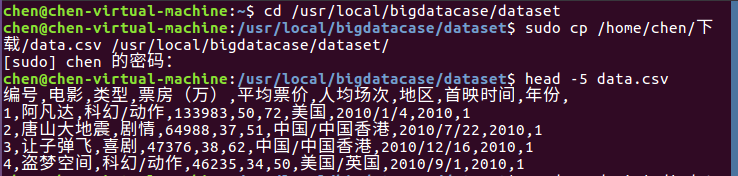

其次,我们把data.csv文件放到下载这个文件夹中,并使用命令把data.csv文件拷贝到我们刚刚所创建的文件夹中,具体步骤如下:

对CSV文件进行预处理生成无标题文本文件,步骤如下:

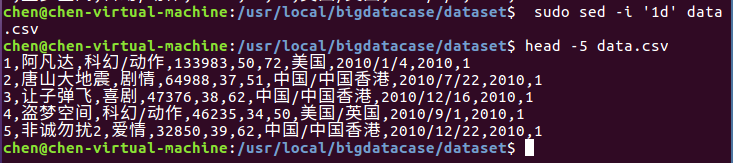

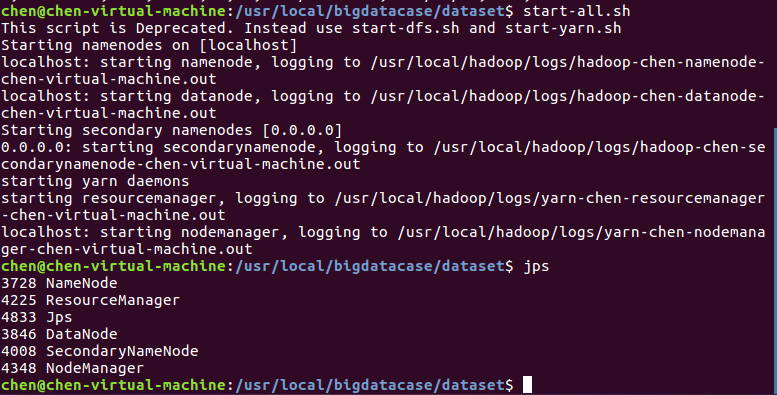

接着,启动hadoop,并查看Hadoop是否启动成功,步骤如下:

最后,我们把本地的文件上传至HDFS中,步骤如下:

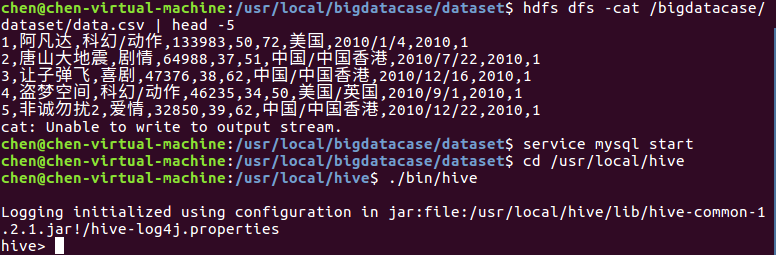

2.把hdfs中的文本文件最终导入到数据仓库Hive中

首先,启动hive,步骤如下

其次,把hdfs中的文本文件最终导入到数据仓库Hive中,并在Hive中查看并分析数据,具体步骤如下:

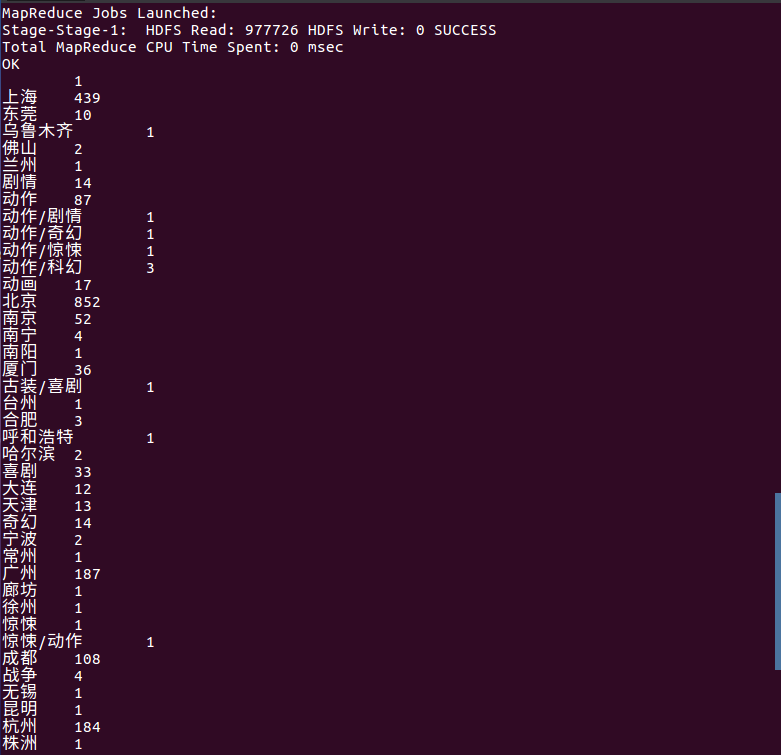

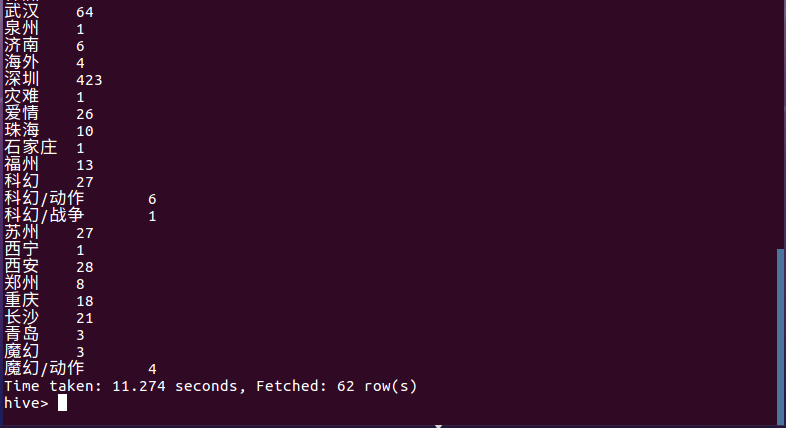

3.用Hive对爬虫大作业产生的进行数据分析

查找城市分布情况,查询结果如下图所示:

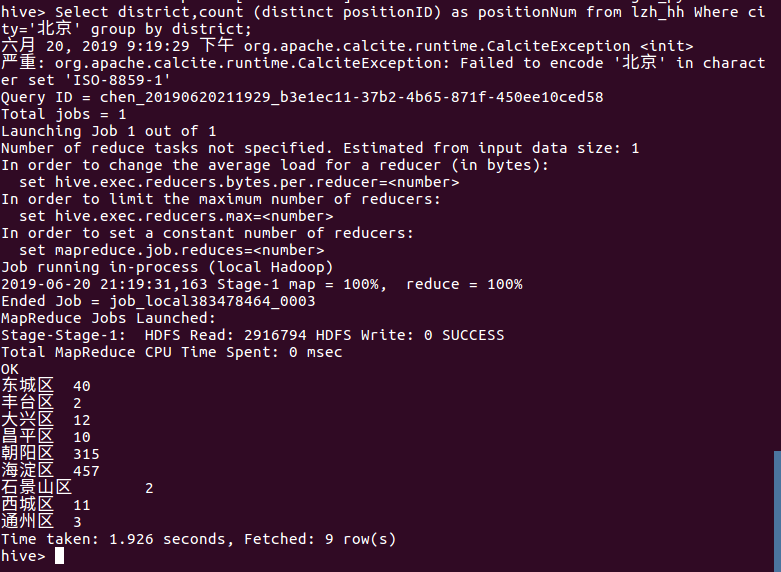

找出北京各个区的电影情况

找出北京各个区的电影情况

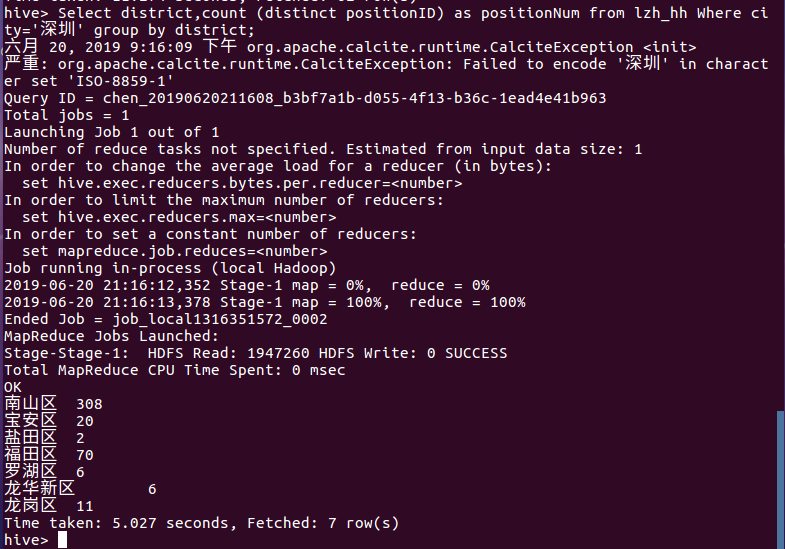

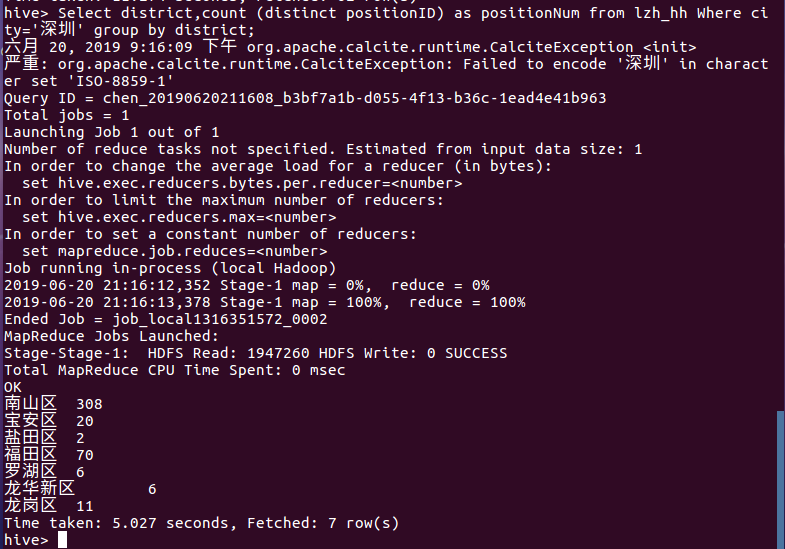

找出深圳各个区的电影情况

找出上海各个区的电影情况

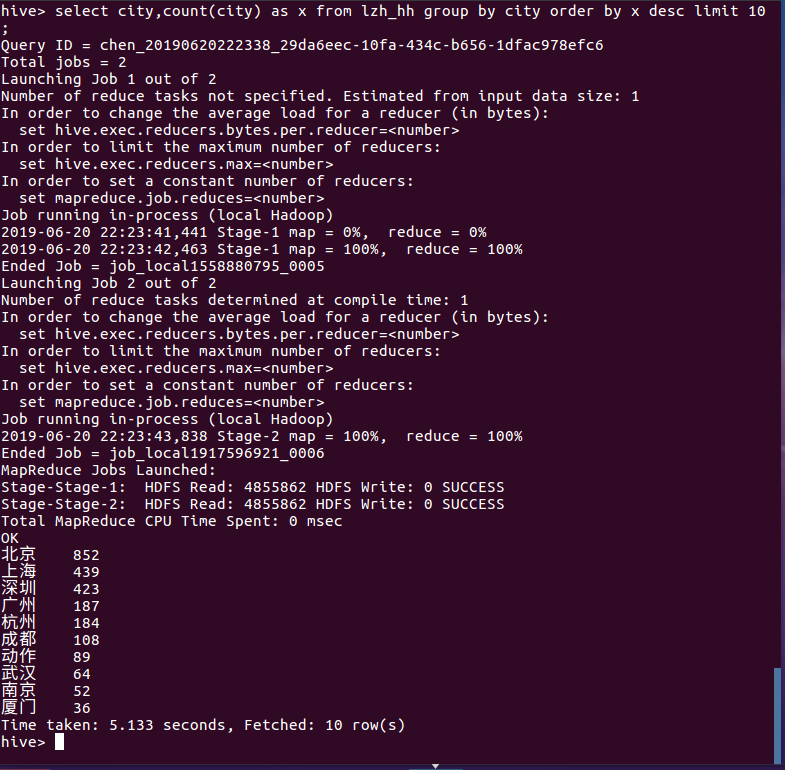

查询票房前10名的城市

浙公网安备 33010602011771号

浙公网安备 33010602011771号