从 “工具” 到 “共生”:GPT-5 藏着哪些颠覆认知的新可能?

概要

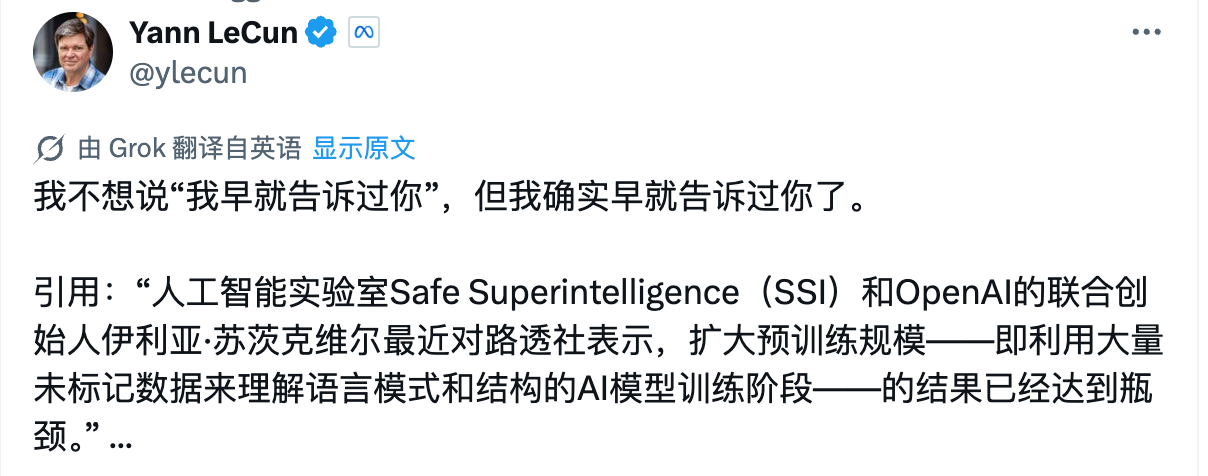

- 从GPT-5来看,通用LLM的性能逼近上限,Scaling Law在失灵;

- 从头部企业来看,MoE取代Dense架构成为了LLM的主流架构;

OpenAI开源模型

8 月 6 日,OpenAI 宣布推出两款开源模型 GPT-oss-120b 和 GPT-oss-20b,这是自 2020 年发布 GPT-2 以来OpenAI 首次推出开源语言模型。

模型性能和性价比

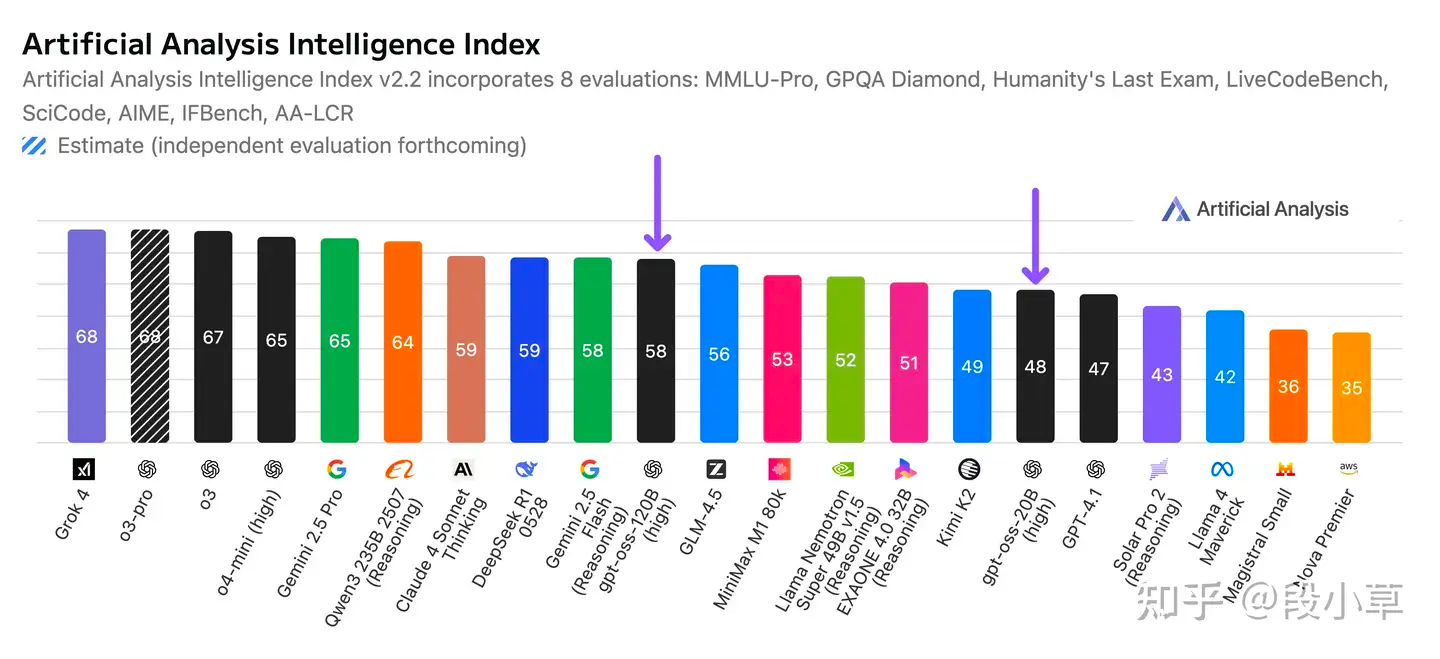

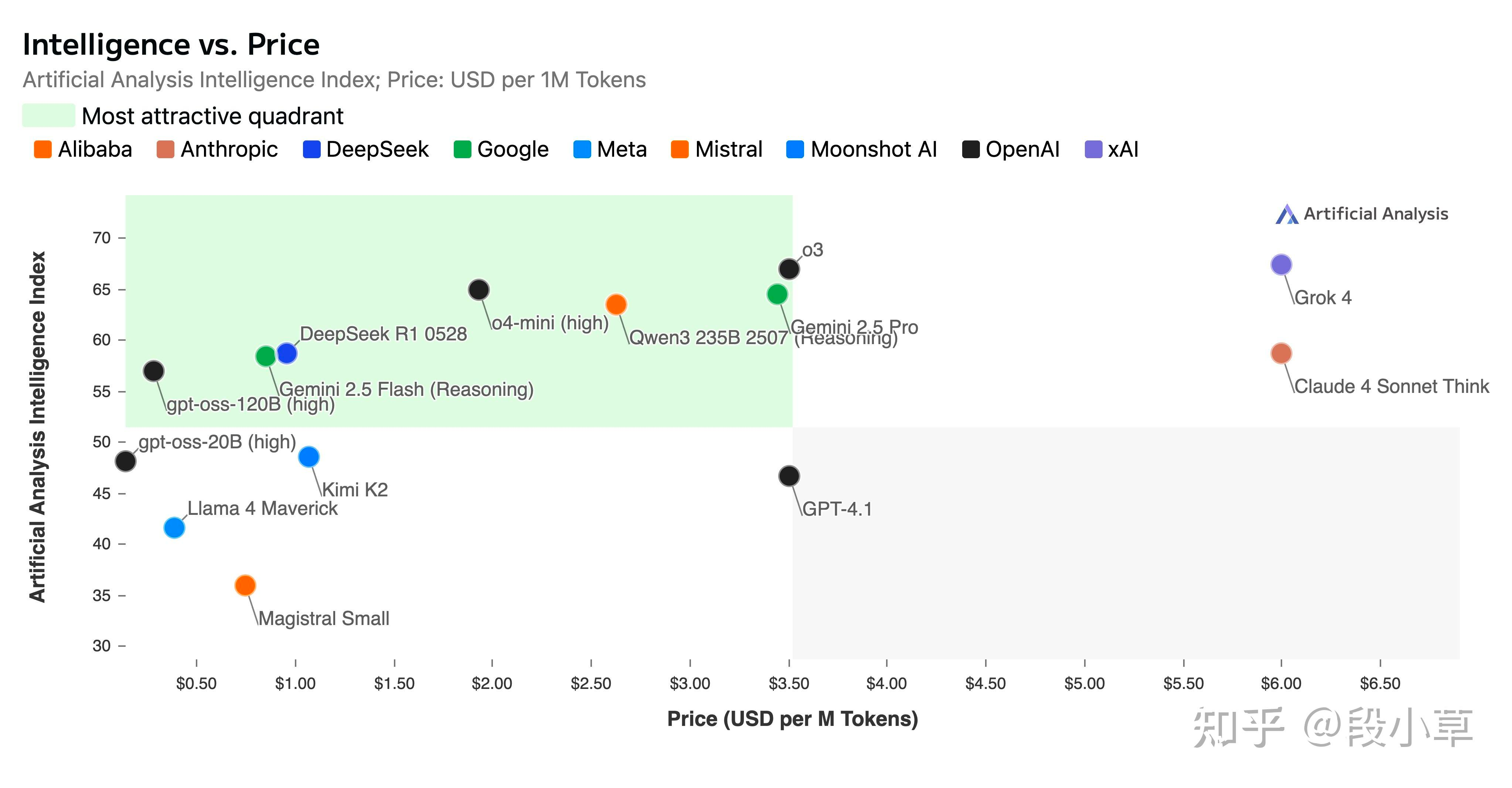

- gpt-oss-120b 在核心推理基准测试上已接近 OpenAI 的 o4-mini+ 模型的表现,可以在单张 80GB GPU 上高效运行。

- gpt-oss-20b 则在常用基准测试中接近 o3-mini+ 的水平,仅需 16GB 内存即可运行,非常适合边缘设备、本地推理以及快速开发迭代。

模型性价比排名

模型架构对比

|

模型/架构 |

层数 |

MoE |

上下文 长度 |

词汇表 |

Embedding&注意力 |

|

qwen3-30B |

48层 隐藏层宽度:768 |

128/8 |

262K |

151K |

2048维 32个注意力头 |

|

GPT-OSS-20B |

24 隐藏层宽度:2880 |

32/4 |

128K |

200K |

2880维度 64个注意力头 |

|

GPT-OSS-120B |

36 |

128/4 |

128K |

gpt-oss的问题

- 事实错误与幻觉:用户普遍反映

gpt-oss幻觉率较高,容易出现事实错误,模型会编造很多不存在的信息。 - 编码能力不够强:虽然官方强调了编码能力,但有用户反馈,

gpt-oss表现不如qwen3-coder-30b。后者能够一次成功,而gpt-oss的代码存在 bug 且无法正常工作。oss-120b输出的代码异常率超过56%,居在测所有模型之下。错误分布在所有语言。存在许多低级错误,比如C++的引用不写#include,golang忘记花括号,python把语句写同一排等等。 - 过度审查:是社区中抱怨最多的问题之一。「它是我用过的第一个因为『违反安全政策』而拒绝回答关于自身技术问题的模型」、「太监了,废了」。这种「过度对齐」似乎让模型在很多无害的创作和交流场景中也变得束手束脚。模型的自我审查到了一种不可思议的地步。

- 微调受限:

gpt-oss开源的是 mxfp4 量化模型,这会给普通用户带来便利,但未必会受社区和开发者的认可 , fp4在blackwell架构的GPU上支持训练(B100,B200等)。 - 语言受限:thinking语言用的是英文;中文脑筋急转弯效果不好;

gpt-oss的优点

gpt-oss-120b 在效率方面具有优势:

- 体积与部署:gpt-oss 模型采用 MXFP4 精度格式,120B 版本仅 60.8GB,20B 版本仅 12.8GB。这意味着 120B 模型可在单张 NVIDIA H100 显卡上原生运行,20B 模型则能轻松部署于显存 >16GB 的消费级 GPU 或笔记本。

- 性能表现:120B 模型超越 o3-mini 但落后于 o4-mini 和 o3,成为单卡 H100 可运行的最智能模型,20B 则是消费级 GPU 的最优选择。评估显示两者无明显能力短板。

- 架构特性:采用标准 MoE 设计,每 token 生成选择 top4 专家。120B 含 36 层,20B 含 24 层,均使用 Rotary 嵌入和 YaRN 技术实现 128k 上下文窗口。120B 前向传播仅激活 4.4% 参数(20B为17.2%)。业界推测 GPT-4 后主流实验室顶级模型均为稀疏 MoE 架构。

- 许可证:Apache 2.0开源协议。

gpt-oss体现的趋势

计算效率和激活效率的进一步压榨

一个算法变得更快,它就更有可能成为更高级算法的一环。模型训练上,稀疏激活、训练时量化会是很长一段时间的标配。

按需分配思考时间(自动挡和手动挡)

根据任务的复杂性、延迟要求和成本预算,给模型挂挡,将大幅扩展推理模型的应用场景。

你好

Thinking...

User says "你好" in Chinese, meaning "Hello". The system instructions are to respond as ChatGPT. So reply in Chinese, friendly. No restrictions. Provide greeting.

...done thinking.

你叫什么名字

Thinking...

User asks "你叫什么名字" meaning "What is your name?" Should respond in Chinese. I can say my name: "我是 ChatGPT" or "你可以叫我 ChatGPT". Provide answer.

...done thinking.

张居正是什么样的人

Thinking...

User asks "张居正是什么样的人" (Who is Zhang Juzheng). They likely want a description of Zhang Juzheng, a famous Chinese statesman during Ming dynasty. Provide summary: his

life, policies, achievements, reputation, controversies. Provide balanced view. Use Chinese. Let's respond.

...done thinking.

脑筋急转弯:小白加小白等于什么

Thinking...

We need to answer a riddle in Chinese: "脑筋急转弯:小白加小白等于什么". It likely refers to a pun: "小白" could be "小白" meaning "little white" but maybe refers to "white

....省略50行

Let's answer: "大白". And we can add a brief explanation.

...done thinking.

从生成器变智能体

GPT-oss 使用特殊 token 和通道,来区分不同类型的信息,为复杂的智能体行为提供了结构化的基础。模型被训练遵循一个明确的指令优先级:System>Developer>User>Assistant>Tool。这为多方参与的系统提供了可靠的护栏和控制机制。专用的智能体交互格式和内置的安全与指令控制层级将成为顶尖模型的标配,其重要性不亚于模型的基础算法。

gpt-oss 模型训练采用 Harmony Chat 格式。它是一种自定义的聊天格式,通过特殊标记和角色(System、Developer、User、Assistant、Tool)来划分消息边界和作者身份,遵循严格的角色优先级解决指令冲突。该格式还引入“channels”机制,区分消息的用途和可见范围,如推理链、工具调用和最终回答,从而支持模型进行复杂的推理和工具调用操作。正确使用这种格式对发挥 gpt-oss 模型的最佳性能非常重要,多轮对话中需删除历史推理痕迹。

智能体网络可能取代单模型应用

多 agent 交互的 pipeline 非常复杂,但是模型鲁棒性/可控性高了以后协调分工就会变得更简单。面对复杂任务时,智能体们将通过一个更高级的领导进行协调和分工。agent 之间不再是简单的 API调用关系,而是能主动交换信息。

后训练变得更重

后训练承担的功能在变多,不仅是推理能力提升,还包含安全性和可控性的塑造。

GPT-5模型

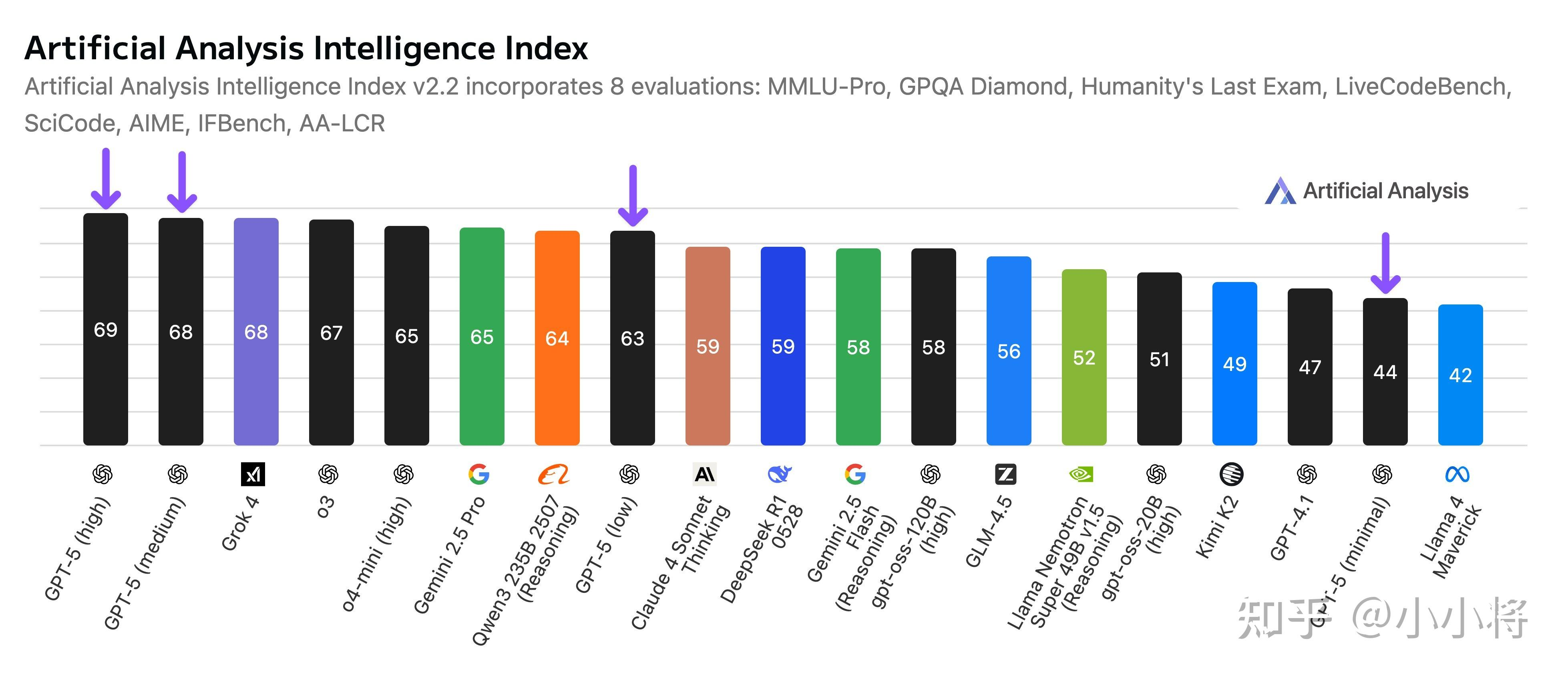

GPT-5系列包含三个模型[1]:

- GPT-5:适合复杂推理、广泛的世界知识,以及大量代码或多步骤的代理任务

- GPT-5 mini:适合成本优化的推理和聊天;在速度、成本和能力之间取得平衡

- GPT-5 nano:适合高吞吐量任务,特别是简单的指令执行或分类

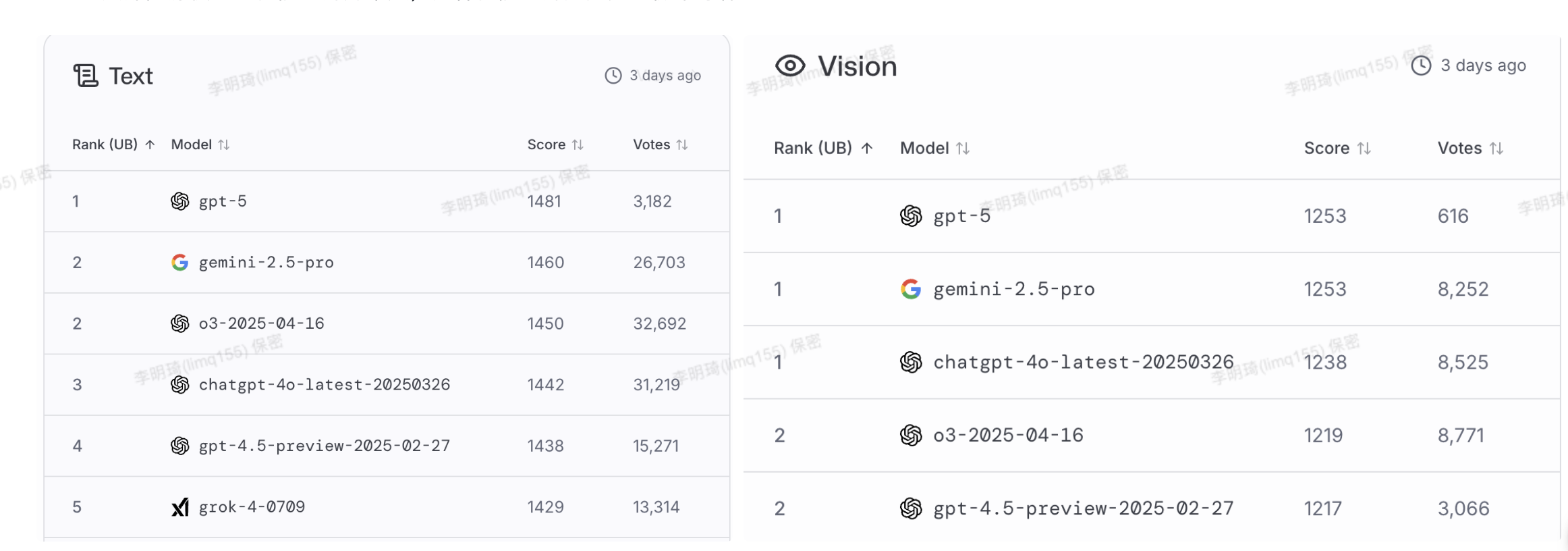

模型性能和性价比

gpt5 主要突破在于 agent 相关能力的提升(垂直领域的 planning 和 function calling 能力)。

- 高速核心模型 (Core Model):这是一个速度优化、效率极高的模型,旨在快速响应和处理绝大多数日常查询和简单指令。其设计目标是提供即时、流畅的交互体验。

- 深度推理模型 (GPT-5 Thinking):这是GPT-5的“智慧核心”,一个专门用于处理高度复杂、需要深度思考和多步推理问题的模型。无论是复杂的科学难题、代码调试,还是需要严谨逻辑的商业分析,该模型都能展现出强大的能力。

- 实时动态路由器:该路由器能即时分析用户请求的复杂性、对话类型和意图,智能地决定调用哪个模型,从而在效率和性能间取得最佳平衡

GPT-5在模型的可靠性和真实性上取得了重大进展。

- 事实准确性大幅提升:

- 在包含网络搜索的真实世界查询中,GPT-5的回答出现事实错误的概率比GPT-4o低约45%。

- 在启用“深度推理”模式时,其事实错误率比OpenAI o3模型低约80%。

- 在LongFact和FActScore等开源事实性基准测试中,“GPT-5 thinking”模式产生的幻觉(捏造信息)次数比o3少了约六倍。

- 更诚实且知晓自身局限:

- 模型在无法完成任务时会更诚实地沟通。在一项测试中,从多模态基准测试中移除了所有图像后,o3模型仍有86.7%的时间会自信地回答关于不存在图像的问题,而GPT-5的这一比例仅为9%。

- 在涉及不可能完成的编码任务和缺失多模态资产的评估中,“GPT-5 thinking”的欺骗率全面低于o3模型。

- 风格优化与交互体验:

- GPT-5显著减少了不必要的奉承(Sycophancy)和表情符号,在专门的评估中,GPT-5将奉承性回复的比例从14.5%降至低于6%。

gpt-5体现的趋势

a.Scaling Law在LLM上的效果提升在放缓, 可能已经接近上限;

b.头部企业最好的模型都是MoE架构,尽管各家架构细节略有差异;MoE架构已经取得了核心地位。

GPT系列、Deepseek R1/V3、Kimi-K2、Qwen-3、Gemini、GLM、天工等;

c.头部闭源模型的性能差异并不大,这种性能差异通过应用侧来弥补;

d.非通用LLM能力借助工具或领域模型实现,比如借助AlphaFold完成分子设计,借助Lean Prover实现数学定理的猜想与证明,借助Verl实现训练自己的AI助手;通用LLM承担桥接中介的角色;

|

技术方向 |

GPT-5体现的核心特征 |

未来潜在发展启示 |

|

增强推理与测试时计算 |

内置思考路由器,动态调整推理深度,减少输出令牌50-80%。 |

LLM将更多投资“思考优化”,如Q*式搜索算法或自适应计算,实现PhD级问题解决。趋势:从预训练转向后训练强化,结合人类反馈(RLHF)提升多步规划和科学发现。 |

|

多模态融合与感官扩展 |

统一处理文本/图像/音频/视频,视觉理解达84.2%。 |

未来LLM将融入3D、触觉和实时传感器数据,成为“多感官基础模型”。应用:机器人、AR/VR和医疗诊断,提升跨模态推理。 |

|

代理自主性和工具集成 |

代理任务如代码生成和自动化工作流,编码准确率74.9%。 |

向“全自主代理”转型,能执行长时序任务(如多天项目)。趋势:内置工具链(如浏览器、API调用)和开源代理框架,减少人为干预。 |

|

效率优化与模型压缩 |

变体如mini/nano版,平衡性能与成本。 |

纯参数扩张放缓,转向混合专家(MoE)和稀疏激活。未来:边缘设备部署小型模型,合成数据训练降低成本。 |

|

安全、对齐与可靠性 |

幻觉降低45%,安全完成机制,避免有害输出。 |

强调伦理对齐,如强化学习减少欺骗。趋势:内置事实核查、局限性自知和多层安全测试,向可解释AI发展。 |

|

个性化与社会智能 |

支持预设人格和情感智能,提升用户互动。 |

LLM将融入“情感 quotient”(EQ)和个性化学习。未来:实时适应用户偏好,应用于教育、心理健康和协作。 |

一些材料

- web端GPT-5内容总结(Google DeepResearch):https://g.co/gemini/share/31072d447b68

- web端GPT-5内容总结(Grok-4):https://x.com/i/grok/share/SIQ7vvsTcxWL6nmnfEePR6BQR

- web端GPT-5内容总结(Kimi-2):https://www.kimi.com/preview/198acf6d-b7a1-84f4-b729-4e4eca000588

本文来自博客园,作者:limingqi,转载请注明原文链接:https://www.cnblogs.com/limingqi/p/19044423

浙公网安备 33010602011771号

浙公网安备 33010602011771号