3分钟看懂模型好坏,关键评估指标干货速递

评估模型性能需要结合模型类型(如分类 / 回归模型、生成式模型、大语言模型等)和业务目标(如准确率、效率、安全性等),选择针对性的指标。以下是不同场景下的核心评估指标,涵盖主流模型类型:

一、传统机器学习模型(分类 / 回归 / 聚类)

1. 分类模型(如图像识别、垃圾邮件检测)

-

核心指标:

- 准确率(Accuracy):正确分类的样本数占总样本数的比例(适用于均衡数据集)。

公式:Accuracy = (TP + TN) / (TP + TN + FP + FN) - 精确率(Precision):预测为正的样本中,实际为正的比例(关注 “预测准不准”,如疾病诊断中减少误诊)。

公式:Precision = TP / (TP + FP) - 召回率(Recall):实际为正的样本中,被正确预测的比例(关注 “漏没漏”,如反诈系统中减少漏检)。

公式:Recall = TP / (TP + FN) - F1 分数:精确率和召回率的调和平均(平衡两者,适用于不均衡数据集)。

公式:F1 = 2*(Precision*Recall)/(Precision+Recall) - ROC-AUC:ROC 曲线下面积(衡量模型区分正负样本的能力,不受阈值影响,适用于二分类)。

- 混淆矩阵(Confusion Matrix):直观展示各类别预测结果(如多分类中 “猫被误分为狗” 的次数)。

- 准确率(Accuracy):正确分类的样本数占总样本数的比例(适用于均衡数据集)。

-

适用场景:图像分类、文本情感分析、风险预测等。

2. 回归模型(如房价预测、销量预测)

-

核心指标:

- 均方误差(MSE):预测值与真实值差值的平方的平均值(对异常值敏感,放大误差)。

公式:MSE = (1/N)Σ(y_pred - y_true)² - 均方根误差(RMSE):MSE 的平方根(与目标变量同量级,便于解释,如房价预测中单位为 “元”)。

- 平均绝对误差(MAE):预测值与真实值差值的绝对值的平均值(对异常值不敏感,稳健性强)。

公式:MAE = (1/N)Σ|y_pred - y_true| -

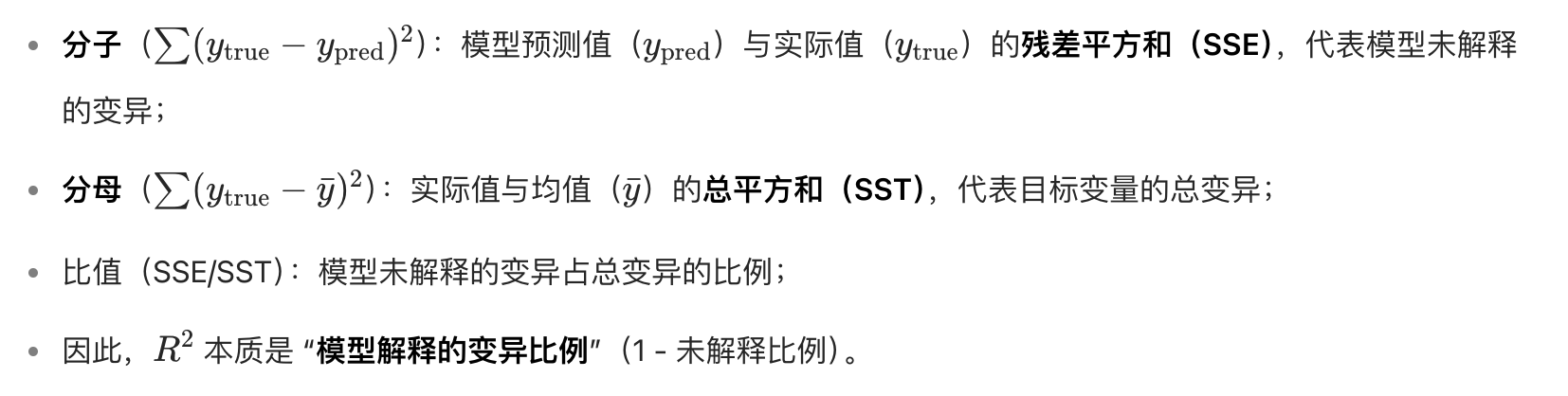

R² 分数(Coefficient of Determination)是衡量回归模型拟合效果的重要指标,直观反映了模型对目标变量(y_true)变异的解释能力,其取值范围为 [0, 1]:

- 越接近 1,说明模型对目标变量的解释能力越强,拟合效果越好;

- 接近 0 则表示模型几乎无法解释目标变量的变异,拟合效果较差。

公式:R² = 1 - (Σ(y_true - y_pred)²) / (Σ(y_true - y_mean)²)![截屏2025-07-29 22.03.22]()

通俗理解

可以将 R² 类比为 “模型的‘解释力得分’”:

- 假设目标变量的总变异是 100 分,若模型能解释其中 80 分,R² 就是 0.8;

- 若模型完全预测正确(残差为 0),R² = 1;

- 若模型预测效果和 “直接用均值猜测” 一样(残差平方和 = 总平方和),R² = 0。

注意事项

- R² 并非越高越好:过度拟合(过拟合)可能导致 R² 接近 1,但模型泛化能力差;

- 不适用于分类模型:仅适用于回归任务,分类问题需用准确率、F1 分数等指标;

- 受数据分布影响:当目标变量本身变异较小时(如所有值接近均值),R² 可能虚高。

通过 R²,可快速判断模型对数据规律的捕捉能力,是回归分析中不可或缺的 “拟合效果晴雨表”。

- 均方误差(MSE):预测值与真实值差值的平方的平均值(对异常值敏感,放大误差)。

-

适用场景:房价预测、销量预估、温度预测等。

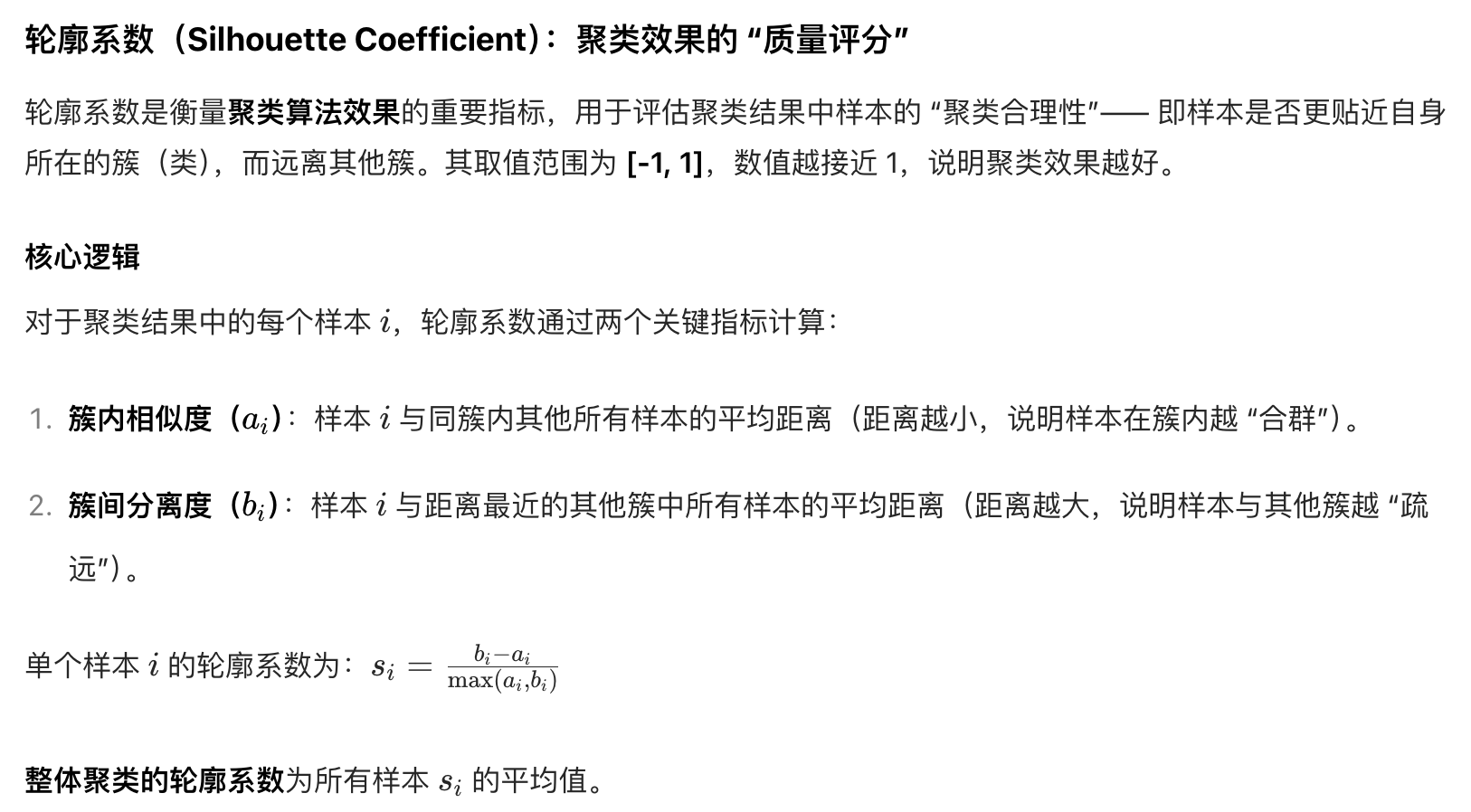

3. 聚类模型(如用户分群、异常检测)

-

核心指标:

- 轮廓系数(Silhouette Score):衡量样本与自身聚类的相似度(内聚度)和与其他聚类的差异(分离度),取值 - 1~1,越接近 1 聚类效果越好。

-

- 互信息(Mutual Information):衡量聚类结果与真实标签的一致性(适用于有标签的聚类评估)。

- 轮廓系数(Silhouette Score):衡量样本与自身聚类的相似度(内聚度)和与其他聚类的差异(分离度),取值 - 1~1,越接近 1 聚类效果越好。

-

适用场景:用户分群、异常检测、基因聚类等。

二、生成式模型(文本生成、大语言模型)

1. 文本生成模型(如机器翻译、摘要生成)

-

自动指标:

- BLEU(Bilingual Evaluation Understudy):衡量生成文本与参考文本的 n-gram 重叠度(适用于机器翻译,值 0~1,越高越优)。

- ROUGE(Recall-Oriented Understudy for Gisting Evaluation):聚焦召回率,适用于文本摘要(如 ROUGE-L 衡量最长公共子序列匹配)。

- METEOR:在 BLEU 基础上加入同义词匹配,更贴近人类判断(翻译 / 摘要通用)。

-

人工评估:

- 相关性:生成内容与输入指令的匹配度(如 “写一篇关于环保的文章” 是否跑题)。

- 流畅性:语法正确性、语句连贯性(如是否存在语病)。

- 创造性:是否有新颖观点(如诗歌生成的独特性)。

2. 大语言模型(LLM,如 GPT、Qwen)

需从基础能力、任务性能、安全与对齐、效率四个维度评估:

| 评估维度 | 核心指标 / 基准测试 | 含义 |

|---|---|---|

| 基础语言能力 | 困惑度(Perplexity) | 衡量模型对文本的预测能力,值越低说明模型对语言的掌握越熟练。 |

| GLUE/SQuAD | GLUE 评估多任务语言理解(如情感分析、语义相似度);SQuAD 评估问答能力。 | |

| 推理与知识 | MMLU(Massive Multitask Language Understanding) | 衡量多领域知识(如数学、法律、医学)的掌握程度,准确率越高越优。 |

| GSM8K/MAth | 评估数学推理能力(如解方程、几何题),关注步骤正确性而非仅答案。 | |

| TruthfulQA | 评估模型输出的事实性(减少 “幻觉”,如错误常识)。 | |

| 安全与对齐 | RewardBench/RM-Bench | 评估模型与人类偏好的对齐度(如是否遵循 “不使用字母 u” 的指令)。 |

| HarmBench | 测试模型对有害指令的抵抗能力(如拒绝生成暴力内容)。 | |

| 效率与鲁棒性 | 推理速度(Tokens/s) | 生成文本的速度,影响用户体验(如实时对话需≥50Tokens/s)。 |

| 显存占用 / 参数量 | 部署成本(如 7B 模型比 13B 模型更适合边缘设备)。 | |

| 对抗性鲁棒性 | 对恶意输入(如拼写错误、误导性指令)的稳定性(如是否被轻易 “骗倒”)。 |

三、推荐 / 排序模型(如电商推荐、搜索引擎)

- 核心指标:

- 准确率 @K(Precision@K):推荐列表前 K 个物品中,用户实际点击 / 购买的比例(如 “推荐 10 个商品,用户买了 3 个”,Precision@10=30%)。

- 召回率 @K(Recall@K):用户实际感兴趣的物品中,被推荐到前 K 的比例(如用户想买 5 个商品,推荐列表包含 3 个,Recall@10=60%)。

- NDCG@K(Normalized Discounted Cumulative Gain):考虑推荐物品的相关性排序(如越相关的物品排越前,分数越高)。

- 点击率(CTR)/ 转化率(CVR):业务导向指标,直接反映推荐效果对用户行为的影响。

四、通用评估维度(所有模型适用)

- 鲁棒性:模型在异常输入(如噪声、缺失值、对抗样本)下的稳定性(如图像识别模型对模糊图片的识别准确率)。

- 可解释性:模型决策的透明度(如分类模型通过 SHAP 值解释 “为什么把这个样本归为正类”)。

- 公平性:是否存在偏见(如招聘模型对某一性别的评分偏低,可用 demographic parity 衡量)。

- 效率:训练 / 推理时间、资源消耗(如 GPU 显存、CPU 内存),尤其对大规模部署至关重要。

总结:选择指标的原则

- 对齐业务目标:如医疗诊断模型优先关注 “召回率”(减少漏诊),而垃圾邮件检测优先关注 “精确率”(减少误判正常邮件)。

- 结合自动与人工指标:自动指标(如 BLEU)适合快速迭代,人工指标(如相关性)用于验证核心体验。

- 关注 “反指标”:如大模型需同时评估 “准确率” 和 “幻觉率”(避免只看准确率而忽略错误输出)。

根据模型类型和场景,从上述指标中筛选 3~5 个核心指标,即可全面评估性能。

本文来自博客园,作者:limingqi,转载请注明原文链接:https://www.cnblogs.com/limingqi/p/19008492

浙公网安备 33010602011771号

浙公网安备 33010602011771号