GPT原理

1.GPT的定义与发展历程

1.1生成式预训练模型

GPT 是 “Generative Pre-trained Transformer” 的缩写,即生成式预训练变换器,是由 OpenAI 开发的一系列自然语言处理模型。它是一种基于 Transformer 架构的生成模型,通过在大规模文本数据上进行预训练,学习语言的通用模式和结构,然后可以在特定任务上进行微调,以优化特定应用的表现。

1.2 迭代演进过程

GPT 的发展历程如下:

· GPT-1(2018 年):2018 年 6 月 11 日,OpenAI 发表论文《通过生成式预训练提高语言理解能力》,介绍了 GPT-1。它采用了 “预训练 + 微调” 的两阶段训练流程,预训练阶段在 BookCorpus 语料库(包含 7000 本未出版书籍,总大小 4.5GB)上进行,目标是预测下一个单词,模型参数数量为 1.2 亿。GPT-1 的出现开启了预训练大模型时代。

· GPT-2(2019 年):2019 年 2 月 OpenAI 发布了 GPT-2,该模型去掉了 GPT-1 阶段的有监督微调,成为无监督模型。其参数数量增加到 15 亿,训练数据集为 WebText,包含八百万个文档,总大小为 40GB。GPT-2 聚焦在无监督、zero - shot(零次学习)上,在 8 个测试语言建模数据集中的 7 个数据集上实现了当时最先进的结果。

· GPT-3(2020 年):2020 年 5 月 OpenAI 发表 GPT-3 的论文,参数数量达到了惊人的 1750 亿,使用了 570GB 的大规模文本语料库,其中包含约四千亿个标记。GPT-3 在许多 NLP 数据集上都有很强的性能,甚至可以生成难以与人类撰写区分开来的新闻文章。

· InstructGPT(2022 年):2022 年 2 月,OpenAI 在 GPT-3 基础上进一步强化推出 InstructGPT 模型,使用来自人类反馈的强化学习方案 RLHF,训练出奖励模型去训练学习模型,通过对大语言模型进行微调,从而能够在参数减少的情况下,实现优于 GPT-3 的功能。

· GPT-3.5 和 GPT-4:后续 OpenAI 还推出了 GPT-3.5 和 GPT-4 等模型,进一步提升了模型的性能和能力,在语言理解、生成、推理等方面表现更加出色,应用场景也更加广泛。

1.3 技术突破

GPT系列标志着NLP领域从任务特定模型向通用大模型的转变,通过"预训练+提示学习"的新范式,显著降低下游任务适配成本,推动AI技术民主化进程。

2. GPT的核心技术特点

2.1基于 Transformer 架构的解码器设计

· Transformer 的核心地位:GPT 完全依赖 Transformer 架构中的解码器模块(Decoder-only),摒弃了传统的循环神经网络(RNN)或卷积神经网络(CNN)。Transformer 的自注意力机制(Self-Attention)允许模型在处理文本时,同时关注输入序列中不同位置的词语关联(如上下文语义、长距离依赖),解决了 RNN 难以捕捉长文本逻辑的问题。

· 解码器的生成能力:Transformer 解码器通过 “掩码自注意力”(Masked Self-Attention)确保生成文本时只能依赖前文信息(类似人类写作的 “顺序逻辑”),为模型的生成式任务(如文本续写、问答、创作)提供了天然支持。

2.2 “预训练 + 微调” 的两阶段训练模式

- 预训练阶段(Pre-training):

- 在大规模无标注文本数据(如书籍、网页、论文等)上进行通用语言建模训练,目标是通过前文预测下一个词(Next Token Prediction)。这一阶段让模型学习到语言的语法规则、语义关联、世界知识(如常识、事实)等通用能力。

- 例如,GPT-3 使用了 570GB 的文本语料(含 4000 亿个 token),通过海量数据训练使模型具备强大的 “泛化性”。

- 微调阶段(Fine-tuning):

- 在预训练基础上,使用特定任务的标注数据(如翻译、摘要、情感分析)对模型进行针对性训练,调整部分参数以适配具体场景。

- 后续迭代(如 GPT-3.5/4)进一步引入指令微调(Instruction Tuning) 和人类反馈强化学习(RLHF),让模型更贴合人类意图(如遵循指令、减少有害输出)。

- 参数规模的指数级增长:从 GPT-1 的 1.2 亿参数,到 GPT-3 的 1750 亿参数,再到 GPT-4 的万亿级参数(未公开具体数值),参数规模的扩大直接提升了模型对复杂语义的捕捉能力。参数越多,模型能存储的 “知识” 和 “模式” 越丰富,处理歧义、推理逻辑的能力越强。

- 海量数据的支撑:参数规模的增长需匹配同等规模的训练数据。大规模无标注数据不仅让模型学习语言规律,还间接 “记住” 了大量事实性知识(如历史事件、科学原理),为后续的问答、推理任务提供基础。

- 传统 NLP 模型需针对特定任务进行大量标注数据训练,而 GPT 通过预训练阶段积累的通用语言能力,可在零样本(无需示例)或少样本(仅需几个示例)情况下完成新任务。

- 例如,用户无需专门训练模型做 “邮件撰写”,只需输入指令 “写一封请假邮件”,GPT 就能基于预训练学到的 “邮件格式” 和 “语言风格” 生成符合要求的内容。这一能力源于预训练阶段对 “任务描述” 和 “语言模式” 的通用理解。

- GPT 生成文本时采用自回归(Autoregressive)方式:从第一个词开始,每次生成一个词(Token),并将其作为下一个词的输入,循环直至生成完整序列(如句子、段落)。

- 这种机制确保了文本生成的连贯性和逻辑性,符合人类语言的 “顺序表达” 习惯,但也导致生成速度相对较慢(需逐词计算)。

- 上下文窗口(Context Window)指模型一次能处理的最大文本长度(以 token 为单位)。早期 GPT-1 的窗口仅为 512 token,而 GPT-4 已支持数万 token(如 128k),意味着模型能 “记住” 更长的对话历史、文档内容或复杂指令。

- 长上下文窗口使其能处理更复杂的任务,如长文档摘要、多轮对话、代码调试(需完整代码上下文)等。

- 随着模型能力增强,GPT 系列通过技术手段让输出更贴合人类价值观和需求:

- 指令微调:用 “指令 - 响应” 格式的数据(如 “请总结这段话”+ 正确总结)训练模型,使其理解并遵循人类指令。

- RLHF(人类反馈强化学习):通过人类标注员对模型输出的质量打分,训练 “奖励模型”,再用强化学习(如 PPO 算法)优化模型,减少有害、偏见或无关内容。

- 这一技术使 GPT 从 “能生成文本” 升级为 “能生成有用、安全、符合意图的文本”。

2.3 超大规模参数与数据驱动的能力跃升

- 参数规模的指数级增长:从 GPT-1 的 1.2 亿参数,到 GPT-3 的 1750 亿参数,再到 GPT-4 的万亿级参数(未公开具体数值),参数规模的扩大直接提升了模型对复杂语义的捕捉能力。参数越多,模型能存储的 “知识” 和 “模式” 越丰富,处理歧义、推理逻辑的能力越强。

- 海量数据的支撑:参数规模的增长需匹配同等规模的训练数据。大规模无标注数据不仅让模型学习语言规律,还间接 “记住” 了大量事实性知识(如历史事件、科学原理),为后续的问答、推理任务提供基础。

2.4零样本 / 少样本学习能力(Few-shot/Zero-shot Learning)

- 传统 NLP 模型需针对特定任务进行大量标注数据训练,而 GPT 通过预训练阶段积累的通用语言能力,可在零样本(无需示例)或少样本(仅需几个示例)情况下完成新任务。

- 例如,用户无需专门训练模型做 “邮件撰写”,只需输入指令 “写一封请假邮件”,GPT 就能基于预训练学到的 “邮件格式” 和 “语言风格” 生成符合要求的内容。这一能力源于预训练阶段对 “任务描述” 和 “语言模式” 的通用理解。

2.5 自回归生成机制

- GPT 生成文本时采用自回归(Autoregressive)方式:从第一个词开始,每次生成一个词(Token),并将其作为下一个词的输入,循环直至生成完整序列(如句子、段落)。

- 这种机制确保了文本生成的连贯性和逻辑性,符合人类语言的 “顺序表达” 习惯,但也导致生成速度相对较慢(需逐词计算)。

2.6 动态上下文窗口的扩展

- 上下文窗口(Context Window)指模型一次能处理的最大文本长度(以 token 为单位)。早期 GPT-1 的窗口仅为 512 token,而 GPT-4 已支持数万 token(如 128k),意味着模型能 “记住” 更长的对话历史、文档内容或复杂指令。

- 长上下文窗口使其能处理更复杂的任务,如长文档摘要、多轮对话、代码调试(需完整代码上下文)等。

2.7 迭代优化的对齐技术(Alignment)

- 随着模型能力增强,GPT 系列通过技术手段让输出更贴合人类价值观和需求:

- 指令微调:用 “指令 - 响应” 格式的数据(如 “请总结这段话”+ 正确总结)训练模型,使其理解并遵循人类指令。

- RLHF(人类反馈强化学习):通过人类标注员对模型输出的质量打分,训练 “奖励模型”,再用强化学习(如 PPO 算法)优化模型,减少有害、偏见或无关内容。

- 这一技术使 GPT 从 “能生成文本” 升级为 “能生成有用、安全、符合意图的文本”。

GPT 的核心技术特点可概括为:以 Transformer 解码器为架构基础,通过 “预训练 + 微调” 实现通用与专用能力的结合,依托大规模参数和数据支撑泛化性,再通过自回归生成和对齐技术确保输出质量。这些特点共同推动了模型从 “语言理解” 到 “复杂任务处理” 的跨越,成为大语言模型的标杆设计。

3. GPT的工作原理

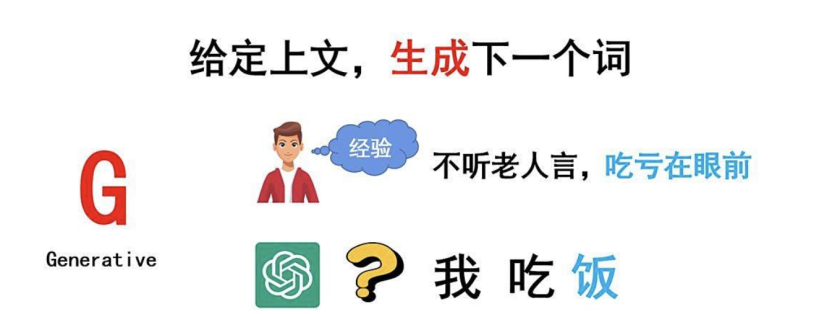

我们来看看"GPT"代表什么含义。为了更好地理解这一点,我们需要了解这个大语言模型是如何工作的。可以简单地概括为:当你提供一段上文时,模型会根据这段上文生成接下来的一个词语。举个例子,假设你有这样一个句子:“我吃饭”,其中“我吃”作为已知的部分(即上文),模型将帮助你生成下一个词语, 在这个例子中就是“饭”。因此,“ChatGPT”的核心功能就是根据给定的上文生成下一个词语。

那么,"GPT"中的"G"代表什么呢?答案是"Generative",意味着生成。这正是模型的工作方式——生成文本。现在我们明白了"G"的含义。

接下来,我们来探讨一下模型是如何生成词语的。当我们听到“不听老人言”的时候,自然而然就会想到下一句是“吃亏在眼前”。这种联想能力源于我们日常生活中的经验。同样地,大型语言模型也需要通过一个过程来获取类似的经验。这个过程就是我们所说的“训练”。

以"ChatGPT"为例,其强大的回答问题能力来自于对海量文本数据的训练。具体来说,它接受了45TB的语言资料训练。为了让大家对这个数字有个概念,举个例子,一个高清电影可能占几GB的空间,而1TB等于1024GB。这意味着45TB的数据非常庞大。但需要注意的是,这些数据全部由文字组成,并非视频或图片。假设我们在电脑记事本里写下10万个汉字,文件大小大约只有几百KB。相比之下,45TB的数据相当于大约450万套《四大名著》的文字内容。这是一个巨大的数字。

训练过程是自动进行的,无需人为干预,这也被称为“无监督学习”。在人工智能领域,机器学习分为三种类型:监督学习、无监督学习和强化学习。无监督学习的特点在于,系统能够自主学习,无需外部指导。

最后,你可能会好奇模型是如何利用这些文本数据进行训练的。显然,它并不能像人类那样阅读书籍。这个问题的答案涉及到了模型内部复杂的算法机制,这些机制使得模型能够分析并学习文本模式,从而实现文本生成的功能。

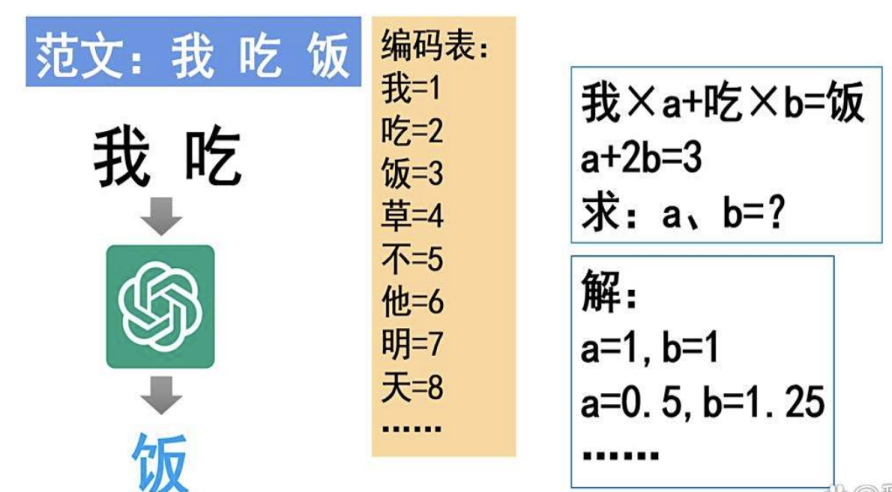

让我们通过一个简单的例子来解释如何训练大模型以生成文本。假设我们要训练模型识别并完成像“四大名著”这样的经典文学作品中的句子。在这个过程中,“范文”就像是学生写作时参考的优秀例文。例如,如果我们有一句范文“我吃饭”,并且我们希望模型在给定“我吃”的前提下能正确生成“饭”这个字,那么它是如何实现这一目标的呢?

首先,我们需要明白计算机处理信息的方式。计算机内部处理的所有信息本质上都是数字。因此,我们需要创建一个“编码表”,将每个字符映射到一个唯一的数字上。比如,可以设定“我”对应数字1,“吃”对应2,“饭”对应3,这只是举例说明,并非实际的编码规则。

有了编码表后,我们就可以开始构建模型的计算逻辑。为了生成“我吃饭”这句话中的“饭”,模型需要解决一个数学问题:找到一组合适的权重(系数),使得输入字符的数字表示与期望输出字符的数字表示之间的关系成立。用数学语言来说,就是寻找一组权重A和B,使得下面的方程成立: 1×A+2×B=3

这里的1、2和3分别代表“我”、“吃”和“饭”的编码值。这是一个二元一次方程,可能存在多个解。例如,A=1,B=1和A=0.5,B=1.25都能满足方程。然而,在训练模型时,关键在于选择那些能够产生预期结果(即“饭”)的解。

这些权重或系数被称为“参数”。对于像ChatGPT这样的大型语言模型而言,它拥有极其庞大的参数数量——约1750亿个参数。这意味着模型能够处理极其复杂的语言结构和模式。在训练过程中,模型通过调整这些参数来学习从给定的上文中预测下一个词的最佳方式。例如,当面对“我不吃草”这样的句子时,模型会根据类似的方程进行计算,以预测出正确的下一个词“草”。

简而言之,训练大模型就像解数学题一样,通过不断地调整参数来找到最佳解,从而生成符合语境的文本。

当我们谈论ChatGPT时,确实有很多人对其表现出的能力感到惊讶,甚至认为它仿佛拥有了人类般的思考和理解能力。这种感觉主要源于其庞大的参数规模——1750亿个参数,这让它能产生出与传统人工智能截然不同的效果。为了帮助理解这种差异,我们可以做一个简化的类比:尽管这种类比并不完全准确,但有助于说明问题。

4. GPT大规模数据训练方法

GPT 的大规模数据训练是一个复杂的系统性工程,核心目标是让模型通过海量文本数据学习语言规律、世界知识和逻辑推理能力。其训练方法围绕数据来源、预处理、训练目标、技术架构四大环节展开,具体流程和技术细节如下:

4.1大规模数据源的选择与构建

GPT 的预训练数据需满足规模大、多样性高、质量可控三大特点,以支撑模型学习通用语言能力。不同版本的 GPT 数据源有所差异,但核心逻辑一致:

核心数据源类型

1. 通用文本语料:包括互联网网页(如 Common Crawl,一个包含数十亿网页的开源数据集)、书籍(如 BooksCorpus、古登堡计划的电子书籍)、论文(如 arXiv、PubMed 的学术文献)、新闻、博客、论坛帖子等。

2. 领域补充数据:为增强特定能力(如代码、逻辑推理),会加入代码库(如 GitHub 开源项目)、数学公式、逻辑推理题等结构化数据。

3. 例如,GPT-3 的训练数据量达 570GB,包含约 4000 亿个 token(注:“token” 是文本的基本单位,可理解为 “词或子词”,英文中 1 个 token 约对应 4 个字符,中文中 1 个 token 约对应 1 个汉字);GPT-4 的数据源进一步扩展,加入了更多多语言文本、长文档和结构化数据。

数据筛选原则

1. 过滤低质量内容:如重复文本(通过哈希去重)、无意义字符、垃圾信息(如广告、乱码)。

2. 平衡多样性:避免单一领域数据占比过高(如网页数据可能包含大量冗余信息,需与书籍等高质量文本混合),确保模型学习到不同风格(正式 / 口语)、不同领域(科技 / 人文)的语言模式。

3. 规避有害内容:提前过滤违法、偏见或低俗文本,减少模型学习不良信息的风险。

4.2 数据预处理:将原始文本转化为模型可理解的格式

大规模原始文本无法直接输入模型,需经过严格预处理,核心目标是统一格式、减少噪声、适配模型输入要求。

文本清洗与标准化

1. 去除特殊符号(如 HTML 标签、表情包)、统一大小写(英文)、处理换行和空格,将长文本分割为连贯的段落。

2. 多语言处理:对非英文文本进行基本校验(如排除乱码),确保语言完整性(如中文分词前的标点符号处理)。

分词(Tokenization):将文本转化为 “数字序列”

1. GPT 采用Byte Pair Encoding(BPE) 分词算法,这是处理大规模多语言文本的关键技术:

1. 原理:将文本拆分为 “子词单元”(如 “unhappiness” 拆分为 “un+happy+ness”),既解决了 “未登录词”(生僻词)问题,又平衡了词汇表大小(GPT-3 的词汇表约 5 万 token)。

2. 优势:对中英文等不同语言兼容性强(中文可拆分为单字或常见词组合),且能高效压缩文本长度(减少输入序列的 token 数量)。

序列截断与填充

1. 模型的 “上下文窗口”(一次能处理的最大 token 长度)有限(如 GPT-1 为 512 token,GPT-4 扩展至 128k token),需将长文本截断为固定长度的序列;短文本则用特殊符号(如<pad>)填充,确保输入格式统一。

4.3 核心训练目标:通过 “预测下一个词” 学习语言规律

GPT 的大规模数据训练以自回归语言建模(Autoregressive Language Modeling) 为核心目标,即让模型通过前文预测下一个 token,具体机制如下:

任务设计

1. 给定一段文本序列(如 “今天天气很好,我打算去____”),模型需预测空白处的 token(如 “公园”“散步”)。训练时,输入序列的每个 token 都会被作为 “目标”,让模型计算其概率分布。

2. 损失函数:采用交叉熵损失(Cross-Entropy Loss),衡量模型预测的 token 与真实 token 的差异,通过反向传播优化模型参数。

掩码自注意力(Masked Self-Attention)

1. 为确保模型 “只能依赖前文信息预测下一个词”(符合自回归生成逻辑),在 Transformer 解码器的注意力层中加入 “掩码”:对于序列中的第 i 个 token,仅允许模型关注第 1 至 i-1 个 token,无法 “偷看” 后文。

2. 例如,预测 “我打算去公园” 中的 “公园” 时,模型只能利用 “今天天气很好,我打算去” 的信息,模拟人类 “边想边说” 的逻辑。

无监督训练的优势

1. 无需人工标注数据(仅需原始文本),可利用互联网上海量免费数据,突破标注成本对数据规模的限制(这是 GPT 能使用千亿级 token 训练的关键)。

4.4 支撑大规模训练的技术架构

面对 “万亿级参数 + 千亿级 token” 的训练需求,单设备无法完成计算,需依赖分布式训练、硬件加速、优化策略三大技术支撑:

分布式训练策略

1. 数据并行(Data Parallelism):将训练数据拆分到多个 GPU/TPU(如 1024 块 GPU),每个设备处理一部分数据,计算局部梯度后汇总更新全局参数,提升数据处理效率。

2. 模型并行(Model Parallelism):将模型参数拆分到不同设备(如 Transformer 的不同层分配给不同 GPU),解决单设备内存无法容纳大规模模型的问题(GPT-3 的 1750 亿参数需 TB 级内存)。

3. 例如,GPT-3 训练使用了微软 Azure 的超级计算机(含 10000+ V100 GPU),通过分布式框架(如 Megatron-LM)协调设备通信与计算。

硬件与加速技术

1. 依赖高性能计算芯片(如 NVIDIA A100/H100 GPU、Google TPU),其高带宽内存(HBM)和张量计算核心(Tensor Cores)可高效处理矩阵运算(Transformer 的核心计算)。

2. 采用混合精度训练(如 FP16/FP8 精度):在不显著损失模型精度的前提下,减少内存占用和计算量,提升训练速度(比 FP32 精度快 2-4 倍)。

优化器与训练策略

1. 优化器:使用 Adam 优化器(自适应学习率),动态调整每个参数的更新幅度,避免训练波动。

2. 学习率调度:采用 “线性预热 + 余弦衰减” 策略,初期缓慢提升学习率(避免参数震荡),后期逐渐降低(稳定收敛)。

3. 梯度累积:当单步 batch size(批次大小)受限于设备内存时,累计多步梯度后再更新参数,等效于增大 batch size(提升训练稳定性)。

4. ** checkpoint 机制 **:定期保存模型参数,避免因设备故障导致训练中断(GPT-3 训练耗时数月,需频繁 checkpoint 备份)。

4.5 训练过程的迭代与优化

大规模训练并非 “一次性跑完所有数据”,而是通过多轮迭代逐步优化:

多 epoch 训练

1. 将全部训练数据重复训练多轮(epoch),让模型反复学习数据中的规律(如 GPT-3 训练了约 300 epoch)。随着训练轮次增加,模型损失逐渐下降,语言生成能力逐步提升。

数据混洗(Shuffling)

1. 每轮训练前随机打乱数据顺序,避免模型 “记住” 固定序列,增强泛化能力(防止过拟合)。

增量训练(Incremental Training)

1. 后续模型(如 GPT-4)可在前期模型(如 GPT-3)的参数基础上继续训练,利用已有知识减少重复计算,同时加入新数据(如多语言、代码)扩展能力边界。

GPT 的大规模数据训练是 “数据规模 + 预处理技术 + 训练目标 + 分布式架构” 的协同结果:通过海量多样的文本数据为基础,经 BPE 分词和掩码机制适配模型输入,以自回归预测为目标学习语言规律,最终依靠分布式计算和硬件加速支撑千亿级参数的优化。这一过程的核心是 “用数据规模换能力泛化性”—— 通过足够多的样本,让模型从统计规律中 “涌现” 出理解、推理、生成等复杂能力。

5. GPT模型参数优化策略

GPT 模型的参数优化是训练过程的核心环节,目标是通过调整千亿级参数(如权重、偏置)最小化损失函数,同时确保模型收敛稳定、泛化能力强。由于模型规模庞大(如 GPT-3 含 1750 亿参数),传统优化方法难以直接适用,需结合优化器改进、学习率调度、正则化、分布式计算等策略协同实现。以下是具体的参数优化策略及在 GPT 中的应用细节:

5.1优化器的选择与改进:适配大规模参数的高效更新

优化器是参数更新的 “引擎”,GPT 需平衡更新效率、收敛稳定性和内存占用,核心采用基于梯度的自适应优化器及其变体:

Adam 与 AdamW:主流选择

1. 基础原理:Adam(Adaptive Moment Estimation)结合了动量(Momentum)和自适应学习率(RMSprop)的优势,通过累积梯度的一阶矩(均值)和二阶矩(方差),动态调整每个参数的更新步长,适合非凸优化问题(大型语言模型的损失函数高度非凸)。

2. GPT 的改进:AdamW:在 Adam 基础上分离 “权重衰减(Weight Decay)” 与梯度更新,避免传统 L2 正则化对梯度的干扰。例如,GPT-3 明确使用 AdamW,权重衰减系数设为 0.01,有效抑制过拟合。

相比传统优化器的优势

1. 对比 SGD(随机梯度下降):AdamW 收敛速度更快,且对学习率初始值不敏感(无需反复调参),适合千亿级参数的快速迭代;

2. 对比 RMSprop:加入动量项(一阶矩),减少更新方向的震荡,提升训练稳定性(尤其在大规模数据训练中)。

5.2学习率调度:动态调整更新步长,平衡收敛速度与稳定性

学习率是控制参数更新幅度的核心超参数:过大易导致训练震荡(不收敛),过小则收敛缓慢。GPT 采用分段式调度策略,根据训练阶段动态调整:

预热(Warmup)阶段

1. 目的:训练初期模型参数随机初始化,梯度波动大,需缓慢提升学习率以避免参数 “跑偏”。

2. GPT 的实现:采用线性预热,例如 GPT-3 在训练前 1000 步将学习率从 0 逐步提升至峰值(6e-5),确保模型平稳进入学习状态。

衰减(Decay)阶段

1. 目的:训练中后期,模型接近收敛,需减小学习率以精细调整参数,避免在最优解附近震荡。

2. GPT 的选择:余弦衰减:学习率随训练步数按余弦函数规律下降(而非线性衰减),后期下降速度放缓,给参数留出微调空间。例如,GPT-3 在预热后,学习率从 6e-5 按余弦曲线衰减至接近 0,最终训练步数达 37 亿步时完成收敛。

关键参数:预热步数(通常为总步数的 1%-5%)、峰值学习率(需根据模型规模调整,参数越多则峰值越低,避免梯度爆炸)。

5.3 正则化策略:抑制过拟合,提升泛化能力

大规模参数模型易 “记住” 训练数据细节(过拟合),需通过正则化约束参数复杂度,GPT 的核心策略包括:

权重衰减(Weight Decay)

1. 原理:在损失函数中加入参数 L2 范数的惩罚项(如λ×∑w2),促使参数值更小(更 “简单”),减少过拟合风险。

2. GPT 的应用:通过 AdamW 实现,权重衰减系数(λ)设为 0.01(GPT-3),直接作用于模型所有权重参数(如 Transformer 的注意力矩阵、前馈网络权重)。

Dropout:随机失活

1. 原理:训练时随机 “关闭” 部分神经元(如注意力层或前馈网络中的激活单元),迫使模型学习更鲁棒的特征(不依赖特定神经元)。

2. GPT 的实现:在 Transformer 的前馈网络(FFN)和残差连接后加入 Dropout,概率通常为 0.1(如 GPT-2)。注意:注意力层较少使用 Dropout,避免破坏上下文依赖的学习。

数据增强间接辅助

1. 虽然不属于参数优化,但训练数据的随机截断、顺序混洗(Shuffling)可减少模型对固定序列的依赖,间接增强正则化效果(与参数优化协同作用)。

5.4 分布式参数优化:突破硬件限制,支撑千亿级参数更新

GPT 的参数规模远超单设备内存(如 1750 亿参数需约 700GB 内存,单 GPU 内存通常为 80-160GB),需通过分布式计算拆分参数和梯度,核心策略包括:

数据并行(Data Parallelism)

1. 机制:多设备(如 1024 个 GPU)同时训练不同批次的数据,各自计算局部梯度后,通过 “梯度同步”(如 AllReduce 算法)汇总全局梯度,再统一更新参数(所有设备保持相同参数)。

2. 优势:不拆分模型结构,实现简单,适合数据量巨大的场景(如 GPT 的千亿 token 训练)。

3. 挑战:梯度同步的通信成本高,需依赖高速网络(如 NVLink)降低延迟。

模型并行(Model Parallelism)

1. 机制:将模型按层拆分到不同设备(如 Transformer 的前 10 层在 GPU1,后 10 层在 GPU2),每个设备仅存储部分参数和计算对应梯度,通过层间通信传递中间结果。

2. 应用:GPT-3 等超大规模模型采用 “数据并行 + 模型并行” 混合策略(如 8 路模型并行 ×128 路数据并行),既拆分参数(解决内存限制),又并行处理数据(提升效率)。

梯度累积(Gradient Accumulation)

1. 当单设备批次大小(Batch Size)受限时,累计多步(如 8 步)的局部梯度后再更新参数,等效于增大批次大小(提升训练稳定性)。例如,GPT-3 单步 Batch Size 为 3.2 万 token,通过 8 步累积后等效于 25.6 万 token,增强梯度估计的准确性。

5.5 稳定性优化:避免训练崩溃,保障收敛

大规模参数训练中,梯度爆炸、数值溢出等问题易导致训练中断,GPT 通过以下策略保障稳定性:

梯度裁剪(Gradient Clipping)

1. 原理:当梯度的 L2 范数超过阈值(如 1.0)时,按比例缩放梯度,避免参数更新幅度过大导致模型震荡。

2. 应用:GPT 在反向传播后对梯度进行裁剪,尤其在训练初期(梯度波动大时)效果显著。

混合精度训练(Mixed Precision Training)

1. 机制:用 16 位浮点数(FP16)存储参数和计算梯度,32 位浮点数(FP32)保存梯度更新的一阶矩和二阶矩(避免精度损失),减少内存占用(约 50%)和计算耗时(提升 2-4 倍)。

2. 关键:通过 “损失缩放(Loss Scaling)” 防止 FP16 梯度下溢,确保梯度更新有效。GPT-3 及后续版本均采用混合精度训练,依赖 NVIDIA 的 AMP(Automatic Mixed Precision)工具实现。

Checkpoint 机制

1. 定期(如每 1000 步)保存模型参数和优化器状态,若训练中断(如硬件故障),可从最近的 Checkpoint 恢复,避免重复计算(GPT-3 训练耗时数月,Checkpoint 是核心保障)。

GPT 的参数优化策略围绕 “大规模、高效率、强稳定” 三大目标设计:通过 AdamW 实现自适应参数更新,结合分段学习率调度平衡收敛速度;用权重衰减和 Dropout 抑制过拟合;依托分布式并行突破硬件限制;最终通过梯度裁剪、混合精度等技术保障训练不崩溃。这些策略的协同作用,使得千亿级参数模型能在海量数据上稳定收敛,并 “涌现” 出复杂的语言理解和生成能力。

本文来自博客园,作者:limingqi,转载请注明原文链接:https://www.cnblogs.com/limingqi/p/18993985

浙公网安备 33010602011771号

浙公网安备 33010602011771号