linux系统部署deepseek大模型

随着AI Deepseek大模型的发展,在企业内部都在进行落地、集群部署,大模型集群构建成功,如何实现统一访问呢?可以引入Nginx+Deepseek大模型负载均衡集群。

首先要部署Deepseek大模型,需借助Ollama模型框架,通过Ollama模型框架去拉取Deepseek模型。部署Ollama+Deepseek方法和指令如下:

#从Ollama官网下载软件包;

ls -l ollama-linux-amd64.tgz

#创建Ollama程序部署目录

mkdir -p /usr/local/ollama/

#通过Tar工具对其解压;(-x extract解压,-z gzip压缩格式,-v verbose详细显示,-f file文件属性)

tar -xzvf ollama-linux-amd64.tgz -C /usr/local/ollama/

#查看Ollama程序是否部署成功

ls -l /usr/local/ollama/

#将Ollama程序bin目录加入到PATH环境变量中

cat>>/etc/profile<<EOF export PATH=\$PATH:/usr/local/ollama/ EOF

#使其PATH环境变量重新生效

source /etc/profile

#启动Ollama服务进程

nohup /usr/local/ollama/bin/ollama serve &

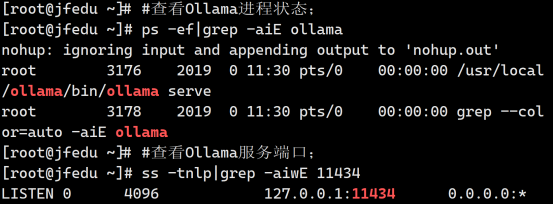

#查看Ollama进程状态

ps -ef|grep -aiE ollama #查看Ollama服务端口; ss -tnlp|grep -aiwE 11434

根据如上Ollama程序指令操作,Ollama软件服务部署成功,查看其进程和端口,如图所示:

浙公网安备 33010602011771号

浙公网安备 33010602011771号