第七周作业:注意力机制的学习

因为这两周准备的考试较多,泛读论文还是有很多费解的地方,这两周考完试后会继续抓紧这方面的学习。

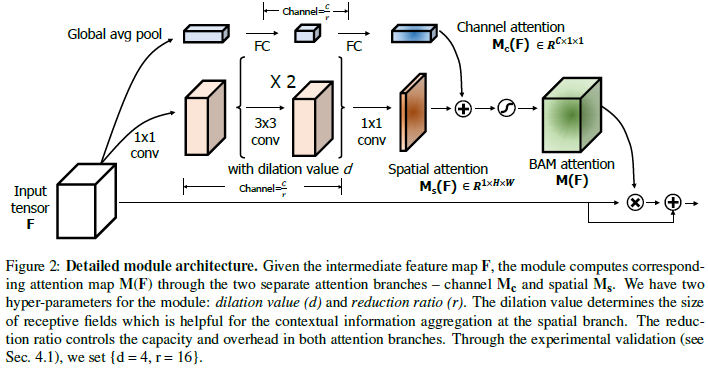

【BMVC2018】BAM: Bottleneck Attention Module

提出了放置在网络瓶颈处的瓶颈注意模块 (BAM)。模型通过两个分离的路径 channel和spatial, 得到一个Attention Map,实验验证了我们算法的有效性。

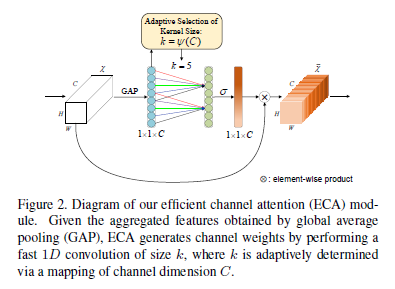

【CVPR2020】ECA-Net: Efficient Channel Attention for Deep Convolutional Neural Networks

提出了一种用于深层CNN的有效通道注意(ECA)模块,该模块避免了维度缩减,并有效捕获了跨通道交互。在不降低维度的情况下进行逐通道全局平均池化之后,ECA通过考虑每个通道及其k个近邻来捕获本地跨通道交互 。ECA可以通过大小为k的快速一维卷积有效实现,其中内核大小k代表本地跨通道交互的覆盖范围,即有多少个相近邻参与一个通道的注意力预测。我们提出了一种自适应确定k的方法,其中交互作用的覆盖范围(即内核大小k)与通道维成比例。

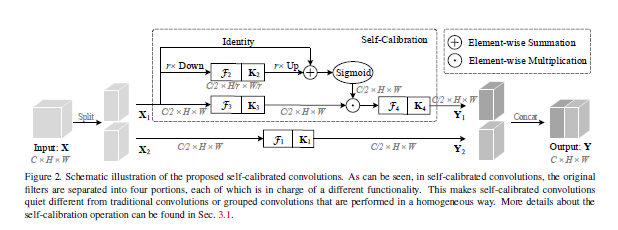

【CVPR2020】Improving Convolutional Networks with Self-Calibrated Convolutions

提出了一种新的自校准卷积,它能够异构地利用嵌套在卷积层中的卷积滤波器。

自校正卷积不是通过均匀地对原始空间中的输入执行所有卷积,而是首先通过下采样将输入转换为低维嵌入。采用由一个卷积核变换的低维嵌入来校准另一部分中卷积核的卷积变换。得益于这种异构卷积和卷积核间通信,可以有效地扩大每个空间位置的感受野。空间上的每一个点都有附近区域的信息和通道上的交互信息,同时也避免了整个全局信息中无关区域的干扰。

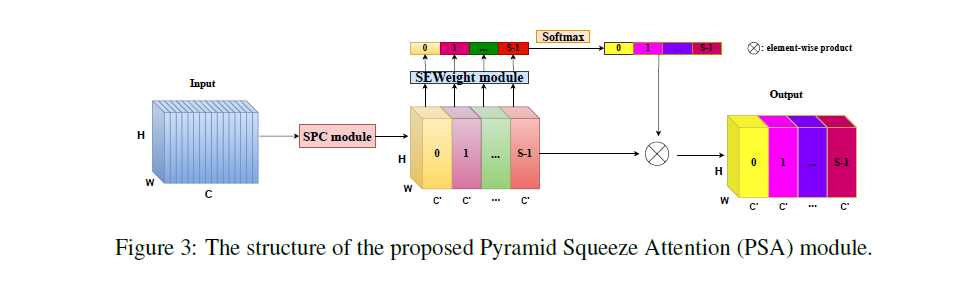

【ARXIV2105】Pyramid Split Attention

在本文中,提出了PSA的有效且轻量级的即插即用注意力模块。 所提出的PSA模块可以充分提取通道注意力向量中的多尺度空间信息和跨维度的重要特征。 提出的 EPSA)块可以在更细粒度的级别上提高多尺度表示能力,并开发远程通道依赖性。 提出的 EPSANet 可以有效地整合多尺度上下文特征和图像级分类信息。

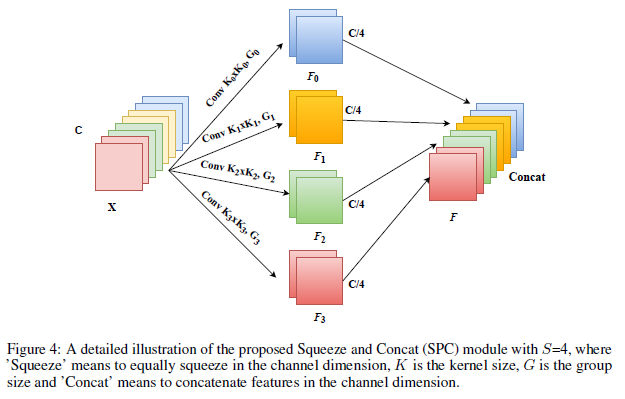

PSA模块主要分四步实现。 首先,通过实施所提出的SPC 模块获得通道上的多尺度特征图。 其次,通过使用SEWeight模块提取不同尺度特征图的attention,得到channel-wise attention vector。 第三,通过使用Softmax重新校准通道方向的注意力向量,获得多尺度通道的重新校准权重。 第四,将逐元素乘积的操作应用于重新校准的权重和相应的特征图。最后,可以得到一个多尺度特征信息更丰富的细化特征图作为输出。

SPC:

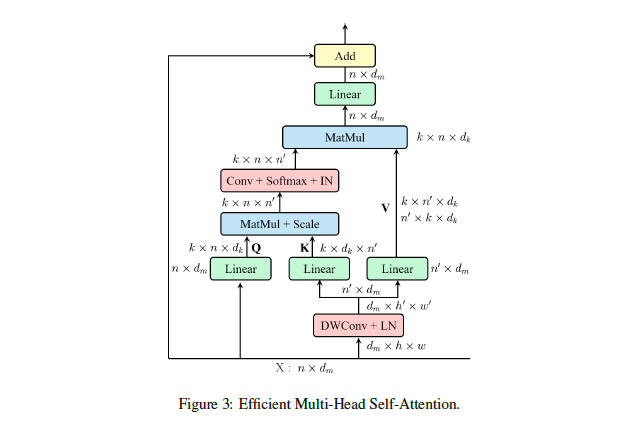

【ARXIV2105】ResT: An Efficient Transformer for Visual Recognition

本文提出了一种称为 ResT 的高效多尺度视觉变换器,它能够作为图像识别的通用主干。 与现有的 Transformer 方法使用标准 Transformer 块来处理具有固定分辨率的原始图像不同,我们的 ResT 有几个优点:(1)构建了一个内存高效的多头自注意力 (2) 位置编码被构建为空间注意力,更灵活,可以处理任意大小的输入图像,无需插值或微调; (3) 不是在每个阶段开始时直接进行标记化,而是将补丁嵌入设计为在标记图上具有步幅的重叠卷积操作的堆栈。

浙公网安备 33010602011771号

浙公网安备 33010602011771号