Self-Supervised Masked Convolutional Transformer Block for Anomaly Detection概述

0.前言

1.针对的问题

这篇论文主要是在作者之前的工作,自监督预测卷积注意块(SSPCAB),基础上进行改进,使用一个3D掩码卷积层,以及一个用于通道级注意的transformer将其扩展为自监督掩码卷积transformer块(SSMCTB),提升了适用性与性能。

2.主要贡献

这里的贡献是相对于SSPCAB来看,包括5点:

•将2D掩码卷积扩展到考虑3D上下文的3D掩码卷积,并将新的3D SSMCTB集成到两个3D网络中,用于异常检测。

•将SSPCAB的Squeeze-and-Excitation模块替换为执行通道注意力的transformer模块。

•进行了一组更全面的实验,包括一种新方法和两个来自以前缺失领域(医学图像、热视频)的新基准。

•提供了广泛的消融研究,包括提出的自监督区组的不同变体。

•用异常标签注释了Drift数据集中Seasons的一个子集(一周的视频),获得了热视频异常检测的新基准。

3.方法

总体结构与SSPCAB类似,不过将2D掩码卷积扩展到考虑3D上下文的3D掩码卷积,Squeeze-and-Excitation模块替换为执行通道注意力的transformer模块。

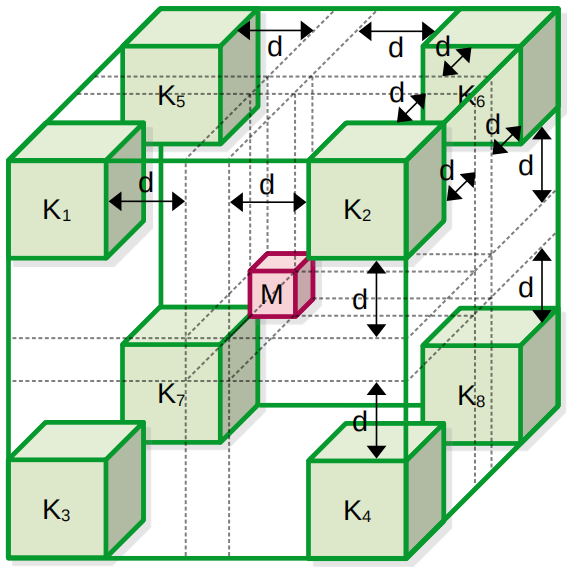

3D掩码卷积就是在2D的基础上增加一个维度,如下:

channel-wise transformer块:

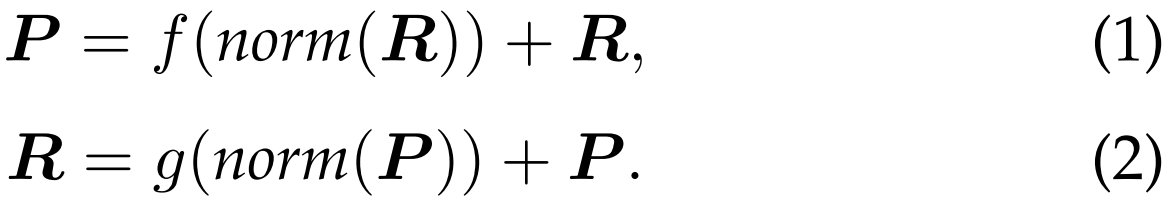

设f是一个多头注意力层,有H∈N+个头,g为多层感知器,norm为归一化层,P, R∈Rc×dt是一些辅助张量。在transformer内部执行的操作为:

将等式(1)和等式(2)所描述的整个过程重复L次,其中L∈N+ 表示transformer模块内的transformer块的数量。对于第一个transformer块,R用T∗初始化。在式(1)中,将c个token的序列R归一化,送入多头注意力层并与自身相加,得到P。进一步,将P归一化,输入多层感知器,并根据等式2对自身进行相加。最后一个transformer块返回的输出序列R沿着token维度进行平均,得到![]() ∈Rc×1。

∈Rc×1。

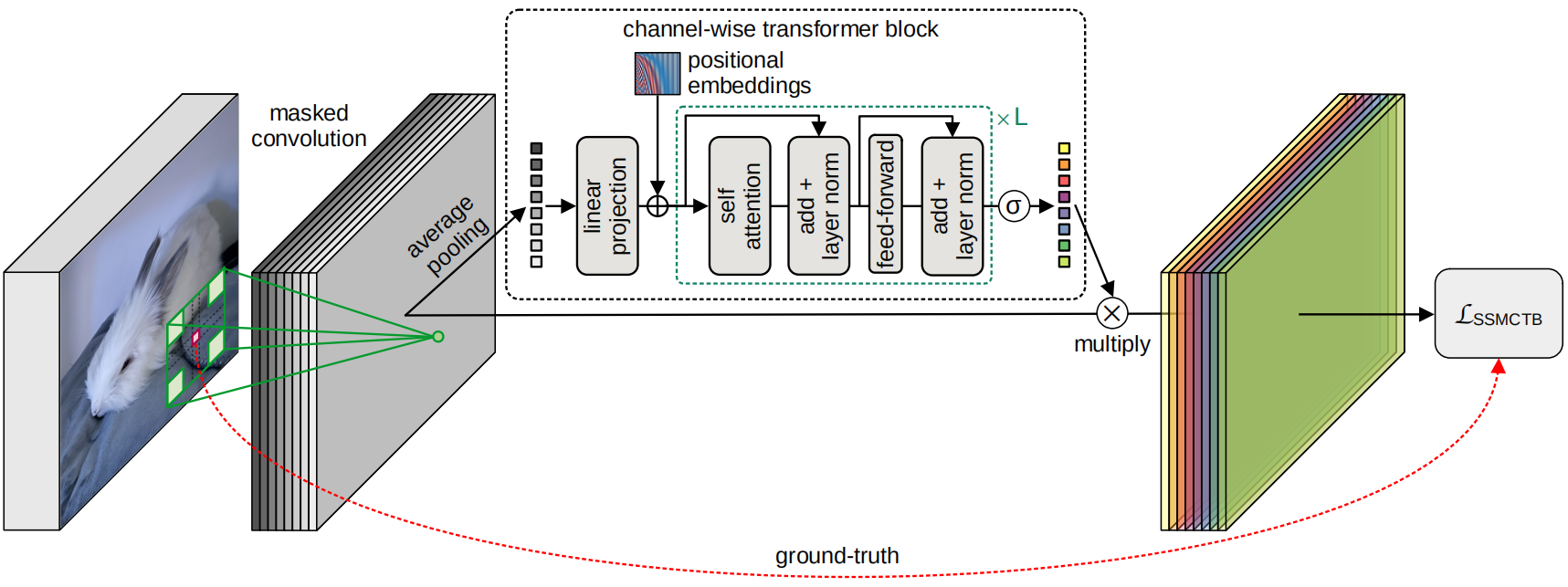

模型结构如下:

设X∈Rh×w×r×c为掩码卷积层的输入张量,其中c为通道数,h和w分别为高度和宽度,r为深度,除了输入数据和内核本身都是3D的之外,3D过滤器与2D过滤器的使用类似,得到输出张量Z∈Rh×w×r×c。

对于2D掩码卷积的输出应用空间平均池化,得到![]() ∈Rh'×w'×c,其中h'≤h,w'≤w,然后进行reshape操作,得到矩阵A∈Rc×n,每行包含一个n=h'·w'的矢量,以表示每个掩码滤波器。接下来,将A输入到线性投影层中,获得token T∈Rc×dt,再与位置嵌入相加,得到最终的token T∗ ∈Rc×dt 。然后输入channel-wise transformer块,得到

∈Rh'×w'×c,其中h'≤h,w'≤w,然后进行reshape操作,得到矩阵A∈Rc×n,每行包含一个n=h'·w'的矢量,以表示每个掩码滤波器。接下来,将A输入到线性投影层中,获得token T∈Rc×dt,再与位置嵌入相加,得到最终的token T∗ ∈Rc×dt 。然后输入channel-wise transformer块,得到![]() ∈Rc×1,

∈Rc×1,![]() 输入到sigmoid层,生成分配给每个通道的最终注意力权重。最后,将得到的注意力权值应用于张量Z,得到以

输入到sigmoid层,生成分配给每个通道的最终注意力权重。最后,将得到的注意力权值应用于张量Z,得到以![]() ∈Rh×w×c表示的重构输出。

∈Rh×w×c表示的重构输出。

浙公网安备 33010602011771号

浙公网安备 33010602011771号