Convex Combination Consistency between Neighbors for Weakly-supervised Action Localization

弱监督动作定位中相邻凸组合一致性

0.前言

-

相关资料:

-

github

-

论文解读

-

论文基本信息:

-

领域:弱监督时序动作定位

-

发表时间:arxiv 2022(2022.5.1)

摘要

在弱监督时间动作定位(WS-TAL)中,这些方法通常遵循“分类定位”过程,该过程使用片段预测来形成视频类分数,然后优化视频分类损失。在此过程中,片段预测(或片段注意力权重)用于分离前景和背景。然而,片段预测通常是不准确的,因为没有帧级标签,然后整体性能受到阻碍。在本文中,我们提出了一种新的C3BN以实现鲁棒的片段预测。C3BN通过探索视频数据的固有特征包含了两个关键设计。首先,由于相邻片段的自然连续性,我们提出了一种利用相邻片段的凸组合来增加片段多样性的微观数据增强策略。其次,我们提出一种宏观-微观一致性正则化策略,使模型在视频语义,片段预测和片段特征的转换方面保持不变(或等变)。实验结果证明了我们提出的方法在视频级和点级监督的WS- TAL任务的基线上的有效性。

1.介绍

时间动作定位(TAL)是一项任务,用于定位动作示例的开始和结束时间戳,并识别它们的类别。近年来,许多工作投入了全监督的方式,取得了很大的成绩。然而,这些全监督的方法需要大量的手动帧级标注。为了解决这个问题,提出了许多弱监督的TAL (简称WS-TAL)方法,探索在弱监督的情况下,检测给定视频中的动作示例的有效方法。在各种弱监管中,视频级标签是最常用的。

大多数现有的方法将WS-TAL描述为一个视频动作识别问题。具体来说,每个输入视频首先被转换成片段特征,然后根据片段进行分类,以生成时序类激活序列(T-CAS)。因为只有视频动作标签是已知的,所以它们从属于该动作的概率很高的片段中汇总分数,形成视频分类分数。为此,有两种主要的策略:多示例学习(multi-instance learning, MIL) [Lee等人, 2020]或注意力机制[Huang等人, 2021]。前一种策略通过对每个类的top-k值应用池化,从T-CAS获得视频级别的类分数。后面的策略引入了片段注意力权重,以突出显示动作片段并消除不相关的背景片段。这两种策略都以使用视频标签的分类损失告终。尽管做了很多努力,这些方法的性能还是依赖于snippet级别预测的质量(包括注意力权重)。然而,在缺乏帧级监督的情况下,WS-TAL模型很难获得准确的片段预测。

在本文中,我们提出了一种简单而有效的训练策略,称为近邻间的凸组合一致性(C3BN),它的目标是实现可靠的片段预测。C3BN的核心思想是利用视频内在的平滑性来进行有效的模型正则化。所谓的“平滑”,我们指的是真实视频中的场景通常会平滑地变化。在此基础上,我们提出了一个微观的(我们所说的“微”,是指所提出的数据增强策略是用于视频片段,而不是视频)数据增强策略,其中,我们通过凸组合混合相邻的片段对(称为父片段),并生成一组新的片段(称为子片段)。该操作借鉴自MixUp[Zhang等人,2018],但也有一些具体任务insight。具体来说,由于视频本身的平滑性,子片段有两个重要的属性。1)它们与真实的片段相似,因为相邻的片段通常在视觉上相似。2)它们的时间位置位于父片段之间。更重要的是,与父片段相比,子片段具有更多不同的时间位置。这两个属性提供了在潜在表示的相邻片段之间探索更多模式的潜力,从而提高了模型对相邻片段之间的数据点的泛化能力。

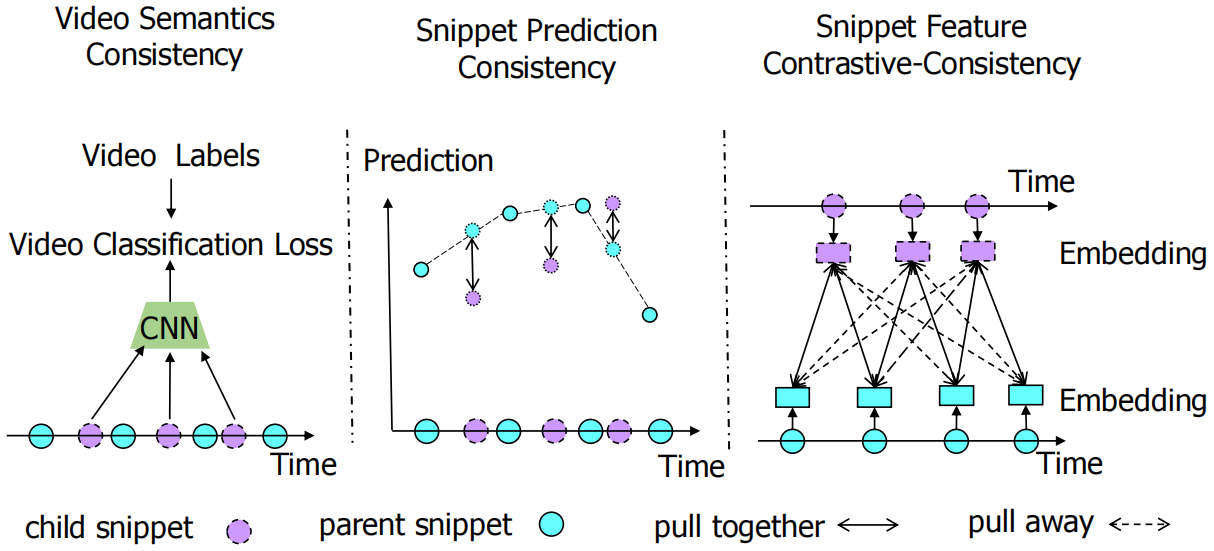

图1:不同一致性正则化示意图。

一个自然要问的问题是:如何在训练期间利用子片段进行模型正则化?为了实现这个目标,我们设计了宏-微观一致性正则化策略(如图1所示),旨在使模型拥有三个所需的属性。1)视频语义的一致性或不变性。我们计算子片段序列上的视频分类损失,使子片段的视频级语义与原始的一致。由于子片段更加模糊,模型被迫将更多的注意力放在非显著的动作片段上,从而减少了背景的假警报。2)片段预测一致性或等方差。基于视频的自然平滑性,我们认为模型也应该在相邻片段之间平滑运行。也就是说,我们强制子片段的预测与父片段预测的凸组合保持一致。这种正则化有两个优点。首先,它迫使模型学习将相邻片段之间的决策边界变平,这可以提高受干扰片段预测的稳定性,从而在给定的测试数据集上实现精确的动作边界定位。其次,它可以减少相邻片段/视觉上相似的片段之间的差异,从而在时间维度上产生更连续的预测。3)片段特征对比一致性。受图像聚类[Do等人, 2021]的启发,表示学习是分类器学习的补充,我们建议进一步正则化模型的中间特征。更重要的是,我们将特征一致性正则化集成到对比学习方案中。在示例(片段)判别的帮助下,该模型可以保留信息,以识别分离片段的细节,这对于视频中的前景和背景分离特别重要。通过进一步施加一致性约束,表示进一步学习自动将语义相似的片段分组在一起。为了同时达到这两个目的,我们引入了一种软版本的基于InfoNCE的对比损失。此外,我们设计了一种双向参考机制,其中子片段和父片段交替query。

提出的C3BN网络简单,灵活,通用。首先,它是对现有的WS-TAL方法的补充。我们证明了我们的方法在各种基础方法和数据集上得到了显著的改进。此外,我们的方法适合与多尺度测试技术相结合,并且与基线相比获得了更显著的性能增益。最后,我们将我们的方法扩展到点监督WS-TAL任务,并观察到性能上的相同提升。我们的贡献总结如下:

•考虑到邻近片段在WS-TAL任务中的关键作用,我们提出了一种新颖的通过相邻片段间的凸组合实现片段扩展的策略。

•我们提出了三个正则化项来增强视频语义,片段预测和片段特征方面的一致性。

•所提出的策略是通用的,可以应用于具有视频级监督和点级监督的各种WS-TAL方法。

2.相关工作

数据扩充 目的是使用转换来扩大训练集合。传统的图像变换包括裁剪,翻转,旋转等。最近的研究考虑使用多幅图像进行增强。MixUp [Zhang等人, 2018]提出通过线性插值将两幅图像的像素值和标签结合起来。它已被证明对分类任务有效,紧随其后的是[Verma等人, 2019]。我们的方法采用了示例与特定任务设计相结合的思想。具体来说,我们实现了在一个视频中的两个片段上的混合操作,而不是在两个不同的视频上进行同样的混合操作,这使得将所提出的方法合并到现有的WS-TAL框架中更容易控制对片段的扰动。

一致性正则化在半监督学习(SSL)中至关重要。假设分类器对未标记样本进行增广后输出的类概率相同。之前的研究[Laine and Aila, 2017]将一致性正则化损失应用于未标记样本的不同增大量。在那之后,有几个变体[Berthelot等人,2019;Sohn等人, 2020]进一步建议延长其应用范围。其中,[Berthelot等人, 2019]也使用MixUp,将未标记的样本与他们猜测的标签进行混合。我们的方法与他们的主要区别在于我们没有对未标记样本的硬标签进行猜测,从而减少了不良噪声。

自监督的对比学习在训练前已经引起了广泛的注意力。被广泛采用的对比学习[Chen等人,2020;He等人,2020]通过示例判别优化模型。具体来说,它学会了嵌入相同图像的不同增强版本的特征,使其相似,而如果它们来自不同的图像,则不同。最近的一些研究[Kim等人,2020]利用了MixUp的思想进行对比学习。我们的方法与这些方法的不同之处在于:(1)上述方法将混合样本作为query,将原始样本作为key,同时我们还考虑了一个反向操作来交换它们的角色。(2)在我们的方法中,负样本和正样本来自于同一个视频,这些负样本可以被视为难负样本,这在对比学习中很重要[Robinson等人, 2020]。

弱监督时间动作检测是为了解决弱监督设置下的时间动作定位问题,视频标签是实践中最常见的监督方式。现有的模型大多遵循“分类定位”的过程,通过聚合帧类分数来产生视频预测。BsS-Net[Lee等人,2020]引入了一个用于背景和抑制背景帧激活的辅助类。同时,FAC-Net[Huang等人, 2021]考虑了前景动作一致性,并对双边关系进行了建模。另一种方法注意到了对比学习。CoLA[Zhang等人, 2021]形成难-易片段对比对,并通过其提出的对比损失进行特征细化。它与我们的显著不同之处在于,它依赖于伪动作标签来定义阳性对和阴性对,而我们将它定义为一个示例辨别任务。近年来,点监督成为新的研究热点。SF-Net [Ma等人, 2020]挖掘伪动作和背景帧。最近,LACP[Lee和Byun, 2021]通过可能包含完整动作示例的密集伪标签提高了性能。

3.WS-TAL方法回顾

为了自洽,我们首先描述主流方法的基本流程,这些方法被用作我们的基线。

对于一个未修剪的视频V,我们只能访问它的one-hot视频标签y={yi}Ci=1,其中C表示类的个数。按照通常的做法,我们首先将V分成不重叠的片段,即 S={St}Tt=1。对于每个片段st,我们应用一个预训练的特征提取器分别为RGB和光流提取两个特征向量fRt,fOt。然后我们将序列{fRt}Tt=1和{fOt}Tt=1进行叠加,得到一个RGB特征映射FR和一个光流特征图FO。以前的方法连接FR 和FO 或在将它们输入后续网络之前分别独立处理FR 和FO。为了简单起见,在本文的其余部分,我们使用F来表示输入特征序列。这里F∈RT×Df ,Df 是通道维度。

特征嵌入 由于提取的特征F在W-TAL任务中没有从头开始训练,主流方法进一步引入了特征嵌入模块,将提取的视频特征映射到特定任务的特征空间。具体地说,它们通常应用一些一维卷积层来将原始特征F∈RT×Df映射到特定任务特征E=[e1,...,eT]∈RT×De。

片段分类 为了定位动作示例,主流方法从嵌入特征E计算T-CAS。具体来说,他们将E输入到一个C+1类片段分类器预测片段分类logit分数S=[s1,...,sT]∈RT×(C+1),每个片段都有自己的分类分数st=[st,1,..,st,C+1]∈RC+1。注意,第(C+1)个类表示背景类。

视频分类 由于我们只有视频标签,所以我们首先聚合片段分数来获得视频类分数,以便计算视频分类的损失。文献中获取视频分数的策略主要有两种:基于MIL的方法和基于注意力的方法。在不失一般性的情况下,本文只回顾了MIL-based方法的基本流程。

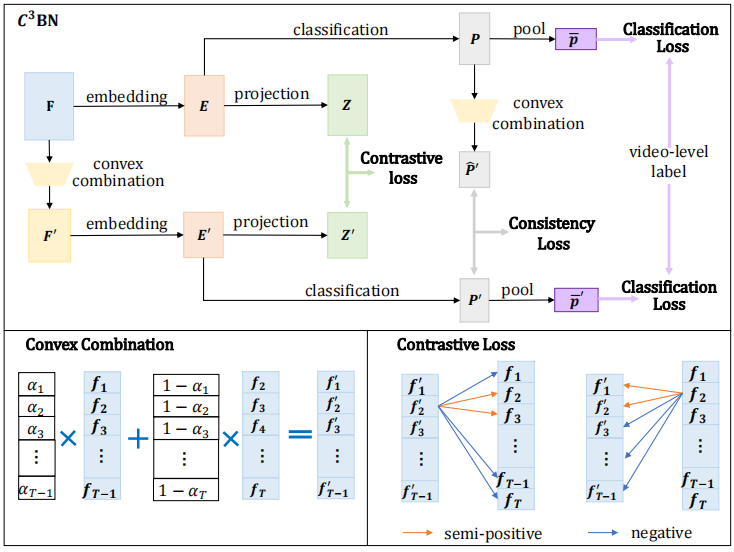

图2:我们提出的C3BN。我们首先对输入片段特征F进行凸组合,生成增强的片段特征F'。该过程称为微数据增强。然后我们同时将F和F'输入模型并计算四项正则化损失项。我们称这个过程为宏-微观一致性正则化。

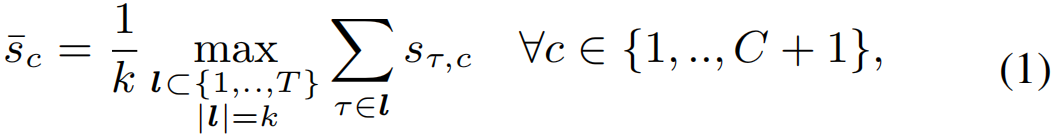

这些方法沿时间维度平均每个类的top-k片段得分,以构建视频类得分:

其中k是与视频长度T成比例的超参数,即k=max(1, T//r), r为预定义参数。然后,我们通过对聚合分数应用Softmax函数,得到每个类的概率:

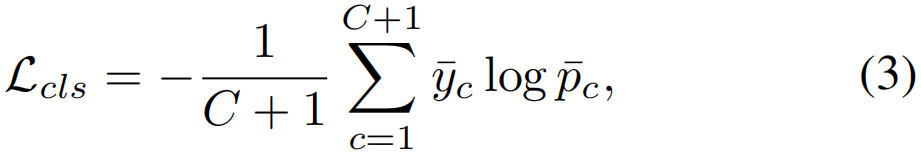

最后我们将视频分类损失表示为

其中![]() =[y1,……yC,1]∈RC+1。背景类的标签设置为1,因为所有训练视频都包含背景帧。

=[y1,……yC,1]∈RC+1。背景类的标签设置为1,因为所有训练视频都包含背景帧。

4.我们的方法

在本节中,我们将介绍我们提出的C3BN。我们提议的C3BN如图2所示。在C3BN中有两个过程,包括微观数据增强和宏微观一致性正则化。

4.1微数据增强

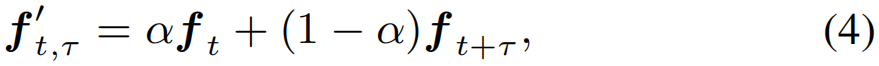

在原始的T个片段特征{ft}Tt=1上,我们对相邻的片段特征进行凸组合,形式化地生成增广的片段特征,

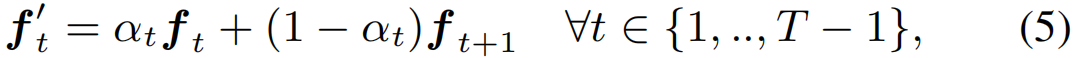

其中f't,τ是子片段,{ft, ft+τ}是父片段。权重α∈(0,1)从beta分布beta (γ, γ)中随机抽样。这里γ是一个预设的正标量。τ是时间距离,τ∈{1,…TM},其中,TM是两个相邻片段的最大距离,TM«T。在本文中,我们根据经验将TM设置为1。然后对于长度为T的片段序列,我们可以得到T−1个子片段如下

其中,α=[α1,..,αT−1]∈RT−1是不同的随机权值。子片段{f't}T−1t=1被连接起来,形成一个名为F'∈R(T−1)×Df的特征图

4.2宏微观一致性正则化

为了使子片段参与到训练中来与父片段合作,我们引入了三个正则化项来共同正则化学习过程。

视频语义一致性 与原始F相比, F' 是一个局部移位版本,而视频语义应该保持不变。因此,我们可以将F'输入进网络,得到与Lcls相同形式的视频分类损失。我们用L'cls表示损失。显然,子片段序列更难识别,然后模型被迫发现来自“非显著”区域的动作片段。避免模型只关注几个判别片段是有帮助的,从而提高片段分类的准确性。然而,这种宏观正则化忽略了子片段和父片段之间的良好关系。为此,我们建议从更微观的角度进一步规范网络。

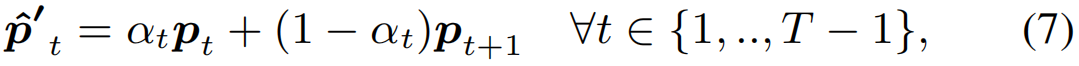

片段预测一致性 在SSL中已经表明,条件概率分布沿其边际分布的流形平滑地变化[Belkin等人,2006]。在这里,我们假设类似的结论也适用于我们的情况,即,模型应该对相邻片段之间的数据点输出平滑的预测。此外,这种特征还与视频的自然平滑性相一致。具体来说,我们首先用一个Softmax操作将片段的logit分数S归一化为

其中P=[p1,...,pT]∈RT×(C+1)为归一化序列。通过将f'输入同一网络,我们可以得到另一个得分序列p'。为了桥接P和p',我们在P上应用凸组合得到被称为![]() 的P的移位版本。在形式上,

的P的移位版本。在形式上,

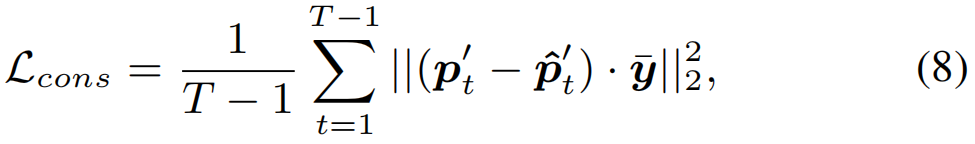

然后我们应用MSE损失来加强p'和![]() 之间的一致性。在形式上,

之间的一致性。在形式上,

在这里,我们只计算视频标签![]() 中出现的类的损失,以避免因无关类迷惑模型,对于不相关的类,一个自然的想法是抑制他们在P和P'方面的预测分数,已通过Lcls和L'cls实现。需要注意的是,在基于注意力的方法中,注意力权值可以作为前景得分,因此我们也应该为它们计算相同形式的一致性损失。

中出现的类的损失,以避免因无关类迷惑模型,对于不相关的类,一个自然的想法是抑制他们在P和P'方面的预测分数,已通过Lcls和L'cls实现。需要注意的是,在基于注意力的方法中,注意力权值可以作为前景得分,因此我们也应该为它们计算相同形式的一致性损失。

片段特征对比一致性 这一正则化过程是在片段特征空间中进行的。所谓“一致性”,我们的意思是我们强制模型去学习表示的相对相似性,反映出每个子片段有多少父片段。通过“对比”,我们的意思是模型应该能够区分每个子片段的父片段和其他父片段。我们在这里共同实现这些目标。

具体来说,按照惯例[Chen等人, 2020],我们首先使用一个由FC层和L2归一化组成的投影头将嵌入特征E映射到低维单位超球面。我们将输出表示为Z = [z1, ..zt]∈RT×Dz 。这里Dz是通道数,Dz<Df 。同样,我们也可以得到E'的紧凑表示,即Z'= [Z'1, . ., z't]。

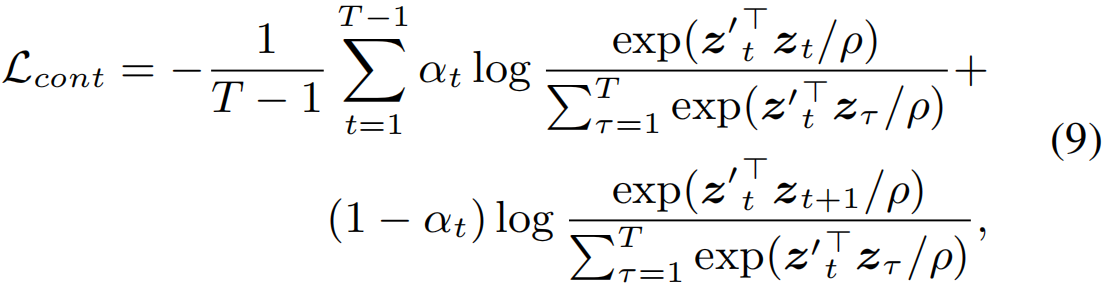

以每个子片段z't作为query,我们可以定义:1)它的父片段zt和zt+1是两个半正key,概率分别为αt和1−αt。2)Z中的其他片段都是负key。因此,我们可以构造一个软对比损失为

其中ρ为温度系数。

式(9)仅考虑Z到Z'的单向引用。为了探索更细粒度的模式,并加强Z和Z'之间的一致性正则化,我们提出了一个双向应用机制,以进一步考虑Z到Z'的引用。也就是说,我们把Z的元素看成query,把Z'的元素作为key。同时,snippet-to-snippet关系保持不变。因此,我们可以计算另一种与式(9)类似的称为L'cont的对比损失 。在这里,我们省略了细节。

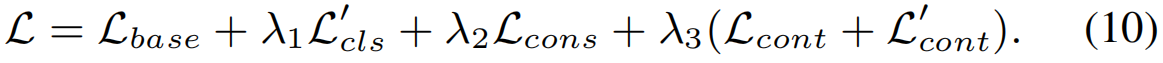

为了以端到端方式对整个模型进行训练,我们优化了以下损失函数:

其中,λ∗为权重项。Lbase=Lcls+Lother表示基线的目标函数,其中Lother表示除Lcls之外的其他损失之和。

多尺度测试 我们的方法天生能够处理调整大小的视频,因为整个视频的线性插值可以视为我们的方法的一个特例。因此,在使用多尺度测试时,我们也比较了我们的方法和基线的性能,多尺度测试是目标检测中的一种流行技术[Zhou等人,2019]。也就是说,我们首先将每个视频序列的大小调整到几个预设的比例,然后将它们逐个输入到模型中。最后,对它们的检测结果进行了综合。

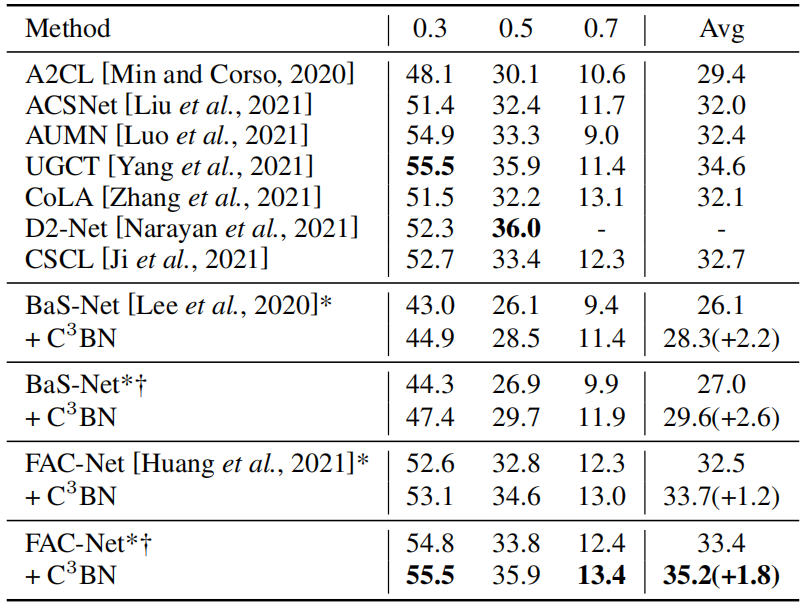

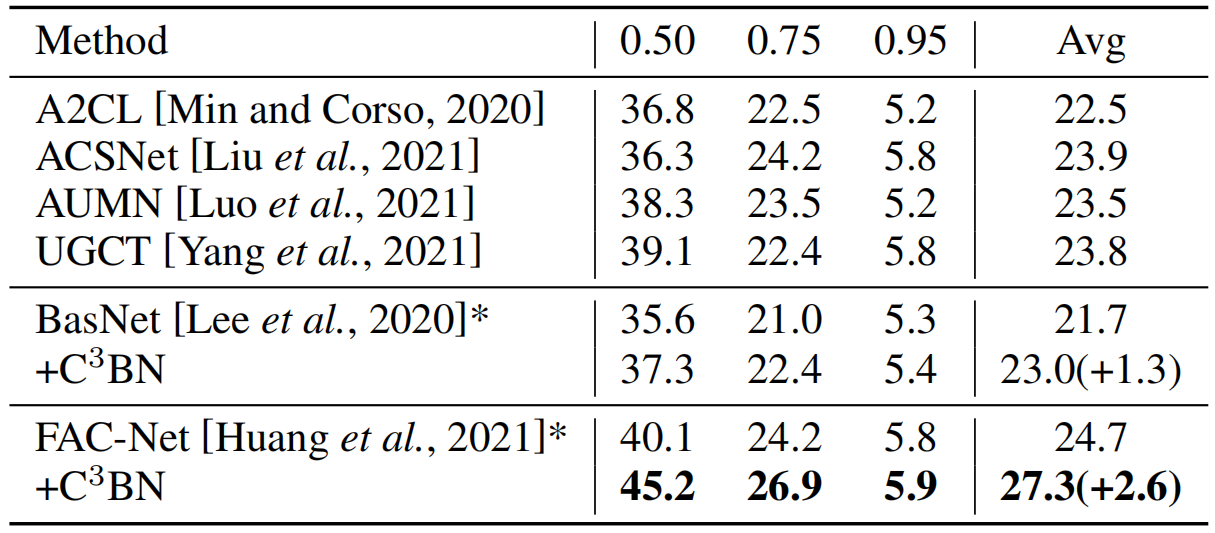

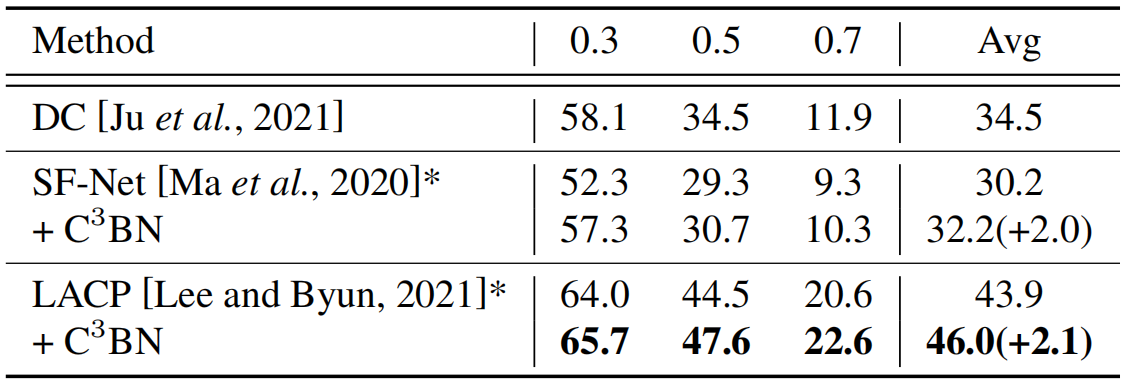

表1:tIoU阈值下的mAP对THUMOS14的比较[0.3:0.7:0.1]。∗表示结果基于我们的重新实现。'†'表示使用多尺度测试。

表2:ActivityNet1.3在tIoU阈值处mAP的性能比较[0.5:0.95:0.05]。

5.实验

在本节中,我们验证我们提出的C3BN的有效性。由于篇幅所限,我们希望读者能参阅补充资料,以了解所有实验的更多细节。

5.1带视频标签的WS-TAL

数据集和设置 THUMOS14 [Jiang等人,2014]包含20个类的未裁剪视频。我们使用验证集的200个视频进行训练,测试集的213个视频进行评估。ActivityNet13 [Caba Heilbron等人,2015]是一个包含200个类别的大型数据集。我们在1024个视频的训练集上进行训练,在4926个视频的验证集上进行测试。我们遵循标准评估协议,在不同时间交并比(tIoU)阈值上报告平均均值精度(mAP)值。

C3BN在不同基线上的有效性 为了验证C3BN的一般有效性,我们将C3BN纳入不同的WS-TAL作为我们的基线,包括BaS-Net[Lee等人,2020年]和FAC-Net[Huang等人,2021年]。注意,Bas-Net基本上是一种基于MIT的方法,而FAC-Net主要采用基于注意力的公式。表1和表2显示了比较。无论基线和数据集的差异如何,C3BN始终能提高两个基线的性能。

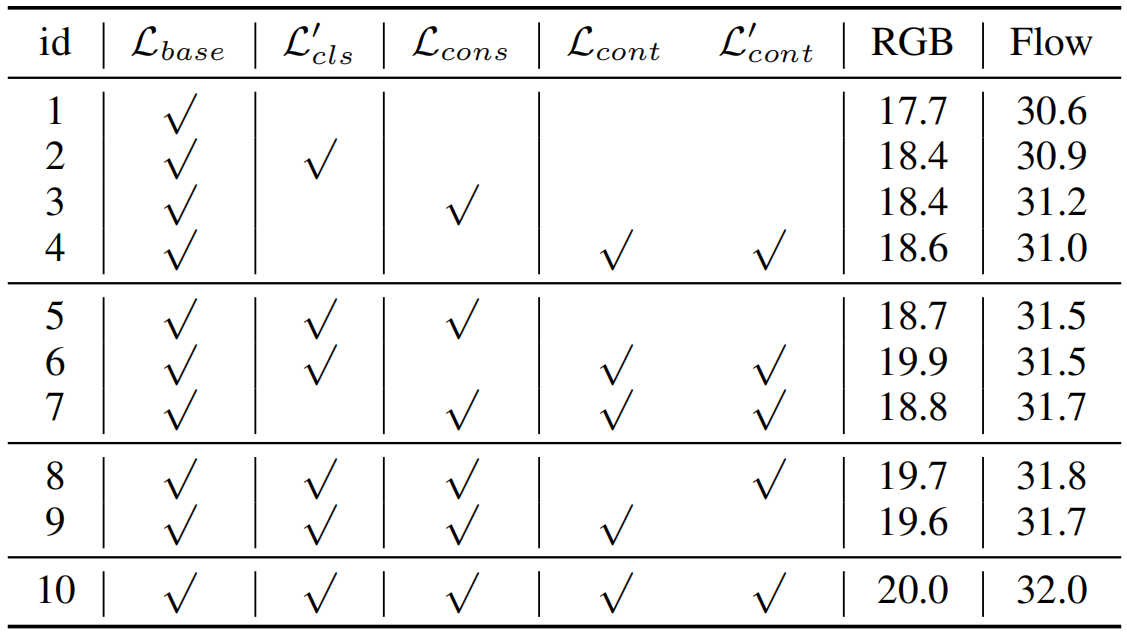

表3:THUMOS14的消融研究,报道了tIoU阈值[0.3:0.7:0.1]下的mAP。“id”表示模型的索引。

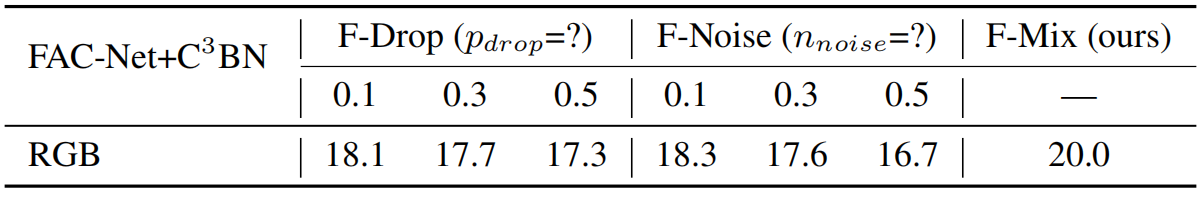

表4:不同增强技术的比较。

C3BN的损失项分析 我们的C3BN在训练中引入了几个额外的损失项。为了弄清楚每个损失项的贡献,我们在表3中进行了详细的消融研究。实验在FAC-Net上进行。FAC-Net在训练过程中独立处理RGB流和Flow流,这使我们能够考察C3BN在不同数据模式下的泛化能力。结果表明:1)每个损失项单独都能提高性能(见模型1-4),说明所有的正则化都是有帮助的。2)任意两项结合均可持续提高性能,表现出损失项之间的互补关系(见模型5-7)。3) Lcont和L'cont结合使用优于单独使用Lcont和L'cont,验证了我们提出的交叉引用机制的有效性(见模型8-9)。此外,上述观测结果在RGB和Flow流中是一致的,进一步证明了C3BN的有效性。

凸组合的有效性 在本文中,我们提出通过相邻片段的凸组合来实现数据的增强。为了检验我们的设计,我们还研究了另外两种流行的数据增强技术。1)‘F- drop’:我们随机的丢弃一些激活的输入特征F,概率为pdrop。2)‘F- noise’:我们从均匀分布N ~ U(−nnoise, nnoise)中随机抽取一个大小与F相同的噪声张量N,通过F'= (f![]() n)+f注入到F中。按照惯例,我们假设F-Noise和F-Drop不会改变每个片段的语义。因此,当采用C3BN来适应F-Noise和F-Drop时,我们对每个原始片段和增强片段进行了相同的预测。此外,在特征对比学习中,每个原始片段及其增广片段都是正的。F-Drop,F-Noise与我们的方法(称为F-Mix)的比较如表4所示,其中评价了FCA-Net的RGB流。可以看出,我们的方法明显优于F-Noise和F-Drop。因为F-噪声和F-Drop可能会改变片段的语义,特别是对于在决策边界附近的片段。因此,它将违反上述假设,并损害性能。相比之下,我们的方法允许增强片段的语义平滑地变化,从而产生具有更强泛化能力的平坦化表示。

n)+f注入到F中。按照惯例,我们假设F-Noise和F-Drop不会改变每个片段的语义。因此,当采用C3BN来适应F-Noise和F-Drop时,我们对每个原始片段和增强片段进行了相同的预测。此外,在特征对比学习中,每个原始片段及其增广片段都是正的。F-Drop,F-Noise与我们的方法(称为F-Mix)的比较如表4所示,其中评价了FCA-Net的RGB流。可以看出,我们的方法明显优于F-Noise和F-Drop。因为F-噪声和F-Drop可能会改变片段的语义,特别是对于在决策边界附近的片段。因此,它将违反上述假设,并损害性能。相比之下,我们的方法允许增强片段的语义平滑地变化,从而产生具有更强泛化能力的平坦化表示。

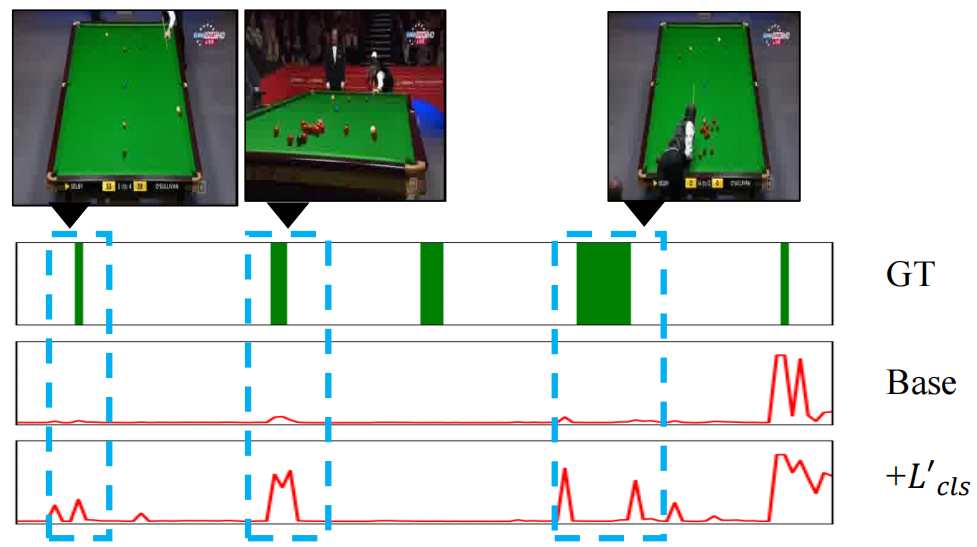

图3:THUMOS14的定性结果。我们展示了没有和有宏观一致性正则化的T-CAS。

多尺度测试 作为一个副产品,我们的C3BN与多尺度测试兼容。在表1中,我们报告了使用多尺度测试的结果。可以看出,1)多尺度测试在提高基线和我们的方法的性能方面都是非常有效的。2)配备C3BN后,多尺度测试的性能提高更加显著,使C3BN在现实中更加适用。

与最先进的(sota)的比较 为了与以前的sota进行比较,我们在最近的强WS-TAL方法FAC-Net上实现了我们的C3BN。表1和表2分别显示了与之前使用THUMOS14和ActivityNet1.3的方法的比较。从结果中我们可以看出,FAC-Net+C3BN在两个数据集上都取得了最好的性能。

5.2可视化

为了进一步验证我们方法的有效性,我们可视化了关于视频标签的T-CAS 。我们采用FAC-Net作为基线。有关更多可视化示例,请参阅补充说明。

宏观一致性的有效性 在图3中,Base只激活最右边的动作示例的片段。这是因为视频分类只能通过几个显著的片段来实现。除此之外,L'cls能够帮助挖掘更多的动作片段。原因是模型更难识别每个子片段,从而自动聚合来自更多动作区域的信息。

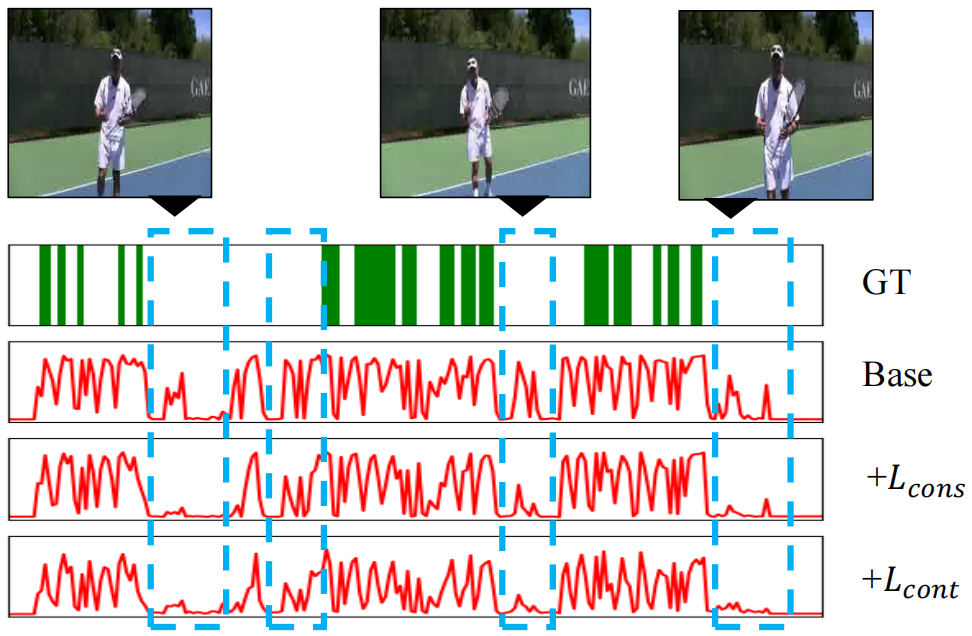

微观一致性的有效性 如图4所示,lcons和Lcont(包括L'cont)有助于抑制背景的反应,使T-CAS更加平滑。我们认为原因是Lcont和Lcons使模型能够学习不同片段之间的相对相似性,进而使同一类别的片段在预测空间和特征空间中更加接近,从而改善前景和背景的分离。

图4:THUMOS14的定性结果。我们展示了有和没有微一致性正则化的T-CAS。

表5:THUMOS14在tIoU阈值[0.3:0.7:0.1]处mAP的比较。

5.3带点标签的WS-TAL

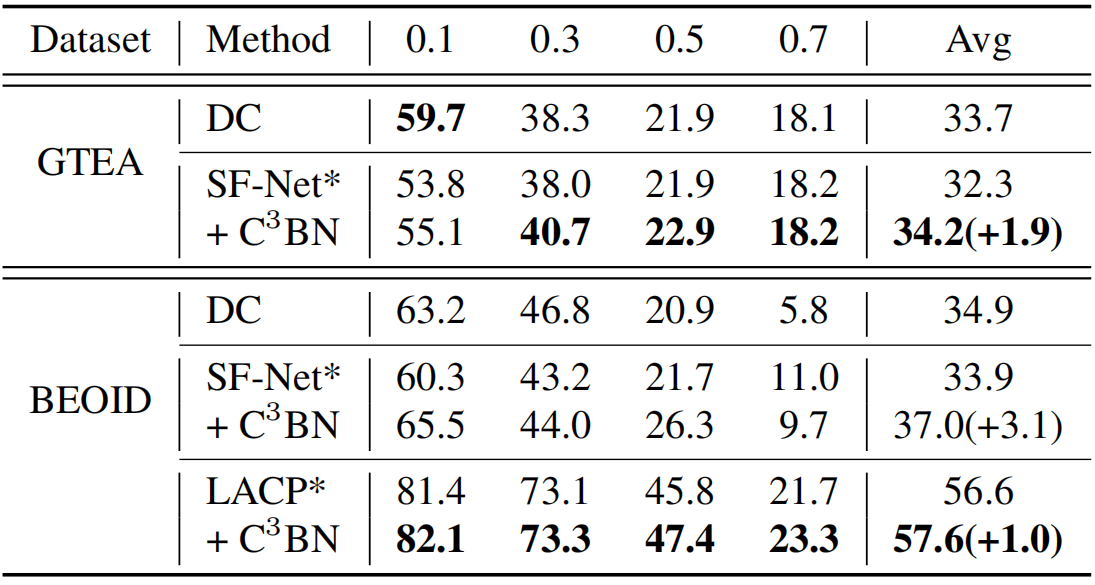

基于mil的方案在WS-TALs中也被采用了点监督[Ma等人, 2020],其中上述问题仍然存在。我们的C3N是通用的,预计可以很好地完成这项任务。我们以SFNet [Ma等人, 2020]和LACP [Lee和Byun, 2021]为基线,在THUMOS14,BEOID [Calway等人, 2015]和GTEA [Lei和Todorovic, 2018]上进行实验。如表5和表6所示,我们的C3BN策略大幅改善了SF-Net和LACP的mAP。此外,我们的方法还优于最近提出的DC[Ju等人,2021],并在所有三个数据集上实现了SOTA性能。这些都验证了我们的C3BN在不同的弱监管下与WS-TAL是兼容的。

表6:GTEA与BEOID在tIoU阈值[0.1:0.7:0.1]下mAP的比较。

6.结论

在本文中,我们提出了一种C3BN训练策略来改进片段预测。它首先通过相邻片段之间的凸组合生成新的片段,然后用它们在三个正则项的辅助下对模型进行正则化。实验结果验证了C3BN适用于视频级监督和点级监督的各种WS-TAL方法。

浙公网安备 33010602011771号

浙公网安备 33010602011771号