Learning Action Completeness from Points for Weakly-supervised Temporal Action Localization

0. 前言

摘要

我们要解决的问题是,在训练中,每个动作实例只使用一个帧标签来定位动作的时间间隔。由于标签稀疏性,现有的工作无法学习动作的完整性,导致动作预测零碎。在本文中,我们提出了一个新的框架,其中生成密集的伪标签,为模型提供完整性指导。具体来说,我们首先选择伪背景点来补充点级动作标签。然后,通过将这些点作为种子,我们在同意种子的同时,搜索可能包含完整动作实例的最佳序列。为了从获得的序列中学习完整性,我们引入了两种新的损失,分别从动作得分和特征相似性的角度将动作实例与背景实例进行对比。实验结果表明,我们的完整性指导确实有助于模型定位完整的操作实例,尤其是在高IoU阈值下,可以获得较大的性能提升。此外,我们还展示了我们的方法在THUMOS'14、GTEA、BEOID和ActivityNet四个基准上优于现有的最先进的方法。值得注意的是,我们的方法甚至可以与最近的完全监督方法相比,而标注成本减少6倍。

1.导言

时间动作定位的目标在于定位动作实例的开始和结束时间戳,并对它们进行分类。由于各种各样的应用[37,55,58],它引起了研究人员的极大关注,导致在全监督设置(即帧级标签)方面取得了快速而显著的进展[31,51,53,60]。与此同时,似乎有人试图通过设计带有视频级别标签的弱监督模型来降低注释单个帧的高昂成本[8,36,56,66]。然而,它们在很大程度上落后于完全监督的同类,主要是因为它们区分动作和背景帧的能力较弱[21,22,45,62]。

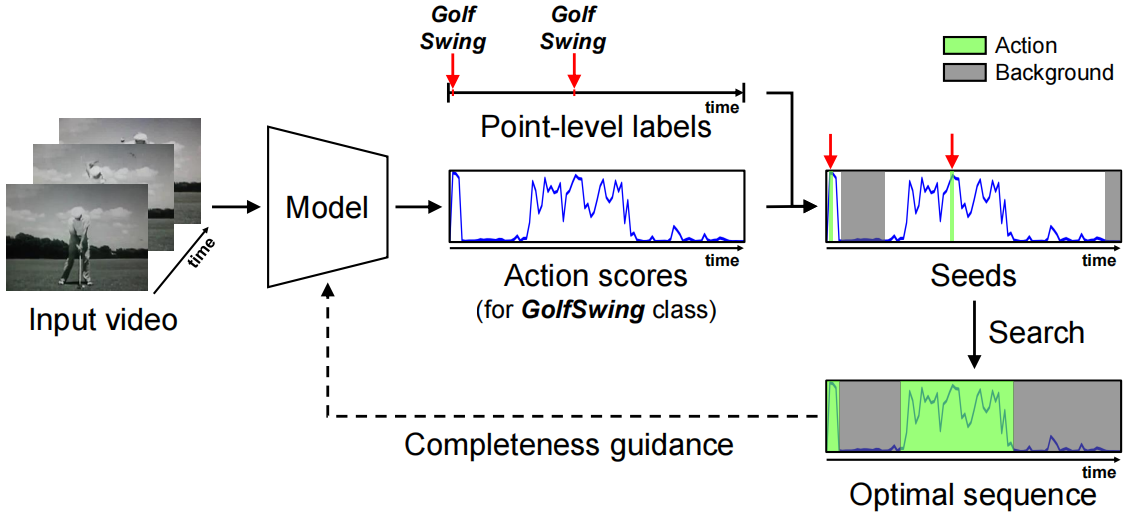

图1:我们想法的简化说明。我们使用点作为种子来寻找最优序列,从而为模型提供完整性指导。

为了缩小两者之间的差距,最近提出了另一种弱监督水平,即点监督设置。在该设置中,在训练期间,每个动作实例只标注一个带有动作类别的时间戳(点)。就标签成本而言,与视频级标签相比,点级标签需要的额外成本可以忽略不计,同时比帧级标签便宜6倍(每1分钟视频50秒对300秒)[35]。

尽管成本可以承受,但它提供了粗略的位置以及动作实例的总数,从而为模型提供了强大的动作识别能力。因此,在较低的联合交叉(IoU)阈值下,点监督方法显示出与完全监督方法相当甚至更优越的性能。然而,据透露,他们遭受不完整的预测,导致在高IoU阈值的情况下表现较差。我们推测,这个问题归因于点级别标签的稀疏性,这导致模型只学习动作的一小部分,而不是动作实例的全部范围。换句话说,他们无法从点注释中学习动作完整性。虽然SF-Net[35]挖掘了伪动作和背景点来缓解标签稀疏性,但它们是不连续,因此不提供完整性提示。

在本文中,我们的目标是让模型在点监督设置下学习动作完整性。为此,我们引入了一个新的框架,其中基于点注释生成密集的伪标签(即序列),为模型提供完整性指导。整体工作流程如图1所示。

从技术上讲,我们首先选择伪背景点来增强点级别的动作标签。如上所述,这样的点注释是不连续的,因此从中学习完整性是不可行的。为此,我们建议在符合点标签的候选对象中搜索覆盖完整动作实例的最佳序列。在没有完全监督的情况下,测量每个候选序列中的实例的完整性是非常重要的。为了实现这一点,我们借用了outer-inner-contrast概念[52],作为实例完整性的代理。直观地说,一个完整的动作实例通常表现出较大的分数对比,即内部帧的动作分数比周围帧的动作分数高得多。相比之下,一个零碎的实例可能在其外部区域(仍在该动作内)具有较高的动作分数,从而导致较小的分数对比。这也适用于背景实例。基于这个特性,我们通过聚合构成序列的动作和背景实例的分数对比度来推导输入序列的分数。通过最大化分数,我们可以获得可能与我们缺少的ground truth较为一致的最佳序列。在实验中,我们给出了最优序列的准确性以及分数对比度和完整性之间的相关性。

根据得到的序列,模型应该学习动作完整性。为此,我们设计了分数对比损失,通过扩大序列的完整性,使模型输出和最优序列之间的一致性最大化。在损失的情况下,训练模型根据动作得分将每个动作(背景)实例与其周围环境区分开来。此外,我们还引入了特征对比损失来鼓励动作实例和背景实例之间的特征差异。实验证明,所提出的损失互补地帮助模型检测完整的动作实例,从而在高IoU阈值下获得较大的性能增益。总而言之,我们的贡献有三个方面。

•我们引入了一个新的框架,其中生成了密集的最优序列,以在点监督设置下为模型提供完整性指导。

•我们提出了两种新的损失,通过对比动作实例与背景实例的动作分数和特征相似性,促进动作完整性学习。

•我们的模型达到了最新水平,在四个基准上有很大差距。此外,它甚至在完全监督的方法中表现良好。

2.相关工作

完全监督的时间动作定位。为了解决时间动作定位问题,全监督方法依赖于精确的时间注释,即帧级标签。它们主要采用两阶段范式(提案生成和分类),根据提案生成方式大致可分为两组。第一组使用滑动窗口技术准备大量提案[5,51,53,59,63,65,72]。另一方面,第二组首先预测每个帧作为动作实例起点(终点)的概率,然后使用可能的起点和终点的组合作为建议[25,26,27,71]。同时,也有一些以片段[1,61]或提议[67]为节点的图形建模方法。与使用昂贵的帧级标签进行动作完整性学习的完全监督方法不同,我们的方法通过引入一种新的框架,只使用点级标签。

弱监督的时间动作定位。为了缓解帧级标签的成本问题,最近已经进行了许多尝试,以解决在弱监督设置下的相同任务,主要使用视频级标签。Untrimmednets[56]通过选择有助于视频级别分类的片段来解决这个问题。STPN[44]提出了关键帧应该稀疏的约束。此外,在视频监督环境下还有一些背景建模方法[10,21,22,45]。为了学习可靠的注意权重,DGAM[50]设计了一个生成模型,而EM-MIL[34]采用了期望最大化策略。同时,度量学习用于动作表征学习[11,43,48]或动作背景分离[41]。还有一些方法可以探索亚作用[12,33],或者利用RGB和流动模式的互补性[64,68]。此外,有几种方法利用外部信息,例如动作计数[43,62]、姿势[70]或音频[20]。此外,一些方法旨在通过聚合多个预测[29],删除最具辨别力的部分[54,73],或直接回归动作间隔[32,52],来检测完整的动作实例。

最近,人们开始探索点级监督,它以可承受的成本提供丰富的信息。Moltisanti等人[42]首先利用点级标签进行动作定位。SF-Net[35]采用伪标签挖掘策略来获取更多的标签帧。同时,Ju等人[14]基于关键帧预测进行边界回归。然而,它们没有明确地考虑动作完备性,因此产生只覆盖部分动作实例的预测。相比之下,我们建议通过对比动作实例和周围背景来从密集的伪标签中学习动作完整性。在第4节显示,我们的方法的有效性在高IoU阈值下得到了明显的性能提升。

图2:所提出的方法的概述。除了传统的目标,即视频级和点级的分类损失外,我们还建议学习动作的完整性(下部)。根据最终的动作分数,在与点级标签一致的候选者中选择最优序列。它反过来提供了完整性指导与两个提出的损失,对比动作实例与背景实例有关的(a)动作得分和(b)特征相似性

3.方法

在本节中,我们首先描述问题设置,并详细介绍基线设置。然后,详细阐述了最优序列搜索,以及我们的动作完整性学习策略。最后,我们解释了模型的联合学习和推理。我们的方法的整体架构如图2所示。

问题设置。在[14,35]之后,我们建立了点监督的时间动作定位问题。给定一个输入视频,将为每个动作实例提供一个点和类别,即![]() ,第i个动作实例在第ti段(帧)上标记有其动作标签yti,Mact是输入视频中的动作实例的总数。这些点按时间顺序排序(即ti < ti+1)。如果第i个动作实例包含第c个动作类,则标签yti是具有yti[c] = 1的二进制向量,否则对于C个动作类为0。值得注意的是,视频级标签yvid可以很容易地通过聚合点级标签获得,即yvid[c]=

,第i个动作实例在第ti段(帧)上标记有其动作标签yti,Mact是输入视频中的动作实例的总数。这些点按时间顺序排序(即ti < ti+1)。如果第i个动作实例包含第c个动作类,则标签yti是具有yti[c] = 1的二进制向量,否则对于C个动作类为0。值得注意的是,视频级标签yvid可以很容易地通过聚合点级标签获得,即yvid[c]= ,其中1[·]是指示函数。

,其中1[·]是指示函数。

3.1. 基线设置

我们的基线如图2的上部所示。我们首先将输入的视频分成16帧的片段,然后将其输入到预先训练好的特征提取器中。按照[21,48]的方法,我们将RGB和光流进行early-fusion。将双流特征通过串联融合,得到X∈RD×T,其中D和T分别表示特征维数和段数。

提取的特征然后经过单个1D卷积层,然后再进行ReLU激活,从而生成嵌入特征F。在实际应用中,嵌入特征的维数与提取特征X的维数相同,即F∈RD×T。然后,将嵌入特征输入到具有sigmoid函数的一维卷积层中,以预测段级类分数P∈RC×T,其中C表示动作类的数量。同时,我们推导了class-agnostic的背景分数Q∈RT,来建模不属于任何动作类的背景帧。然后,我们将动作分数与背景概率补充相融合,得到最终的分数![]() ,即

,即![]() 。这种融合策略与[22]类似,尽管我们的模型中没有纳入分布外模型。

。这种融合策略与[22]类似,尽管我们的模型中没有纳入分布外模型。

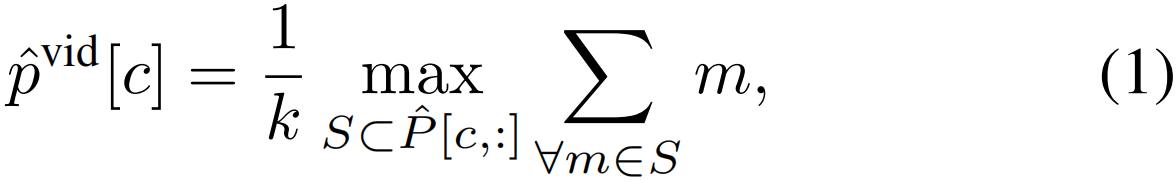

然后,将片段级动作得分汇总,以构建单个视频级类别得分。我们使用时序top-k进行聚合,如[21,48]所示。在形式上,视频级别的概率计算如下。

其中, ,S表示包含k个片段的

,S表示包含k个片段的![]() [c,:]的所有可能的子集,即|S| = k。

[c,:]的所有可能的子集,即|S| = k。

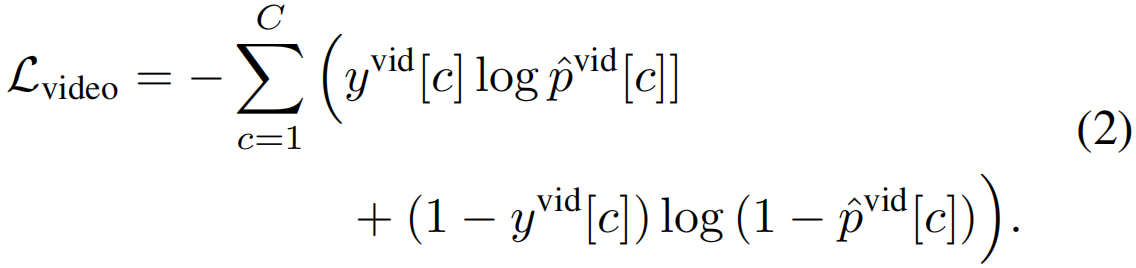

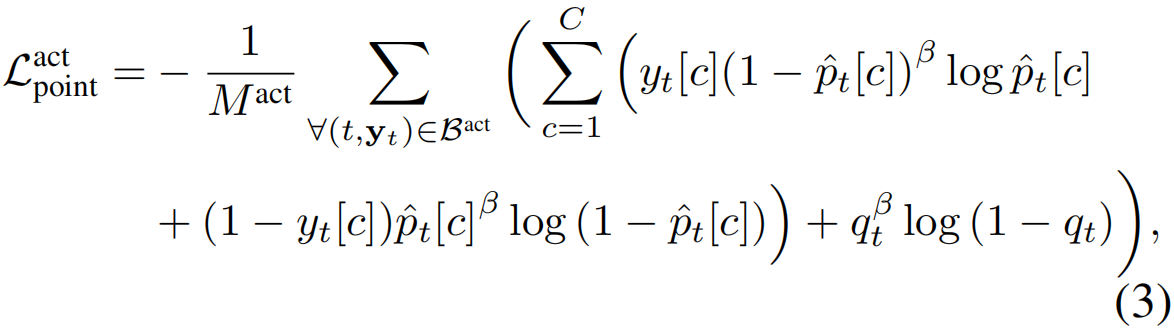

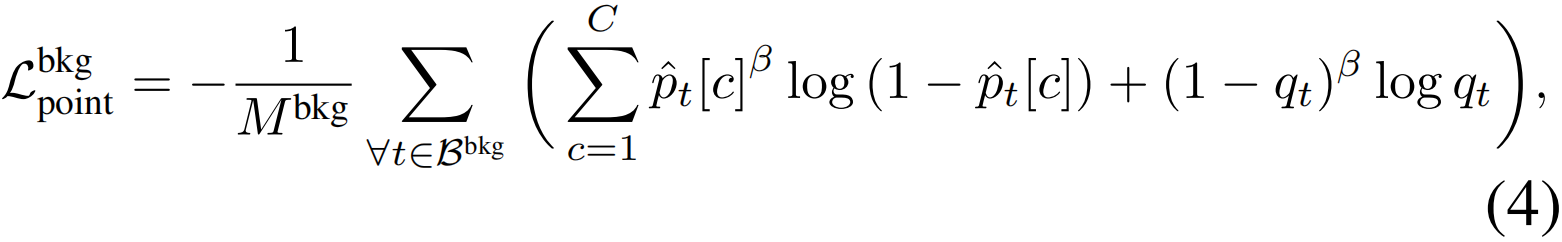

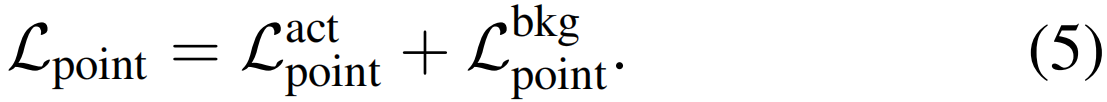

我们的基线模型包括两个分别使用视频和点级别标签的损失函数。如上所述,可以通过点级标签来获得视频级别类别标签yvid[c]。然后利用二进制交叉熵计算视频级别的分类损失。

点级分类损失也通过二元交叉熵计算,但涉及到背景项来有效地训练Q。此外,我们采用focal损失[28]来促进训练过程。在形式上,动作点的分类损失定义如下。

其中,Mact为视频中的动作实例数,β为聚焦参数,根据原论文[28]设置为2。

仅使用行动点进行训练将导致网络始终产生较低的背景分数,而不是学习将行动和背景分开。因此,我们收集了一些伪背景点来补充动作点。我们的选择原则是,必须在两个相邻的动作实例之间放置至少一个背景帧,以将它们分开。根据问题定义,从不同的实例中抽取两个不同的动作点,因此我们使用这些动作点作为对应实例的代理。具体来说,在两个相邻的动作点之间,我们找到背景分数大于阈值的片段。如果某个区段中没有满足条件的片段,我们将选择背景分数最大的片段。同时,对于在一个部分中选择多个背景点的情况,我们将它们之间的所有点标记为背景,因为在那里不存在任何动作是很平常的。在实践中,通过收集更多的hard点,这种策略被证明比全局挖掘[35]更有效。给定伪背景点集Bbkg = {tj}Mbkgj=1,背景点的分类损失计算方法为:

其中,Mbkg为所选背景点的个数,β为focusing因子,与(3)相同。对于伪背景点,我们惩罚所有动作类的最终分数,同时鼓励背景分数。

3.2. 最优序列搜索

如第1节所述,点级别的分类损失不足以了解行动的完整性,因为点标签只覆盖了行动实例的一小部分。因此,我们建议生成密集的伪标签,这些伪标签可以为模型的动作完整性提供一些提示。具体来说,我们考虑与动作和伪背景点一致的所有可能的序列候选。其中,我们找到了能够为模型提供良好完备性指导的最优序列。然而,如果没有全面的监督,衡量候选序列覆盖完整动作实例的程度是非常重要的。为了实现这一点,我们重新使用了外部-内部-对比概念[52],作为判断序列的完整性评分的代理。直观地说,对于一个完整的动作实例,内部分数和外部分数之间的对比可能很大,但对于一个不完整的动作实例来说却很小。请注意,我们的目的不同于最初的论文[52]。它最初是为参数边界回归而设计的。相比之下,我们利用它作为一个评分函数来搜索最优序列,从中模型可以学习动作的完整性。

在详细描述评分函数之前,我们先给出候选序列的公式。由于时间动作定位的多标签性质,我们考虑每个动作类的class-specific序列。请注意,属于其他动作类的所有片段都被视为类序列的背景。然后,序列被定义为连续交替的多个动作和背景(包括其他动作)实例。形式上,类的序列可以表示为πc={(scn,ecn , zcn)}Ncn=1,其中scn和ecn分别表示第n个实例的起始点和结束点,而Nc为类c的实例总数。另外,zcn∈{0,1}表示实例的类型,即如果第n个实例是第c个动作类的,则zcn = 1,否则为0(背景)

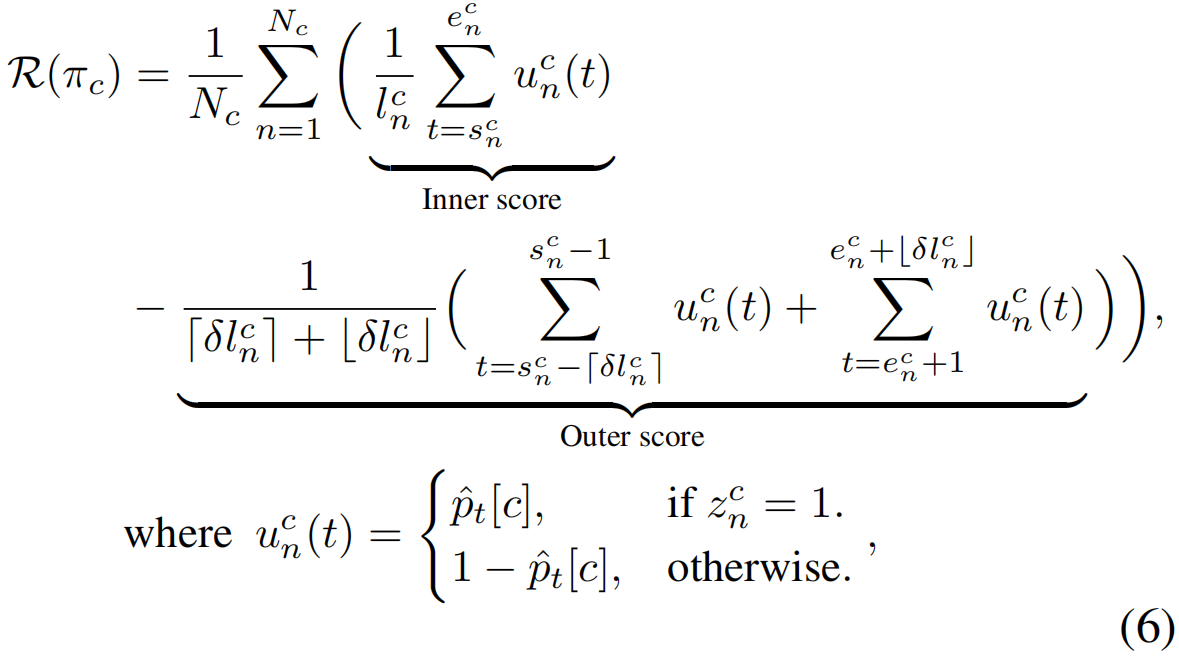

给定一个输入序列,我们通过平均序列中包含的单个动作和背景实例的对比度得分来计算其完整性得分。需要注意的是,计算中包含了背景实例的对比分数,这被证明对找到更准确的最优序列是有效的,如Sec4.3所示。形式上,第c类动作类的序列πc的完整性得分计算方法为

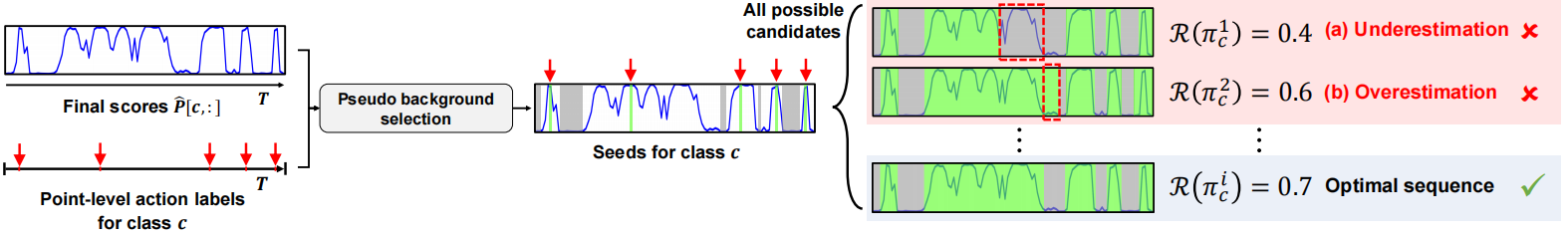

lcn=ecn−scn + 1是πc的第n个实例的时间长度,δ是调整外部范围的超参数(设置为0.25),Nc是c类的动作和背景实例的总数。然后,可以通过找到使得分最大化的序列来获得c类的最优序列,即,π∗c= arg maxπc R(πc)使用(6)。最优序列搜索过程如图3所示。通过对完整性评分的评估,我们的方法可以防止低估(图3a)和高估(图3b)的情况。因此,我们获得了最有可能包含完整动作实例的最优序列。

图3:类c的最优序列搜索。给定最终的分数和点级标签,我们选择伪背景点。然后,在所有可能的候选序列中,我们寻找使完整性得分最大化的(6)的最优序列。

然而,随着T的增加,搜索空间呈指数增长,导致最优序列搜索的成本过高。为了解决这一问题,我们在有限的预算下采用贪婪算法实现了搜索过程,从而大大节省了计算成本。详细的算法和成本分析在附录B节中提出。请注意,最优序列搜索只对视频中包含的动作类执行。

3.3. 动作完整性学习

给定了class-specific的最优序列{π∗c}Cc=1,我们的目标是让模型学习动作的完整性。为此,我们设计了两个损失,通过对比动作实例和背景实例来实现完整性学习。这有助于进行完整的行动预测,正如在Sec4中验证的那样。

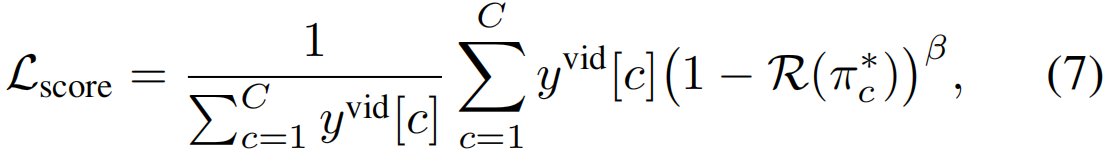

首先,我们提出分数对比损失,鼓励模型根据最终分数将动作(背景)实例与其周围环境分开。它也可以解释为将模型输出拟合到最佳序列(图2a)。从形式上讲,损失的计算方法是:

其中,我们使用β-平方项来关注与最优序列基本不一致的实例(β = 2)。

其次,受对比学习最近取得的成功[6,9,16]的启发,我们设计了特征对比损失。我们的直觉是,与同一视频中的任何其他背景实例相比,来自不同实例但具有相同动作类别的特征应该更接近彼此(图2b)。我们注意到,我们的损失与[6,9,16]不同,因为他们对输入图像有不同的看法,而我们的损失在给定的视频中吸引了不同的动作实例。此外,我们不需要从不同的图像中进行负采样,因为背景实例来自同一视频。

为了提取每个动作(或背景)实例的代表性特征,我们修改了兴趣段(SOI)池[5],用随机采样替换最大池化。详细地说,我们将每个输入实例均匀地划分为三个间隔,从每个间隔中随机采样一个段。然后,对采样段的嵌入特征进行平均,得到序列π∗c的第n个实例的代表性特征fcn。

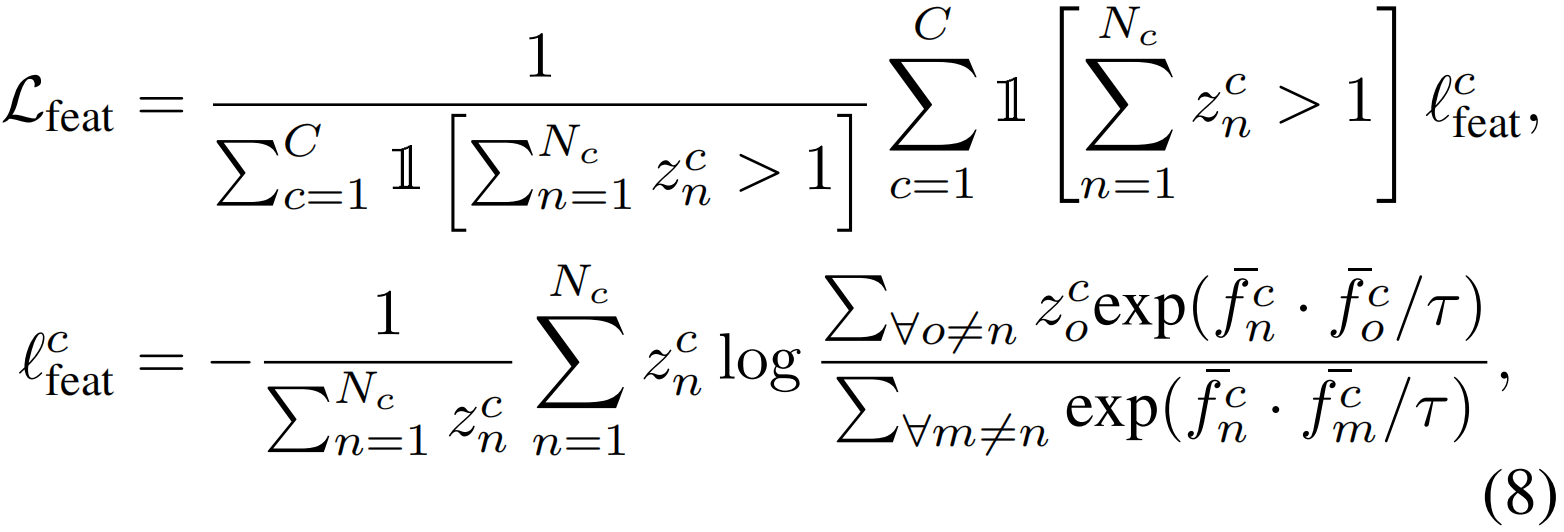

以归一化实例特征![]() 作为输入,推导出特征对比损失。仅对动作计数大于1的类计算损失,即在视频中至少存在两个动作实例。请注意,背景实例并不会相互吸引。给定最优序列{π∗c= {(scn,ecn,zcn)}Ncn=1}Cc=1,所提出的特征对比损失表示为:

作为输入,推导出特征对比损失。仅对动作计数大于1的类计算损失,即在视频中至少存在两个动作实例。请注意,背景实例并不会相互吸引。给定最优序列{π∗c= {(scn,ecn,zcn)}Ncn=1}Cc=1,所提出的特征对比损失表示为:

其中lcfeat为c类的部分损失,τ为温度参数,1[·]为指标函数。

3.4.联合训练和推理

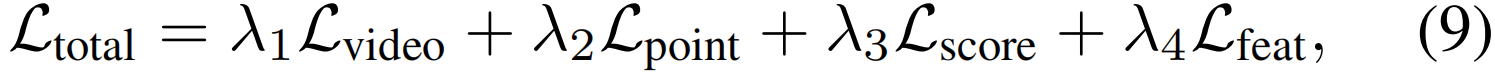

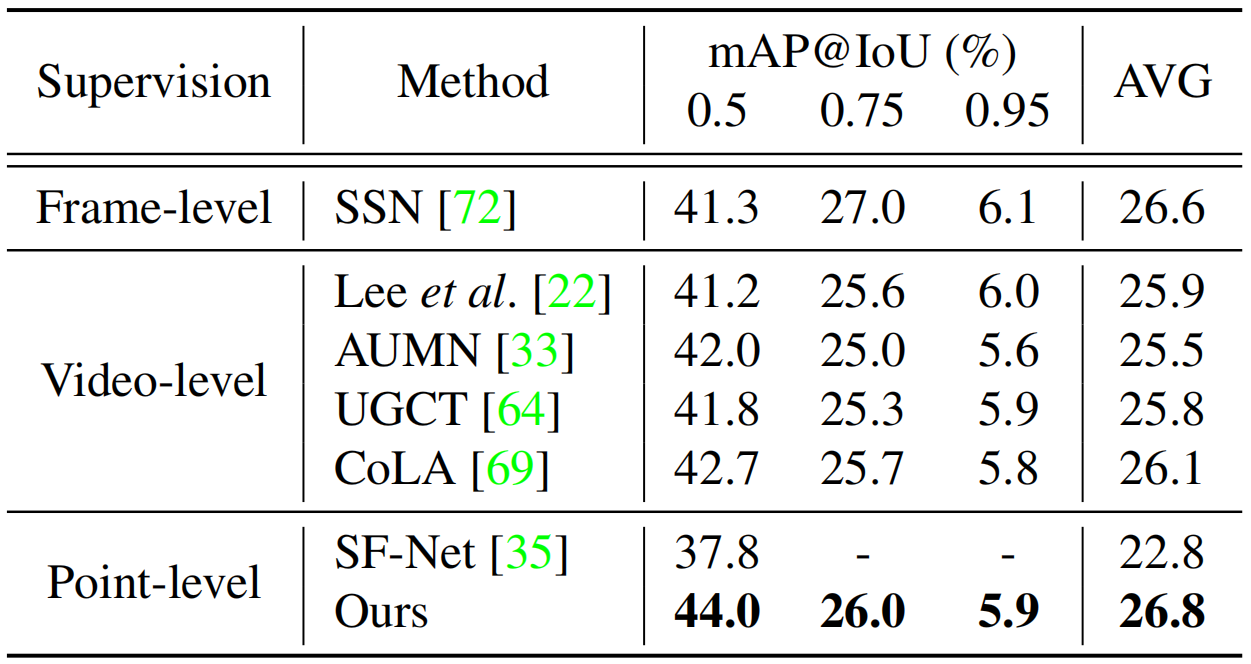

我们模式的总体训练目标如下。

其中,λ∗是平衡损失的加权参数,由经验确定。

在测试期间,我们首先对视频分数![]() 设定阈值Θvid,以确定哪些动作类别需要定位。然后,仅对剩下的类,我们在段级最终分数

设定阈值Θvid,以确定哪些动作类别需要定位。然后,仅对剩下的类,我们在段级最终分数![]() 施加阈值Θseg来选择候选段。之后,连续的候选被合并成一个单一的提案,成为定位的结果。我们将每个方案的置信度设置为其外部-内部对比度分数,如[21,29]所示。为了增加提案池,我们使用多个阈值,并执行非最大抑制(NMS)来删除重叠提案。请注意,最佳序列搜索不会在测试时执行,因此不会影响推断时间。

施加阈值Θseg来选择候选段。之后,连续的候选被合并成一个单一的提案,成为定位的结果。我们将每个方案的置信度设置为其外部-内部对比度分数,如[21,29]所示。为了增加提案池,我们使用多个阈值,并执行非最大抑制(NMS)来删除重叠提案。请注意,最佳序列搜索不会在测试时执行,因此不会影响推断时间。

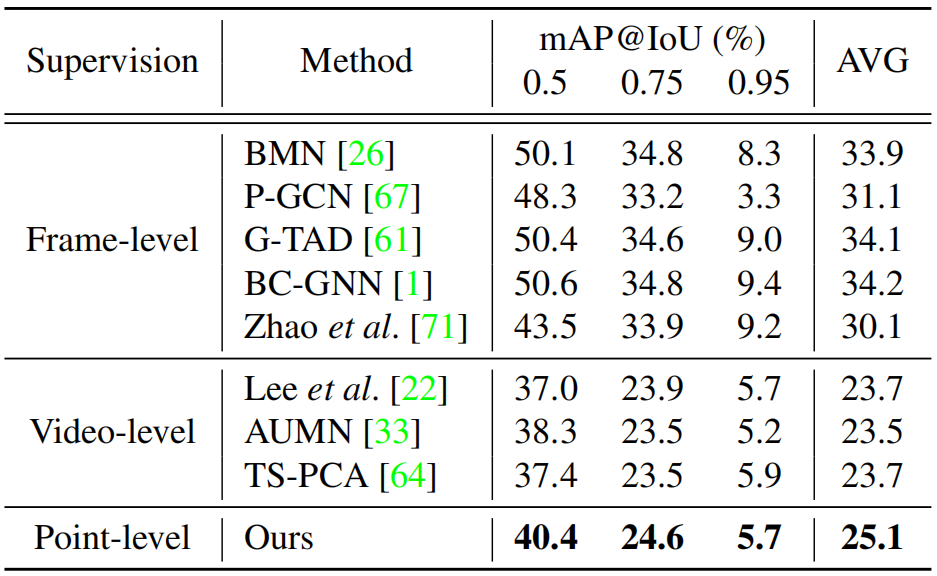

表1:对THUMOS'14的最新比较。我们还包括视频级和帧级监督的方法供参考。平均map是在IoU阈值0.1:0.5和0.3:0.7下计算的,步长为0.1。![]() 表示使用从[35]中手动注释的标签,

表示使用从[35]中手动注释的标签,![]() 表示使用在[42]中自动生成的标签。

表示使用在[42]中自动生成的标签。

4.实验

4.1. 实验环境

数据集。THUMOS'14[13]包含20个动作类,分别有200和213个未经剪辑的视频用于验证和测试。众所周知,由于动作实例的长度不同且频繁发生,这是一个具有挑战性的问题。按照惯例[44],我们使用验证视频进行训练,使用测试视频进行测试。GTEA[23]包含28个关于厨房中7个精细日常动作的视频,其中21个和7个视频分别用于训练和测试。BEOID[7]有58个视频,共有30个动作类别。我们遵循[35]提供的数据分割。ActivityNet[3]是一个具有两个版本的大型数据集。1.3版包括10024个训练、4926个验证和5044个测试视频,以及200个动作课程。1.2版包含4819个训练、2383个验证和2480个测试视频,共100个类别。我们在两个版本的验证集上评估我们的模型。应该注意的是,我们的模型只需要点级注释进行训练。

评估指标。按照时间动作定位的标准协议,我们计算了在联合(IoU)阈值上的几个不同相交级别下的平均精度(MAP)。我们注意到,在小IoU阈值下的性能显示了发现动作的能力,而在高IoU阈值下的性能则显示了动作预测的完整性。

实施细节。我们使用在Kinetics-400[4]上预训练的双流I3D网络[4]作为我们的特征提取器,在我们的实验中没有进行微调以进行公平比较。为了获得光流图,我们使用了TV-L1算法[57]。每个视频被分割成16帧的片段,由特征提取器作为输入,为每个模态产生1024维的特征(即D = 2048)。我们使用原始的段数作为T,没有抽样。我们的模型由Adam[17]进行优化,学习速率为10−4,batch大小为16。超参数由网格搜索确定: γ = 0.95,τ = 0.1。视频级阈值θvid设置为0.5,而分段级阈值θseg跨度从0到0.25,步长为0.05。执行NMS时的阈值为0.6。

4.2. 与最新方法的比较

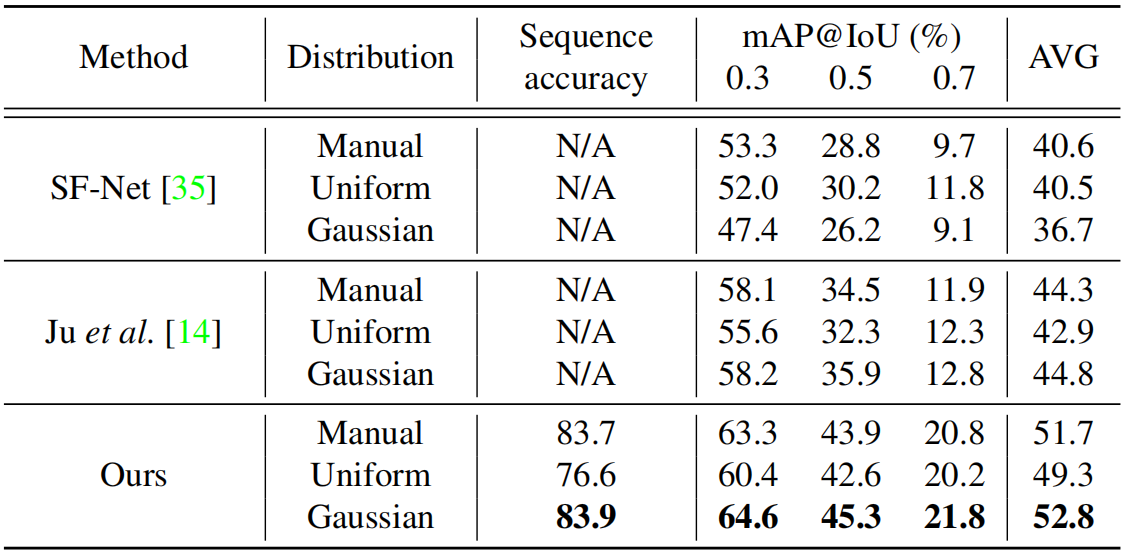

在表1中,我们将我们的方法与THUMOS'14在不同监督级别下的最先进模型进行了比较。我们注意到,与弱监督的模型相比,完全监督的模型需要更昂贵的注释成本。相比之下,我们的模型显著优于最先进的点监督方法。我们还注意到在高IoU阈值下的巨大性能提升,例如,mAP@0.6为∼11%,mAP@0.7为∼9%。这证实了所提出的方法有助于定位完整的动作实例。同时,我们的模型在标签成本相当的情况下大大超过了视频监督方法。此外,我们的模型在平均mAPs方面甚至优于全监督方法,但注释成本要低得多。然而,这也表明,由于缺乏边界信息,我们的IoU阈值在高水平上落后于他们。

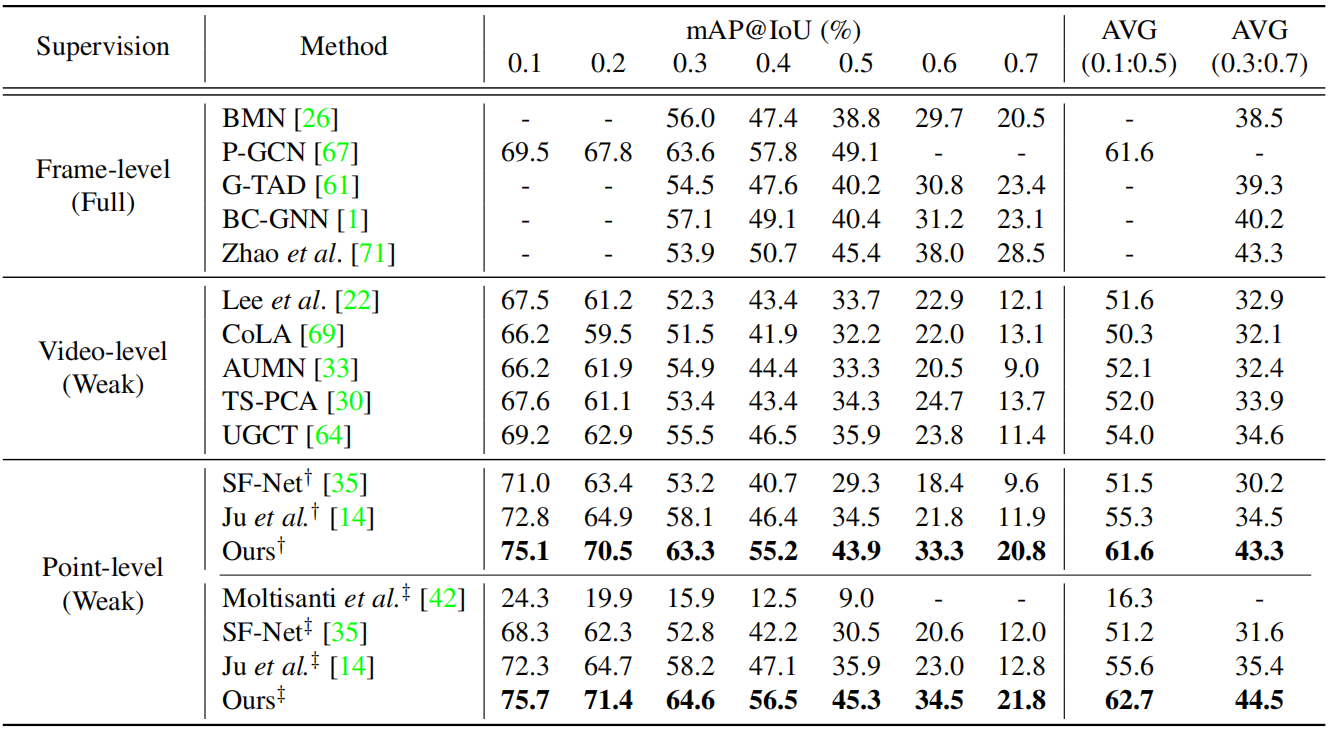

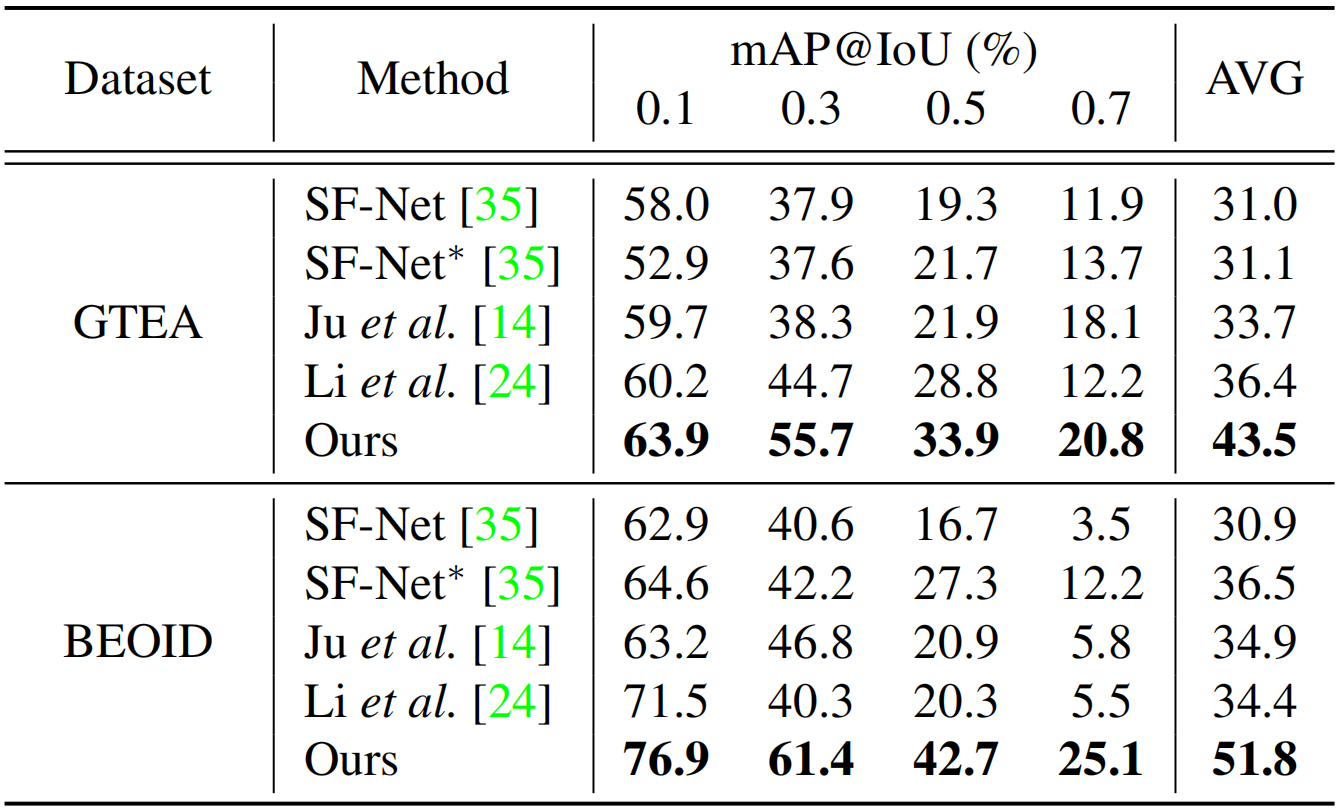

表2:对GTEA和BEOID的最新比较。AVG表示在阈值0.1:0.1:0.7处的平均mAP。*表示通过官方实现得到的复制结果。

表3:ActivityNet 1.2的最新比较。AVG是阈值为0.5:0.05:0.95时的平均mAP。

我们在表2中提供了GTEA和BEOID基准测试的实验结果。在这两个数据集上,我们的方法与现有的最先进的方法相比有很大的差距。值得注意的是,我们的方法在0.5和0.7的高阈值下表现出显著的性能提升,验证了所提出的完整性学习的有效性。

表3和表4总结了ActivityNet上的结果。我们的模型在两个版本上都显示了优于所有现有弱监督方法的性能。还可以观察到,与THUMOS'14相比,视频级别标签的性能提升相对较小,我们推测这是由于动作实例的频率远低于THUMOS'14(每个视频1.5次,而15次)。

4.3. 分析

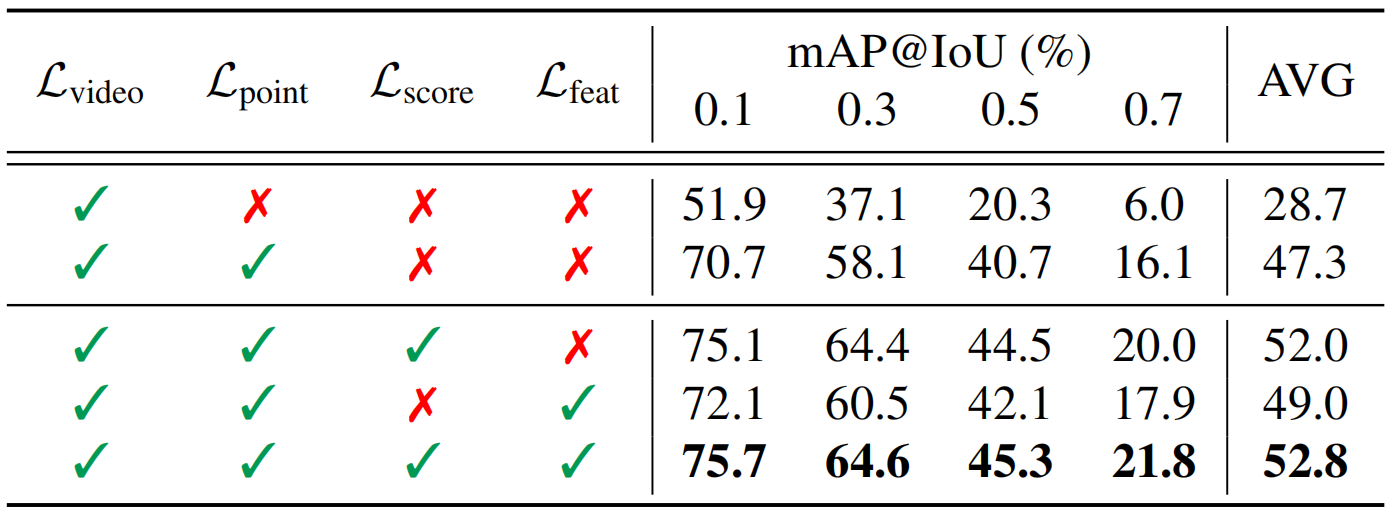

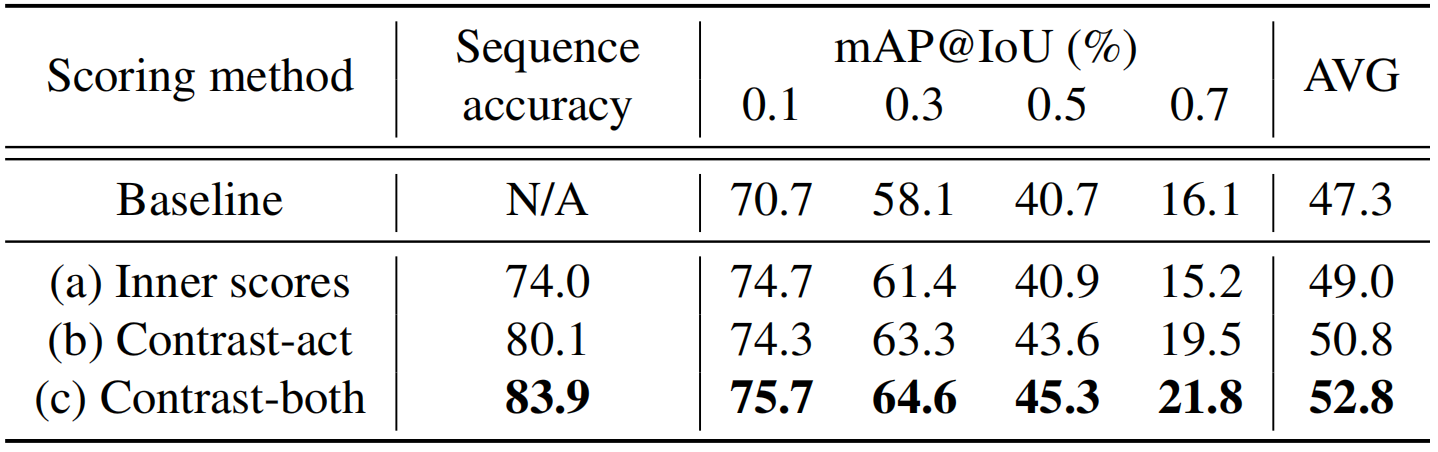

每种成分的作用。在表5中,我们进行了消融研究,以调查每种成分的贡献。上半部分报告了基线性能,从中我们观察到点级监督带来的巨大分数增益,尤其是在低IoU阈值下。它主要来自背景建模[21,22,45],以及点注释在发现动作实例方面的帮助。另一方面,下半部分展示了所提出方法的结果,其中为模型提供了完整性指导。我们观察到,在得分和特征相似性方面,从所提出的对比损失中,mAP的绝对平均增益分别为4.7%和1.7%。此外,由于这两项损失加在一起,性能进一步提升至52.8%。这清楚地表明,提出的两种损失是互补的,有利于精确的行动定位。值得注意的是,高IoU阈值下的分数大幅提高,验证了我们学习的有效性。比较不同的评分方法。在表6中,我们比较了关于训练集中最佳序列的帧级精度以及THUMOS'14测试集中的定位性能的不同序列评分方法。具体来说,我们调查了三个变量:(a)内部分数和(b)动作实例的分数对比,以及(c)动作和背景的对比。因此,与内部分数相比,对比方法可以生成更精确的最优序列,并在高IoU阈值下带来更大的性能增益。此外,我们观察到,合并背景实例进行分数计算有助于找到高度准确的最佳序列,从而提高测试时的定位性能。

表4:ActivityNet 1.3的最新比较。AVG是阈值为0.5:0.05:0.95时的平均mAP。

表5:THUMOS'14的消融研究。AVG代表IoU阈值0.1:0.1:0.7时的平均mAP。

表6:THUMOS'14上最佳序列搜索不同评分方法的比较。AVG表示IoU阈值为0.1:0.1:0.7时的平均mAP。

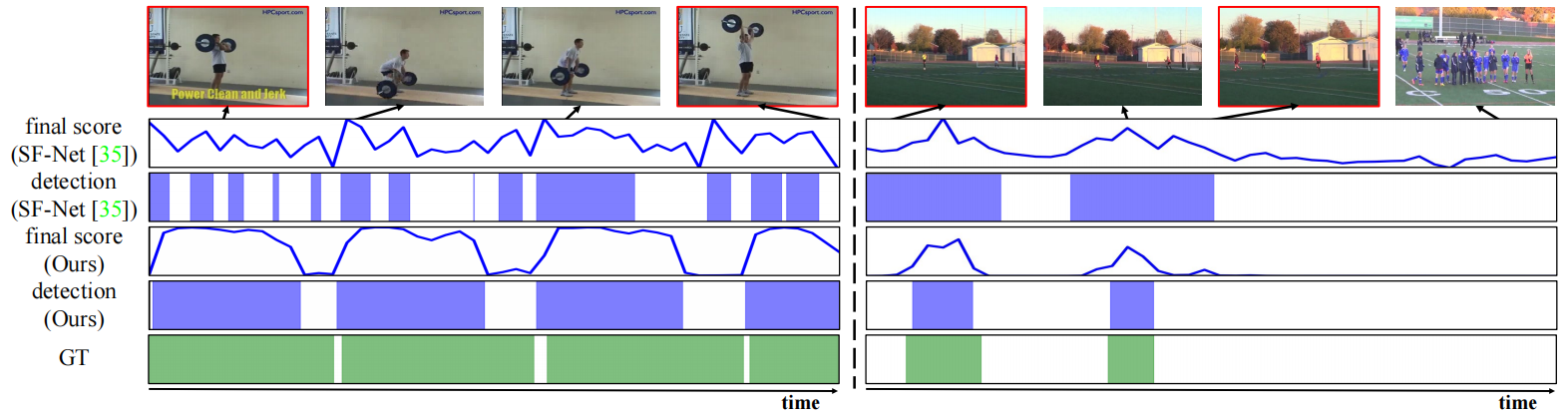

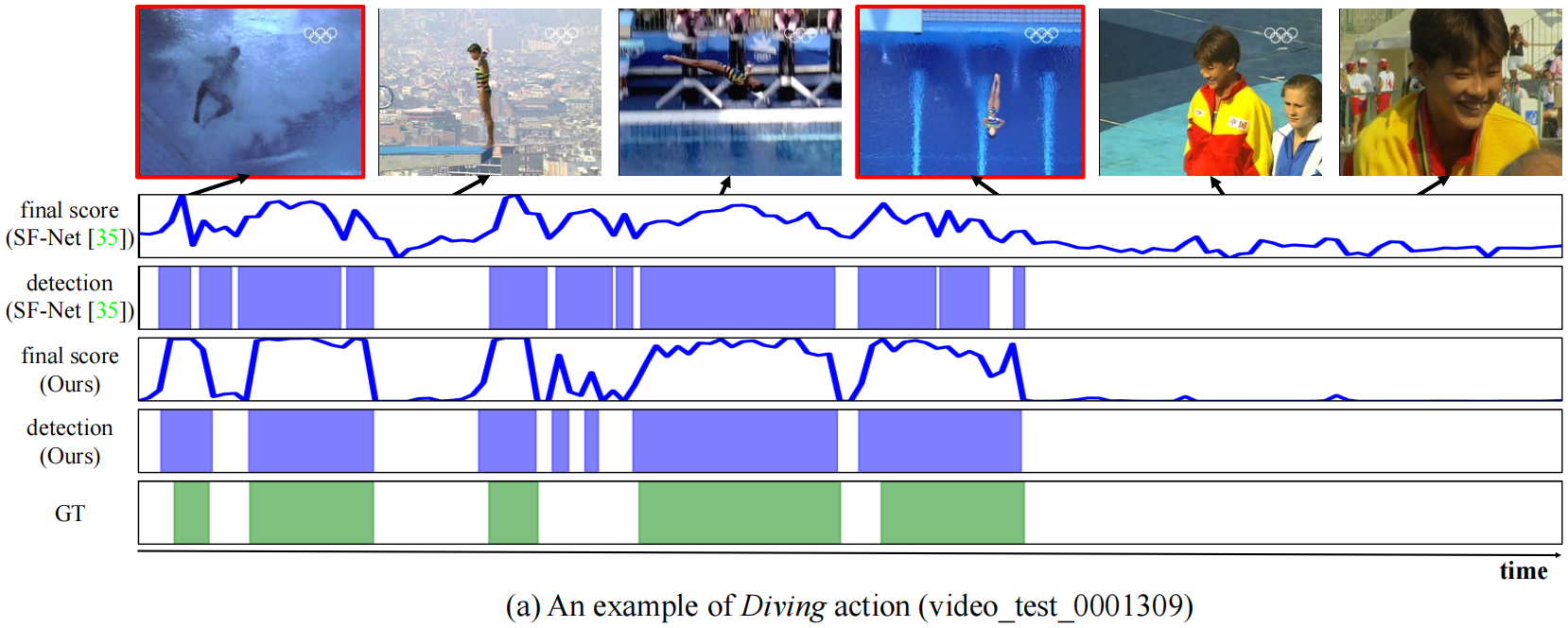

图4:在THUMOS'14上与SF-Net [35]的定性比较。我们提供了两个具有不同动作类的例子: (1)挺举和(2)罚球。对于每个视频,我们给出了来自SF-Net和我们的模型的最终分数和检测结果,以及ground truth行动间隔。我们的方法的检测阈值设置为0.2,并按照原始论文设置为SF-Net的平均分数。红框表示被SF-Net错误分类但被我们的方法检测到的帧。请注意,我们所有的检测结果都显示了与ground truth的高iou(>0.6)。

表7:THUMOS'14上不同分布的点级别标签比较。AVG表示IoU阈值为0.1:0.1:0.7时的平均mAP。

比较不同的标签分布。在表7中,我们探讨了不同的标签分布。“Manual”表示使用了[35]中的人工注释,而其他表示相应发行版中的模拟标签。结果表明,无论分布选择如何,我们的方法都明显优于现有方法,显示了其鲁棒性。我们还观察到,与其他分布相比,我们的方法在“均匀”分布中的性能稍差。我们推测这是因为辨别力较弱的点有更多的机会被注释。它们的邻域可能具有较低的置信度,这可能导致贪婪算法产生次优序列。事实上,最佳序列精度在均匀分布中是最低的,这支持了我们的说法。

4.4. 定性比较

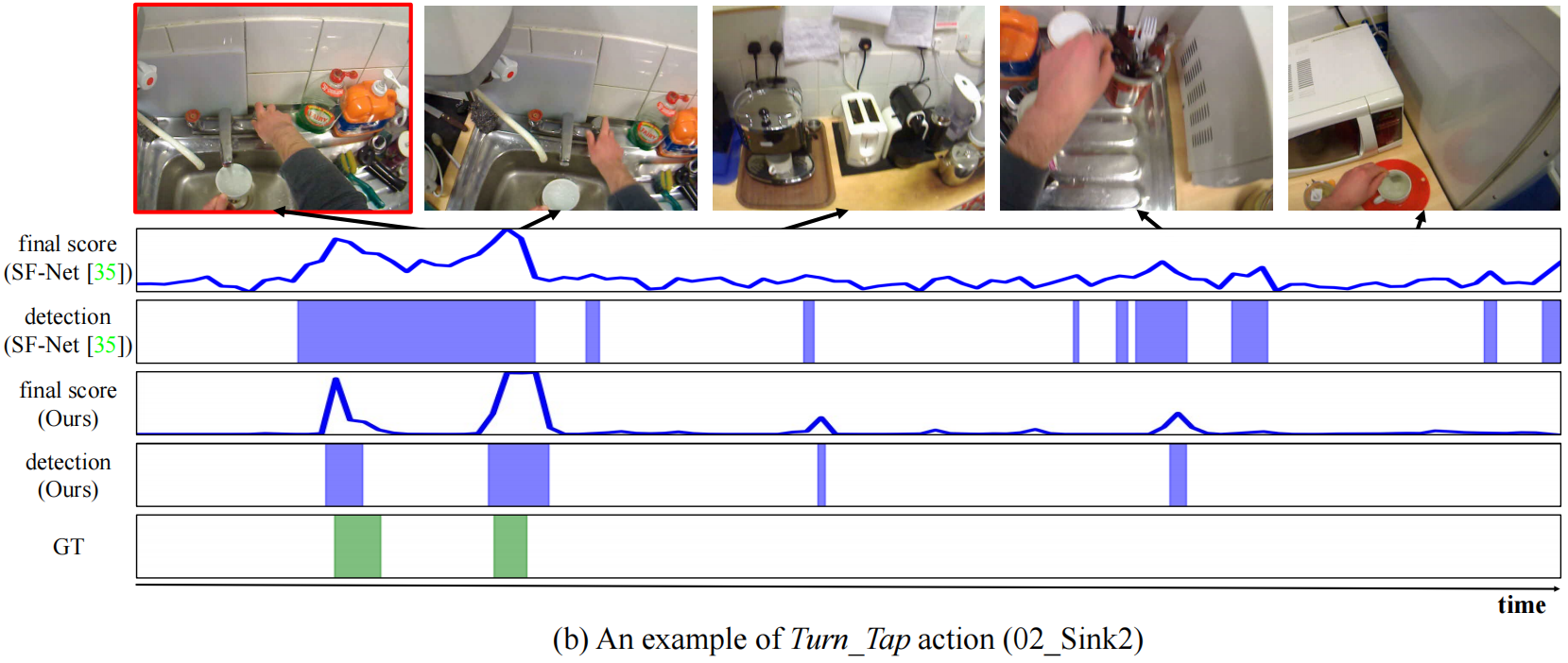

我们在图4中给出了与SF-Net[35]的定性比较。可以清楚地注意到,我们的方法可以更精确地定位动作实例。具体地说,在左例中,SF-Net生成了带有假阴性的片段预测,而我们的方法检测到了完整的动作实例,而没有拆分它们。在正确的样本中,虽然SF-Net高估了带有误报的动作实例,但我们的方法通过将动作帧与背景帧进行很好的对比来产生精确的检测结果。红色框分别突出显示左侧和右侧示例中SFNet的假阴性和假阳性。我们注意到,在这两个例子中,我们模型的所有预测都比相应的ground truth实例高出0.6,这验证了我们完整性学习的有效性。与其他基准测试和更多可视化结果的比较可在附录的Sec C中找到。

5.结论

在本文中,我们提出了一个新的点监督时间动作定位框架,其中密集序列为模型提供完整性指导。具体地说,我们根据完备性得分找到与点标签一致的最优序列,并用贪婪算法有效地实现了这一点。为了从获得的序列中学习完整性,我们引入了两个新的损失,这两个损失分别鼓励在动作得分和特征相似性方面在动作和背景实例之间进行对比。实验验证了最优序列的准确性,提出的损失确实有助于检测完整的动作实例。此外,我们的模型在四个基准上都有很大的差距,达到了新的水平。值得注意的是,尽管监督水平较低,但平均而言,它甚至优于完全监督的方法。

A.关于点级监督

在本文中,我们解决了点级监督下的时间动作定位问题。在这里,时间戳由时间轴上的“点”表示,而“点”在文献中也被广泛用于表示空间像素。Bearman等人[2]介绍了第一个弱监督语义分割框架,该框架将每个对象的单个注释像素作为监督。自那项工作以来,由于其可承受的注释成本,大量工作[15、18、19、49、74]一直致力于利用点级监督来解决图像或视频中的各种分割任务。同时,也有人试图利用点级监督来训练目标探测器[38,46,47]。另一方面,还探索了空间点,以便为弱监督的时空动作定位任务提供监督[39,40]。我们注意到,在我们的问题设置中,“点”的定义是基于时间维度的,与上述工作的定义不同。

B.贪婪最优序列搜索

正如本文所讨论的,最优序列选择的搜索空间将随着输入视频长度的增加而呈指数增长,这使得最优序列搜索变得困难。为了绕过成本问题,我们设计了一个贪婪算法,在固定预算的情况下,在每一步进行局部最优选择。具体地说,我们以顺序的方式处理输入视频,一个时间步取一段。在每个时间步t处,我们考虑所有与点标签一致的可能的t长度候选序列,并通过平均构成序列的动作和背景实例的对比分数来计算它们的完整性分数(正文的等式6)。在此计算中,我们不包括正在进行(即未终止)的实例,因为不展望未来就无法得出其对比度分数。之后,我们只保留具有前α 完整性得分(预算规模)的候选。当步骤t到达视频结束时,我们终止算法,选择得分最高的最优序列。这样,我们可以节省大量的计算成本,从而使搜索过程易于处理。我们的算法关于第c个类的伪代码在算法1中描述。

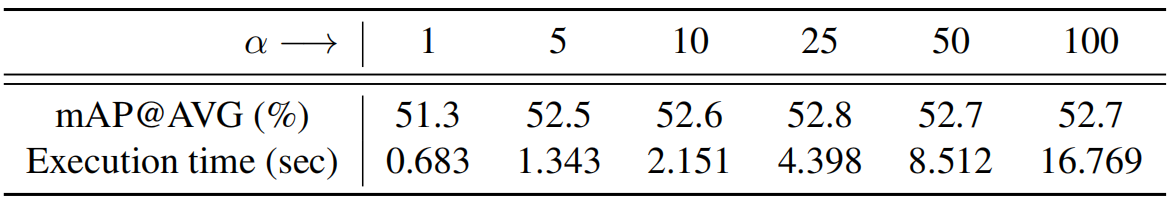

由于预算α会影响计算成本和性能,我们在THUMOS'14上研究了几种不同的预算大小。对于计算成本,我们对模型进行了100个epoch的训练,并报告了一个epoch(即200个训练视频)最佳序列选择的平均执行时间。该选择在具有16个工作进程的多处理中实现,并在单个AMD-3960X线程驱动器CPU上执行。表8显示了不同α值下的平均mAPs(%)和执行时间(秒),不出所料,当预算增加时,计算成本几乎呈线性增长,此外,当α设置为一个过小的值(例如1)时,所选择的最优序列可能是局部最优,导致性能的性能下降。另一方面,当α大于5时,性能差异不显著。这表明,该模型对预算规模具有相当强的鲁棒性,而一个不太小的α就足以找到能够为该模型提供有用的完整性指导的序列。在实践中,我们将α设置为25,因为它在处理整个训练视频的不到5秒的合理成本下实现了最佳性能。

表8:THUMOS'14预算规模分析。我们提供了执行时间以及IoU阈值0.1:0.1:0.7(从1到100)下的平均映射。每个epoch最佳序列选择的平均执行时间以秒为单位。α α

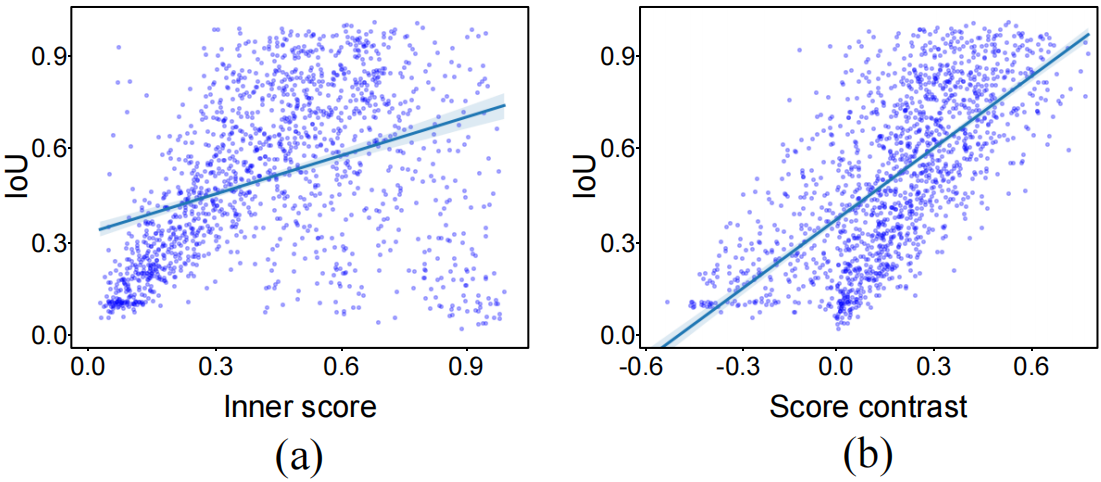

图5:分数和IOU与ground truth之间的相关性。(a) 内部分数显示出中等相关性(皮尔逊的r=0.38),而(b)分数对比显示出更强的相关性(皮尔逊的r=0.68)。

C.额外的实验

C.1.分数对比vs完整性。

为了分析分数对比度和动作完整性之间的相关性,我们利用THUMOS'14的训练视频中随机抽样的2000个时间间隔,通过ground truth动作实例绘制了分数对比度vs IoUs的散点图。作为参考,我们还提供了相同时间间隔内的内部行为得分与IOU的散点图。在实验中,我们使用基线模型进行公平比较。图5a表明,内部行为得分与IOU之间存在中度相关性,但许多情况下,内部得分较高,但IOU较低(见右下角)。相反,如图5b所示,分数对比度与IOU的相关性更强,证明了IOU在没有任何监督的情况下作为衡量行动完整性的指标的有效性。

算法1贪婪最优序列搜索

表9:THUMOS'14上不同伪背景挖掘方法的比较。AVG代表IoU阈值0.1:0.1:0.7时的平均mAP。

C.2.伪背景挖掘分析

我们在THUMOS'14上比较了伪背景挖掘的不同变体。具体而言,我们考虑三个变体:(1)"Global mining"在整个视频中选择得分最高的ηMact个点,而不考虑它们的位置,如SF-Net(35),其中,Mact为动作实例的数量,η设置为5,(2)"Ours w/o filling"遵循3.1节中描述的原理,除了填充阶段,即我们为两个行动点之间的每个部分选择至少一个背景点,(3)"Ours",如果在第二个变体中发现多个点,则挖掘每个部分的背景点之间的所有点。请注意,我们使用的是基线模型,没有完整性学习来进行清晰的比较。

结果如表9所示。可以观察到,我们的两种方法都显著优于“全局挖掘”方法,这验证了我们的选择原则的有效性,即每个部分至少应放置一个背景点。此外,通过确保每个部分至少有一个背景点,可以显著减少最佳序列选择的搜索空间,尽管我们不包括本实验的成本分析。同时,我们注意到,两个背景点之间的填充略微提高了定位性能。这大概是因为在填充步骤中可以收集到背景分数较低的hard背景点。

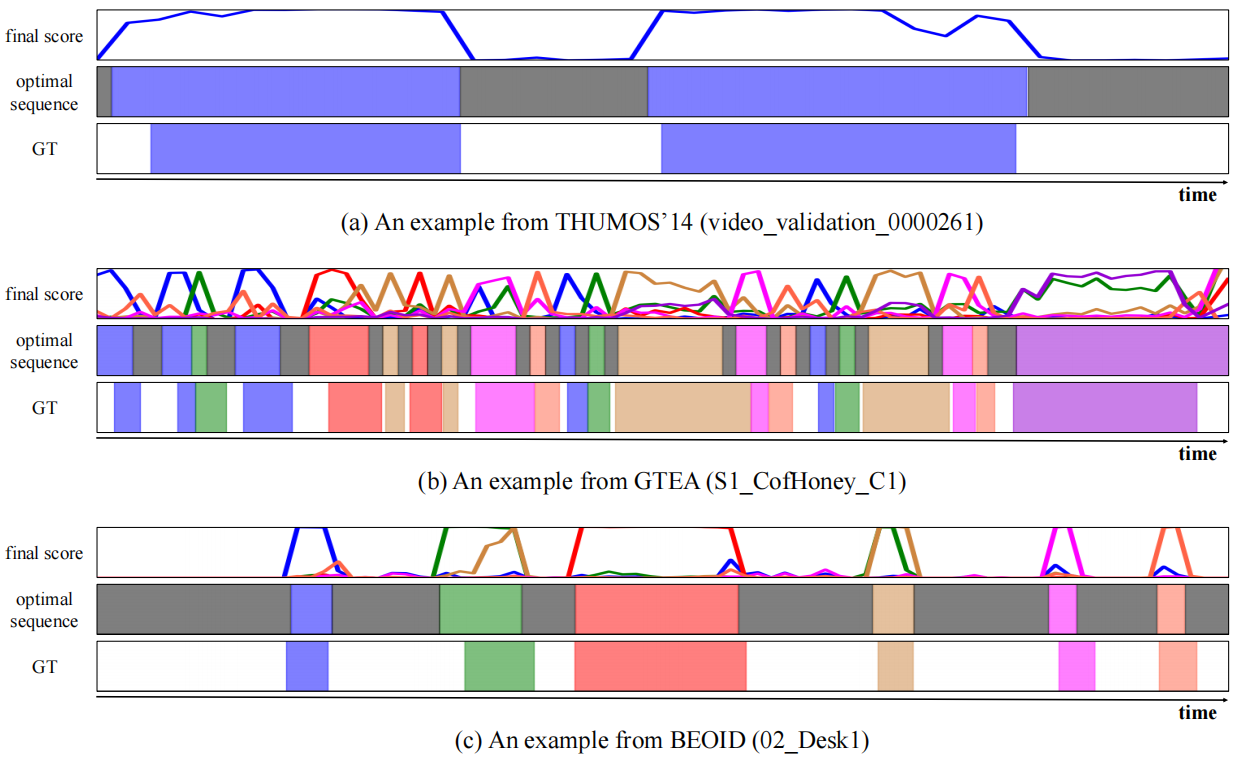

C.3.最优序列可视化

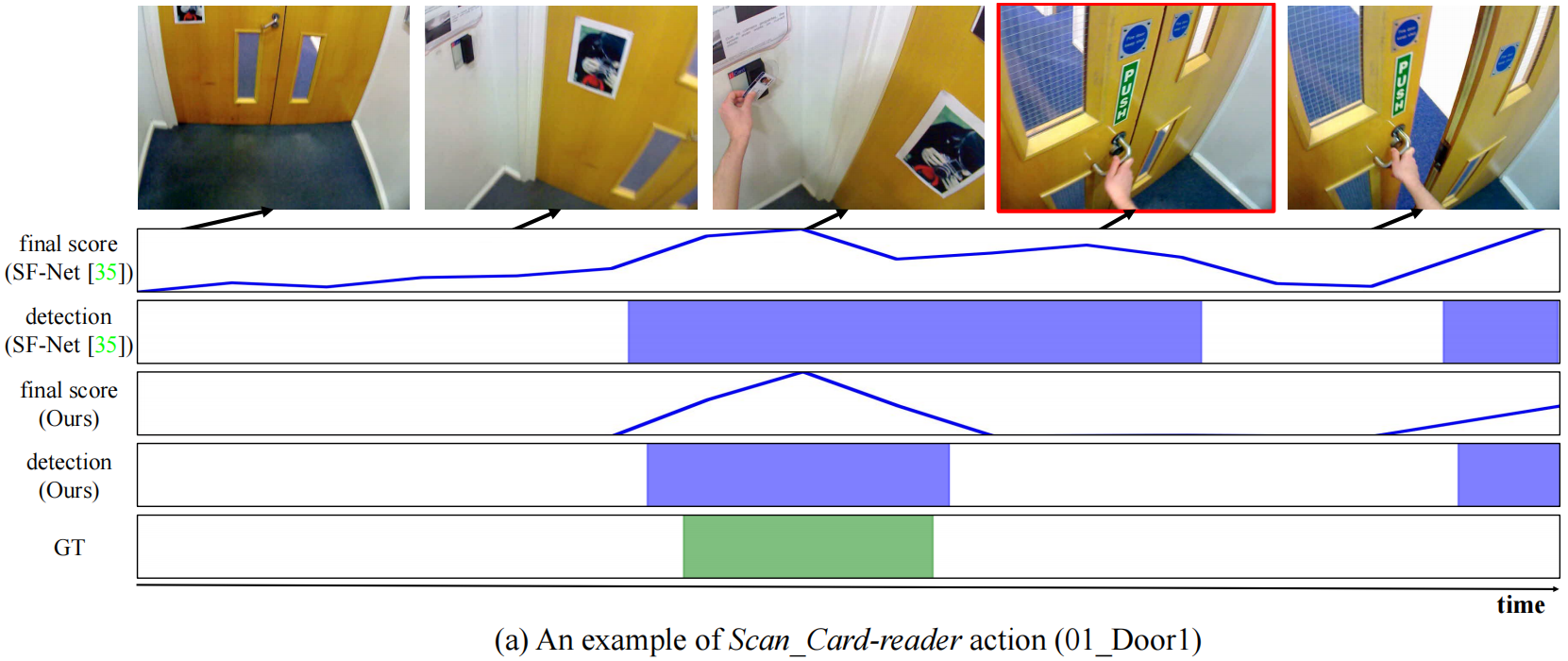

在图6中,我们可视化了从三个基准测试中获得的示例的最佳序列。在THUMOS'14(a)中的第一个例子中,最优序列很好地覆盖了ground truth动作实例,因此模型可以从中学习动作完整性。此外,尽管GTEA(b)和BEOID(c)的例子在一个视频中包含了各种动作类,但我们的方法成功地找到了最佳序列,该序列显示了与基本真相的大量重叠。总的来说,从所有的例子中可以看出,即使在没有完全监督的情况下根据点级标签选择最佳序列,它们也是相当准确的。它们反过来为我们的模型提供了完整性指导,这印证了在正文的4.3节中高IoU阈值下定位性能的提升。

C.4.更多的定性比较

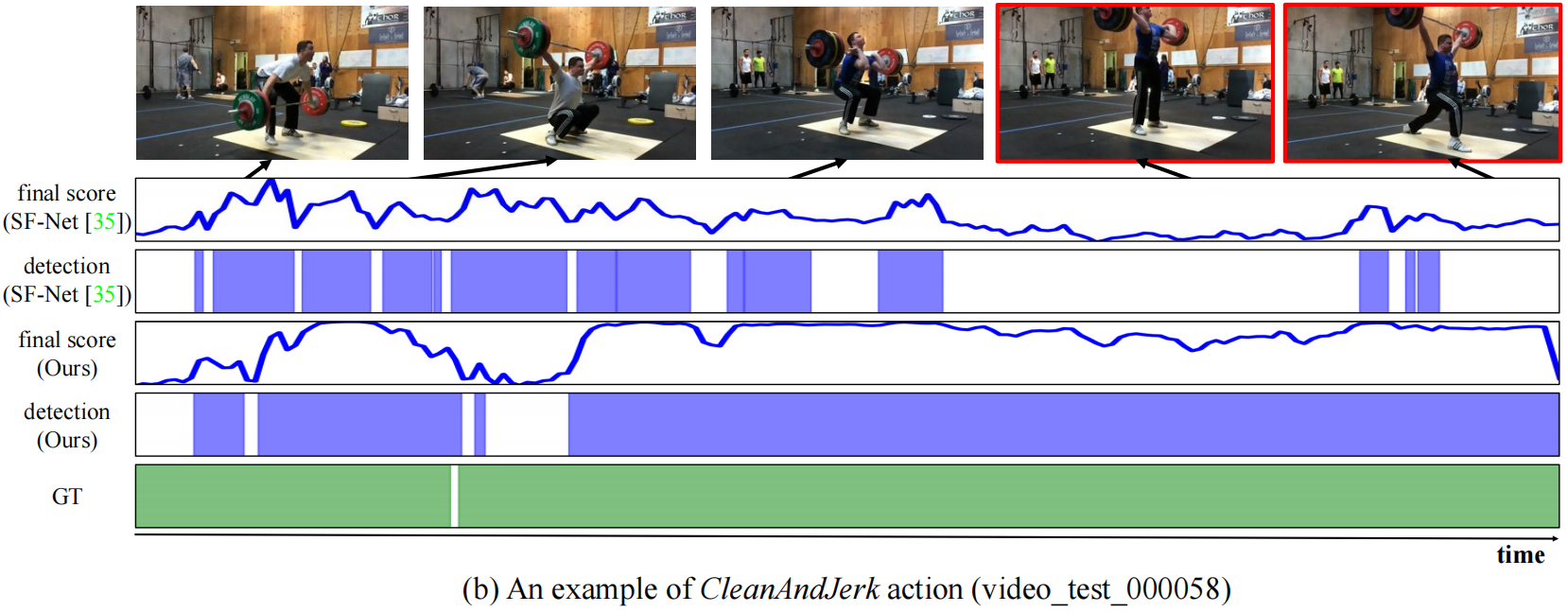

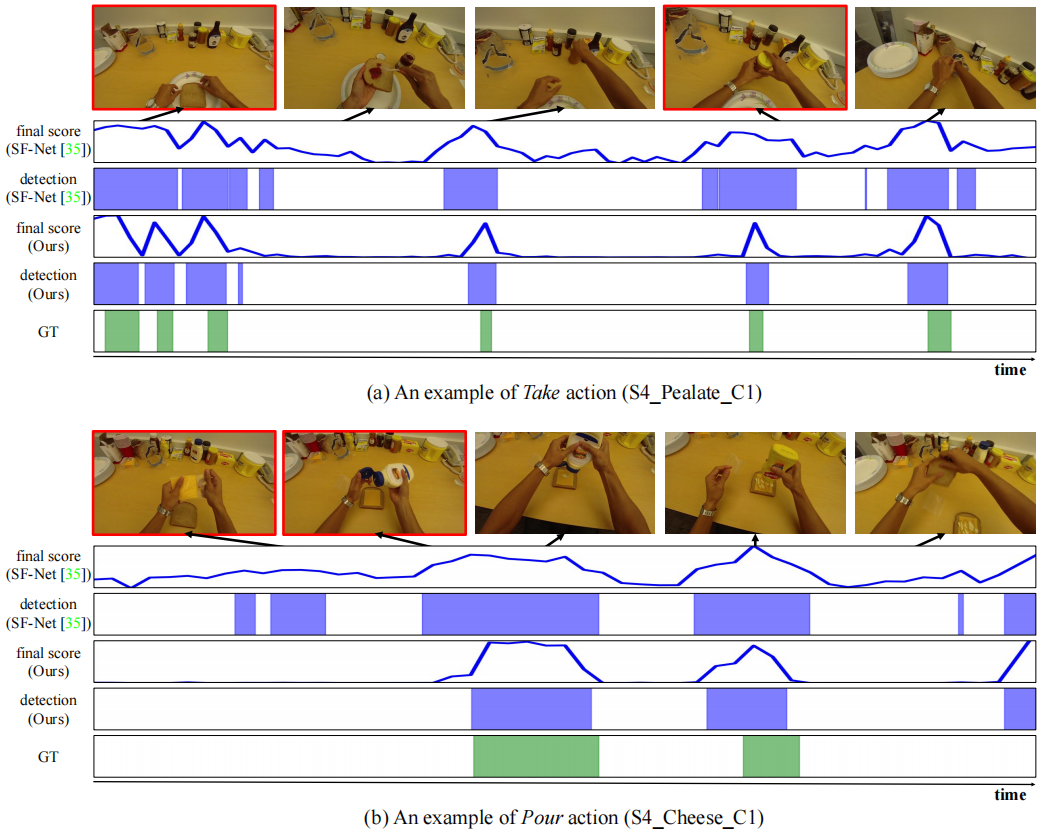

我们在三个基准上定性地将我们的方法与SF-Net[35]进行了比较。图7展示了对图莫斯14[13]的比较。如图所示,SFNet通过拆分动作实例来生成零碎的预测,而我们的方法即使对于非常长的动作实例(b),也会以高IOU输出完整的预测。GTEA[23]的比较结果如图8所示。需要指出的是,GTEA上的动作定位具有挑战性,因为不同动作类别的框架在视觉上相似,导致误报。我们发现SFNet很难区分动作实例和背景实例,导致定位不准确。另一方面,我们的方法通过学习完备性成功地找到了动作实例,显示出较少的误报。最后,BEOID[7]的比较如图9所示。可以清楚地注意到,SF-Net无法预测动作实例的结束时间,导致了高估问题。相反,在完整性指导的帮助下,我们的方法更好地将动作与其周围环境分开,并更精确地定位动作实例。

图6:三个基准上的最佳序列可视化。这些例子分别取自(a)THUMOS'14、(b)GTEA和(c)BEOID。请注意,所有示例都属于相应基准的训练集。对于每一个视频,我们给出最终分数和获得的最佳序列以及ground truth行动间隔。每个图中的横轴表示视频的时间步长,而第一个图中的纵轴表示从0到1的分数值。对于每个示例,不同的颜色对应不同的动作类别,而灰色表示背景类别。

图7:THUMOS'14与SF-Net[35]的定性比较。我们提供了两个不同动作类别的例子:(a)跳水和(b)挺举。对于每一个视频,我们展示了SF网络和我们的模型的最终分数和检测结果,以及ground truth行动间隔。水平轴表示视频的时间步长,而垂直轴表示从0到1的分数值。我们的方法将检测阈值设置为0.2,并将SF-Net的检测阈值设置为原始论文的平均分数。红色框表示SF-Net错误分类但我们的方法检测到的帧。我们所有的检测结果都显示,无论其长度如何,具有相应的ground truth性的高IOU(>0.5)。

图8:GTEA与SF-Net[35]的定性比较。我们提供了两个不同动作类的例子:(a)Take和(b)Pour。对于每一个视频,我们展示了SF网络和我们的模型的最终分数和检测结果,以及ground truth行动间隔。每个图中的横轴表示视频的时间步长,而纵轴表示从0到1的分数值。我们的方法将检测阈值设置为0.2,并将SF-Net的检测阈值设置为原始论文的平均分数。红色框表示SF-Net的假警报,但我们的方法拒绝了它们。与SF-Net相比,我们的方法能够更精确地定位动作实例,且误报率更低。

图9:BEOID上与SF-Net[35]的定性比较。我们提供了两个不同动作类的例子:(a)扫描读卡器和(b)旋转点击。对于每一个视频,我们展示了SF网络和我们的模型的最终分数和检测结果,以及ground truth行动间隔。每个图中的横轴表示视频的时间步长,而纵轴表示从0到1的分数值。我们的方法将检测阈值设置为0.2,并将SF-Net的检测阈值设置为原始论文的平均分数。红色框表示SF-Net在高IoU阈值下的错误警报,会恶化性能。当SF-Net高估了动作实例时,我们的方法通过区分动作实例和背景来检测完整的动作实例。

浙公网安备 33010602011771号

浙公网安备 33010602011771号