Hadoop综合大作业

1.用Hive对爬虫大作业产生的文本文件(或者英文词频统计下载的英文长篇小说)进行词频统计。

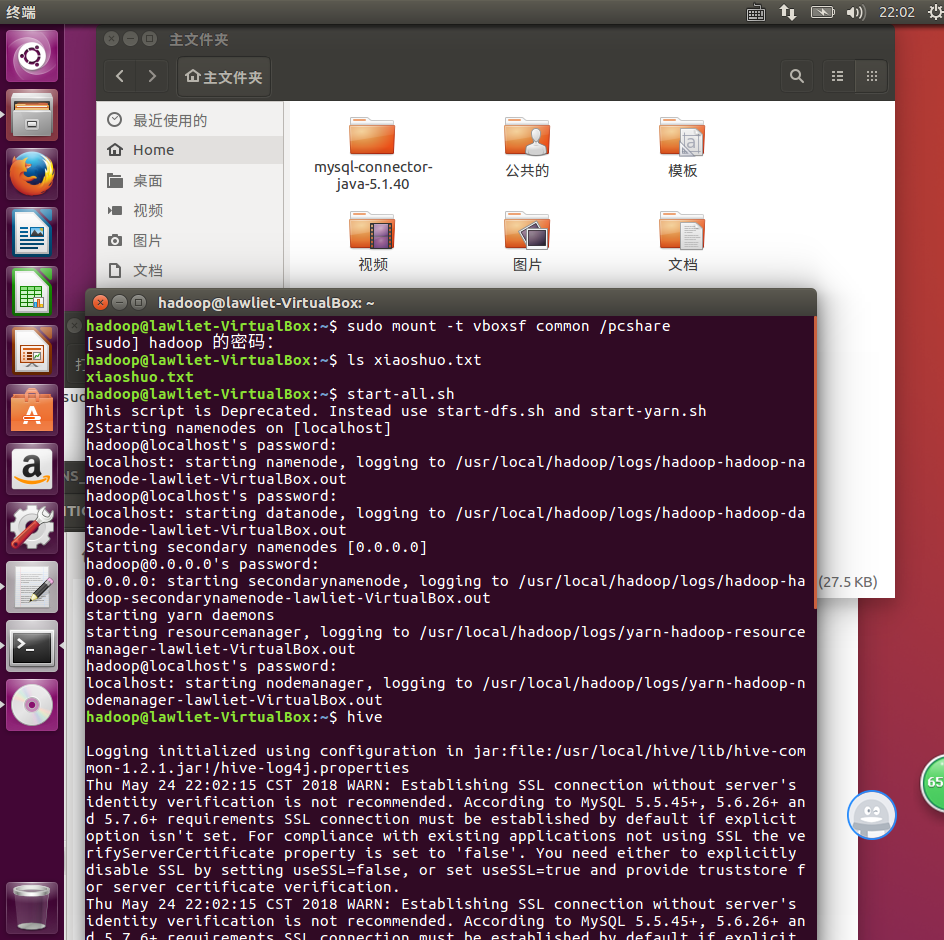

将小说利用vb共享文件夹传到虚拟机

启动hive

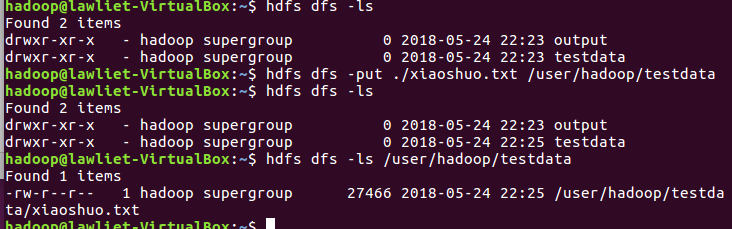

将小说上传到hdfs

中间出现“Parent path is not a directory: /user/admini”错误,后将/user/hadoop文件夹重建后解决

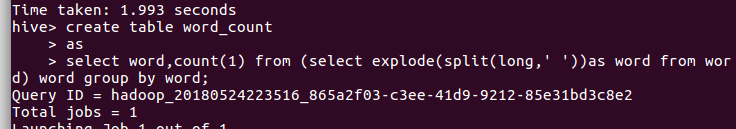

将小说传到数据库

存到word_count表

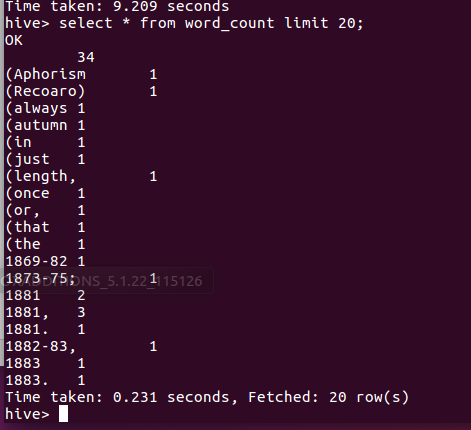

查询结果

2.用Hive对爬虫大作业产生的csv文件进行数据分析,写一篇博客描述你的分析过程和分析结果。

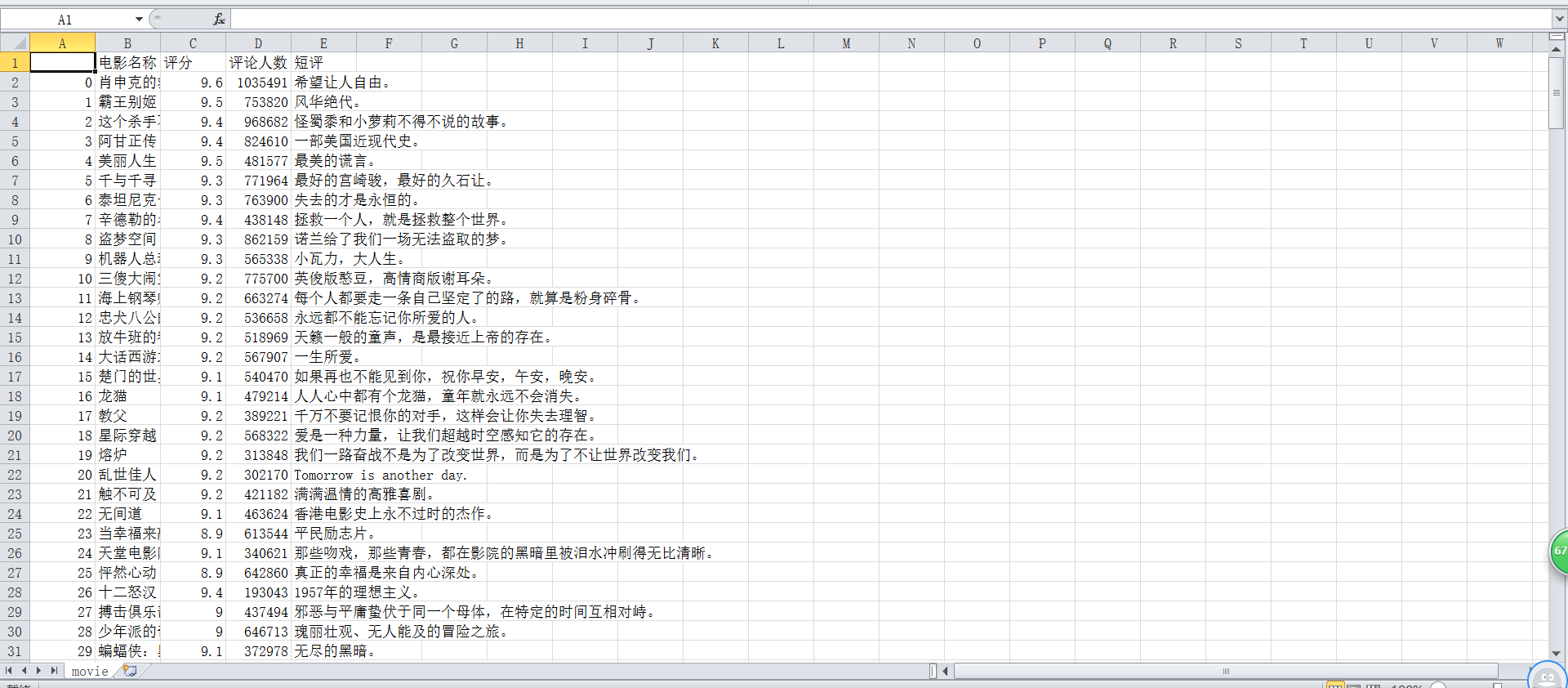

爬虫大作业产生CSV文件一览图:

csv生成时出现乱码,使用notepad++将其编码从UTF-8转换为UTF-8无BOM解决。

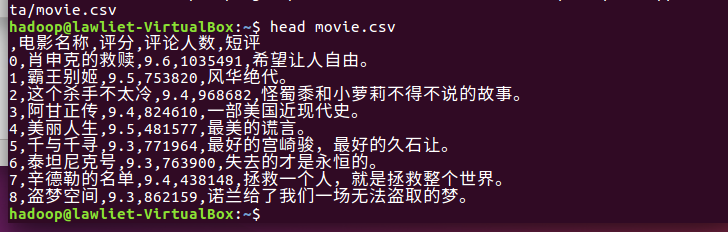

将文件从虚拟机共享文件夹中传过来并查看数据。

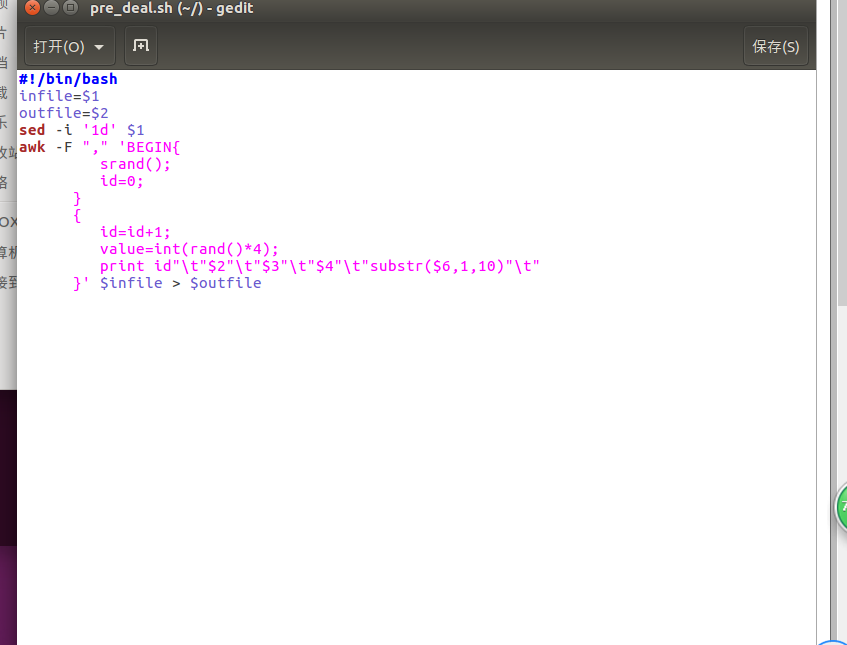

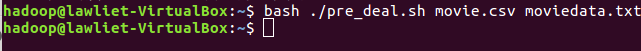

数据预处理

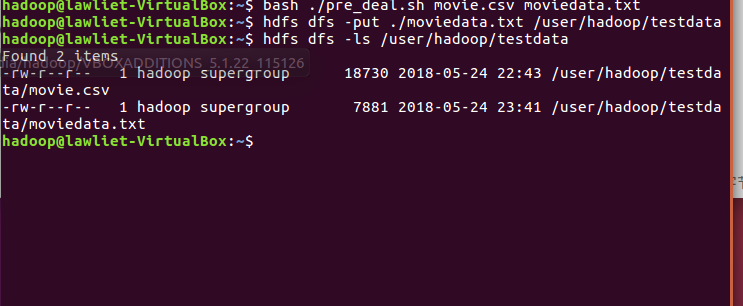

将处理后的txt文本上传到hdfs

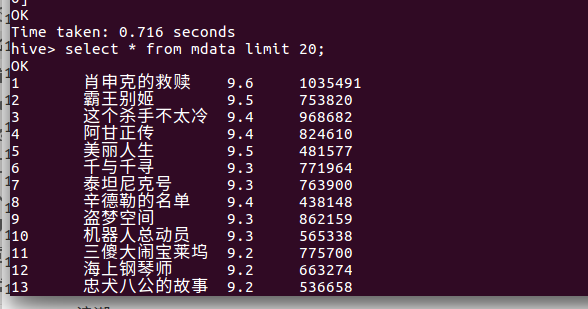

存到hive后查看

浙公网安备 33010602011771号

浙公网安备 33010602011771号