分布式日志系统ELK+skywalking分布式链路解决方案

在分布式系统中,日志跟踪是一件很令程序员头疼的问题,在遇到生产问题时,如果是多节点需要打开多节点服务器去跟踪问题,如果下游也是多节点且调用多个服务,那就更麻烦,再者,如果没有分布式链路,在生产日志飞速滑动的情况下,很难找出问题。

所以,分布式系统中很有必要搭建一套分布式日志系统,笔者采用了市面成熟的解决方案ELK+skywalking解决,本文将从0到1搭建一个分布式日志系统。

1.kibana:在kibana中可直接查看线上错误日志,trace_id表示这次请求的唯一链路id,关键词搜索功能强大

2.skywalking:通过1中的trace_id在skywalking中搜索,能迅速定位到日志

一、架构说明:

1.skywalking:分布式链路解决方案,可记录整条链路的调用详情,含所有下游服务,TID贯穿整条链路

2.elasticsearch1:用来存储skywalking的链路数据

3.filebeat:见名知意,文件心跳,用来收集springboot的日志文件,原理就是可指定log未知,开启收割机定时收集日志

4.logstash:用来过滤有效的日志信息,比如收集IP、TID等信息,定义索引规范,数据存储对接es

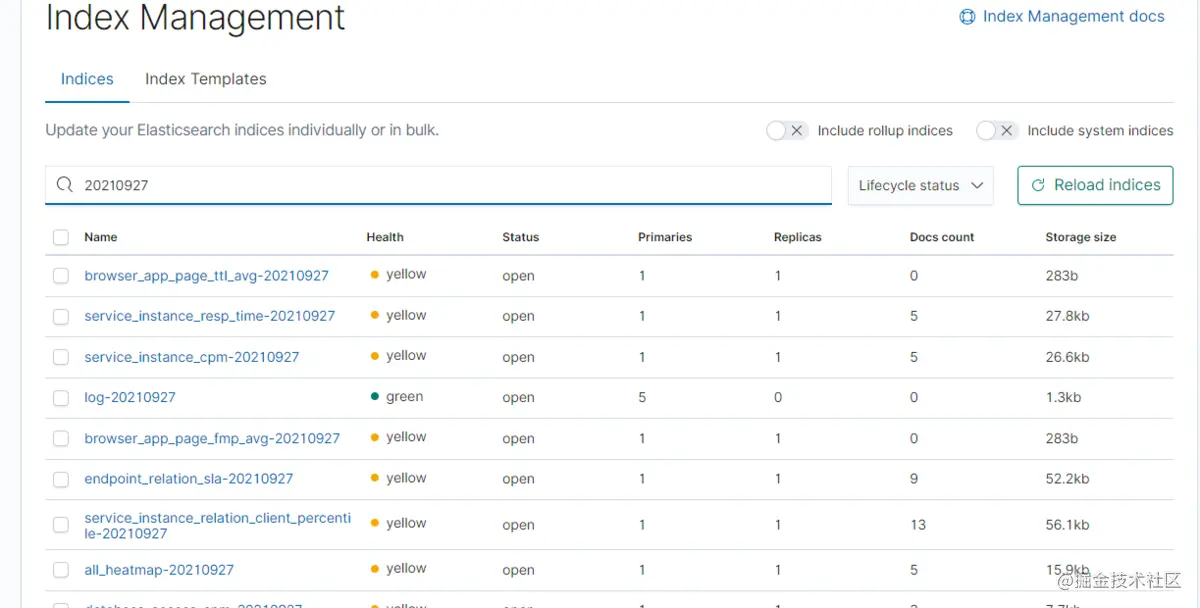

5.elasticsearch2:用来存储logstash过滤后的日志信息,本文主要存储错误日志

6.kibana:读取elasticsearch2的错误日志,UI页面

二、搭建流程

机器配置:两台32G的服务器,ES没有上集群版,按需扩充

1.elasticsearch和kibana搭建

以前搭建过,这里就不赘述了,具体看这里www.jianshu.com/p/a69f8cefe…

2.skywalking搭建

下载地址:archive.apache.org/dist/skywal…

因为我使用的es是7.6.2版本,所以下载apache-skywalking-apm-es7-8.4.0.tar.gz

①下载后解压,修改webui的端口号:webapp/webapp.yml

修改skywalking oap服务配置文件 conf/application.yml,保存日志到es

配置表示trace记录保持7天,之后自动删除

storage.elasticsearch7配置(省略了${},转义错误)

recordDataTTL: SW_STORAGE_ES_RECORD_DATA_TTL:7

otherMetricsDataTTL: SW_STORAGE_ES_OTHER_METRIC_DATA_TTL:45

monthMetricsDataTTL: SW_STORAGE_ES_MONTH_METRIC_DATA_TTL:18

②启动apache-skywalking-apm-bin/bin/startup.sh

该脚本会启动两个服务,一个是webUI的服务,一个是oap收集日志服务

③在应用机02上传apache-skywalking-apm-es7-8.4.0.tar.gz,解压

④修改springboot启动脚本(java agent探针技术)

java -javaagent:apache-skywalking-apm-bin/agent/skywalking-agent.jar -Dskywalking.agent.service_name=${pro} -Dskywalking.collector.backend_service=xxx:11800 -jar xxx.jar >> logs/catalina.out &

⑤springboot集成skywalking服务

<!--skywalking--> <dependency> <groupId>org.apache.skywalking</groupId> <artifactId>apm-toolkit-logback-1.x</artifactId> <version>8.4.0</version> </dependency> logback-spring.xml配置 <encoder class="ch.qos.logback.core.encoder.LayoutWrappingEncoder"> <layout class="org.apache.skywalking.apm.toolkit.log.logback.v1.x.TraceIdPatternLogbackLayout"> <!-- 日志格式中添加 %tid 即可输出 trace id --> <Pattern>${APP_NAME}:${ServerIP}:${ServerPort} %d{yyyy-MM-dd HH:mm:ss.SSS} %-5level %tid %t %logger{36}: %msg%n</Pattern> </layout> </encoder>

3.filebeat搭建

①在JAVA应用服务器上搭建,采用的版本是filebeat-7.6.2-linux-x86_64,和es的版本要保持一致

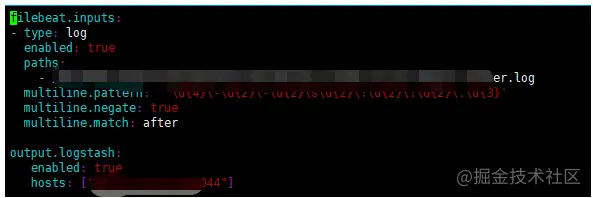

②新建filebeat-logstash.yml

multiline.pattern: '^\d{4}-\d{2}-\d{2}\s\d{2}:\d{2}:\d{2}.\d{3}'

③启动

./filebeat -e -c filebeat-logstash.yml

4.logstash搭建

①在软件机01上传logstash-7.6.2

②在logstash-7.6.2/config新建filebeat-grok.conf

message表示索引 mapping

index 表示索引名称,按天建立,然后写定时任务保留最近X天

总结几个注意事项

1.需要保证kibana和skywalking web ui的安全性,可以通过nginx设置登录密码

2.oap服务需要根据调用量灵活调整

3.es需要搭建集群,需要设置定期清理,比如保留最近7天日志

4.skywalking增强:有报警服务、grpc日志上传服务等,需要另外配置

5.缺点:filebeat和skywalking的agent服务需要安装在每台应用机器上

————————————————

版权声明:本文为CSDN博主「qq_20630341」的原创文章,遵循CC 4.0 BY-SA版权协议,转载请附上原文出处链接及本声明。

原文链接:https://blog.csdn.net/qq_20630341/article/details/120530263

浙公网安备 33010602011771号

浙公网安备 33010602011771号