Hypergraph Neural Networks

核心问题与动机

-

图神经网络的局限:

传统 GCN 基于简单图(Simple Graph),每条边仅连接两个节点,无法表达现实数据中更复杂的关联(如社交网络中用户的多重互动、多模态数据的跨模态联系)。 -

超图的优势:

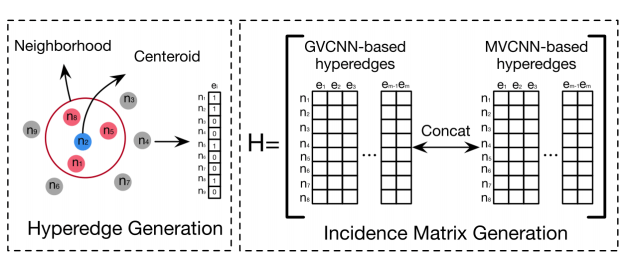

超图(Hypergraph)的超边(Hyperedge) 可连接任意数量的节点(如图 2 所示),能灵活建模高阶关系(例如:一个超边可关联同一话题下的所有推文、视觉相似的多个图像等)。

方法创新:HGNN 框架

1. 超图结构建模

-

定义:超图 G=(V,E,W)

-

V:节点集合(如数据样本)

-

E:超边集合(如数据关联组)

-

W:超边权重矩阵

-

-

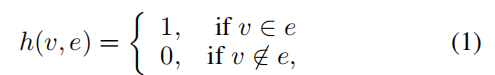

关联矩阵 H:

∣V∣×∣E∣ 矩阵,其中 h(v,e)=1 表示节点 v 属于超边 e(公式 1)。

2. 超边卷积操作(核心贡献)

-

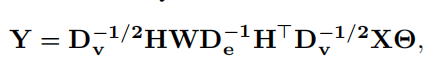

关键公式(公式 10):

Y=Dv−1/2HWDe−1H⊤Dv−1/2XΘ

-

-

X:输入节点特征(n×C1)

-

Θ:可学习参数(C1×C2)

-

Dv,De:节点度与超边度的对角矩阵(用于归一化)

-

-

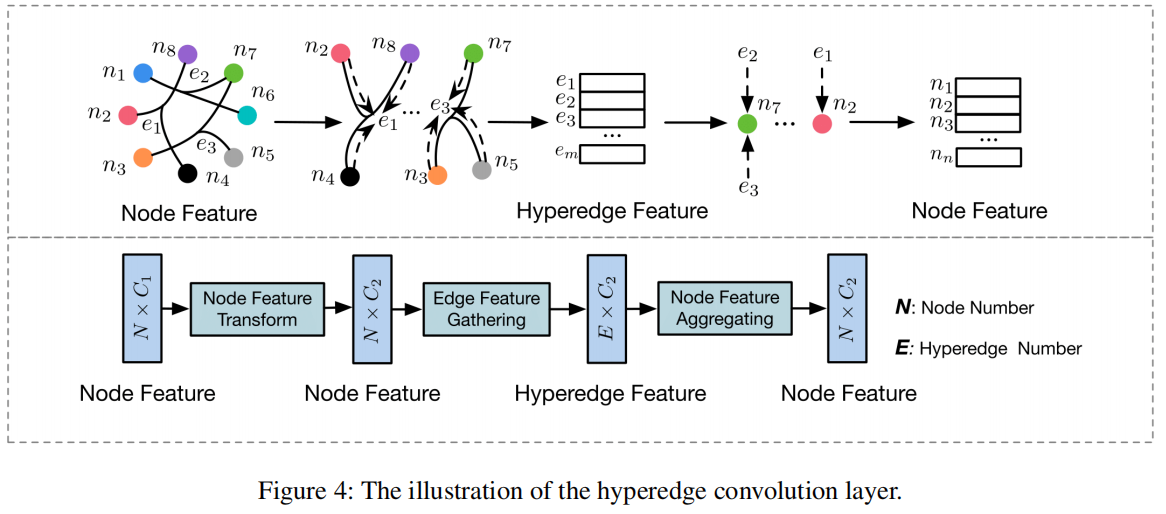

物理意义:

通过矩阵变换实现“节点→超边→节点”的信息传递(图 4):-

H⊤X:聚合节点特征至超边。

-

H⋅(超边特征):将超边特征传播回关联节点。

-

-

高效性:避免传统超图方法中拉普拉斯矩阵求逆O(n3)),计算复杂度降至 O(∣E∣×K)(K 为超边平均大小)。

3. 与现有方法的关联

-

GCN 是特例:当所有超边仅连接 2 个节点时,HGNN 退化为 GCN。

-

超越传统超图学习:通过可微卷积替代高成本优化过程(如 Zhou et al. 2007 的传播算法)。

实验验证

1. 任务 1:引文网络分类(Cora, Pubmed)

-

设置:

-

用词袋特征表示文档,基于引用关系构建超边(节点为中心+邻居节点)。

-

对比方法:DeepWalk、GCN、Chebyshev 等。

-

-

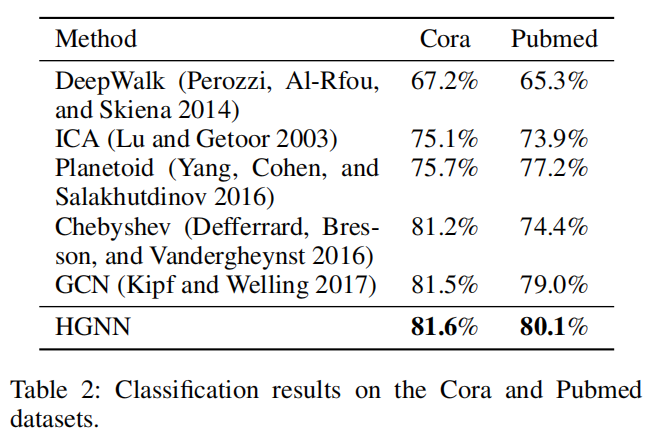

结果(表 2):

-

HGNN 准确率:Cora 81.6%,Pubmed 80.1%(优于 GCN 的 81.5%/79.0%)。

-

分析:超图结构与传统图相似时,性能提升有限(因数据本身缺乏高阶关联)。

-

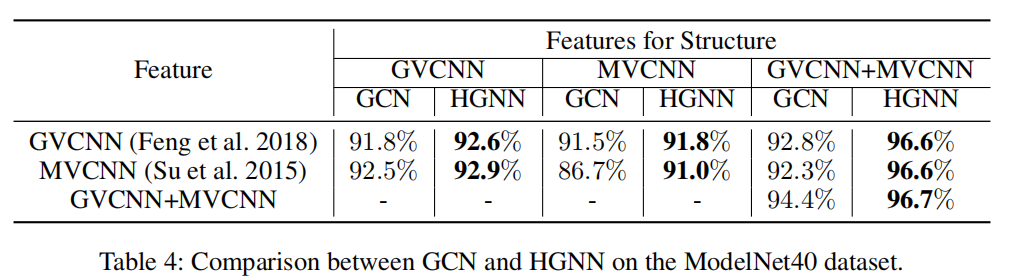

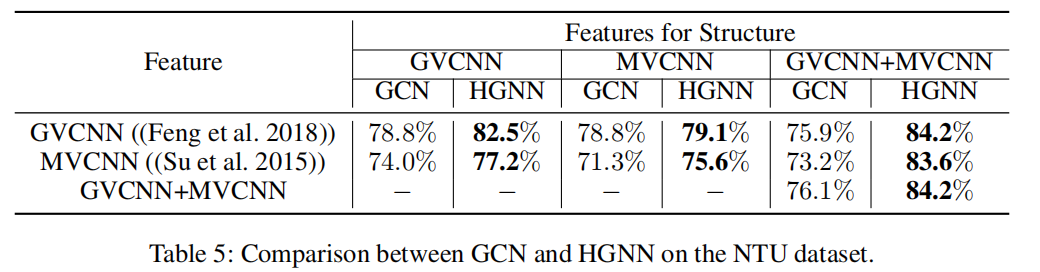

2. 任务 2:视觉物体识别(ModelNet40, NTU)

-

多模态超图构建(图 5):

-

单模态:基于欧氏距离,每个节点与其 K 近邻构建超边。

-

多模态:融合不同特征(如 MVCNN/GVCNN)的关联矩阵 H。

-

-

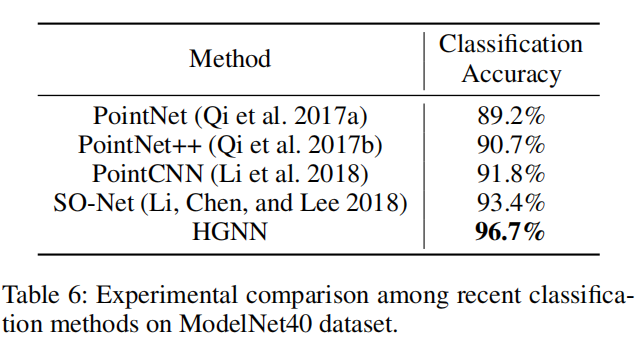

关键结果:

-

ModelNet40(表 4):HGNN 达 96.7%,显著优于 PointCNN (91.8%)、SO-Net (93.4%)。

-

NTU(表 5):多模态特征下,HGNN 比 GCN 提升 8.1–10.4%(如 84.2% vs 76.1%)。

-

HGNN方法的优越性能(表 6):提出的HGNN方法在ModelNet40数据集上的性能优于最先进的对象识别方法。具体来说,与PointCNN和SO-Net相比,HGNN方法分别实现了4.8%和3.2%的性能提升。这些结果证明了HGNN方法在视觉对象识别上的优越性能。

-

-

结论:

-

多模态数据下,HGNN 通过超边融合异构信息,性能优势显著。

-

高阶关联建模是性能提升的关键(如物体多视角间的复杂关系)。

-

贡献总结

-

理论创新:

-

首次将谱卷积推广至超图,提出可微的超边卷积算子。

-

证明 GCN 是 HGNN 在二元关系下的特例。

-

-

应用价值:

-

为多模态数据(视觉+文本)、社交网络分析等需建模高阶关联的任务提供通用框架。

-

开源代码促进后续研究(论文未提及,但此类工作通常公开)。

-

局限与未来方向

-

超图构建依赖启发式规则(如 K 近邻),未来可探索自适应超边生成。

-

计算效率:超边数量较大时,需进一步优化(如采样策略)。

-

拓展至动态超图:当前方法处理静态结构,动态数据关联是挑战。

浙公网安备 33010602011771号

浙公网安备 33010602011771号