论文《Network Pruning via Transformable Architecture Search》

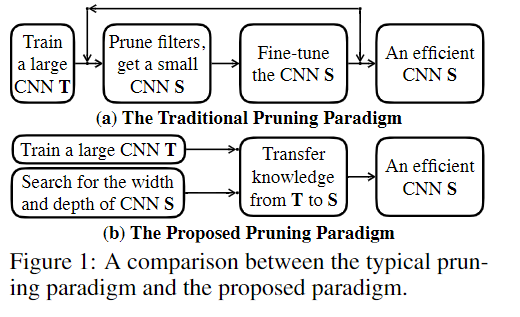

上图为传统的神经结构搜索算法与TAS的对比。

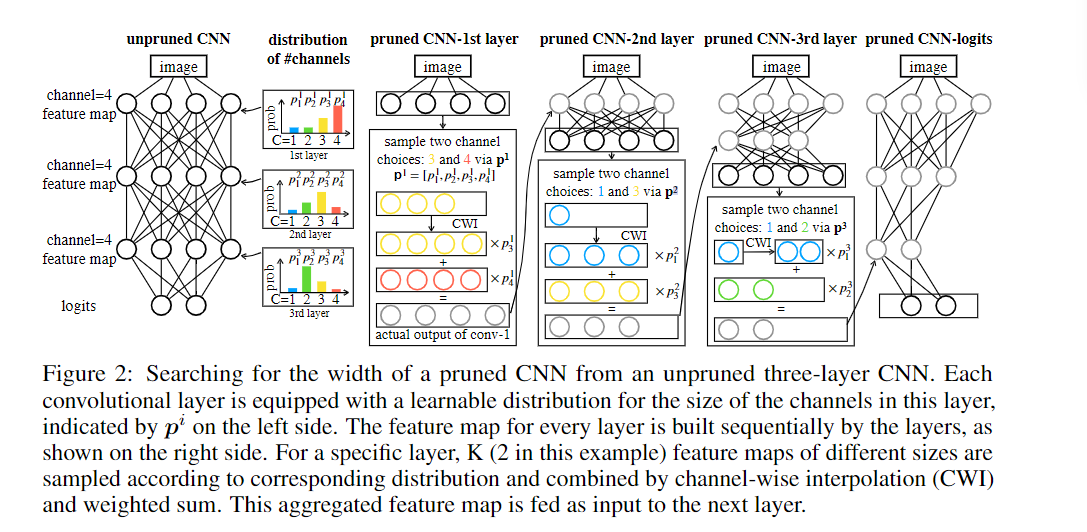

整体的网络模型结构图,为每个通道设定一个超参数α(可更新),用于计算该通道可能被保留的概率,可视为该通道的贡献度。贡献度越大,被保留的概率越大。之后对每一层保留的通道数进行K次采样,如图中K=2个。如图中第一层,采样的通道数为3和4,则对前三个通道与P3进行乘积,前4个通道与P4进行乘积,最后通道对齐(channel wise interpolation,CWI)进行相加作为该层的最终输出。此处的通道对齐(CWI)使用的是3D的自适应平均池化操作。

需要注意的是,采样的过程不能够进行梯度回传,所以不能够从Pi回传到αi,此文引入了Gumbel-softmax分布来soften采样过程以此来优化α。

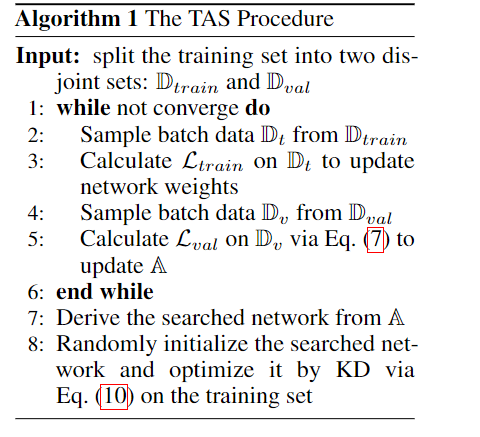

最终的LOSS还引入了计算损失,此处的计算损失是使用分段计算,这样能够使得模型在收敛目标周围更加敏感。

在获得小模型后,将其权重随机初始化,并使用蒸馏技术来训练小模型。

整体的算法过程如下:

浙公网安备 33010602011771号

浙公网安备 33010602011771号