论文《Knowledge Distillation with the Reused Teacher Classifier》

在某种程度上,我们重用教师分类器的关键思想是与之前关于假设迁移学习 (HTL) 的研究有关。HTL 旨在利用学习到的源域分类器来帮助目标域分类器的训练,条件是只有少量标记的目标数据集并且没有可用的源数据集。

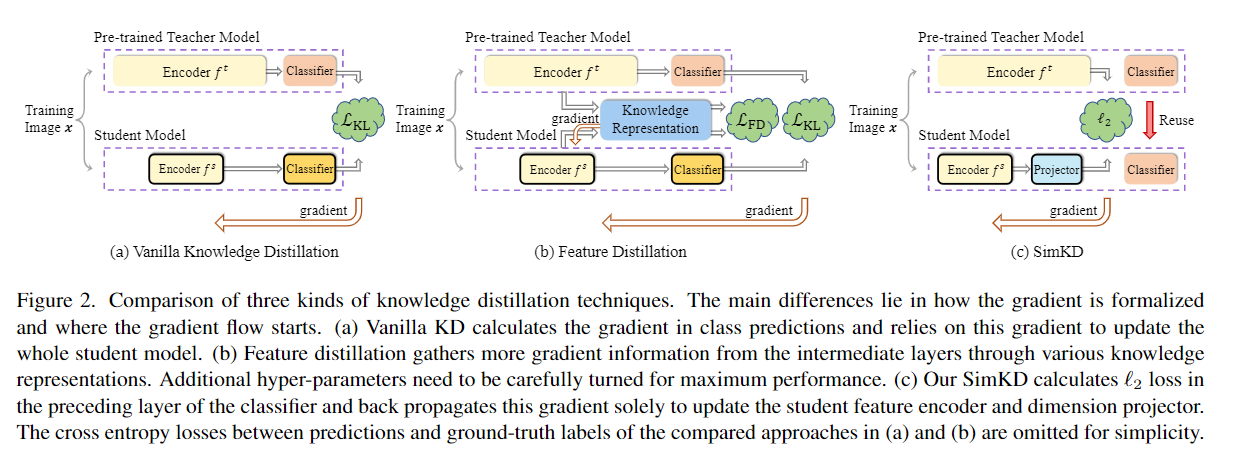

SimKD 的一个关键组成部分是“分类器重用”操作,即我们直接借用预训练的教师分类器进行学生推理,而不是利用教师网络的soft target去训练一个新的分类器。这消除了标签信息计算交叉熵损失的需要,并使特征对齐损失成为生成梯度的唯一来源。

来自预训练教师模型的重用部分允许合并更多层,而不仅仅是仅限于最终分类器。通常,重用更多的层会导致更高的学生准确性,但会给推理带来负担增加。

浙公网安备 33010602011771号

浙公网安备 33010602011771号