[Spark News] Spark + GPU are the next generation technology

一、资源:Spark进行机器学习,支持GPU

From:https://my.oschina.net/u/2306127/blog/1602291

为了使用Spark进行机器学习,支持GPU是必须的,上层再运行神经网络引擎。

目前AWS\GCP和Databricks的云都已经支持GPU的机器学习,AliYun也在实验之中。

这包括几个层次:

- GPU直接支持Spark。因为Spark是多线程的,而GPU往往只能起一个单例,导致线程会竞争GPU资源,需要进行管理、加锁和调度。方法包括:

- 原生代码内置编译支持。

- 引入cuDNN等NVidia库进行调用。

- 通过Tensorflow等间接进行支持。

- JIT方式即时编译调用方式支持。

- GPU支持的Docker中运行Spark。如果将Spark节点放入Docker容器中运行,则需要使用NVidia提供的特殊版本Docker,而且需要安装NVidai提供的cuDNN等软件支持库。由于这些库调用了系统驱动,而且是C++编写,因此Spark要能够进行系统库的调用。

- GPU支持的Kubernetes之上运行Spark。

- 在上面的基础上,支持GPU的Docker容器需要能够接受Kubernetes的管理和调度。

- 参考:https://my.oschina.net/u/2306127/blog/1808304

只有同时满足上面的条件,才能通过Kubernetes的集群管理对Docker中Spark进行GPU操作。

下面是已经做的一些研究。

- IBMSparkGPU 的方案可以将GPU用于RDD和DataFrame,支持通用计算,重点支持机器学习;

- deeplearning4j 是基于Java的,包含数值计算和神经网络,支持GPU;

- NUMBA 的方案通过PySpark即时编译产生GPU的调用代码,兼容性好;

- Tensorflow/Caffe/MXNet等与Spark整合主要是节点调度,GPU由深度学习引擎调度,RDD需要数据交换,主要用于存储中间超参数数据。如TensorFrame的实现-https://github.com/databricks/tensorframes

Reference

- https://github.com/databricks/spark-deep-learning,Deep Learning Pipelines for Apache Spark,直接支持Images的一些功能。

- http://www.spark.tc/simd-and-gpu/, Spark多种支持GPU方法。

- http://www.spark.tc/gpu-acceleration-on-apache-spark-2/,GPU扩展

- https://my.oschina.net/u/2306127/blog/1602295,同上。

- http://www.spark.tc/0-to-life-changing-app-new-apache-systemml-api-on-spark-shell/,systemML在Spark中使用。

- Continuum-Anaconda,NUMBA: A PYTHON JIT COMPILER,http://on-demand.gputechconf.com/gtc/2016/presentation/s6413-stanley-seibert-apache-spark-python.pdf

- http://spark.tc/why-you-should-be-using-apache-systemml-2/,关于SystemML。

- 基于Java的神经网络深度学习系列库(支持GPU,https://deeplearning4j.org/),https://github.com/deeplearning4j

- https://github.com/IBMSparkGPU,源码:https://github.com/IBMSparkGPU/GPUEnabler

- Spark Summit 2016 Talk by Jun Feng Liu (IBM) and Yonggang Hu (IBM)

- Hadoop, Spark, Deep Learning Mesh on Single GPU Cluster,https://www.nextplatform.com/2016/02/24/hadoop-spark-deep-learning-mesh-on-single-gpu-cluster/

- IBM,关于GPU RDD的讨论,http://on-demand.gputechconf.com/gtc/2016/presentation/s6280-rajesh-bordawekar-accelerating-spark.pdf

- GPU Computing with Apache Spark and Python,http://on-demand.gputechconf.com/gtc/2016/presentation/s6413-stanley-seibert-apache-spark-python.pdf

- Spark ML Runs 10x Faster on GPUs, Databricks Says。https://www.datanami.com/2016/10/27/spark-ml-runs-faster-gpus/

二、在笔记本上实现Spark-GPU集群开发教程

From: https://www.jdon.com/bigdata/spark-gpu.html

第1部分:Spark-Notebook

选择Scala:完整的Spark API;GPU库允许我无需编写编译C代码而直接使用Java (这样从scala调用Java)。

Zeppelin -> buggy API

Spark-Notebook -> 导入依赖很头疼

Sparknotebook -> 就选择这个了,杀手级应用

下面是从Sparknotebook 仓储Clone下载一份,按照其指引操作,比如下载IScala.jar等等。

第2部分:在JVM上GPU

灵感来自于一个令人印象深刻的库包 ScalaNLP 。 他们声称有一个解析器,可以在一台计算机上每分钟解析一百万字。

Aparapi 出现的原因。 它编译Java代码到OpenCL,如果不能获得一个GPU则使用Java线程池运行。

第3部分:整合Spark和笔记本中Aparapi

真正的挑战是让这些工具相互调用。 集成的第一步,我们需要做的就是aparapi jar导入iscala笔记本。

第4部分:在笔记本(仅使用Scala)构建案例

第5部分:在Spark 集群执行GPU内核

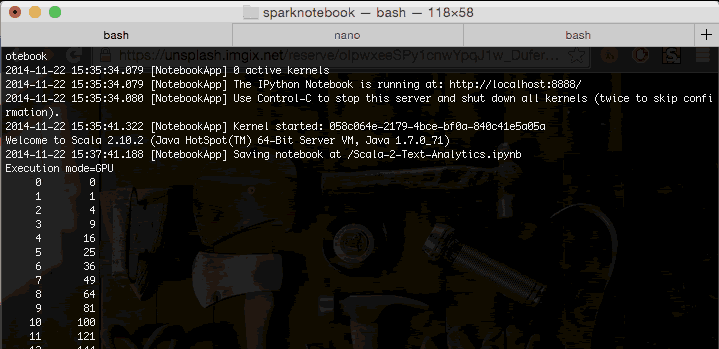

下面是Spark运行在笔记本上的内核上示意图:

程序日志记录出现GPU…显示它确实是被运行在GPU。

但问题在于深度学习必须使用cuda,还是cuda才是正道。

/* implement */

浙公网安备 33010602011771号

浙公网安备 33010602011771号