一、词频统计

A.分步骤实现

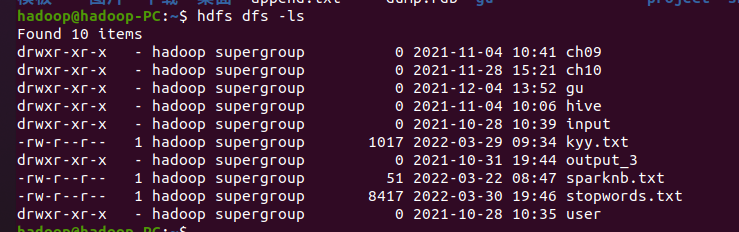

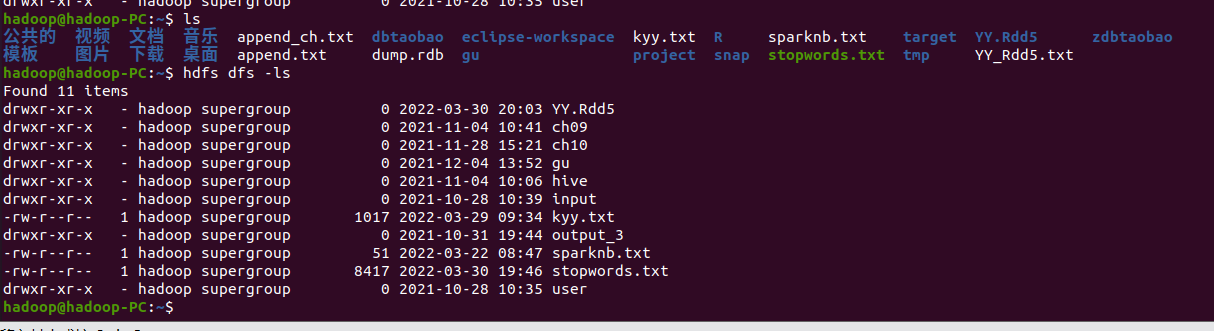

1.准备文件

1.下载小说或长篇新闻稿

2.上传到hdfs

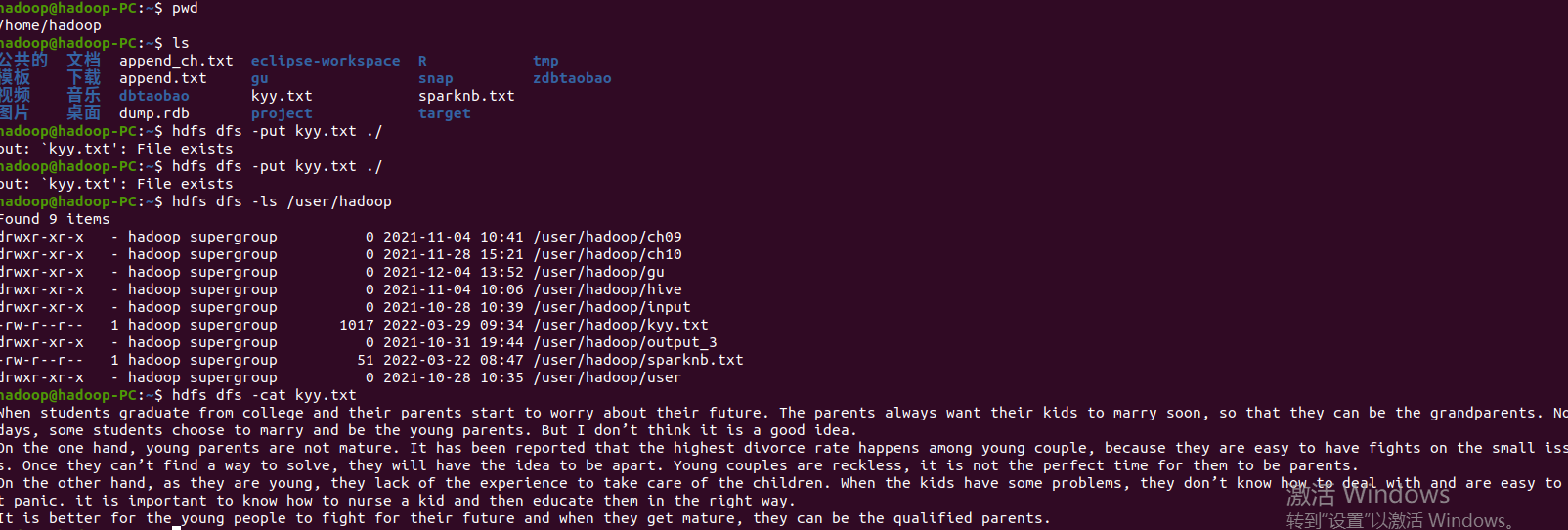

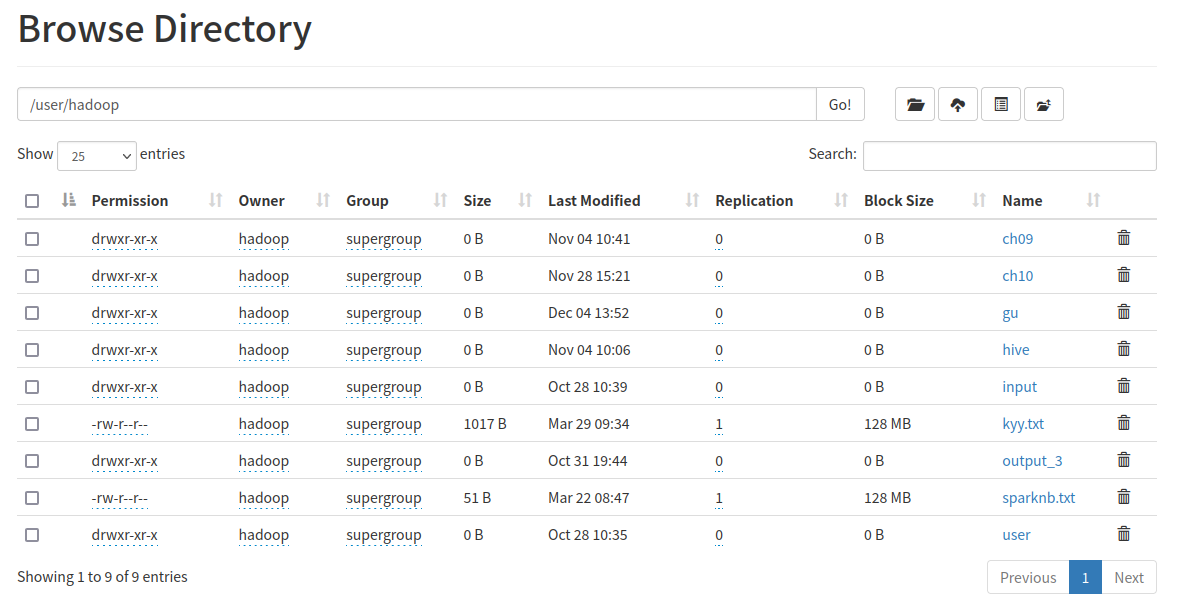

启动hdfs

上传文件并查看

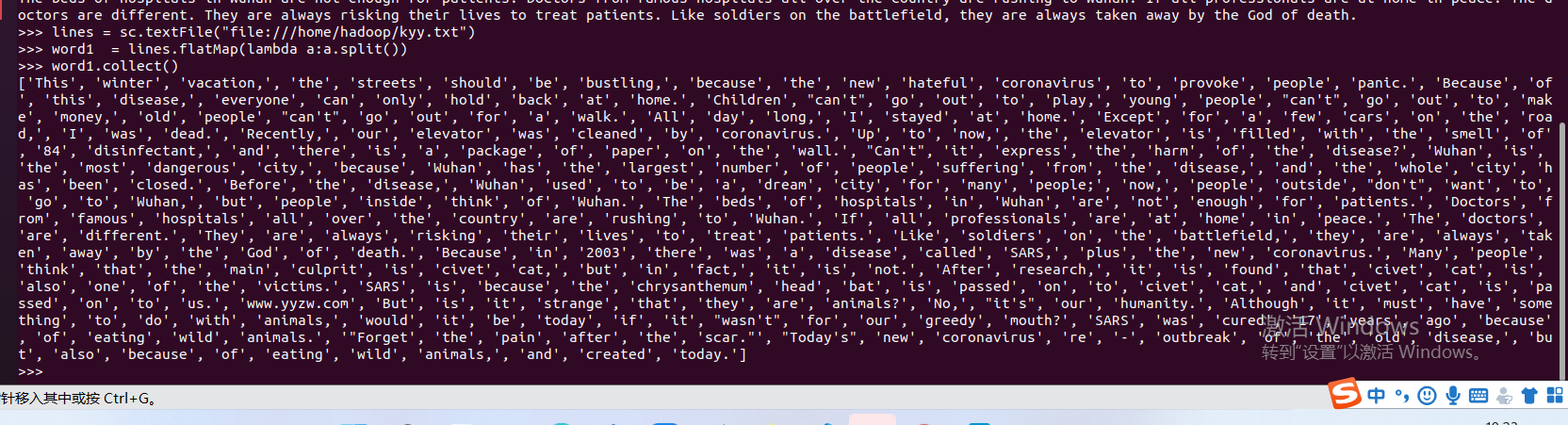

2.读文件创建RDD

创建SparkContext以及从文件系统中加载数据创建RDD

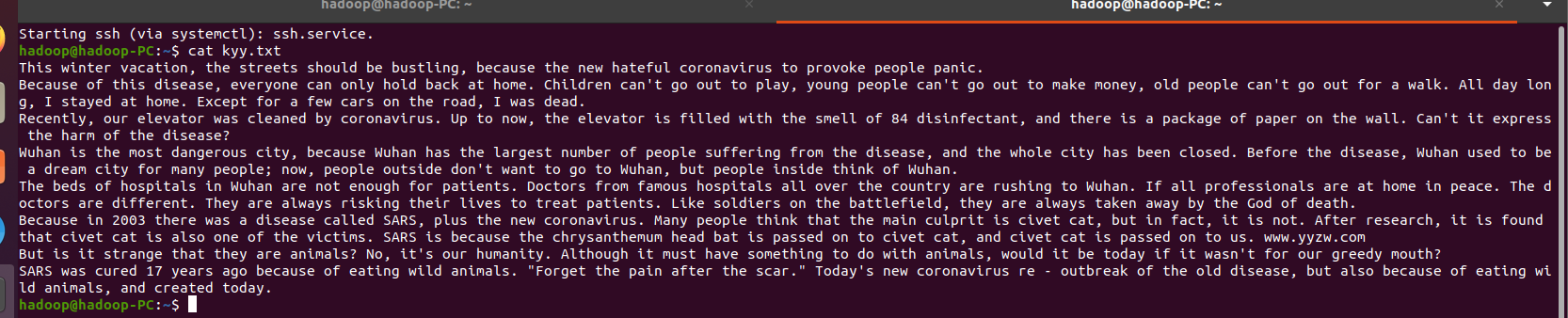

与原txt文件对比

3.分词

4.标点符号re.split(pattern,str),flatMap(),

先导入re

用re.split分词(\W+会匹配所有非单词字符,(\W+)会返回这些,但我们不需要返回,所以这里用\W+即可)

再分词一遍清除去标点后产生的新的无用数据

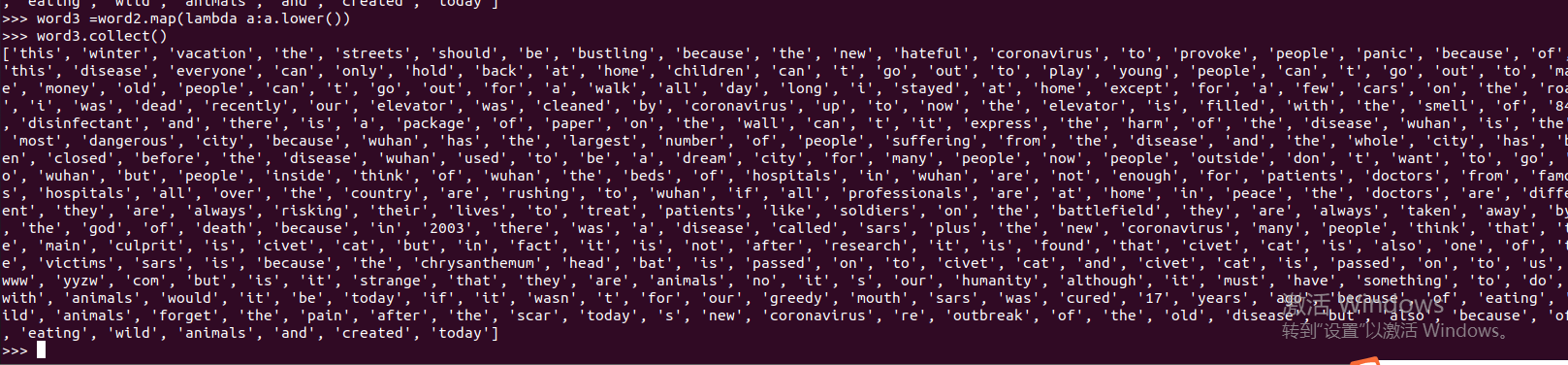

排除大小写lower(),map()

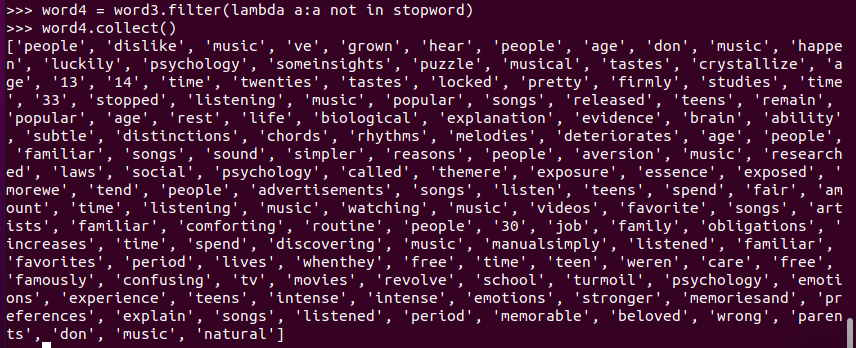

停用词,可网盘下载stopwords.txt,filter(),

将停用词文件分词储存到变量中

筛选出不在停用表中的词

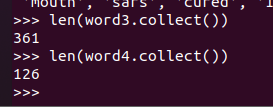

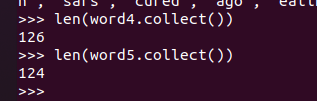

筛选前后对比

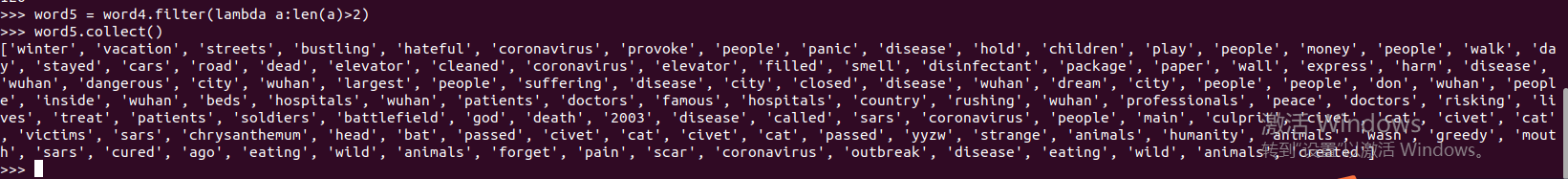

长度小于2的词filter()

筛选前后对比

5.统计词频

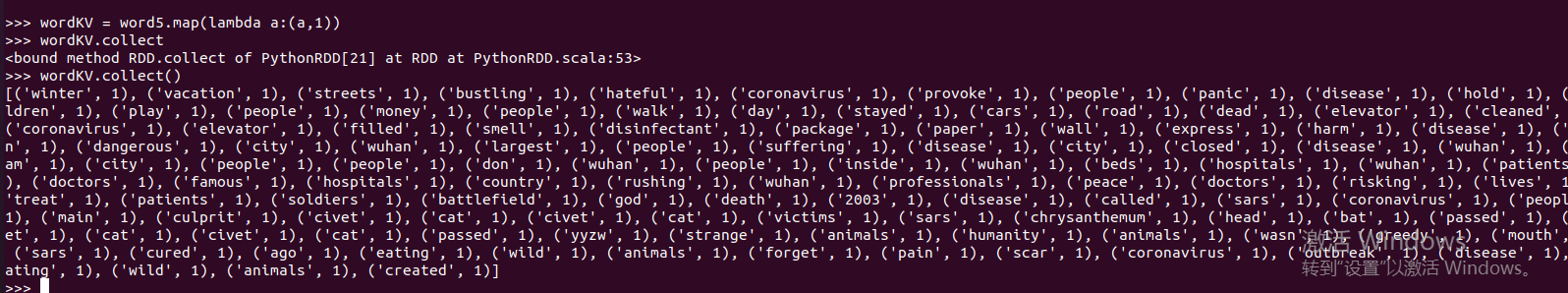

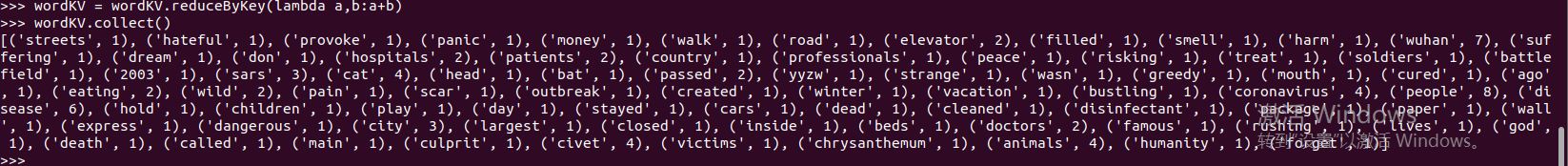

先把单词映射成键值对

将key相同的values合并起来,做词频的统计

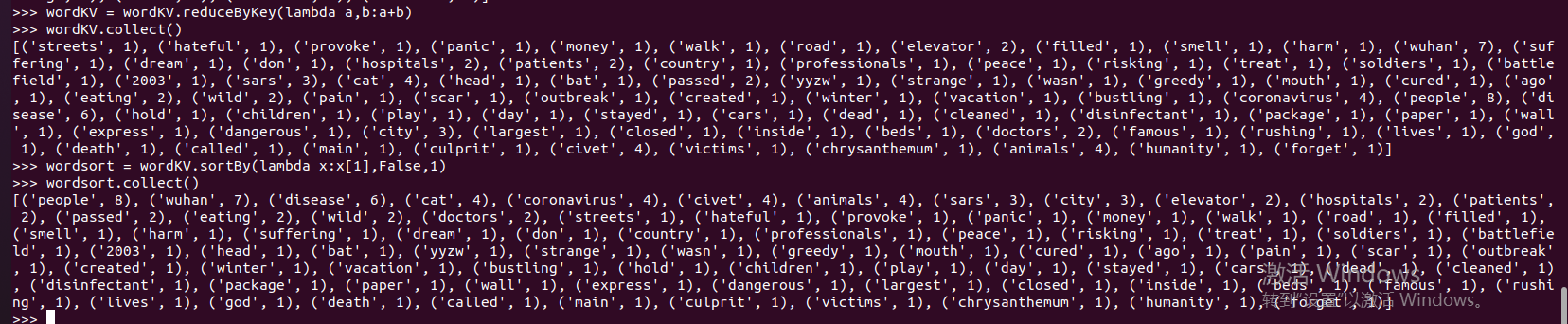

6.按词频排序

7.输出到文件

输出到本地文件上

输出到分布式文件上

8.查看结果

浙公网安备 33010602011771号

浙公网安备 33010602011771号