《后端开发》—常见面试题整理

JAVA

什么是面向对象

面向对象的特征(封装、继承、多态、抽象)

什么是字节码?采用字节码的好处?

equal与==的区别

equals() 方法用于比较对象的内容是否相等,而 == 运算符用于比较对象引用是否相同。通常情况下,我们会使用 equals() 方法来判断对象的相等性。

常见的设计模型

https://www.bilibili.com/video/BV1Np4y1z7BU?p=22&vd_source=2a2fe9b853da988c75fe77c1564ca13d

-

单例模式

-

工厂方法模式

-

代理模式

-

观察者模式

在问Spring的时候可能会问到这样一个问题:在Spring框架中都用到了哪些设计模式,并举例说明?

- 工厂设计模式 : Spring使用工厂模式通过

BeanFactory、ApplicationContext创建 bean 对象。 - 代理设计模式 : Spring AOP 功能的实现。

- 单例设计模式: Spring 中的 Bean 默认都是单例的。

- 包装器设计模式 : 我们的项目需要连接多个数据库,而且不同的客户在每次访问中根据需要会去访问不同的数据库。这种模式让我们可以根据客户的需求能够动态切换不同的数据源。

- 观察者模式: Spring 事件驱动模型就是观察者模式很经典的一个应用。

- 适配器模式:Spring AOP 的增强或通知(Advice)使用到了适配器模式、spring MVC 中也是用到了适配器模式适配

Controller。

怎么解决哈希冲突

Array和ArrayList有何区别?什么时候更适合用Array?

Array可以容纳基本类型和对象,而ArrayList只能容纳对象。

Array是指定大小的,而ArrayList大小可自动扩容。

Array可以通过索引访问元素,访问速度很快,是常数时间复杂度(O(1))。

尽管ArrayList明显是更好的选择,但也有些时候Array比较好用,比如下面的三种情况。

- 如果列表的大小已经指定,大部分情况下是存储和遍历它们

- 对于遍历基本数据类型,尽管Collections使用自动装箱来减轻编码任务,在指定大小的基本类型的列表上工作也会变得很慢。

- 如果你要使用多维数组,使用[][][] []List会方便。

- 如果需要频繁地进行插入、删除或者搜索元素,且不关心内存占用,使用 ArrayList 更加方便。

- 如果需要更高效地访问元素,并且元素数量是固定的,可以使用数组。数组的访问速度比 ArrayList 更快,因为数组中的元素是连续存储的,而 ArrayList 中的元素可能是分散存储的。

综上所述,Array 适用于固定大小的元素集合,需要高效访问元素的场景,而 ArrayList 适用于动态大小的元素集合,需要频繁进行插入、删除或搜索元素的场景。

ArrayList和LinkedList区别

- 底层数据结构:

- ArrayList 的底层实现是动态数组,它使用数组来存储元素。因此,ArrayList 对元素的随机访问速度很快,时间复杂度为 O(1)。

- LinkedList 的底层实现是双向链表,每个节点都包含对前一个节点和后一个节点的引用。因此,LinkedList 在插入和删除操作上比较快,时间复杂度为 O(1),但是在随机访问时效率较低,时间复杂度为 O(n)。

- 内存占用:

- ArrayList 在内存中是连续存储的,因此它的内存占用相对较小。

- LinkedList 中的每个节点都需要额外的空间来存储对前一个节点和后一个节点的引用,因此它的内存占用相对较大。

- 性能特征:

- ArrayList 适用于需要频繁访问列表元素的场景,因为它支持高效的随机访问。

- LinkedList 适用于需要频繁进行插入、删除操作的场景,因为它对插入和删除操作有较好的性能。

- 特定操作的性能:

- 在 ArrayList 中,插入和删除操作涉及到元素的移动,所以在列表的中间或开头进行插入和删除操作会比较慢。

- 在 LinkedList 中,由于插入和删除只涉及到节点的指针修改,所以在列表的中间或开头进行插入和删除操作比较快。

- 迭代器性能:

- 在 ArrayList 中,使用迭代器(Iterator)进行迭代时效率较高。

- 在 LinkedList 中,由于每次迭代都需要遍历节点,所以迭代器的性能比 ArrayList 差。

综上所述,如果需要频繁访问列表元素或者列表的大小是固定的,可以使用 ArrayList。如果需要频繁进行插入、删除操作,或者列表的大小不确定,可以考虑使用 LinkedList。

ArrayList扩容

HashMap

HashMap和Hashtable的区别

HashMap 和 HashTable 都是 Java 中用于存储键值对的数据结构,但它们有一些重要的区别。以下是 HashMap 和 HashTable 的主要区别:

线程安全性:

- HashMap 是非线程安全的。多个线程可以同时访问和修改 HashMap,如果没有适当的同步措施,可能会导致数据不一致或竞争条件。如果多个线程同时访问一个

HashMap对象,并且至少有一个线程从结构上修改了映射,则它必须保持外部同步。 - HashTable 是线程安全的。多个线程可以共享同一个

Hashtable对象,而不会造成数据的不一致性。它的方法都被同步(synchronized)了,可以在多线程环境中使用,但这可能会降低性能。

允许空键和空值:

- HashMap 允许使用空(null)键和空(null)值。这意味着可以将 null 作为键或值存储在 HashMap 中。

- HashTable 不允许使用空(null)键或空(null)值。如果尝试存储空(null)键或空(null)值,会抛出 NullPointerException。

继承关系:

HashMap 继承自 AbstractMap 类,而 HashTable 继承自 Dictionary 类(已过时)。

效率和性能:

- 由于 HashMap 不进行同步,适用于单线程环境,因此在性能上通常比 HashTable 更高效。

- HashTable 的同步操作可能导致性能下降,特别是在高并发环境下。

迭代器和枚举:

- HashMap 的迭代器是快速失败的(fail-fast iterator),可以检测到在迭代过程中其他线程对 HashMap 的修改。

- HashTable 的枚举(Enumeration)不是快速失败的,不能检测到其他线程的修改。

泛型支持:

- HashMap 支持泛型,可以指定键和值的类型。

- HashTable 不支持泛型,只能存储 Object 类型。

总的来说,如果在多线程环境下需要使用键值对存储,可以考虑使用 ConcurrentHashMap 来替代 HashTable,因为 ConcurrentHashMap 提供了更好的并发性能。在单线程环境下,通常首选使用 HashMap,因为它的性能更好。

HashMap和HashSet的区别

主要用途

- HashMap 是一个实现了

Map接口的集合,用于存储键值对(key-value pairs)。每个键映射到一个具体的值,键必须唯一。 - HashSet 是一个实现了

Set接口的集合,用于存储不重复的元素集合。它基本上使用HashMap实现,每个元素都作为键存储在底层的HashMap实例中,而值使用一个固定的对象标记(通常是PRESENT这个静态的Object对象)。

TreeSet和HashSet的区别

数据结构

- HashSet 基于哈希表实现,具体来说是通过一个

HashMap来实现的。它通过使用元素的哈希码来快速定位元素是否存在于集合中,从而优化了查找、添加和删除操作的速度。 - TreeSet 基于红黑树(一种自平衡的二叉查找树)实现,所有的元素都按照某种比较规则(自然排序或者根据

Comparator提供的排序规则)被排序存储。

性能

- HashSet 在添加、删除和查找元素时,提供了较为稳定的性能,理论上这些操作的时间复杂度是O(1),但实际性能取决于哈希函数的质量和集合的大小。

- TreeSet 添加、删除和查找操作的时间复杂度为O(log n),因为这些操作需要通过树结构进行。

用途

- HashSet 通常在不需要元素排序时使用,当你需要快速查找元素是否存在于集合中时,它是一个好选择。

- TreeSet 适用于需要有序集合的场景,例如,当你需要一个排序的唯一元素集合,或者需要频繁地进行有序操作(如查找范围内的元素)时。

虚拟机篇

1. JVM 内存结构

要求

- 掌握 JVM 内存结构划分

- 尤其要知道方法区、永久代、元空间的关系

结合一段 java 代码的执行理解内存划分

- 执行 javac 命令编译源代码为字节码

- 执行 java 命令

- 创建 JVM,调用类加载子系统加载 class,将类的信息存入方法区

- 创建 main 线程,使用的内存区域是 JVM 虚拟机栈,开始执行 main 方法代码

- 如果遇到了未见过的类,会继续触发类加载过程,同样会存入方法区

- 需要创建对象,会使用堆内存来存储对象

- 不再使用的对象,会由垃圾回收器在内存不足时回收其内存

- 调用方法时,方法内的局部变量、方法参数所使用的是 JVM 虚拟机栈中的栈帧内存

- 调用方法时,先要到方法区获得到该方法的字节码指令,由解释器将字节码指令解释为机器码执行

- 调用方法时,会将要执行的指令行号读到程序计数器,这样当发生了线程切换,恢复时就可以从中断的位置继续

- 对于非 java 实现的方法调用,使用内存称为本地方法栈(见说明)

- 对于热点方法调用,或者频繁的循环代码,由 JIT 即时编译器将这些代码编译成机器码缓存,提高执行性能

说明

- 加粗字体代表了 JVM 虚拟机组件

- 对于 Oracle 的 Hotspot 虚拟机实现,不区分虚拟机栈和本地方法栈

会发生内存溢出的区域

- 不会出现内存溢出的区域 – 程序计数器

- 出现 OutOfMemoryError 的情况

- 堆内存耗尽 – 对象越来越多,又一直在使用,不能被垃圾回收

- 方法区内存耗尽 – 加载的类越来越多,很多框架都会在运行期间动态产生新的类

- 虚拟机栈累积 – 每个线程最多会占用 1 M 内存,线程个数越来越多,而又长时间运行不销毁时

- 出现 StackOverflowError 的区域

- JVM 虚拟机栈,原因有方法递归调用未正确结束、反序列化 json 时循环引用

方法区、永久代、元空间

- 方法区是 JVM 规范中定义的一块内存区域,用来存储类元数据、方法字节码、即时编译器需要的信息等

- 永久代是 Hotspot 虚拟机对 JVM 规范的实现(1.8 之前)

- 元空间是 Hotspot 虚拟机对 JVM 规范的另一种实现(1.8 以后),使用本地内存作为这些信息的存储空间

从这张图学到三点

- 当第一次用到某个类是,由类加载器将 class 文件的类元信息读入,并存储于元空间

- X,Y 的类元信息是存储于元空间中,无法直接访问

- 可以用 X.class,Y.class 间接访问类元信息,它们俩属于 java 对象,我们的代码中可以使用

从这张图可以学到

- 堆内存中:当一个类加载器对象,这个类加载器对象加载的所有类对象,这些类对象对应的所有实例对象都没人引用时,GC 时就会对它们占用的对内存进行释放

- 元空间中:内存释放以类加载器为单位,当堆中类加载器内存释放时,对应的元空间中的类元信息也会释放

2. JVM 内存参数

要求

- 熟悉常见的 JVM 参数,尤其和大小相关的

堆内存,按大小设置

解释:

- -Xms 最小堆内存(包括新生代和老年代)

- -Xmx 最大对内存(包括新生代和老年代)

- 通常建议将 -Xms 与 -Xmx 设置为大小相等,即不需要保留内存,不需要从小到大增长,这样性能较好

- -XX:NewSize 与 -XX:MaxNewSize 设置新生代的最小与最大值,但一般不建议设置,由 JVM 自己控制

- -Xmn 设置新生代大小,相当于同时设置了 -XX:NewSize 与 -XX:MaxNewSize 并且取值相等

- 保留是指,一开始不会占用那么多内存,随着使用内存越来越多,会逐步使用这部分保留内存。下同

堆内存,按比例设置

解释:

- -XX:NewRatio=2:1 表示老年代占两份,新生代占一份

- -XX:SurvivorRatio=4:1 表示新生代分成六份,伊甸园占四份,from 和 to 各占一份

元空间内存设置

解释:

- class space 存储类的基本信息,最大值受 -XX:CompressedClassSpaceSize 控制

- non-class space 存储除类的基本信息以外的其它信息(如方法字节码、注解等)

- class space 和 non-class space 总大小受 -XX:MaxMetaspaceSize 控制

注意:

- 这里 -XX:CompressedClassSpaceSize 这段空间还与是否开启了指针压缩有关,这里暂不深入展开,可以简单认为指针压缩默认开启

代码缓存内存设置

解释:

- 如果 -XX:ReservedCodeCacheSize < 240m,所有优化机器代码不加区分存在一起

- 否则,分成三个区域(图中笔误 mthod 拼写错误,少一个 e)

- non-nmethods - JVM 自己用的代码

- profiled nmethods - 部分优化的机器码

- non-profiled nmethods - 完全优化的机器码

线程内存设置

官方参考文档

3. JVM 垃圾回收

要求

- 掌握垃圾回收算法

- 掌握分代回收思想

- 理解三色标记及漏标处理

- 了解常见垃圾回收器

三种垃圾回收算法

标记清除法

解释:

- 找到 GC Root 对象,即那些一定不会被回收的对象,如正执行方法内局部变量引用的对象、静态变量引用的对象

- 标记阶段:沿着 GC Root 对象的引用链找,直接或间接引用到的对象加上标记

- 清除阶段:释放未加标记的对象占用的内存

要点:

- 标记速度与存活对象线性关系

- 清除速度与内存大小线性关系

- 缺点是会产生内存碎片

标记整理法

解释:

- 前面的标记阶段、清理阶段与标记清除法类似

- 多了一步整理的动作,将存活对象向一端移动,可以避免内存碎片产生

特点:

-

标记速度与存活对象线性关系

-

清除与整理速度与内存大小成线性关系

-

缺点是性能上较慢

标记复制法

解释:

- 将整个内存分成两个大小相等的区域,from 和 to,其中 to 总是处于空闲,from 存储新创建的对象

- 标记阶段与前面的算法类似

- 在找出存活对象后,会将它们从 from 复制到 to 区域,复制的过程中自然完成了碎片整理

- 复制完成后,交换 from 和 to 的位置即可

特点:

- 标记与复制速度与存活对象成线性关系

- 缺点是会占用成倍的空间

GC 与分代回收算法

GC 的目的在于实现无用对象内存自动释放,减少内存碎片、加快分配速度

GC 要点:

- 回收区域是堆内存,不包括虚拟机栈

- 判断无用对象,使用可达性分析算法,三色标记法标记存活对象,回收未标记对象

- GC 具体的实现称为垃圾回收器

- GC 大都采用了分代回收思想

- 理论依据是大部分对象朝生夕灭,用完立刻就可以回收,另有少部分对象会长时间存活,每次很难回收

- 根据这两类对象的特性将回收区域分为新生代和老年代,新生代采用标记复制法、老年代一般采用标记整理法

- 根据 GC 的规模可以分成 Minor GC,Mixed GC,Full GC

分代回收

- 伊甸园 eden,最初对象都分配到这里,与幸存区 survivor(分成 from 和 to)合称新生代,

-

当伊甸园内存不足,标记伊甸园与 from(现阶段没有)的存活对象

-

将存活对象采用复制算法复制到 to 中,复制完毕后,伊甸园和 from 内存都得到释放

- 将 from 和 to 交换位置

- 经过一段时间后伊甸园的内存又出现不足

- 标记伊甸园与 from(现阶段没有)的存活对象

- 将存活对象采用复制算法复制到 to 中

- 复制完毕后,伊甸园和 from 内存都得到释放

- 将 from 和 to 交换位置

- 老年代 old,当幸存区对象熬过几次回收(最多15次),晋升到老年代(幸存区内存不足或大对象会导致提前晋升)

GC 规模

-

Minor GC 发生在新生代的垃圾回收,暂停时间短

-

Mixed GC 新生代 + 老年代部分区域的垃圾回收,G1 收集器特有

-

Full GC 新生代 + 老年代完整垃圾回收,暂停时间长,应尽力避免

三色标记

即用三种颜色记录对象的标记状态

- 黑色 – 已标记

- 灰色 – 标记中

- 白色 – 还未标记

- 起始的三个对象还未处理完成,用灰色表示

- 该对象的引用已经处理完成,用黑色表示,黑色引用的对象变为灰色

- 依次类推

- 沿着引用链都标记了一遍

- 最后为标记的白色对象,即为垃圾

并发漏标问题

比较先进的垃圾回收器都支持并发标记,即在标记过程中,用户线程仍然能工作。但这样带来一个新的问题,如果用户线程修改了对象引用,那么就存在漏标问题。例如:

- 如图所示标记工作尚未完成

- 用户线程同时在工作,断开了第一层 3、4 两个对象之间的引用,这时对于正在处理 3 号对象的垃圾回收线程来讲,它会将 4 号对象当做是白色垃圾

- 但如果其他用户线程又建立了 2、4 两个对象的引用,这时因为 2 号对象是黑色已处理对象了,因此垃圾回收线程不会察觉到这个引用关系的变化,从而产生了漏标

- 如果用户线程让黑色对象引用了一个新增对象,一样会存在漏标问题

因此对于并发标记而言,必须解决漏标问题,也就是要记录标记过程中的变化。有两种解决方法:

- Incremental Update 增量更新法,CMS 垃圾回收器采用

- 思路是拦截每次赋值动作,只要赋值发生,被赋值的对象就会被记录下来,在重新标记阶段再确认一遍

- Snapshot At The Beginning,SATB 原始快照法,G1 垃圾回收器采用

- 思路也是拦截每次赋值动作,不过记录的对象不同,也需要在重新标记阶段对这些对象二次处理

- 新加对象会被记录

- 被删除引用关系的对象也被记录

垃圾回收器 - Parallel GC

-

eden 内存不足发生 Minor GC,采用标记复制算法,需要暂停用户线程

-

old 内存不足发生 Full GC,采用标记整理算法,需要暂停用户线程

-

注重吞吐量

垃圾回收器 - ConcurrentMarkSweep GC

-

它是工作在 old 老年代,支持并发标记的一款回收器,采用并发清除算法

- 并发标记时不需暂停用户线程

- 重新标记时仍需暂停用户线程

-

如果并发失败(即回收速度赶不上创建新对象速度),会触发 Full GC

-

注重响应时间

垃圾回收器 - G1 GC

- 响应时间与吞吐量兼顾

- 划分成多个区域,每个区域都可以充当 eden,survivor,old, humongous,其中 humongous 专为大对象准备

- 分成三个阶段:新生代回收、并发标记、混合收集

- 如果并发失败(即回收速度赶不上创建新对象速度),会触发 Full GC

G1 回收阶段 - 新生代回收

- 初始时,所有区域都处于空闲状态

- 创建了一些对象,挑出一些空闲区域作为伊甸园区存储这些对象

- 当伊甸园需要垃圾回收时,挑出一个空闲区域作为幸存区,用复制算法复制存活对象,需要暂停用户线程

- 复制完成,将之前的伊甸园内存释放

- 随着时间流逝,伊甸园的内存又有不足

- 将伊甸园以及之前幸存区中的存活对象,采用复制算法,复制到新的幸存区,其中较老对象晋升至老年代

- 释放伊甸园以及之前幸存区的内存

G1 回收阶段 - 并发标记与混合收集

- 当老年代占用内存超过阈值后,触发并发标记,这时无需暂停用户线程

- 并发标记之后,会有重新标记阶段解决漏标问题,此时需要暂停用户线程。这些都完成后就知道了老年代有哪些存活对象,随后进入混合收集阶段。此时不会对所有老年代区域进行回收,而是根据暂停时间目标优先回收价值高(存活对象少)的区域(这也是 Gabage First 名称的由来)。

- 混合收集阶段中,参与复制的有 eden、survivor、old,下图显示了伊甸园和幸存区的存活对象复制

- 下图显示了老年代和幸存区晋升的存活对象的复制

- 复制完成,内存得到释放。进入下一轮的新生代回收、并发标记、混合收集

4. 内存溢出

要求

- 能够说出几种典型的导致内存溢出的情况

典型情况

- 误用线程池导致的内存溢出

- 参考 day03.TestOomThreadPool

- 查询数据量太大导致的内存溢出

- 参考 day03.TestOomTooManyObject

- 动态生成类导致的内存溢出

- 参考 day03.TestOomTooManyClass

5. 类加载

要求

- 掌握类加载阶段

- 掌握类加载器

- 理解双亲委派机制

类加载过程的三个阶段

-

加载

-

将类的字节码载入方法区,并创建类.class 对象

-

如果此类的父类没有加载,先加载父类

-

加载是懒惰执行

-

-

链接

- 验证 – 验证类是否符合 Class 规范,合法性、安全性检查

- 准备 – 为 static 变量分配空间,设置默认值

- 解析 – 将常量池的符号引用解析为直接引用

-

初始化

- 静态代码块、static 修饰的变量赋值、static final 修饰的引用类型变量赋值,会被合并成一个

<cinit>方法,在初始化时被调用 - static final 修饰的基本类型变量赋值,在链接阶段就已完成

- 初始化是懒惰执行

- 静态代码块、static 修饰的变量赋值、static final 修饰的引用类型变量赋值,会被合并成一个

验证手段

- 使用 jps 查看进程号

- 使用 jhsdb 调试,执行命令

jhsdb.exe hsdb打开它的图形界面

- Class Browser 可以查看当前 jvm 中加载了哪些类

- 控制台的 universe 命令查看堆内存范围

- 控制台的 g1regiondetails 命令查看 region 详情

scanoops 起始地址 结束地址 对象类型可以根据类型查找某个区间内的对象地址- 控制台的

inspect 地址指令能够查看这个地址对应的对象详情- 使用 javap 命令可以查看 class 字节码

代码说明

- day03.loader.TestLazy - 验证类的加载是懒惰的,用到时才触发类加载

- day03.loader.TestFinal - 验证使用 final 修饰的变量不会触发类加载

jdk 8 的类加载器

| 名称 | 加载哪的类 | 说明 |

|---|---|---|

| Bootstrap ClassLoader | JAVA_HOME/jre/lib | 无法直接访问 |

| Extension ClassLoader | JAVA_HOME/jre/lib/ext | 上级为 Bootstrap,显示为 null |

| Application ClassLoader | classpath | 上级为 Extension |

| 自定义类加载器 | 自定义 | 上级为 Application |

双亲委派机制

所谓的双亲委派,就是指优先委派上级类加载器进行加载,如果上级类加载器

- 能找到这个类,由上级加载,加载后该类也对下级加载器可见

- 找不到这个类,则下级类加载器才有资格执行加载

双亲委派的目的有两点

-

让上级类加载器中的类对下级共享(反之不行),即能让你的类能依赖到 jdk 提供的核心类

-

让类的加载有优先次序,保证核心类优先加载

对双亲委派的误解

下面面试题的回答是错误的

错在哪了?

-

自己编写类加载器就能加载一个假冒的 java.lang.System 吗? 答案是不行。

-

假设你自己的类加载器用双亲委派,那么优先由启动类加载器加载真正的 java.lang.System,自然不会加载假冒的

-

假设你自己的类加载器不用双亲委派,那么你的类加载器加载假冒的 java.lang.System 时,它需要先加载父类 java.lang.Object,而你没有用委派,找不到 java.lang.Object 所以加载会失败

-

以上也仅仅是假设。事实上操作你就会发现,自定义类加载器加载以 java. 打头的类时,会抛安全异常,在 jdk9 以上版本这些特殊包名都与模块进行了绑定,更连编译都过不了

代码说明

- day03.loader.TestJdk9ClassLoader - 演示类加载器与模块的绑定关系

6. 四种引用

要求

- 掌握四种引用

强引用

-

普通变量赋值即为强引用,如 A a = new A();

-

通过 GC Root 的引用链,如果强引用不到该对象,该对象才能被回收

软引用(SoftReference)

-

例如:SoftReference a = new SoftReference(new A());

-

如果仅有软引用该对象时,首次垃圾回收不会回收该对象,如果内存仍不足,再次回收时才会释放对象

-

软引用自身需要配合引用队列来释放

-

典型例子是反射数据

弱引用(WeakReference)

-

例如:WeakReference a = new WeakReference(new A());

-

如果仅有弱引用引用该对象时,只要发生垃圾回收,就会释放该对象

-

弱引用自身需要配合引用队列来释放

-

典型例子是 ThreadLocalMap 中的 Entry 对象

虚引用(PhantomReference)

-

例如: PhantomReference a = new PhantomReference(new A(), referenceQueue);

-

必须配合引用队列一起使用,当虚引用所引用的对象被回收时,由 Reference Handler 线程将虚引用对象入队,这样就可以知道哪些对象被回收,从而对它们关联的资源做进一步处理

-

典型例子是 Cleaner 释放 DirectByteBuffer 关联的直接内存

代码说明

- day03.reference.TestPhantomReference - 演示虚引用的基本用法

- day03.reference.TestWeakReference - 模拟 ThreadLocalMap, 采用引用队列释放 entry 内存

7. finalize

要求

- 掌握 finalize 的工作原理与缺点

finalize

- 它是 Object 中的一个方法,如果子类重写它,垃圾回收时此方法会被调用,可以在其中进行资源释放和清理工作

- 将资源释放和清理放在 finalize 方法中非常不好,非常影响性能,严重时甚至会引起 OOM,从 Java9 开始就被标注为 @Deprecated,不建议被使用了

finalize 原理

- 对 finalize 方法进行处理的核心逻辑位于 java.lang.ref.Finalizer 类中,它包含了名为 unfinalized 的静态变量(双向链表结构),Finalizer 也可被视为另一种引用对象(地位与软、弱、虚相当,只是不对外,无法直接使用)

- 当重写了 finalize 方法的对象,在构造方法调用之时,JVM 都会将其包装成一个 Finalizer 对象,并加入 unfinalized 链表中

- Finalizer 类中还有另一个重要的静态变量,即 ReferenceQueue 引用队列,刚开始它是空的。当狗对象可以被当作垃圾回收时,就会把这些狗对象对应的 Finalizer 对象加入此引用队列

- 但此时 Dog 对象还没法被立刻回收,因为 unfinalized -> Finalizer 这一引用链还在引用它嘛,为的是【先别着急回收啊,等我调完 finalize 方法,再回收】

- FinalizerThread 线程会从 ReferenceQueue 中逐一取出每个 Finalizer 对象,把它们从链表断开并真正调用 finallize 方法

- 由于整个 Finalizer 对象已经从 unfinalized 链表中断开,这样没谁能引用到它和狗对象,所以下次 gc 时就被回收了

finalize 缺点

- 无法保证资源释放:FinalizerThread 是守护线程,代码很有可能没来得及执行完,线程就结束了

- 无法判断是否发生错误:执行 finalize 方法时,会吞掉任意异常(Throwable)

- 内存释放不及时:重写了 finalize 方法的对象在第一次被 gc 时,并不能及时释放它占用的内存,因为要等着 FinalizerThread 调用完 finalize,把它从 unfinalized 队列移除后,第二次 gc 时才能真正释放内存

- 有的文章提到【Finalizer 线程会和我们的主线程进行竞争,不过由于它的优先级较低,获取到的CPU时间较少,因此它永远也赶不上主线程的步伐】这个显然是错误的,FinalizerThread 的优先级较普通线程更高,原因应该是 finalize 串行执行慢等原因综合导致

代码说明

- day03.reference.TestFinalize - finalize 的测试代码

并发篇

1. 线程状态

要求

- 掌握 Java 线程六种状态

- 掌握 Java 线程状态转换

- 能理解五种状态与六种状态两种说法的区别

六种状态及转换

分别是

- 新建

- 当一个线程对象被创建,但还未调用 start 方法时处于新建状态

- 此时未与操作系统底层线程关联

- 可运行

- 调用了 start 方法,就会由新建进入可运行

- 此时与底层线程关联,由操作系统调度执行

- 终结

- 线程内代码已经执行完毕,由可运行进入终结

- 此时会取消与底层线程关联

- 阻塞

- 当获取锁失败后,由可运行进入 Monitor 的阻塞队列阻塞,此时不占用 cpu 时间

- 当持锁线程释放锁时,会按照一定规则唤醒阻塞队列中的阻塞线程,唤醒后的线程进入可运行状态

- 等待

- 当获取锁成功后,但由于条件不满足,调用了 wait() 方法,此时从可运行状态释放锁进入 Monitor 等待集合等待,同样不占用 cpu 时间

- 当其它持锁线程调用 notify() 或 notifyAll() 方法,会按照一定规则唤醒等待集合中的等待线程,恢复为可运行状态

- 有时限等待

- 当获取锁成功后,但由于条件不满足,调用了 wait(long) 方法,此时从可运行状态释放锁进入 Monitor 等待集合进行有时限等待,同样不占用 cpu 时间

- 当其它持锁线程调用 notify() 或 notifyAll() 方法,会按照一定规则唤醒等待集合中的有时限等待线程,恢复为可运行状态,并重新去竞争锁

- 如果等待超时,也会从有时限等待状态恢复为可运行状态,并重新去竞争锁

- 还有一种情况是调用 sleep(long) 方法也会从可运行状态进入有时限等待状态,但与 Monitor 无关,不需要主动唤醒,超时时间到自然恢复为可运行状态

其它情况(只需了解)

- 可以用 interrupt() 方法打断等待、有时限等待的线程,让它们恢复为可运行状态

- park,unpark 等方法也可以让线程等待和唤醒

五种状态

五种状态的说法来自于操作系统层面的划分

- 运行态:分到 cpu 时间,能真正执行线程内代码的

- 就绪态:有资格分到 cpu 时间,但还未轮到它的

- 阻塞态:没资格分到 cpu 时间的

- 涵盖了 java 状态中提到的阻塞、等待、有时限等待

- 多出了阻塞 I/O,指线程在调用阻塞 I/O 时,实际活由 I/O 设备完成,此时线程无事可做,只能干等

- 新建与终结态:与 java 中同名状态类似,不再啰嗦

2. 线程池

要求

- 掌握线程池的 7 大核心参数

七大参数

- corePoolSize 核心线程数目 - 池中会保留的最多线程数

- maximumPoolSize 最大线程数目 - 核心线程+救急线程的最大数目

- keepAliveTime 生存时间 - 救急线程的生存时间,生存时间内没有新任务,此线程资源会释放

- unit 时间单位 - 救急线程的生存时间单位,如秒、毫秒等

- workQueue - 当没有空闲核心线程时,新来任务会加入到此队列排队,队列满会创建救急线程执行任务

- threadFactory 线程工厂 - 可以定制线程对象的创建,例如设置线程名字、是否是守护线程等

- handler 拒绝策略 - 当所有线程都在繁忙,workQueue 也放满时,会触发拒绝策略

- 抛异常 java.util.concurrent.ThreadPoolExecutor.AbortPolicy

- 由调用者执行任务 java.util.concurrent.ThreadPoolExecutor.CallerRunsPolicy

- 丢弃任务 java.util.concurrent.ThreadPoolExecutor.DiscardPolicy

- 丢弃最早排队任务 java.util.concurrent.ThreadPoolExecutor.DiscardOldestPolicy

代码说明

day02.TestThreadPoolExecutor 以较为形象的方式演示了线程池的核心组成

3. wait vs sleep

要求

- 能够说出二者区别

一个共同点,三个不同点

共同点

- wait() ,wait(long) 和 sleep(long) 的效果都是让当前线程暂时放弃 CPU 的使用权,进入阻塞状态

不同点

-

方法归属不同

- sleep(long) 是 Thread 的静态方法

- 而 wait(),wait(long) 都是 Object 的成员方法,每个对象都有

-

醒来时机不同

- 执行 sleep(long) 和 wait(long) 的线程都会在等待相应毫秒后醒来

- wait(long) 和 wait() 还可以被 notify 唤醒,wait() 如果不唤醒就一直等下去

- 它们都可以被打断唤醒

-

锁特性不同(重点)

- wait 方法的调用必须先获取 wait 对象的锁,而 sleep 则无此限制

- wait 方法执行后会释放对象锁,允许其它线程获得该对象锁(我放弃 cpu,但你们还可以用)

- 而 sleep 如果在 synchronized 代码块中执行,并不会释放对象锁(我放弃 cpu,你们也用不了)

4. lock vs synchronized

要求

- 掌握 lock 与 synchronized 的区别

- 理解 ReentrantLock 的公平、非公平锁

- 理解 ReentrantLock 中的条件变量

三个层面

不同点

- 语法层面

- synchronized 是关键字,源码在 jvm 中,用 c++ 语言实现

- Lock 是接口,源码由 jdk 提供,用 java 语言实现

- 使用 synchronized 时,退出同步代码块锁会自动释放,而使用 Lock 时,需要手动调用 unlock 方法释放锁

- 功能层面

- 二者均属于悲观锁、都具备基本的互斥、同步、锁重入功能

- Lock 提供了许多 synchronized 不具备的功能,例如获取等待状态、公平锁、可打断、可超时、多条件变量

- Lock 有适合不同场景的实现,如 ReentrantLock, ReentrantReadWriteLock

- 性能层面

- 在没有竞争时,synchronized 做了很多优化,如偏向锁、轻量级锁,性能不赖

- 在竞争激烈时,Lock 的实现通常会提供更好的性能

公平锁

- 公平锁的公平体现

- 已经处在阻塞队列中的线程(不考虑超时)始终都是公平的,先进先出

- 公平锁是指未处于阻塞队列中的线程来争抢锁,如果队列不为空,则老实到队尾等待

- 非公平锁是指未处于阻塞队列中的线程来争抢锁,与队列头唤醒的线程去竞争,谁抢到算谁的

- 公平锁会降低吞吐量,一般不用

条件变量

- ReentrantLock 中的条件变量功能类似于普通 synchronized 的 wait,notify,用在当线程获得锁后,发现条件不满足时,临时等待的链表结构

- 与 synchronized 的等待集合不同之处在于,ReentrantLock 中的条件变量可以有多个,可以实现更精细的等待、唤醒控制

代码说明

- day02.TestReentrantLock 用较为形象的方式演示 ReentrantLock 的内部结构

5. volatile

要求

- 掌握线程安全要考虑的三个问题

- 掌握 volatile 能解决哪些问题

原子性

- 起因:多线程下,不同线程的指令发生了交错导致的共享变量的读写混乱

- 解决:用悲观锁或乐观锁解决,volatile 并不能解决原子性

可见性

- 起因:由于编译器优化、或缓存优化、或 CPU 指令重排序优化导致的对共享变量所做的修改另外的线程看不到

- 解决:用 volatile 修饰共享变量,能够防止编译器等优化发生,让一个线程对共享变量的修改对另一个线程可见

有序性

- 起因:由于编译器优化、或缓存优化、或 CPU 指令重排序优化导致指令的实际执行顺序与编写顺序不一致

- 解决:用 volatile 修饰共享变量会在读、写共享变量时加入不同的屏障,阻止其他读写操作越过屏障,从而达到阻止重排序的效果

- 注意:

- volatile 变量写加的屏障是阻止上方其它写操作越过屏障排到 volatile 变量写之下

- volatile 变量读加的屏障是阻止下方其它读操作越过屏障排到 volatile 变量读之上

- volatile 读写加入的屏障只能防止同一线程内的指令重排

代码说明

- day02.threadsafe.AddAndSubtract 演示原子性

- day02.threadsafe.ForeverLoop 演示可见性

- 注意:本例经实践检验是编译器优化导致的可见性问题

- day02.threadsafe.Reordering 演示有序性

- 需要打成 jar 包后测试

- 请同时参考视频讲解

6. 悲观锁 vs 乐观锁

要求

- 掌握悲观锁和乐观锁的区别

对比悲观锁与乐观锁

-

悲观锁的代表是 synchronized 和 Lock 锁

- 其核心思想是【线程只有占有了锁,才能去操作共享变量,每次只有一个线程占锁成功,获取锁失败的线程,都得停下来等待】

- 线程从运行到阻塞、再从阻塞到唤醒,涉及线程上下文切换,如果频繁发生,影响性能

- 实际上,线程在获取 synchronized 和 Lock 锁时,如果锁已被占用,都会做几次重试操作,减少阻塞的机会

-

乐观锁的代表是 AtomicInteger,使用 cas 来保证原子性

- 其核心思想是【无需加锁,每次只有一个线程能成功修改共享变量,其它失败的线程不需要停止,不断重试直至成功】

- 由于线程一直运行,不需要阻塞,因此不涉及线程上下文切换

- 它需要多核 cpu 支持,且线程数不应超过 cpu 核数

代码说明

- day02.SyncVsCas 演示了分别使用乐观锁和悲观锁解决原子赋值

- 请同时参考视频讲解

7. Hashtable vs ConcurrentHashMap

要求

- 掌握 Hashtable 与 ConcurrentHashMap 的区别

- 掌握 ConcurrentHashMap 在不同版本的实现区别

更形象的演示,见资料中的 hash-demo.jar,运行需要 jdk14 以上环境,进入 jar 包目录,执行下面命令

java -jar --add-exports java.base/jdk.internal.misc=ALL-UNNAMED hash-demo.jar

Hashtable 对比 ConcurrentHashMap

- Hashtable 与 ConcurrentHashMap 都是线程安全的 Map 集合

- Hashtable 并发度低,整个 Hashtable 对应一把锁,同一时刻,只能有一个线程操作它

- ConcurrentHashMap 并发度高,整个 ConcurrentHashMap 对应多把锁,只要线程访问的是不同锁,那么不会冲突

ConcurrentHashMap 1.7

- 数据结构:

Segment(大数组) + HashEntry(小数组) + 链表,每个 Segment 对应一把锁,如果多个线程访问不同的 Segment,则不会冲突 - 并发度:Segment 数组大小即并发度,决定了同一时刻最多能有多少个线程并发访问。Segment 数组不能扩容,意味着并发度在 ConcurrentHashMap 创建时就固定了

- 索引计算

- 假设大数组长度是 \(2^m\),key 在大数组内的索引是 key 的二次 hash 值的高 m 位

- 假设小数组长度是 \(2^n\),key 在小数组内的索引是 key 的二次 hash 值的低 n 位

- 扩容:每个小数组的扩容相对独立,小数组在超过扩容因子时会触发扩容,每次扩容翻倍

- Segment[0] 原型:首次创建其它小数组时,会以此原型为依据,数组长度,扩容因子都会以原型为准

ConcurrentHashMap 1.8

- 数据结构:

Node 数组 + 链表或红黑树,数组的每个头节点作为锁,如果多个线程访问的头节点不同,则不会冲突。首次生成头节点时如果发生竞争,利用 cas 而非 syncronized,进一步提升性能 - 并发度:Node 数组有多大,并发度就有多大,与 1.7 不同,Node 数组可以扩容

- 扩容条件:Node 数组满 3/4 时就会扩容

- 扩容单位:以链表为单位从后向前迁移链表,迁移完成的将旧数组头节点替换为 ForwardingNode

- 扩容时并发 get

- 根据是否为 ForwardingNode 来决定是在新数组查找还是在旧数组查找,不会阻塞

- 如果链表长度超过 1,则需要对节点进行复制(创建新节点),怕的是节点迁移后 next 指针改变

- 如果链表最后几个元素扩容后索引不变,则节点无需复制

- 扩容时并发 put

- 如果 put 的线程与扩容线程操作的链表是同一个,put 线程会阻塞

- 如果 put 的线程操作的链表还未迁移完成,即头节点不是 ForwardingNode,则可以并发执行

- 如果 put 的线程操作的链表已经迁移完成,即头结点是 ForwardingNode,则可以协助扩容

- 与 1.7 相比是懒惰初始化

- capacity 代表预估的元素个数,capacity / factory 来计算出初始数组大小,需要贴近 \(2^n\)

- loadFactor 只在计算初始数组大小时被使用,之后扩容固定为 3/4

- 超过树化阈值时的扩容问题,如果容量已经是 64,直接树化,否则在原来容量基础上做 3 轮扩容

8. ThreadLocal

要求

- 掌握 ThreadLocal 的作用与原理

- 掌握 ThreadLocal 的内存释放时机

作用

- ThreadLocal 可以实现【资源对象】的线程隔离,让每个线程各用各的【资源对象】,避免争用引发的线程安全问题

- ThreadLocal 同时实现了线程内的资源共享

原理

每个线程内有一个 ThreadLocalMap 类型的成员变量,用来存储资源对象

- 调用 set 方法,就是以 ThreadLocal 自己作为 key,资源对象作为 value,放入当前线程的 ThreadLocalMap 集合中

- 调用 get 方法,就是以 ThreadLocal 自己作为 key,到当前线程中查找关联的资源值

- 调用 remove 方法,就是以 ThreadLocal 自己作为 key,移除当前线程关联的资源值

ThreadLocalMap 的一些特点

- key 的 hash 值统一分配

- 初始容量 16,扩容因子 2/3,扩容容量翻倍

- key 索引冲突后用开放寻址法解决冲突

弱引用 key

ThreadLocalMap 中的 key 被设计为弱引用,原因如下

- Thread 可能需要长时间运行(如线程池中的线程),如果 key 不再使用,需要在内存不足(GC)时释放其占用的内存

内存释放时机

- 被动 GC 释放 key

- 仅是让 key 的内存释放,关联 value 的内存并不会释放

- 懒惰被动释放 value

- get key 时,发现是 null key,则释放其 value 内存

- set key 时,会使用启发式扫描,清除临近的 null key 的 value 内存,启发次数与元素个数,是否发现 null key 有关

- 主动 remove 释放 key,value

- 会同时释放 key,value 的内存,也会清除临近的 null key 的 value 内存

- 推荐使用它,因为一般使用 ThreadLocal 时都把它作为静态变量(即强引用),因此无法被动依靠 GC 回收

框架篇

1. Spring refresh 流程

要求

- 掌握 refresh 的 12 个步骤

Spring refresh 概述

refresh 是 AbstractApplicationContext 中的一个方法,负责初始化 ApplicationContext 容器,容器必须调用 refresh 才能正常工作。它的内部主要会调用 12 个方法,我们把它们称为 refresh 的 12 个步骤:

-

prepareRefresh

-

obtainFreshBeanFactory

-

prepareBeanFactory

-

postProcessBeanFactory

-

invokeBeanFactoryPostProcessors

-

registerBeanPostProcessors

-

initMessageSource

-

initApplicationEventMulticaster

-

onRefresh

-

registerListeners

-

finishBeanFactoryInitialization

-

finishRefresh

功能分类

1 为准备环境

2 3 4 5 6 为准备 BeanFactory

7 8 9 10 12 为准备 ApplicationContext

11 为初始化 BeanFactory 中非延迟单例 bean

1. prepareRefresh

-

这一步创建和准备了 Environment 对象,它作为 ApplicationContext 的一个成员变量

-

Environment 对象的作用之一是为后续 @Value,值注入时提供键值

-

Environment 分成三个主要部分

- systemProperties - 保存 java 环境键值

- systemEnvironment - 保存系统环境键值

- 自定义 PropertySource - 保存自定义键值,例如来自于 *.properties 文件的键值

2. obtainFreshBeanFactory

- 这一步获取(或创建) BeanFactory,它也是作为 ApplicationContext 的一个成员变量

- BeanFactory 的作用是负责 bean 的创建、依赖注入和初始化,bean 的各项特征由 BeanDefinition 定义

- BeanDefinition 作为 bean 的设计蓝图,规定了 bean 的特征,如单例多例、依赖关系、初始销毁方法等

- BeanDefinition 的来源有多种多样,可以是通过 xml 获得、配置类获得、组件扫描获得,也可以是编程添加

- 所有的 BeanDefinition 会存入 BeanFactory 中的 beanDefinitionMap 集合

3. prepareBeanFactory

- 这一步会进一步完善 BeanFactory,为它的各项成员变量赋值

- beanExpressionResolver 用来解析 SpEL,常见实现为 StandardBeanExpressionResolver

- propertyEditorRegistrars 会注册类型转换器

- 它在这里使用了 ResourceEditorRegistrar 实现类

- 并应用 ApplicationContext 提供的 Environment 完成 ${ } 解析

- registerResolvableDependency 来注册 beanFactory 以及 ApplicationContext,让它们也能用于依赖注入

- beanPostProcessors 是 bean 后处理器集合,会工作在 bean 的生命周期各个阶段,此处会添加两个:

- ApplicationContextAwareProcessor 用来解析 Aware 接口

- ApplicationListenerDetector 用来识别容器中 ApplicationListener 类型的 bean

4. postProcessBeanFactory

- 这一步是空实现,留给子类扩展。

- 一般 Web 环境的 ApplicationContext 都要利用它注册新的 Scope,完善 Web 下的 BeanFactory

- 这里体现的是模板方法设计模式

5. invokeBeanFactoryPostProcessors

- 这一步会调用 beanFactory 后处理器

- beanFactory 后处理器,充当 beanFactory 的扩展点,可以用来补充或修改 BeanDefinition

- 常见的 beanFactory 后处理器有

- ConfigurationClassPostProcessor – 解析 @Configuration、@Bean、@Import、@PropertySource 等

- PropertySourcesPlaceHolderConfigurer – 替换 BeanDefinition 中的 $

- MapperScannerConfigurer – 补充 Mapper 接口对应的 BeanDefinition

6. registerBeanPostProcessors

- 这一步是继续从 beanFactory 中找出 bean 后处理器,添加至 beanPostProcessors 集合中

- bean 后处理器,充当 bean 的扩展点,可以工作在 bean 的实例化、依赖注入、初始化阶段,常见的有:

- AutowiredAnnotationBeanPostProcessor 功能有:解析 @Autowired,@Value 注解

- CommonAnnotationBeanPostProcessor 功能有:解析 @Resource,@PostConstruct,@PreDestroy

- AnnotationAwareAspectJAutoProxyCreator 功能有:为符合切点的目标 bean 自动创建代理

7. initMessageSource

- 这一步是为 ApplicationContext 添加 messageSource 成员,实现国际化功能

- 去 beanFactory 内找名为 messageSource 的 bean,如果没有,则提供空的 MessageSource 实现

8. initApplicationContextEventMulticaster

- 这一步为 ApplicationContext 添加事件广播器成员,即 applicationContextEventMulticaster

- 它的作用是发布事件给监听器

- 去 beanFactory 找名为 applicationEventMulticaster 的 bean 作为事件广播器,若没有,会创建默认的事件广播器

- 之后就可以调用 ApplicationContext.publishEvent(事件对象) 来发布事件

9. onRefresh

- 这一步是空实现,留给子类扩展

- SpringBoot 中的子类在这里准备了 WebServer,即内嵌 web 容器

- 体现的是模板方法设计模式

10. registerListeners

- 这一步会从多种途径找到事件监听器,并添加至 applicationEventMulticaster

- 事件监听器顾名思义,用来接收事件广播器发布的事件,有如下来源

- 事先编程添加的

- 来自容器中的 bean

- 来自于 @EventListener 的解析

- 要实现事件监听器,只需要实现 ApplicationListener 接口,重写其中 onApplicationEvent(E e) 方法即可

11. finishBeanFactoryInitialization

- 这一步会将 beanFactory 的成员补充完毕,并初始化所有非延迟单例 bean

- conversionService 也是一套转换机制,作为对 PropertyEditor 的补充

- embeddedValueResolvers 即内嵌值解析器,用来解析 @Value 中的 ${ },借用的是 Environment 的功能

- singletonObjects 即单例池,缓存所有单例对象

- 对象的创建都分三个阶段,每一阶段都有不同的 bean 后处理器参与进来,扩展功能

12. finishRefresh

- 这一步会为 ApplicationContext 添加 lifecycleProcessor 成员,用来控制容器内需要生命周期管理的 bean

- 如果容器中有名称为 lifecycleProcessor 的 bean 就用它,否则创建默认的生命周期管理器

- 准备好生命周期管理器,就可以实现

- 调用 context 的 start,即可触发所有实现 LifeCycle 接口 bean 的 start

- 调用 context 的 stop,即可触发所有实现 LifeCycle 接口 bean 的 stop

- 发布 ContextRefreshed 事件,整个 refresh 执行完成

2. Spring bean 生命周期

要求

- 掌握 Spring bean 的生命周期

bean 生命周期 概述

bean 的生命周期从调用 beanFactory 的 getBean 开始,到这个 bean 被销毁,可以总结为以下七个阶段:

- 处理名称,检查缓存

- 处理父子容器

- 处理 dependsOn

- 选择 scope 策略

- 创建 bean

- 类型转换处理

- 销毁 bean

注意

- 划分的阶段和名称并不重要,重要的是理解整个过程中做了哪些事情

1. 处理名称,检查缓存

- 这一步会处理别名,将别名解析为实际名称

- 对 FactoryBean 也会特殊处理,如果以 & 开头表示要获取 FactoryBean 本身,否则表示要获取其产品

- 这里针对单例对象会检查一级、二级、三级缓存

- singletonFactories 三级缓存,存放单例工厂对象

- earlySingletonObjects 二级缓存,存放单例工厂的产品对象

- 如果发生循环依赖,产品是代理;无循环依赖,产品是原始对象

- singletonObjects 一级缓存,存放单例成品对象

2. 处理父子容器

- 如果当前容器根据名字找不到这个 bean,此时若父容器存在,则执行父容器的 getBean 流程

- 父子容器的 bean 名称可以重复

3. 处理 dependsOn

- 如果当前 bean 有通过 dependsOn 指定了非显式依赖的 bean,这一步会提前创建这些 dependsOn 的 bean

- 所谓非显式依赖,就是指两个 bean 之间不存在直接依赖关系,但需要控制它们的创建先后顺序

4. 选择 scope 策略

- 对于 singleton scope,首先到单例池去获取 bean,如果有则直接返回,没有再进入创建流程

- 对于 prototype scope,每次都会进入创建流程

- 对于自定义 scope,例如 request,首先到 request 域获取 bean,如果有则直接返回,没有再进入创建流程

5.1 创建 bean - 创建 bean 实例

| 要点 | 总结 |

|---|---|

| 有自定义 TargetSource 的情况 | 由 AnnotationAwareAspectJAutoProxyCreator 创建代理返回 |

| Supplier 方式创建 bean 实例 | 为 Spring 5.0 新增功能,方便编程方式创建 bean 实例 |

| FactoryMethod 方式 创建 bean 实例 | ① 分成静态工厂与实例工厂;② 工厂方法若有参数,需要对工厂方法参数进行解析,利用 resolveDependency;③ 如果有多个工厂方法候选者,还要进一步按权重筛选 |

| AutowiredAnnotationBeanPostProcessor | ① 优先选择带 @Autowired 注解的构造;② 若有唯一的带参构造,也会入选 |

| mbd.getPreferredConstructors | 选择所有公共构造,这些构造之间按权重筛选 |

| 采用默认构造 | 如果上面的后处理器和 BeanDefiniation 都没找到构造,采用默认构造,即使是私有的 |

5.2 创建 bean - 依赖注入

| 要点 | 总结 |

|---|---|

| AutowiredAnnotationBeanPostProcessor | 识别 @Autowired 及 @Value 标注的成员,封装为 InjectionMetadata 进行依赖注入 |

| CommonAnnotationBeanPostProcessor | 识别 @Resource 标注的成员,封装为 InjectionMetadata 进行依赖注入 |

| resolveDependency | 用来查找要装配的值,可以识别:① Optional;② ObjectFactory 及 ObjectProvider;③ @Lazy 注解;④ @Value 注解(${ }, #{ }, 类型转换);⑤ 集合类型(Collection,Map,数组等);⑥ 泛型和 @Qualifier(用来区分类型歧义);⑦ primary 及名字匹配(用来区分类型歧义) |

| AUTOWIRE_BY_NAME | 根据成员名字找 bean 对象,修改 mbd 的 propertyValues,不会考虑简单类型的成员 |

| AUTOWIRE_BY_TYPE | 根据成员类型执行 resolveDependency 找到依赖注入的值,修改 mbd 的 propertyValues |

| applyPropertyValues | 根据 mbd 的 propertyValues 进行依赖注入(即xml中 `<property name ref |

5.3 创建 bean - 初始化

| 要点 | 总结 |

|---|---|

| 内置 Aware 接口的装配 | 包括 BeanNameAware,BeanFactoryAware 等 |

| 扩展 Aware 接口的装配 | 由 ApplicationContextAwareProcessor 解析,执行时机在 postProcessBeforeInitialization |

| @PostConstruct | 由 CommonAnnotationBeanPostProcessor 解析,执行时机在 postProcessBeforeInitialization |

| InitializingBean | 通过接口回调执行初始化 |

| initMethod | 根据 BeanDefinition 得到的初始化方法执行初始化,即 <bean init-method> 或 @Bean(initMethod) |

| 创建 aop 代理 | 由 AnnotationAwareAspectJAutoProxyCreator 创建,执行时机在 postProcessAfterInitialization |

5.4 创建 bean - 注册可销毁 bean

在这一步判断并登记可销毁 bean

- 判断依据

- 如果实现了 DisposableBean 或 AutoCloseable 接口,则为可销毁 bean

- 如果自定义了 destroyMethod,则为可销毁 bean

- 如果采用 @Bean 没有指定 destroyMethod,则采用自动推断方式获取销毁方法名(close,shutdown)

- 如果有 @PreDestroy 标注的方法

- 存储位置

- singleton scope 的可销毁 bean 会存储于 beanFactory 的成员当中

- 自定义 scope 的可销毁 bean 会存储于对应的域对象当中

- prototype scope 不会存储,需要自己找到此对象销毁

- 存储时都会封装为 DisposableBeanAdapter 类型对销毁方法的调用进行适配

6. 类型转换处理

- 如果 getBean 的 requiredType 参数与实际得到的对象类型不同,会尝试进行类型转换

7. 销毁 bean

- 销毁时机

- singleton bean 的销毁在 ApplicationContext.close 时,此时会找到所有 DisposableBean 的名字,逐一销毁

- 自定义 scope bean 的销毁在作用域对象生命周期结束时

- prototype bean 的销毁可以通过自己手动调用 AutowireCapableBeanFactory.destroyBean 方法执行销毁

- 同一 bean 中不同形式销毁方法的调用次序

- 优先后处理器销毁,即 @PreDestroy

- 其次 DisposableBean 接口销毁

- 最后 destroyMethod 销毁(包括自定义名称,推断名称,AutoCloseable 接口 多选一)

3. Spring bean 循环依赖

要求

- 掌握单例 set 方式循环依赖的原理

- 掌握其它循环依赖的解决方法

循环依赖的产生

- 首先要明白,bean 的创建要遵循一定的步骤,必须是创建、注入、初始化三步,这些顺序不能乱

-

set 方法(包括成员变量)的循环依赖如图所示

-

可以在【a 创建】和【a set 注入 b】之间加入 b 的整个流程来解决

-

【b set 注入 a】 时可以成功,因为之前 a 的实例已经创建完毕

-

a 的顺序,及 b 的顺序都能得到保障

-

- 构造方法的循环依赖如图所示,显然无法用前面的方法解决

构造循环依赖的解决

- 思路1

- a 注入 b 的代理对象,这样能够保证 a 的流程走通

- 后续需要用到 b 的真实对象时,可以通过代理间接访问

- 思路2

- a 注入 b 的工厂对象,让 b 的实例创建被推迟,这样能够保证 a 的流程先走通

- 后续需要用到 b 的真实对象时,再通过 ObjectFactory 工厂间接访问

- 示例1:用 @Lazy 为构造方法参数生成代理

public class App60_1 {

static class A {

private static final Logger log = LoggerFactory.getLogger("A");

private B b;

public A(@Lazy B b) {

log.debug("A(B b) {}", b.getClass());

this.b = b;

}

@PostConstruct

public void init() {

log.debug("init()");

}

}

static class B {

private static final Logger log = LoggerFactory.getLogger("B");

private A a;

public B(A a) {

log.debug("B({})", a);

this.a = a;

}

@PostConstruct

public void init() {

log.debug("init()");

}

}

public static void main(String[] args) {

GenericApplicationContext context = new GenericApplicationContext();

context.registerBean("a", A.class);

context.registerBean("b", B.class);

AnnotationConfigUtils.registerAnnotationConfigProcessors(context.getDefaultListableBeanFactory());

context.refresh();

System.out.println();

}

}

- 示例2:用 ObjectProvider 延迟依赖对象的创建

public class App60_2 {

static class A {

private static final Logger log = LoggerFactory.getLogger("A");

private ObjectProvider<B> b;

public A(ObjectProvider<B> b) {

log.debug("A({})", b);

this.b = b;

}

@PostConstruct

public void init() {

log.debug("init()");

}

}

static class B {

private static final Logger log = LoggerFactory.getLogger("B");

private A a;

public B(A a) {

log.debug("B({})", a);

this.a = a;

}

@PostConstruct

public void init() {

log.debug("init()");

}

}

public static void main(String[] args) {

GenericApplicationContext context = new GenericApplicationContext();

context.registerBean("a", A.class);

context.registerBean("b", B.class);

AnnotationConfigUtils.registerAnnotationConfigProcessors(context.getDefaultListableBeanFactory());

context.refresh();

System.out.println(context.getBean(A.class).b.getObject());

System.out.println(context.getBean(B.class));

}

}

- 示例3:用 @Scope 产生代理

public class App60_3 {

public static void main(String[] args) {

GenericApplicationContext context = new GenericApplicationContext();

ClassPathBeanDefinitionScanner scanner = new ClassPathBeanDefinitionScanner(context.getDefaultListableBeanFactory());

scanner.scan("com.itheima.app60.sub");

context.refresh();

System.out.println();

}

}

@Component

class A {

private static final Logger log = LoggerFactory.getLogger("A");

private B b;

public A(B b) {

log.debug("A(B b) {}", b.getClass());

this.b = b;

}

@PostConstruct

public void init() {

log.debug("init()");

}

}

@Scope(proxyMode = ScopedProxyMode.TARGET_CLASS)

@Component

class B {

private static final Logger log = LoggerFactory.getLogger("B");

private A a;

public B(A a) {

log.debug("B({})", a);

this.a = a;

}

@PostConstruct

public void init() {

log.debug("init()");

}

}

- 示例4:用 Provider 接口解决,原理上与 ObjectProvider 一样,Provider 接口是独立的 jar 包,需要加入依赖

<dependency>

<groupId>javax.inject</groupId>

<artifactId>javax.inject</artifactId>

<version>1</version>

</dependency>

public class App60_4 {

static class A {

private static final Logger log = LoggerFactory.getLogger("A");

private Provider<B> b;

public A(Provider<B> b) {

log.debug("A({}})", b);

this.b = b;

}

@PostConstruct

public void init() {

log.debug("init()");

}

}

static class B {

private static final Logger log = LoggerFactory.getLogger("B");

private A a;

public B(A a) {

log.debug("B({}})", a);

this.a = a;

}

@PostConstruct

public void init() {

log.debug("init()");

}

}

public static void main(String[] args) {

GenericApplicationContext context = new GenericApplicationContext();

context.registerBean("a", A.class);

context.registerBean("b", B.class);

AnnotationConfigUtils.registerAnnotationConfigProcessors(context.getDefaultListableBeanFactory());

context.refresh();

System.out.println(context.getBean(A.class).b.get());

System.out.println(context.getBean(B.class));

}

}

解决 set 循环依赖的原理

一级缓存

作用是保证单例对象仅被创建一次

- 第一次走

getBean("a")流程后,最后会将成品 a 放入 singletonObjects 一级缓存 - 后续再走

getBean("a")流程时,先从一级缓存中找,这时已经有成品 a,就无需再次创建

一级缓存与循环依赖

一级缓存无法解决循环依赖问题,分析如下

- 无论是获取 bean a 还是获取 bean b,走的方法都是同一个 getBean 方法,假设先走

getBean("a") - 当 a 的实例对象创建,接下来执行

a.setB()时,需要走getBean("b")流程,红色箭头 1 - 当 b 的实例对象创建,接下来执行

b.setA()时,又回到了getBean("a")的流程,红色箭头 2 - 但此时 singletonObjects 一级缓存内没有成品的 a,陷入了死循环

二级缓存

解决思路如下:

- 再增加一个 singletonFactories 缓存

- 在依赖注入前,即

a.setB()以及b.setA()将 a 及 b 的半成品对象(未完成依赖注入和初始化)放入此缓存 - 执行依赖注入时,先看看 singletonFactories 缓存中是否有半成品的对象,如果有拿来注入,顺利走完流程

对于上面的图

a = new A()执行之后就会把这个半成品的 a 放入 singletonFactories 缓存,即factories.put(a)- 接下来执行

a.setB(),走入getBean("b")流程,红色箭头 3 - 这回再执行到

b.setA()时,需要一个 a 对象,有没有呢?有! factories.get()在 singletonFactories 缓存中就可以找到,红色箭头 4 和 5- b 的流程能够顺利走完,将 b 成品放入 singletonObject 一级缓存,返回到 a 的依赖注入流程,红色箭头 6

二级缓存与创建代理

二级缓存无法正确处理循环依赖并且包含有代理创建的场景,分析如下

- spring 默认要求,在

a.init完成之后才能创建代理pa = proxy(a) - 由于 a 的代理创建时机靠后,在执行

factories.put(a)向 singletonFactories 中放入的还是原始对象 - 接下来箭头 3、4、5 这几步 b 对象拿到和注入的都是原始对象

三级缓存

简单分析的话,只需要将代理的创建时机放在依赖注入之前即可,但 spring 仍然希望代理的创建时机在 init 之后,只有出现循环依赖时,才会将代理的创建时机提前。所以解决思路稍显复杂:

- 图中

factories.put(fa)放入的既不是原始对象,也不是代理对象而是工厂对象 fa - 当检查出发生循环依赖时,fa 的产品就是代理 pa,没有发生循环依赖,fa 的产品是原始对象 a

- 假设出现了循环依赖,拿到了 singletonFactories 中的工厂对象,通过在依赖注入前获得了 pa,红色箭头 5

- 这回

b.setA()注入的就是代理对象,保证了正确性,红色箭头 7 - 还需要把 pa 存入新加的 earlySingletonObjects 缓存,红色箭头 6

a.init完成后,无需二次创建代理,从哪儿找到 pa 呢?earlySingletonObjects 已经缓存,蓝色箭头 9

当成品对象产生,放入 singletonObject 后,singletonFactories 和 earlySingletonObjects 就中的对象就没有用处,清除即可

4. Spring 事务失效

要求

- 掌握事务失效的八种场景

1. 抛出检查异常导致事务不能正确回滚

@Service

public class Service1 {

@Autowired

private AccountMapper accountMapper;

@Transactional

public void transfer(int from, int to, int amount) throws FileNotFoundException {

int fromBalance = accountMapper.findBalanceBy(from);

if (fromBalance - amount >= 0) {

accountMapper.update(from, -1 * amount);

new FileInputStream("aaa");

accountMapper.update(to, amount);

}

}

}

-

原因:Spring 默认只会回滚非检查异常

-

解法:配置 rollbackFor 属性

@Transactional(rollbackFor = Exception.class)

2. 业务方法内自己 try-catch 异常导致事务不能正确回滚

@Service

public class Service2 {

@Autowired

private AccountMapper accountMapper;

@Transactional(rollbackFor = Exception.class)

public void transfer(int from, int to, int amount) {

try {

int fromBalance = accountMapper.findBalanceBy(from);

if (fromBalance - amount >= 0) {

accountMapper.update(from, -1 * amount);

new FileInputStream("aaa");

accountMapper.update(to, amount);

}

} catch (FileNotFoundException e) {

e.printStackTrace();

}

}

}

-

原因:事务通知只有捉到了目标抛出的异常,才能进行后续的回滚处理,如果目标自己处理掉异常,事务通知无法知悉

-

解法1:异常原样抛出

- 在 catch 块添加

throw new RuntimeException(e);

- 在 catch 块添加

-

解法2:手动设置 TransactionStatus.setRollbackOnly()

- 在 catch 块添加

TransactionInterceptor.currentTransactionStatus().setRollbackOnly();

- 在 catch 块添加

3. aop 切面顺序导致导致事务不能正确回滚

@Service

public class Service3 {

@Autowired

private AccountMapper accountMapper;

@Transactional(rollbackFor = Exception.class)

public void transfer(int from, int to, int amount) throws FileNotFoundException {

int fromBalance = accountMapper.findBalanceBy(from);

if (fromBalance - amount >= 0) {

accountMapper.update(from, -1 * amount);

new FileInputStream("aaa");

accountMapper.update(to, amount);

}

}

}

@Aspect

public class MyAspect {

@Around("execution(* transfer(..))")

public Object around(ProceedingJoinPoint pjp) throws Throwable {

LoggerUtils.get().debug("log:{}", pjp.getTarget());

try {

return pjp.proceed();

} catch (Throwable e) {

e.printStackTrace();

return null;

}

}

}

-

原因:事务切面优先级最低,但如果自定义的切面优先级和他一样,则还是自定义切面在内层,这时若自定义切面没有正确抛出异常…

-

解法1、2:同情况2 中的解法:1、2

-

解法3:调整切面顺序,在 MyAspect 上添加

@Order(Ordered.LOWEST_PRECEDENCE - 1)(不推荐)

4. 非 public 方法导致的事务失效

@Service

public class Service4 {

@Autowired

private AccountMapper accountMapper;

@Transactional

void transfer(int from, int to, int amount) throws FileNotFoundException {

int fromBalance = accountMapper.findBalanceBy(from);

if (fromBalance - amount >= 0) {

accountMapper.update(from, -1 * amount);

accountMapper.update(to, amount);

}

}

}

-

原因:Spring 为方法创建代理、添加事务通知、前提条件都是该方法是 public 的

-

解法1:改为 public 方法

-

解法2:添加 bean 配置如下(不推荐)

@Bean

public TransactionAttributeSource transactionAttributeSource() {

return new AnnotationTransactionAttributeSource(false);

}

5. 父子容器导致的事务失效

package day04.tx.app.service;

// ...

@Service

public class Service5 {

@Autowired

private AccountMapper accountMapper;

@Transactional(rollbackFor = Exception.class)

public void transfer(int from, int to, int amount) throws FileNotFoundException {

int fromBalance = accountMapper.findBalanceBy(from);

if (fromBalance - amount >= 0) {

accountMapper.update(from, -1 * amount);

accountMapper.update(to, amount);

}

}

}

控制器类

package day04.tx.app.controller;

// ...

@Controller

public class AccountController {

@Autowired

public Service5 service;

public void transfer(int from, int to, int amount) throws FileNotFoundException {

service.transfer(from, to, amount);

}

}

App 配置类

@Configuration

@ComponentScan("day04.tx.app.service")

@EnableTransactionManagement

// ...

public class AppConfig {

// ... 有事务相关配置

}

Web 配置类

@Configuration

@ComponentScan("day04.tx.app")

// ...

public class WebConfig {

// ... 无事务配置

}

现在配置了父子容器,WebConfig 对应子容器,AppConfig 对应父容器,发现事务依然失效

-

原因:子容器扫描范围过大,把未加事务配置的 service 扫描进来

-

解法1:各扫描各的,不要图简便

-

解法2:不要用父子容器,所有 bean 放在同一容器

6. 调用本类方法导致传播行为失效

@Service

public class Service6 {

@Transactional(propagation = Propagation.REQUIRED, rollbackFor = Exception.class)

public void foo() throws FileNotFoundException {

LoggerUtils.get().debug("foo");

bar();

}

@Transactional(propagation = Propagation.REQUIRES_NEW, rollbackFor = Exception.class)

public void bar() throws FileNotFoundException {

LoggerUtils.get().debug("bar");

}

}

-

原因:本类方法调用不经过代理,因此无法增强

-

解法1:依赖注入自己(代理)来调用

-

解法2:通过 AopContext 拿到代理对象,来调用

-

解法3:通过 CTW,LTW 实现功能增强

解法1

@Service

public class Service6 {

@Autowired

private Service6 proxy; // 本质上是一种循环依赖

@Transactional(propagation = Propagation.REQUIRED, rollbackFor = Exception.class)

public void foo() throws FileNotFoundException {

LoggerUtils.get().debug("foo");

System.out.println(proxy.getClass());

proxy.bar();

}

@Transactional(propagation = Propagation.REQUIRES_NEW, rollbackFor = Exception.class)

public void bar() throws FileNotFoundException {

LoggerUtils.get().debug("bar");

}

}

解法2,还需要在 AppConfig 上添加 @EnableAspectJAutoProxy(exposeProxy = true)

@Service

public class Service6 {

@Transactional(propagation = Propagation.REQUIRED, rollbackFor = Exception.class)

public void foo() throws FileNotFoundException {

LoggerUtils.get().debug("foo");

((Service6) AopContext.currentProxy()).bar();

}

@Transactional(propagation = Propagation.REQUIRES_NEW, rollbackFor = Exception.class)

public void bar() throws FileNotFoundException {

LoggerUtils.get().debug("bar");

}

}

7. @Transactional 没有保证原子行为

@Service

public class Service7 {

private static final Logger logger = LoggerFactory.getLogger(Service7.class);

@Autowired

private AccountMapper accountMapper;

@Transactional(rollbackFor = Exception.class)

public void transfer(int from, int to, int amount) {

int fromBalance = accountMapper.findBalanceBy(from);

logger.debug("更新前查询余额为: {}", fromBalance);

if (fromBalance - amount >= 0) {

accountMapper.update(from, -1 * amount);

accountMapper.update(to, amount);

}

}

public int findBalance(int accountNo) {

return accountMapper.findBalanceBy(accountNo);

}

}

上面的代码实际上是有 bug 的,假设 from 余额为 1000,两个线程都来转账 1000,可能会出现扣减为负数的情况

- 原因:事务的原子性仅涵盖 insert、update、delete、select … for update 语句,select 方法并不阻塞

- 如上图所示,红色线程和蓝色线程的查询都发生在扣减之前,都以为自己有足够的余额做扣减

8. @Transactional 方法导致的 synchronized 失效

针对上面的问题,能否在方法上加 synchronized 锁来解决呢?

@Service

public class Service7 {

private static final Logger logger = LoggerFactory.getLogger(Service7.class);

@Autowired

private AccountMapper accountMapper;

@Transactional(rollbackFor = Exception.class)

public synchronized void transfer(int from, int to, int amount) {

int fromBalance = accountMapper.findBalanceBy(from);

logger.debug("更新前查询余额为: {}", fromBalance);

if (fromBalance - amount >= 0) {

accountMapper.update(from, -1 * amount);

accountMapper.update(to, amount);

}

}

public int findBalance(int accountNo) {

return accountMapper.findBalanceBy(accountNo);

}

}

答案是不行,原因如下:

- synchronized 保证的仅是目标方法的原子性,环绕目标方法的还有 commit 等操作,它们并未处于 sync 块内

- 可以参考下图发现,蓝色线程的查询只要在红色线程提交之前执行,那么依然会查询到有 1000 足够余额来转账

-

解法1:synchronized 范围应扩大至代理方法调用

-

解法2:使用 select … for update 替换 select

5. Spring MVC 执行流程

要求

- 掌握 Spring MVC 的执行流程

- 了解 Spring MVC 的重要组件的作用

概要

我把整个流程分成三个阶段

- 准备阶段

- 匹配阶段

- 执行阶段

准备阶段

-

在 Web 容器第一次用到 DispatcherServlet 的时候,会创建其对象并执行 init 方法

-

init 方法内会创建 Spring Web 容器,并调用容器 refresh 方法

-

refresh 过程中会创建并初始化 SpringMVC 中的重要组件, 例如 MultipartResolver,HandlerMapping,HandlerAdapter,HandlerExceptionResolver、ViewResolver 等

-

容器初始化后,会将上一步初始化好的重要组件,赋值给 DispatcherServlet 的成员变量,留待后用

匹配阶段

-

用户发送的请求统一到达前端控制器 DispatcherServlet

-

DispatcherServlet 遍历所有 HandlerMapping ,找到与路径匹配的处理器

① HandlerMapping 有多个,每个 HandlerMapping 会返回不同的处理器对象,谁先匹配,返回谁的处理器。其中能识别 @RequestMapping 的优先级最高

② 对应 @RequestMapping 的处理器是 HandlerMethod,它包含了控制器对象和控制器方法信息

③ 其中路径与处理器的映射关系在 HandlerMapping 初始化时就会建立好

- 将 HandlerMethod 连同匹配到的拦截器,生成调用链对象 HandlerExecutionChain 返回

- 遍历HandlerAdapter 处理器适配器,找到能处理 HandlerMethod 的适配器对象,开始调用

调用阶段

- 执行拦截器 preHandle

-

由 HandlerAdapter 调用 HandlerMethod

① 调用前处理不同类型的参数

② 调用后处理不同类型的返回值

-

第 2 步没有异常

① 返回 ModelAndView

② 执行拦截器 postHandle 方法

③ 解析视图,得到 View 对象,进行视图渲染

- 第 2 步有异常,进入 HandlerExceptionResolver 异常处理流程

-

最后都会执行拦截器的 afterCompletion 方法

-

如果控制器方法标注了 @ResponseBody 注解,则在第 2 步,就会生成 json 结果,并标记 ModelAndView 已处理,这样就不会执行第 3 步的视图渲染

6. Spring 注解

要求

- 掌握 Spring 常见注解

提示

- 注解的详细列表请参考:面试题-spring-注解.xmind

- 下面列出了视频中重点提及的注解,考虑到大部分注解同学们已经比较熟悉了,仅对个别的作简要说明

事务注解

- @EnableTransactionManagement,会额外加载 4 个 bean

- BeanFactoryTransactionAttributeSourceAdvisor 事务切面类

- TransactionAttributeSource 用来解析事务属性

- TransactionInterceptor 事务拦截器

- TransactionalEventListenerFactory 事务监听器工厂

- @Transactional

核心

- @Order

切面

- @EnableAspectJAutoProxy

- 会加载 AnnotationAwareAspectJAutoProxyCreator,它是一个 bean 后处理器,用来创建代理

- 如果没有配置 @EnableAspectJAutoProxy,又需要用到代理(如事务)则会使用 InfrastructureAdvisorAutoProxyCreator 这个 bean 后处理器

组件扫描与配置类

-

@Component

-

@Controller

-

@Service

-

@Repository

-

@ComponentScan

-

@Conditional

-

@Configuration

- 配置类其实相当于一个工厂, 标注 @Bean 注解的方法相当于工厂方法

- @Bean 不支持方法重载, 如果有多个重载方法, 仅有一个能入选为工厂方法

- @Configuration 默认会为标注的类生成代理, 其目的是保证 @Bean 方法相互调用时, 仍然能保证其单例特性

- @Configuration 中如果含有 BeanFactory 后处理器, 则实例工厂方法会导致 MyConfig 提前创建, 造成其依赖注入失败,解决方法是改用静态工厂方法或直接为 @Bean 的方法参数依赖注入, 针对 Mapper 扫描可以改用注解方式

-

@Bean

-

@Import

-

四种用法

① 引入单个 bean

② 引入一个配置类

③ 通过 Selector 引入多个类

④ 通过 beanDefinition 注册器

-

解析规则

- 同一配置类中, @Import 先解析 @Bean 后解析

- 同名定义, 默认后面解析的会覆盖前面解析的

- 不允许覆盖的情况下, 如何能够让 MyConfig(主配置类) 的配置优先? (虽然覆盖方式能解决)

- 采用 DeferredImportSelector,因为它最后工作, 可以简单认为先解析 @Bean, 再 Import

-

-

@Lazy

- 加在类上,表示此类延迟实例化、初始化

- 加在方法参数上,此参数会以代理方式注入

-

@PropertySource

依赖注入

- @Autowired

- @Qualifier

- @Value

mvc mapping

- @RequestMapping,可以派生多个注解如 @GetMapping 等

mvc rest

- @RequestBody

- @ResponseBody,组合 @Controller => @RestController

- @ResponseStatus

mvc 统一处理

- @ControllerAdvice,组合 @ResponseBody => @RestControllerAdvice

- @ExceptionHandler

mvc 参数

- @PathVariable

mvc ajax

- @CrossOrigin

boot auto

- @SpringBootApplication

- @EnableAutoConfiguration

- @SpringBootConfiguration

boot condition

- @ConditionalOnClass,classpath 下存在某个 class 时,条件才成立

- @ConditionalOnMissingBean,beanFactory 内不存在某个 bean 时,条件才成立

- @ConditionalOnProperty,配置文件中存在某个 property(键、值)时,条件才成立

boot properties

- @ConfigurationProperties,会将当前 bean 的属性与配置文件中的键值进行绑定

- @EnableConfigurationProperties,会添加两个较为重要的 bean

- ConfigurationPropertiesBindingPostProcessor,bean 后处理器,在 bean 初始化前调用下面的 binder

- ConfigurationPropertiesBinder,真正执行绑定操作

7. SpringBoot 自动配置原理

要求

- 掌握 SpringBoot 自动配置原理

自动配置原理

@SpringBootConfiguration 是一个组合注解,由 @ComponentScan、@EnableAutoConfiguration 和 @SpringBootConfiguration 组成

-

@SpringBootConfiguration 与普通 @Configuration 相比,唯一区别是前者要求整个 app 中只出现一次

-

@ComponentScan

- excludeFilters - 用来在组件扫描时进行排除,也会排除自动配置类

-

@EnableAutoConfiguration 也是一个组合注解,由下面注解组成

- @AutoConfigurationPackage – 用来记住扫描的起始包

- @Import(AutoConfigurationImportSelector.class) 用来加载

META-INF/spring.factories中的自动配置类

为什么不使用 @Import 直接引入自动配置类

有两个原因:

- 让主配置类和自动配置类变成了强耦合,主配置类不应该知道有哪些从属配置

- 直接用

@Import(自动配置类.class),引入的配置解析优先级较高,自动配置类的解析应该在主配置没提供时作为默认配置

因此,采用了 @Import(AutoConfigurationImportSelector.class)

- 由

AutoConfigurationImportSelector.class去读取META-INF/spring.factories中的自动配置类,实现了弱耦合。 - 另外

AutoConfigurationImportSelector.class实现了 DeferredImportSelector 接口,让自动配置的解析晚于主配置的解析

8. Spring 中的设计模式

要求

- 掌握 Spring 中常见的设计模式

1. Spring 中的 Singleton

请大家区分 singleton pattern 与 Spring 中的 singleton bean

- 根据单例模式的目的 Ensure a class only has one instance, and provide a global point of access to it

- 显然 Spring 中的 singleton bean 并非实现了单例模式,singleton bean 只能保证每个容器内,相同 id 的 bean 单实例

- 当然 Spring 中也用到了单例模式,例如

- org.springframework.transaction.TransactionDefinition#withDefaults

- org.springframework.aop.TruePointcut#INSTANCE

- org.springframework.aop.interceptor.ExposeInvocationInterceptor#ADVISOR

- org.springframework.core.annotation.AnnotationAwareOrderComparator#INSTANCE

- org.springframework.core.OrderComparator#INSTANCE

2. Spring 中的 Builder

定义 Separate the construction of a complex object from its representation so that the same construction process can create different representations

它的主要亮点有三处:

-

较为灵活的构建产品对象

-

在不执行最后 build 方法前,产品对象都不可用

-

构建过程采用链式调用,看起来比较爽

Spring 中体现 Builder 模式的地方:

-

org.springframework.beans.factory.support.BeanDefinitionBuilder

-

org.springframework.web.util.UriComponentsBuilder

-

org.springframework.http.ResponseEntity.HeadersBuilder

-

org.springframework.http.ResponseEntity.BodyBuilder

3. Spring 中的 Factory Method

定义 Define an interface for creating an object, but let subclasses decide which class to instantiate. Factory Method lets a class defer instantiation to subclasses

根据上面的定义,Spring 中的 ApplicationContext 与 BeanFactory 中的 getBean 都可以视为工厂方法,它隐藏了 bean (产品)的创建过程和具体实现

Spring 中其它工厂:

-

org.springframework.beans.factory.FactoryBean

-

@Bean 标注的静态方法及实例方法

-

ObjectFactory 及 ObjectProvider

前两种工厂主要封装第三方的 bean 的创建过程,后两种工厂可以推迟 bean 创建,解决循环依赖及单例注入多例等问题

4. Spring 中的 Adapter

定义 Convert the interface of a class into another interface clients expect. Adapter lets classes work together that couldn't otherwise because of incompatible interfaces

典型的实现有两处:

- org.springframework.web.servlet.HandlerAdapter – 因为控制器实现有各种各样,比如有

- 大家熟悉的 @RequestMapping 标注的控制器实现

- 传统的基于 Controller 接口(不是 @Controller注解啊)的实现

- 较新的基于 RouterFunction 接口的实现

- 它们的处理方法都不一样,为了统一调用,必须适配为 HandlerAdapter 接口

- org.springframework.beans.factory.support.DisposableBeanAdapter – 因为销毁方法多种多样,因此都要适配为 DisposableBean 来统一调用销毁方法

5. Spring 中的 Composite

定义 Compose objects into tree structures to represent part-whole hierarchies. Composite lets clients treat individual objects and compositions of objects uniformly

典型实现有:

- org.springframework.web.method.support.HandlerMethodArgumentResolverComposite

- org.springframework.web.method.support.HandlerMethodReturnValueHandlerComposite

- org.springframework.web.servlet.handler.HandlerExceptionResolverComposite

- org.springframework.web.servlet.view.ViewResolverComposite

composite 对象的作用是,将分散的调用集中起来,统一调用入口,它的特征是,与具体干活的实现实现同一个接口,当调用 composite 对象的接口方法时,其实是委托具体干活的实现来完成

6. Spring 中的 Decorator

定义 Attach additional responsibilities to an object dynamically. Decorators provide a flexible alternative to subclassing for extending functionality

典型实现:

- org.springframework.web.util.ContentCachingRequestWrapper

7. Spring 中的 Proxy

定义 Provide a surrogate or placeholder for another object to control access to it

装饰器模式注重的是功能增强,避免子类继承方式进行功能扩展,而代理模式更注重控制目标的访问

典型实现:

- org.springframework.aop.framework.JdkDynamicAopProxy

- org.springframework.aop.framework.ObjenesisCglibAopProxy

8. Spring 中的 Chain of Responsibility

定义 Avoid coupling the sender of a request to its receiver by giving more than one object a chance to handle the request. Chain the receiving objects and pass the request along the chain until an object handles it

典型实现:

- org.springframework.web.servlet.HandlerInterceptor

9. Spring 中的 Observer

定义 Define a one-to-many dependency between objects so that when one object changes state, all its dependents are notified and updated automatically

典型实现:

- org.springframework.context.ApplicationListener

- org.springframework.context.event.ApplicationEventMulticaster

- org.springframework.context.ApplicationEvent

10. Spring 中的 Strategy

定义 Define a family of algorithms, encapsulate each one, and make them interchangeable. Strategy lets the algorithm vary independently from clients that use it

典型实现:

- org.springframework.beans.factory.support.InstantiationStrategy

- org.springframework.core.annotation.MergedAnnotations.SearchStrategy

- org.springframework.boot.autoconfigure.condition.SearchStrategy

11. Spring 中的 Template Method

定义 Define the skeleton of an algorithm in an operation, deferring some steps to subclasses. Template Method lets subclasses redefine certain steps of an algorithm without changing the algorithm's structure

典型实现:

- 大部分以 Template 命名的类,如 JdbcTemplate,TransactionTemplate

- 很多以 Abstract 命名的类,如 AbstractApplicationContext

Spring基础

Spring IOC

Spring AoP

Spring MVC

Spring 框架的设计模式

Spring事物

MyBatis

比起这些枯燥的面试题,我更建议你看看文末推荐的 MyBatis 优质好文。

MySQL

基础篇

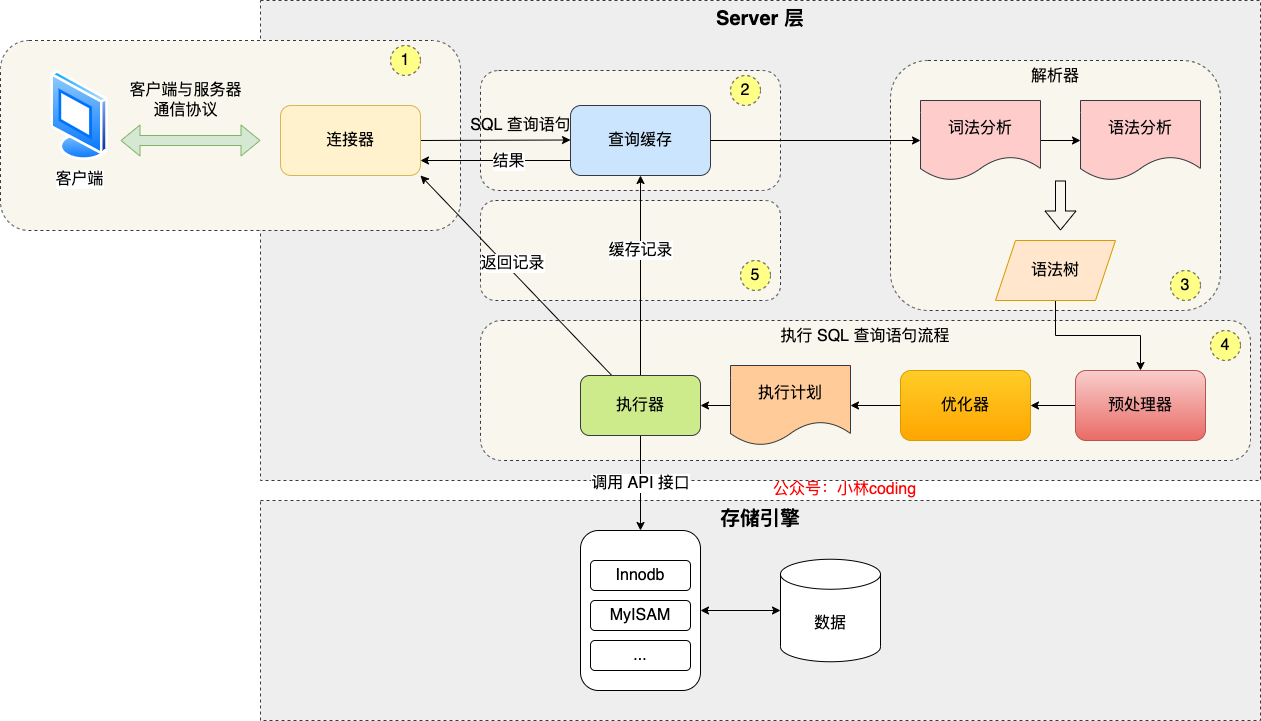

先来一个上帝视角图,下面就是 MySQL 执行一条 SQL 查询语句的流程,也从图中可以看到 MySQL 内部架构里的各个功能模块。

可以看到, MySQL 的架构共分为两层:Server 层和存储引擎层,

- Server 层负责建立连接、分析和执行 SQL。MySQL 大多数的核心功能模块都在这实现,主要包括连接器,查询缓存、解析器、预处理器、优化器、执行器等。另外,所有的内置函数(如日期、时间、数学和加密函数等)和所有跨存储引擎的功能(如存储过程、触发器、视图等。)都在 Server 层实现。

- 存储引擎层负责数据的存储和提取。支持 InnoDB、MyISAM、Memory 等多个存储引擎,不同的存储引擎共用一个 Server 层。现在最常用的存储引擎是 InnoDB,从 MySQL 5.5 版本开始, InnoDB 成为了 MySQL 的默认存储引擎。我们常说的索引数据结构,就是由存储引擎层实现的,不同的存储引擎支持的索引类型也不相同,比如 InnoDB 支持索引类型是 B+树 ,且是默认使用,也就是说在数据表中创建的主键索引和二级索引默认使用的是 B+ 树索引。

总结:

-

连接器:建立连接,管理连接、校验用户身份;

-

查询缓存:查询语句如果命中查询缓存则直接返回,否则继续往下执行。MySQL 8.0 已删除该模块;

-

解析 SQL,通过解析器对 SQL 查询语句进行词法分析、语法分析,然后构建语法树,方便后续模块读取表名、字段、语句类型;

-

执行 SQL:执行 SQL 共有三个阶段:

- 预处理阶段:检查表或字段是否存在;将

select *中的*符号扩展为表上的所有列。 - 优化阶段:基于查询成本的考虑, 选择查询成本最小的执行计划;

- 执行阶段:根据执行计划执行 SQL 查询语句,从存储引擎读取记录,返回给客户端;

- 预处理阶段:检查表或字段是否存在;将

⼀条SQL查询语句是如何执行的

select * from product where id = 1;

- 1连接器:建立连接,管理连接、校验用户身份;

如果你在 Linux 操作系统里要使用 MySQL,那你第一步肯定是要先连接 MySQL 服务,然后才能执行 SQL 语句,普遍我们都是使用下面这条命令进行连接:

# -h 指定 MySQL 服务得 IP 地址,如果是连接本地的 MySQL服务,可以不用这个参数;

# -u 指定用户名,管理员角色名为 root;

# -p 指定密码,如果命令行中不填写密码(为了密码安全,建议不要在命令行写密码),就需要在交互对话里面输入密码

mysql -h$ip -u$user -p

连接的过程需要先经过 TCP 三次握手,因为 MySQL 是基于 TCP 协议进行传输的,如果 MySQL 服务并没有启动,则会收到如下的报错:

如果 MySQL 服务正常运行,完成 TCP 连接的建立后,连接器就要开始验证你的用户名和密码,如果用户名或密码不对,就收到一个"Access denied for user"的错误,然后客户端程序结束执行。

如果用户密码都没有问题,连接器就会获取该用户的权限,然后保存起来,后续该用户在此连接里的任何操作,都会基于连接开始时读到的权限进行权限逻辑的判断。

所以,如果一个用户已经建立了连接,即使管理员中途修改了该用户的权限,也不会影响已经存在连接的权限。修改完成后,只有再新建的连接才会使用新的权限设置。

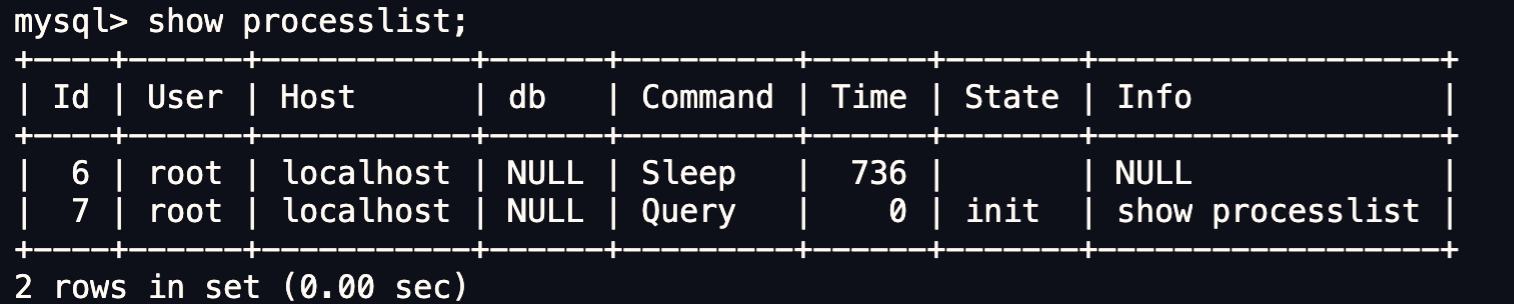

如何查看 MySQL 服务被多少个客户端连接了?

如果你想知道当前 MySQL 服务被多少个客户端连接了,你可以执行 show processlist 命令进行查看。

比如上图的显示结果,共有两个用户名为 root 的用户连接了 MySQL 服务,其中 id 为 6 的用户的 Command 列的状态为 Sleep ,这意味着该用户连接完 MySQL 服务就没有再执行过任何命令,也就是说这是一个空闲的连接,并且空闲的时长是 736 秒( Time 列)。

空闲连接会一直占用着吗?

当然不是了,MySQL 定义了空闲连接的最大空闲时长,由 wait_timeout 参数控制的,默认值是 8 小时(28880秒),如果空闲连接超过了这个时间,连接器就会自动将它断开。

mysql> show variables like 'wait_timeout';

+---------------+-------+

| Variable_name | Value |

+---------------+-------+

| wait_timeout | 28800 |

+---------------+-------+

1 row in set (0.00 sec)

当然,我们自己也可以手动断开空闲的连接,使用的是 kill connection + id 的命令。

mysql> kill connection +6;

Query OK, 0 rows affected (0.00 sec)

一个处于空闲状态的连接被服务端主动断开后,这个客户端并不会马上知道,等到客户端在发起下一个请求的时候,才会收到这样的报错“ERROR 2013 (HY000): Lost connection to MySQL server during query”。

MySQL 的连接数有限制吗?

MySQL 服务支持的最大连接数由 max_connections 参数控制,比如我的 MySQL 服务默认是 151 个,超过这个值,系统就会拒绝接下来的连接请求,并报错提示“Too many connections”。

mysql> show variables like 'max_connections';

+-----------------+-------+

| Variable_name | Value |

+-----------------+-------+

| max_connections | 151 |

+-----------------+-------+

1 row in set (0.00 sec)

MySQL 的连接也跟 HTTP 一样,有短连接和长连接的概念,它们的区别如下:

// 短连接

连接 mysql 服务(TCP 三次握手)

执行sql

断开 mysql 服务(TCP 四次挥手)

// 长连接

连接 mysql 服务(TCP 三次握手)

执行sql

执行sql

执行sql

....

断开 mysql 服务(TCP 四次挥手)

可以看到,使用长连接的好处就是可以减少建立连接和断开连接的过程,所以一般是推荐使用长连接。

但是,使用长连接后可能会占用内存增多,因为 MySQL 在执行查询过程中临时使用内存管理连接对象,这些连接对象资源只有在连接断开时才会释放。如果长连接累计很多,将导致 MySQL 服务占用内存太大,有可能会被系统强制杀掉,这样会发生 MySQL 服务异常重启的现象。

怎么解决长连接占用内存的问题?

有两种解决方式。

第一种,定期断开长连接。既然断开连接后就会释放连接占用的内存资源,那么我们可以定期断开长连接。

第二种,客户端主动重置连接。MySQL 5.7 版本实现了 mysql_reset_connection() 函数的接口,注意这是接口函数不是命令,那么当客户端执行了一个很大的操作后,在代码里调用 mysql_reset_connection 函数来重置连接,达到释放内存的效果。这个过程不需要重连和重新做权限验证,但是会将连接恢复到刚刚创建完时的状态。

至此,连接器的工作做完了,简单总结一下:

-

与客户端进行 TCP 三次握手建立连接;

-

校验客户端的用户名和密码,如果用户名或密码不对,则会报错;

-

如果用户名和密码都对了,会读取该用户的权限,然后后面的权限逻辑判断都基于此时读取到的权限;

-

2查询缓存:查询语句如果命中查询缓存则直接返回,否则继续往下执行。MySQL 8.0 已删除该模块;

连接器得工作完成后,客户端就可以向 MySQL 服务发送 SQL 语句了,MySQL 服务收到 SQL 语句后,就会解析出 SQL 语句的第一个字段,看看是什么类型的语句。

如果 SQL 是查询语句(select 语句),MySQL 就会先去查询缓存( Query Cache )里查找缓存数据,看看之前有没有执行过这一条命令,这个查询缓存是以 key-value 形式保存在内存中的,key 为 SQL 查询语句,value 为 SQL 语句查询的结果。

如果查询的语句命中查询缓存,那么就会直接返回 value 给客户端。如果查询的语句没有命中查询缓存中,那么就要往下继续执行,等执行完后,查询的结果就会被存入查询缓存中。

这么看,查询缓存还挺有用,但是其实查询缓存挺鸡肋的。

对于更新比较频繁的表,查询缓存的命中率很低的,因为只要一个表有更新操作,那么这个表的查询缓存就会被清空。如果刚缓存了一个查询结果很大的数据,还没被使用的时候,刚好这个表有更新操作,查询缓冲就被清空了,相当于缓存了个寂寞。

所以,MySQL 8.0 版本直接将查询缓存删掉了,也就是说 MySQL 8.0 开始,执行一条 SQL 查询语句,不会再走到查询缓存这个阶段了。

对于 MySQL 8.0 之前的版本,如果想关闭查询缓存,我们可以通过将参数 query_cache_type 设置成 DEMAND。

TIP

这里说的查询缓存是 server 层的,也就是 MySQL 8.0 版本移除的是 server 层的查询缓存,并不是 Innodb 存储引擎中的 buffer pool。

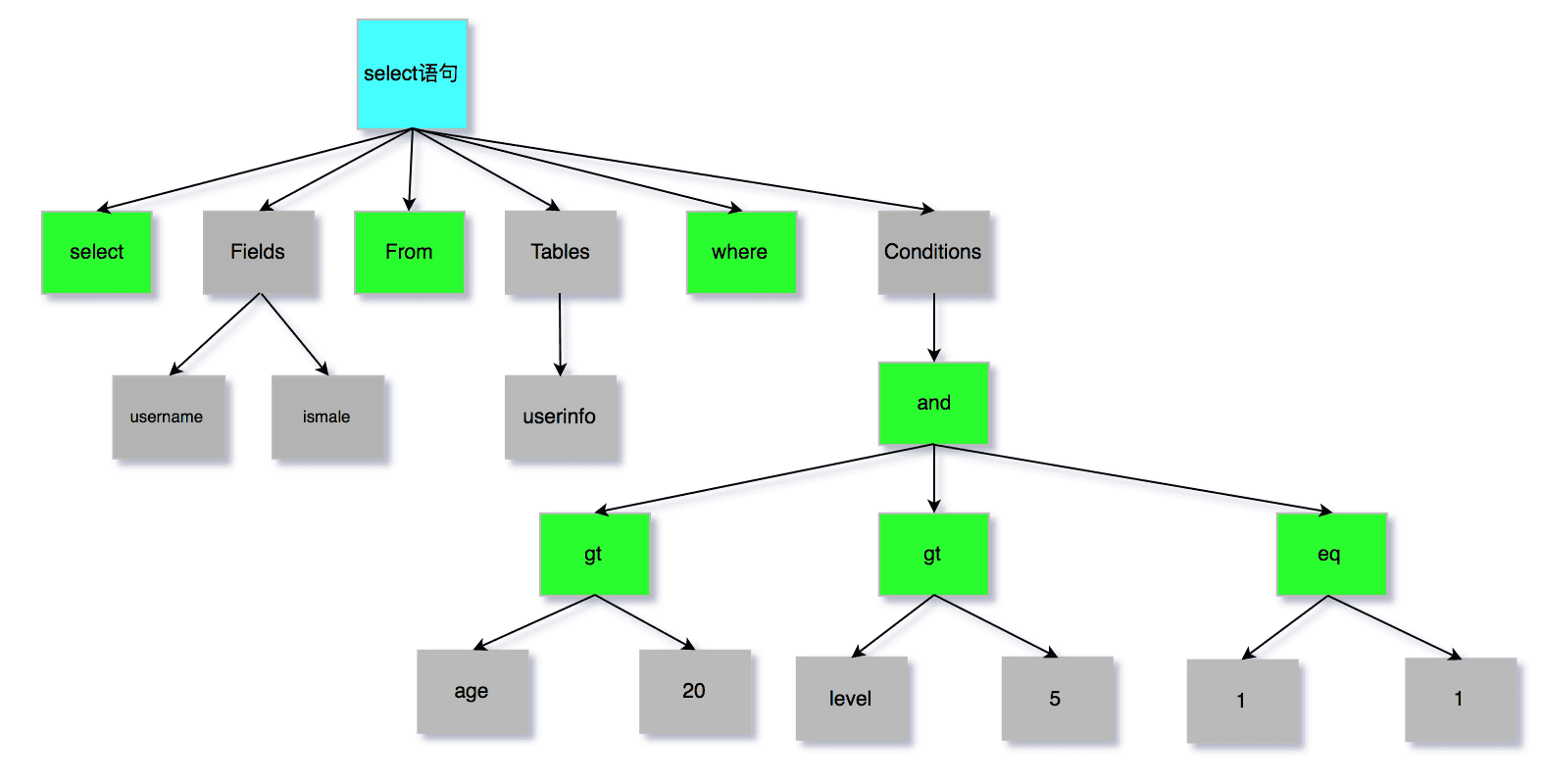

- 3解析 SQL,通过解析器对 SQL 查询语句进行词法分析、语法分析,然后构建语法树,方便后续模块读取表名、字段、语句类型;

解析器

解析器会做如下两件事情。

第一件事情,词法分析。MySQL 会根据你输入的字符串识别出关键字出来,例如,SQL语句 select username from userinfo,在分析之后,会得到4个Token,其中有2个Keyword,分别为select和from:

| 关键字 | 非关键字 | 关键字 | 非关键字 |

|---|---|---|---|

| select | username | from | userinfo |

第二件事情,语法分析。根据词法分析的结果,语法解析器会根据语法规则,判断你输入的这个 SQL 语句是否满足 MySQL 语法,如果没问题就会构建出 SQL 语法树,这样方便后面模块获取 SQL 类型、表名、字段名、 where 条件等等。

如果我们输入的 SQL 语句语法不对,就会在解析器这个阶段报错。比如,我下面这条查询语句,把 from 写成了 form,这时 MySQL 解析器就会给报错。

但是注意,表不存在或者字段不存在,并不是在解析器里做的,《MySQL 45 讲》说是在解析器做的,但是经过我和朋友看 MySQL 源码(5.7和8.0)得出结论是解析器只负责检查语法和构建语法树,但是不会去查表或者字段存不存在。

那到底谁来做检测表和字段是否存在的工作呢?别急,接下来就是了。

-

4执行 SQL:执行 SQL 共有三个阶段:

- 预处理阶段:检查表或字段是否存在;将

select *中的*符号扩展为表上的所有列。

我们先来说说预处理阶段做了什么事情。

- 检查 SQL 查询语句中的表或者字段是否存在;

- 将

select *中的*符号,扩展为表上的所有列;

我下面这条查询语句,test 这张表是不存在的,这时 MySQL 就会在执行 SQL 查询语句的 prepare 阶段中报错。

mysql> select * from test; ERROR 1146 (42S02): Table 'mysql.test' doesn't exist- 优化阶段:基于查询成本的考虑, 选择查询成本最小的执行计划;

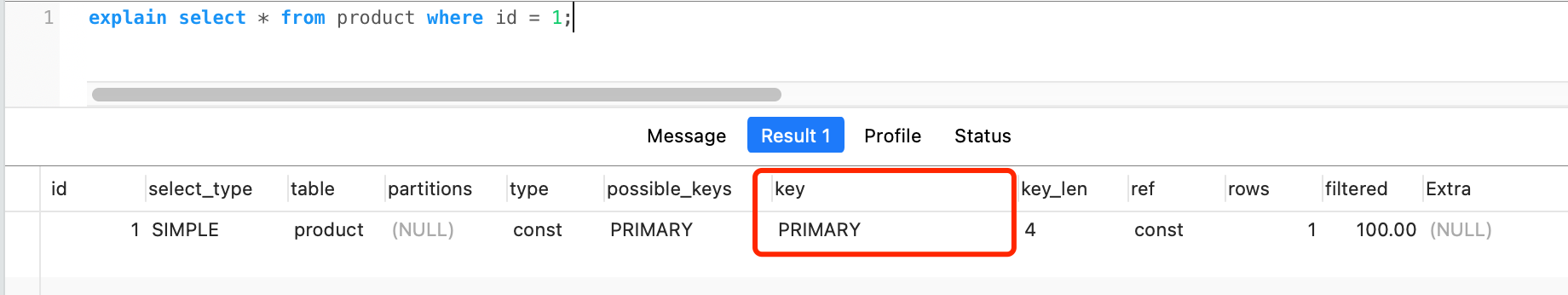

经过预处理阶段后,还需要为 SQL 查询语句先制定一个执行计划,这个工作交由「优化器」来完成的。

优化器主要负责将 SQL 查询语句的执行方案确定下来,比如在表里面有多个索引的时候,优化器会基于查询成本的考虑,来决定选择使用哪个索引。

当然,我们本次的查询语句(select * from product where id = 1)很简单,就是选择使用主键索引。

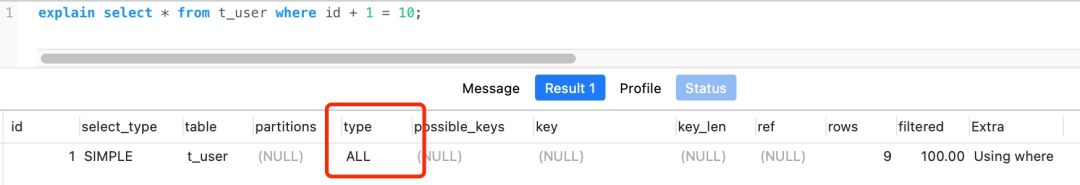

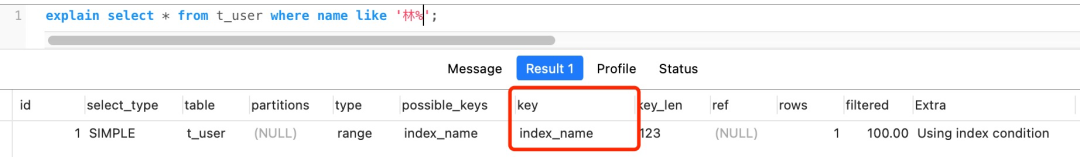

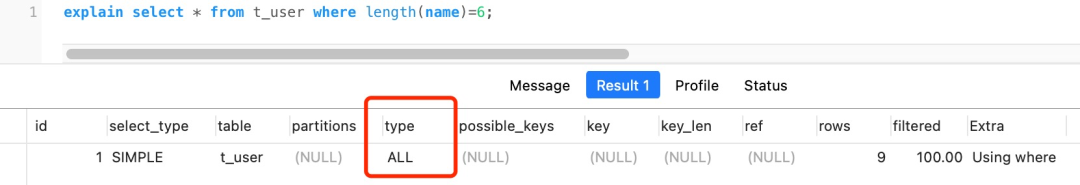

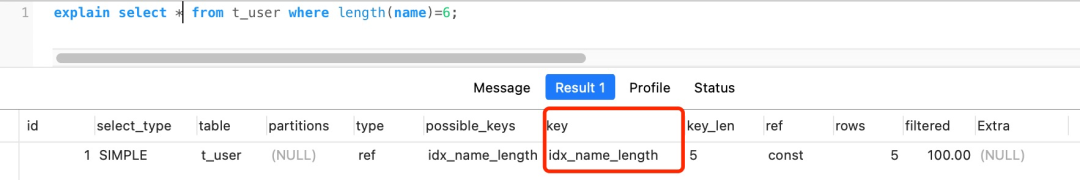

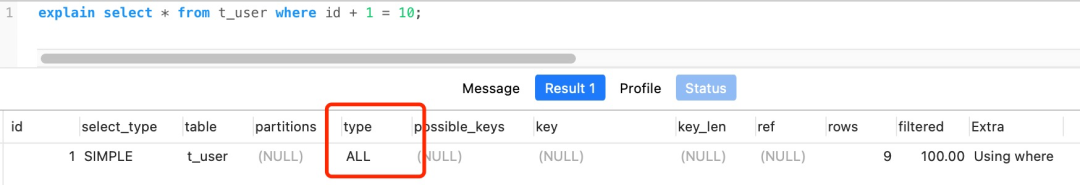

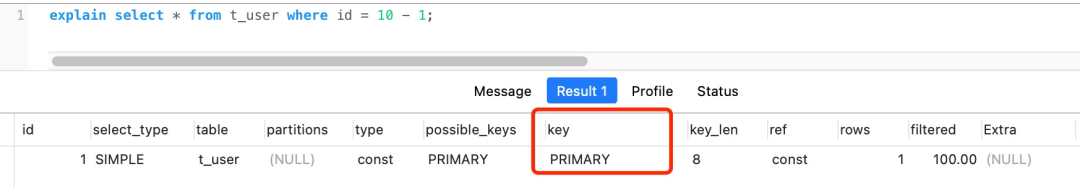

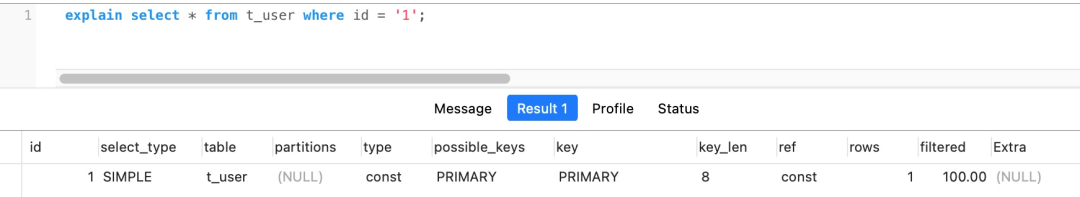

要想知道优化器选择了哪个索引,我们可以在查询语句最前面加个

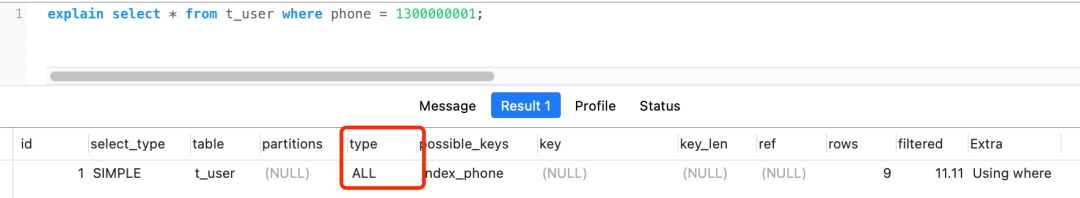

explain命令,这样就会输出这条 SQL 语句的执行计划,然后执行计划中的 key 就表示执行过程中使用了哪个索引,比如下图的 key 为PRIMARY就是使用了主键索引。

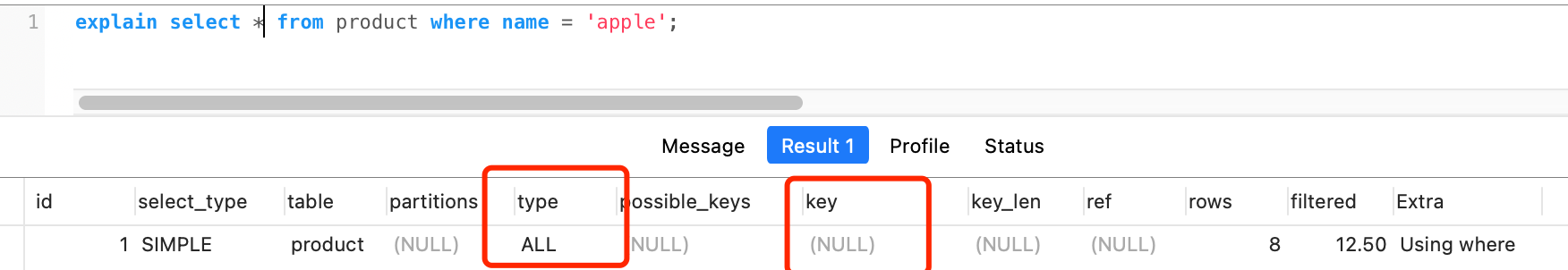

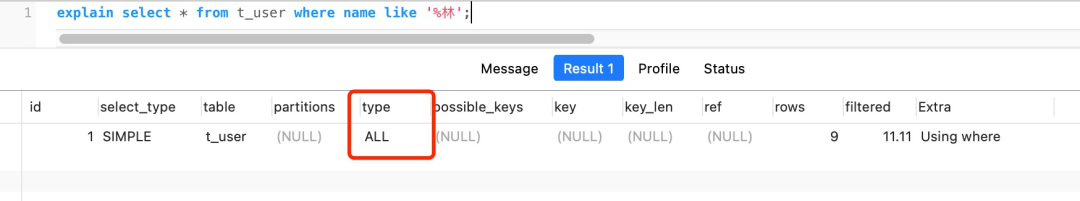

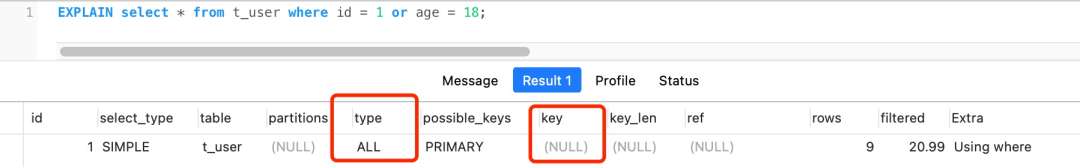

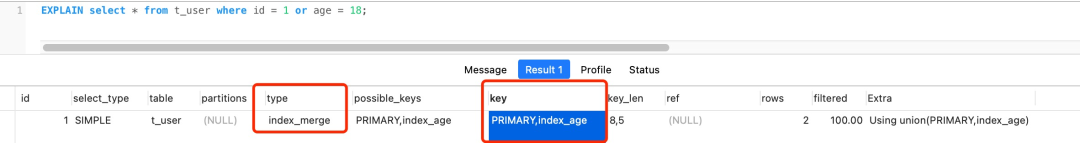

如果查询语句的执行计划里的 key 为 null 说明没有使用索引,那就会全表扫描(type = ALL),这种查询扫描的方式是效率最低档次的,如下图:

这张 product 表只有一个索引就是主键,现在我在表中将 name 设置为普通索引(二级索引)。

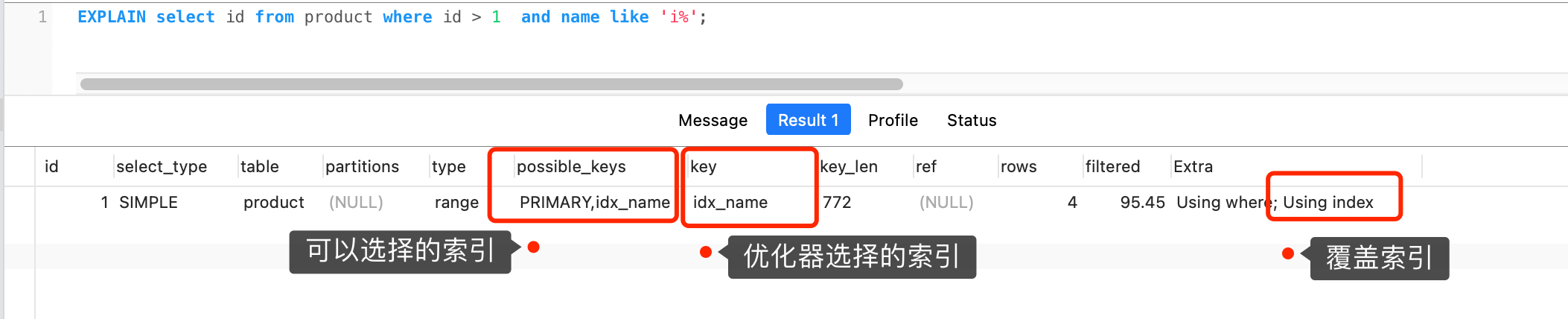

这时 product 表就有主键索引(id)和普通索引(name)。假设执行了这条查询语句:

select id from product where id > 1 and name like 'i%';这条查询语句的结果既可以使用主键索引,也可以使用普通索引,但是执行的效率会不同。这时,就需要优化器来决定使用哪个索引了。

很显然这条查询语句是覆盖索引,直接在二级索引就能查找到结果(因为二级索引的 B+ 树的叶子节点的数据存储的是主键值),就没必要在主键索引查找了,因为查询主键索引的 B+ 树的成本会比查询二级索引的 B+ 的成本大,优化器基于查询成本的考虑,会选择查询代价小的普通索引。

在下图中执行计划,我们可以看到,执行过程中使用了普通索引(name),Exta 为 Using index,这就是表明使用了覆盖索引优化。

- 执行阶段:根据执行计划执行 SQL 查询语句,从存储引擎读取记录,返回给客户端;

- 预处理阶段:检查表或字段是否存在;将

经历完优化器后,就确定了执行方案,接下来 MySQL 就真正开始执行语句了,这个工作是由「执行器」完成的。在执行的过程中,执行器就会和存储引擎交互了,交互是以记录为单位的。

接下来,用三种方式执行过程,跟大家说一下执行器和存储引擎的交互过程(PS :为了写好这一部分,特地去看 MySQL 源码,也是第一次看哈哈)。

- 主键索引查询

- 全表扫描

- 索引下推

主键索引查询

以本文开头查询语句为例,看看执行器是怎么工作的。

select * from product where id = 1;

这条查询语句的查询条件用到了主键索引,而且是等值查询,同时主键 id 是唯一,不会有 id 相同的记录,所以优化器决定选用访问类型为 const 进行查询,也就是使用主键索引查询一条记录,那么执行器与存储引擎的执行流程是这样的:

- 执行器第一次查询,会调用 read_first_record 函数指针指向的函数,因为优化器选择的访问类型为 const,这个函数指针被指向为 InnoDB 引擎索引查询的接口,把条件

id = 1交给存储引擎,让存储引擎定位符合条件的第一条记录。 - 存储引擎通过主键索引的 B+ 树结构定位到 id = 1的第一条记录,如果记录是不存在的,就会向执行器上报记录找不到的错误,然后查询结束。如果记录是存在的,就会将记录返回给执行器;

- 执行器从存储引擎读到记录后,接着判断记录是否符合查询条件,如果符合则发送给客户端,如果不符合则跳过该记录。

- 执行器查询的过程是一个 while 循环,所以还会再查一次,但是这次因为不是第一次查询了,所以会调用 read_record 函数指针指向的函数,因为优化器选择的访问类型为 const,这个函数指针被指向为一个永远返回 - 1 的函数,所以当调用该函数的时候,执行器就退出循环,也就是结束查询了。

至此,这个语句就执行完成了。

全表扫描

举个全表扫描的例子:

select * from product where name = 'iphone';

这条查询语句的查询条件没有用到索引,所以优化器决定选用访问类型为 ALL 进行查询,也就是全表扫描的方式查询,那么这时执行器与存储引擎的执行流程是这样的:

- 执行器第一次查询,会调用 read_first_record 函数指针指向的函数,因为优化器选择的访问类型为 all,这个函数指针被指向为 InnoDB 引擎全扫描的接口,让存储引擎读取表中的第一条记录;

- 执行器会判断读到的这条记录的 name 是不是 iphone,如果不是则跳过;如果是则将记录发给客户的(是的没错,Server 层每从存储引擎读到一条记录就会发送给客户端,之所以客户端显示的时候是直接显示所有记录的,是因为客户端是等查询语句查询完成后,才会显示出所有的记录)。

- 执行器查询的过程是一个 while 循环,所以还会再查一次,会调用 read_record 函数指针指向的函数,因为优化器选择的访问类型为 all,read_record 函数指针指向的还是 InnoDB 引擎全扫描的接口,所以接着向存储引擎层要求继续读刚才那条记录的下一条记录,存储引擎把下一条记录取出后就将其返回给执行器(Server层),执行器继续判断条件,不符合查询条件即跳过该记录,否则发送到客户端;

- 一直重复上述过程,直到存储引擎把表中的所有记录读完,然后向执行器(Server层) 返回了读取完毕的信息;

- 执行器收到存储引擎报告的查询完毕的信息,退出循环,停止查询。

至此,这个语句就执行完成了。

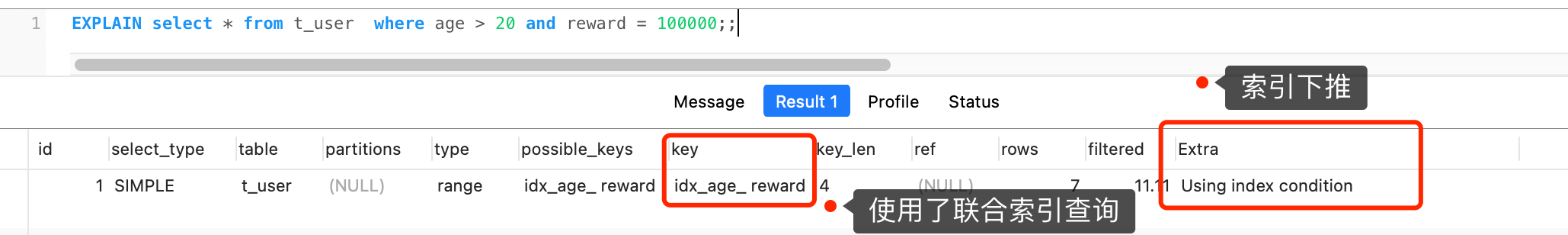

索引下推

在这部分非常适合讲索引下推(MySQL 5.6 推出的查询优化策略),这样大家能清楚的知道,「下推」这个动作,下推到了哪里。

索引下推能够减少二级索引在查询时的回表操作,提高查询的效率,因为它将 Server 层部分负责的事情,交给存储引擎层去处理了。

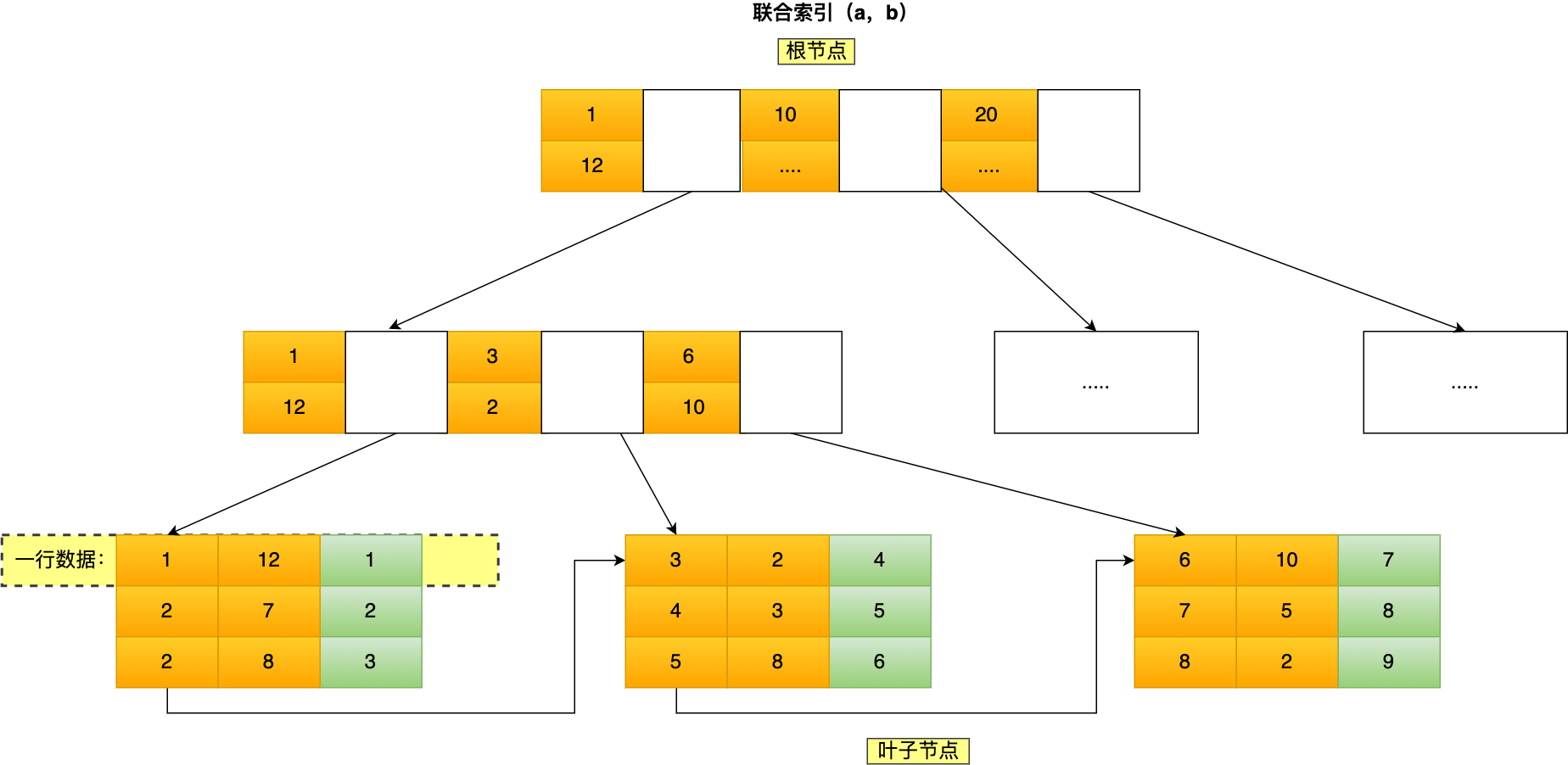

举一个具体的例子,方便大家理解,这里一张用户表如下,我对 age 和 reward 字段建立了联合索引(age,reward):

现在有下面这条查询语句:

select * from t_user where age > 20 and reward = 100000;

联合索引当遇到范围查询 (>、<) 就会停止匹配,也就是 age 字段能用到联合索引,但是 reward 字段则无法利用到索引。

那么,不使用索引下推(MySQL 5.6 之前的版本)时,执行器与存储引擎的执行流程是这样的:

- Server 层首先调用存储引擎的接口定位到满足查询条件的第一条二级索引记录,也就是定位到 age > 20 的第一条记录;

- 存储引擎根据二级索引的 B+ 树快速定位到这条记录后,获取主键值,然后进行回表操作,将完整的记录返回给 Server 层;

- Server 层在判断该记录的 reward 是否等于 100000,如果成立则将其发送给客户端;否则跳过该记录;

- 接着,继续向存储引擎索要下一条记录,存储引擎在二级索引定位到记录后,获取主键值,然后回表操作,将完整的记录返回给 Server 层;

- 如此往复,直到存储引擎把表中的所有记录读完。

可以看到,没有索引下推的时候,每查询到一条二级索引记录,都要进行回表操作,然后将记录返回给 Server,接着 Server 再判断该记录的 reward 是否等于 100000。

而使用索引下推后,判断记录的 reward 是否等于 100000 的工作交给了存储引擎层,过程如下 :

- Server 层首先调用存储引擎的接口定位到满足查询条件的第一条二级索引记录,也就是定位到 age > 20 的第一条记录;

- 存储引擎定位到二级索引后,先不执行回表操作,而是先判断一下该索引中包含的列(reward列)的条件(reward 是否等于 100000)是否成立。如果条件不成立,则直接跳过该二级索引。如果成立,则执行回表操作,将完成记录返回给 Server 层。

- Server 层在判断其他的查询条件(本次查询没有其他条件)是否成立,如果成立则将其发送给客户端;否则跳过该记录,然后向存储引擎索要下一条记录。

- 如此往复,直到存储引擎把表中的所有记录读完。

可以看到,使用了索引下推后,虽然 reward 列无法使用到联合索引,但是因为它包含在联合索引(age,reward)里,所以直接在存储引擎过滤出满足 reward = 100000 的记录后,才去执行回表操作获取整个记录。相比于没有使用索引下推,节省了很多回表操作。

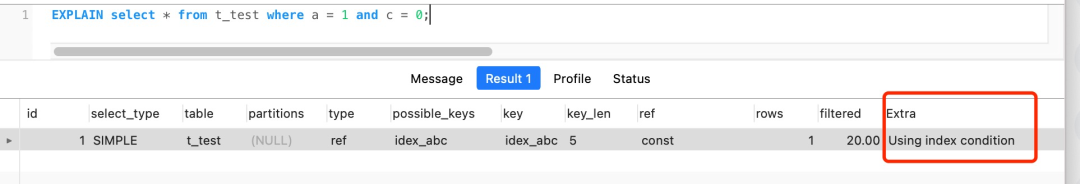

当你发现执行计划里的 Extr 部分显示了 “Using index condition”,说明使用了索引下推。

MySQL 一行记录是怎么存储的?

- MySQL 的 NULL 值会占用空间吗?

- MySQL 怎么知道 varchar(n) 实际占用数据的大小?

- varchar(n) 中 n 最大取值为多少?

- 行溢出后,MySQL 是怎么处理的?

MySQL 的数据存放在哪个文件?

InnoDB 是我们常用的存储引擎,也是 MySQL 默认的存储引擎。所以,本文主要以 InnoDB 存储引擎展开讨论。

先来看看 MySQL 数据库的文件存放在哪个目录?

mysql> SHOW VARIABLES LIKE 'datadir';

+---------------+-----------------+

| Variable_name | Value |

+---------------+-----------------+

| datadir | /var/lib/mysql/ |

+---------------+-----------------+

1 row in set (0.00 sec)

我们每创建一个 database(数据库) 都会在 /var/lib/mysql/ 目录里面创建一个以 database 为名的目录,然后保存表结构和表数据的文件都会存放在这个目录里。

比如,我这里有一个名为 my_test 的 database,该 database 里有一张名为 t_order 数据库表。

然后,我们进入 /var/lib/mysql/my_test 目录,看看里面有什么文件?

[root@xiaolin ~]#ls /var/lib/mysql/my_test

db.opt

t_order.frm

t_order.ibd

可以看到,共有三个文件,这三个文件分别代表着:

- db.opt,用来存储当前数据库的默认字符集和字符校验规则。

- t_order.frm ,t_order 的表结构会保存在这个文件。在 MySQL 中建立一张表都会生成一个.frm 文件,该文件是用来保存每个表的元数据信息的,主要包含表结构定义。

- t_order.ibd,t_order 的表数据会保存在这个文件。表数据既可以存在共享表空间文件(文件名:ibdata1)里,也可以存放在独占表空间文件(文件名:表名字.ibd)。这个行为是由参数 innodb_file_per_table 控制的,若设置了参数 innodb_file_per_table 为 1,则会将存储的数据、索引等信息单独存储在一个独占表空间,从 MySQL 5.6.6 版本开始,它的默认值就是 1 了,因此从这个版本之后, MySQL 中每一张表的数据都存放在一个独立的 .ibd 文件。

一张数据库表的数据是保存在「 表名字.ibd 」的文件里的,这个文件也称为独占表空间文件。

表空间文件的结构是怎么样的?

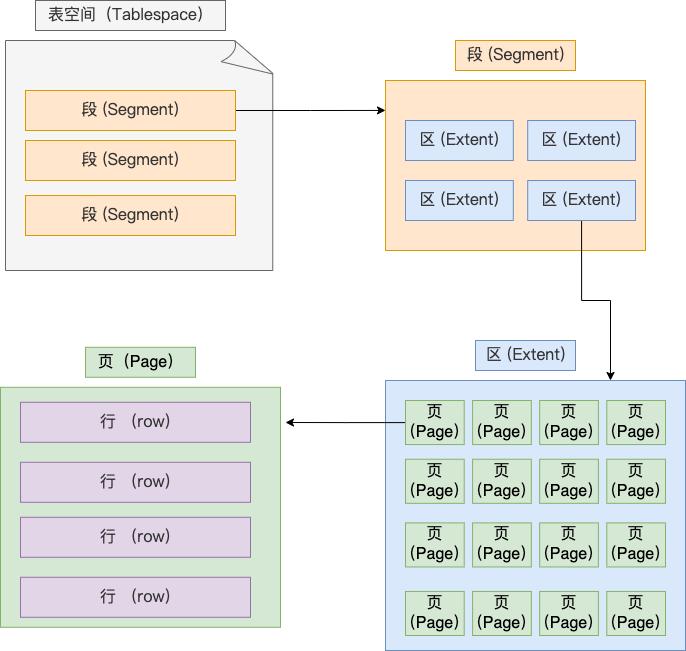

表空间由段(segment)、区(extent)、页(page)、行(row)组成,InnoDB存储引擎的逻辑存储结构大致如下图:

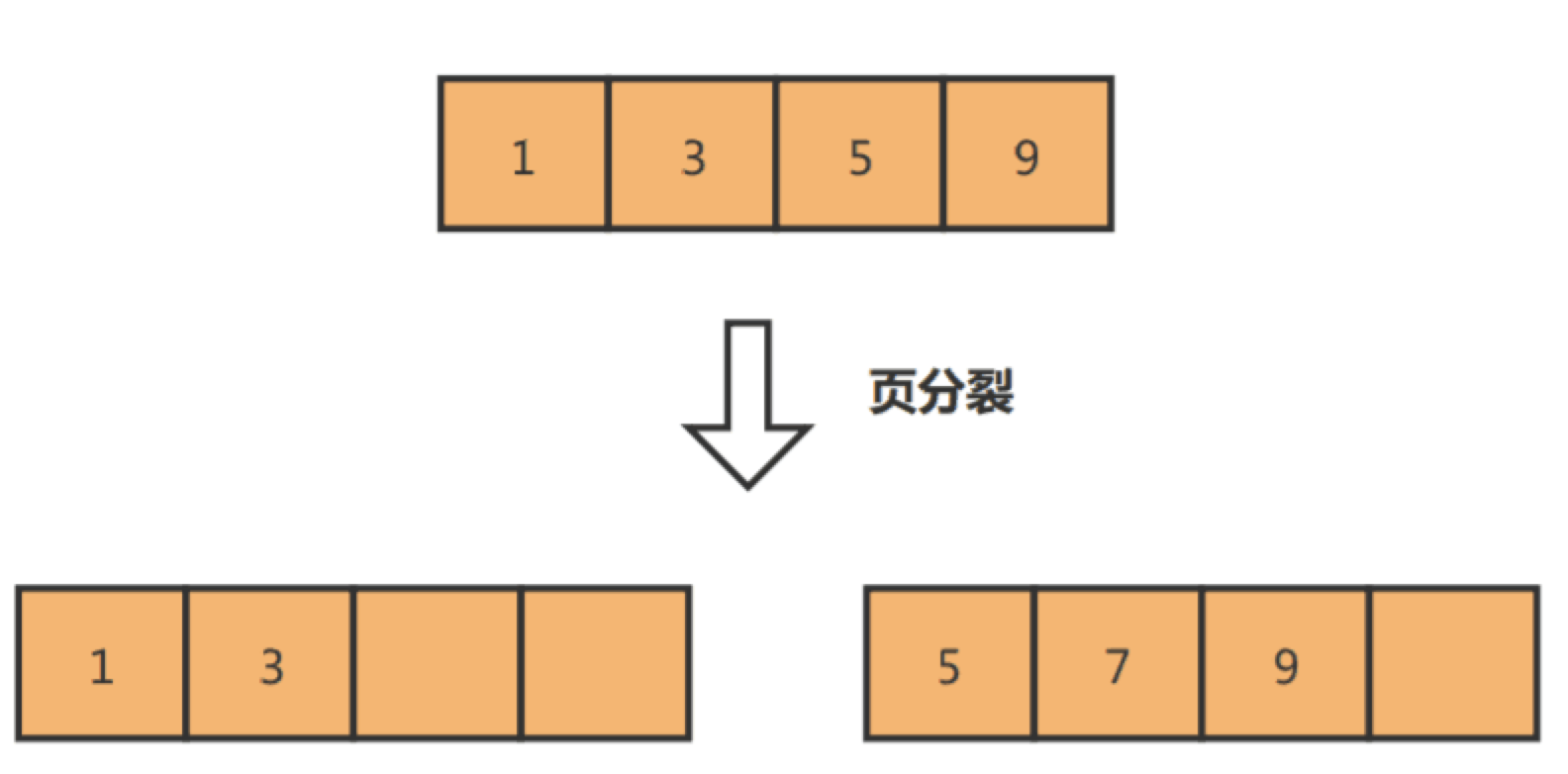

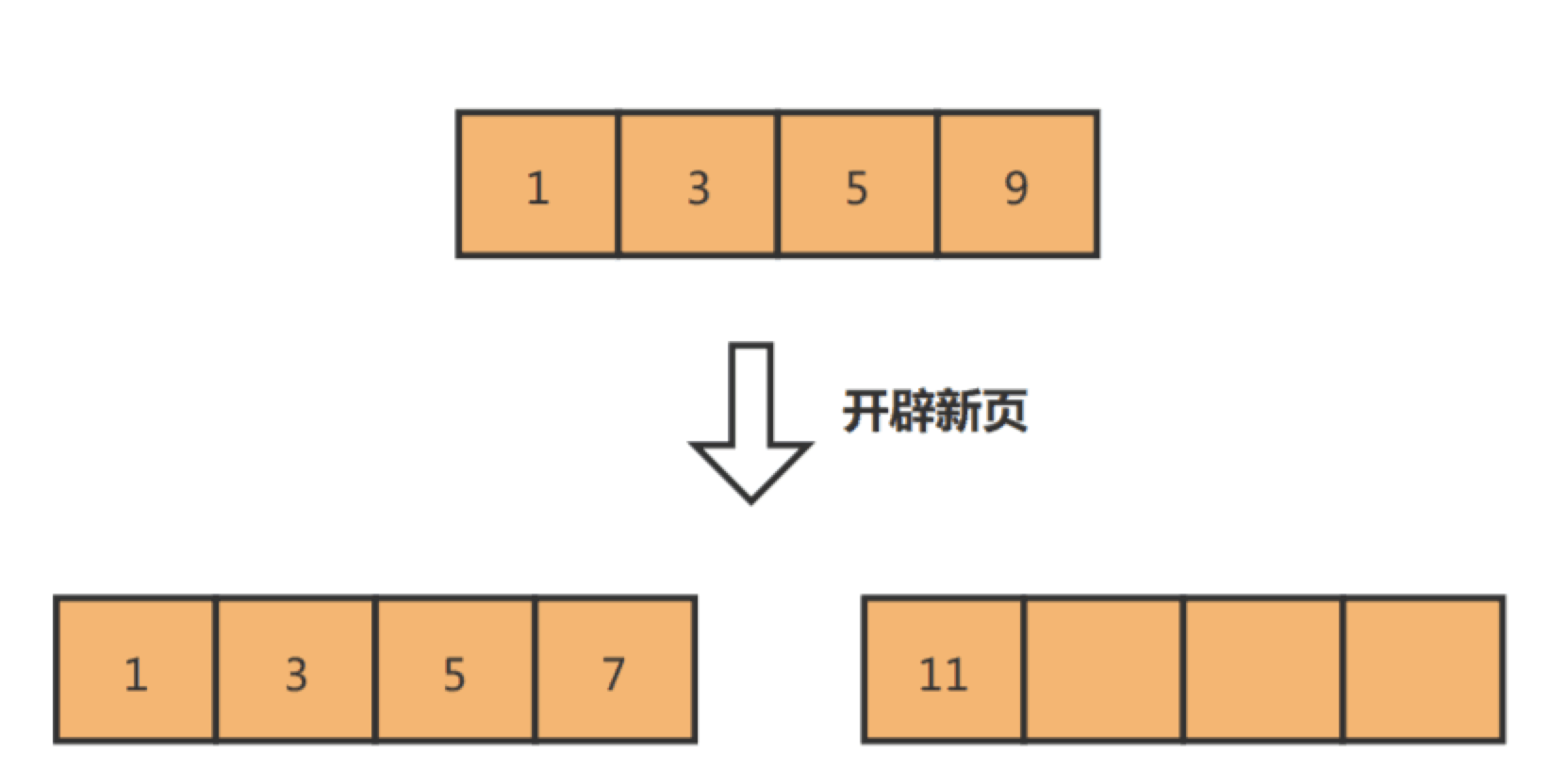

1、行(row)

**数据库表中的记录都是按行(row)进行存放的**,每行记录根据不同的行格式,有不同的存储结构。

后面我们详细介绍 InnoDB 存储引擎的行格式,也是本文重点介绍的内容。

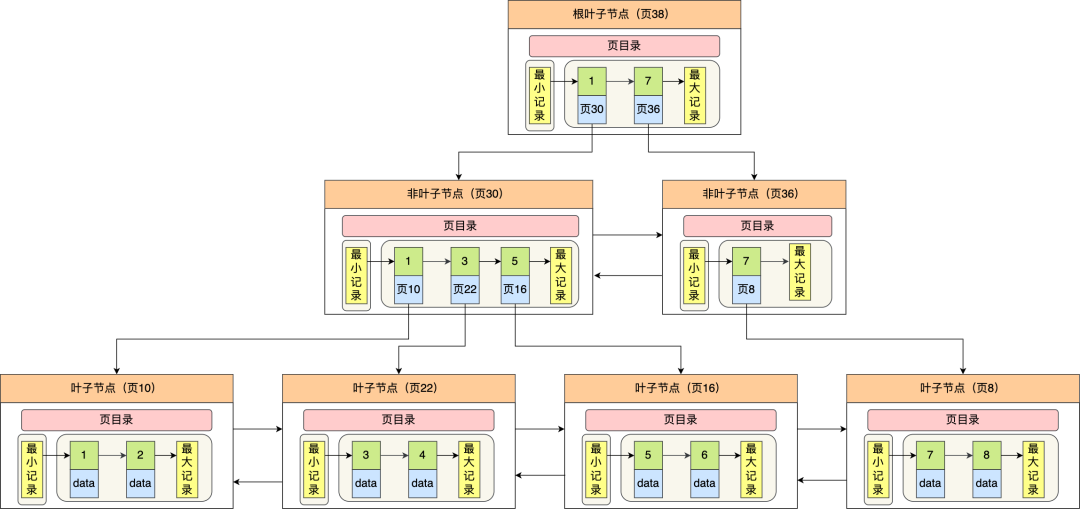

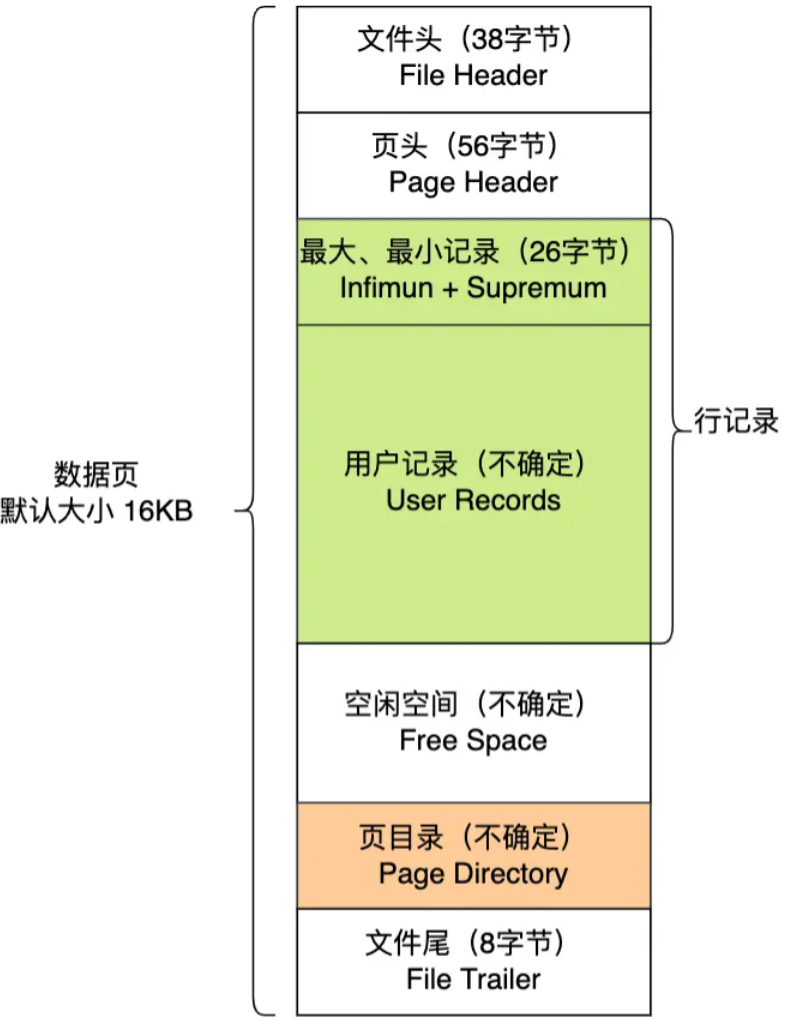

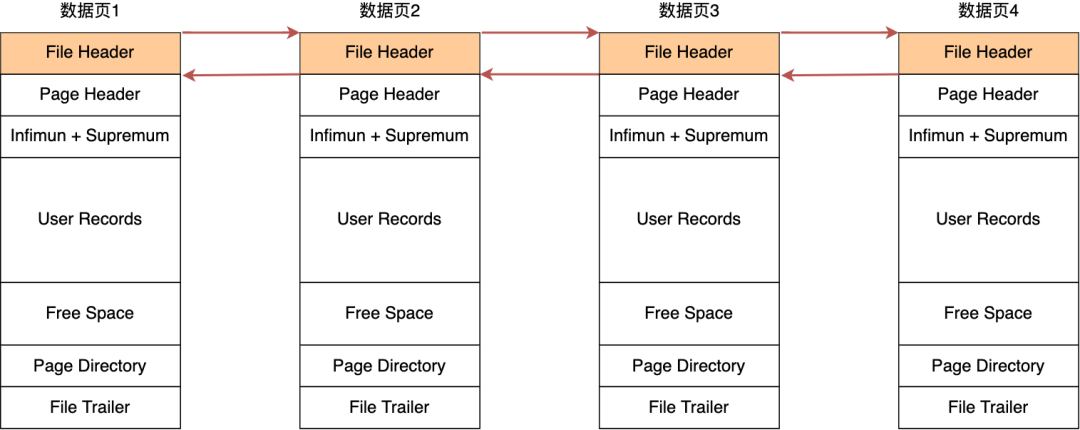

2、页(page)

记录是按照行来存储的,但是数据库的读取并不以「行」为单位,否则一次读取(也就是一次 I/O 操作)只能处理一行数据,效率会非常低。

因此,InnoDB 的数据是按「页」为单位来读写的,也就是说,当需要读一条记录的时候,并不是将这个行记录从磁盘读出来,而是以页为单位,将其整体读入内存。

默认每个页的大小为 16KB,也就是最多能保证 16KB 的连续存储空间。

页是 InnoDB 存储引擎磁盘管理的最小单元,意味着数据库每次读写都是以 16KB 为单位的,一次最少从磁盘中读取 16K 的内容到内存中,一次最少把内存中的 16K 内容刷新到磁盘中。

页的类型有很多,常见的有数据页、undo 日志页、溢出页等等。数据表中的行记录是用「数据页」来管理的。

总之知道表中的记录存储在「数据页」里面就行。

3、区(extent)

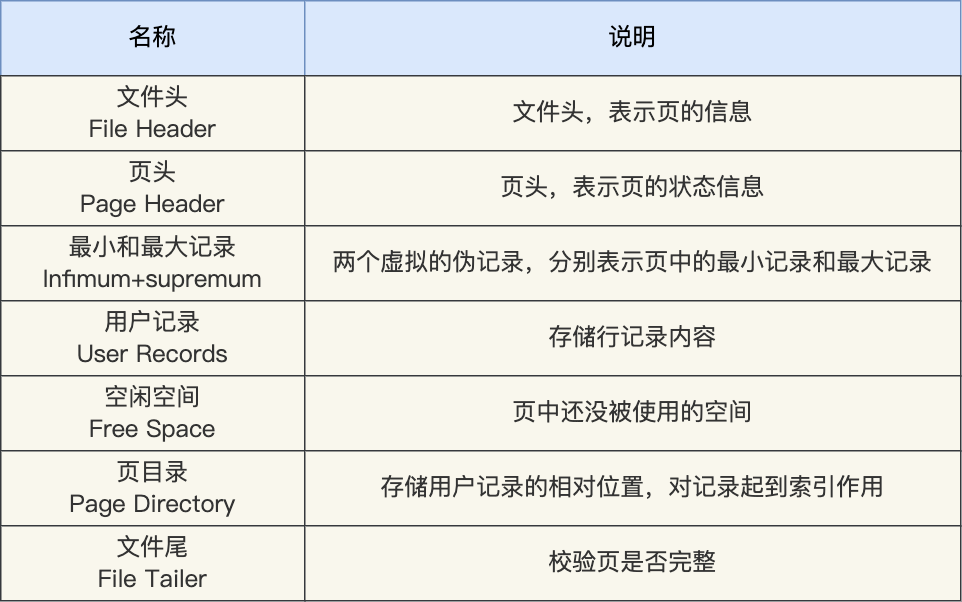

我们知道 InnoDB 存储引擎是用 B+ 树来组织数据的。

B+ 树中每一层都是通过双向链表连接起来的,如果是以页为单位来分配存储空间,那么链表中相邻的两个页之间的物理位置并不是连续的,可能离得非常远,那么磁盘查询时就会有大量的随机I/O,随机 I/O 是非常慢的。

解决这个问题也很简单,就是让链表中相邻的页的物理位置也相邻,这样就可以使用顺序 I/O 了,那么在范围查询(扫描叶子节点)的时候性能就会很高。

那具体怎么解决呢?

在表中数据量大的时候,为某个索引分配空间的时候就不再按照页为单位分配了,而是按照区(extent)为单位分配。每个区的大小为 1MB,对于 16KB 的页来说,连续的 64 个页会被划为一个区,这样就使得链表中相邻的页的物理位置也相邻,就能使用顺序 I/O 了。

4、段(segment)

表空间是由各个段(segment)组成的,段是由多个区(extent)组成的。段一般分为数据段、索引段和回滚段等。

- 索引段:存放 B + 树的非叶子节点的区的集合;

- 数据段:存放 B + 树的叶子节点的区的集合;

- 回滚段:存放的是回滚数据的区的集合,之前讲的时候就介绍到了 MVCC 利用了回滚段实现了多版本查询数据。

InnoDB 行格式有哪些

行格式(row_format),就是一条记录的存储结构。

InnoDB 提供了 4 种行格式,分别是 Redundant、Compact、Dynamic和 Compressed 行格式。

- Redundant 是很古老的行格式了, MySQL 5.0 版本之前用的行格式,现在基本没人用了。

- 由于 Redundant 不是一种紧凑的行格式,所以 MySQL 5.0 之后引入了 Compact 行记录存储方式,Compact 是一种紧凑的行格式,设计的初衷就是为了让一个数据页中可以存放更多的行记录,从 MySQL 5.1 版本之后,行格式默认设置成 Compact。

- Dynamic 和 Compressed 两个都是紧凑的行格式,它们的行格式都和 Compact 差不多,因为都是基于 Compact 改进一点东西。从 MySQL5.7 版本之后,默认使用 Dynamic 行格式。

Redundant 行格式我这里就不讲了,因为现在基本没人用了,这次重点介绍 Compact 行格式,因为 Dynamic 和 Compressed 这两个行格式跟 Compact 非常像。

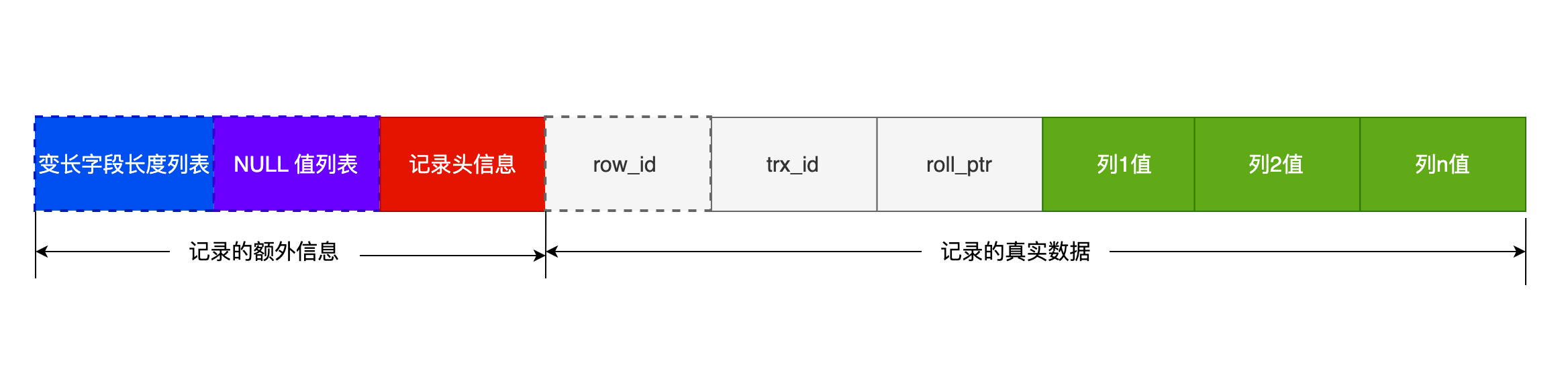

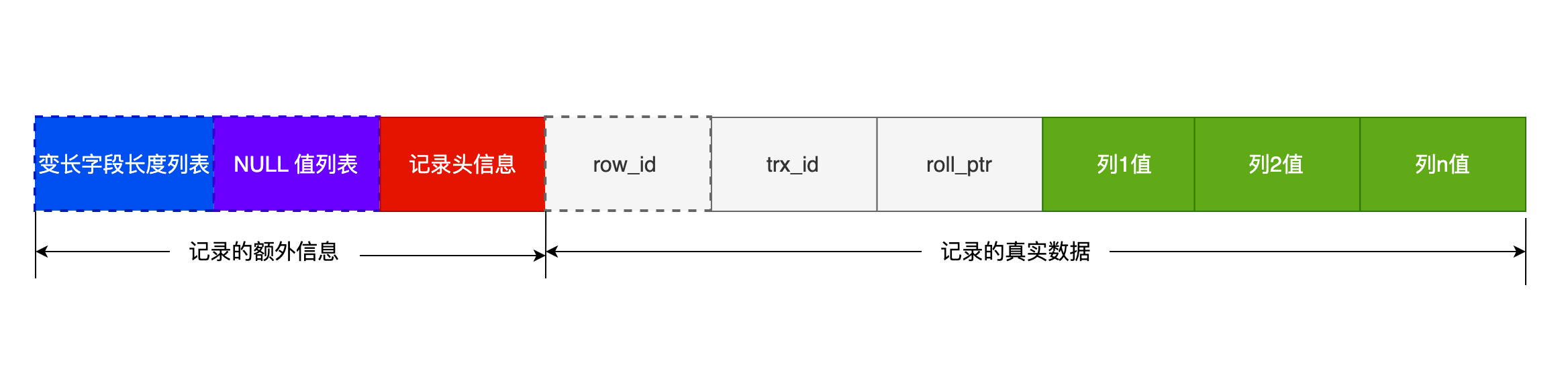

COMPACT 行格式长什么样?

可以看到,一条完整的记录分为「记录的额外信息」和「记录的真实数据」两个部分。

记录的额外信息

记录的额外信息包含 3 个部分:变长字段长度列表、NULL 值列表、记录头信息。

- 变长字段长度列表

varchar(n) 和 char(n) 的区别是什么,相信大家都非常清楚,char 是定长的,varchar 是变长的,变长字段实际存储的数据的长度(大小)不固定的。

所以,在存储数据的时候,也要把数据占用的大小存起来,存到「变长字段长度列表」里面,读取数据的时候才能根据这个「变长字段长度列表」去读取对应长度的数据。其他 TEXT、BLOB 等变长字段也是这么实现的。

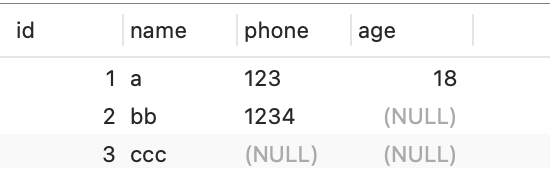

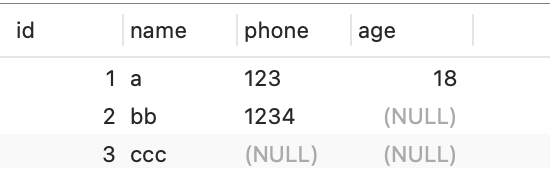

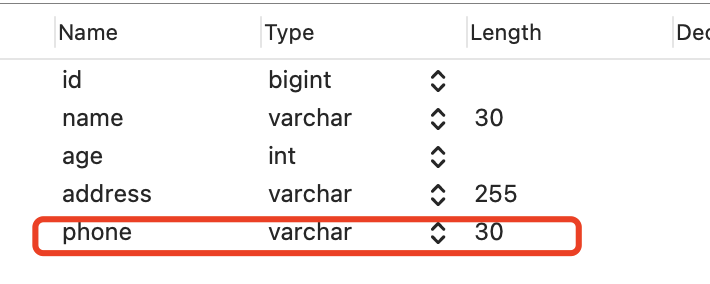

为了展示「变长字段长度列表」具体是怎么保存「变长字段的真实数据占用的字节数」,我们先创建这样一张表,字符集是 ascii(所以每一个字符占用的 1 字节),行格式是 Compact,t_user 表中 name 和 phone 字段都是变长字段:

CREATE TABLE `t_user` (

`id` int(11) NOT NULL,

`name` VARCHAR(20) DEFAULT NULL,

`phone` VARCHAR(20) DEFAULT NULL,

`age` int(11) DEFAULT NULL,

PRIMARY KEY (`id`) USING BTREE

) ENGINE = InnoDB DEFAULT CHARACTER SET = ascii ROW_FORMAT = COMPACT;

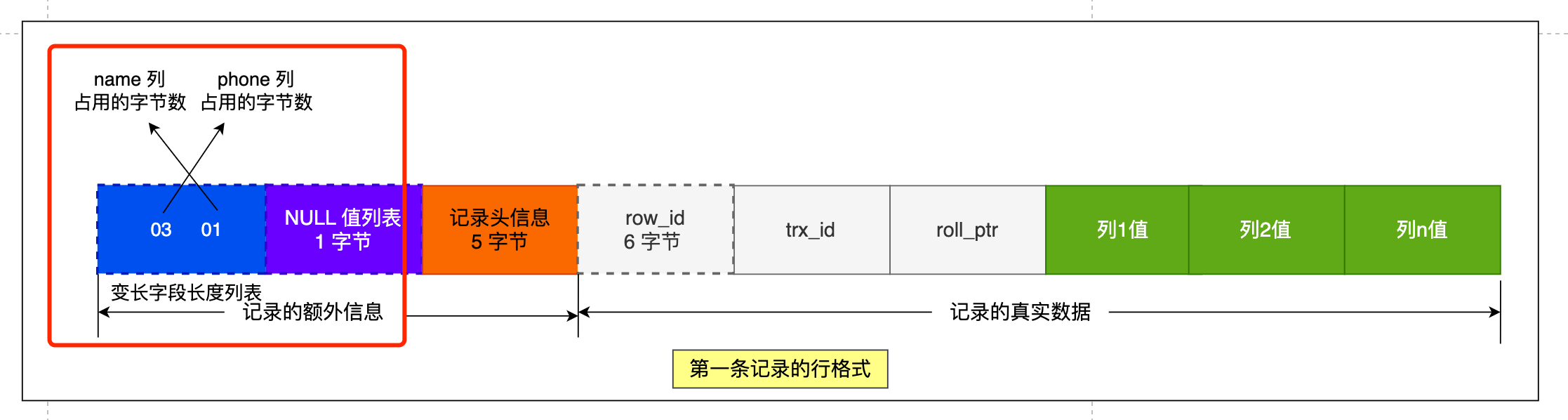

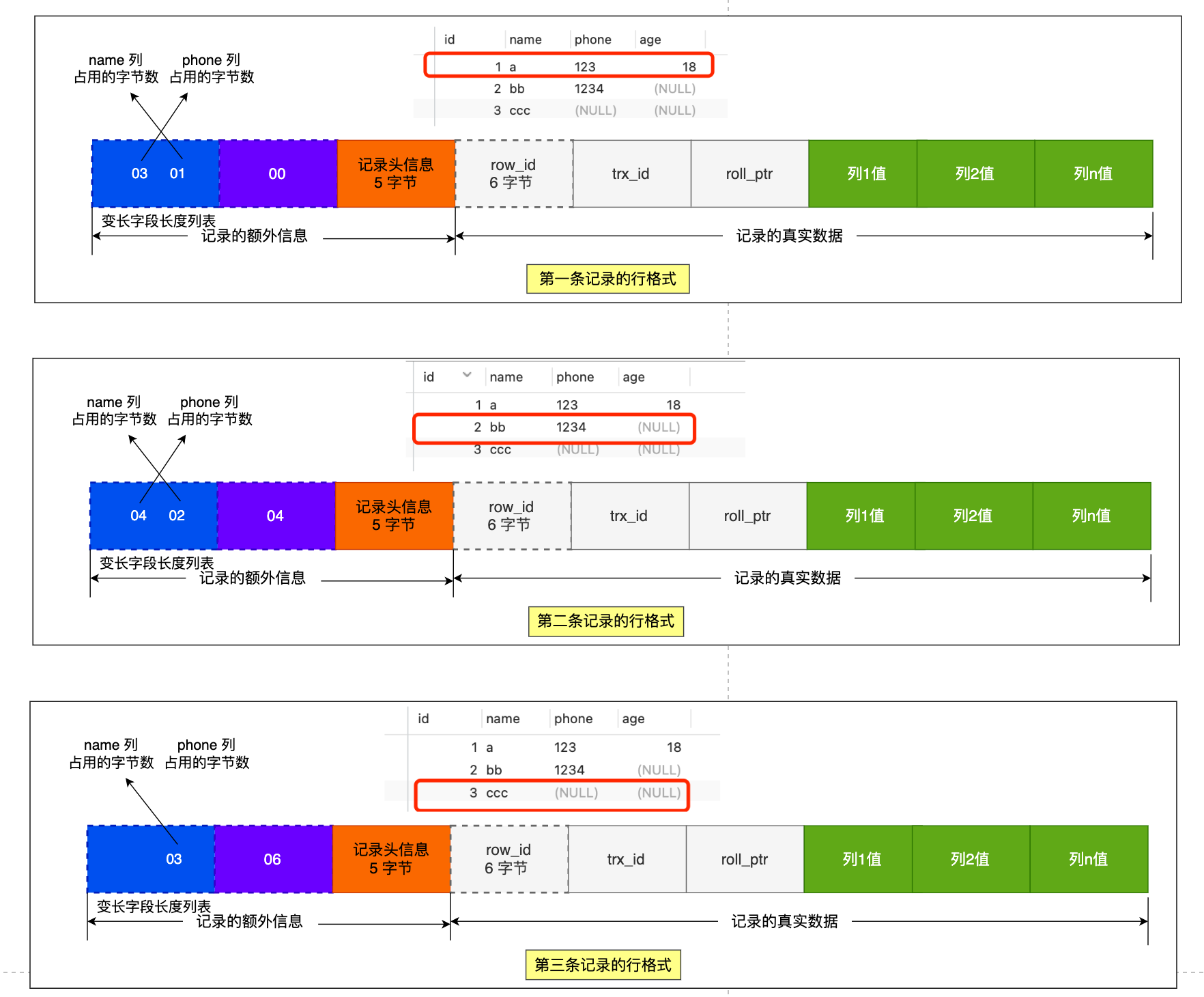

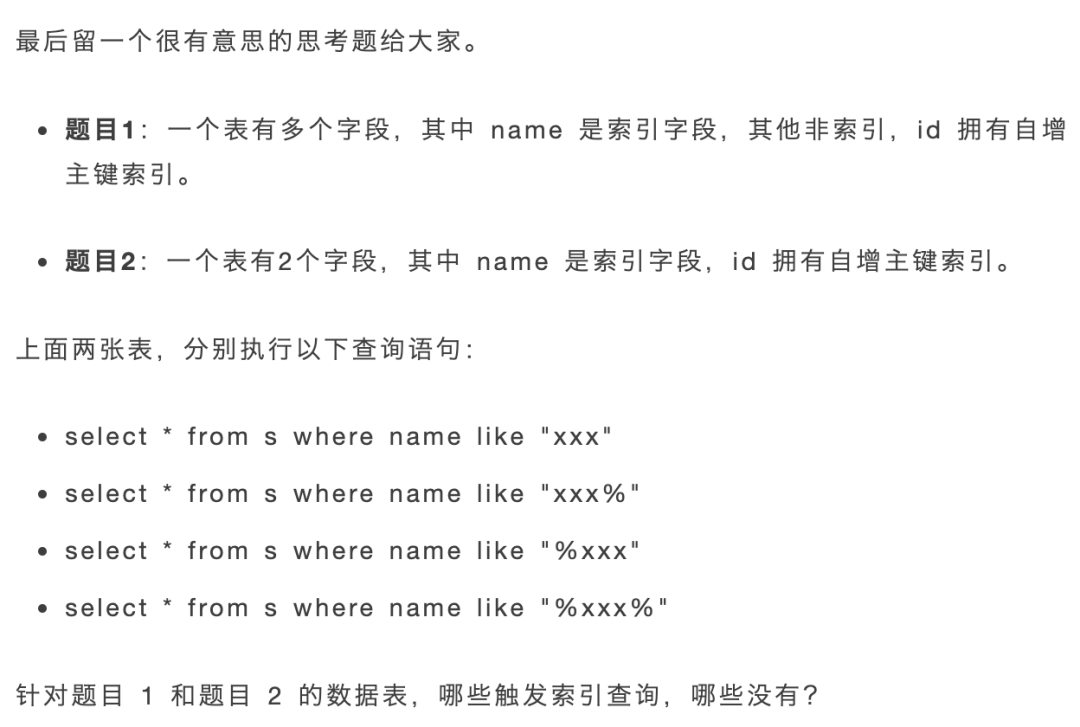

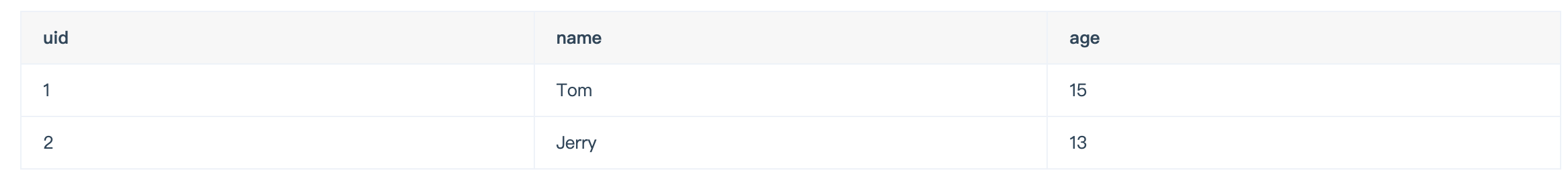

现在 t_user 表里有这三条记录:

先来看第一条记录:

- name 列的值为 a,真实数据占用的字节数是 1 字节,十六进制 0x01;

- phone 列的值为 123,真实数据占用的字节数是 3 字节,十六进制 0x03;

- age 列和 id 列不是变长字段,所以这里不用管。

这些变长字段的真实数据占用的字节数会按照列的顺序逆序存放(等下会说为什么要这么设计),所以「变长字段长度列表」里的内容是「 03 01」,而不是 「01 03」。

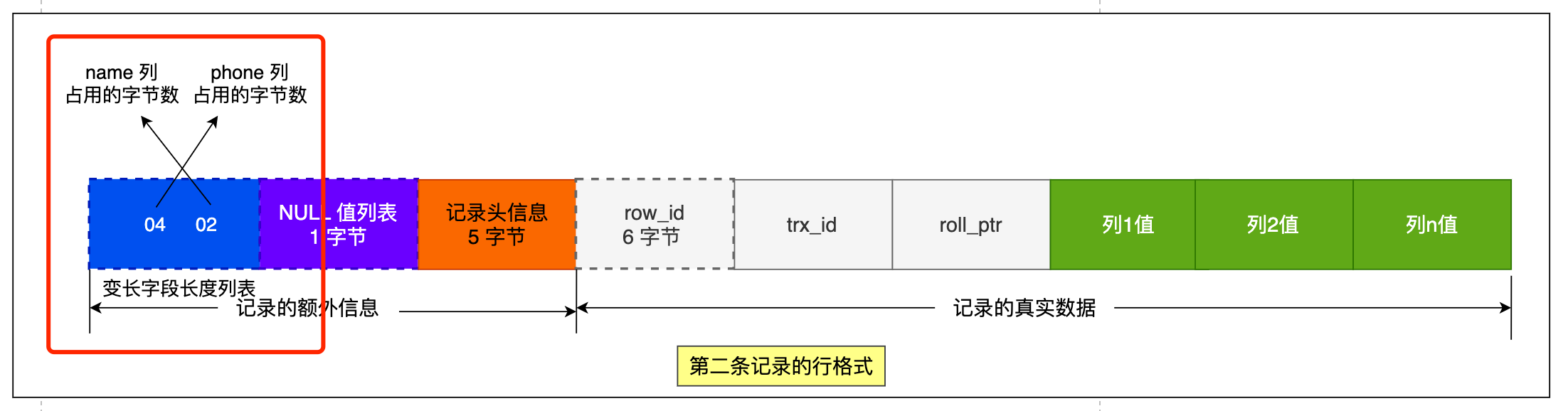

同样的道理,我们也可以得出第二条记录的行格式中,「变长字段长度列表」里的内容是「 04 02」,如下图:

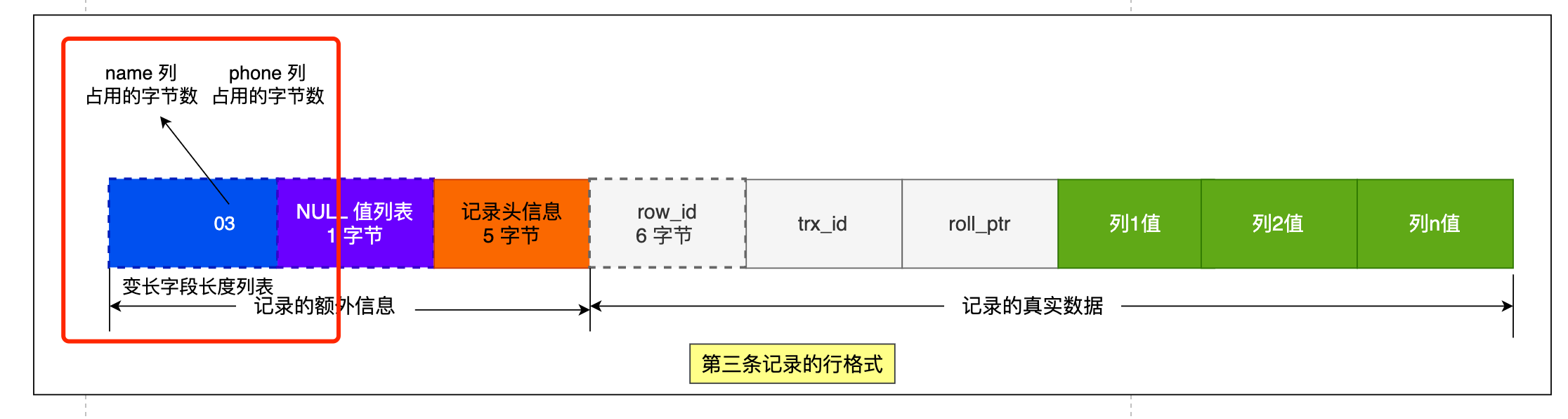

第三条记录中 phone 列的值是 NULL,NULL 是不会存放在行格式中记录的真实数据部分里的,所以「变长字段长度列表」里不需要保存值为 NULL 的变长字段的长度。

为什么「变长字段长度列表」的信息要按照逆序存放?

这个设计是有想法的,主要是因为「 记录头信息」中指向下一个记录的指针,指向的是下一条记录的「记录头信息」和「真实数据」之间的位置,这样的好处是向左读就是记录头信息,向右读就是真实数据,比较方便。

「变长字段长度列表」中的信息之所以要逆序存放,是因为这样可以使得位置靠前的记录的真实数据和数据对应的字段长度信息可以同时在一个 CPU Cache Line 中,这样就可以提高 CPU Cache 的命中率。

同样的道理, NULL 值列表的信息也需要逆序存放=。

每个数据库表的行格式都有「变长字段字节数列表」吗?

其实变长字段字节数列表不是必须的。

当数据表没有变长字段的时候,比如全部都是 int 类型的字段,这时候表里的行格式就不会有「变长字段长度列表」了,因为没必要,不如去掉以节省空间。

所以「变长字段长度列表」只出现在数据表有变长字段的时候。

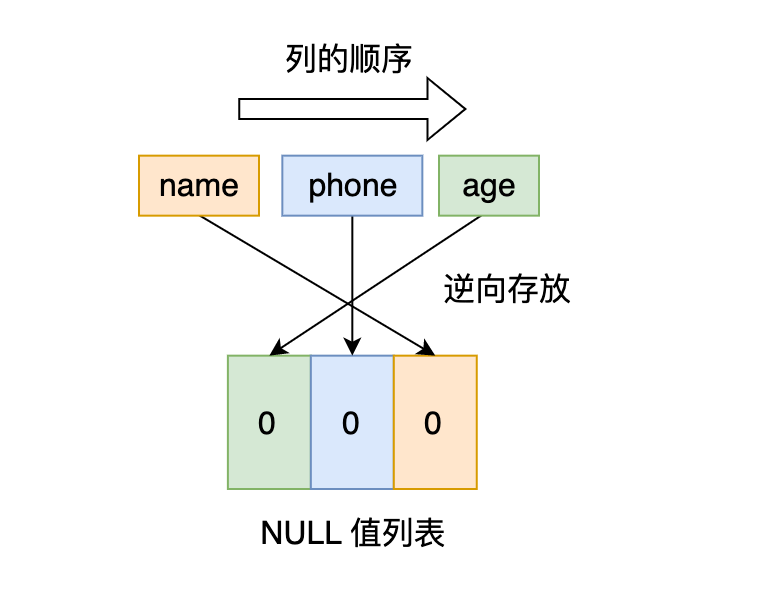

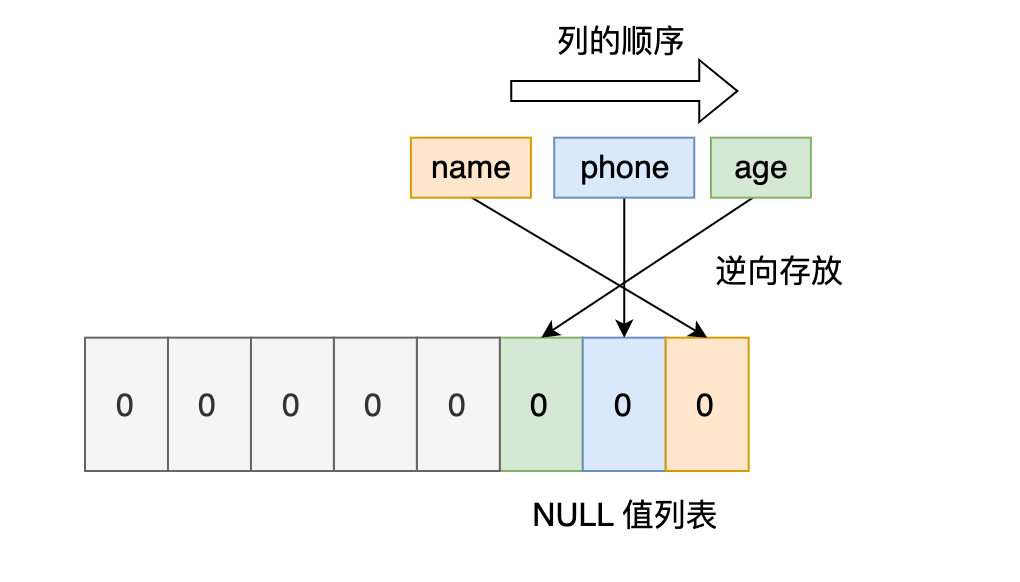

2. NULL 值列表

表中的某些列可能会存储 NULL 值,如果把这些 NULL 值都放到记录的真实数据中会比较浪费空间,所以 Compact 行格式把这些值为 NULL 的列存储到 NULL值列表中。

如果存在允许 NULL 值的列,则每个列对应一个二进制位(bit),二进制位按照列的顺序逆序排列。

- 二进制位的值为

1时,代表该列的值为NULL。 - 二进制位的值为

0时,代表该列的值不为NULL。

另外,NULL 值列表必须用整数个字节的位表示(1字节8位),如果使用的二进制位个数不足整数个字节,则在字节的高位补 0。

还是以 t_user 表的这三条记录作为例子:

接下来,我们看看看看这三条记录的行格式中的 NULL 值列表是怎样存储的。

先来看第一条记录,第一条记录所有列都有值,不存在 NULL 值,所以用二进制来表示是酱紫的:

但是 InnoDB 是用整数字节的二进制位来表示 NULL 值列表的,现在不足 8 位,所以要在高位补 0,最终用二进制来表示是酱紫的:

所以,对于第一条数据,NULL 值列表用十六进制表示是 0x00。

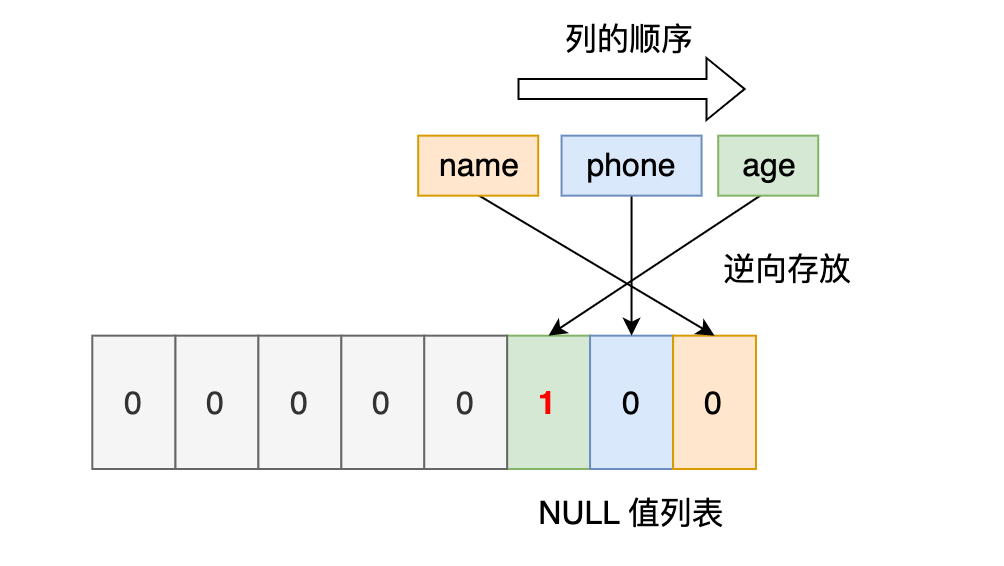

接下来看第二条记录,第二条记录 age 列是 NULL 值,所以,对于第二条数据,NULL值列表用十六进制表示是 0x04。

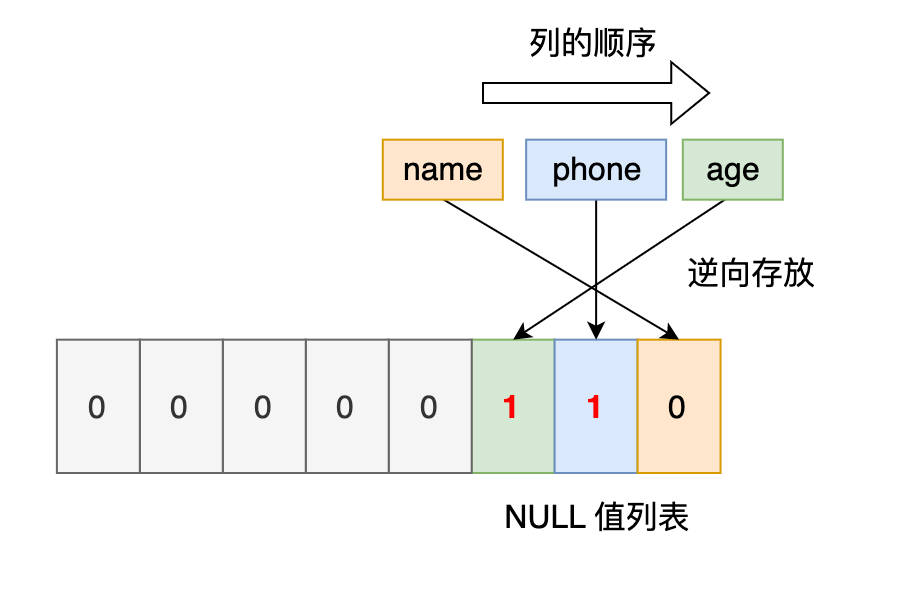

最后第三条记录,第三条记录 phone 列 和 age 列是 NULL 值,所以,对于第三条数据,NULL 值列表用十六进制表示是 0x06。

我们把三条记录的 NULL 值列表都填充完毕后,它们的行格式是这样的:

每个数据库表的行格式都有「NULL 值列表」吗?

NULL 值列表也不是必须的。

当数据表的字段都定义成 NOT NULL 的时候,这时候表里的行格式就不会有 NULL 值列表了。

所以在设计数据库表的时候,通常都是建议将字段设置为 NOT NULL,这样可以至少节省 1 字节的空间(NULL 值列表至少占用 1 字节空间)。

「NULL 值列表」是固定 1 字节空间吗?如果这样的话,一条记录有 9 个字段值都是 NULL,这时候怎么表示?

「NULL 值列表」的空间不是固定 1 字节的。

当一条记录有 9 个字段值都是 NULL,那么就会创建 2 字节空间的「NULL 值列表」,以此类推。

- 记录头信息

记录头信息中包含的内容很多,我就不一一列举了,这里说几个比较重要的:

- delete_mask :标识此条数据是否被删除。从这里可以知道,我们执行 detele 删除记录的时候,并不会真正的删除记录,只是将这个记录的 delete_mask 标记为 1。

- next_record:下一条记录的位置。从这里可以知道,记录与记录之间是通过链表组织的。在前面我也提到了,指向的是下一条记录的「记录头信息」和「真实数据」之间的位置,这样的好处是向左读就是记录头信息,向右读就是真实数据,比较方便。

- record_type:表示当前记录的类型,0表示普通记录,1表示B+树非叶子节点记录,2表示最小记录,3表示最大记录

记录的真实数据

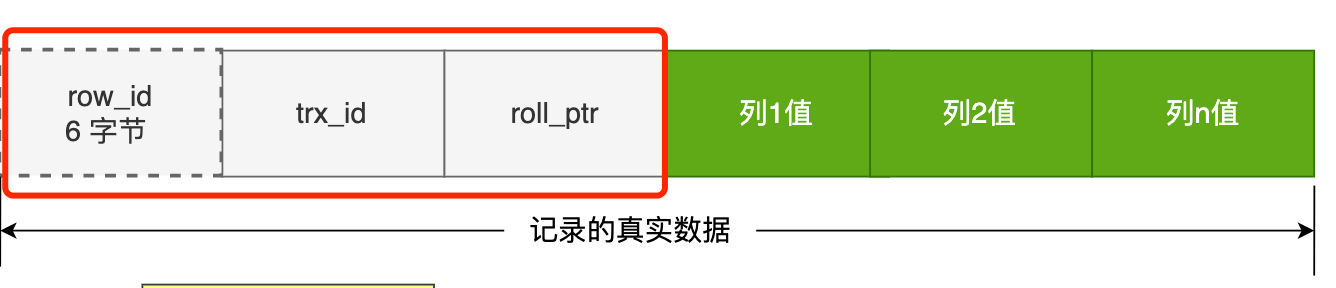

记录真实数据部分除了我们定义的字段,还有三个隐藏字段,分别为:row_id、trx_id、roll_pointer,我们来看下这三个字段是什么。

- row_id

建表的时候指定了主键或者唯一约束列,那么就没有 row_id 隐藏字段了。

如果既没有指定主键,又没有唯一约束,那么 InnoDB 就会为记录添加 row_id 隐藏字段。row_id不是必需的,占用 6 个字节。

- trx_id

事务id,表示这个数据是由哪个事务生成的。 trx_id是必需的,占用 6 个字节。

- roll_pointer

这条记录上一个版本的指针。roll_pointer 是必需的,占用 7 个字节。

熟悉 MVCC 机制,你应该就清楚 trx_id 和 roll_pointer 的作用

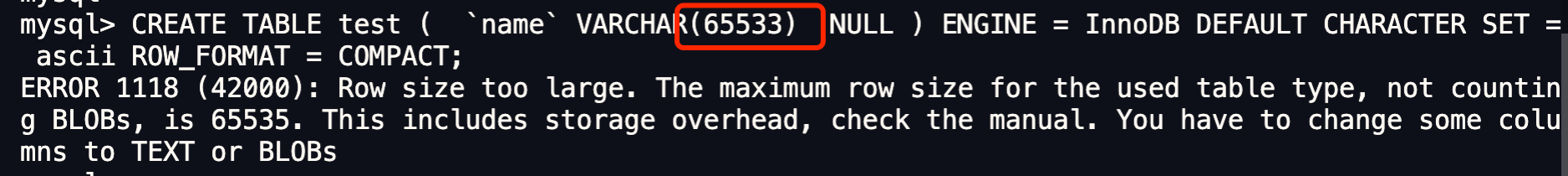

varchar(n) 中 n 最大取值为多少?

MySQL 规定除了 TEXT、BLOBs 这种大对象类型之外,其他所有的列(不包括隐藏列和记录头信息)占用的字节长度加起来不能超过 65535 个字节。

一行记录除了 TEXT、BLOBs 类型的列,限制最大为 65535 字节,注意是一行的总长度,不是一列。

varchar(n) 字段类型的 n 代表的是最多存储的字符数量,并不是字节大小哦。

要算 varchar(n) 最大能允许存储的字节数,还要看数据库表的字符集,因为字符集代表着,1个字符要占用多少字节,比如 ascii 字符集, 1 个字符占用 1 字节,那么 varchar(100) 意味着最大能允许存储 100 字节的数据。

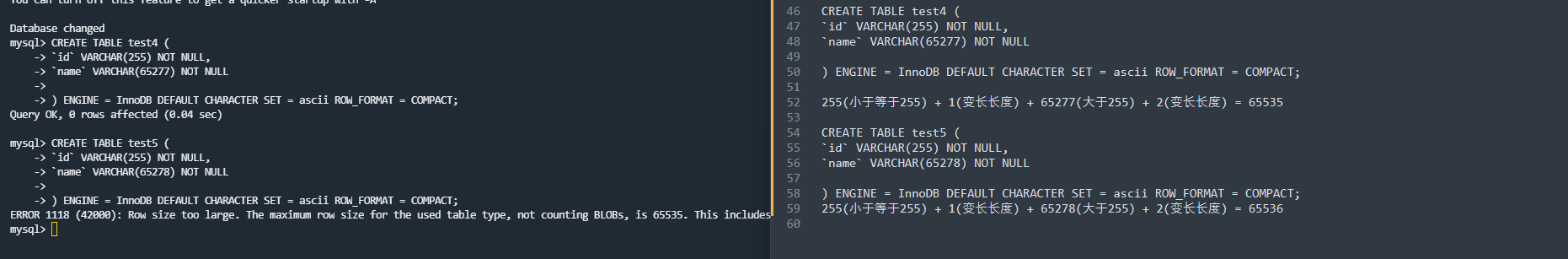

本次案例中,「NULL 值列表」所占用的字节数是多少?

前面我创建表的时候,字段是允许为 NULL 的,所以会用 1 字节来表示「NULL 值列表」。

本次案例中,「变长字段长度列表」所占用的字节数是多少?

「变长字段长度列表」所占用的字节数 = 所有「变长字段长度」占用的字节数之和。

所以,我们要先知道每个变长字段的「变长字段长度」需要用多少字节表示?具体情况分为:

- 条件一:如果变长字段允许存储的最大字节数小于等于 255 字节,就会用 1 字节表示「变长字段长度」;

- 条件二:如果变长字段允许存储的最大字节数大于 255 字节,就会用 2 字节表示「变长字段长度」;

我们这里字段类型是 varchar(65535) ,字符集是 ascii,所以代表着变长字段允许存储的最大字节数是 65535,符合条件二,所以会用 2 字节来表示「变长字段长度」。

因为我们这个案例是只有 1 个变长字段,所以「变长字段长度列表」= 1 个「变长字段长度」占用的字节数,也就是 2 字节。

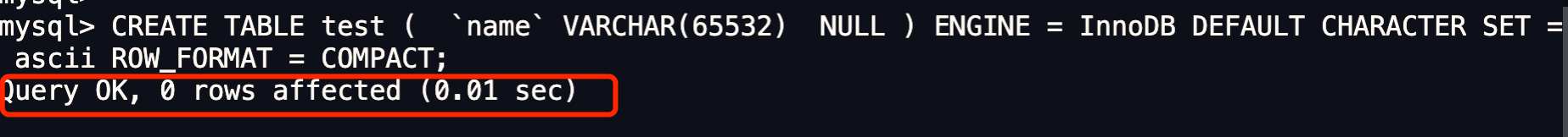

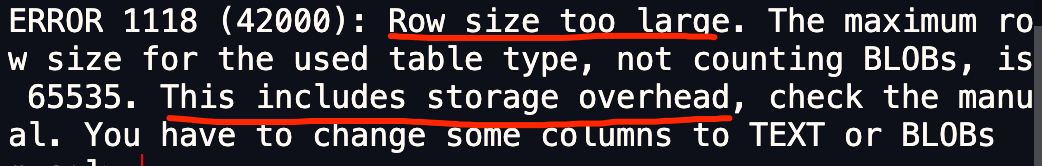

因为我们在算 varchar(n) 中 n 最大值时,需要减去 「变长字段长度列表」和 「NULL 值列表」所占用的字节数的。所以,在数据库表只有一个 varchar(n) 字段且字符集是 ascii 的情况下,varchar(n) 中 n 最大值 = 65535 - 2 - 1 = 65532。

我们先来测试看看 varchar(65533) 是否可行?

可以看到,还是不行,接下来看看 varchar(65532) 是否可行?

可以看到,创建成功了。说明我们的推论是正确的,在算 varchar(n) 中 n 最大值时,需要减去 「变长字段长度列表」和 「NULL 值列表」所占用的字节数的。

当然,我上面这个例子是针对字符集为 ascii 情况,如果采用的是 UTF-8,varchar(n) 最多能存储的数据计算方式就不一样了:

- 在 UTF-8 字符集下,一个字符最多需要三个字节,varchar(n) 的 n 最大取值就是 65532/3 = 21844。

上面所说的只是针对于一个字段的计算方式。

单字段的情况

一行记录最大只能存储 65535 字节的数据。

那假设数据库表只有一个 varchar(n) 类型的列且字符集是 ascii,在这种情况下, varchar(n) 中 n 最大取值是 65535 吗?

不着急说结论,我们先来做个实验验证一下。

我们定义一个 varchar(65535) 类型的字段,字符集为 ascii 的数据库表。

CREATE TABLE test (

`name` VARCHAR(65535) NULL

) ENGINE = InnoDB DEFAULT CHARACTER SET = ascii ROW_FORMAT = COMPACT;

看能不能成功创建一张表:

可以看到,创建失败了。

从报错信息就可以知道一行数据的最大字节数是 65535(不包含 TEXT、BLOBs 这种大对象类型),其中包含了 storage overhead。

storage overhead 是什么呢?其实就是「变长字段长度列表」和 「NULL 值列表」,也就是说一行数据的最大字节数 65535,其实是包含「变长字段长度列表」和 「NULL 值列表」所占用的字节数的。

在算 varchar(n) 中 n 最大值时,需要减去 storage overhead 占用的字节数。

这是因为我们存储字段类型为 varchar(n) 的数据时,其实分成了三个部分来存储:

- 真实数据

- 真实数据占用的字节数

- NULL 标识,如果不允许为NULL,这部分不需要

多字段的情况

如果有多个字段的话,要保证所有字段的长度 + 变长字段字节数列表所占用的字节数 + NULL值列表所占用的字节数 <= 65535。

行溢出后,MySQL是怎么处理的?

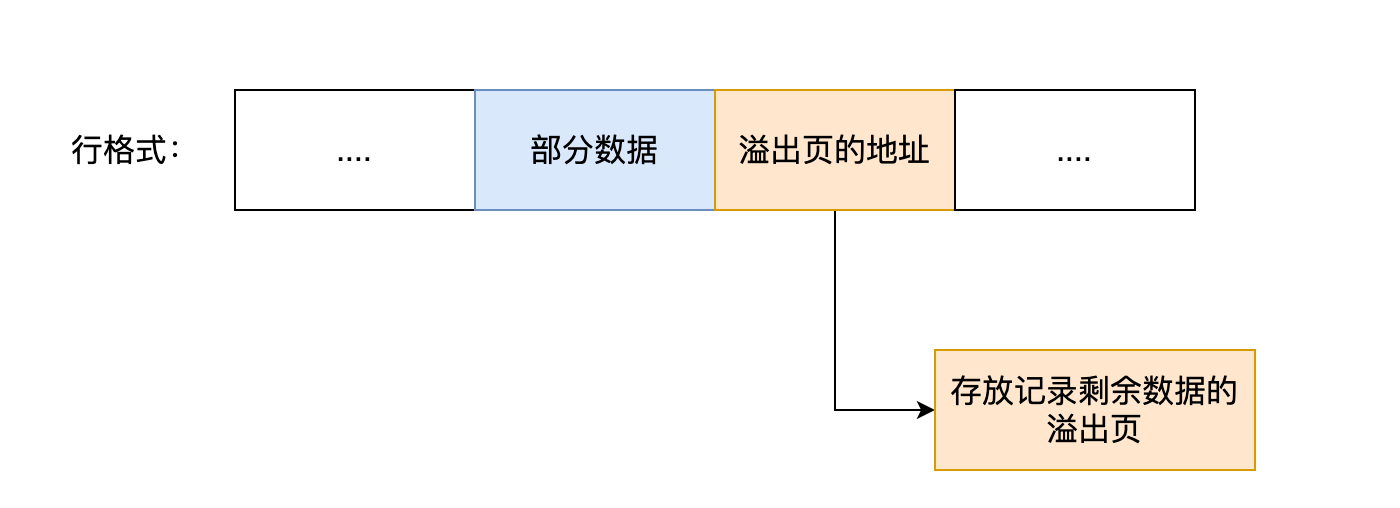

MySQL 中磁盘和内存交互的基本单位是页,一个页的大小一般是 16KB,也就是 16384字节,而一个 varchar(n) 类型的列最多可以存储 65532字节,一些大对象如 TEXT、BLOB 可能存储更多的数据,这时一个页可能就存不了一条记录。这个时候就会发生行溢出,多的数据就会存到另外的「溢出页」中。

如果一个数据页存不了一条记录,InnoDB 存储引擎会自动将溢出的数据存放到「溢出页」中。

在一般情况下,InnoDB 的数据都是存放在 「数据页」中。但是当发生行溢出时,溢出的数据会存放到「溢出页」中。

当发生行溢出时,在记录的真实数据处只会保存该列的一部分数据,而把剩余的数据放在「溢出页」中,然后真实数据处用 20 字节存储指向溢出页的地址,从而可以找到剩余数据所在的页。大致如下图所示。

上面这个是 Compact 行格式在发生行溢出后的处理。

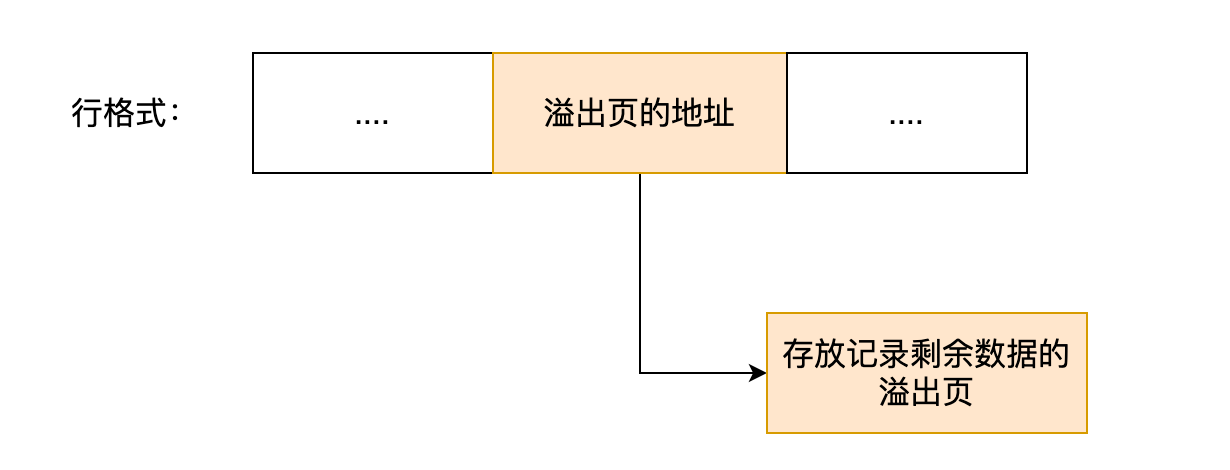

Compressed 和 Dynamic 这两个行格式和 Compact 非常类似,主要的区别在于处理行溢出数据时有些区别。

这两种格式采用完全的行溢出方式,记录的真实数据处不会存储该列的一部分数据,只存储 20 个字节的指针来指向溢出页。而实际的数据都存储在溢出页中,看起来就像下面这样:

总结:

MySQL 的 NULL 值是怎么存放的?

MySQL 的 Compact 行格式中会用「NULL值列表」来标记值为 NULL 的列,NULL 值并不会存储在行格式中的真实数据部分。

NULL值列表会占用 1 字节空间,当表中所有字段都定义成 NOT NULL,行格式中就不会有 NULL值列表,这样可节省 1 字节的空间。

MySQL 怎么知道 varchar(n) 实际占用数据的大小?

MySQL 的 Compact 行格式中会用「变长字段长度列表」存储变长字段实际占用的数据大小。

varchar(n) 中 n 最大取值为多少?

一行记录最大能存储 65535 字节的数据,但是这个是包含「变长字段字节数列表所占用的字节数」和「NULL值列表所占用的字节数」。所以, 我们在算 varchar(n) 中 n 最大值时,需要减去这两个列表所占用的字节数。

如果一张表只有一个 varchar(n) 字段,且允许为 NULL,字符集为 ascii。varchar(n) 中 n 最大取值为 65532。

计算公式:65535 - 变长字段字节数列表所占用的字节数 - NULL值列表所占用的字节数 = 65535 - 2 - 1 = 65532。

如果有多个字段的话,要保证所有字段的长度 + 变长字段字节数列表所占用的字节数 + NULL值列表所占用的字节数 <= 65535。

行溢出后,MySQL 是怎么处理的?

如果一个数据页存不了一条记录,InnoDB 存储引擎会自动将溢出的数据存放到「溢出页」中。

Compact 行格式针对行溢出的处理是这样的:当发生行溢出时,在记录的真实数据处只会保存该列的一部分数据,而把剩余的数据放在「溢出页」中,然后真实数据处用 20 字节存储指向溢出页的地址,从而可以找到剩余数据所在的页。

Compressed 和 Dynamic 这两种格式采用完全的行溢出方式,记录的真实数据处不会存储该列的一部分数据,只存储 20 个字节的指针来指向溢出页。而实际的数据都存储在溢出页中。

索引篇

- 索引底层使用了什么数据结构和算法?

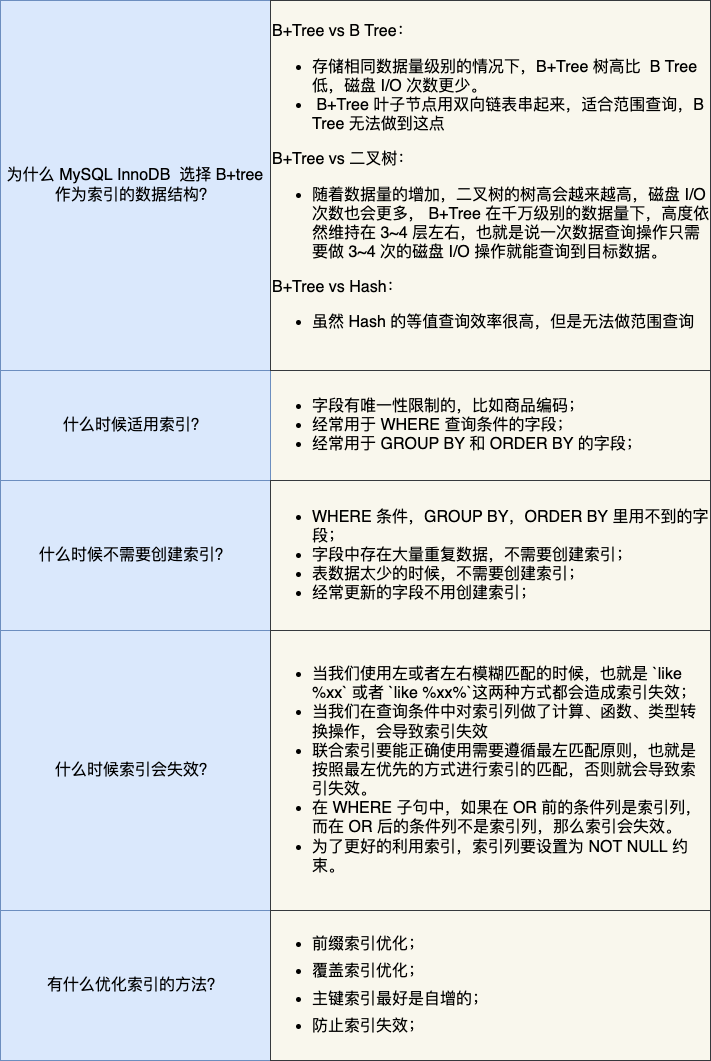

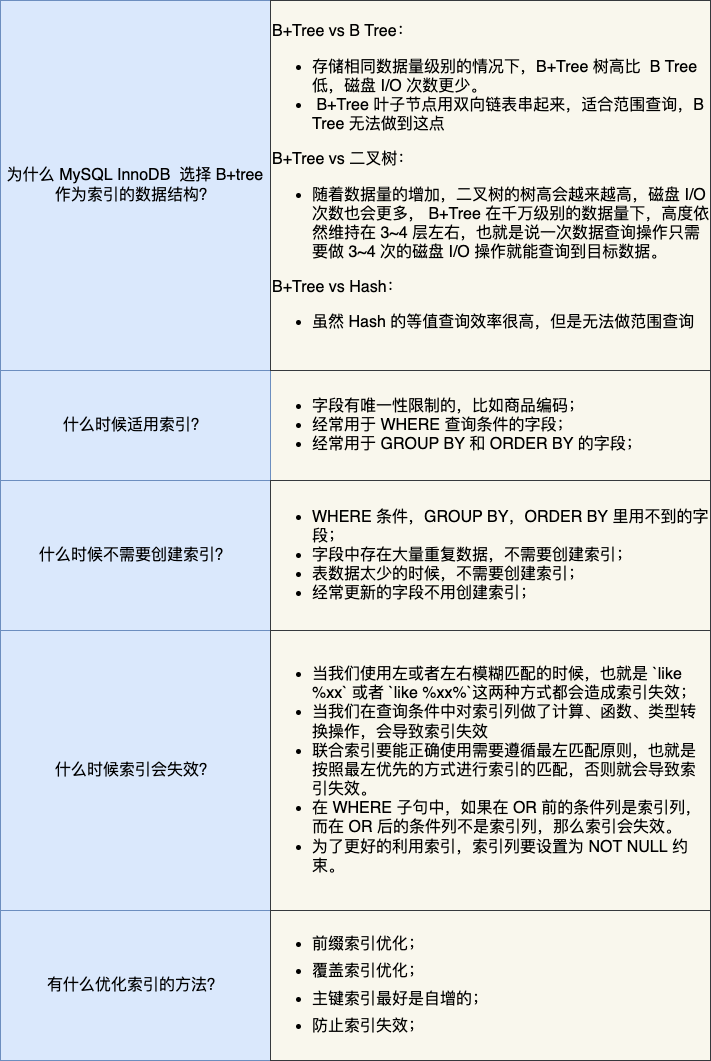

- 为什么 MySQL InnoDB 选择 B+tree 作为索引的数据结构?

- 什么时候适用索引?

- 什么时候不需要创建索引?

- 什么情况下索引会失效?

- 有什么优化索引的方法?

什么是索引?

书中的目录,就是充当索引的角色,方便我们快速查找书中的内容,所以索引是以空间换时间的设计思想。

数据库中,索引的定义就是帮助存储引擎快速获取数据的一种数据结构,形象的说就是索引是数据的目录。

索引种类

- 按「数据结构」分类:B+tree索引、Hash索引、Full-text索引

- 按「物理存储」分类:聚簇索引(主键索引)、二级索引(辅助索引)

- 按「字段特性」分类:主键索引、唯一索引、普通索引、前缀索引

- 按「字段个数」分类:单列索引、联合索引

按数据结构分类

InnoDB 是在 MySQL 5.5 之后成为默认的 MySQL 存储引擎,B+Tree 索引类型也是 MySQL 存储引擎采用最多的索引类型。

在创建表时,InnoDB 存储引擎会根据不同的场景选择不同的列作为索引:

- 如果有主键,默认会使用主键作为聚簇索引的索引键(key);

- 如果没有主键,就选择第一个不包含 NULL 值的唯一列作为聚簇索引的索引键(key);

- 在上面两个都没有的情况下,InnoDB 将自动生成一个隐式自增 id 列作为聚簇索引的索引键(key);

其它索引都属于辅助索引(Secondary Index),也被称为二级索引或非聚簇索引。

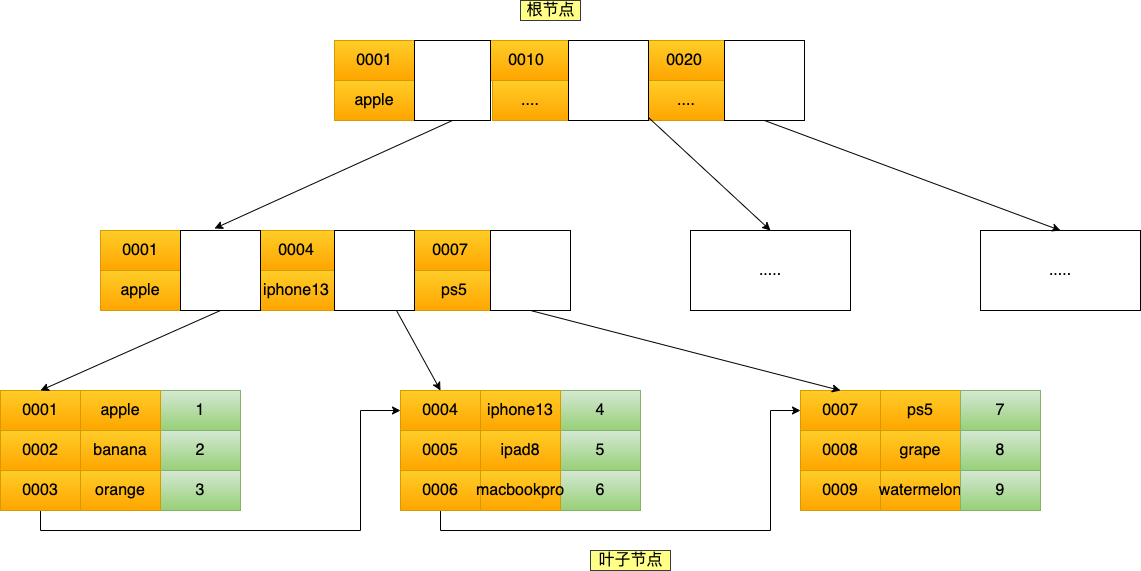

创建的主键索引和二级索引默认使用的是 B+Tree 索引。

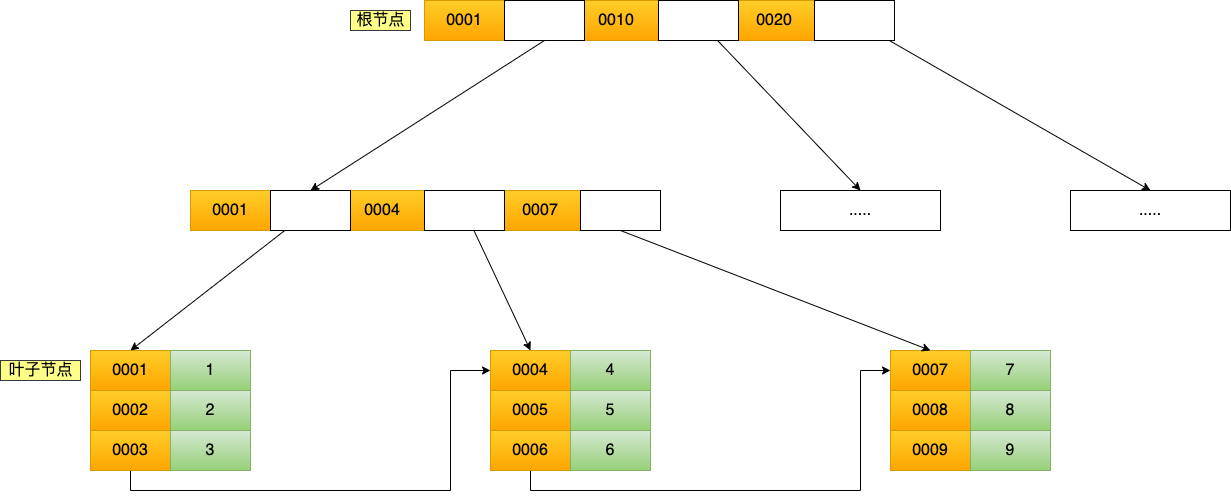

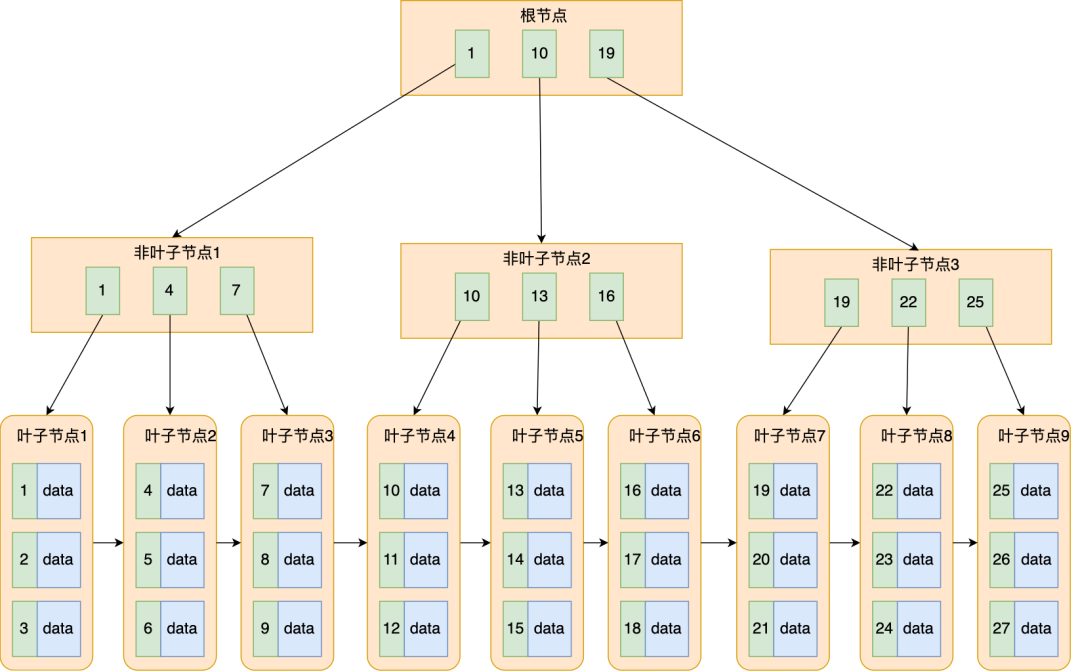

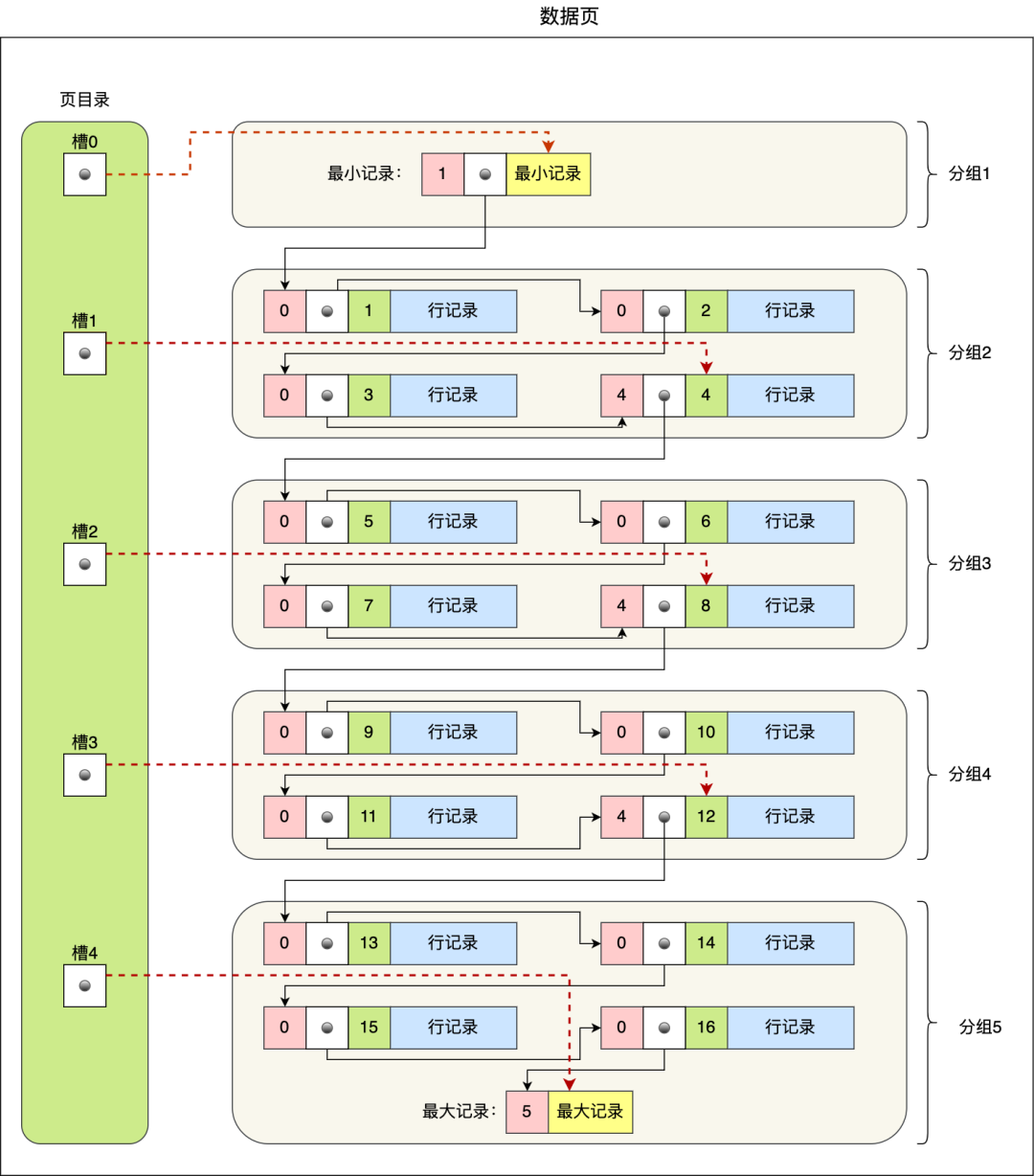

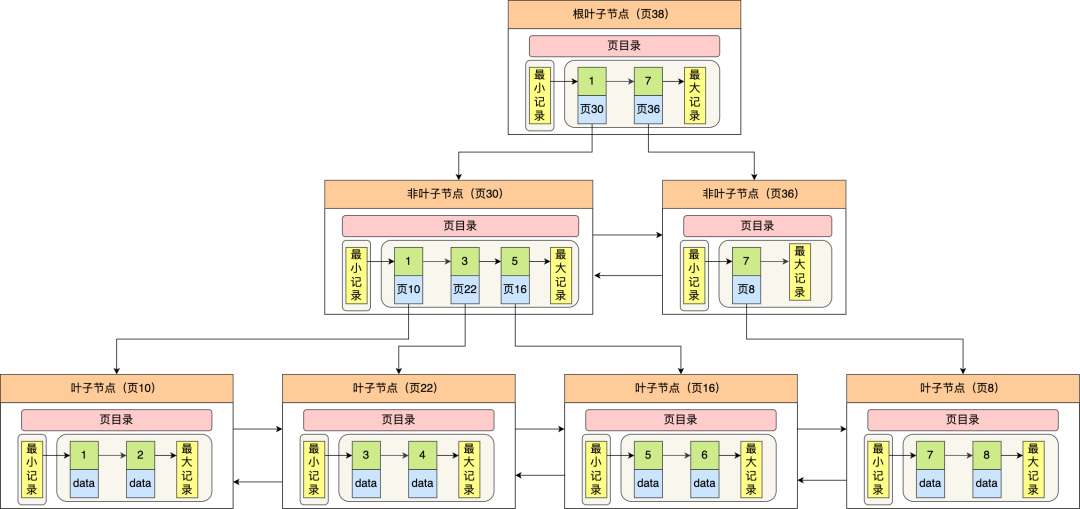

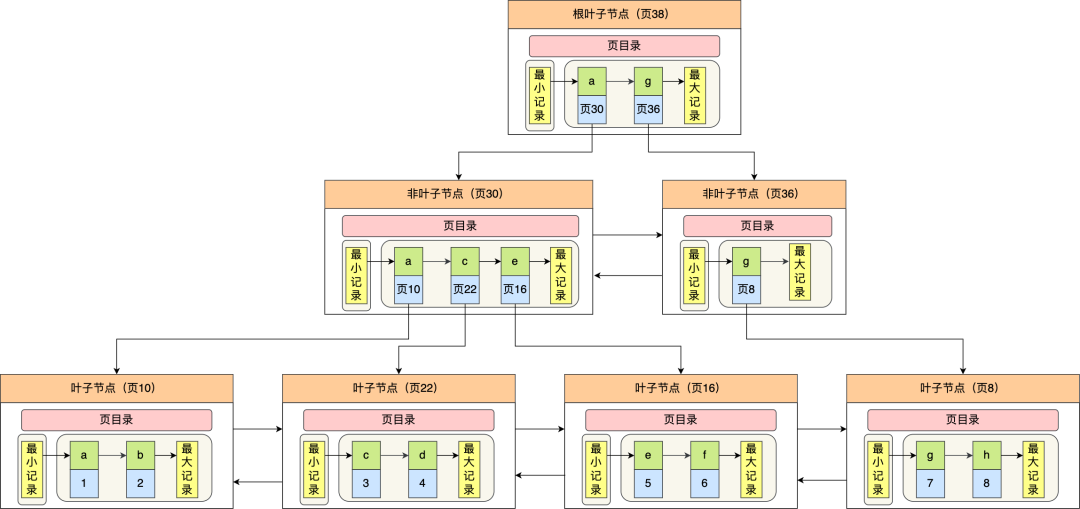

B+Tree 是一种多叉树,叶子节点才存放数据,非叶子节点只存放索引,而且每个节点里的数据是按主键顺序存放的。

每一层父节点的索引值都会出现在下层子节点的索引值中,因此在叶子节点中,包括了所有的索引值信息,并且每一个叶子节点都有两个指针,分别指向下一个叶子节点和上一个叶子节点,形成一个双向链表。

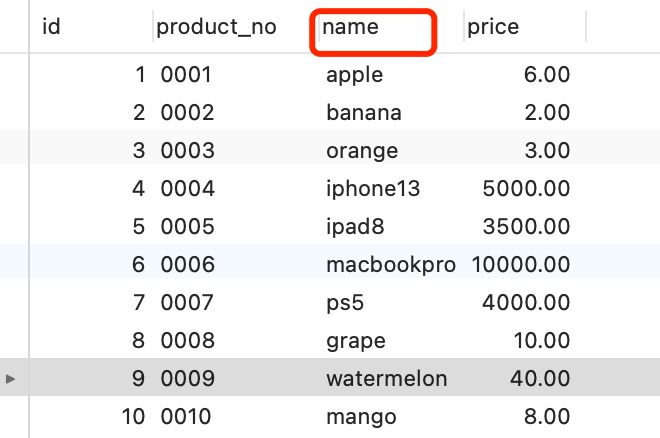

先创建一张商品表,id 为主键,如下:

CREATE TABLE `product` (

`id` int(11) NOT NULL,

`product_no` varchar(20) DEFAULT NULL,

`name` varchar(255) DEFAULT NULL,

`price` decimal(10, 2) DEFAULT NULL,

PRIMARY KEY (`id`) USING BTREE

) CHARACTER SET = utf8 COLLATE = utf8_general_ci ROW_FORMAT = Dynamic;

主键索引的 B+Tree 如图所示

通过主键查询商品数据的过程

比如,我们执行了下面这条查询语句:

select * from product where id= 5;

这条语句使用了主键索引查询 id 号为 5 的商品。查询过程是这样的,B+Tree 会自顶向下逐层进行查找:

- 将 5 与根节点的索引数据 (1,10,20) 比较,5 在 1 和 10 之间,所以根据 B+Tree的搜索逻辑,找到第二层的索引数据 (1,4,7);

- 在第二层的索引数据 (1,4,7)中进行查找,因为 5 在 4 和 7 之间,所以找到第三层的索引数据(4,5,6);

- 在叶子节点的索引数据(4,5,6)中进行查找,然后我们找到了索引值为 5 的行数据。

数据库的索引和数据都是存储在硬盘的,我们可以把读取一个节点当作一次磁盘 I/O 操作。那么上面的整个查询过程一共经历了 3 个节点,也就是进行了 3 次 I/O 操作。

B+Tree 存储千万级的数据只需要 3-4 层高度就可以满足,这意味着从千万级的表查询目标数据最多需要 3-4 次磁盘 I/O,所以B+Tree 相比于 B 树和二叉树来说,最大的优势在于查询效率很高,因为即使在数据量很大的情况,查询一个数据的磁盘 I/O 依然维持在 3-4次。

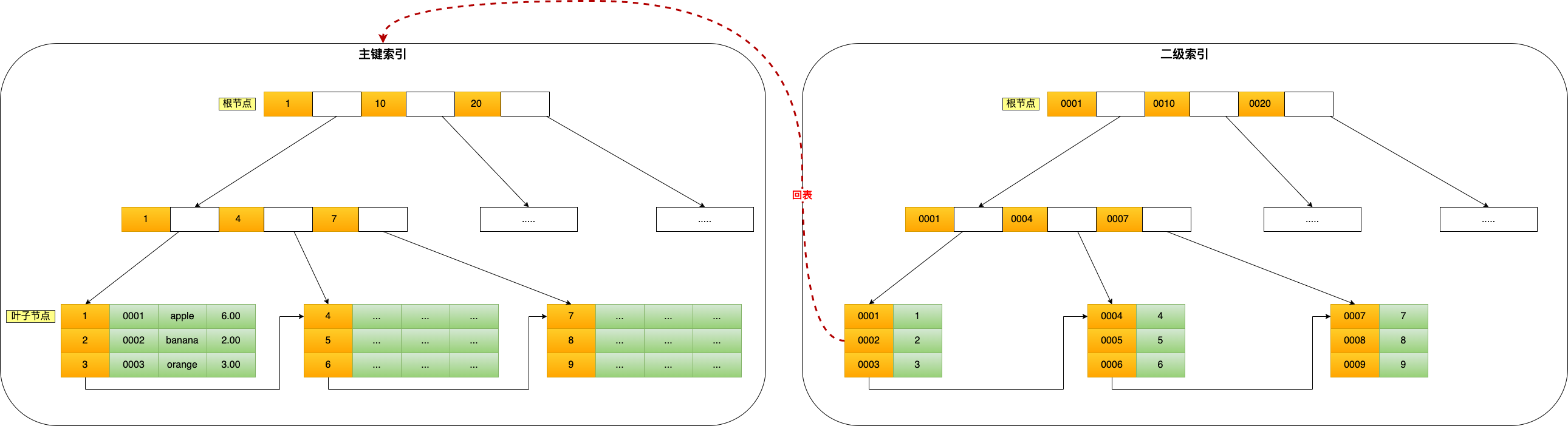

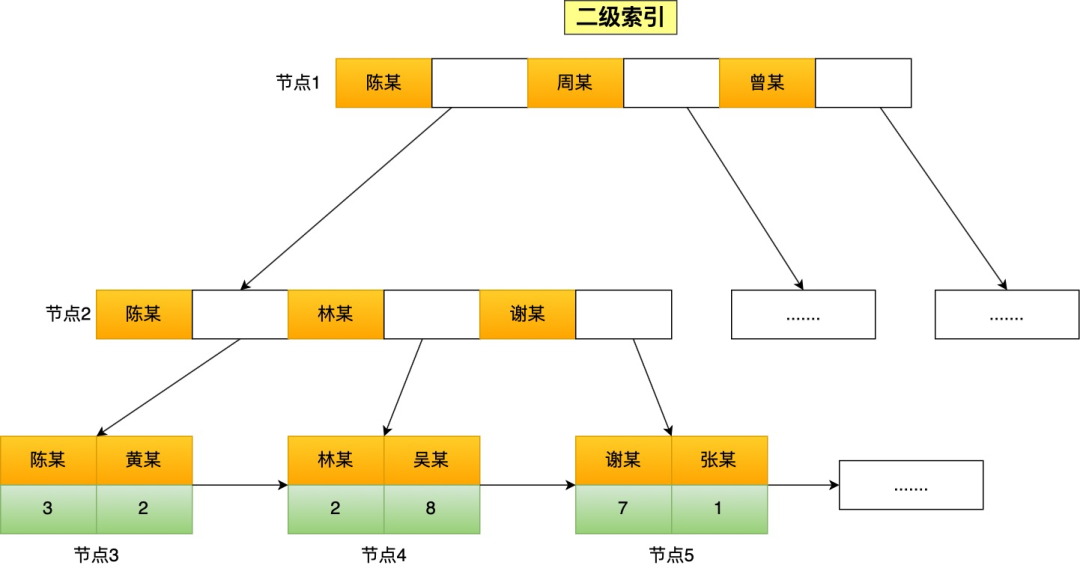

通过二级索引查询商品数据的过程

主键索引的 B+Tree 和二级索引的 B+Tree 区别如下:

- 主键索引的 B+Tree 的叶子节点存放的是实际数据,所有完整的用户记录都存放在主键索引的 B+Tree 的叶子节点里;

- 二级索引的 B+Tree 的叶子节点存放的是主键值,而不是实际数据。

我这里将前面的商品表中的 product_no (商品编码)字段设置为二级索引,那么二级索引的 B+Tree 如下图(图中叶子节点之间我画了单向链表,但是实际上是双向链表)。