GBDT

一、目标函数

结构风险最小: 目标函数=损失函数(loss function/cost function代价函数)+lamda*正则项

经验风险最小: 目标函数=损失函数(loss funciton/cost function代价函数)

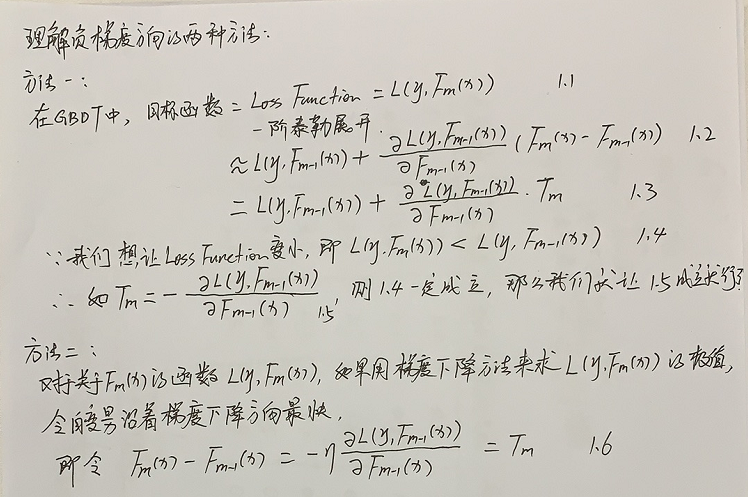

二、GB理论

用损失函数的负梯度来拟合本轮损失的近似值,进而拟合一个CART回归树。

三、GBDT理论

2.当基函数为DT时,首先正则项为0。第二、损失函数是均方损失函数,它的梯度值是残差的2倍,貌似和残差一致。

3.对于每棵决策树叶子结点y值,貌似不是直接和前面的值相加,具体怎么加的还没搞清楚。???

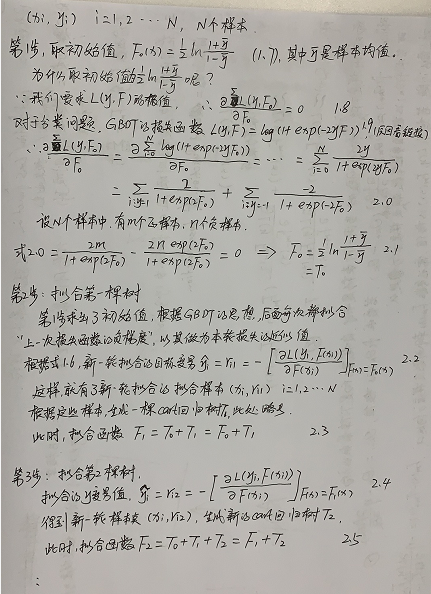

四、GBDT步骤

变量说明:a,![]() ,i=1...N ; b,

,i=1...N ; b,![]() ; c,

; c,![]() ; d,

; d, ![]() ; e,

; e,![]()

a: 训练样本。

b: 拟合的函数,m表示拟合m棵树,或者进行了m次迭代。

c: 第m次拟合的函数,第m棵树,![]() 。

。

d: 第m次拟合时第i个样本的目标变量,是根据负梯度值计算得到的。

e: 这些样本构成第m棵树的训练样本。

参考资料:

https://blog.csdn.net/horizonheart/article/details/78782622

https://blog.csdn.net/google19890102/article/details/51746402

https://blog.csdn.net/youhuakongzhi/article/details/94488888

GBDT原理与sklearn源码分析 *****

posted on 2019-09-24 10:35 静静的白桦林_andy 阅读(313) 评论(0) 收藏 举报

浙公网安备 33010602011771号

浙公网安备 33010602011771号