MBMF: Model-Based Priors for Model-Free Reinforcement Learning

发表时间:2017

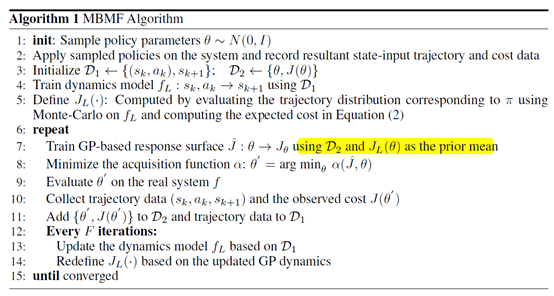

文章要点:这篇文章提出了一个Model-Based Model-Free (MBMF)算法,通过学习一个dynamics model然后作为先验来做model free optimization,这里的model free optimization指的是基于Gaussian Process (GP) 的Bayesian Optimization (BO)。

具体的,如果dynamics model是未知的,就先学一个

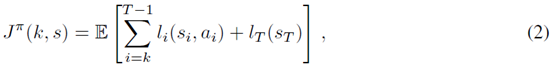

有了这个之后,把策略看成一个参数搜索问题,用GP去搜策略。每次搜到一个策略,就可以去计算目标函数,这里定义的目标函数是最小化cost,用\(l\)表示每个step的cost,式子如下

这个在真实环境里面得到的J用来拟合一个\(J\)的估计\(\hat{J}\),基于这个估计进而用来更新BO的acquisition function

这里\(\theta\)表示一组policy的参数,\(J\)就是估计的cost函数,所以acquisition function就是基于policy和cost计算的一个用来选下一组policy参数\(\theta\)的一个函数。

有了新的policy的参数之后,就可以拿到环境里面去测试,得到状态转移以及cost。状态转移就用来更新model,cost就用来更新\(\hat{J}\)。然后循环下去。

总结:model based加BO的方式来做,还挺有意思的。

疑问:算法伪代码里面学了的dynamics model好像没用上啊,不知道哪里理解错了。还是说,dynamics model就是用来算J的,然后BO是基于dynamics model做的?

浙公网安备 33010602011771号

浙公网安备 33010602011771号