Deep Reinforcement Learning in a Handful of Trials using Probabilistic Dynamics Models

发表时间:2018(NIPS 2018)

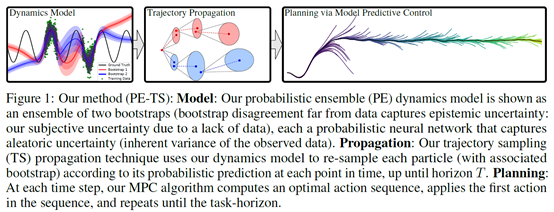

文章要点:这篇文章提出了一个model based 方法probabilistic ensembles with trajectory sampling (PETS),达到了model free方法的performance。主要思路是通过概率model和ensemble来识别model的uncertainty(uncertainty-aware dynamics models)(probabilistic ensembles),然后用online planning的方式来选动作(trajectory sampling)。

具体的,作者考虑了两种不同的uncertainty,一种是aleatoric,由于环境的随机性造成的uncertainty,对于这种uncertainty,就需要用概率模型去识别,所以作者的网络是去估计的状态的高斯分布,而不是一个点估计。另一种是epistemic,由于数据量不够多造成的uncertainty,这个uncertainty对于神经网络比较严重,因为神经网络的拟合能力很强,前期数据量不够的情况下很容易过拟合,作者的做法就是用ensemble的方式去训练多个model。有了这些model之后,剩下的就是planning了。这里作者没有用model free的方式去学一个policy网络,而是直接online planning,作者的解释是前期做实验发现效果并不理想。作者用的planning方法就是采很多条轨迹,然后选return最好的轨迹对应的第一个动作,而这多条轨迹来自不同的model,所以相当于就在planning的时候ensemble了uncertainty,就更稳健了。

总结:感觉这个结果才是靠谱的啊,model based就是应该干得过model free才对啊,不知道为什么有的paper说干不过。另外这里面没有去学policy,而是用的online planning,个人觉得这里面还是有提升的空间的,一个好的policy的prior,肯定可以有效指导online planning。

疑问:无。

浙公网安备 33010602011771号

浙公网安备 33010602011771号