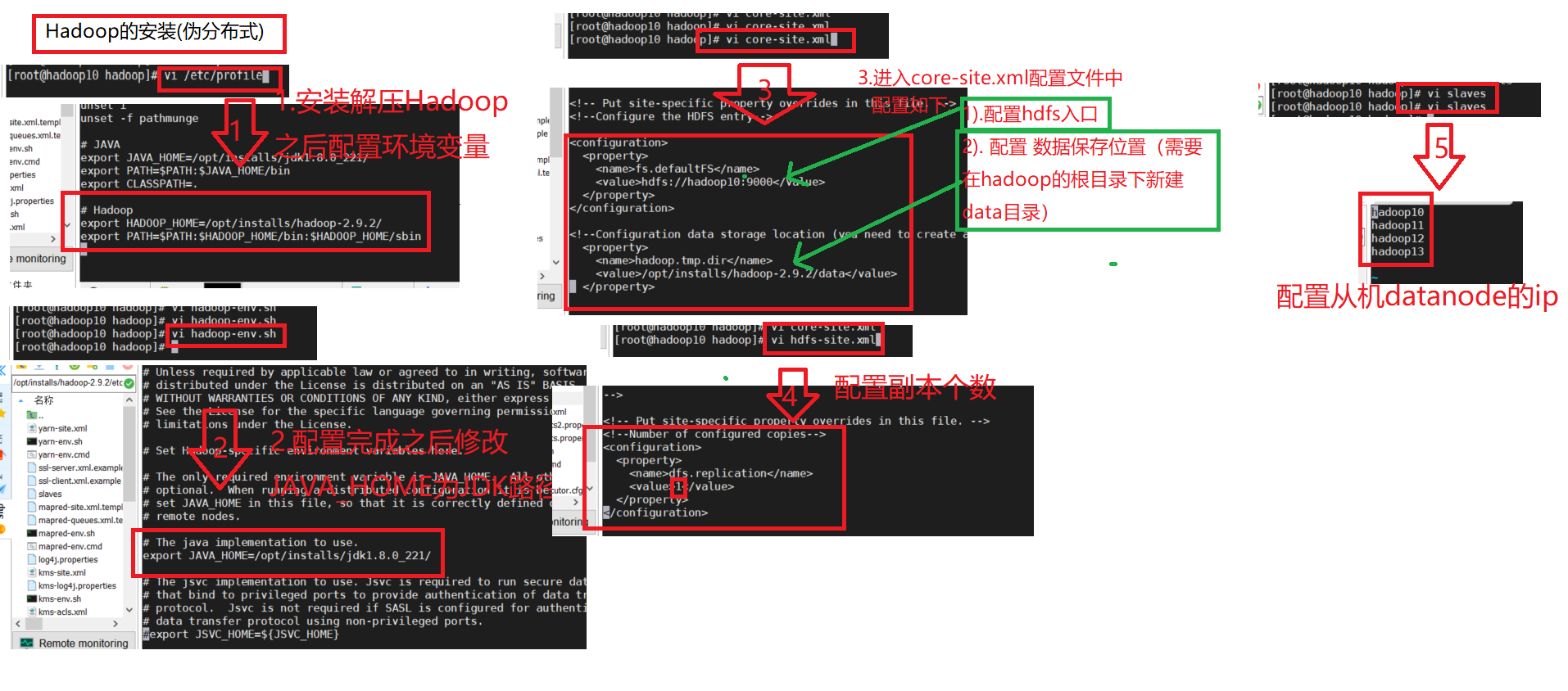

HDFS分布式伪安装

图解

文解

1.配置环境变量

vim /etc/profile

-------------以下是环境变量-------------

配置HADOOP_HOME

export HADOOP_HOME=/opt/installs/hadoop2.8.3

配置PATH

export PATH=\(PATH:\)HADOOP_HOME/bin:$HADOOP_HOME/sbin

生效配置信息(重新执行profile中的指令,加载配置信息)

source /etc/profile

2: 初始化配置文件

# hadoop-env.sh

core-site.xml

hdfs-site.xml

slaves

hadoop-env.sh

jdk安装目录

JAVA_HOME=/opt/installs/jdk1.8

文件所在路径/opt/installs/hadoop-2.9.2/etc/hadoop/

core-site.xml

配置hdfs入口

<property>

<name>fs.defaultFS</name>

<value>hdfs://hadoop10:9000</value>

</property>

配置 数据保存位置(需要在hadoop的根目录下新建data目录)

<property>

<name>hadoop.tmp.dir</name>

<value>/opt/installs/hadoop-2.9.2/data</value>

</property>

hdfs-site.xml

配置副本个数

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

slaves (建议使用vi编辑)

# 配置从机datanode的ip

hadoop10

注意: 最后-->> 3: 格式化HDFS(第一次安装HDFS 格式化系统磁盘)一旦hadoop配置启动失败,清空data下的文件,再重新格式化。初始化namenode和datanode存放数据的目录

hdfs namenode -format

4: 启动HDFS

启动hdfs

- start-dfs.sh

关闭hdfs

- stop-dfs.sh

查看hdfs进程

[root@hadoop10 install]# jps

- 2225 NameNode # master namenode主机

- 4245 Jps

- 2509 SecondaryNameNode

- 2350 DataNode # slave datanode从机

查看hdfsWeb服务

- 查看namenode的web服务

- http://hadoop10(ip或映射名):50070

- 查看datanode的Web服务

- http://hadoop10(ip或映射名):50075

搭建知识补充

- 日志查看(查看hdfs运行异常)

namenode启动运行日志

- hadoop-用户名-namenode-主机名.log

datanode启动日志 - hadoop-用户名-datanode-主机名.log

2. HDFS(配置错误修正)

- 关闭启动的hdfs程序(NN DN)

- 修改错误的配置文件。

- data目录清空,重新格式化-->>hdfs namenode -format

场景: 格式化或者启动hadoop失败。

说明:

hadoop/data文件夹

作用: 保存datanode和namenode持久化的数据。

时机:

1. 格式化hdfs namenode -format 会初始化该目录下的文件。

2. hdfs运行期间产生的数据,会操作该目录中的数据。

浙公网安备 33010602011771号

浙公网安备 33010602011771号