Dify让你拖拽式搭建企业级AI应用

在当今竞争激烈的商业环境中,人工智能已成为企业提升效率、优化服务的关键工具。然而,传统AI应用开发面临高技术门槛、漫长周期和昂贵成本的问题。Dify作为一款开源的大模型应用开发平台,正通过可视化工作流和低代码理念,彻底改变这一现状,让企业能够以前所未有的速度构建和部署AI应用。

一、Dify:AI应用开发的全栈“操作系统”

Dify(发音为/ˈdɪfaɪ/)代表"Design Intelligence For You",是一个集成了后端即服务(BaaS)与LLMOps理念的开源平台。其核心定位是将AI应用开发从"手工作坊"升级为"标准化流水线"。

Dify的三大核心优势

乐高式搭建:通过拖拽节点连接AI模型、知识库、API工具,1小时即可构建客服机器人或数据分析助手。这种可视化编排引擎让用户能够组合LLM调用、工具集成、条件分支等节点,构建复杂任务链。

模型无界兼容:一键接入OpenAI、DeepSeek、Claude、讯飞星火等20+主流模型,快速切换推理引擎,兼容数百种开源和商业模型。

生产级监控:自动记录对话日志,像"行车记录仪"般追踪AI表现,持续优化效果,提供企业级的安全性与合规性。

二、环境部署:快速搭建Dify平台

Docker一键部署

Dify支持多种部署方式,其中Docker部署是最简单快捷的方法:

Docker一键部署

docker run -d -p 5000:5000 dify/dify:latest

或者使用docker-compose部署

git clone https://github.com/langgenius/dify

cd dify/docker

cp .env.example .env

docker-compose up -d

避坑提示:

端口冲突解决方案:修改命令为 -p 8080:5000

Windows用户若遇WSL2安装失败(错误码0x80370102),需执行:

dism.exe /online /enable-feature /featurename:VirtualMachinePlatform /all /norestart

wsl --install -d Ubuntu # 重装内核

Linux内存优化:编辑~/.wslconfig添加:

[wsl2]

memory=6GB # 低于8GB易崩溃

模型配置

部署完成后,访问 http://localhost:8088 进入控制台:

进入"设置" → "模型供应商" → 添加API Key

以配置DeepSeek模型为例:

选择"自定义模型"

API端点:https://api.deepseek.com/v1

密钥获取:访问 https://platform.deepseek.com 申请免费试用

三、实战演练:构建智能客服机器人

下面通过一个完整的智能客服机器人示例,展示Dify的工作流编排能力。

创建工作流

进入Dify工作室,点击"创建应用",选择"Workflow"类型:

nodes:

-type:llm

model:deepseek-chat

prompt:|

你是一名专业的客服助手,请用友好、清晰的语气回答用户关于{{product}}的问题。

根据以下知识库内容提供准确信息:

用户问题:{{user_input}}

temperature:0.2

max_tokens:2048

-type:webhook

url:https://api.crm.com/save_log

method:POST

body: |

{

"user_query": "{{user_input}}",

"product": "{{product}}",

"timestamp": "{{timestamp}}"

}

添加知识库增强

为提高回答准确性,为客服机器人添加知识库支持:

在"知识库"中创建新的知识库,上传产品文档、FAQ和售后政策

配置检索优化参数:

分段最大长度:512 tokens

分段重叠长度:64 tokens

检索方式:混合检索(平衡准确率与召回率)

Rerank模型:bge-reranker(结果排序优化↑40%)

在工作流中添加"知识库检索"节点,将其输出作为LLM节点的上下文

设置条件分支

为处理复杂查询,可以添加条件分支节点:

-

type:if-else

condition:"{{intent}} == 'complaint'"

true_branch:

-type:llm

model:deepseek-chat

prompt:|

这是一条客户投诉,需要特别关注和妥善处理。

问题:{{user_input}}请以empathetic的语气回应,表达理解并提供解决方案。

false_branch:

-type:llm

model:deepseek-chat

prompt: |

这是一般咨询问题:{{user_input}}

请提供专业、清晰的解答。

四、构建企业级知识库系统

知识库是企业AI应用的核心,Dify通过RAG(检索增强生成)技术实现精准问答。

知识库分段策略

Dify提供两种分段模式,针对不同场景优化检索效果:

通用模式适用于简单文档:

分段标识符:\n(可按正则表达式自定义)

分段最大长度:500 tokens(最大支持4000 tokens)

分段重叠长度:建议分段长度的10-25%

父子模式适用于复杂技术文档:

父区块:保持较大的文本单位(如段落),提供丰富的上下文信息

子区块:较小的文本单位(如句子),用于精确检索

优势:首先通过子区块进行精确检索以确保相关性,然后获取对应的父区块来补充上下文信息

检索优化配置

在"高质量模式"下,Dify提供三种检索方式:

向量检索:比较查询向量与知识库内文本向量间的距离

TopK:默认3,数值越高召回片段越多

Score阈值:默认0.5,数值越高相似度要求越高

全文检索:关键词检索,通过明文关键词匹配

混合检索:同时执行全文检索和向量检索,可设置权重(语义0.7+关键词0.3)

五、企业级安全与性能优化

安全加固方案

Dify提供完善的企业级安全特性:

传输加密:HTTPS + JWT令牌验证

权限控制:RBAC模型分级授权,基于LDAP集成现有企业账号体系

审计日志:记录所有API调用和操作,满足GDPR/HIPAA合规要求

性能优化策略

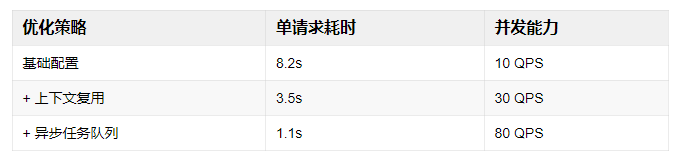

根据实测数据,通过以下优化策略可显著提升系统性能:

关键技术点:

模型量化:FP16→INT8(精度损失<0.5%)

请求批处理:batch_size=32时吞吐提升4倍

结果缓存:相似请求命中率高达70%

六、典型应用场景与效果

电商订单处理Agent

某电商客户使用Dify构建订单处理Agent:

传统痛点:需串联订单查询API、库存检测、回复生成等多个系统

Dify方案:工具节点调用订单系统API + 条件分支处理退货审批 + 自动化回复生成

实践效果:开发周期从3周缩短至2天,错误率下降90%

金融文档分析系统

基于Dify的RAG能力构建金融文档分析:

数据接入:上传年度报告、研报、公告等各类金融文档

向量存储:使用Qdrant索引,百万级文档检索<2秒

输出能力:自动生成财务摘要、增长分析和风险因素识别

七、常见问题与解决方案

知识库检索结果不稳定

根因:分段策略不当导致信息碎片化

解决方案:

开启"替换连续空格/换行符"选项

添加规则型预处理节点:删除URL/邮箱等噪声数据

调整分段策略,技术文档建议512token分块大小

智能体响应超时

性能优化数据:

操作指南:

在FastAPI服务中添加重试逻辑

from requests.adapters import HTTPAdapter, Retry

adapter = HTTPAdapter(max_retries=Retry(total=3))

session.mount('https://', adapter)

结语:AI开发的"水电煤"时代已来

Dify通过"可视化工作流 + 预置组件 + 企业级引擎"的三重革新,证明了低代码AI开发并非概念,而是落地现实。

正如某制造企业CTO所言:"过去AI是技术团队的'奢侈品',现在Dify让它成为业务部门的'日用品'。"

技术民主化公式:AI生产力 = (业务需求 × Dify节点) ÷ 编码复杂度

当大模型成为新生产力,低代码正是打开规模化应用的钥匙。从今天开始,用Dify拥抱AI应用开发的新范式,让你的企业在智能时代抢占先机。

推荐学习

自动化智能体与工作流管理平台课程,限时免费,机会难得。扫码报名,参与直播,希望您在这场公开课中掌握自动化与Ai智能体,轻松实现效率翻倍!

浙公网安备 33010602011771号

浙公网安备 33010602011771号