大模型性能测试完全指南:从原理到实践

一、大模型性能测试的核心价值

在AI技术快速发展的今天,大模型性能直接影响用户体验和商业价值。性能测试不仅能发现系统瓶颈,还能为容量规划、成本优化提供数据支撑。

为什么大模型需要专门的性能测试方法?

传统性能测试关注TPS(每秒事务数)和响应时间,但大模型的流式响应特性(Token逐个生成)和长上下文处理能力,需要全新的测试维度。

二、大模型工作原理科普

- 流式响应机制

大模型采用"思考-回答"的两阶段模式:

思考阶段:模型分析问题、检索知识、规划回答框架

回答阶段:逐个生成Token(文字片段)返回给用户

python

# 典型的大模型响应数据结构

{

"choices": [{

"delta": {

"role": "assistant",

"content": "思考过程..." # 思考包

},

"finish_reason": null

}]

}

- PD分离架构

现代大模型系统普遍采用Prefill-Decode分离架构:

P节点:处理请求预处理和首Token生成

D节点:专门负责后续Token生成

三、五大核心性能指标详解

首Token延迟:反映系统初始响应速度

行业标杆:≤2秒(中等长度文本)

影响因素:P节点负载、KV Cache计算

吐字率(Token/s):反映文本生成效率

行业标杆:≥40 Token/s

计算公式:吐字率 = 输出Token数/(结束时间-首Token时间)

QPM:系统吞吐能力

计算公式:QPM = 成功请求数/(测试时长/60)

输入Token数:影响计算复杂度

包括:System指令+用户问题+上下文历史

输出Token数:影响生成时间

测试时需保持不同测试轮次输出量级一致

四、实战:从零搭建测试环境

- 云服务准备(以阿里云为例)

# 安装OpenAI兼容SDK

pip install openai

# 初始化客户端

client = OpenAI(

api_key="your_api_key",

base_url="https://dashscope.aliyuncs.com/api/v1"

)

- 测试数据准备原则

真实性:使用线上真实对话数据

多样性:覆盖不同长度(1k/16k/64k Token)

防缓存:添加UUID避免缓存影响

messages = [

{"role": "system", "content": "你是一个AI助手"},

{"role": "user", "content": f"[{uuid.uuid4()}] 请解释量子计算原理"}

]

五、Locust压力测试实战

- 自定义指标实现

from locust import HttpUser, task, events

@events.init.add_listener

def on_locust_init(environment, **kwargs):

# 注册自定义指标

environment.stats.custom_stats["first_token_latency"] = []

environment.stats.custom_stats["token_rate"] = []

class ModelUser(HttpUser):

@task

def test_stream(self):

start_time = time.time()

first_token_received = False

with self.client.post("/v1/chat/completions",

stream=True,

json={"messages": [...]}) as response:

for line in response.iter_lines():

if not first_token_received:

first_token_time = time.time() - start_time

environment.stats.custom_stats["first_token_latency"].append(first_token_time)

first_token_received = True

# 解析Token并计算吐字率...

- 阶梯式压测策略

# locustfile.yaml

stages:

- duration: 5m # 预热阶段

target: 1

- duration: 10m # 基准测试

target: 8

- duration: 10m # 压力测试

target: 32

- duration: 5m # 极限测试

target: 64

六、性能瓶颈分析与优化

-

常见瓶颈场景

-

性能优化黄金法则

30-60-10原则:

首Token延迟≤3秒

吐字率≥60 Token/s

GPU利用率保持在70-90%

七、行业前沿:多模态测试挑战

随着多模态大模型兴起,测试面临新挑战:

混合输入处理:

同时测试文本+图片+音频输入

示例:{"text": "描述这张图片", "image": base64_data}

跨模态一致性:

验证文本描述与生成图片的相关性

需要专门的评估指标(如CLIP Score)

资源消耗模式:

视觉模型通常需要更多显存

测试时需监控显存使用曲线

结语:测试工程师的进阶之路

大模型性能测试既是挑战也是机遇。掌握这些技能,你将成为:

AI系统健康的"体检医生"

性能瓶颈的" forensic 专家"

架构优化的"战略顾问"

思考题:在测试百亿参数大模型时,如何平衡测试深度与资源成本?欢迎在评论区分享你的见解!

Playwright学习交流群

推荐学习

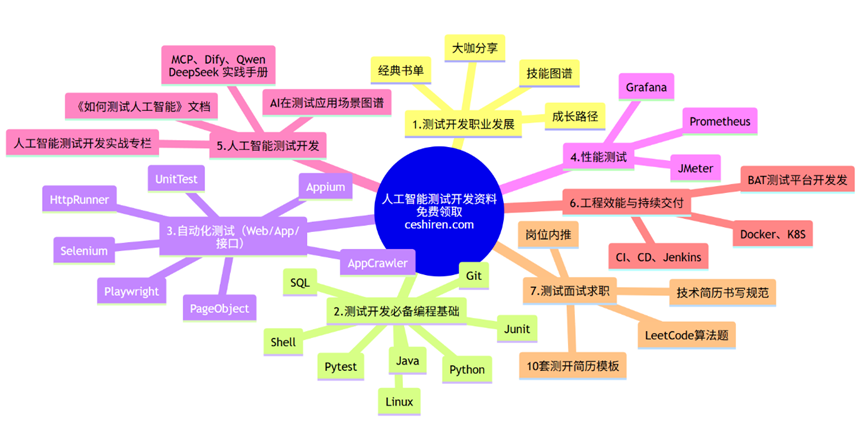

行业首个「知识图谱+测试开发」深度整合课程【人工智能测试开发训练营】,赠送智能体工具。提供企业级解决方案,人工智能的管理平台部署,实现智能化测试,落地大模型,实现从传统手工转向用AI和自动化来实现测试,提升效率和质量。

浙公网安备 33010602011771号

浙公网安备 33010602011771号