模型评估指标

(1)分类问题评估指标:

准确率 - Accuracy

精确率(差准率)- Precision

召回率(查全率)- Recall

F1分数

KS曲线

ROC曲线

AUC曲线

(2)回归问题评估指标:

MAE/MSE

准确率 Accuracy = (TP+TN)/(TP+TN+FP+FN)

精确率 Precision = TP/(TP+FP) --预测为正的所有样本中,为正的占比

召回率 Recall =TP/(TP+FN) --实际为正的所有样本中,为正的占比

F1=(2×Precision×Recall)/(Precision+Recall)

TPR = TP/(TP+FN) --实际为正的所有样本中,为正的占比

FPR = FP/(FP+TN) --实际为负的所有样本中,为正的占比

TPR 和 FPR 分别是基于实际表现 1 和 0 出发的,也就是说它们分别在实际的正样本和负样本中来观察相关概率问题。 正因为如此,所以无论样本是否平衡,都不会被影响。

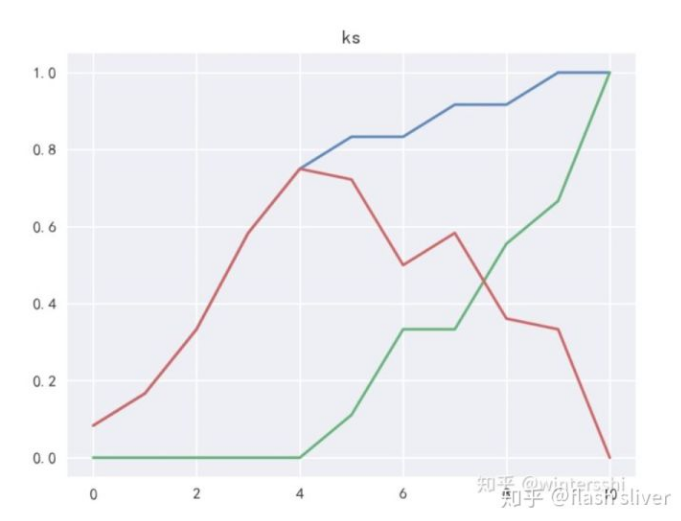

KS曲线

我们训练出来的模型,一般不是直接给出是正类还是负类的结果,给的是为正类的概率,我们还需要选择一个阈值,实例通过模型得到的概率大于阈值,判断为正类,小于阈值判断为负类。也就是说阈值的不同,以上的各个指标的值也是不同的。

把阈值看成自变量,以上TPR、和FPR看成因变量,在二维坐标系里面做关系曲线,这就是KS曲线。

KS=max(TPR-FPR)

1) 当KS<0.2 时,模型无鉴别能力

2) 在0.2~0.4 之间,模型勉强接受,需要考虑优化

3) 在0.4~0.5 之间,模型有区别能力

4) 在0.5~0.6 之间,模型有较好的区别能力

5) 在0.6~0.7 之间,模型有非常好的区别能力

6) 当KS>0.75 时,要检验模型是否过拟合

ROC曲线

ROC 曲线中的主要两个指标就是真正率和假正率, 其中横坐标为假正率(FPR),纵坐标为真正率(TPR)

AUC曲线

我们可以使用不同的分类阈值多次评估逻辑回归模型,但这样做效率非常低。这种算法称为曲线下面积(Area Under Curve)。

AUC 的一般判断标准

0.5 - 0.7: 效果较低,但用于预测股票已经很不错了

0.7 - 0.85: 效果一般

0.85 - 0.95: 效果很好

0.95 - 1: 效果非常好,但一般不太可能

posted on 2020-09-09 11:27 happygril3 阅读(563) 评论(0) 收藏 举报

浙公网安备 33010602011771号

浙公网安备 33010602011771号